部署本地模型,使用cherry-studio测试本地模型和云端模型

1 版本选型

JDK17 (之前有个坑: 支持 jdk17 的最低 idea 版本 为 2023 年的)

SpringBoot 3.4.0 (最低 jdk17 才支持 spring boot 3 ; 所以要准备好 jdk17 )

Spring AI 1.0.0-M6

Spring Al Alibaba 1.0.0-M6.1 (目前 25 年最新版)

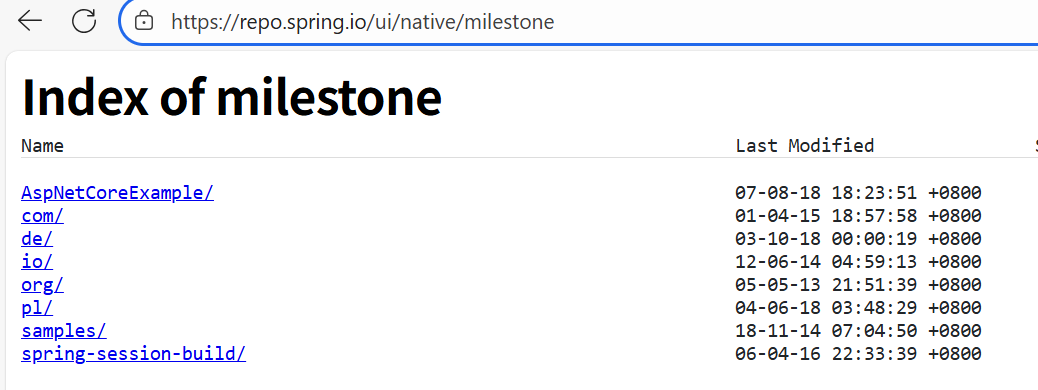

有个问题 Spring AI 相关依赖包 还没有发布到中央仓库;解决方法如下

<repositories><repository><id>spring-milestones</id><name>Spring Milestones</name><url>https://repo.spring.io/milestone</url><snapshots><enabled>false</enabled></snapshots></repository>

</repositories>url 这个网址是浏览和下载 Spring 项目各种里程碑(预览)版本构件(如 JAR 文件)的官方入口

2 大模型选型

1 . 本地部署: Ollama+通义模型(Qwen)/DeepSeek

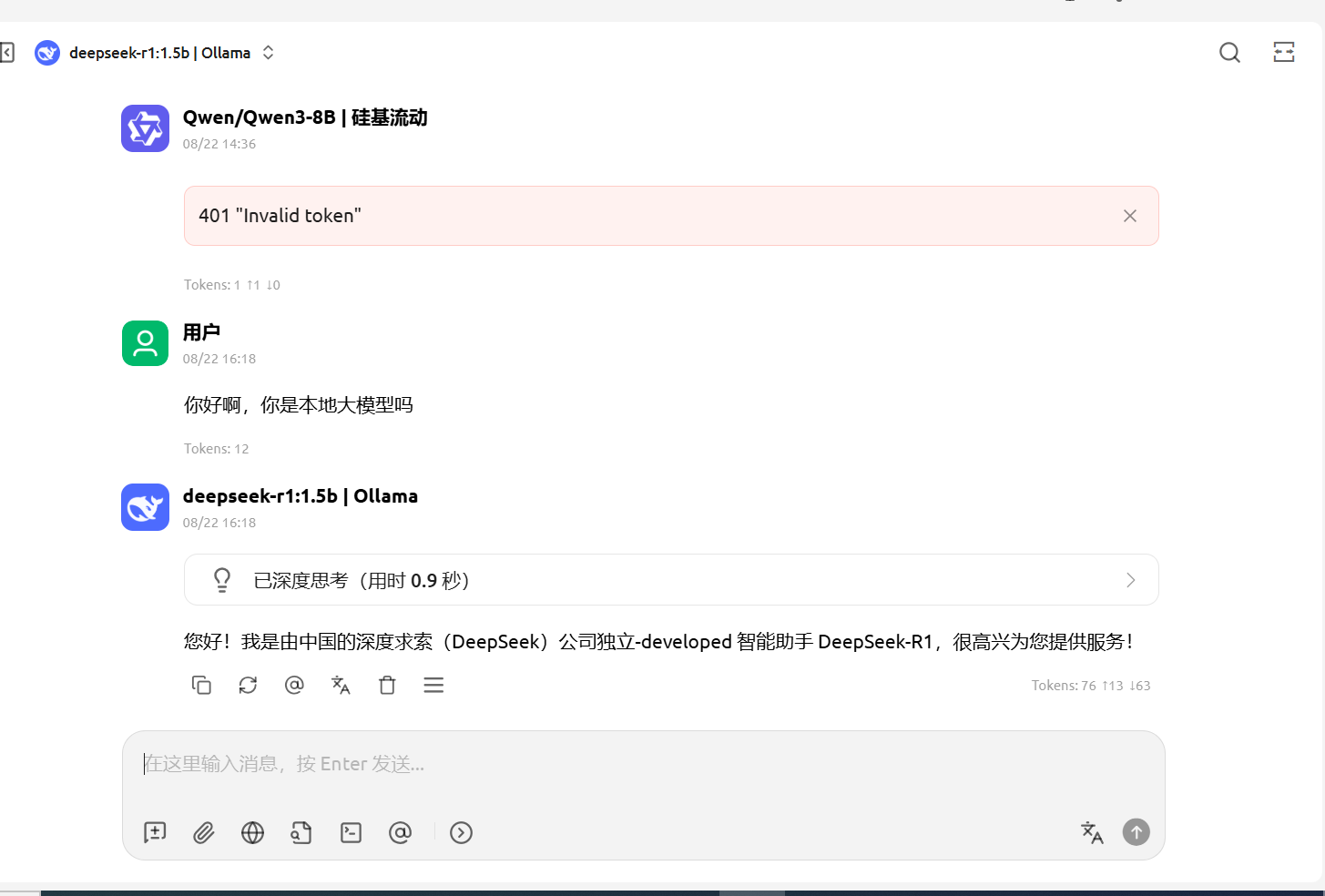

测试方式: 基于Ollama本地部署DeepSeek模型,并通过CherryStudio客户端访问大模型;

本地部署好的话就使用 AI 接口就 不用走网络,

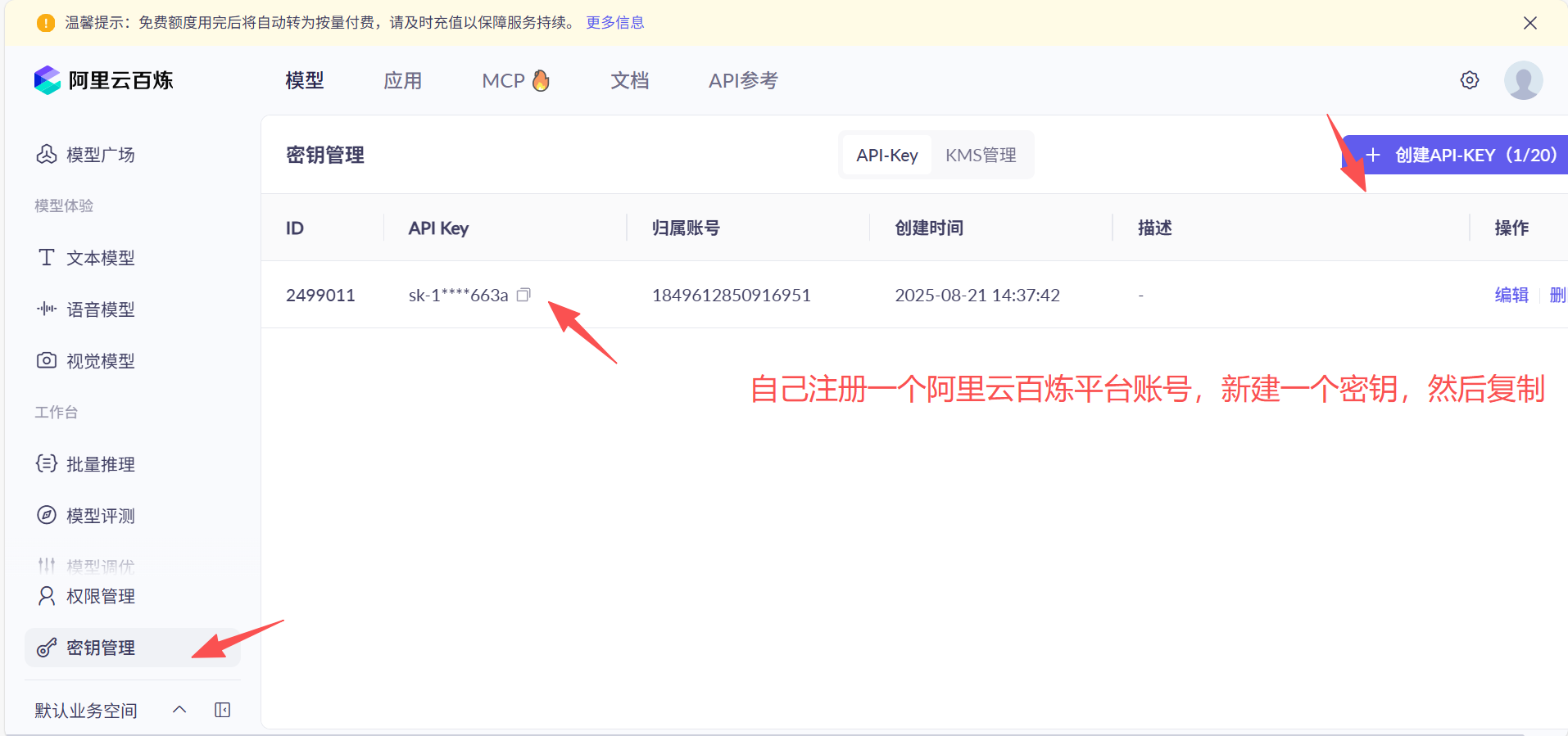

2 . 云端大模型

阿里云百炼平台 :支持通义系列和DeepSeek等大模型;

硅基流动平台 : 也支持通义系列和DeepSeek等大模型; 注册即送 2000 万 Tokens;

测试方式: 也是通过Cherry Studio客户端访问云端大模型;

3 使用Ollama 本地部署好大模型;然后cherry-studio 测试;

Ollama 是一个开源的大型语言模型服务工具,旨在帮助用户快速在本地运行大模型。

通过简单的安装指令,用户可以通过一条命令轻松启动和运行开源的大型语言模型。Ollama是 LLM 领域的 Docker。

一句话 : Ollama 可以帮助你快速部署本地大模型;

1 官网下载Ollama : Ollama 官网下载网速太慢使用极客应用下载 Ollama下载 - 官方正版 - 极客应用

安装教程就不用多说了,无脑下一步就行了

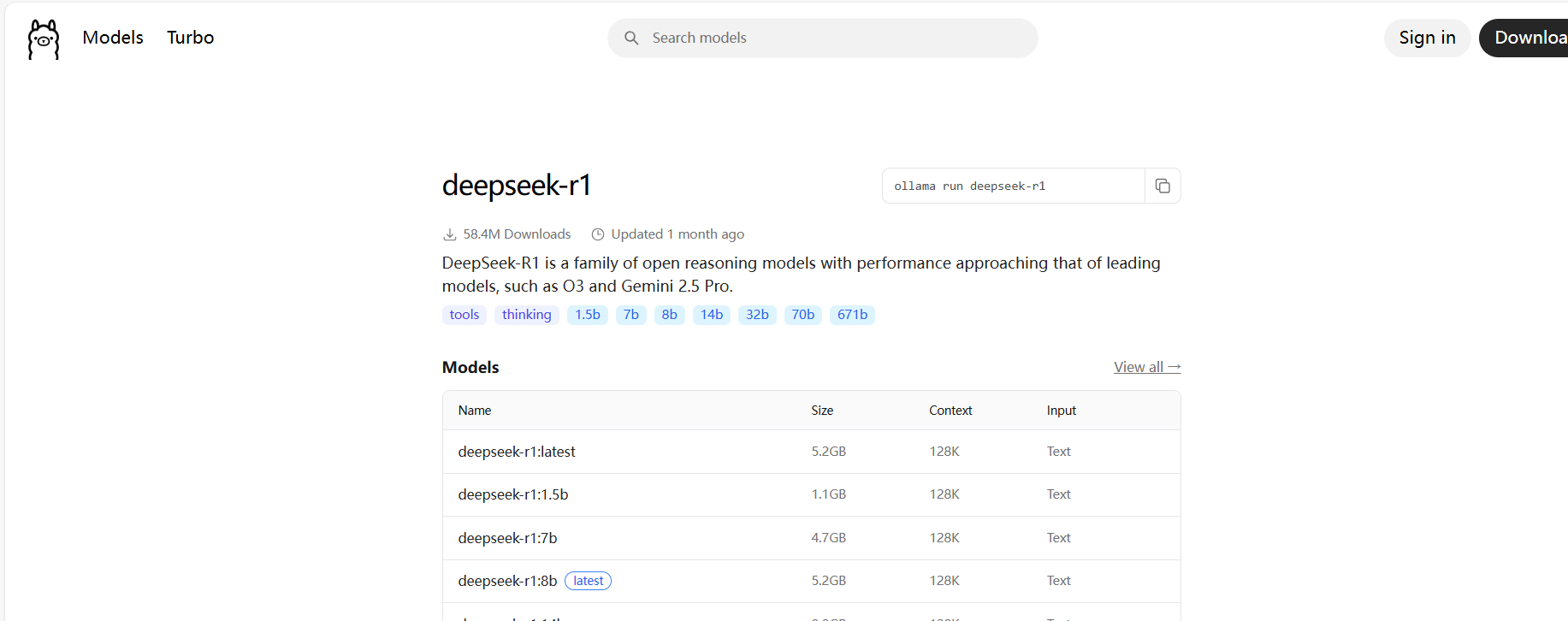

2 安装完成回到官网;搜索框里搜索deepseek-r1,选择要安装的模型;

电脑配置不行的,选择1.5B版本,这个模型有15亿参数,属于最轻量的Deepseek版本,电脑配置好点的,可以选择7b以上的。

各个模型版本最低配置

| 模型规模 | 最低配置要求 |

| 1.5B | GPU 4GB + 内存 8GB(如 GTX 1650 笔记本) |

| 3B | GPU 6GB + 内存 12GB(如 RTX 3060) |

| 7B | GPU 8GB + 内存 16GB(如 RTX 3070 / 4060 Ti) |

| 8B | GPU 10GB + 内存 24GB(如 RTX 3080 10GB) |

| 13B | GPU 16GB + 内存 32GB(如 RTX 3090 / 4080) |

我就选择 1.5 b 吧

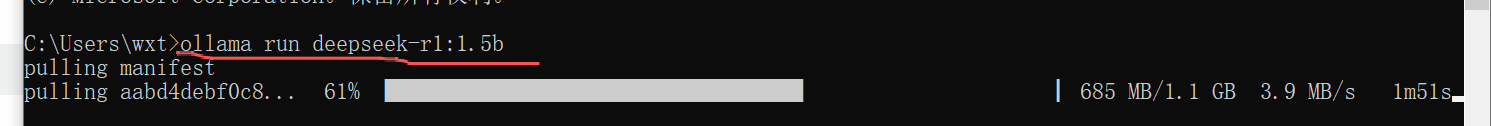

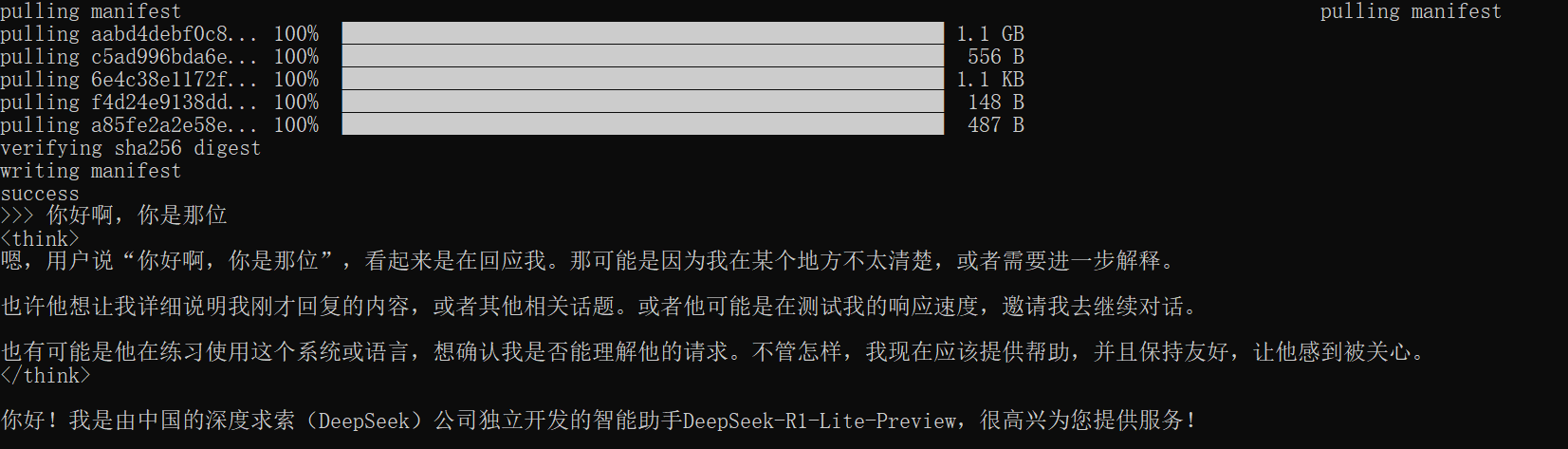

打开 cmd ; 执行命令 “ollama run + 刚才复制的的版本”

删除模型命令

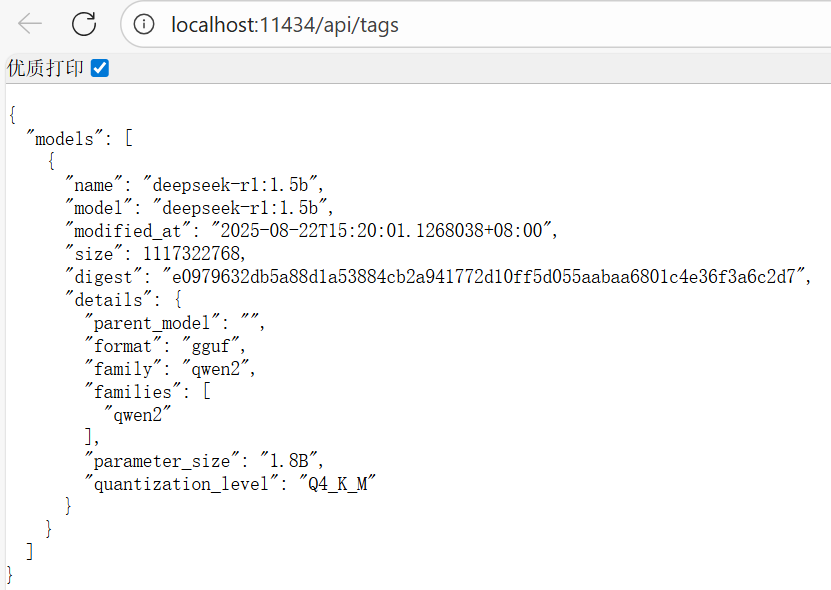

安装完成了就可以测试了;浏览器中访问http://localhost:11434测试

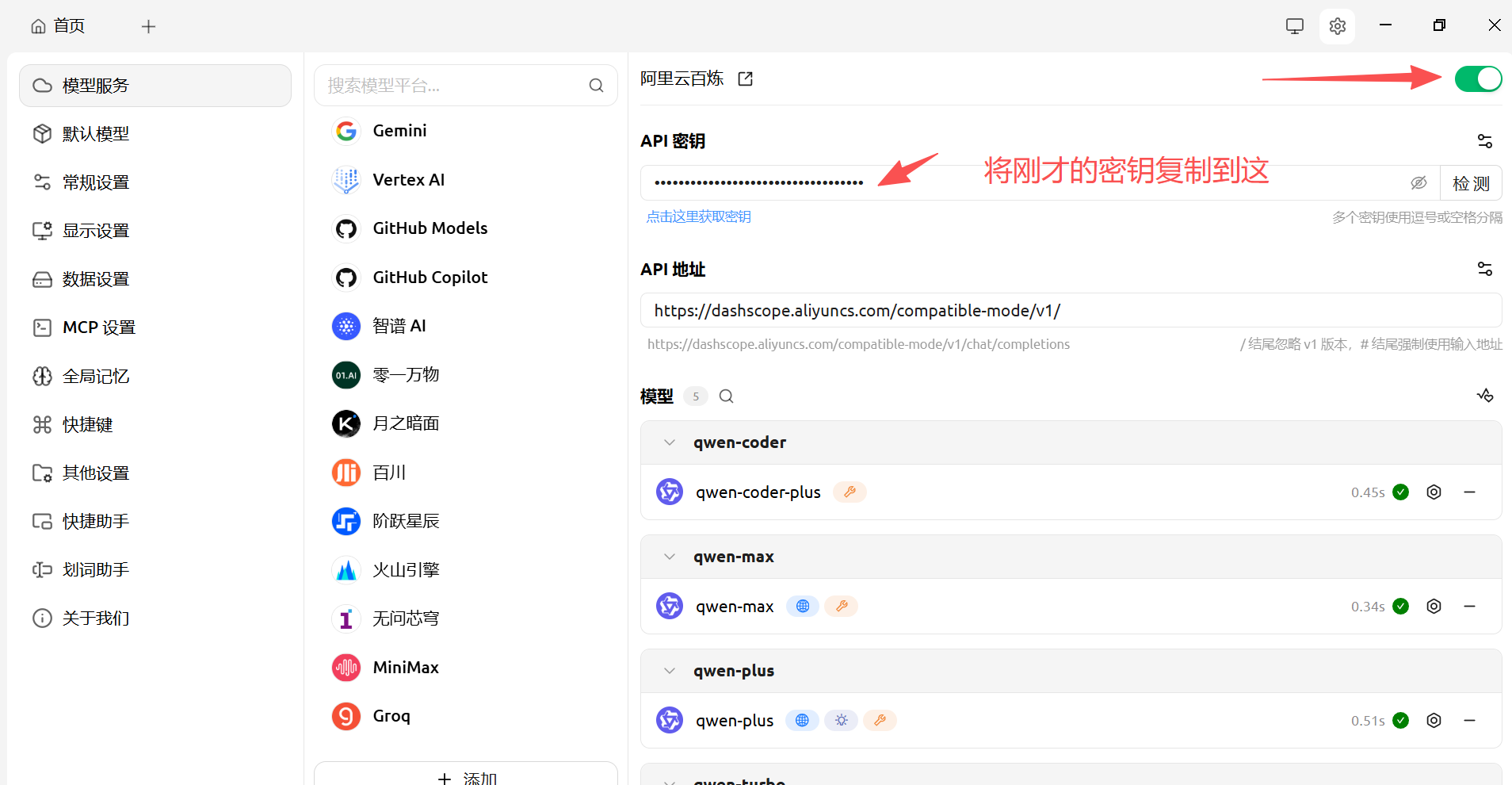

3 命令行聊天对操作不友好;所以安装可视化聊天客户端 cherry-studio 进行测试;

cherry-studio 安装官网Cherry Studio 官方网站 - 全能的 AI 助手

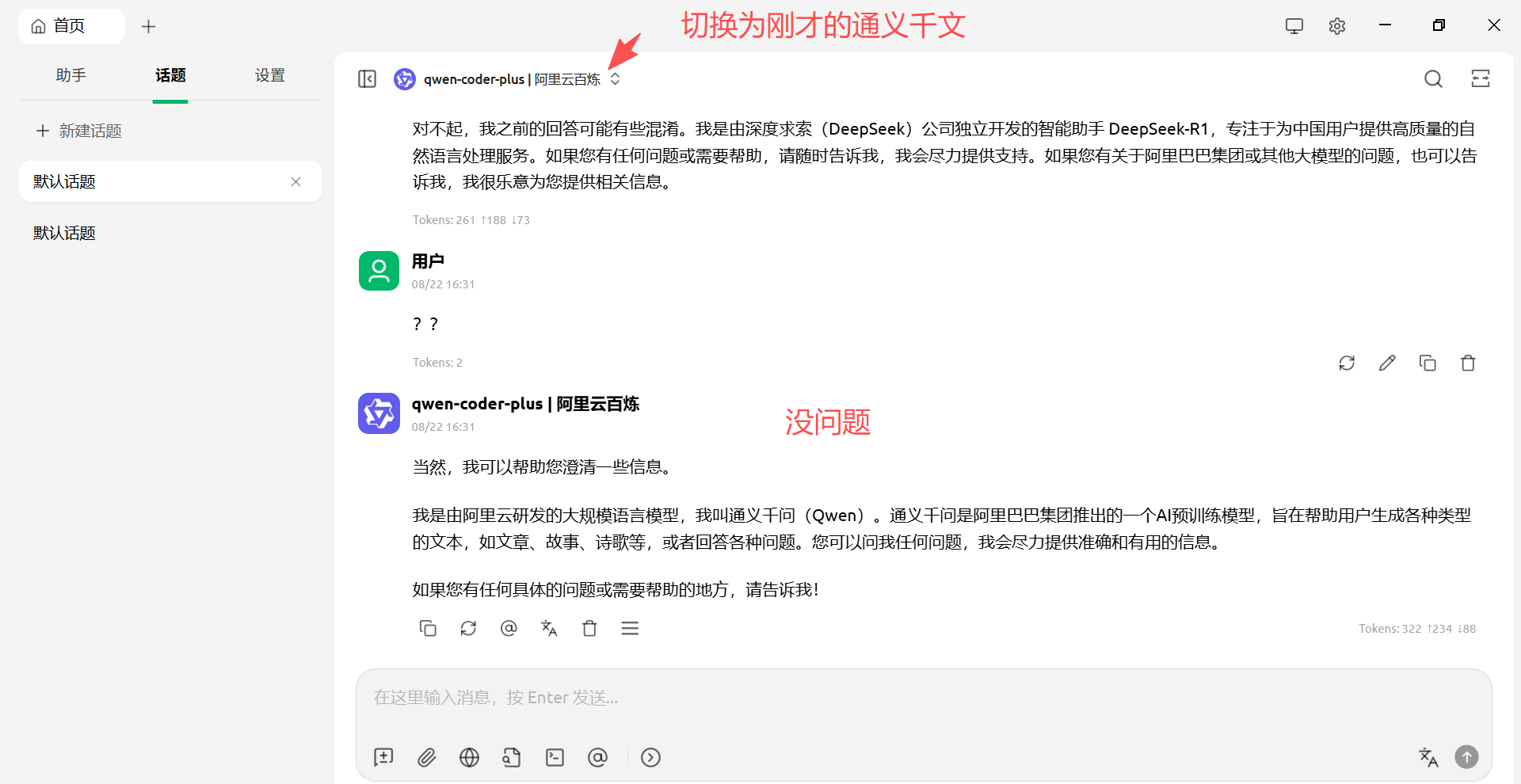

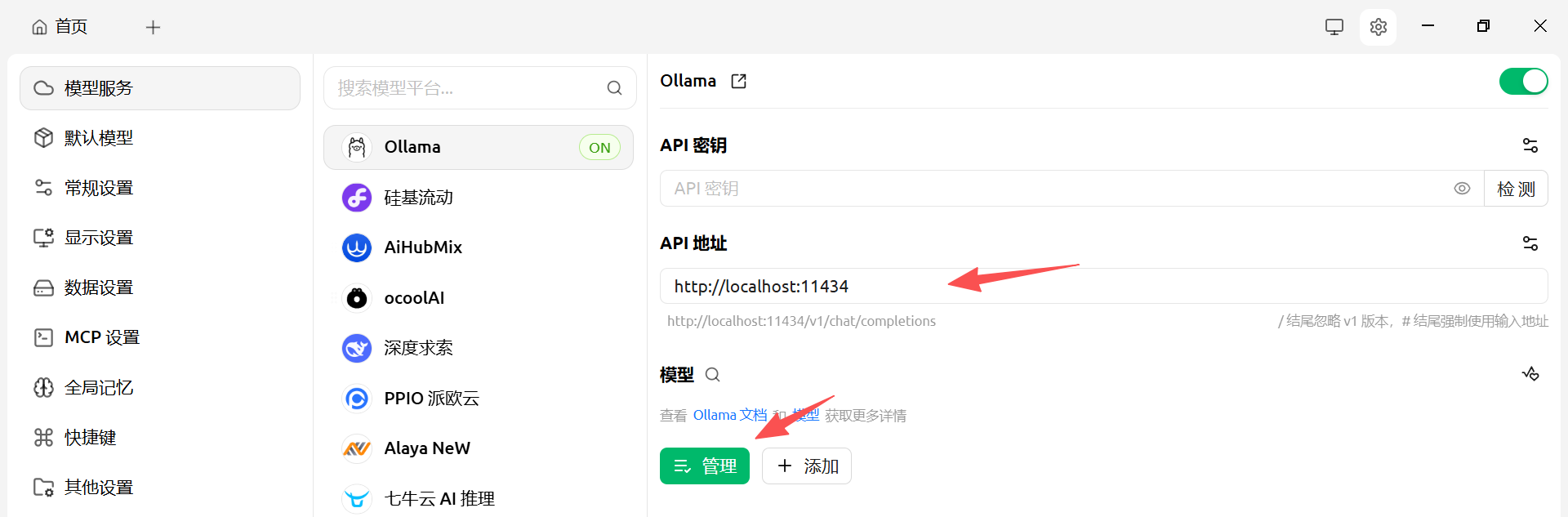

首页->设置->模型服务->选中 ollama 来选择我们部署的本地大模型

api 地址: 输入访问模型的 url http://localhost:11434

补充: 右上角开关按钮要打开

回到首页测试,没有问题

3 使用cherry-studio 客户端 测试 云端大模型

云端大模型;直接远程访问就行了; 不需要部署啥的