机器人视频感知架构深度解析:7条技术法则,打造低延迟实时感知与交互

引言

过去几年,机器人行业像过山车一样经历了极端起伏:从资本的狂热追捧,到泡沫破裂后的冷静回归。尤其是 2024 年之后,整个行业进入“去伪存真”的阶段,投资人和客户提出的终极问题不再是“能不能做出炫酷 Demo”,而是“能否规模化量产、在真实场景稳定运行”。

在这一轮深度洗牌中,机器人公司比拼的已不再是表面的AI算法演示,而是底层系统架构的工程实力。其中,一个决定产品能否真正走出实验室、走进工厂、仓库、商超,甚至家庭的关键因素,就是实时感知与视频交互链路。

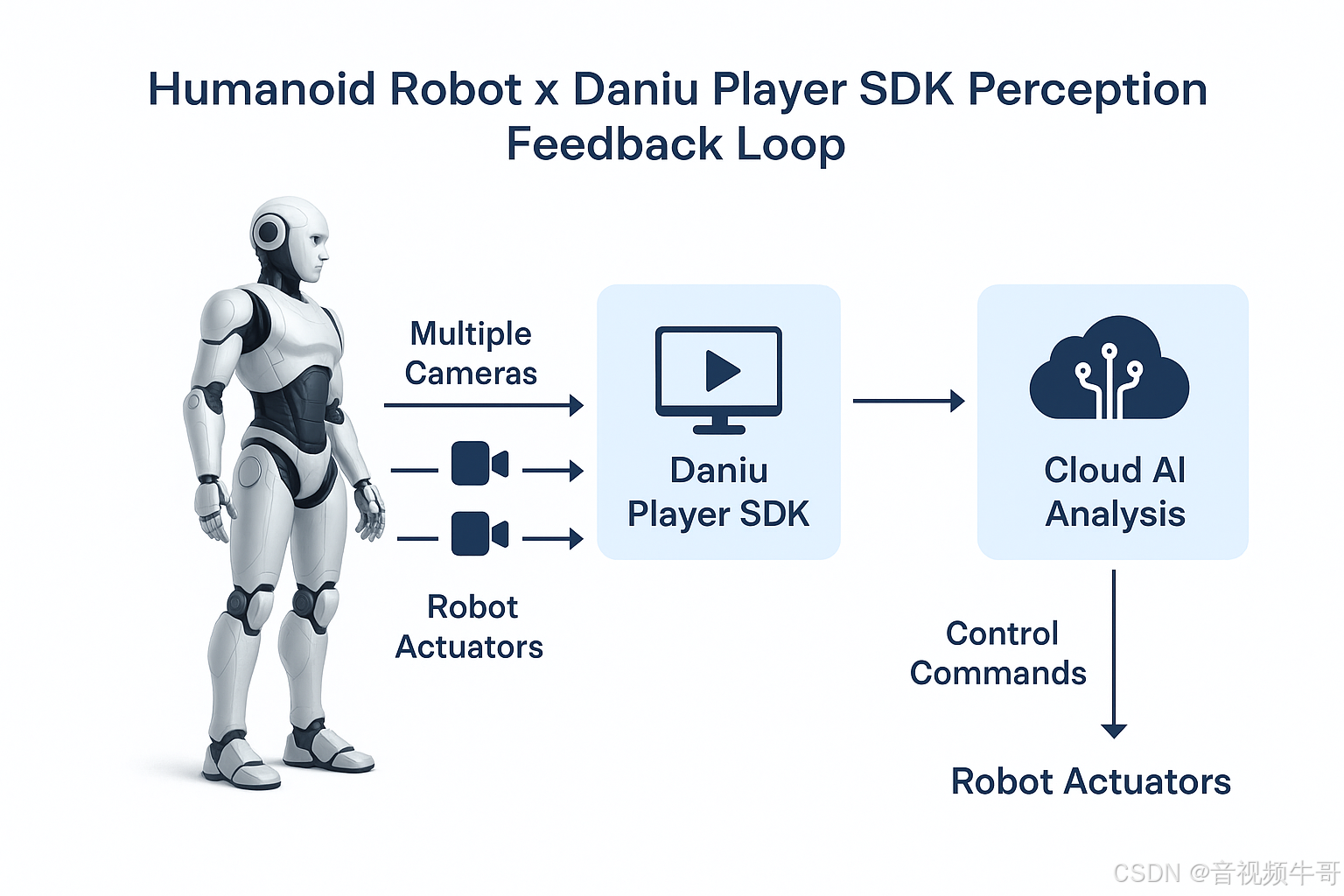

为什么这条链路如此重要?因为不论是AGV、巡检无人机、协作机械臂,还是类人服务机器人,感知永远是智能的入口,而感知的最主要来源仍是多通道视频和音频数据。如果数据回传延迟过高,AI决策就会滞后,整台机器人变得“反应迟钝”;如果网络波动导致画面卡顿或丢帧,控制和安全性都无从谈起。因此,如何在复杂网络环境下实现毫秒级低延迟、高清晰度、稳定可靠的多路视频传输,已成为机器人商业化落地的生命线。

在大牛直播SDK(SmartMediakit)支持众多机器人厂商的过程中,我们观察到一个显著趋势:能够穿越行业寒冬、实现规模应用的企业,几乎都具备一个共性——在视频感知、传输、解码渲染以及与AI推理的融合上,做到了极致的工程优化。基于我们在行业落地的经验,结合对机器人技术演进的观察,本文总结出一个面向实时音视频维度的“机器人公司 7 条技术生存法则”,希望能为行业带来一些启发。

行业现状:从算法PK到系统博弈

早期的机器人创业公司,几乎都把重点放在AI算法精度上,宣传PPT里动辄是“感知识别准确率 99%”“路径规划精度厘米级”。然而,当产品真正进入仓储、物流、巡检、电力等复杂应用场景,企业才发现:算法并不是唯一的胜负手,甚至不是最难的环节。

原因在于,机器人是一套高度复杂的“系统工程”,AI只是大脑,真正的神经系统,是底层的数据链路。以视觉感知为例,模型要实时处理来自多颗摄像头、深度传感器的数据,这些数据必须通过低延迟、高可靠的视频流传输链路,才能供AI决策使用。而这条链路不仅要承受高分辨率视频带宽压力(如1080p/4K多路)、跨公网网络抖动、丢包的挑战,还要兼顾设备功耗、编码效率以及边缘侧算力资源限制。

在一些项目中,我们看到不少机器人公司栽在这个看似不起眼的环节:

-

在实验室 Demo 时视频流畅,一旦走进实际场景就卡顿严重;

-

控制端延迟超过1秒,导致机器人运动出现“鬼影”或动作滞后;

-

多路视频同时接入时,系统崩溃或花屏,甚至出现内存泄漏,长期运行不稳定。

这些问题不仅影响用户体验,更直接拉高了部署和维护成本,让客户望而却步。所以,在行业真正进入商业化阶段后,谁能在音视频实时感知和传输链路上做到极致,谁就能在竞争中拿到入场券。

Windows平台 RTSP vs RTMP播放器延迟大比拼

技术生存法则的提出:为什么视频链路是底座?

很多人一提到机器人技术,就会想到AI大模型、路径规划、自然语言交互,仿佛只要算法强大,机器人就能无所不能。然而,真正进入产业落地,企业会发现一个残酷的现实:如果底层感知链路不稳,所有AI能力都是“空中楼阁”。

为什么?因为智能决策必须依赖真实、连续、低延迟的感知数据。当视频流出现 500ms 以上的延迟,AI就无法实时感知环境变化,控制命令也会滞后,直接导致机器人“失明”或“反应迟钝”。这不仅影响体验,更可能带来安全事故和运营风险。

而视频链路的问题,往往不是单点优化能解决的,而是一个系统性挑战:

-

网络维度:公网抖动、丢包、带宽不足,如何保证画面不卡顿?

-

性能维度:多路高清视频同时回传,如何避免CPU瓶颈、功耗过高?

-

兼容维度:Android、Linux、Windows不同系统如何统一?

-

未来演进:如何兼容新一代编码标准(H.266、AVS3)?

这正是为什么,我们在总结行业经验后,提出了**“机器人公司 7 条技术生存法则”**,帮助企业在设计感知和控制链路时建立系统性思维。这7条法则覆盖从团队架构到协议栈、从实时性能到部署效率,都是企业能否撑过洗牌期的关键。

接下来,我们将从第一个法则开始,拆解底层视频感知链路的设计要点,并结合大牛直播SDK在行业中的应用案例,看看顶尖机器人公司是如何做到低延迟、高可靠、可扩展的。

Android平台Unity3D下RTMP播放器延迟测试

法则一:跨学科的顶尖团队 + 系统架构视野

机器人不是单一学科的产物,它是一场涉及 AI算法、音视频技术、网络协议、硬件架构、操作系统内核的系统级工程。

-

如果团队里没有人懂低延迟传输协议(RTSP、SRT、RTMP)、视频解码优化、GPU加速,那么再强的AI算法也可能“卡在路上”。

-

如果没有系统架构师来设计整个数据流,从摄像头 → 编码器 → 网络 → 控制端 → AI推理 → 任务执行的链路,就无法保证整体延迟可控、带宽利用率最优。

为什么视频链路是关键?

-

视频流占据机器人感知数据的 80% 以上带宽,如果不优化,会成为“拖慢整车”的瓶颈。

-

网络层面涉及抗丢包、拥塞控制,应用层还要处理多路流同步,任何一环没经验都会踩坑。

大牛直播SDK的助力:

-

提供完整的低延迟传输协议栈(RTSP、RTMP、SRT、GB28181),避免团队重复造轮子。

-

跨平台统一API(Android/iOS/Windows/Linux/Unity3D),降低多平台集成难度,让AI和控制开发团队专注业务逻辑,而不是协议兼容。

Android平台RTMP直播播放器延迟测试

法则二:真实、复杂场景下的演示能力

还在拿剪辑过的Demo骗投资?这种公司很难活过2025。

为什么?

-

实际部署场景(工厂、仓库、室外巡检)网络波动极大,延迟和丢包率直接影响控制和安全。

-

如果产品只在Wi-Fi或局域网下测试,等客户一部署到4G/5G或跨公网,延迟就从100ms飙到1s,体验瞬间崩盘。

评估方法:

-

看演示时,观察视频流是否在弱网下依然流畅,码率是否自适应。

-

是否支持抗丢包重传、动态缓冲调节,尤其在4G信号波动时是否仍保持亚秒级延迟。

大牛直播SDK的优势:

-

自研高效协议栈,丢包状态下仍可保证视频流畅。

-

弱网环境下自动调节码率,保持画质与延迟的平衡,真实场景也能稳定运行。

Android平台RTSP播放器时延测试

法则三:三大核心性能指标——质量、吞吐量、稳健性

机器人系统的感知链路,必须满足三个指标:

-

质量(Quality):1080p甚至4K画质,细节清晰,方便AI目标检测。

-

吞吐量(Throughput):同时处理多路视频流(如前后左右+机械臂摄像头),延迟依然可控。

-

稳健性(Robustness):长时间运行无内存泄漏、不卡顿、不花屏。

行业现象:

很多机器人公司Demo时没问题,但项目一上线,多路并发+长时间运行,系统就频繁崩溃,原因是底层视频链路没有做足优化。

大牛直播SDK:

-

单台设备可支持多路高清视频并发,仍保持亚秒级延迟。

-

提供硬编/硬解加速,降低CPU负载,保障稳定性。

法则四:训练与部署的效率

在机器人行业,研发周期和部署效率决定了企业的生死。过去,很多团队在部署时需要花费大量时间适配摄像头、调试推流、解决编解码兼容问题,导致上线成本高昂、交付周期一拖再拖。

为什么部署效率如此重要?

-

每延迟一周交付,客户信任度下降,项目现金流受影响。

-

如果AI模型更新,但视频链路无法快速适配,就会影响整体算法效果。

核心指标:

-

摄像头接入是否支持即插即用?

-

新终端上线是否需要重写大量代码?

-

SDK是否有统一API,可以快速集成到不同平台?

大牛直播SDK的实践:

-

全平台统一接口(Android/iOS/Linux/Windows/Unity3D),减少开发适配时间。

-

支持软硬件编解码灵活切换,满足不同芯片平台需求。

-

提供开箱即用的推流、拉流Demo,降低部署门槛。

安卓轻量级RTSP服务采集摄像头,PC端到安卓拉取RTSP流

法则五:底层技术壁垒

机器人行业早期,很多公司忽略了协议和编码标准的重要性,直接采用开源方案,结果遇到以下问题:

-

不支持新一代编码(如H.265、H.266、AVS3),未来升级困难。

-

在多协议兼容性上掉链子,导致和客户已有系统无法对接。

-

缺乏针对弱网的优化,导致视频链路不稳定。

为什么底层协议是护城河?

因为视频链路涉及 RTSP、RTMP、GB28181等多种协议,每个协议的优化需要大量经验和内核开发能力,不是短期能补齐的。

大牛直播SDK的能力:

-

跨平台低延迟场景全覆盖,且针对实时场景深度优化。

-

可轻松支持最新编码标准,兼容未来演进。

-

拥有自研传输内核架构,性能和稳定性远超开源方案。

iOS平台RTMP播放器时延测试

法则六:市场与客户的真实价值

技术再酷炫,如果不能带来成本下降或效率提升,客户不会买单。视频链路优化的意义在于:

-

降低带宽成本:自适应码率 + 编码优化,减少流量费用。

-

提升运行效率:低延迟意味着更快的任务响应,提高产线效率。

-

提升安全性:实时回传画面,防止事故发生,减少赔偿风险。

案例:

某仓储机器人客户,通过优化视频链路延迟,从500ms降低到150ms,协作效率提升 30%,直接减少人工干预,降低运营成本。

法则七:硬件策略与系统集成

视频链路不是独立存在的,它必须与摄像头、GPU、AI推理芯片深度协同。如果摄像头输出4K视频,但边缘端算力不足,延迟就会爆炸。

如何避免?

-

视频链路必须支持硬编解码,充分利用GPU/ASIC能力。

-

在架构设计时,考虑AI推理和视频处理的并行性,避免互相抢占算力。

-

SDK是否提供针对常见硬件平台的优化?

大牛直播SDK的亮点:

-

针对ARM平台、GPU加速深度优化。

-

支持边缘端多流并行传输,减少延迟。

总结:视频链路是机器人智能的“中枢神经”

机器人能否真正走向规模化,不取决于PPT里的炫酷AI算法,而取决于底层系统是否稳得住、跑得快。实时视频感知链路,是整个智能决策的血液循环和神经网络,它决定了:

-

AI是否能看清世界(感知清晰度)

-

能否快速做出决策(延迟和稳定性)

-

能否安全、可靠地执行任务(控制闭环)

如果这条链路不稳,再强的算法也是“盲人骑马”。

未来的竞争,已经不是“谁的大模型更花哨”,而是谁能把底层做到极致——低延迟、高可靠、可扩展。这是一条硬核工程路线,而不是概念秀场。

大牛直播SDK在与行业企业的合作中,验证了一个事实:只有把视频传输和感知链路打磨到极致,机器人才能真正进入商业化的高速公路。从抗丢包、弱网优化,到多路并发和跨平台兼容,我们帮助客户在真实场景中跑通了链路,撑过了洗牌期。

如果你的机器人项目正面临弱网卡顿、延迟过高、协议兼容困难等问题,那么这7条法则,或许是你重新审视架构、打造长期竞争力的起点。

📎 CSDN官方博客:音视频牛哥-CSDN博客