【完整源码+数据集+部署教程】化妆品实例分割系统源码和数据集:改进yolo11-DynamicConv

背景意义

研究背景与意义

随着计算机视觉技术的迅猛发展,实例分割在多个领域中展现出了巨大的应用潜力,尤其是在产品识别和图像分析方面。化妆品行业作为一个高度竞争且快速发展的市场,对产品识别和分类的需求日益增加。传统的图像处理方法往往无法满足现代化妆品行业对高精度、高效率的要求,因此,基于深度学习的实例分割技术逐渐成为解决这一问题的有效手段。

本研究旨在基于改进的YOLOv11模型,构建一个高效的化妆品实例分割系统。该系统将利用一个包含3700张图像的专用数据集,专注于化妆品这一单一类别的实例分割任务。通过对该数据集的深入分析和处理,我们期望能够提升模型在化妆品识别中的准确性和鲁棒性,从而为行业应用提供更为精准的技术支持。

在当前的市场环境中,消费者对化妆品的选择日益多样化,产品信息的获取和处理成为品牌竞争力的重要组成部分。通过实例分割技术,商家能够实现对产品图像的自动化分析,进而优化库存管理、提升用户体验、加强市场营销策略。因此,构建一个高效的化妆品实例分割系统,不仅具有重要的学术价值,也将为实际应用提供切实的支持。

此外,随着数据集的不断扩展和技术的不断进步,基于YOLOv11的实例分割系统将具备良好的可扩展性和适应性,能够在未来的研究中为其他类别的产品识别提供借鉴。综上所述,本研究不仅具有重要的理论意义,也将为化妆品行业的数字化转型提供有力的技术保障。

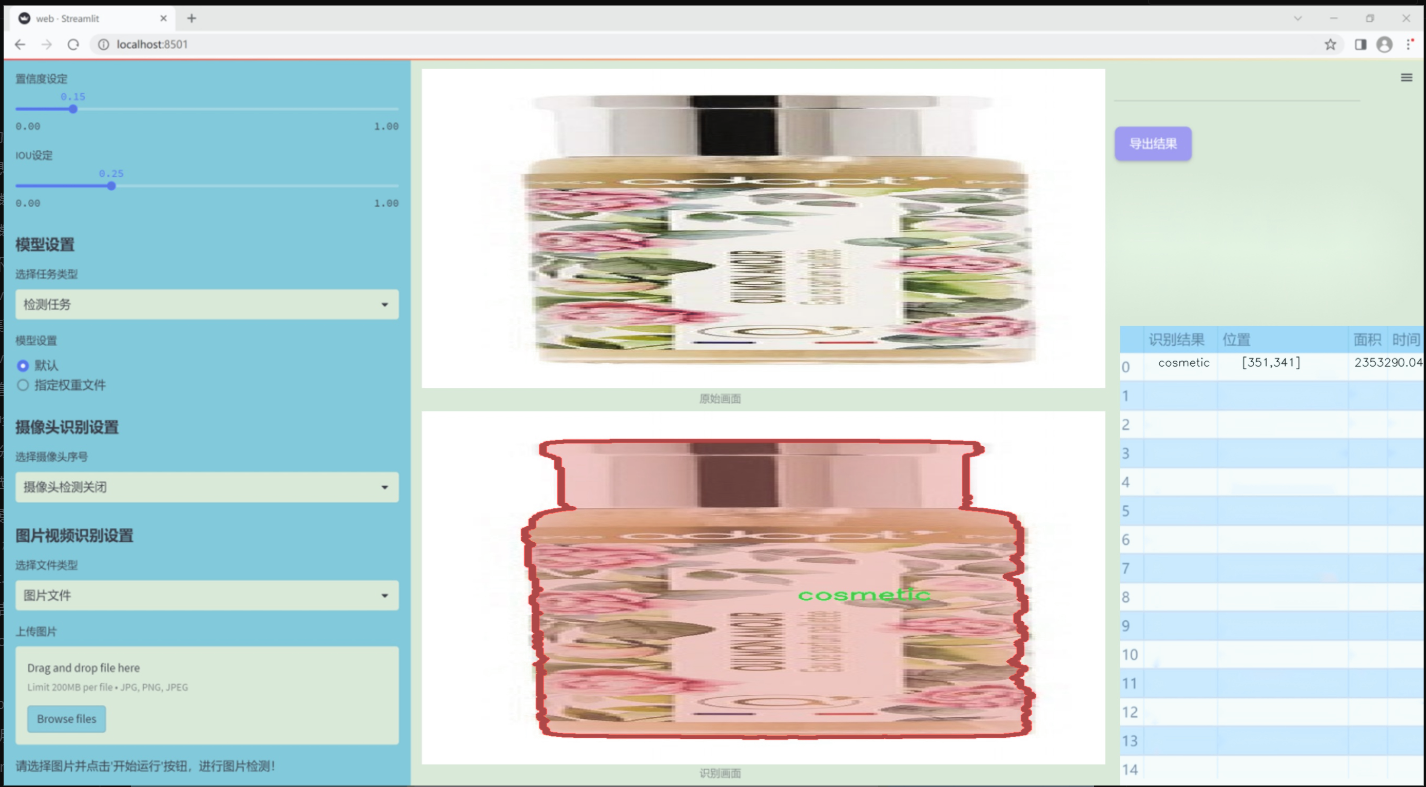

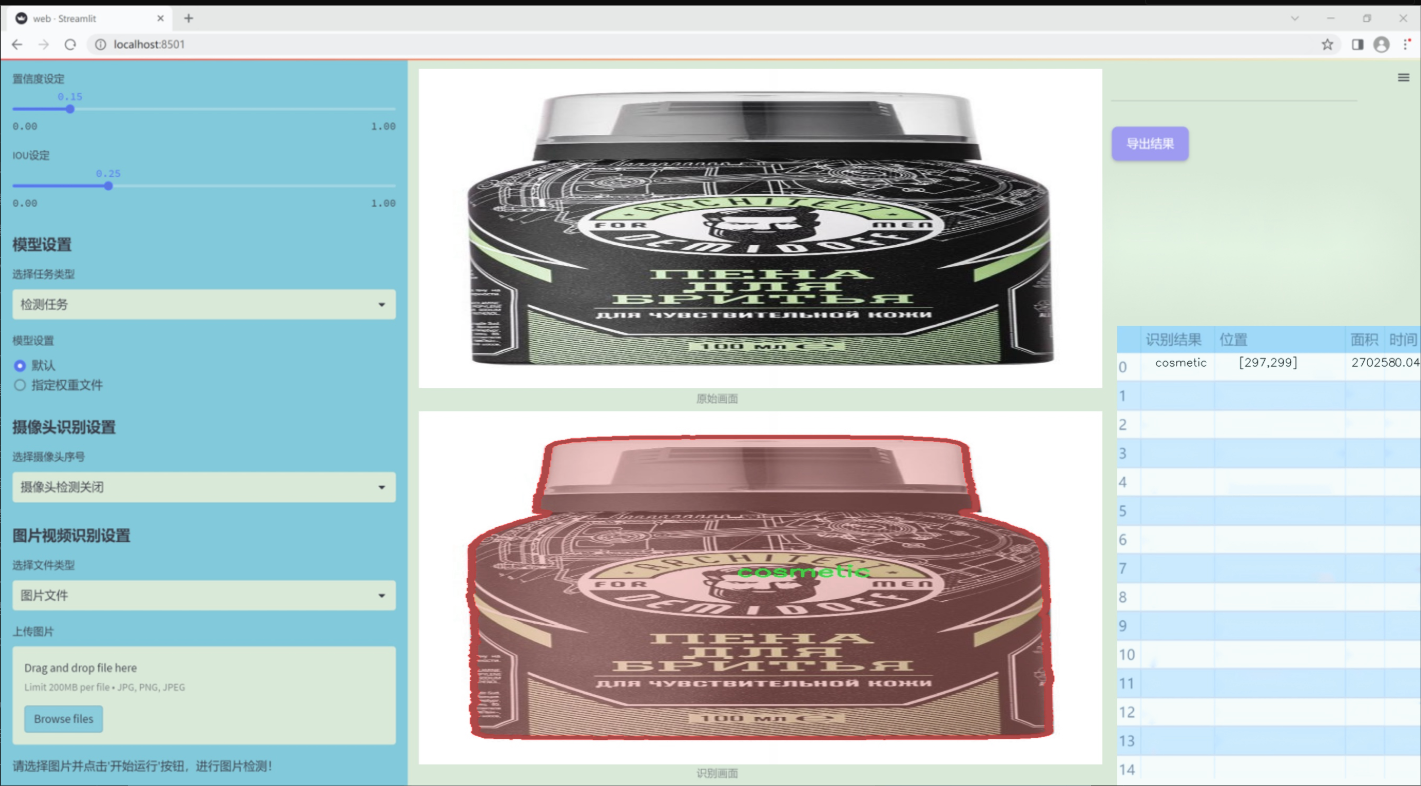

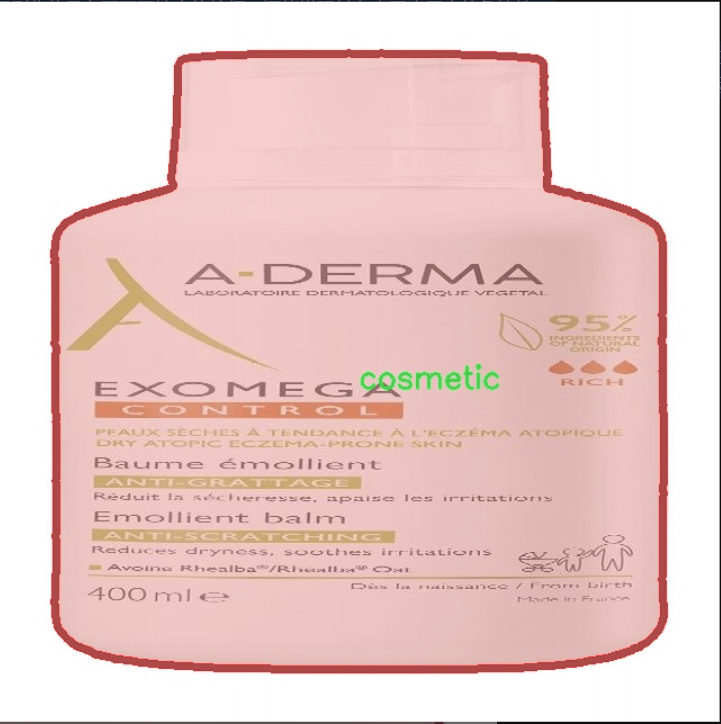

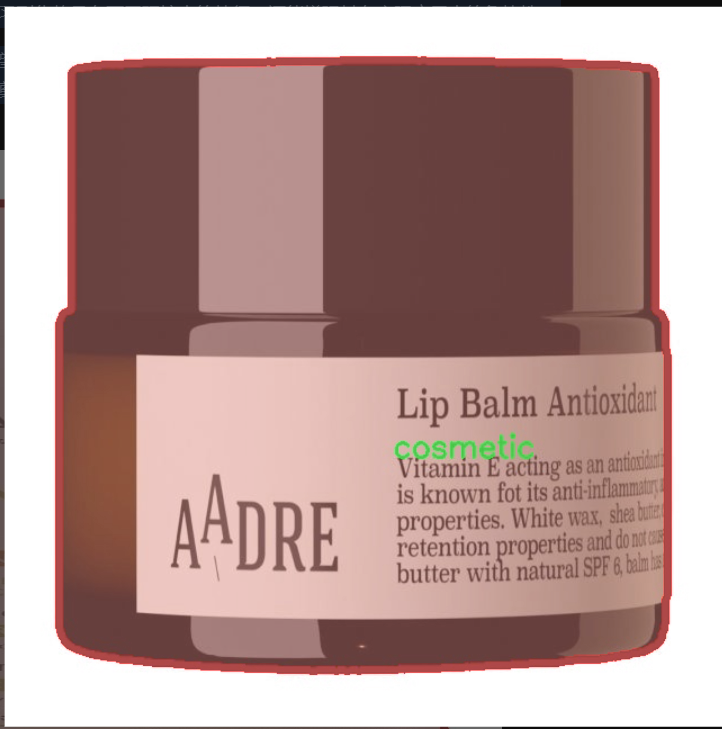

图片效果

数据集信息

本项目数据集信息介绍

本项目所使用的数据集以“cosm2”为主题,专注于化妆品的实例分割任务。该数据集的设计旨在支持对化妆品对象的精确识别与分割,进而提升YOLOv11模型在化妆品检测和识别方面的性能。数据集中包含的类别数量为1,具体类别为“cosmetic”,这意味着数据集专注于化妆品这一单一类别的多样性和复杂性。

在数据集的构建过程中,我们收集了大量的化妆品图像,涵盖了不同品牌、类型和包装形式的产品。这些图像不仅包括化妆品的正面视图,还包括侧面、背面及不同光照条件下的拍摄,以确保模型能够在各种环境中进行有效的识别和分割。此外,数据集中的图像经过精心标注,确保每个化妆品对象的边界框和分割掩码准确无误,为模型的训练提供了高质量的输入。

为了提高模型的泛化能力,数据集中还包含了多种背景和场景,涵盖了家庭环境、化妆间、商店货架等多种使用场景。这种多样性不仅有助于模型学习到化妆品在不同环境中的特征,还能增强其在实际应用中的鲁棒性。

通过对该数据集的训练,期望能够显著提升YOLOv11在化妆品实例分割任务中的表现,使其能够更准确地识别和分割化妆品对象,为后续的应用开发奠定坚实的基础。该数据集的构建和应用,将为化妆品行业的智能化发展提供重要支持,推动相关技术的进步与创新。

核心代码

以下是经过简化和注释的核心代码部分,主要集中在 Detect_DyHead 类及其相关方法。该类实现了 YOLOv8 的检测头,使用动态头(DyHead)进行目标检测。

import torch

import torch.nn as nn

import math

class Detect_DyHead(nn.Module):

“”“YOLOv8 检测头,使用动态头(DyHead)进行目标检测。”“”

def __init__(self, nc=80, hidc=256, block_num=2, ch=()):"""初始化检测头的参数。参数:nc (int): 类别数量。hidc (int): 隐藏层通道数。block_num (int): 动态头块的数量。ch (tuple): 输入通道数。"""super().__init__()self.nc = nc # 类别数量self.nl = len(ch) # 检测层数量self.reg_max = 16 # DFL 通道数self.no = nc + self.reg_max * 4 # 每个锚点的输出数量self.stride = torch.zeros(self.nl) # 在构建过程中计算的步幅c2, c3 = max((16, ch[0] // 4, self.reg_max * 4)), max(ch[0], self.nc) # 通道数self.conv = nn.ModuleList(nn.Sequential(Conv(x, hidc, 1)) for x in ch) # 卷积层self.dyhead = nn.Sequential(*[DyHeadBlock(hidc) for _ in range(block_num)]) # 动态头块self.cv2 = nn.ModuleList(nn.Sequential(Conv(hidc, c2, 3), Conv(c2, c2, 3), nn.Conv2d(c2, 4 * self.reg_max, 1)) for _ in ch) # 用于输出回归的卷积层self.cv3 = nn.ModuleList(nn.Sequential(nn.Sequential(DWConv(hidc, x, 3), Conv(x, c3, 1)),nn.Sequential(DWConv(c3, c3, 3), Conv(c3, c3, 1)),nn.Conv2d(c3, self.nc, 1),)for x in ch) # 用于输出类别的卷积层self.dfl = DFL(self.reg_max) if self.reg_max > 1 else nn.Identity() # DFL层def forward(self, x):"""连接并返回预测的边界框和类别概率。"""for i in range(self.nl):x[i] = self.conv[i](x[i]) # 通过卷积层处理输入x = self.dyhead(x) # 通过动态头处理shape = x[0].shape # 获取输出形状for i in range(self.nl):# 连接回归和类别输出x[i] = torch.cat((self.cv2[i](x[i]), self.cv3[i](x[i])), 1)if self.training:return x # 如果在训练模式,返回输出elif self.dynamic or self.shape != shape:# 动态锚点和步幅计算self.anchors, self.strides = (x.transpose(0, 1) for x in make_anchors(x, self.stride, 0.5))self.shape = shape# 将输出展平并分割为边界框和类别x_cat = torch.cat([xi.view(shape[0], self.no, -1) for xi in x], 2)box, cls = x_cat.split((self.reg_max * 4, self.nc), 1) # 分割为边界框和类别dbox = dist2bbox(self.dfl(box), self.anchors.unsqueeze(0), xywh=True, dim=1) * self.strides # 解码边界框y = torch.cat((dbox, cls.sigmoid()), 1) # 返回边界框和类别概率return y if self.export else (y, x)def bias_init(self):"""初始化检测头的偏置,警告:需要步幅可用。"""for a, b, s in zip(self.cv2, self.cv3, self.stride):a[-1].bias.data[:] = 1.0 # 边界框偏置初始化b[-1].bias.data[:self.nc] = math.log(5 / self.nc / (640 / s) ** 2) # 类别偏置初始化

代码注释说明

类和方法注释:每个类和方法都有详细的文档字符串,描述其功能和参数。

变量注释:重要变量的用途和含义都进行了注释,帮助理解代码逻辑。

逻辑流程:通过注释解释了每一步的处理逻辑,特别是在前向传播过程中,如何处理输入、生成输出以及动态锚点的计算。

这个文件 head.py 是一个实现 YOLOv8 检测头的 PyTorch 模块,主要用于目标检测、分割和姿态估计等任务。文件中定义了多个类,每个类代表一种不同的检测头,具有不同的结构和功能。

首先,文件导入了一些必要的库,包括 PyTorch 和一些自定义模块。然后,定义了一个 all 列表,列出了该模块中所有公开的类和函数,以便于外部调用。

接下来,定义了 Detect_DyHead 类,这是 YOLOv8 的检测头,使用了动态头(DyHead)结构。该类的构造函数接受类别数、隐藏通道数、块数和通道配置等参数。它初始化了一些必要的参数和层,包括卷积层、动态头块、DFL(Distribution Focal Loss)等。在 forward 方法中,输入特征经过一系列卷积和动态头处理后,输出预测的边界框和类别概率。

文件中还定义了其他多种检测头类,如 Detect_DyHeadWithDCNV3、Detect_AFPN_P345、Detect_Efficient 等,这些类继承自 Detect_DyHead 或 Detect_AFPN_P345,并根据不同的需求和结构进行了相应的修改。例如,Detect_AFPN_P345 使用了自适应特征金字塔网络(AFPN),而 Detect_Efficient 则实现了更高效的检测结构。

每个检测头类的 forward 方法负责处理输入特征并生成最终的预测结果。在训练模式下,返回的是特征图;在推理模式下,返回的是经过处理的边界框和类别概率。文件中还实现了一些辅助方法,如 bias_init 用于初始化偏置,decode_bboxes 用于解码边界框等。

此外,文件中还定义了一些特定于任务的检测头类,如 Segment_Efficient、Pose_LSCD 和 OBB_LSCD,这些类分别用于分割、姿态估计和旋转边界框检测,具有与目标检测类似的结构,但输出和处理方式有所不同。

总的来说,这个文件实现了 YOLOv8 检测模型的多个变种,提供了灵活的结构以适应不同的检测任务和需求。每个类都可以根据具体的应用场景进行扩展和修改,支持更复杂的模型设计和训练策略。

10.4 prepbn.py

以下是经过简化并添加详细中文注释的核心代码部分:

import torch

import torch.nn as nn

定义一个自定义的批量归一化类

class RepBN(nn.Module):

def init(self, channels):

super(RepBN, self).init()

# 定义一个可学习的参数 alpha,初始值为 1

self.alpha = nn.Parameter(torch.ones(1))

# 定义一个一维批量归一化层

self.bn = nn.BatchNorm1d(channels)

def forward(self, x):# 将输入的维度进行转置,以适应 BatchNorm1d 的输入格式x = x.transpose(1, 2)# 进行批量归一化,并加上 alpha 乘以输入 xx = self.bn(x) + self.alpha * x# 再次转置回原来的维度x = x.transpose(1, 2)return x

定义一个线性归一化类

class LinearNorm(nn.Module):

def init(self, dim, norm1, norm2, warm=0, step=300000, r0=1.0):

super(LinearNorm, self).init()

# 注册一些缓冲区,用于控制训练过程中的参数

self.register_buffer(‘warm’, torch.tensor(warm)) # 预热阶段的步数

self.register_buffer(‘iter’, torch.tensor(step)) # 当前迭代步数

self.register_buffer(‘total_step’, torch.tensor(step)) # 总步数

self.r0 = r0 # 初始比例

# 初始化两个归一化层

self.norm1 = norm1(dim)

self.norm2 = norm2(dim)

def forward(self, x):if self.training: # 如果处于训练模式if self.warm > 0: # 如果还有预热步数self.warm.copy_(self.warm - 1) # 减少预热步数x = self.norm1(x) # 使用 norm1 进行归一化else:# 计算当前的比例 lamdalamda = self.r0 * self.iter / self.total_stepif self.iter > 0:self.iter.copy_(self.iter - 1) # 减少迭代步数# 使用两个归一化层进行处理x1 = self.norm1(x)x2 = self.norm2(x)# 线性组合两个归一化的结果x = lamda * x1 + (1 - lamda) * x2else:# 如果不在训练模式,直接使用 norm2 进行归一化x = self.norm2(x)return x

代码说明:

RepBN 类:

该类实现了一个自定义的批量归一化层,除了标准的批量归一化外,还引入了一个可学习的参数 alpha,用于调整输入的影响。

LinearNorm 类:

该类实现了一个线性归一化机制,支持在训练过程中根据预热阶段和迭代次数动态调整归一化的方式。

norm1 和 norm2 是两个不同的归一化方法,可以在训练过程中进行线性组合,以便更好地适应模型的学习。

通过这种设计,模型在训练初期可以使用一种归一化方式,随着训练的进行逐渐过渡到另一种方式,从而提高模型的稳定性和性能。

这个程序文件定义了两个神经网络模块,分别是 RepBN 和 LinearNorm,它们都是基于 PyTorch 框架构建的。

首先,RepBN 类是一个自定义的批量归一化模块。它的构造函数 init 接受一个参数 channels,用于指定输入数据的通道数。在构造函数中,定义了一个可学习的参数 alpha,并初始化为 1,同时创建了一个标准的 1D 批量归一化层 bn。在 forward 方法中,输入张量 x 首先进行了维度转换,将通道维和序列维进行交换,以适应批量归一化的要求。接着,经过批量归一化处理后,输出结果与 alpha 乘以原始输入 x 相加,最后再进行一次维度转换以恢复原来的形状。这个模块的设计目的是在进行批量归一化的同时,保留原始输入信息,从而可能提高模型的表现。

接下来是 LinearNorm 类,它实现了一种线性归一化策略。构造函数中接受多个参数,包括 dim(输入的维度)、norm1 和 norm2(分别是两种归一化方法的类),以及一些控制训练过程的参数如 warm、step 和 r0。在构造函数中,使用 register_buffer 方法注册了一些常量,以便在模型训练过程中使用。forward 方法中,首先检查模型是否处于训练模式。如果是,并且 warm 参数大于 0,则进行第一次归一化(norm1),并减少 warm 的值。否则,计算一个线性权重 lamda,这个权重随着训练的进行而变化,接着分别对输入 x 进行两种归一化处理(norm1 和 norm2),然后根据 lamda 的值将两者线性组合。若模型不在训练模式下,则直接使用 norm2 进行归一化。这个模块的设计意图是通过逐步过渡到另一种归一化方法,来提高模型的稳定性和性能。

总体来说,这个文件实现了两种自定义的神经网络层,分别用于改进批量归一化和实现动态归一化策略,旨在提升深度学习模型的训练效果和性能。

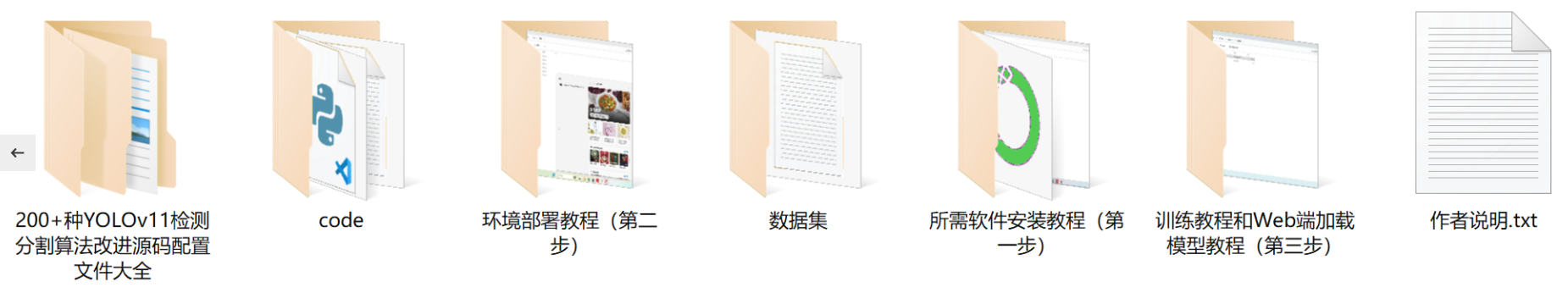

源码文件

源码获取

欢迎大家点赞、收藏、关注、评论啦 、查看👇🏻获取联系方式👇🏻