Science Robotics 通过人机交互强化学习进行精确而灵巧的机器人操作

机器人操作仍然是机器人技术中最困难的挑战之一,其方法范围从基于经典模型的控制到现代模仿学习。尽管这些方法已经取得了实质性进展,但它们通常需要大量的手动设计,在性能方面存在困难,并且需要大规模数据收集。这些限制阻碍了它们在实际世界中的大规模部署,其中可靠性、速度和稳健性至关重要。强化学习 (RL) 提供了一种强大的替代方案,它使机器人能够通过交互自主获得复杂的作技能。然而,由于样品效率和安全性问题,在现实世界中充分发挥 RL 的潜力仍然具有挑战性。强化学习 (RL) 是一种很有前途的方法,可以自主获取复杂而灵巧的机器人技能。通过反复试验学习,原则上,有效的 RL 方法应该能够获得针对部署任务的特定物理特征量身定制的高度熟练技能。这可能会带来不仅超过手工设计控制器的性能,而且超越人类远程作的性能。然而,由于样本复杂性、假设(例如,准确的奖励函数)和优化稳定性等问题,在现实环境中实现这一承诺一直具有挑战性。RL 方法对于模拟训练和现有大型真实世界数据集的训练非常有效,目的是泛化 。它们还与手工设计的功能或表示一起使用,用于狭隘的定制任务。然而,开发通用的、基于视觉的方法仍然具有挑战性,这些方法可以在不同的现实世界任务中有效地学习物理复杂的技能,同时超越 IL 和手工设计控制器的熟练程度。我们相信,在这方面取得根本性进展可以释放新的机会,从而推动真正高性能的机器人纵政策的发展。这里开发了一种用于基于视觉的作的 RL 系统,可以获得广泛的精确和灵巧的机器人技能。系统名为人机交互样本高效机器人强化学习 (HIL-SERL),通过集成许多组件来解决前面提到的挑战,这些组件可以在现实世界中实现有效的基于视觉的 RL 策略。为了解决优化稳定性问题,使用了预训练的可视化主干网进行策略学习。为了处理样本复杂性问题,使用了一种基于具有先验数据的 RL (RLPD)的样本效率非策略 RL 算法,该算法结合了人工演示和校正。此外,还包括一个精心设计的低级控制器,以确保政策培训期间的安全。

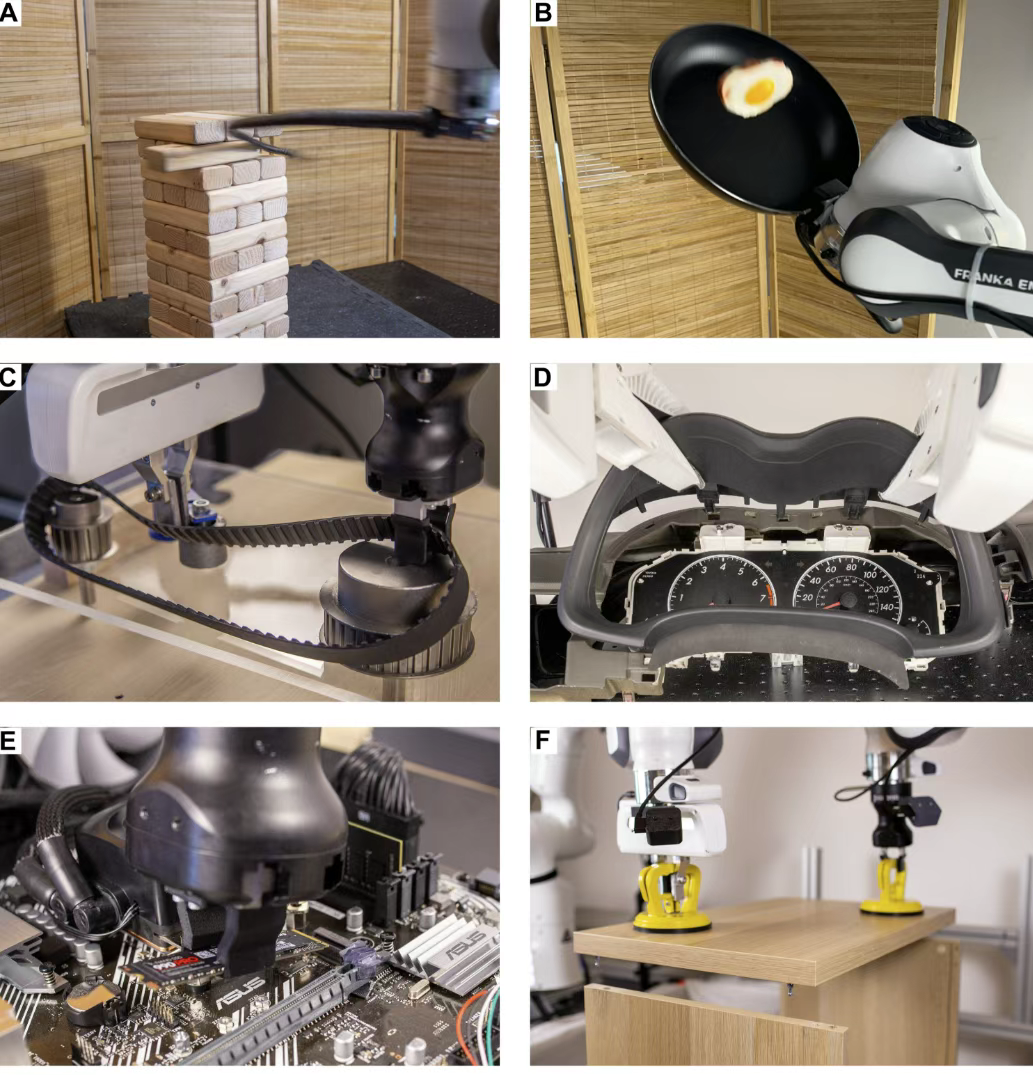

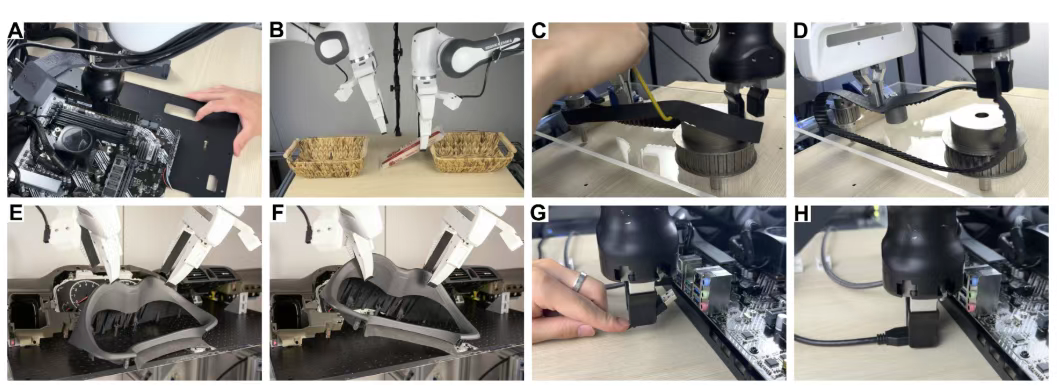

在训练期间,系统会向人工操作员询问潜在的更正,然后用于以非政策方式更新策略。研究发现,这种人机交互的纠正程序对于使策略能够从错误中吸取教训并提高绩效至关重要,特别是对于本文考虑的难以从头开始学习的具有挑战性的任务。如图 1 所示,系统解决的任务包括动态翻转平底锅中的对象;从塔上拿出叠叠乐块;在两只手臂之间交出物体;以及使用一个或两个机械臂组装复杂的设备,例如计算机主板、宜家搁板、汽车仪表板或正时皮带。这些任务在复杂错综复杂的动态、高维状态和动作空间、长视野或它们的组合方面提出了挑战。其中一些技能以前被认为无法直接在现实环境中使用 RL 进行训练,例如许多双臂作任务,或者几乎无法用当前的机器人方法克服,例如正时皮带组装或叠叠乐鞭打。此外,它们还需要不同类型的控制策略,例如用于精确作任务的反应性闭环控制或难以规定的精细开环行为,例如叠叠乐鞭打。然而,也许最出乎意料的发现是,系统可以训练 RL 策略,在现实世界中只有 1 小时到 2.5 小时的训练时间,在几乎所有任务上实现近乎完美的成功率和超人的周期时间,受制于初始放置的几厘米或程度变化。训练有素的 RL 策略大大优于在相同数量的人类数据上训练的 IL 方法,例如,相同数量的演示或纠正,平均成功率提高了 101%,周期时间缩短了 1.8×。这一结果很重要,因为它表明 RL 可以在实际培训时间内直接在现实世界中学习各种复杂的基于视觉的纵策略,这在以前被认为用早期方法是不可行的。此外,RL 的性能水平远远超过了 IL 和手工设计的控制器。图1.实验任务概述。本文考虑的任务子集,包括 (A) 从塔上取出叠叠乐块,(B) 翻转平底锅中的物体,以及组装复杂的设备,

例如 (C) 正时皮带、(D) 仪表板、(E) 主板和 (F) 宜家搁板。为了评估系统的有效性,将其与几种最先进的 RL 方法进行了比较,并进行了消融研究以了解每个组件的贡献。结果表明,系统不仅优于相关基线,而且还强调令人印象深刻的实证结果归功于这些组件的精心整合。此外,还对实证结果进行了全面分析,提供了对基于 RL 的作有效性的见解。该分析探讨了学习的 RL 策略的训练动态,并进一步检查了 RL 策略作为获取不同类型控制策略的通用基于愿景的策略的灵活性。总之,通过适当的系统级设计选择,RL 可以有效地解决现实世界中各种灵巧而复杂的基于视觉的作任务。系统支持从图像输入进行双臂协调,并处理诸如鞭打叠叠乐块和组装正时皮带等任务,展示了这种方法在不同作场景中的灵活性。在实际培训的 1 到 2.5 小时内,该方法优于其他基线,将任务成功率提高了 2×,实现了近乎完美的成功率,平均执行速度提高了 1.8×。通过广泛的实验和分析结果表明,RL可以在实际训练时间内直接在现实世界中学习各种复杂的基于视觉的纵策略。我们希望这项工作能够激发新一代学习的机器人操作技术,有利于工业应用和研究进步。