(论文速读)并行自回归视觉生成

论文题目:Parallelized Autoregressive Visual Generation(并行自回归视觉生成)

会议:CVPR2025

摘要:自回归模型已成为一种强大的视觉生成方法,但由于其顺序的逐个标记预测过程,导致推理速度慢。在本文中,我们提出了一种简单而有效的并行化自回归视觉生成方法,在保留自回归建模优点的同时提高了生成效率。我们的关键见解是,并行生成依赖于视觉令牌依赖关系——具有弱依赖关系的令牌可以并行生成,而强依赖的相邻令牌很难一起生成,因为它们的独立采样可能导致不一致。基于这一观察,我们开发了一种并行生成策略,该策略可以并行生成具有弱依赖关系的远程令牌,同时保持对强依赖的本地令牌的顺序生成。我们的方法可以无缝地集成到标准的自回归模型中,而无需修改体系结构或标记器。在ImageNet和UCF-101上的实验表明,我们的方法在图像和视频生成任务中都实现了3.6倍的加速和高达9.5倍的加速,并且质量下降最小。我们希望这项工作能够启发未来在高效视觉生成和统一自回归建模方面的研究。

项目页面:http://yuqingwang1029.github.io /PAR-project。

核心问题:自回归视觉生成的速度瓶颈

自回归模型在视觉生成任务中表现出色,具有强大的可扩展性和统一建模能力。然而,这类模型面临一个关键问题:推理速度过慢。传统方法需要按照栅格扫描顺序逐个生成视觉token,这种严格的序列化生成过程导致生成时间与序列长度成正比,严重限制了实际应用。

现有解决方案的局限性:

- 语言模型的并行方法(如speculative decoding)需要额外的辅助模型

- 专门的视觉方法(如VAR)需要特殊设计的多尺度tokenizer和更长的token序列

- 这些方法增加了模型复杂度,限制了自回归模型作为统一解决方案的灵活性

核心创新点

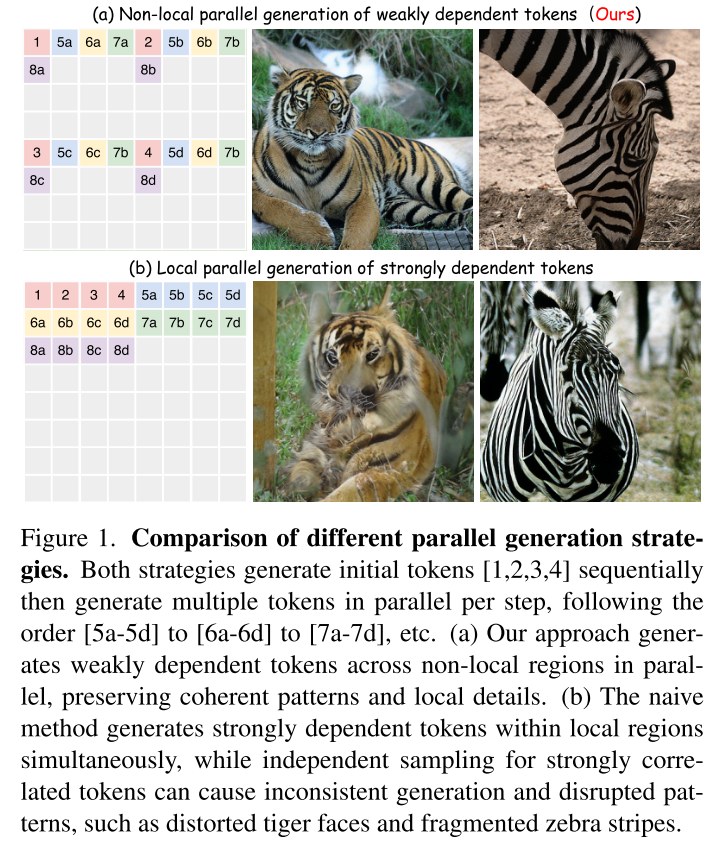

1. 关键洞察:token依赖关系决定并行生成可行性

论文提出了一个重要观察:并行生成的成功与否取决于视觉token之间的依赖强度

- 强依赖的相邻token:难以并行生成,独立采样会导致不一致性

- 弱依赖的远距离token:可以安全并行生成

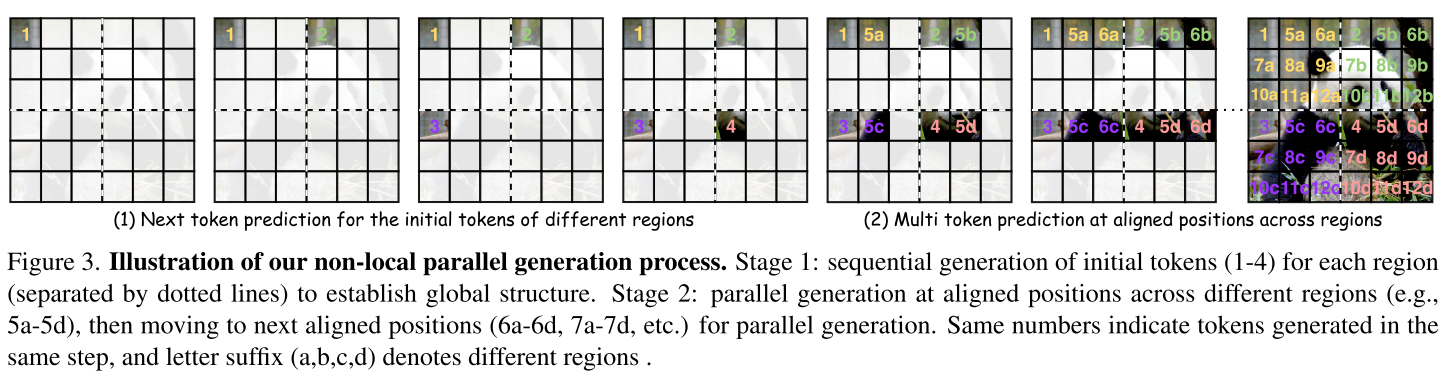

2. 非局部并行生成策略

核心思想: 生成空间距离远的弱相关token,而不是相邻的强相关token

具体实现:(见核心问题前的图像)

阶段1:顺序生成每个区域的初始token [1,2,3,4]

阶段2:并行生成对应位置的token [5a,5b,5c,5d] → [6a,6b,6c,6d] → ...

设计原理:

- 将图像划分为M×M个区域

- 初始token建立全局结构,必须顺序生成

- 后续token按对应位置跨区域并行生成

3. 架构集成方案

无缝集成: 无需修改标准transformer架构或tokenizer 关键技术:

- 2D旋转位置编码(RoPE)保持空间关系

- 组内双向注意力 + 组间因果注意力

- 可学习的过渡token帮助模式切换

实验结果

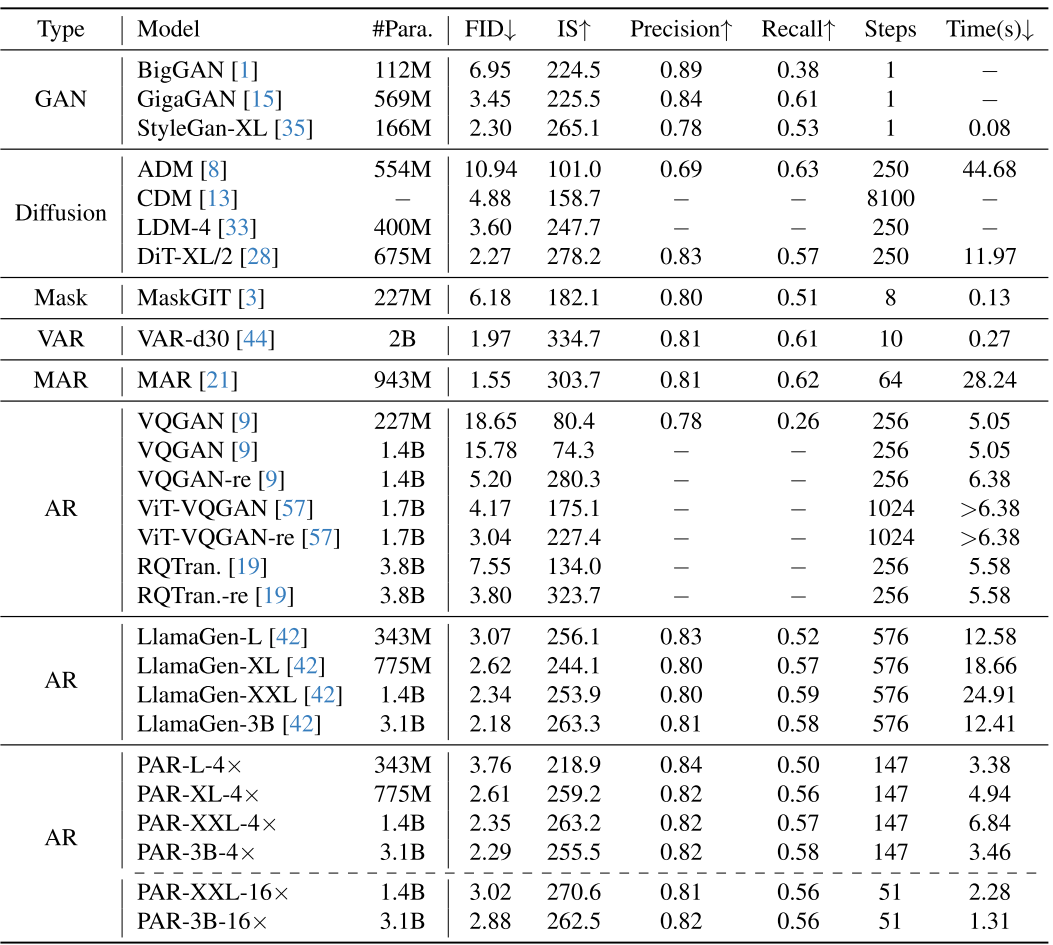

图像生成性能(ImageNet)

| 模型 | 生成步数 | 时间(秒) | FID | 加速比 |

|---|---|---|---|---|

| LlamaGen | 576 | 12.41 | 2.18 | 1× |

| PAR-4× | 147 | 3.46 | 2.29 | 3.6× |

| PAR-16× | 51 | 1.31 | 2.88 | 9.5× |

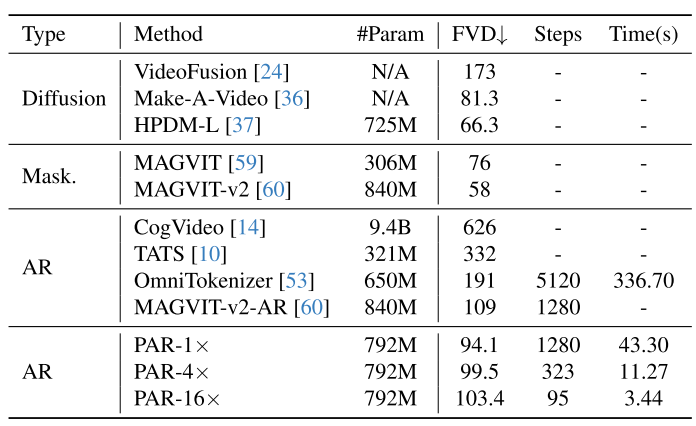

视频生成性能(UCF-101)

| 模型 | 生成步数 | 时间(秒) | FVD | 加速比 |

|---|---|---|---|---|

| PAR-1× | 1280 | 43.30 | 94.1 | 1× |

| PAR-4× | 323 | 11.27 | 99.5 | 3.8× |

| PAR-16× | 95 | 3.44 | 103.4 | 12.6× |