【habitat学习二】Habitat-Lab 快速入门指南(Quickstart)详解

1. 页面概述

Quickstart是Habitat-Lab 官方文档中的快速入门指南,专门针对希望快速了解和使用 Habitat 平台进行具身 AI(Embodied AI)研究的用户。页面内容主要分为两部分:Habitat 平台概述和一个具体的 PointNav 任务示例。本文将对页面内容进行极其详尽的解析,不遗漏任何技术细节、代码实现和使用说明。

2. Habitat 平台概述

2.1 Habitat 的定义与组成

页面开篇明确定义了 Habitat 是一个专为具身 AI 研究设计的平台,由两个核心组件构成:

2.1.1 Habitat-Sim

- 性质:灵活、高性能的 3D 模拟器

- 核心功能:

- 可配置的智能体(Agents)

- 多种传感器支持(RGB、深度、语义等)

- 通用 3D 数据集处理能力

- 内置对 MatterPort3D、Gibson 等主流数据集的支持

- 技术定位:底层物理和图形渲染引擎

- 代码库链接:文档中明确标注了

[github-repo]标记,指向 Habitat-Sim 的 GitHub 仓库(https://github.com/facebookresearch/habitat-sim)

2.1.2 Habitat Lab

- 性质:模块化的高级库

- 核心功能:

- 定义具身 AI 任务(导航、指令跟随、问答等)

- 配置具身智能体(物理形态、传感器、能力)

- 训练智能体(通过模仿学习、强化学习或传统方法如 SLAM)

- 使用标准指标评估智能体性能

- 技术定位:任务定义、训练和评估的高层框架

- 代码库链接:同样标注了

[github-repo]标记,指向 Habitat-Lab 的 GitHub 仓库(https://github.com/facebookresearch/habitat-lab)

2.2 安装要求

- 明确说明:安装 Habitat-Sim 和 Habitat-Lab 需遵循特定安装说明(页面提供了"follow instructions here"链接,指向完整的安装指南)

- 数据要求:需要下载场景数据(安装说明中提供具体步骤)

- 额外依赖:示例代码需要 OpenCV(通过

pip install opencv-python安装)

3. 示例详解:PointNav 任务

3.1 任务定义

- 任务名称:PointNav(点目标导航任务)

- 任务目标:智能体需从源位置导航到目标位置

- 本示例特点:

- 智能体由用户(操作者)亲自控制

- 用户通过键盘按键在环境中移动

- 提供实时视觉反馈和导航信息

3.2 运行前提条件

页面明确列出运行此示例的所有必要条件:

- Habitat-Sim 成功安装:提供物理模拟和渲染能力

- Habitat-Lab 成功安装:提供任务框架和环境接口

- 场景数据已下载:包括 MatterPort3D 或 Gibson 等 3D 场景

- OpenCV 安装:通过

pip install opencv-python安装,用于图像显示

3.3 完整代码解析

3.3.1 导入库

import habitat

from habitat.sims.habitat_simulator.actions import HabitatSimActions

import cv2

- habitat:主模块,提供环境创建和管理功能

- HabitatSimActions:从模拟器中导入预定义动作(关键动作枚举)

- cv2:OpenCV 库,用于图像显示和处理

3.3.2 定义按键常量

FORWARD_KEY="w"

LEFT_KEY="a"

RIGHT_KEY="d"

FINISH="f"

- 设计目的:将按键映射到具体动作,提高代码可读性

- 按键映射:

- “w” → 前进(Forward)

- “a” → 左转(Left)

- “d” → 右转(Right)

- “f” → 结束任务(Finish)

3.3.3 图像格式转换函数

def transform_rgb_bgr(image):return image[:, :, [2, 1, 0]]

- 功能:将 RGB 格式图像转换为 BGR 格式

- 技术原因:Habitat 使用 RGB 格式,而 OpenCV 默认使用 BGR 格式

- 实现细节:通过 NumPy 数组切片操作

[2, 1, 0]交换颜色通道顺序 - 关键性:若省略此步骤,图像颜色会显示异常(红色和蓝色通道互换)

3.3.4 主函数:example()

def example():env = habitat.Env(config=habitat.get_config("benchmark/nav/pointnav/pointnav_habitat_test.yaml"))print("Environment creation successful")

- 环境创建:

- 使用

habitat.Env初始化环境 - 配置文件路径:

benchmark/nav/pointnav/pointnav_habitat_test.yaml - 关键细节:该配置文件定义了 PointNav 任务的所有参数,包括:

- 使用的场景

- 智能体传感器配置

- 任务成功条件

- 最大步数限制等

- 使用

3.3.4.1 初始化与重置环境

observations = env.reset()

print("Destination, distance: {:3f}, theta(radians): {:.2f}".format(observations["pointgoal_with_gps_compass"][0],observations["pointgoal_with_gps_compass"][1]))

cv2.imshow("RGB", transform_rgb_bgr(observations["rgb"]))

- env.reset():

- 重置环境到新 episode 的初始状态

- 返回初始观察值(observations 字典)

- 观察字典内容:

pointgoal_with_gps_compass:目标点的极坐标表示- 索引 0:到目标的欧氏距离(米)

- 索引 1:到目标的角度(弧度,相对于智能体朝向)

rgb:当前视角的 RGB 图像(H×W×3 numpy 数组)

- 输出信息:

- 精确打印距离(3位小数)和角度(2位小数)

- 显示 RGB 图像窗口,标题为 “RGB”

3.3.4.2 交互循环

print("Agent stepping around inside environment.")

count_steps = 0

while not env.episode_over:keystroke = cv2.waitKey(0)# ... [按键处理] ...observations = env.step(action)count_steps += 1# ... [更新显示] ...

- 循环条件:

while not env.episode_overenv.episode_over:布尔值,表示当前 episode 是否结束- 结束条件包括:

- 智能体执行 STOP 动作

- 达到最大步数限制(默认 500 步)

- 达到任务成功/失败条件

- 按键等待:

cv2.waitKey(0)- 参数 0 表示无限期等待按键

- 返回按键的 ASCII 码值

- 步数计数器:

count_steps跟踪已执行的动作数量

3.3.4.3 按键处理逻辑

if keystroke == ord(FORWARD_KEY):action = HabitatSimActions.move_forwardprint("action: FORWARD")

elif keystroke == ord(LEFT_KEY):action = HabitatSimActions.turn_leftprint("action: LEFT")

elif keystroke == ord(RIGHT_KEY):action = HabitatSimActions.turn_rightprint("action: RIGHT")

elif keystroke == ord(FINISH):action = HabitatSimActions.stopprint("action: FINISH")

else:print("INVALID KEY")continue

- 按键检测:使用

ord()将字符常量转换为 ASCII 码进行比较 - 动作映射:

HabitatSimActions.move_forward:向前移动固定距离(默认 0.25 米)HabitatSimActions.turn_left:向左旋转固定角度(默认 10 度)HabitatSimActions.turn_right:向右旋转固定角度(默认 10 度)HabitatSimActions.stop:停止并结束 episode

- 错误处理:无效按键会打印 “INVALID KEY” 并跳过本次循环

3.3.4.4 执行动作与更新显示

observations = env.step(action)

count_steps += 1

print("Destination, distance: {:3f}, theta(radians): {:.2f}".format(observations["pointgoal_with_gps_compass"][0],observations["pointgoal_with_gps_compass"][1]))

cv2.imshow("RGB", transform_rgb_bgr(observations["rgb"]))

- env.step(action):

- 执行指定动作

- 返回新的观察值字典

- 更新内部状态(位置、朝向等)

- 实时反馈:

- 更新打印目标距离和角度

- 更新显示当前视角的 RGB 图像

3.3.4.5 任务完成评估

print("Episode finished after {} steps.".format(count_steps))

if (action == HabitatSimActions.stop and observations["pointgoal_with_gps_compass"][0] < 0.2):print("you successfully navigated to destination point")

else:print("your navigation was unsuccessful")

- 成功条件:

- 执行了 STOP 动作(

action == HabitatSimActions.stop) - 当前到目标的距离小于 0.2 米(

observations["pointgoal_with_gps_compass"][0] < 0.2)

- 执行了 STOP 动作(

- 失败条件:

- 未执行 STOP 动作而 episode 结束(如达到最大步数)

- 执行 STOP 动作但距离目标 ≥ 0.2 米

- 步数报告:显示完成 episode 所用的总步数

3.3.4.6 主程序入口

if __name__ == "__main__":example()

- 标准 Python 惯用写法:确保模块被直接运行时才执行 example 函数

- 可导入性:允许其他脚本导入此文件而不立即执行

3.4 运行说明与行为细节

页面提供了极其详细的运行说明:

3.4.1 控制方式

- W 键:前进(move forward)

- A 键:左转(turn left)

- D 键:右转(turn right)

- F 键:停止并结束任务(stop and finish)

3.4.2 终端输出信息

- 目标信息格式:

Destination, distance: {:3f}, theta(radians): {:.2f}- 距离:以米为单位,3位小数精度

- 角度:以弧度为单位,2位小数精度

- 角度定义:从智能体正前方开始测量的偏角(0 弧度表示目标在正前方)

3.4.3 成功与失败条件

- 成功条件:

- 距离目标 < 0.2 米

- 主动按下 F 键执行 STOP 动作

- 终端显示:“you successfully navigated to destination point”

- 失败条件(任一满足即失败):

- 按下 F 键但距离目标 ≥ 0.2 米

- 未主动停止,但达到最大步数限制(500 步)

- 终端显示:“your navigation was unsuccessful”

3.4.4 环境限制

- 最大步数:500 步(硬编码在配置文件中)

- 距离阈值:0.2 米(任务成功判定阈值)

- 旋转角度:每次 10 度(默认配置)

- 移动距离:每次 0.25 米(默认配置)

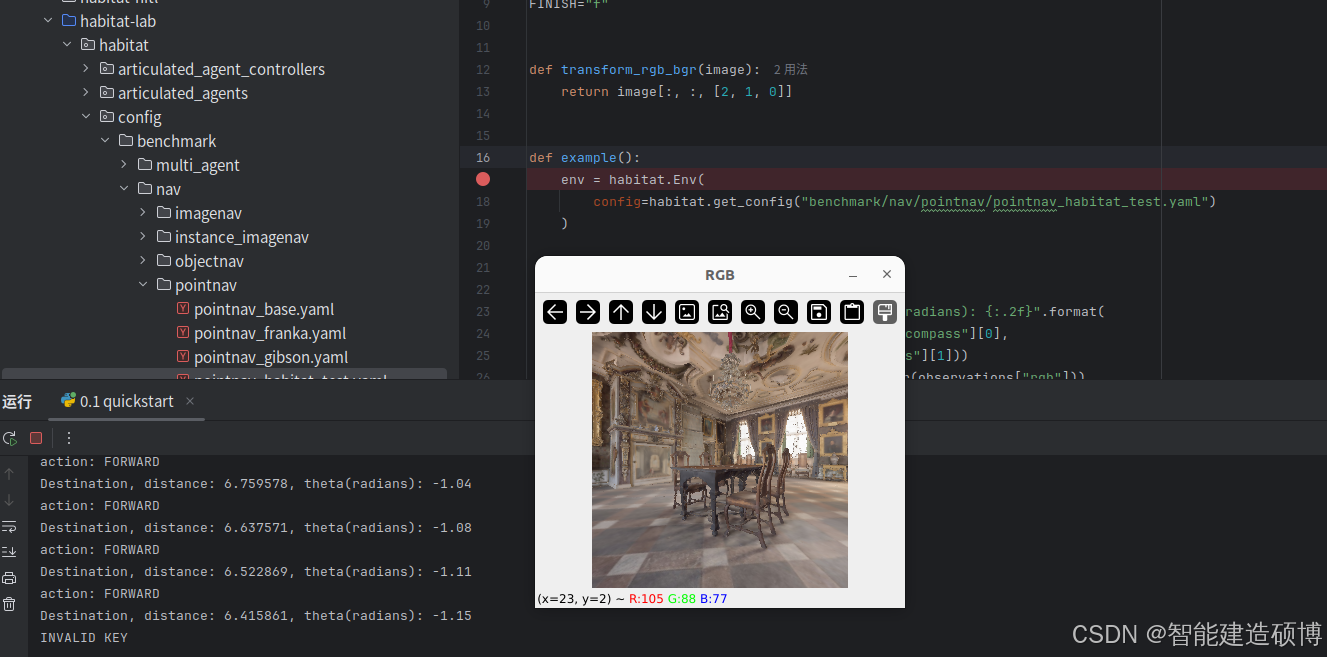

3.5 示例输出可视化

页面包含一张截图(quickstart.png),展示了:

- 左侧窗口:RGB 视图,显示智能体当前视角

- 右侧终端:

- 初始目标信息:距离和角度

- 用户操作记录("action: FORWARD"等)

- 最终任务结果(成功/失败信息)

- 交互过程:清晰展示了从开始到结束的完整交互流程

4. 技术细节深度解析

4.1 配置文件路径分析

- 完整路径:

benchmark/nav/pointnav/pointnav_habitat_test.yaml - 目录结构含义:

benchmark/:基准测试配置nav/:导航任务类别pointnav/:点目标导航具体任务pointnav_habitat_test.yaml:测试用配置文件

- 配置内容:该文件定义了:

- 使用的场景数据集

- 智能体传感器配置(默认包含 RGB 传感器)

- 任务参数(成功距离阈值、最大步数等)

- 模拟器参数(物理特性、渲染质量等)

4.2 观察空间结构

- pointgoal_with_gps_compass:

- 2 维向量:[距离, 角度]

- 距离:欧氏距离(米),范围 [0, ∞)

- 角度:弧度值,范围 [-π, π],0 表示正前方

- 技术实现:结合 GPS(位置)和指南针(朝向)信息计算

- rgb:

- 3D NumPy 数组:形状为 (H, W, 3)

- 数据类型:uint8(0-255 范围)

- 颜色顺序:RGB(与 OpenCV 的 BGR 相反)

4.3 动作空间详解

- move_forward:

- 移动距离:默认 0.25 米

- 物理约束:受场景碰撞检测限制

- 失败处理:若前方有障碍物,移动会被阻止

- turn_left/turn_right:

- 旋转角度:默认 10 度(π/18 弧度)

- 旋转中心:智能体位置

- 无碰撞检测(纯朝向变化)

4.4 环境生命周期

- 初始化:

habitat.Env(config=...)加载配置 - 重置:

env.reset()创建新 episode,返回初始观察 - 交互:循环执行

env.step(action)直到 episode 结束 - 终止:

env.episode_over变为 True,结束循环 - 资源释放:Python 垃圾回收自动处理(Habitat 会正确清理模拟器资源)

4.5 错误处理机制

- 无效按键:打印 “INVALID KEY” 并继续等待

- 边界条件:

- 移动到场景边界:自动停止(碰撞检测)

- 旋转超过 360 度:角度值自动归一化到 [-π, π]

- 异常处理:示例代码未显式处理异常,但 Habitat 内部有完善的错误检查

5. 实践建议与注意事项

5.1 常见问题排查

- 场景未加载:

- 现象:环境创建失败或黑屏

- 解决:确认场景数据已下载到正确路径

- 图像颜色异常:

- 现象:红色和蓝色通道互换

- 解决:确保使用

transform_rgb_bgr函数

- 按键无响应:

- 现象:OpenCV 窗口无焦点

- 解决:点击 OpenCV 窗口使其获得焦点

5.2 参数调整建议

- 调整移动距离:修改配置文件中的

SIMULATOR.ACTION_SPACE_CONFIG - 更改传感器:在配置文件中添加/修改

SIMULATOR.AGENT_0.SENSORS - 修改成功阈值:调整

TASK.SUCCESS_DISTANCE参数

5.3 扩展示例

- 添加深度传感器:在配置文件中添加

"DepthSensor" - 添加语义传感器:需确保场景有语义标注,添加

"SemanticSensor" - 自动导航代理:替换键盘控制为简单算法(如向目标直线移动)

6. 与 Habitat 生态系统的关联

6.1 配置系统集成

- 该示例直接使用 Habitat 的 YAML 配置系统

- 配置文件继承自 Habitat 的标准任务配置

- 支持通过命令行覆盖配置参数

6.2 与 Habitat-Sim 的交互

HabitatSimActions直接映射到 Habitat-Sim 的底层动作- 观察数据(RGB 图像)由 Habitat-Sim 渲染生成

- 物理模拟和碰撞检测由 Habitat-Sim 处理

6.3 评估指标基础

- 此示例中使用的

pointgoal_with_gps_compass是更复杂评估指标(如 SPL)的基础 - 成功条件(<0.2m)与 Habitat Challenge 标准一致

7. 教育价值与研究意义

7.1 教学价值

- 直观理解具身 AI:用户亲自体验导航挑战

- 观察-动作循环:清晰展示感知-决策-行动闭环

- 空间推理训练:理解距离、角度与导航的关系

7.2 研究基础

- 基准测试起点:此示例是 PointNav 基准测试的基础

- 算法开发平台:可扩展为自动化代理的测试环境

- 参数敏感性分析:可研究不同成功阈值对性能的影响

8. 技术限制与注意事项

8.1 性能限制

- 实时性:依赖硬件性能,复杂场景可能导致帧率下降

- 内存使用:高分辨率传感器会增加内存消耗

- 物理精度:简化物理模型可能与现实有差异

8.2 使用限制

- 单智能体:此示例仅支持一个智能体

- 预定义动作:仅支持离散动作(前进、转向)

- 固定场景:测试配置使用固定场景(van-gogh-room)

8.3 开发注意事项

- 配置优先:应优先通过配置文件而非硬编码修改参数

- 资源管理:长时间运行需注意模拟器资源释放

- 跨平台差异:不同操作系统下 OpenCV 行为可能略有不同

通过此指南,研究人员和开发者可以在 5 分钟内:

- 安装必要依赖

- 运行第一个具身 AI 环境

- 亲身体验导航任务挑战

- 理解 Habitat 的核心工作流程