【完整源码+数据集+部署教程】空中目标检测系统源码和数据集:改进yolo11-UniRepLKNetBlock

背景意义

研究背景与意义

随着无人机技术的迅猛发展,空中目标检测在军事、民用和环境监测等领域的应用日益广泛。无人机不仅可以用于监视和侦察,还能在灾害救援、交通监控以及生态保护等方面发挥重要作用。因此,构建一个高效、准确的空中目标检测系统显得尤为重要。现有的目标检测算法在处理复杂环境下的目标识别时,往往面临着准确率低、实时性差等问题,亟需通过改进算法来提升其性能。

本研究旨在基于改进的YOLOv11算法,开发一个针对空中目标的检测系统。该系统将专注于识别三类目标:飞机、鸟类和无人机。这三类目标在空中场景中具有不同的特征和行为模式,针对性地优化检测算法,将有助于提高系统的整体识别能力。为此,我们将利用包含4500张图像的“Drone_Bird_Aircraft”数据集进行训练和测试。该数据集不仅涵盖了多种空中目标,还提供了丰富的标注信息,为模型的训练提供了坚实的基础。

在技术层面,YOLO系列算法以其高效的实时检测能力和较高的准确率受到广泛关注。通过对YOLOv11的改进,我们将结合最新的深度学习技术,探索更为精细的特征提取和目标定位方法,以提升模型在复杂空中环境中的表现。此外,针对不同目标的特征差异,我们将设计特定的训练策略,以实现更为精准的目标检测。

本研究的成果不仅将推动空中目标检测技术的发展,还将为相关领域的应用提供理论支持和实践指导。通过构建一个高效的空中目标检测系统,我们希望能够为无人机的智能化应用提供更为可靠的技术保障,从而促进无人机技术的广泛应用与发展。

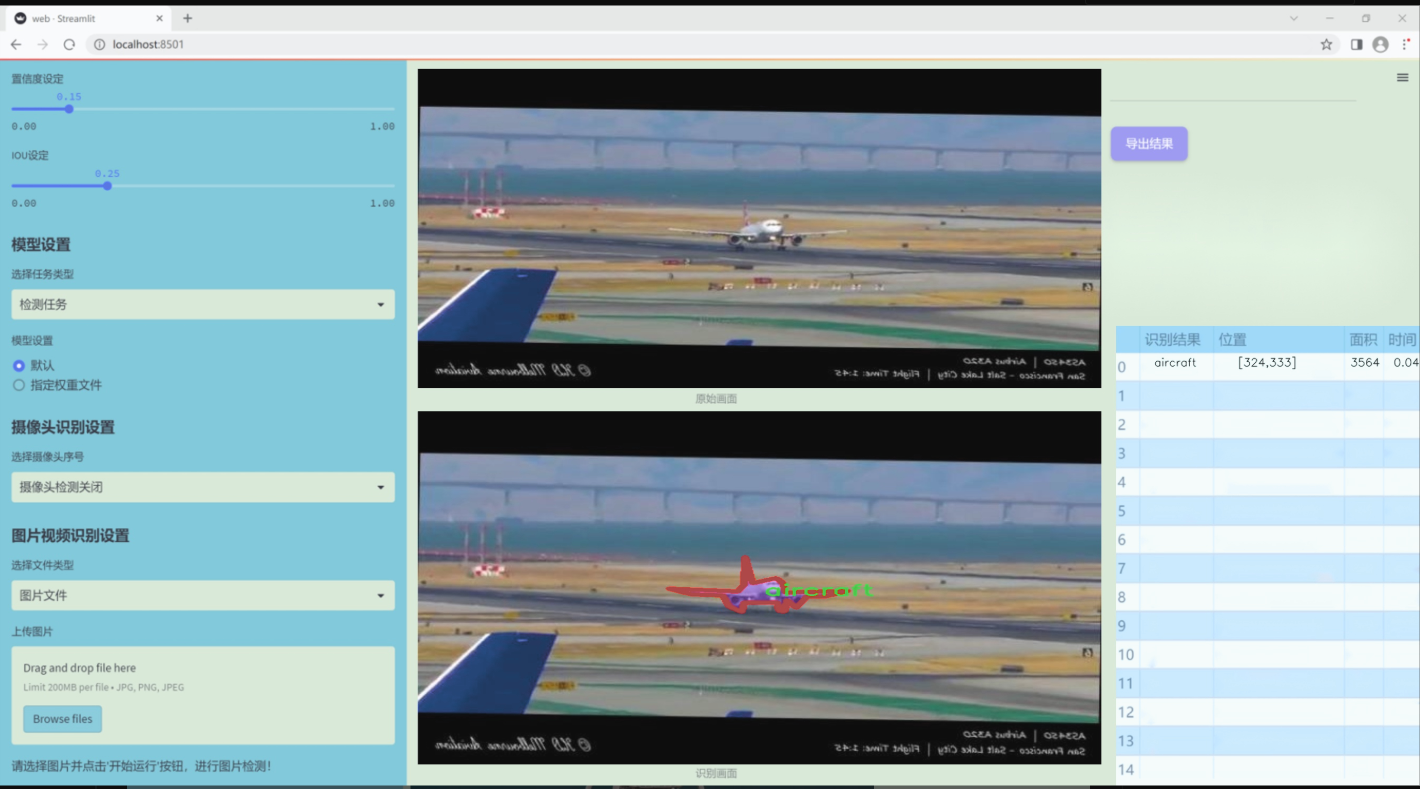

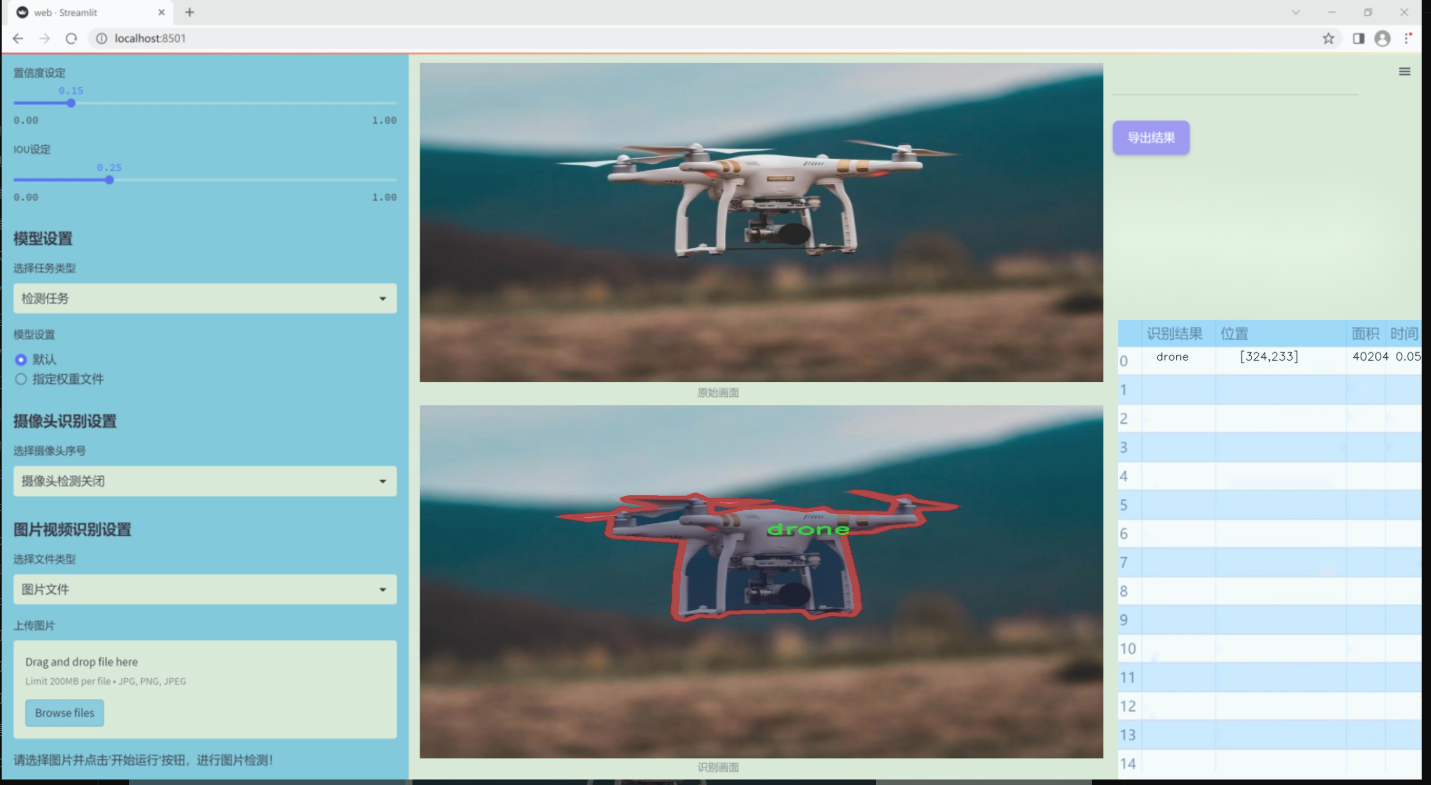

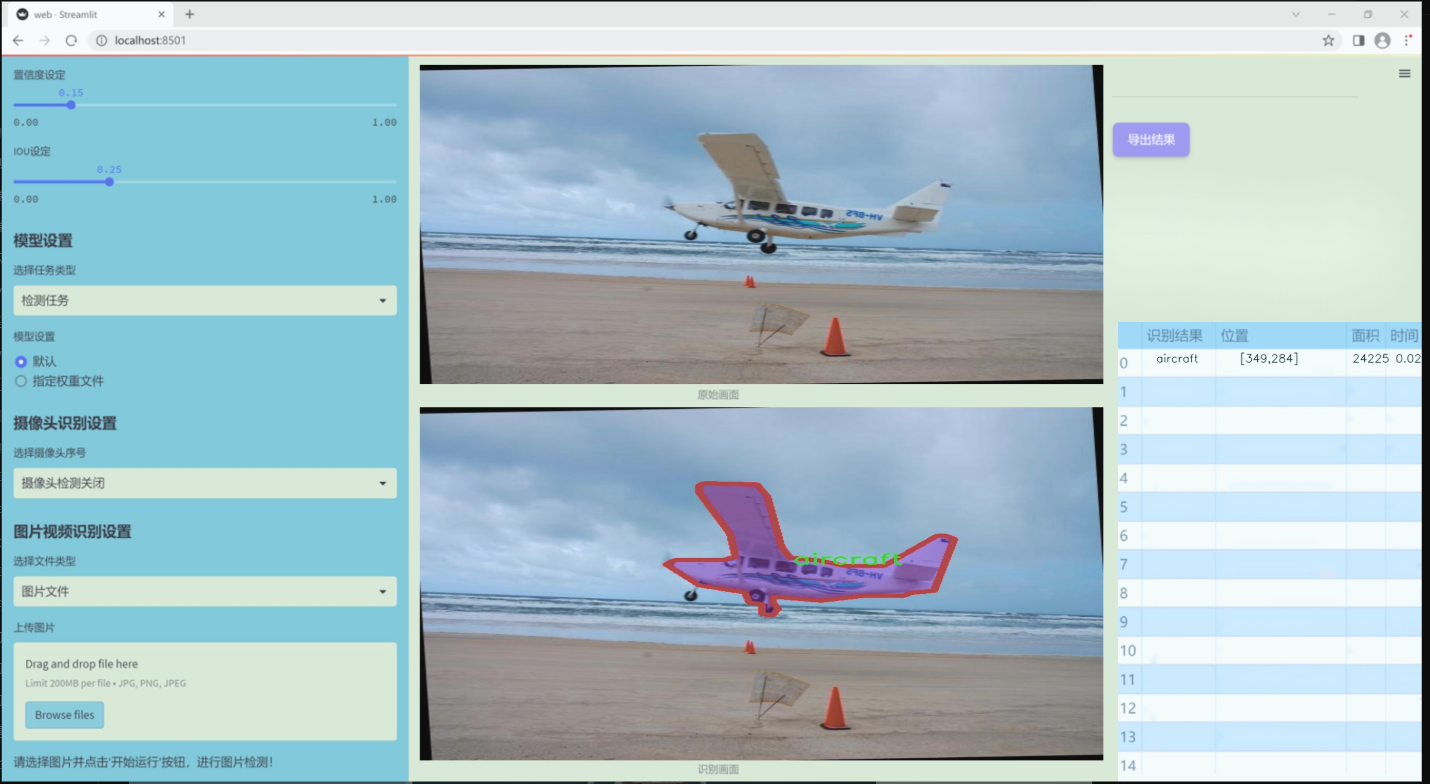

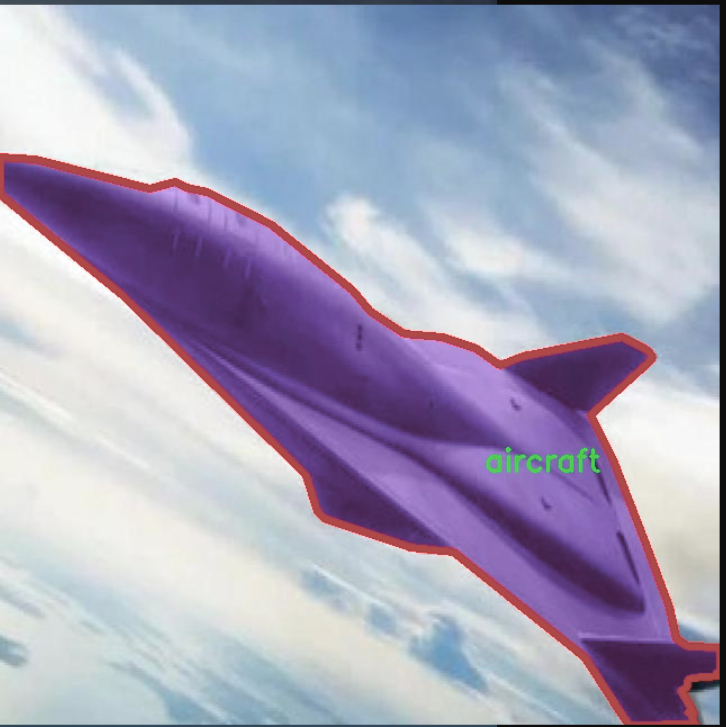

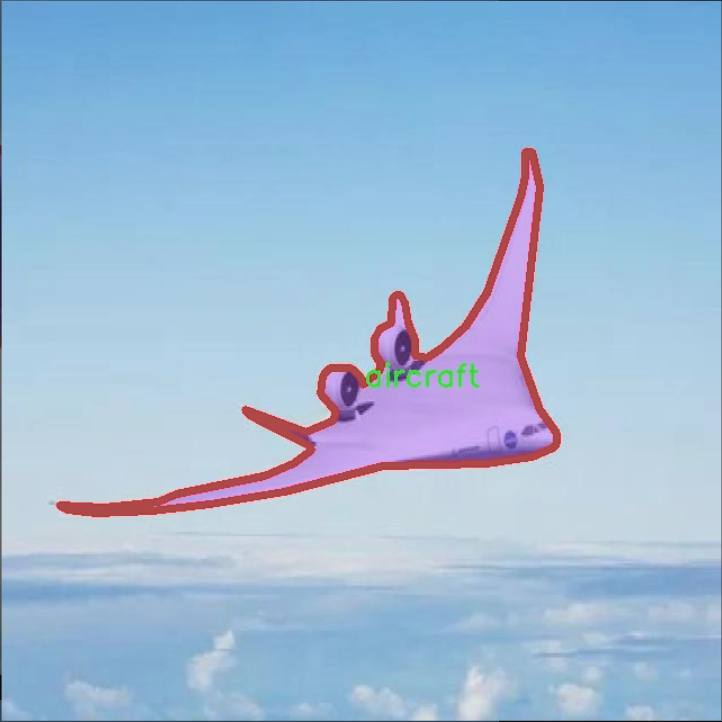

图片效果

数据集信息

本项目数据集信息介绍

本项目所使用的数据集专注于空中目标检测,旨在为改进YOLOv11算法提供丰富的训练素材。数据集的主题为“Drone_Bird_Aircraft”,涵盖了三种主要类别:飞机(aircraft)、鸟类(bird)和无人机(drone)。这些类别的选择不仅反映了现代空中交通的多样性,也为算法在复杂环境中的应用提供了广泛的测试场景。

在数据集的构建过程中,研究团队精心收集了来自不同环境和条件下的图像,以确保数据的多样性和代表性。飞机类图像包括商用飞机、私人飞机及军用飞机等多种类型,涵盖了不同的飞行高度和角度;鸟类图像则选取了多种常见鸟类的飞行状态,旨在模拟自然环境中的空中目标;无人机类图像则包括了多种型号的无人机,反映了当前无人机技术的快速发展。

数据集的设计考虑到了不同光照、天气条件及背景复杂度对目标检测的影响,使得训练出的模型能够在各种实际应用场景中保持高效的检测性能。通过对这三类目标的深入分析与研究,数据集不仅为算法的训练提供了基础,也为后续的性能评估和优化奠定了坚实的基础。

总之,本项目的数据集在类别数量和多样性上均表现出色,旨在为空中目标检测领域的研究提供有力支持。通过使用这一数据集,研究人员希望能够显著提升YOLOv11在空中目标检测任务中的准确性和鲁棒性,为无人机监控、航空安全等应用领域的进一步发展做出贡献。

核心代码

以下是经过简化和注释的核心代码部分,保留了模型的主要结构和功能:

import torch

import torch.nn as nn

from timm.models.layers import SqueezeExcite

def _make_divisible(v, divisor, min_value=None):

“”"

确保所有层的通道数是可被8整除的。

:param v: 输入的通道数

:param divisor: 需要整除的数

:param min_value: 最小值

:return: 处理后的通道数

“”"

if min_value is None:

min_value = divisor

new_v = max(min_value, int(v + divisor / 2) // divisor * divisor)

if new_v < 0.9 * v: # 确保向下取整不会超过10%

new_v += divisor

return new_v

class Conv2d_BN(nn.Sequential):

“”"

带有BatchNorm的卷积层

“”"

def init(self, in_channels, out_channels, kernel_size=1, stride=1, padding=0, dilation=1, groups=1):

super().init()

# 添加卷积层

self.add_module(‘conv’, nn.Conv2d(in_channels, out_channels, kernel_size, stride, padding, dilation, groups, bias=False))

# 添加BatchNorm层

self.add_module(‘bn’, nn.BatchNorm2d(out_channels))

@torch.no_grad()

def fuse_self(self):"""融合卷积层和BatchNorm层为一个卷积层"""conv, bn = self._modules.values()# 计算融合后的权重和偏置w = bn.weight / (bn.running_var + bn.eps)**0.5w = conv.weight * w[:, None, None, None]b = bn.bias - bn.running_mean * bn.weight / (bn.running_var + bn.eps)**0.5# 创建新的卷积层fused_conv = nn.Conv2d(w.size(1) * conv.groups, w.size(0), w.shape[2:], stride=conv.stride, padding=conv.padding, dilation=conv.dilation, groups=conv.groups)fused_conv.weight.data.copy_(w)fused_conv.bias.data.copy_(b)return fused_conv

class RepViTBlock(nn.Module):

“”"

RepViT的基本块

“”"

def init(self, inp, hidden_dim, oup, kernel_size, stride, use_se, use_hs):

super(RepViTBlock, self).init()

self.identity = stride == 1 and inp == oup # 判断是否为身份映射

assert(hidden_dim == 2 * inp) # 隐藏层维度是输入的两倍

if stride == 2:# 当步幅为2时,使用卷积和SqueezeExciteself.token_mixer = nn.Sequential(Conv2d_BN(inp, inp, kernel_size, stride, (kernel_size - 1) // 2, groups=inp),SqueezeExcite(inp, 0.25) if use_se else nn.Identity(),Conv2d_BN(inp, oup, ks=1, stride=1, pad=0))else:assert(self.identity)# 当步幅为1时,使用RepVGGDWself.token_mixer = nn.Sequential(RepVGGDW(inp),SqueezeExcite(inp, 0.25) if use_se else nn.Identity(),)# 通道混合器self.channel_mixer = Residual(nn.Sequential(Conv2d_BN(oup, hidden_dim, 1, 1, 0),nn.GELU() if use_hs else nn.GELU(),Conv2d_BN(hidden_dim, oup, 1, 1, 0)))def forward(self, x):return self.channel_mixer(self.token_mixer(x))

class RepViT(nn.Module):

“”"

RepViT模型

“”"

def init(self, cfgs):

super(RepViT, self).init()

self.cfgs = cfgs # 配置参数

layers = []

# 构建初始层input_channel = self.cfgs[0][2]patch_embed = nn.Sequential(Conv2d_BN(3, input_channel // 2, 3, 2, 1), nn.GELU(),Conv2d_BN(input_channel // 2, input_channel, 3, 2, 1))layers.append(patch_embed)# 构建RepViT块for k, t, c, use_se, use_hs, s in self.cfgs:output_channel = _make_divisible(c, 8)exp_size = _make_divisible(input_channel * t, 8)layers.append(RepViTBlock(input_channel, exp_size, output_channel, k, s, use_se, use_hs))input_channel = output_channelself.features = nn.ModuleList(layers)def forward(self, x):for f in self.features:x = f(x)return x

def repvit_m2_3(weights=‘’):

“”"

构建RepViT模型

“”"

cfgs = [

# k, t, c, SE, HS, s

[3, 2, 80, 1, 0, 1],

[3, 2, 80, 0, 0, 1],

# 省略其他配置…

]

model = RepViT(cfgs)

if weights:

model.load_state_dict(torch.load(weights)[‘model’])

return model

if name == ‘main’:

model = repvit_m2_3(‘repvit_m2_3_distill_450e.pth’) # 加载模型

inputs = torch.randn((1, 3, 640, 640)) # 随机输入

res = model(inputs) # 前向传播

for i in res:

print(i.size()) # 输出每层的尺寸

代码说明:

_make_divisible: 确保通道数是8的倍数。

Conv2d_BN: 定义一个带BatchNorm的卷积层,并提供融合功能。

RepViTBlock: 代表ViT的基本块,包含token混合和通道混合的逻辑。

RepViT: 构建整个RepViT模型,包含多个RepViTBlock。

repvit_m2_3: 构建特定配置的RepViT模型,并可加载预训练权重。

这段代码实现了一个基于RepViT架构的深度学习模型,适用于图像处理任务。

这个程序文件 repvit.py 实现了一个基于 RepVGG 结构的视觉模型,主要用于图像分类等任务。代码中包含了多个类和函数,下面是对其主要部分的讲解。

首先,文件导入了必要的库,包括 PyTorch 的神经网络模块 torch.nn、NumPy、以及 timm 库中的 SqueezeExcite 层。然后定义了一个 all 列表,列出了可以从该模块导入的模型名称。

接下来,定义了一个 replace_batchnorm 函数,该函数用于遍历网络的所有子模块,并将 BatchNorm2d 层替换为 Identity 层,以便在推理时提高效率。同时,如果子模块具有 fuse_self 方法,则会调用该方法进行融合。

_make_divisible 函数用于确保每一层的通道数是 8 的倍数,这对于某些模型架构(如 MobileNet)是必要的。它通过向上取整和下取整的方式来实现这一点。

Conv2d_BN 类是一个自定义的卷积层,包含卷积操作和 BatchNorm。它在初始化时会对 BatchNorm 的权重进行常数初始化,并提供了一个 fuse_self 方法来融合卷积和 BatchNorm 层,以提高推理速度。

Residual 类实现了残差连接,允许在训练时使用随机丢弃(dropout)来增强模型的鲁棒性。它同样提供了 fuse_self 方法,用于融合卷积层和残差连接。

RepVGGDW 类实现了一个特定的卷积块,结合了深度可分离卷积和残差连接。它的 forward 方法定义了前向传播的计算过程。

RepViTBlock 类是 RepViT 的基本构建块,包含了 token mixer 和 channel mixer 的结构。根据步幅的不同,它会选择不同的结构来处理输入。

RepViT 类是整个模型的主体,负责构建模型的各个层。它根据配置参数(如卷积核大小、扩展因子、输出通道数等)构建多个 RepViTBlock,并在 forward 方法中定义了前向传播过程。

此外,switch_to_deploy 方法用于将模型切换到推理模式,调用 replace_batchnorm 函数以提高推理效率。

update_weight 函数用于更新模型的权重,确保新权重与模型结构相匹配。

最后,定义了一系列函数(如 repvit_m0_9、repvit_m1_0 等)用于构建不同配置的 RepViT 模型,并可以选择加载预训练权重。

在文件的最后部分,使用 if name == ‘main’: 块来测试模型的构建和前向传播,生成随机输入并输出各层的尺寸。

总体而言,这个文件实现了一个灵活且高效的视觉模型架构,适用于各种图像处理任务。

10.4 starnet.py

以下是经过简化并添加详细中文注释的核心代码部分:

import torch

import torch.nn as nn

from timm.models.layers import DropPath, trunc_normal_

定义一个卷积层和批归一化层的组合

class ConvBN(torch.nn.Sequential):

def init(self, in_planes, out_planes, kernel_size=1, stride=1, padding=0, dilation=1, groups=1, with_bn=True):

super().init()

# 添加卷积层

self.add_module(‘conv’, torch.nn.Conv2d(in_planes, out_planes, kernel_size, stride, padding, dilation, groups))

# 如果需要,添加批归一化层

if with_bn:

self.add_module(‘bn’, torch.nn.BatchNorm2d(out_planes))

# 初始化批归一化层的权重和偏置

torch.nn.init.constant_(self.bn.weight, 1)

torch.nn.init.constant_(self.bn.bias, 0)

定义网络中的基本模块

class Block(nn.Module):

def init(self, dim, mlp_ratio=3, drop_path=0.):

super().init()

# 深度可分离卷积

self.dwconv = ConvBN(dim, dim, 7, 1, (7 - 1) // 2, groups=dim, with_bn=True)

# 线性变换

self.f1 = ConvBN(dim, mlp_ratio * dim, 1, with_bn=False)

self.f2 = ConvBN(dim, mlp_ratio * dim, 1, with_bn=False)

self.g = ConvBN(mlp_ratio * dim, dim, 1, with_bn=True)

self.dwconv2 = ConvBN(dim, dim, 7, 1, (7 - 1) // 2, groups=dim, with_bn=False)

self.act = nn.ReLU6() # 激活函数

self.drop_path = DropPath(drop_path) if drop_path > 0. else nn.Identity() # 随机深度

def forward(self, x):input = x # 保存输入x = self.dwconv(x) # 深度可分离卷积x1, x2 = self.f1(x), self.f2(x) # 线性变换x = self.act(x1) * x2 # 元素级乘法x = self.dwconv2(self.g(x)) # 再次卷积x = input + self.drop_path(x) # 残差连接return x

定义StarNet网络结构

class StarNet(nn.Module):

def init(self, base_dim=32, depths=[3, 3, 12, 5], mlp_ratio=4, drop_path_rate=0.0, num_classes=1000, **kwargs):

super().init()

self.num_classes = num_classes

self.in_channel = 32

# stem层

self.stem = nn.Sequential(ConvBN(3, self.in_channel, kernel_size=3, stride=2, padding=1), nn.ReLU6())

dpr = [x.item() for x in torch.linspace(0, drop_path_rate, sum(depths))] # 随机深度

# 构建各个阶段

self.stages = nn.ModuleList()

cur = 0

for i_layer in range(len(depths)):

embed_dim = base_dim * 2 ** i_layer # 当前层的嵌入维度

down_sampler = ConvBN(self.in_channel, embed_dim, 3, 2, 1) # 下采样

self.in_channel = embed_dim

blocks = [Block(self.in_channel, mlp_ratio, dpr[cur + i]) for i in range(depths[i_layer])] # 添加Block

cur += depths[i_layer]

self.stages.append(nn.Sequential(down_sampler, *blocks)) # 将下采样和Block组合

def forward(self, x):features = []x = self.stem(x) # 通过stem层features.append(x)for stage in self.stages:x = stage(x) # 通过每个阶段features.append(x)return features # 返回特征

定义不同规模的StarNet模型

def starnet_s1(pretrained=False, **kwargs):

model = StarNet(24, [2, 2, 8, 3], **kwargs)

return model

def starnet_s2(pretrained=False, **kwargs):

model = StarNet(32, [1, 2, 6, 2], **kwargs)

return model

def starnet_s3(pretrained=False, **kwargs):

model = StarNet(32, [2, 2, 8, 4], **kwargs)

return model

def starnet_s4(pretrained=False, **kwargs):

model = StarNet(32, [3, 3, 12, 5], **kwargs)

return model

代码说明:

ConvBN类:封装了卷积层和批归一化层的组合,方便创建卷积模块。

Block类:实现了StarNet的基本构建块,包含深度可分离卷积、线性变换和元素级乘法的操作。

StarNet类:构建了整个网络结构,包括stem层和多个阶段,每个阶段由下采样和多个Block组成。

starnet_sX函数:提供了不同规模的StarNet模型的构造函数,方便用户根据需求创建模型。

这个程序文件实现了一个名为StarNet的深度学习网络,主要用于图像处理任务。StarNet的设计旨在展示元素级乘法的关键贡献,因此在网络设计中尽量简化,比如没有使用层级缩放(layer-scale)和训练过程中的指数移动平均(EMA),这些简化可能会进一步提升性能。

文件首先导入了必要的库,包括PyTorch和一些用于构建网络层的模块。接着定义了一个包含不同StarNet模型的列表和对应的模型权重下载链接。

接下来,定义了一个名为ConvBN的类,它是一个顺序容器,包含卷积层和可选的批归一化层。这个类的构造函数接受多个参数来设置卷积层的属性,并初始化批归一化层的权重和偏置。

然后定义了Block类,表示StarNet中的基本构建块。这个类中包含了深度卷积、两个全连接层(通过ConvBN实现)和一个ReLU6激活函数。它的前向传播方法实现了输入的处理流程,包括对输入进行卷积、激活和元素级乘法操作,最后将结果与输入相加并通过DropPath进行随机深度的处理。

StarNet类是整个网络的核心,包含了多个阶段(stages),每个阶段由一个下采样层和多个Block组成。构造函数中设置了网络的基础维度、每个阶段的深度、MLP比率和随机丢弃率等参数。网络的前向传播方法会依次通过各个阶段,并收集特征图。

文件中还定义了多个函数(如starnet_s1、starnet_s2等),用于创建不同配置的StarNet模型。这些函数允许用户选择是否加载预训练权重,并根据需要传递其他参数。

最后,文件中还定义了一些非常小的网络版本(如starnet_s050、starnet_s100和starnet_s150),这些网络具有更少的层数和参数,适合于资源受限的环境或快速实验。

总体来说,这个文件提供了一个灵活且易于扩展的深度学习模型实现,适合用于图像分类等任务,同时展示了元素级乘法在网络设计中的重要性。

源码文件

源码获取

欢迎大家点赞、收藏、关注、评论啦 、查看👇🏻获取联系方式👇🏻