从「行走」到「思考」:机器人进化之路与感知—决策链路的工程化实践

引言:机器人从舞台走向现实

近年来,人形机器人和具身智能频频登上舞台,从马拉松式的步态演示到竞技擂台上的“对打”,一次次制造着社交媒体上的话题热度。然而,炫技过后留下的核心问题是:机器人能否真正走出实验室与秀场,进入工厂车间、医疗手术室、家庭客厅,承担起生产与生活中的真实任务?

当机器人迈出“行走”的第一步之后,挑战才真正开始:它必须能在非结构化环境中完成复杂操作,能在动态场景下实时感知和决策,并能长时间、稳定地运行。这条从 “会走路” 到 “能思考” 的进化之路,不仅依赖大模型与多模态算法的突破、柔性执行器与传感器的进步,更需要 工程化基础设施 的支撑。

在这一进化过程中,实时感知与信息传输链路成为机器人能否完成“感知—理解—决策—执行”闭环的关键环节。大牛直播SDK以其跨平台、低延迟、可组合的视频链路能力,为机器人构建了可靠的“神经网络”:它让机器人“眼睛”所见能够毫秒级传递到“头脑”,为后续的认知与动作规划提供确定性的基础。这种看似不起眼的底层能力,正是机器人从表演走向现实的分水岭。

一、机器人智能发展的三阶段

如果把人类对机器的追求比作一条进化路径,那么具身智能就是“赋予机器生命”的必然结果。从蒸汽机到工业机器人,再到今天的人形机器人,我们经历了三次跨越:

1. 行走阶段:从机械动作到动态平衡

最初的目标,是让机器能够像人一样移动。无论是四足机器人跨越复杂地形,还是双足人形机器人完成长距离步态展示,这一阶段的核心在于 运动控制与动力学建模。

-

技术要点:步态规划、关节驱动、实时控制。

-

典型瓶颈:动作刚性、能耗高、续航短。

行走的突破让机器人不再是“固定在流水线上的机械臂”,而是一个能进入真实世界的动态主体。

2. 操作阶段:从夹取到灵巧操作

会走并不等于会做事。进入这一阶段,机器人开始学习“手”的能力:抓取、放置、搬运,甚至完成装配、清理等复杂任务。

-

技术要点:计算机视觉、动作规划、触觉传感、强化学习。

-

典型瓶颈:任务泛化能力不足,缺乏真实交互数据。

这一阶段催生了“多模态感知”的概念:光学视觉、惯性动捕、力学触觉逐渐融合,机器才真正具备与环境交互的基础。

3. 思考阶段:从被动执行到主动认知

真正的难题不在“手和脚”,而在“脑”。机器人需要理解模糊目标,在动态环境中实时调整行为,甚至学会自主规划。

-

技术要点:VLA(Vision-Language-Action)范式、多模态大模型、世界模型、长时序推理。

-

典型瓶颈:数据规模与质量不足,现实与仿真的差距,算力与能耗的约束。

在这一阶段,机器人不再只是机械执行,而是进入了 “具身智能” 的范畴:它能够感知环境 → 理解任务 → 生成动作,这一链路的稳定性决定了机器人能否真正落地。

二、从算法到工程:为什么需要“视频神经链路”

当我们谈论机器人进化时,往往过于聚焦在算法与硬件本体,而忽略了一个关键前提:感知必须实时、信息必须可达。

无论是工厂流水线上的 SOP 执行,还是家庭场景下的多任务处理,机器人都需要在毫秒级时间内完成“看 → 想 → 做”的闭环。延迟过高,意味着机器人在拿杯子的瞬间,杯子已经掉在地上;传输不稳,意味着巡检机器人可能漏掉关键的安全隐患。

这正是 大牛直播SDK 之类的工程化基建发挥作用的地方:

-

低延迟传输:RTSP 播放器保证毫秒级实时性,RTMP 播放器保证公网大规模分发的稳定。

-

跨平台兼容:Windows / Linux / Android / iOS / Unity 全覆盖,适配机器人研发与部署的多样环境。

-

模块化可拼接:轻量级 RTSP 服务、RTMP 转发、GB28181 接入,可按需组合,快速搭建机器人“感知神经”。

换句话说,如果把算法比作“机器人思维”,把传感器比作“机器人五感”,那么像大牛直播SDK这样的实时链路,就是连接感知与思维的“神经系统”。没有它,机器人只能在孤立环境中自我演示,而无法真正走向复杂世界。

Android平台RTSP播放器时延测试

三、具身智能的瓶颈与突破

1. 泛化能力:从“会做一次”到“能适应百次”

当前的具身智能,最大的挑战在于 泛化能力不足。在实验室 Demo 中,机器人能完成“拿起—放下”的任务;但当环境光照改变、物体形状不同,或出现训练数据中未见过的情况时,机器人往往表现失常。

-

典型表现:稍微偏离已知数据分布(Out-of-Distribution),成功率显著下降。

-

产业困境:家庭、工厂、医院等开放环境中任务无限多样,不可能靠穷举式示教来覆盖。

解决思路是引入 端到端大模型(VLA/VTLA),让机器人通过多模态感知在新场景中实现迁移。但这要求海量的、实时的、多样化数据。

大牛直播SDK在这一环节提供了现实意义:

-

通过 RTSP/RTMP 转发与汇聚,能将分布在多地、多类型机器人的实时感知数据统一接入 AI 中心,成为模型泛化的“燃料”。

-

通过 毫秒级低延迟回传,确保模型能快速验证新场景下的推理效果,缩短从“实验”到“泛化”的闭环周期。

2. 数据匮乏:从“欠账”到“造富”

相比语言模型的万亿级 Token,具身智能的数据量严重不足。实验显示,哪怕是百万级真机交互数据,也远远不够支撑复杂动作的泛化。

目前主流路径是:

-

真实采集:通过遥操作、动捕、触觉手套等方式,采集高价值交互数据。

-

仿真生成:利用物理引擎或生成式世界模型,在虚拟环境中扩充训练样本。

然而,真实采集成本高,仿真结果与现实仍存在鸿沟。

在这里,视频链路的作用非常突出:

-

轻量级 RTSP 服务 可直接嵌入机器人本体,把真实交互过程转化为标准化流媒体,低成本地进行采集与存档。

-

多路转发模块 可支持大规模场景实验,把来自不同机器人的数据统一封装,方便集中训练。

这使得 “采集—传输—存储—训练” 形成标准闭环,为数据规模化提供工程化路径。

3. 仿真与现实的差距

在虚拟仿真器里,机器人能轻松完成上千次实验,但一旦进入真实世界,就可能出现“力道失衡”“物体滑落”“意外碰撞”等问题。

-

仿真优势:成本低、可重复、速度快。

-

仿真短板:难以准确复现摩擦、温度、柔性体交互等复杂物理特性。

因此,产业界提出 “仿真 + 真机混合训练” 的思路:仿真负责规模扩展,真机数据负责边界校准。

在这个过程中,大牛直播SDK扮演着“桥梁”的角色:

-

统一接口:无论是真机数据还是仿真数据,都可以通过视频流统一采集与传输,形成跨源对比。

-

实时比对:AI 推理结果与机器人实际动作通过低延迟视频流回传,帮助研究者快速识别仿真偏差并校正。

这样,视频链路不仅是“数据通道”,更是 真实与虚拟之间的校准工具。

小结

泛化、数据、仿真,是具身智能三大核心瓶颈。而它们的共同需求,都是 高效、标准化、低延迟的数据链路。

这正是大牛直播SDK的价值所在:它让机器人“看见的世界”能够被完整、实时地传输到 AI 训练与决策层,从而为泛化提供数据,为训练补足规模,为仿真提供校准。

四、大牛直播SDK:机器人「神经链路」的工程化基座

如果说传感器是机器人的“眼睛与耳朵”,大模型是它的“大脑”,那么在两者之间,必须有一条稳定、低延迟、跨平台的「神经链路」,来保证感知信息能够被及时送达、处理结果能够被迅速执行。大牛直播SDK正是这条链路的核心。

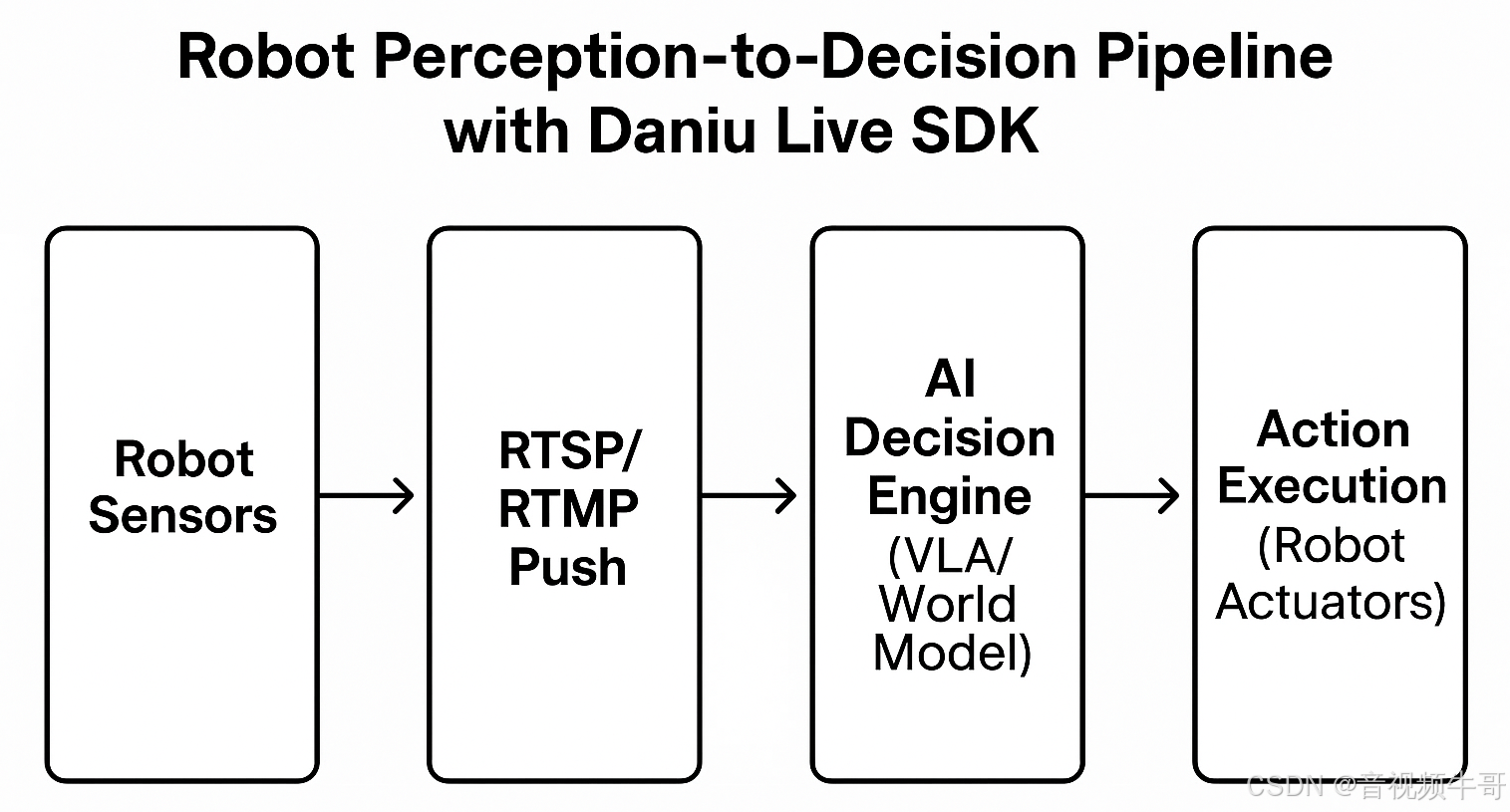

1. 架构思路:从感知到决策的全链路传输

在典型的机器人具身智能体系中,视频与多模态感知数据需要经过 采集—传输—决策—执行 的完整闭环。其核心链路如下所示:

流程说明

-

Sensors(Camera / Tactile / IMU)

负责环境信息采集,包括视觉、触觉与惯性测量单元数据。 -

Stream Push (RTSP / RTMP)

将多源传感数据实时推送至传输模块,确保低延迟与跨平台兼容。 -

Daniu SDK Transmission Modules

通过跨平台、低延迟的传输内核,实现视频/数据的稳定分发与高效解复用。 -

AI Decision Engine (VLA / World Model)

在大模型或世界模型的驱动下完成环境建模与决策推理。 -

Action Execution (Robot Arm / Locomotion)

将决策结果实时下发至机器人本体,实现抓取、移动、交互等复杂动作。

其中,大牛直播SDK承担了两个关键职能:

-

实时采集与推流:通过轻量级 RTSP/HTTP-FLV 服务,将机器人端采集的多模态数据转化为标准化流媒体。

-

跨平台低延迟回传:在 100–200ms 的时间窗口内,把视频和传感数据传输到远端 AI 决策中心,确保机器人对外部环境的反馈接近“实时”。

这一架构保证了机器人从“看”到“想”再到“做”的链路可控、可扩展。

Android平台RTSP播放器时延测试

2. 关键能力:不仅是“视频”,更是“神经信号”

-

毫秒级延迟:在安防、巡检、远程医疗等场景中,保证机器人能在 0.1–0.3 秒内完成感知与反应。

-

多协议支持:RTSP 主打低延迟,RTMP 主打稳定分发,HTTP-FLV 则面向网页端兼容。它们共同构成了机器人“多模态神经束”。

-

跨平台嵌入:Windows、Linux(x86_64 / ARM)、Android、iOS、Unity 全覆盖,方便机器人研发团队在不同硬件平台快速集成。

-

模块化组合:推流、转发、播放器、录制、GB28181 接入等模块可自由拼接,满足从实验室到产业落地的多样需求。

3. 实际场景:如何成为“最后一公里”的解决者

-

工厂 SOP 执行:通过 RTSP 回传,机器人在流水线上执行任务时,远程 AI 能毫秒级捕捉异常,实时纠正。

-

远程巡检:工业或电力巡检机器人通过 SDK 推流,运维人员与 AI 模型可并行监控,发现异常立即回传控制指令。

-

家庭辅助:轻量化部署的 RTMP/HTTP-FLV 服务,让机器人在家庭环境中执行拾取、清扫等任务时,依然保持与远程大脑的低延迟连接。

这些应用场景表明:大牛直播SDK不是简单的“视频播放器”,而是机器人进入现实场景时“能否稳定闭环”的关键保障。

4. 架构图

大牛直播SDK是“感知”与“决策”之间的桥梁,确保机器人从“行走”到“思考”的进化能够落地。

五、展望:从单任务到多模态智能的未来路径

机器人从“会走”到“能思考”,并不是一蹴而就的过程,而是一条循序渐进的产业演化之路。结合具身智能的技术趋势与大牛直播SDK的工程化支撑,我们可以预见三个阶段的发展节奏:

1. 近期(2025–2027):单任务机器人落地

未来两三年内,最先大规模进入市场的仍将是 单任务机器人。

-

形态代表:扫地机器人、巡检机器人、安防巡逻机器人。

-

技术特征:以规则系统 + 小规模端侧模型为主,执行相对固定的 SOP(标准操作流程)。

-

链路需求:

-

低延迟视频回传(RTSP) → 保证实时监控与远程干预。

-

稳定分发(RTMP/HTTP-FLV) → 便于云端 AI 模型与运维平台统一接入。

-

在这个阶段,大牛直播SDK的价值在于 提供低成本、可规模化的链路组件,让单任务机器人具备“看得见”“连得上”的能力,从而快速进入家庭和工厂。

2. 中期(2027–2030):多任务与场景迁移

随着 VLA/VTLA 模型的成熟,机器人将逐步迈入 多任务与跨场景迁移 阶段。

-

形态代表:具备多模态感知与简单操作臂的家庭助理机器人,能同时完成清洁、搬运、拾取等任务。

-

技术特征:端到端模型与世界模型结合,具备基础的泛化能力;仿真与真机混合训练普及。

-

链路需求:

-

多路流媒体汇聚(RTSP → RTMP 转发模块),支撑大规模数据回流,用于模型迭代。

-

低延迟链路保障,使机器人能在开放环境中完成动态任务。

-

在这一阶段,大牛直播SDK的价值是 成为“数据燃料管道”,把分布在千家万户、工厂车间的机器人感知数据实时回传,支撑模型的持续迭代与泛化。

3. 远期(2030+):具身智能进入“思考”阶段

当机器人真正跨入 认知与思考 阶段,它们将不仅是任务执行者,而是具备 自主学习与长时序推理能力 的智能体。

-

形态代表:能够在家庭、医院、城市等开放环境中执行复杂任务的多模态机器人。

-

技术特征:

-

世界模型成熟,能预测动作后果。

-

VLA 与大语言模型深度融合,形成自主决策能力。

-

多模态感知超越人类五感(红外、温度、电磁感知等)。

-

-

链路需求:

-

实时多模态通道:不仅传输视频,还需承载触觉、力觉、温度等信号。

-

高可靠性跨平台分发:保证大规模部署下的稳定性与安全性。

-

在这一阶段,大牛直播SDK将不再只是“视频组件”,而是升级为 多模态实时神经系统 的一部分。它将帮助机器人真正实现“边看、边想、边学”,成为人类的 伙伴型智能体。

结语

机器人进化的真正分水岭,不在于它能否完成一次惊艳的舞台表演,而在于它能否在开放世界中稳定完成复杂任务。算法和硬件固然重要,但没有工程化的基础设施,具身智能就只能停留在实验室的 Demo。

大牛直播SDK正是这样一个“幕后推手”:它像神经系统一样,把感知与决策紧密连接,让机器人能够真正“看见世界、理解世界、行动于世界”。

当我们回望这条从“行走”到“思考”的进化之路时,也许会发现,真正让机器人走向现实的,并不是单一的算法突破,而是像大牛直播SDK这样的工程化能力,让人工智能有了真正抵达现实的“最后一公里”。

📎 CSDN官方博客:音视频牛哥-CSDN博客