k8sday09

解决昨天问题

1、重建集群

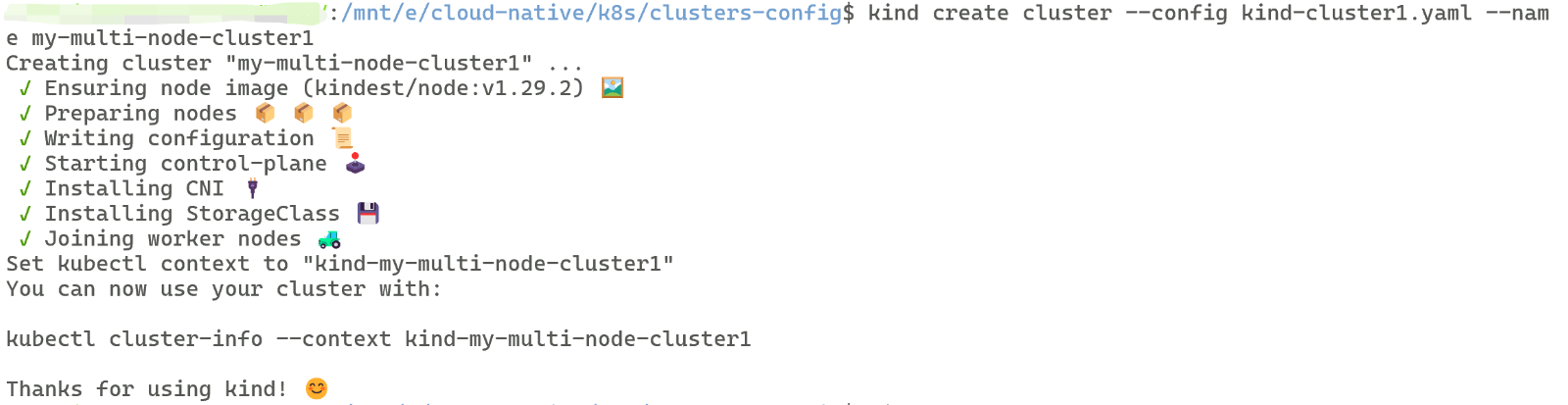

首先按照昨天所说删除已有集群,重建集群

# 删除当前已有的集群# 这个my-multi-node-cluster1是我的集群的名字kind delete cluster --name my-multi-node-cluster1# 如果不知道自己集群叫什么,可以使用:kind get clusters# 转换到你新yaml文件的路径下(当然也可以不转,只不过下面的文件名用绝对路径即可)cd <你的路径># 利用新的yaml文件,重建集群kind create cluster --config kind-cluster1.yaml --name my-multi-node-cluster1成功后和我们第一次创建集群提示相同(可见k8sday03),如图:

2、HPA重新测压

由于昨天详细配置(除测压外)已全部演示(可见k8sday08),中间的什么创建有资源限制的Deployment,配置HPA均不再过多赘述,不过为了方便加深流程,我只给出粗略的中间步骤,详细进行最后一步。

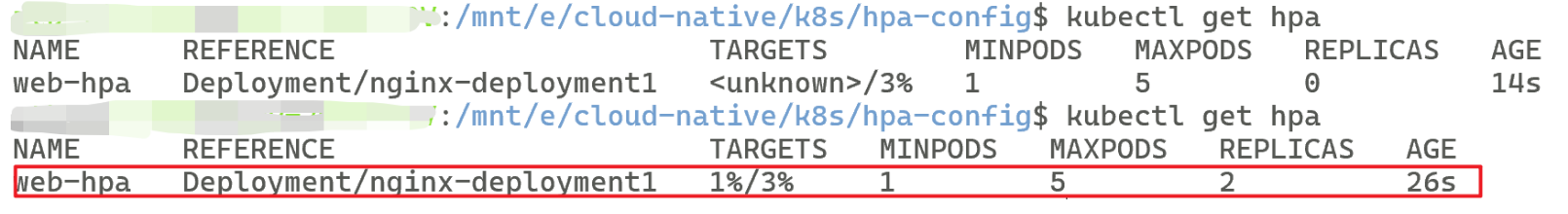

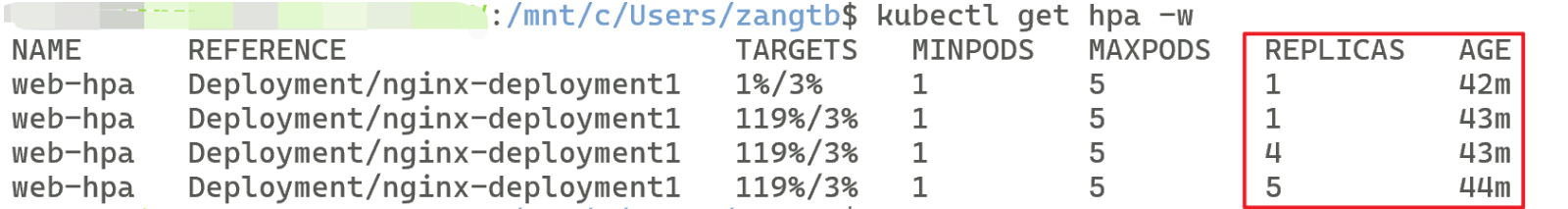

# 创建有资源限制的Deploymentkubectl create -f nginx-deploy1.yaml# 部署metrics-serverkubectl apply -f components.yaml# 创建HPAkubectl create -f text1-hpa.yaml最终监测如图:

2.1新出现的问题

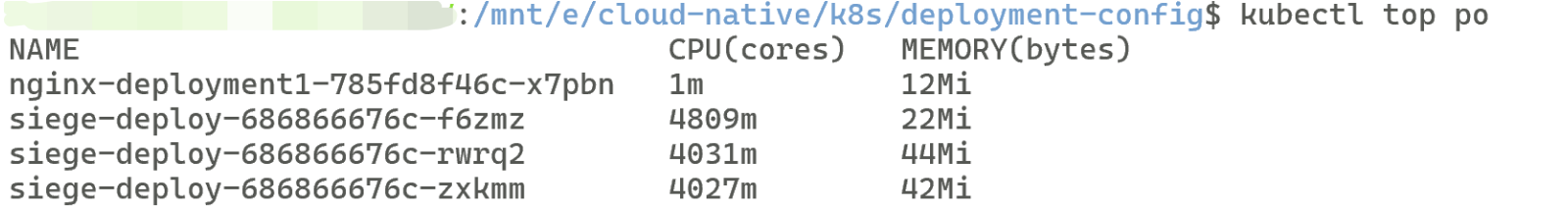

即使我的

siege-deploy虽然跑满了,但是我的nginx-deployment1始终cpu使用率是1%,达不到扩容标准

2.2原因

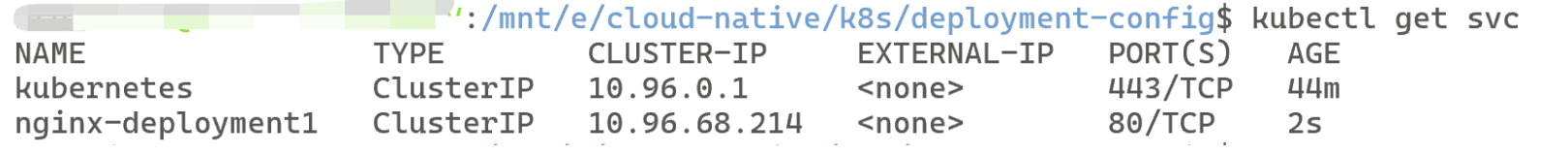

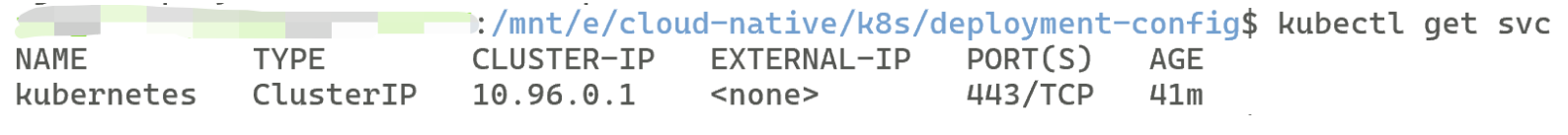

使用kubectl get svc发现我只有一个默认的kubernetes Service,而 没有名为 nginx-deployment1 的 Service,因此 siege Pod 发出的请求根本打不到任何 nginx Pod,导致 HPA 监控不到负载

2.3解决方法:

立即创建 Service(把流量导到 nginx Pod)

之所以要 Service,是为了让 压力流量真正打到这些 Pod 上,否则 Pod 一直空转,CPU/内存永远上不去,HPA 自然不起作用。

Service 只是把外部流量导进来,让 Pod 真正“吃”到负载。

# 以下命令只会直接调用 apiserver 创建 Service 对象kubectl expose deployment nginx-deployment1 --name=nginx-deployment1 --port=80 --target-port=80# 查看已有的service服务kubectl get svc2.4实施最终步骤

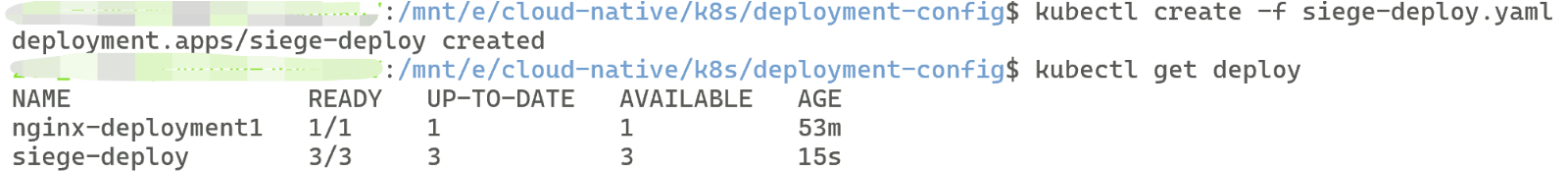

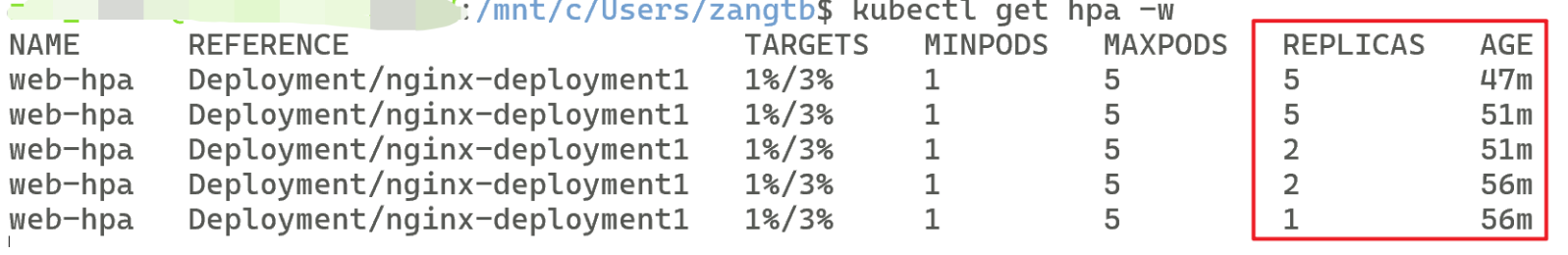

# 创建测压deploykubectl create -f siege-deploy.yaml# 验证是否创建成功kubectl get deploykubectl get po# 双开实时监控自动扩容和缩容# HPA 在 CPU 利用率低于目标值(3%) 并持续默认 5 分钟后,会自动把副本缩回最小值kubectl get hpa -w# 暂停脚本(就是把Pod副本数设置为0即可)kubectl scale deployment siege-deploy --replicas=0# 重启脚本(同理修改replicas即可)kubectl scale deployment siege-deploy --replicas=<你想要的数量,越多压力越高>

默认CPU 利用率低于目标值持续一会才缩容哈

PS:由于我的疏忽,k8sday08给的测压脚本里有个地方写错了,导致会监测不到负载,大家记得改改哦!!!

在command命令里的curl -s的for循环内的地址给nginx-deployment改为nginx-deployment1

command: ........ for i in $(seq 50); do curl -s http://nginx-deployment1.default.svc.cluster.local &

..........

PS:本来今天打算也把service的学习内容搞好的,但是今天是星期天,就少学一点吧~嘿嘿其实完全是因为懒,明天继续开始服务发现的学习(包含service和ingress)