解码词嵌入向量的正负奥秘

LLM的词嵌入向量的正负是什么意义

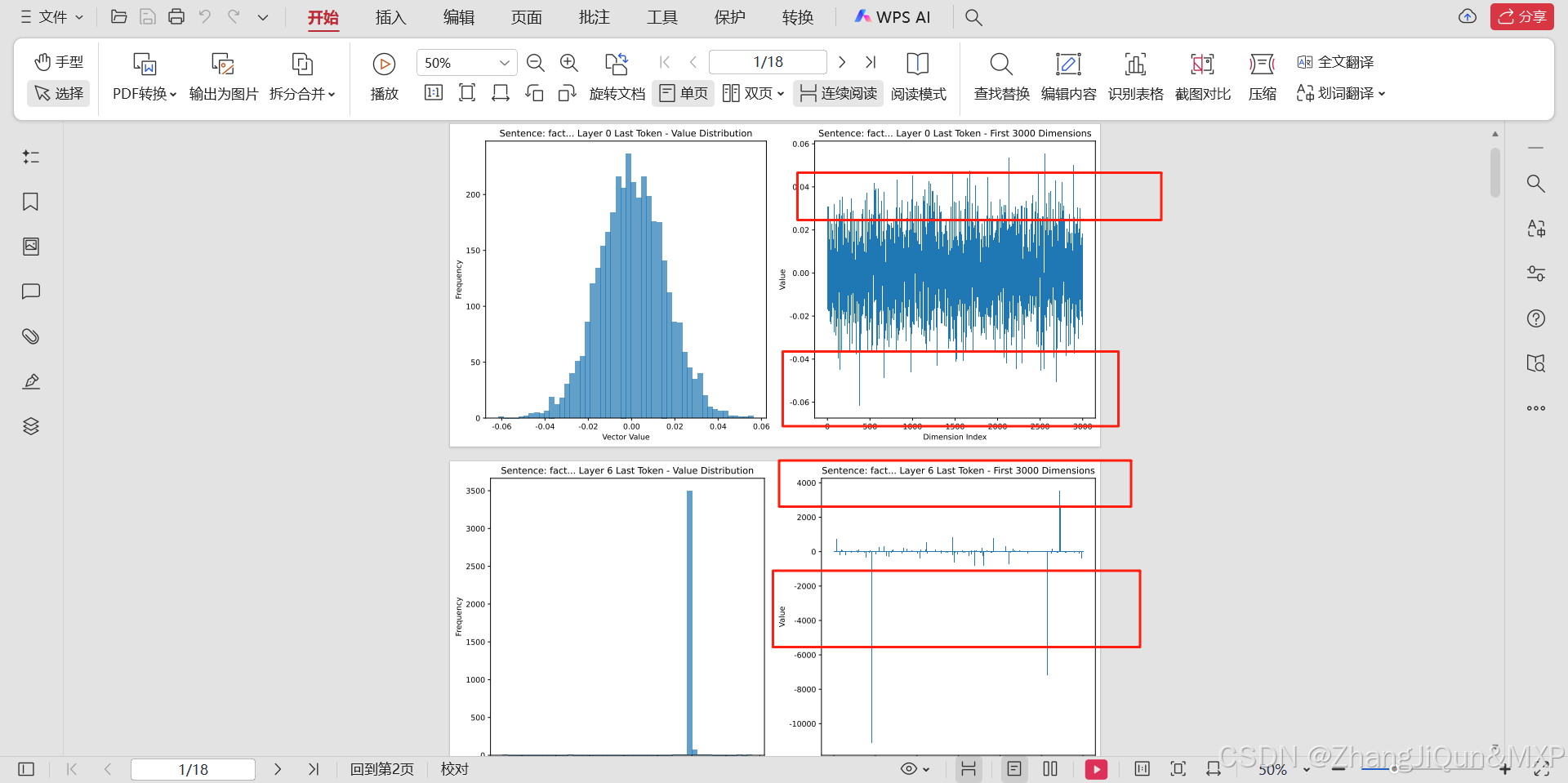

在LLM的词嵌入(Word Embedding)中,向量的正负值本身没有绝对的、统一的语义含义(不像数学中“正数表示增加、负数表示减少”那样有固定定义),但它们的相对关系(同一维度上的正负对比、向量方向差异)往往对应着词语在某些潜在语义维度上的对立或关联。

核心逻辑:

词嵌入的本质是将词语的语义信息编码到低维向量空间中,向量的每个维度都对应模型自动学习到的“潜在语义属性”(这些属性是模型从训练数据中挖掘的,没有人工定义)。

正负值的意义通常体现在同一维度上的对比:两个词在某个维度上的正负相反,可能意味着它们在该维度对应的语义属性上是对立的;正负相同则可能意味着在该属性上是相似的。

举例说明:

1. 反义词在特定维度上的正负对立

假设模型学习到一个“情感倾向”维度(模型自动识别,无人工标注):

- 正面词(如“快乐”“美好”)在该维度上可能为正值,表示“积极情感”;

- 负面词(如“悲伤”“糟糕”)在该维度上可能为负值,表示“消极情感”。

此时,“