AutoDL使用学习

文章目录

- 说明

- 参考资料

- AutoDL简介

- AutoDL实用功能简介

- AutoDL平台功能局限

- AutoDL实用指南

- FinalShell连接

- 通过AutoDL快速切换pip源

- github和HuggingFace加速

- AutoDL SSH隧道工具使用指南

- 远程代理到本地

- 本地代理到远程

- 虚拟环境创建和内核安装

- PyCharm连接AutoDL python环境

- 无卡模式使用指南

说明

- 本文仅供学习和交流使用,不得用作任何商业用途!

参考资料

- 大模型最佳实验云环境:AutoDL快速入门与GPU租赁使用指南

- AutoDL帮助文档

- PyCharm无缝连接远程服务器实战教程 (以AutoDL算力云为例)

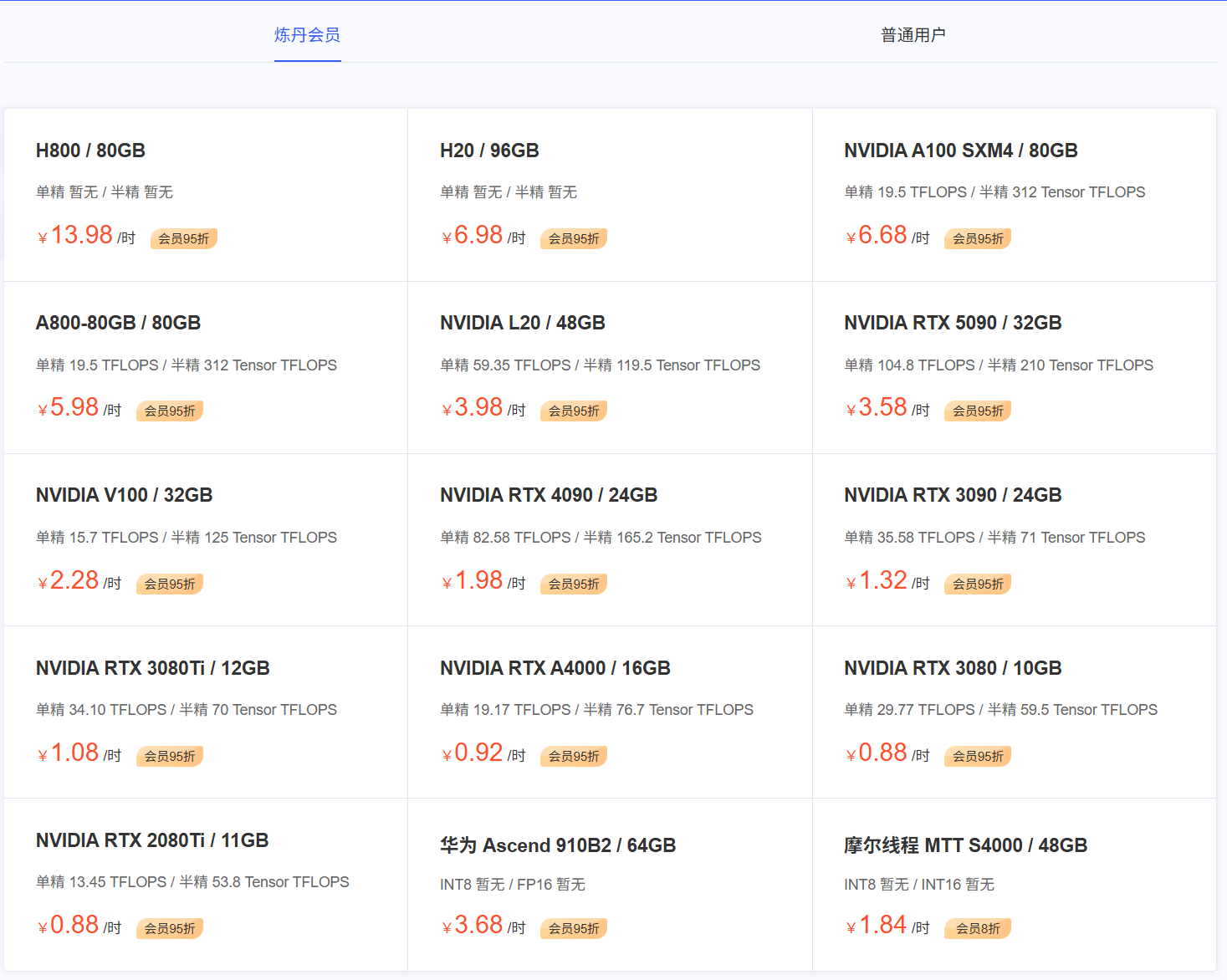

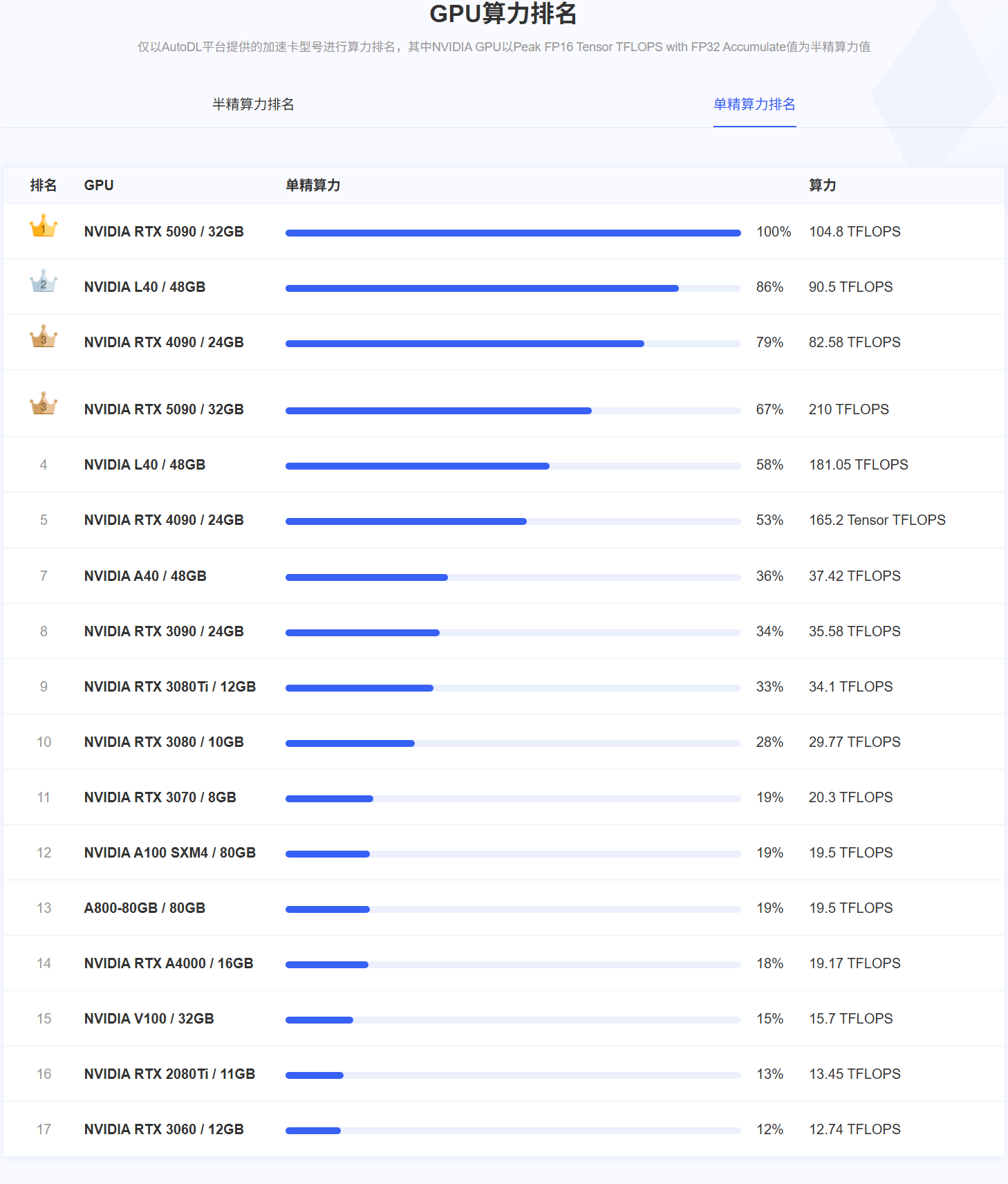

AutoDL简介

- AutoDL是一个国内稳定高效的算力租赁平台,AutoDL支持一键部署基础Linux基础环境、镜像环境,同时支持镜像文件保存与迁移、跨实力读取文件等,且平台显卡较为充裕,价格成本相对合理,并支持多种不同计费方式,对于大模型初学者来说是非常不错的算力租赁渠道。

- AutoDL是一个非常适合进行中小型大模型项目或深度学习项目部署执行的实验性平台,若是企业级、工程化程度更加复杂的项目,更推荐本地采购硬件进行部署,或是利用阿里云等更专业的企业级云服务平台来完成项目开发和部署。

AutoDL实用功能简介

- 对于定位于实验性项目的云平台来说,AutoDL还拥有一系列有助于提高开发效率的实用功能,特色实用功能介绍如下:

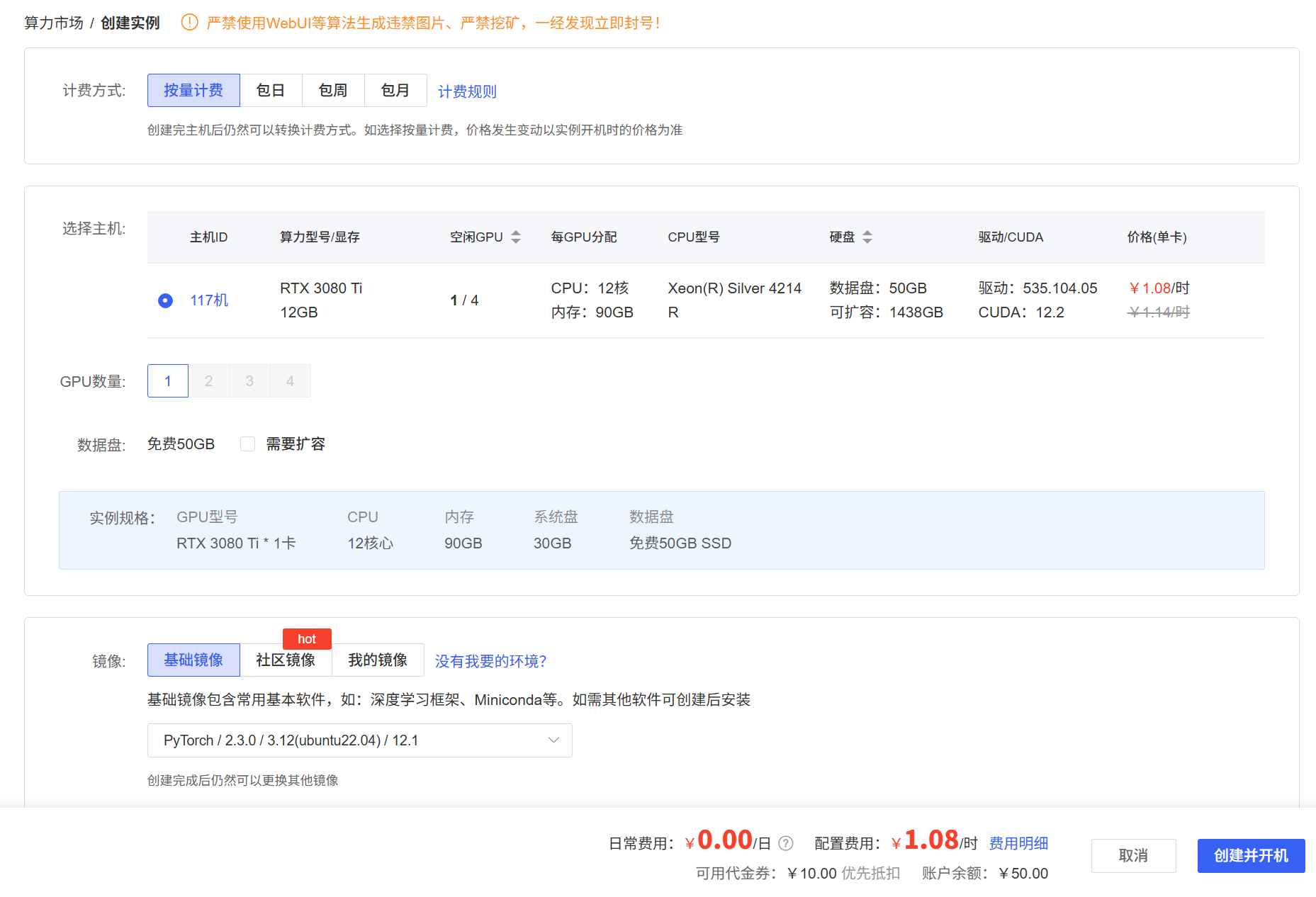

- 根据GPU型号自动选配CPU和内存:在AutoDL上租赁算力,几乎无需考虑CPU型号和内存大小,用户在租赁服务器的时候,只需要选择GPU,系统就会自动根据GPU型号和数量,配置与之相匹配的CPU和内存,从而极大程度降低用户租赁算力的门槛。

- 一键深度学习环境搭建与复原:在实际执行深度学习或大模型项目的时候,环境部署和还原至关重要,在首次部署项目前,需要谨慎的选择Python、PyTorch、和CUDA版本,并和当前GPU像匹配,同时还需要安装Anaconda等计算环境,这本身就是一个非常复杂的过程,而当我们遇到不可修复的问题时,可能还需要卸载当前环境或将环境还原到某个状态,此时AutoDL的一键部署和还原功能就非常方便了,部署的时候可以一键点击即可部署环境。

- 活跃的镜像社区,以及镜像分享与迁移功能:当我们完成某个项目的部署并顺利运行之后,往往需要拷贝一份完整的系统文件镜像,便于我们将其迁移到别的服务器上运行,从而避免同一个项目在不同的硬件环境中重复安装。AutoDL不仅提供了每个服务器保存、更换镜像的服务。

- 同时还允许用户使用自己的镜像,或和别人分享镜像。如今AutoDL的镜像社区https://www.codewithgpu.com/image上已经有非常丰富的镜像生态,很多热门项目都有成熟的可以一键部署运行的镜像,用户也可以直接在镜像。

- 云端到本地的端口代理,以及本地到云端的反向端口代理:由于AotuDL上租赁的服务器本质上是虚拟环境,因此没有独立IP(同时也无法使用docker),因此如何将服务器上启动的服务(如Jupyter)在本地调用,就非常重要。AutoDL提供了一个专项工具AutoDL-SSH-Tools,用于将服务器上运行的端口映射到本地,这样,我们就可以在服务器上运行lupyter,然后本地调用了。

AutoDL平台功能局限

-

作为基于虚拟环境的云算力平台,AutoDL也存在自己的局限,主要的使用局限有以下两个方面:

- 无法使用docker:由于AutoDL本身就是基于docker的虚拟环境,因此无法在虚拟沙盒环境中再创建docker虚拟环境。(虚拟环境和Python虚拟环境并不是同一个概念。)

- 没有独立IP:由于不是实体服务器物理机,因此每个虚拟服务器都没有独立IP。

-

要解决这两个问题,可以考虑使用AutoDL私有云服务,或者阿里云弹性计算云服务等,不过相应的这些云服务价格会更高。

AutoDL实用指南

- AutoDL官网

- AutoDL文档

- 登录AutoDL官网,然后完成认证和充值,选择租用的GPU服务器,最后远程连接使用即可!

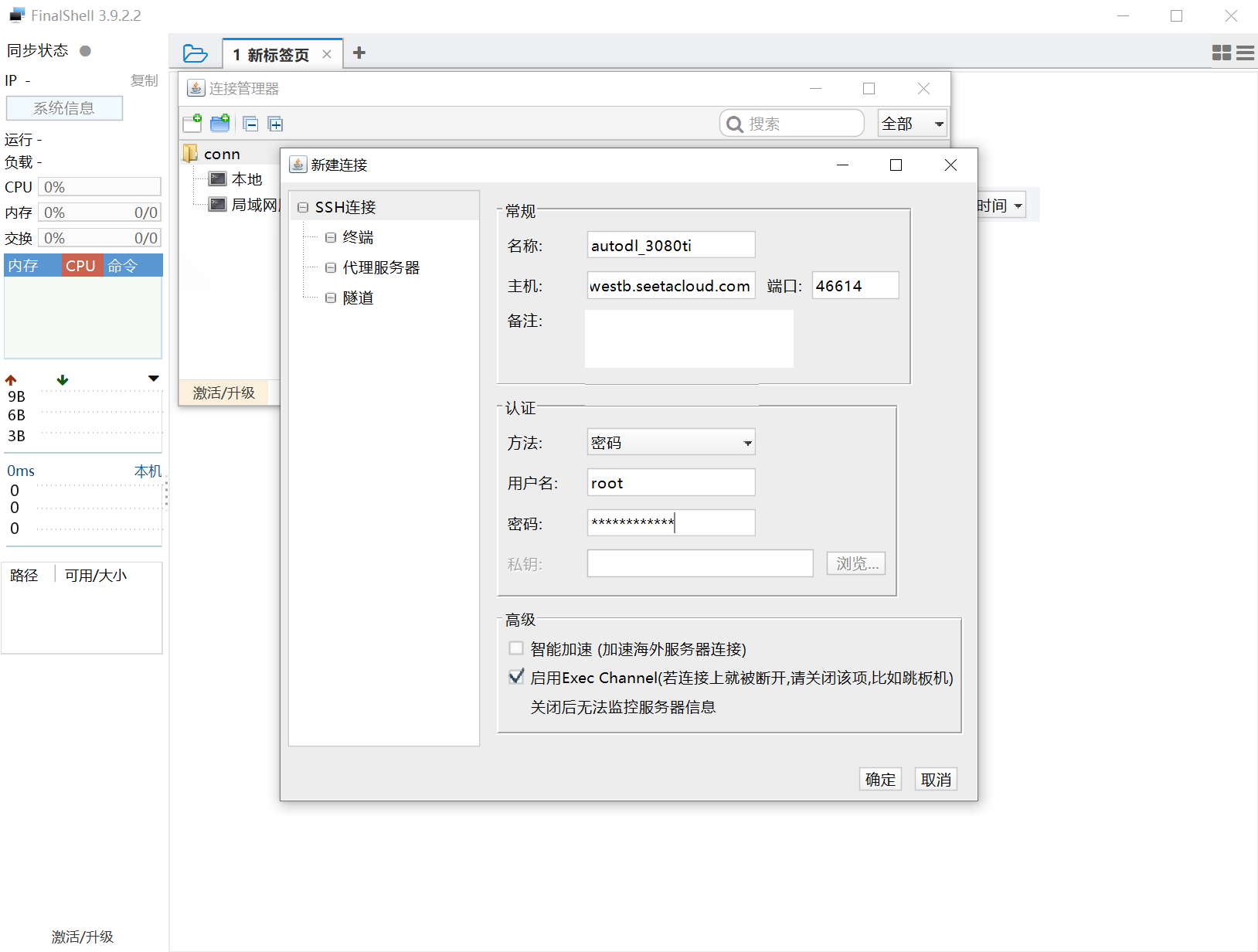

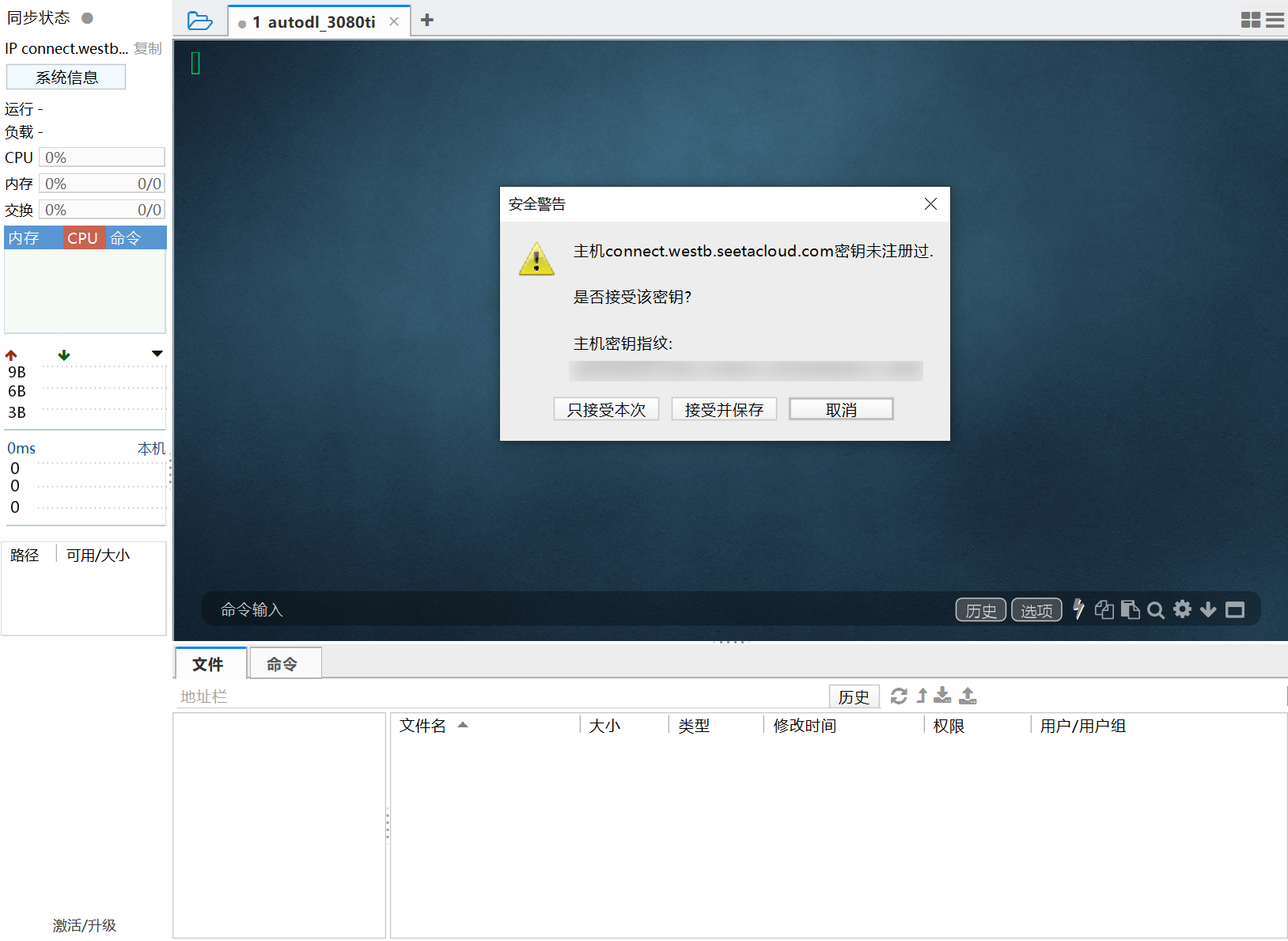

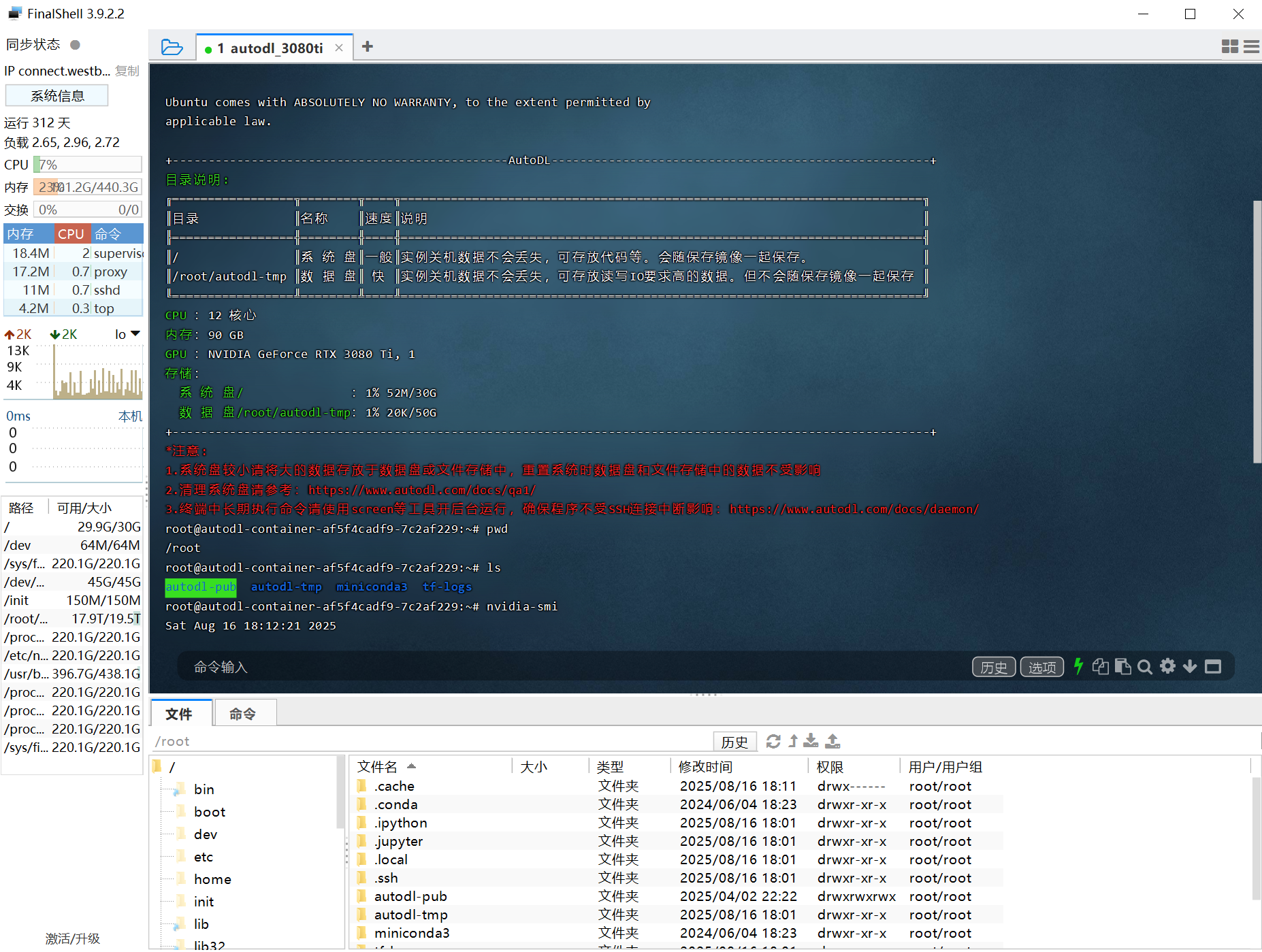

FinalShell连接

- 连接远程服务器的方式有多种,服务器已预安装JupyterLab,可以直接通过JupyterLab中的Terminal来连接服务器,并通过命令行的方式操作远程服务器。但由于JupyterLab中Termianl界面较为原始。推荐使用专门的远程终端连接软件连接远程服务器,这里推荐使用FinalShell。

登录指令:ssh -p 46614 root@connect.westb.seetacloud.com

密码:xxx

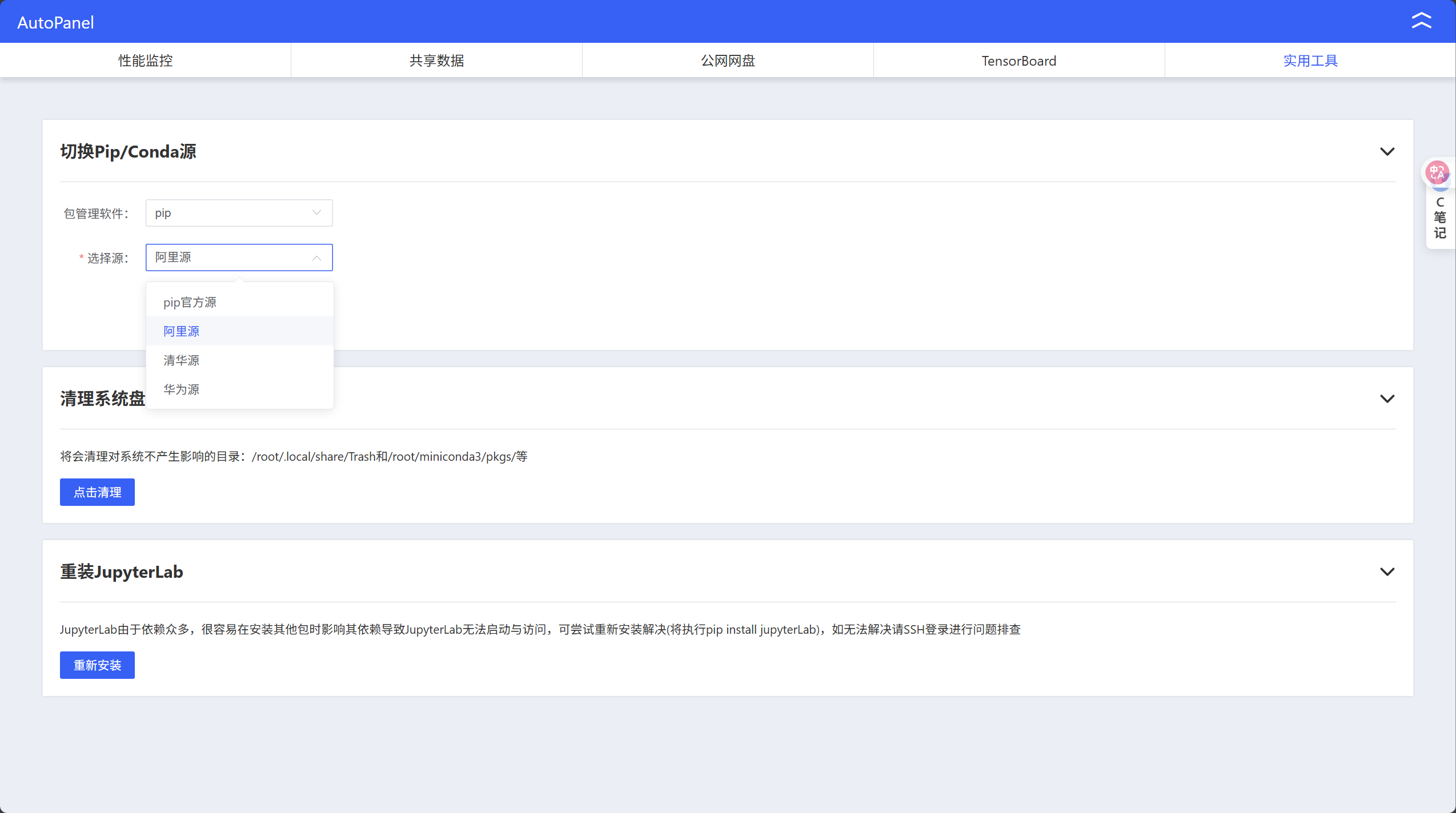

通过AutoDL快速切换pip源

github和HuggingFace加速

- 学术资源加速指导文档

(MateConv) root@autodl-container-af5f4cadf9-7c2af229:~# source /etc/network_turbo

设置成功

注意:仅限于学术用途,不承诺稳定性保证

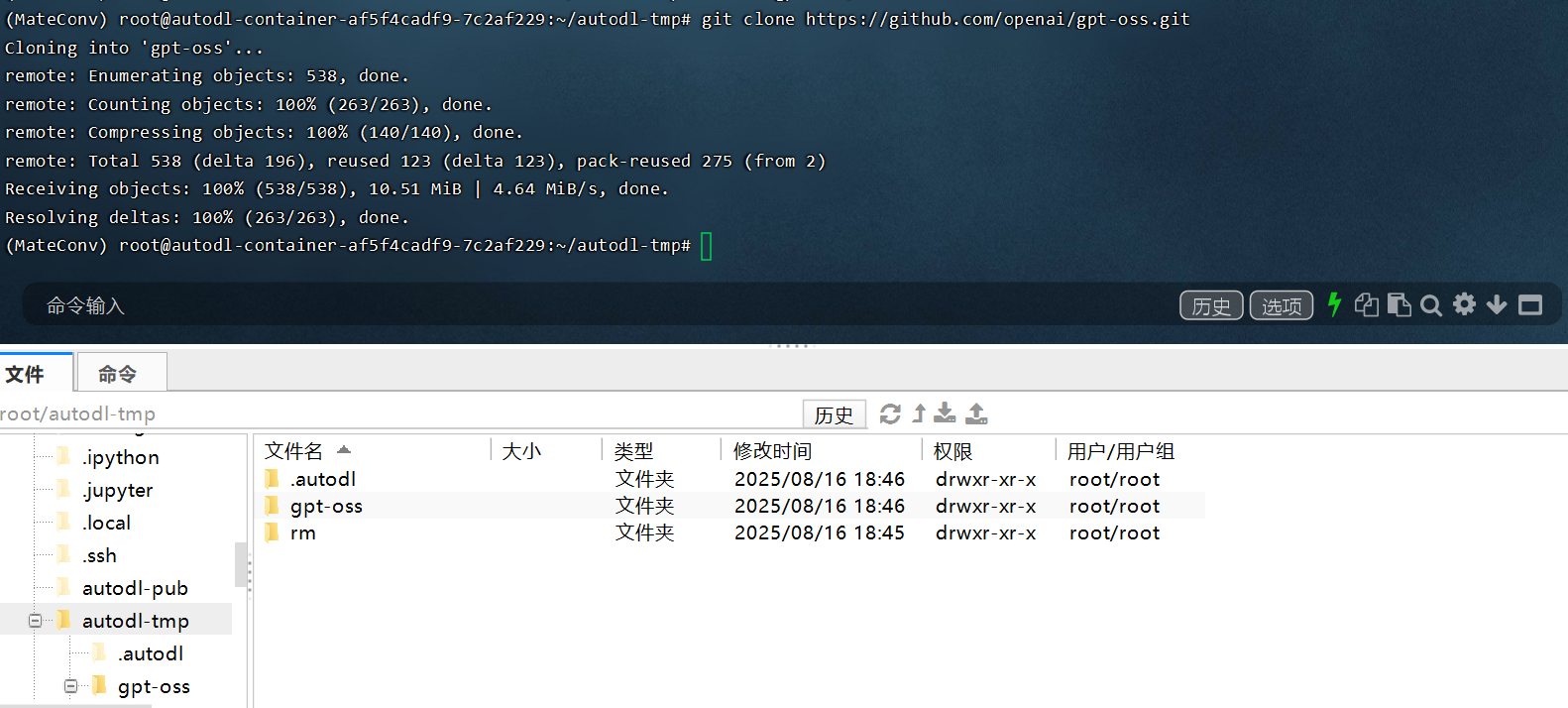

- 选择openai gpt-oss官网源码进行下载测试:

git clone https://github.com/openai/gpt-oss.git

AutoDL SSH隧道工具使用指南

远程代理到本地

- AutoDL SSH 隧道使用

- 首先在服务器上启动一个web服务,如

python -m http.server 6006

- 下载AutoDL SSH隧道工具,并填写连接信息,进行代理。复制登录命令和密码,然后选择自定义服务,下载AutoDL SSH隧道工具。

- 打开本地访问连接,即可访问运行的服务。

本地代理到远程

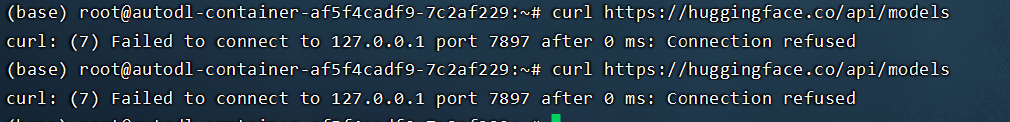

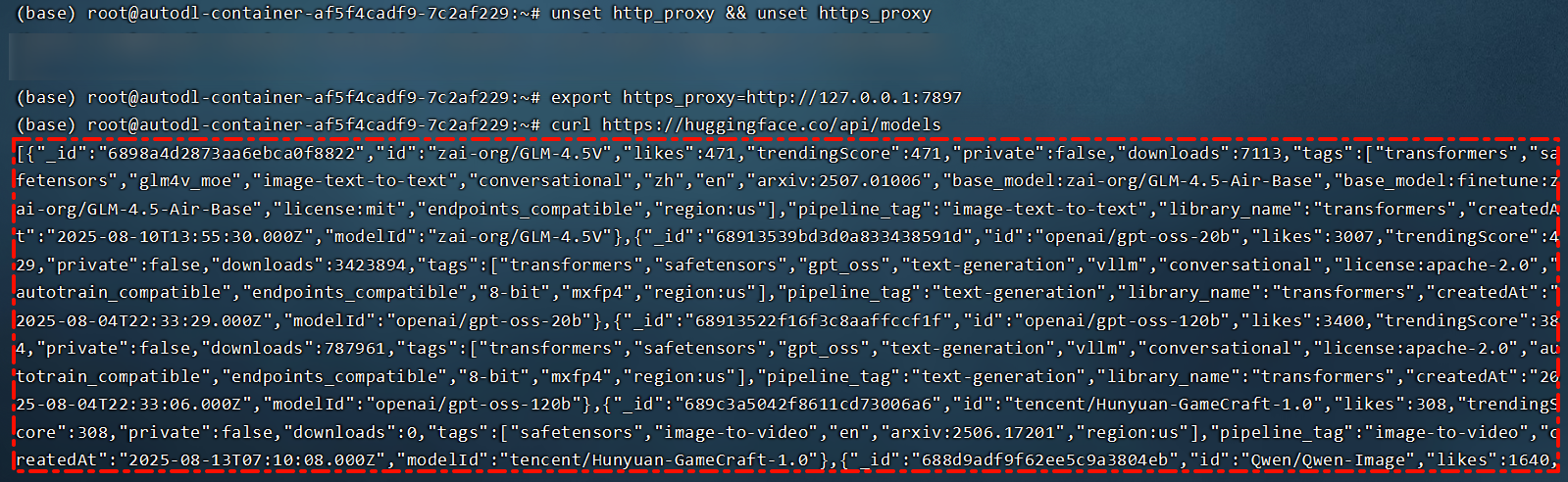

- 未开启网络代理情况下,访问hugging face结果。

- 借助AutoDLSSH隧道工具,可以让本地代理环境映射到服务器上,例如假设本地开启某网络代理,且代理端口号为7897(代理端口号根据工具不同而不同),则可以在AutoDLSSH中设置7897作为代理端口,令其代理到远程。

- 注意:如果已经开启AutoDL内置的的资源加速,针对github和hugging face,则不需要使用本地代理网络的辅助!

- 在服务器某个会话窗口输入:

export http_proxy=http://127.0.0.1:7897 export https_proxy=http://127.0.0.1:7897 - 即可让服务器使用本地代理环境,访问例如huggingface网络。例如,在未开启代理时,无法连接hugging face。

# 取消autodl内置的资源加速

unset http_proxy && unset https_proxy

# 暴露服务器7897端口

export https_proxy=http://127.0.0.1:7897

# 请求huggingface网络

curl https://huggingface.co/api/models

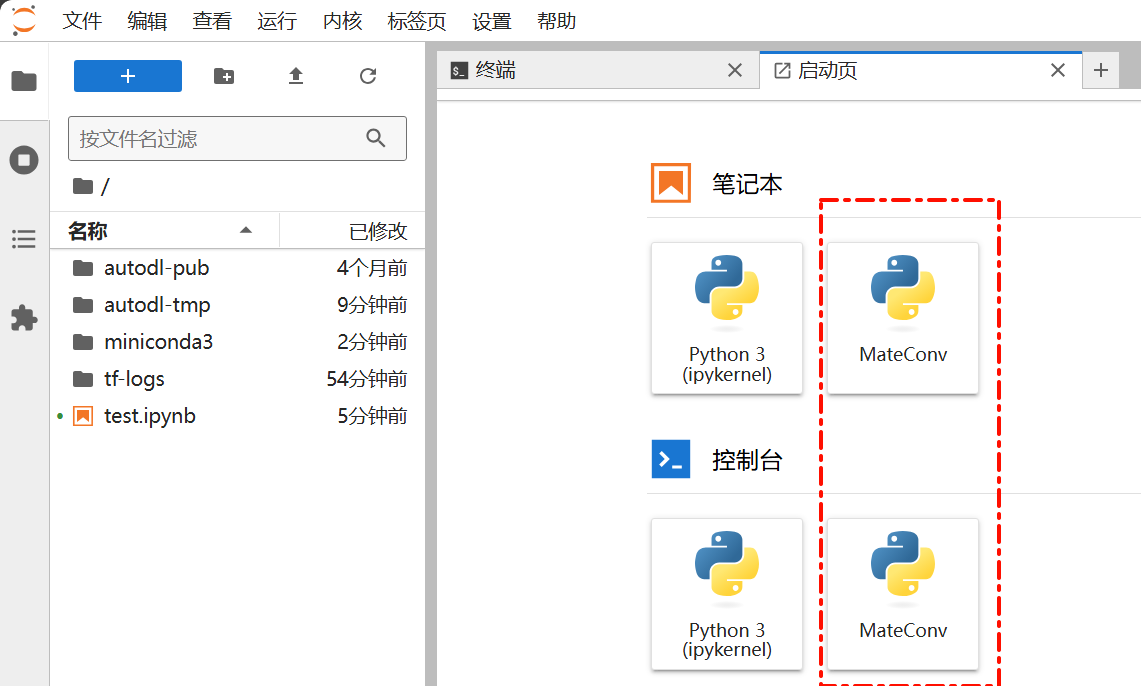

虚拟环境创建和内核安装

- python等环境情况查看

root@autodl-container-af5f4cadf9-7c2af229:~# python --version

Python 3.12.3

root@autodl-container-af5f4cadf9-7c2af229:~# conda --version

conda 24.4.0

- 创建并使用虚拟环境

conda create --name MateConv python=3.12

conda init

source ~/.bashrc

conda activate MateConv

#进入环境,安装内核包,注册Python环境为Jupyter的一个内核,并命名

conda activate MateConv

conda install ipykernel

python -m ipykernel install --user --name [env_name] --display-name [env_name]

- 刷新JupyterLab启动页就可以看到新创建的内核

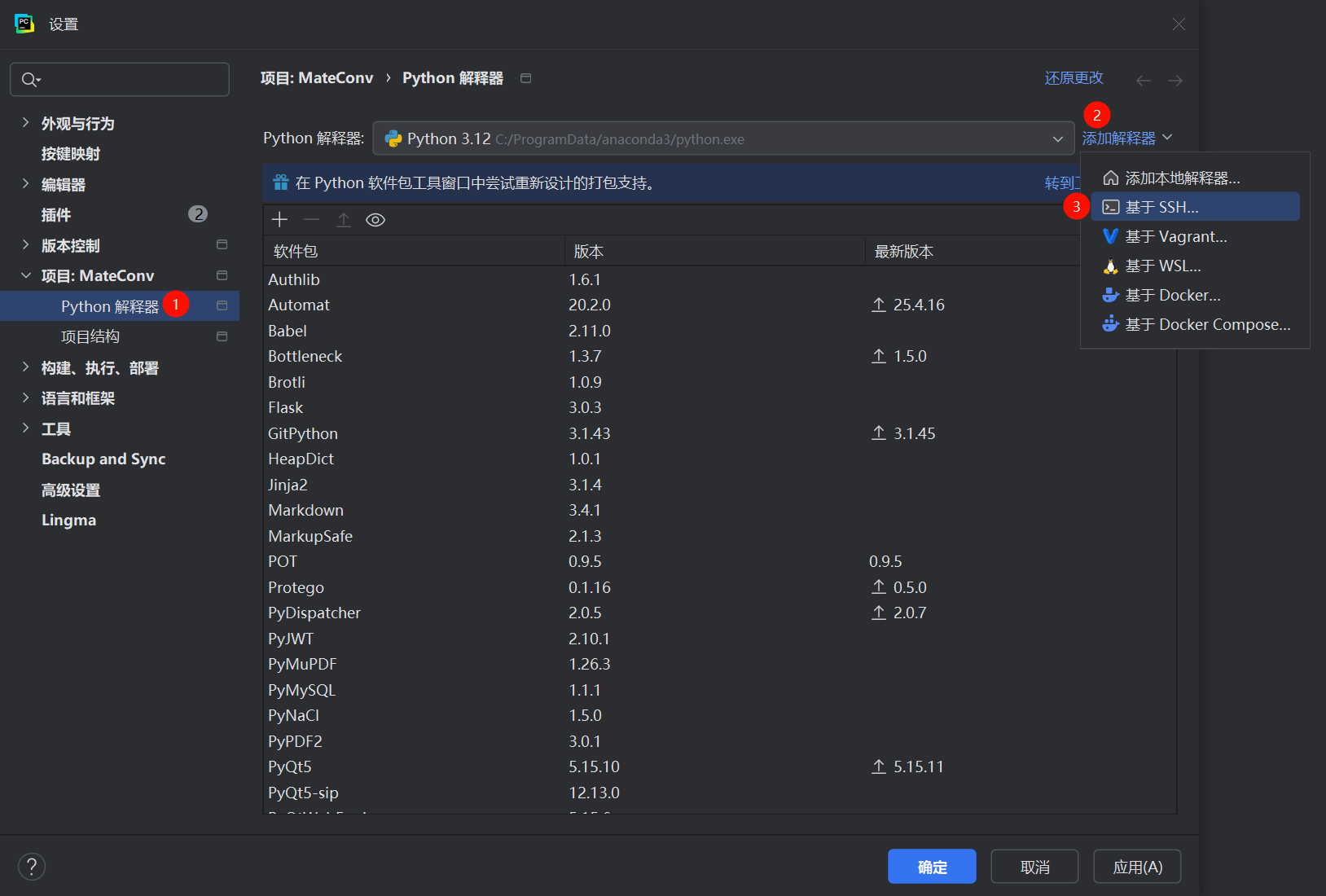

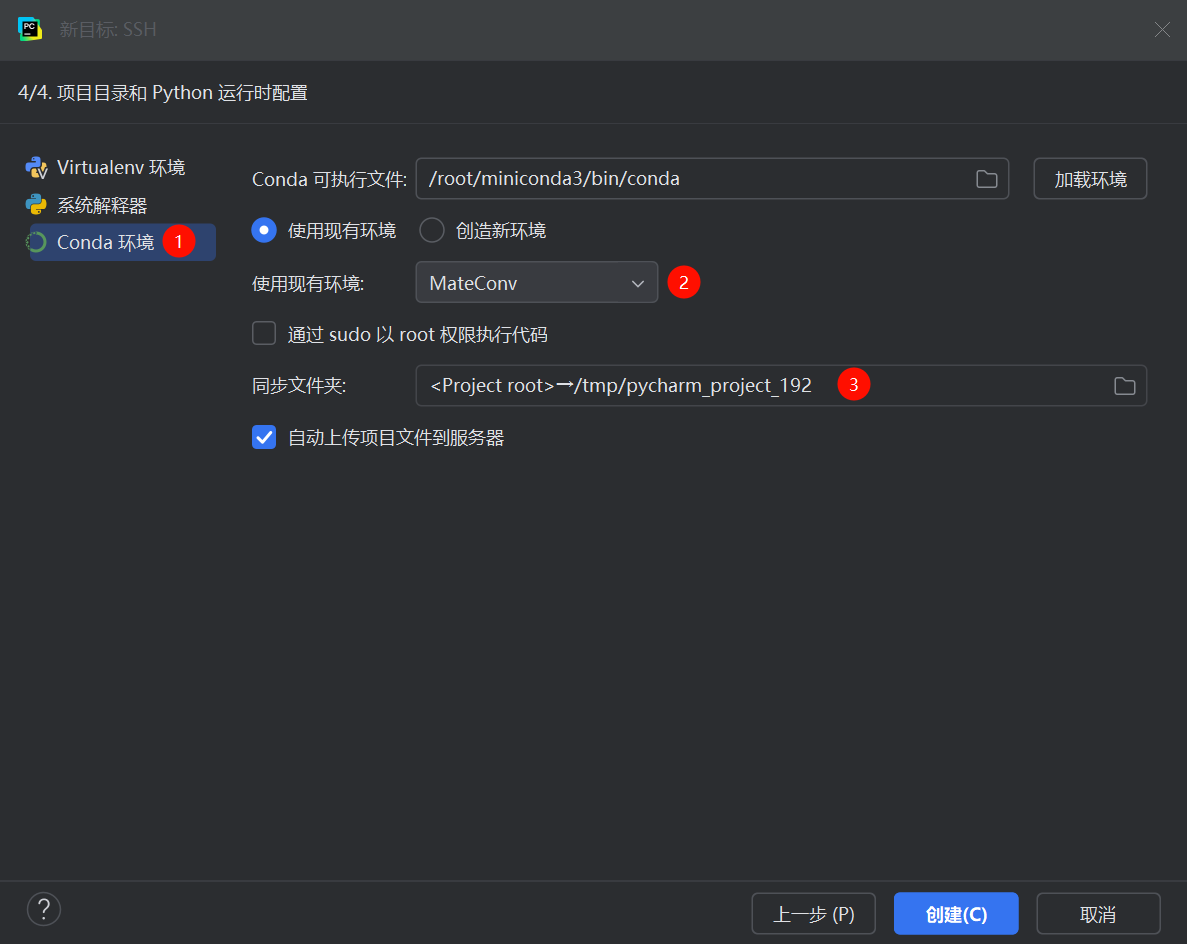

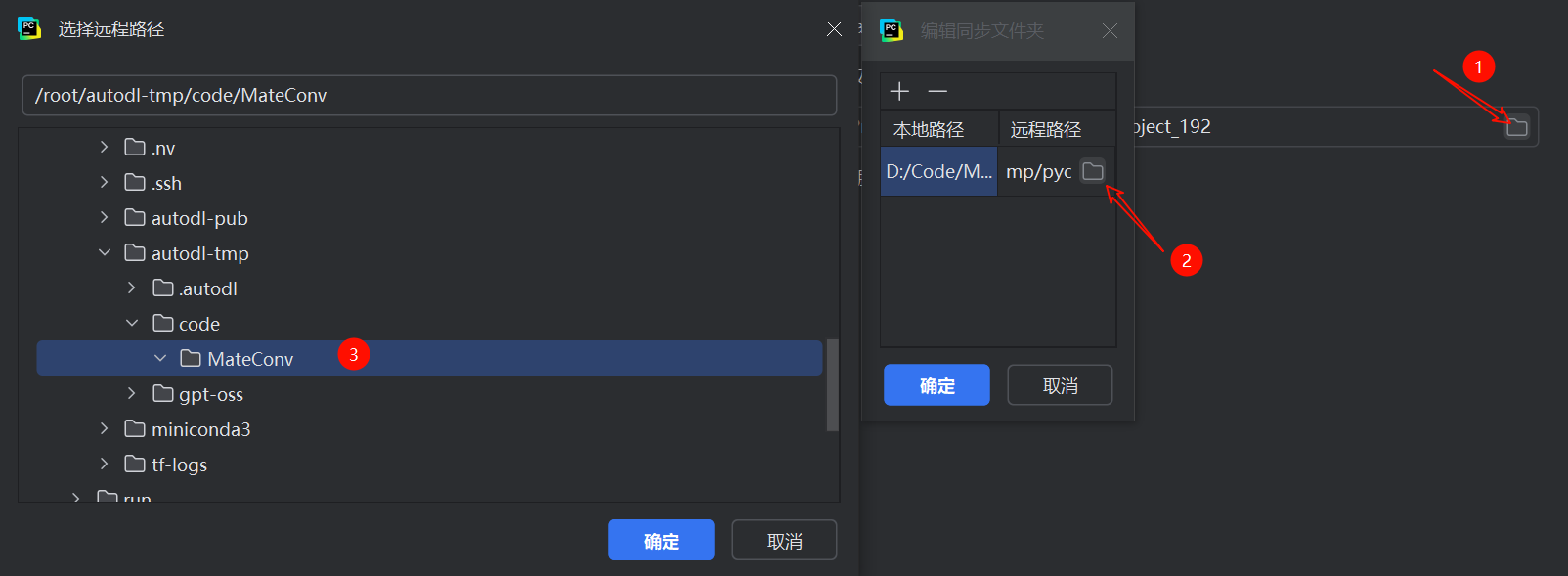

PyCharm连接AutoDL python环境

ssh -p 46614 root@connect.westb.seetacloud.com

# 端口 46614

# 用户 root

# 连接主机connect.westb.seetacloud.com

# 密码 xxx

- 然后确定,等待加载python环境和上传代码即可!

无卡模式使用指南

- 无卡模式:按量计费实例关机后可使用无卡模式开机。无卡模式下CPU:0.5核,内存:2GB,G无卡模式开机PU:0卡,计费:¥0.1/时

- pytorch环境会丢失,如果需要可以先安装CPU版本的pytorch进行暂时使用。

pip install torch torchvision torchaudio --index-url https://download.pytorch.org/whl/cpu - 测试安装效果

import torch print(torch.__version__) print(torch.cuda.is_available())2.8.0+cpu False