打破枷锁:Python GIL下的并发突围之路

一、GIL 的 “紧箍咒”

在 Python 的世界里,Global Interpreter Lock(GIL),也就是全局解释器锁,是一个绕不开的话题,它就像孙悟空头上的紧箍咒,限制着 Python 多线程的并行能力。简单来说,GIL 是 Python 解释器(主要指 CPython)中的一个互斥锁,它确保在同一时刻,只有一个线程能够执行 Python 字节码。

为什么会有 GIL 这个 “紧箍咒” 呢?这要从 Python 的内存管理机制说起。Python 采用引用计数来管理内存,每个对象都有一个引用计数,记录指向该对象的引用数量。当引用计数变为 0 时,对象占用的内存就会被释放。在多线程环境下,如果没有 GIL,多个线程同时修改对象的引用计数,就可能导致内存管理的混乱,比如出现引用计数错误,进而引发内存泄漏或程序崩溃等问题。所以,GIL 的存在主要是为了简化 CPython 的内存管理,保证多线程环境下 Python 对象的访问安全。

虽然 GIL 保证了内存管理的安全性,但它对 Python 多线程性能的影响也是显著的。在 CPU 密集型任务中,由于 GIL 的存在,多线程并不能真正实现并行执行,同一时刻只有一个线程能在 CPU 上运行,其他线程只能等待 GIL 的释放。这就导致了在多核处理器上,Python 多线程程序无法充分利用多核优势,性能提升不明显,甚至可能因为线程上下文切换的开销而比单线程性能更差。

我们来看一个简单的 CPU 密集型任务的例子:

import threading

import timedef cpu_bound_task():result = 0for i in range(10000000):result += idef single_thread():start_time = time.time()cpu_bound_task()cpu_bound_task()print(f"单线程时间: {time.time() - start_time:.2f} 秒")def multi_thread():start_time = time.time()thread1 = threading.Thread(target=cpu_bound_task)thread2 = threading.Thread(target=cpu_bound_task)thread1.start()thread2.start()thread1.join()thread2.join()print(f"多线程时间: {time.time() - start_time:.2f} 秒")if __name__ == "__main__":single_thread()multi_thread()

运行这段代码,你可能会发现,有时多线程版本的执行时间比单线程版本还要长,这就是 GIL 在 CPU 密集型任务中带来的负面影响。

而在 I/O 密集型任务中,情况则有所不同。当线程执行 I/O 操作(如文件读取、网络请求等)时,会释放 GIL,此时其他线程就有机会获取 GIL 并执行。所以,在 I/O 密集型场景下,Python 多线程能够有效利用线程切换的时间来执行其他任务,从而提高程序的整体效率。以下是一个模拟 I/O 密集型任务的示例:

import threading

import timedef io_bound_task():time.sleep(2)def single_thread():start_time = time.time()io_bound_task()io_bound_task()print(f"单线程时间: {time.time() - start_time:.2f} 秒")def multi_thread():start_time = time.time()thread1 = threading.Thread(target=io_bound_task)thread2 = threading.Thread(target=io_bound_task)thread1.start()thread2.start()thread1.join()thread2.join()print(f"多线程时间: {time.time() - start_time:.2f} 秒")if __name__ == "__main__":single_thread()multi_thread()

运行这个示例,你会看到多线程版本的执行时间明显比单线程版本短,这体现了多线程在 I/O 密集型任务中的优势。

GIL 的存在使得 Python 多线程在不同任务场景下表现各异,对于 CPU 密集型任务,它成为了性能提升的阻碍;而对于 I/O 密集型任务,它的影响相对较小,多线程仍能发挥一定的作用。那么,有没有办法绕过 GIL 的限制,实现更高效的并发呢?接下来,我们就来探讨几种替代方案。

二、多进程:另辟蹊径

既然多线程在 CPU 密集型任务中受到 GIL 的限制,那么我们不妨另辟蹊径,采用多进程的方式来实现并发。在 Python 中,multiprocessing模块为我们提供了强大的多进程支持,让我们能够充分利用多核 CPU 的优势。

multiprocessing模块允许我们创建多个独立的进程,每个进程都有自己独立的 Python 解释器和内存空间,这就意味着它们不受 GIL 的限制,可以真正实现并行执行。与多线程相比,多进程在 CPU 密集型任务上具有明显的优势。例如,在进行大规模数据处理、科学计算等需要大量 CPU 计算资源的任务时,多进程能够显著提高执行效率。

下面我们通过一个示例代码来对比多线程和多进程在 CPU 密集型任务中的表现。还是以之前的 CPU 密集型任务为例,我们将其改写成多进程版本:

import multiprocessing

import timedef cpu_bound_task():result = 0for i in range(10000000):result += idef single_process():start_time = time.time()cpu_bound_task()cpu_bound_task()print(f"单进程时间: {time.time() - start_time:.2f} 秒")def multi_process():start_time = time.time()process1 = multiprocessing.Process(target=cpu_bound_task)process2 = multiprocessing.Process(target=cpu_bound_task)process1.start()process2.start()process1.join()process2.join()print(f"多进程时间: {time.time() - start_time:.2f} 秒")if __name__ == "__main__":single_process()multi_process()

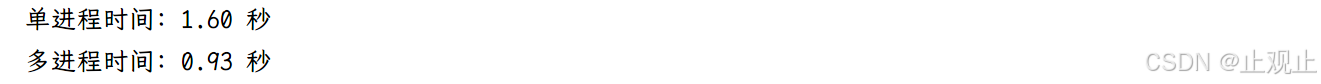

运行这段代码,你会发现多进程版本的执行时间明显比单线程版本短,甚至比之前的多线程版本也要短很多,这充分展示了多进程在 CPU 密集型任务中的强大性能。

多进程方案虽然在 CPU 密集型任务中表现出色,但它也并非完美无缺。其优点主要包括:

-

真正的并行执行:每个进程都有自己独立的 Python 解释器和内存空间,不受 GIL 的限制,能够充分利用多核 CPU 的计算能力,实现真正的并行计算,大大提高 CPU 密集型任务的执行效率。

-

稳定性高:一个进程的崩溃不会影响其他进程的运行,提高了程序的整体稳定性。例如,在一个多进程的数据处理程序中,如果某个进程在处理数据时出现错误崩溃了,其他进程仍然可以继续正常工作。

然而,多进程也存在一些缺点:

-

资源开销大:创建进程需要分配独立的内存空间和系统资源,进程间的切换也会带来一定的开销,所以多进程的资源消耗比多线程大很多。比如,在创建大量进程时,系统的内存占用会显著增加,可能导致系统性能下降。

-

通信和同步复杂:进程间的通信和同步比线程间要复杂得多。因为进程之间内存隔离,需要通过特殊的机制(如队列、管道、共享内存等)来进行数据传递和同步,这增加了编程的难度和复杂性。例如,在使用队列进行进程间通信时,需要注意队列的大小限制和数据的序列化、反序列化问题。

多进程是绕过 GIL 限制、实现高效并发的有效方案之一,尤其适用于 CPU 密集型任务。但在使用多进程时,需要充分考虑其资源开销和通信同步的复杂性,根据具体的应用场景进行合理的选择和优化。

三、异步编程:轻装上阵

除了多进程,异步编程也是应对 GIL 限制、实现高效并发的一种有力武器。在 Python 中,asyncio库为我们提供了丰富的异步编程支持,让我们可以在单线程内实现高效的并发操作。

asyncio库是 Python 3.4 版本引入的标准库,它基于事件循环和协程机制,实现了异步 I/O 操作。其核心原理是通过事件循环来管理和调度协程,当某个协程执行到await语句时,如果await后面的操作是一个 I/O 操作或者其他需要等待的操作,事件循环会将执行权交给其他可执行的协程,当等待的操作完成后,再将执行权交回原来的协程。这样就避免了线程阻塞,提高了程序的并发性能。

下面我们通过一个简单的示例来了解asyncio库的使用。假设我们有多个任务,每个任务都需要执行一些耗时的操作(这里用asyncio.sleep模拟),如果使用同步编程,任务需要依次执行,总时间是所有任务耗时之和;而使用异步编程,我们可以并发执行这些任务,总时间只取决于耗时最长的任务。

import asyncio

import timeasync def async_task(task_name, delay):print(f"{task_name} 开始执行,将耗时 {delay} 秒")await asyncio.sleep(delay)print(f"{task_name} 执行完成")async def main():tasks = [async_task("任务1", 2),async_task("任务2", 1),async_task("任务3", 3)]start_time = time.time()await asyncio.gather(*tasks)end_time = time.time()print(f"总耗时: {end_time - start_time:.2f} 秒")if __name__ == "__main__":asyncio.run(main())

在这个示例中,async_task是一个异步函数,也就是一个协程,它会打印任务开始信息,然后使用await asyncio.sleep(delay)模拟耗时操作,最后打印任务完成信息。main函数中创建了三个async_task任务,并使用asyncio.gather函数并发执行这些任务。asyncio.run(main())用于启动事件循环并执行main函数。运行这段代码,你会发现总耗时约为 3 秒,而不是所有任务耗时之和(2 + 1 + 3 = 6 秒),这就是异步编程的优势,它充分利用了等待时间来执行其他任务,大大提高了效率。

为了更直观地对比异步编程与多线程在 I/O 密集型任务中的表现,我们再来看一个模拟网络请求的示例。假设我们需要从多个 URL 获取数据,每个请求都需要等待一段时间才能得到响应。

import asyncio

import aiohttp

import time

import threadingasync def fetch(session, url):async with session.get(url) as response:return await response.text()async def async_fetch_all(urls):async with aiohttp.ClientSession() as session:tasks = [fetch(session, url) for url in urls]start_time = time.time()results = await asyncio.gather(*tasks)end_time = time.time()print(f"异步编程总耗时: {end_time - start_time:.2f} 秒")return resultsdef sync_fetch(url):import requestsresponse = requests.get(url)return response.textdef multi_thread_fetch(urls):threads = []results = []start_time = time.time()for url in urls:thread = threading.Thread(target=lambda u: results.append(sync_fetch(u)), args=(url,))thread.start()threads.append(thread)for thread in threads:thread.join()end_time = time.time()print(f"多线程总耗时: {end_time - start_time:.2f} 秒")return resultsif __name__ == "__main__":urls = ["https://example.com","https://example.org","https://example.net"]asyncio.run(async_fetch_all(urls))multi_thread_fetch(urls)

在这个示例中,async_fetch_all函数使用asyncio和aiohttp实现了异步的网络请求,multi_thread_fetch函数使用多线程实现了相同的功能。运行代码后,你会发现异步编程版本的总耗时通常会比多线程版本更短,这是因为异步编程在等待网络响应时不会阻塞线程,而多线程虽然也能并发请求,但线程切换和 GIL 的存在会带来一定的开销。

异步编程特别适用于 I/O 密集型任务,如网络爬虫、文件读写、数据库操作等场景。在这些场景中,任务大部分时间都花费在等待 I/O 操作完成上,而异步编程能够充分利用等待时间,在单线程内实现高效的并发,从而显著提高程序的性能和响应速度。同时,由于异步编程不需要创建大量的线程或进程,资源消耗也相对较小。但异步编程也有其局限性,它的代码结构相对复杂,调试难度较大,而且不适用于 CPU 密集型任务,因为在 CPU 密集型任务中,不存在 I/O 等待时间,异步编程无法发挥其优势。

四、其他 Python 实现:另起炉灶

除了上述基于 CPython 的并发解决方案,我们还可以另辟蹊径,选择其他的 Python 实现版本,它们从根源上避免了 GIL 的限制。

Jython:运行在 JVM 上的 Python

Jython 是 Python 的 Java 实现,它将 Python 代码编译成 Java 字节码,运行在 Java 虚拟机(JVM)上。由于 Jython 运行在 JVM 上,它使用的是 JVM 的内存管理机制和线程模型,而不是 CPython 的引用计数内存管理和 GIL 机制,因此不受 GIL 的限制。

Jython 最大的优势在于它能够无缝地与 Java 代码和库进行交互。在 Java 生态系统中,有大量成熟的类库和框架,Jython 可以直接使用这些资源,这为 Python 开发者提供了更广阔的选择空间。例如,在企业级开发中,如果需要使用 Java 的 EJB(Enterprise JavaBeans)框架来构建分布式应用,使用 Jython 就可以很方便地实现 Python 代码与 EJB 的集成。同时,Jython 也具备 Java 的跨平台特性,可以在 Windows、Linux、macOS 等多种操作系统上运行。

然而,Jython 也存在一些不足之处。一方面,Jython 目前最新版本仅支持到 Python 2.7,对于 Python 3 的支持还不完善,这在一定程度上限制了它的应用范围,因为现在越来越多的新项目都基于 Python 3 进行开发。另一方面,由于 Jython 需要将 Python 代码编译成 Java 字节码,再在 JVM 上运行,这个过程可能会带来一些性能损耗,尤其是在执行一些对性能要求极高的计算密集型任务时,其性能可能不如原生的 Python 实现。 此外,Jython 的社区活跃度相对较低,相关的文档和教程也不如 CPython 丰富,这可能会给开发者在使用过程中遇到问题时的解决带来一定困难。

Jython 适用于那些需要与 Java 生态系统紧密结合的项目,比如在 Java 企业级应用中嵌入 Python 脚本,实现动态逻辑;或者在基于 JVM 的大数据处理框架(如 Apache Hadoop、Apache Spark)中使用 Python 进行数据处理和分析。

IronPython:扎根.NET 平台的 Python

IronPython 是 Python 在.NET 平台上的实现,它允许开发者在.NET 环境中运行 Python 代码,并与 C#、VB.NET 等.NET 语言进行无缝协作。与 Jython 类似,IronPython 也不依赖 GIL,它利用的是.NET 的线程和内存管理机制。

IronPython 的主要优势在于其与.NET 框架的高度集成。在 Windows 平台上,.NET 框架提供了丰富的功能和服务,IronPython 可以充分利用这些资源,例如使用 Windows Forms 或 WPF(Windows Presentation Foundation)来创建图形用户界面(GUI)应用程序。同时,IronPython 也能够方便地调用.NET 类库中的各种功能,这使得它在 Windows 平台的开发中具有很大的优势。例如,在开发一个 Windows 桌面应用程序时,如果需要使用.NET 的数据库访问组件来连接 SQL Server 数据库,IronPython 可以轻松实现。

但是,IronPython 也面临一些挑战。其社区活跃度相对较低,更新频率较慢,这可能导致一些新的 Python 特性和库不能及时得到支持。并且,由于 IronPython 依赖于.NET 平台,其跨平台支持有限,主要还是针对 Windows 系统。此外,对于一些依赖 C 扩展的 Python 库,IronPython 可能无法直接使用,这在一定程度上限制了其库的生态系统。

IronPython 适合用于 Windows 平台上需要与.NET 框架深度集成的项目,比如为 C# 或 VB.NET 应用程序添加 Python 脚本扩展,或者在.NET 环境中进行快速原型开发。

PyPy:追求极致性能的 Python

PyPy 是一个用 Python 实现的 Python 解释器,它采用了即时编译(Just-in-Time Compilation,JIT)技术,这使得它在性能上有了显著的提升,尤其是在处理 CPU 密集型任务时。PyPy 不依赖 GIL,通过 JIT 编译器将热点代码(即被频繁执行的代码)动态编译成机器码,从而实现真正的并行执行,大大提高了程序的运行效率。

PyPy 的优势非常明显,其性能表现出色,在许多 CPU 密集型的基准测试中,PyPy 的速度比 CPython 快数倍。例如,在计算斐波那契数列这样的递归计算任务中,PyPy 的执行速度会远远超过 CPython。同时,PyPy 具有高效的垃圾回收机制,能够更好地管理内存,减少内存碎片的产生。此外,PyPy 对 Python 2 和 Python 3 都提供了良好的支持,兼容性较好。

不过,PyPy 也并非十全十美。由于它是一个相对独立的项目,与 CPython 的生态系统存在一定差异,某些依赖 C 扩展的第三方库可能无法直接在 PyPy 中使用,需要进行额外的适配或寻找替代方案。而且,PyPy 的启动时间相对较长,因为它需要加载 JIT 编译器并进行一些初始化工作,这对于一些短时间运行的脚本程序来说可能不太友好。

PyPy 适用于对性能要求极高的 CPU 密集型应用场景,如科学计算、数据分析、复杂算法的实现等。在这些场景中,PyPy 能够充分发挥其性能优势,提高程序的运行效率。

五、C 扩展与 Cython:深入底层

除了上述几种高层级的并发替代方案,我们还可以深入底层,通过编写 C 扩展模块来绕过 GIL 的限制。C 扩展模块是用 C 语言编写的 Python 模块,它可以直接访问 Python 解释器的内部数据结构和函数,执行效率非常高。

编写 C 扩展模块绕过 GIL

在 C 扩展模块中,我们可以通过释放 GIL 来实现真正的多线程并行执行。Python 提供了Py_BEGIN_ALLOW_THREADS和Py_END_ALLOW_THREADS宏来实现这一目的。在执行计算密集型任务的 C 代码段之前,使用Py_BEGIN_ALLOW_THREADS释放 GIL,允许其他线程执行;任务完成后,使用Py_END_ALLOW_THREADS重新获取 GIL。这样,在多核处理器上,多个线程可以同时执行 C 扩展模块中的代码,从而提高程序的并行性能。

下面是一个简单的 C 扩展模块示例,展示了如何在 C 代码中释放和重新获取 GIL:

#include <Python.h>

#include <stdio.h>static PyObject* compute_task(PyObject* self, PyObject* args) {// 释放GILPy_BEGIN_ALLOW_THREADS // 模拟计算密集型任务for (int i = 0; i < 10000000; i++) {// 进行一些计算操作}// 重新获取GILPy_END_ALLOW_THREADS Py_RETURN_NONE;

}static PyMethodDef MyMethods[] = {{"compute_task", compute_task, METH_NOARGS, "Compute-intensive task"},{NULL, NULL, 0, NULL}

};static struct PyModuleDef mymodule = {PyModuleDef_HEAD_INIT,"mymodule", NULL,-1,MyMethods

};PyMODINIT_FUNC PyInit_mymodule(void) {return PyModule_Create(&mymodule);

}

在这个示例中,compute_task函数是一个计算密集型任务,在函数内部,使用Py_BEGIN_ALLOW_THREADS和Py_END_ALLOW_THREADS宏来释放和重新获取 GIL。这样,当多个线程调用这个函数时,就可以实现并行执行。

编写 C 扩展模块需要一定的 C 语言编程基础和对 Python/C API 的了解,因为在 C 扩展模块中,需要使用 Python/C API 来与 Python 解释器进行交互,如创建和操作 Python 对象、处理函数参数和返回值等。同时,由于 C 语言是一种低级语言,编写 C 扩展模块时需要更加小心地处理内存管理、错误处理等问题,以确保程序的稳定性和安全性。

Cython:Python 与 C 的桥梁

Cython 是一种将 Python 代码编译为 C 扩展模块的语言,它结合了 Python 的简洁性和 C 语言的高效性。Cython 的语法与 Python 非常相似,对于 Python 开发者来说,学习成本较低。使用 Cython,我们可以在 Python 代码中直接嵌入 C 代码,或者使用 Cython 特有的语法来声明变量类型、函数参数类型等,从而提高代码的执行效率。

在 Cython 中,我们可以通过声明nogil块来释放 GIL,实现多线程并行执行。例如:

def compute_task():cdef int i# nogil块中释放GILwith nogil: for i in range(10000000):# 进行一些计算操作pass

在这个 Cython 代码示例中,compute_task函数中的with nogil块表示在这个代码块内释放 GIL,允许其他线程并发执行。这样,在多线程环境下,就可以充分利用多核 CPU 的优势,提高计算密集型任务的执行效率。

Cython 使用示例及性能对比

下面我们通过一个完整的示例来展示 Cython 的使用,并对比它与原生 Python 在性能上的差异。假设我们有一个计算斐波那契数列的函数,分别用原生 Python 和 Cython 实现。

原生 Python 实现(保存为py_fibonacci.py):

def fibonacci(n):if n <= 1:return nelse:return fibonacci(n - 1) + fibonacci(n - 2)

Cython 实现(保存为fibonacci.pyx):

def fibonacci(int n):if n <= 1:return nelse:return fibonacci(n - 1) + fibonacci(n - 2)

为了将 Cython 代码编译为 C 扩展模块,我们还需要创建一个setup.py文件:

from setuptools import setup

from Cython.Build import cythonizesetup(name='fibonacci',ext_modules=cythonize('fibonacci.pyx'),

)

在命令行中运行python setup.py build_ext --inplace,即可将 Cython 代码编译为 C 扩展模块。

接下来,我们对比一下原生 Python 和 Cython 实现的性能:

import time

from py_fibonacci import fibonacci as py_fibonacci

from fibonacci import fibonacci as cy_fibonaccistart_time = time.time()

py_fibonacci(30)

print(f"原生Python执行时间: {time.time() - start_time:.2f} 秒")

start_time = time.time()

cy_fibonacci(30)

print(f"Cython执行时间: {time.time() - start_time:.2f} 秒")

运行这段代码,你会发现 Cython 实现的执行时间明显比原生 Python 短,这是因为 Cython 将代码编译为 C 扩展模块后,执行效率得到了大幅提升。尤其是在处理计算密集型任务时,Cython 的性能优势更加显著。

通过编写 C 扩展模块或使用 Cython,我们可以深入底层,绕过 GIL 的限制,实现更高效的并发和计算性能。虽然这种方式需要一定的 C 语言编程基础和学习成本,但对于对性能要求极高的应用场景来说,是非常值得尝试的。

六、总结与展望

在 Python 并发编程的领域中,由于 GIL 的存在,我们需要根据不同的任务类型和应用场景,灵活选择合适的并发替代方案。

多进程适用于 CPU 密集型任务,能够充分利用多核 CPU 的优势,实现真正的并行计算。但它的资源开销较大,进程间通信和同步较为复杂。在进行大规模数据处理、科学计算等对 CPU 计算能力要求高的场景中,多进程是一个很好的选择。

异步编程则是 I/O 密集型任务的利器,通过事件循环和协程机制,在单线程内实现高效的并发操作,资源消耗小。像网络爬虫、文件读写、数据库操作等涉及大量 I/O 等待的场景,异步编程能够显著提高程序的性能和响应速度。

Jython、IronPython 和 PyPy 等其他 Python 实现版本,从根本上避免了 GIL 的限制。Jython 适合与 Java 生态系统结合的项目,IronPython 在 Windows 平台上与.NET 框架集成方面有优势,而 PyPy 在 CPU 密集型任务的性能表现上非常出色。

编写 C 扩展模块和使用 Cython 深入底层,也可以绕过 GIL,实现高效的并发和计算性能。不过,这需要一定的 C 语言编程基础和对 Python/C API 的了解。

未来,随着 Python 社区的不断发展,我们可以期待更高效、更易用的并发编程解决方案的出现。例如,Python 3.11 引入了新的自适应互斥锁,对 GIL 的性能进行了优化,未来或许会有更多针对 GIL 的改进措施,进一步提升 Python 多线程的性能。同时,异步编程的生态系统也在不断完善,更多支持异步操作的库和工具的出现,将使异步编程在更多场景中得到应用。此外,随着硬件技术的发展,多核处理器的性能不断提升,如何更好地利用多核资源,实现更高效的并发编程,也将是 Python 开发者持续关注和研究的方向。