【机器学习深度学习】大模型应用落地:微调与RAG的角色与实践

目录

前言

一、微调与RAG:大模型应用落地的两大支柱

1. 微调(Fine-tuning)

2. RAG(Retrieval-Augmented Generation)

二、微调可以做什么?

1. 模型自我认知调整

2. 对话风格优化

3. 提升问题理解能力

4.为什么不能只靠微调做专业问答系统?

三、为什么专业问答系统更依赖RAG而非微调?

1. 大模型的“幻觉”问题

2. 微调的局限性:静态与数据依赖

3. 成本与效率的权衡

四、微调与RAG的协同应用

1. 微调+RAG的专业问答系统

2. 微调用于初始优化,RAG用于动态更新

五、可视化理解:微调 vs RAG

六、微调的当前落地实践

1. 模型自我认知调整

2. 对话风格优化

3. 提升问题理解能力

六、未来展望:微调与RAG的融合趋势

七、总结

前言

大型语言模型(LLM)在AI领域的广泛应用推动了企业数字化转型和智能化升级。然而,如何让这些模型在特定业务场景中高效落地,成为业界关注的焦点。本文将深入探讨两种关键技术——微调(Fine-tuning)和检索增强生成(RAG),分析它们在专业问答系统等场景中的作用、局限性以及如何结合使用,以实现更精准、可靠的应用落地。

一、微调与RAG:大模型应用落地的两大支柱

| 路径 | 核心思想 | 优势 | 局限 |

|---|---|---|---|

| 🔧 微调(Fine-tuning) | 让模型“学会”你的专属数据 | 精准控制模型行为 | 不可动态扩展,仍有幻觉问题 |

| 🔍 RAG(检索增强生成) | 模型 + 实时知识库 | 动态问答,降低幻觉 | 检索质量依赖知识库和索引策略 |

在将大模型应用于实际业务场景时,微调和RAG是两种常见的技术路径。它们分别从不同角度优化模型的性能,以满足特定需求:

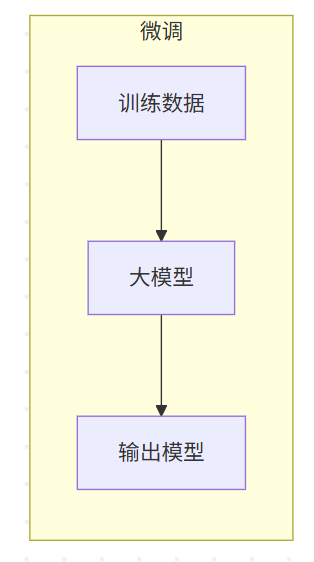

1. 微调(Fine-tuning)

微调是指在预训练的大模型基础上,使用特定领域的私有数据集进一步训练模型,使其更适配特定任务或场景。微调的目标是让模型“学会”处理特定数据,增强其在特定领域的表现。

微调的核心目标:

适配私有数据:通过微调,模型可以更好地理解和生成与企业私有数据相关的输出。

优化特定任务:例如,调整模型的对话风格、语言表达,或针对特定任务(如法律文档分析、医疗诊断辅助)进行优化。

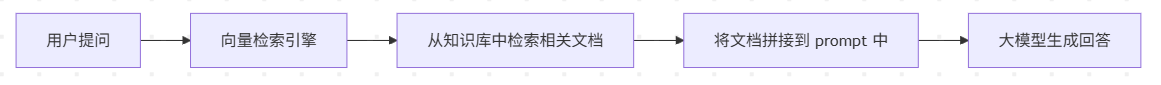

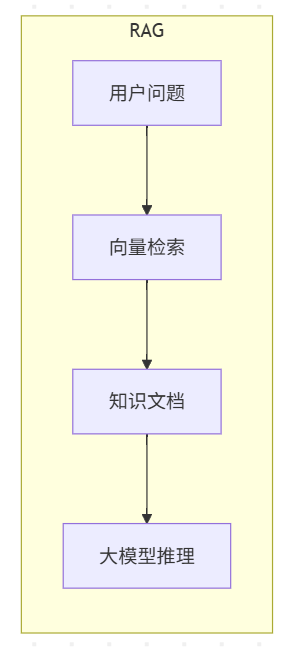

2. RAG(Retrieval-Augmented Generation)

RAG是一种结合检索和生成的技术,通过从外部知识库中检索相关信息,再结合大模型的生成能力,生成更准确、上下文相关的回答。RAG的核心优势在于能够动态引入外部知识,减少模型的“幻觉”问题(即生成不准确或凭空捏造的内容)。

RAG的核心目标:

提升回答准确性:通过检索真实、权威的数据源,降低模型生成错误信息的概率。

动态适应性:RAG可以根据业务场景的变化,动态更新知识库,无需重新训练模型。

RAG(Retrieval-Augmented Generation)提供了更灵活、可靠的落地方案:

✨ “让模型不去记住所有知识,而是去查资料再回答。”

它的工作流程如下:

✅ RAG 优势:

-

🔄 动态更新:知识库随时可改,无需重训模型

-

📉 减少幻觉:提供上下文支持,模型“看着资料”回答

-

🚀 更低成本:只需推理,无需重新训练

二、微调可以做什么?

微调(Fine-tuning)指的是:在已有大模型的基础上,使用特定领域的数据再次训练模型,以适应特定任务或行业。

🧠 目标:让模型“具备处理某类私有数据”的能力。

✅ 微调适合解决的问题:

模型“自我认知”调整:例如你希望模型自称为“小度医生”,而不是“ChatGPT”。

对话风格设定:打造亲切、严谨、专业等风格。

强化问题理解:当模型频繁误解某类专业术语时,可以通过微调让其理解更精准。

微调作为大模型优化的重要手段,在以下场景中发挥了关键作用:

1. 模型自我认知调整

当企业需要模型体现特定的身份或功能时,微调可以帮助模型“记住”这些特性。例如:

名称与品牌调整:让模型以特定名称(如“企业助手小智”)进行自我介绍。

功能介绍优化:通过微调,模型可以更清晰地描述其功能,例如“专注于金融分析的AI助手”。

示例:

**原始模型输出**:我是Grok,一个通用知识的AI助手。

**微调后输出**:我是小智,专为您的企业提供精准的财务分析和决策支持。2. 对话风格优化

微调可以调整模型的语气、风格或语言习惯,以适配不同用户群体的需求。例如:

专业化风格:让模型以更正式、严谨的语言回答法律或医疗相关问题。

轻松化风格:为消费品行业的客服机器人注入幽默、亲切的语气。

示例:

**原始输出**:好的,我会帮您分析这个问题。

**微调后输出**:没问题!让我用最简单的方式为您解答~3. 提升问题理解能力

在专业问答系统中,如果模型对特定领域的问题理解不到位,微调可以帮助模型更好地捕捉用户意图。例如:

在医疗场景中,微调模型以更准确地理解专业术语或复杂问题描述。

在法律场景中,微调模型以识别合同条款中的关键点。

案例: 某医疗企业通过微调,使模型能够准确区分“急性阑尾炎”和“慢性阑尾炎”的症状描述,从而提供更精准的辅助诊断建议。

4.为什么不能只靠微调做专业问答系统?

专业问答系统,特别是金融、医疗、法律类场景,对准确性和实时性要求极高,而微调存在如下硬伤:

🚫 1. 幻觉问题无法彻底解决

微调后的模型,仍可能在缺乏知识的情况下“编造答案”。

这在医疗、法律等领域是灾难性的。

🚫 2. 数据更新困难

微调是“离线训练”,无法动态适应业务变动或新数据。例如你公司出了新产品,模型就得重新训练才能回答。

🚫 3. 成本与部署复杂

-

显存资源消耗大

-

训练门槛高(需懂模型结构)

-

每次改动都得重新部署

三、为什么专业问答系统更依赖RAG而非微调?

尽管微调在某些场景下非常有效,但对于专业问答系统,RAG通常是更核心的技术。原因如下:

1. 大模型的“幻觉”问题

大模型的一个显著缺陷是幻觉(Hallucination),即生成看似合理但实际上错误或凭空捏造的内容。在专业问答系统中,这种错误是不可接受的。例如:

一个离线大模型可能自信满满地回答:“2025年全球GDP增长率为8%”,而这可能是完全错误的猜测。

RAG的解决方案: RAG通过从权威知识库中检索实时、准确的信息(如企业内部数据库、行业报告),大幅降低幻觉发生的概率。例如:

用户提问:“2025年全球GDP增长率是多少?”

RAG流程:

检索最新经济报告,获取权威数据。

结合检索结果,生成准确回答:“根据国际货币基金组织2025年预测,全球GDP增长率预计为3.5%。”

2. 微调的局限性:静态与数据依赖

微调的效果高度依赖训练数据的质量和覆盖范围,且模型一旦微调完成,其知识和能力是静态的。如果业务场景发生变化(如新增数据、行业规则更新),微调模型无法动态适应,必须重新训练。

RAG的动态优势:

RAG通过动态检索外部知识库,能够实时引入最新信息,无需重新训练模型。

例如,在法律问答系统中,RAG可以检索最新的法律法规,确保回答符合当前政策,而微调模型可能基于过时的训练数据。

3. 成本与效率的权衡

微调需要大量标注数据和算力支持,成本较高。而RAG只需维护一个高质量的知识库,结合大模型的生成能力,部署成本更低,维护更灵活。

可视化对比:

| 特性 | 微调(Fine-tuning) | RAG(Retrieval-Augmented Generation) |

|---|---|---|

| 幻觉控制 | 无法完全消除幻觉 | 通过检索权威数据显著降低幻觉 |

| 动态适应性 | 静态,需重新训练以适应变化 | 动态,知识库更新即可适应变化 |

| 部署成本 | 高(需要大量数据和算力) | 较低(维护知识库即可) |

| 适用场景 | 模型风格调整、问题理解优化 | 专业问答、实时信息查询 |

四、微调与RAG的协同应用

其实,在实际落地中,最理想的方式是:

用 微调 调整模型风格和理解能力,用 RAG 管理业务知识和问答内容。

举个例子:

| 任务 | 使用方式 |

|---|---|

| 模型自称为“AI小助手” | ✅ 微调设定对话人格 |

| 回答用户关于合同条款的问题 | ✅ 使用 RAG 检索合同知识库 |

| 用户问题中带有行业术语模型识别不到 | ✅ 微调增强语义理解能力 |

在实际场景中,微调和RAG并非互斥,而是可以互补使用,共同提升大模型的性能。以下是一些典型的应用模式:

1. 微调+RAG的专业问答系统

微调的作用:优化模型对特定领域问题的理解能力,调整对话风格以符合企业需求。

RAG的作用:提供准确、实时的知识支持,减少幻觉,确保回答的权威性。

案例:某金融企业部署了一个投资顾问AI,通过微调让模型掌握金融术语和专业语气,同时通过RAG检索最新的市场数据和法规,确保回答准确且及时。

2. 微调用于初始优化,RAG用于动态更新

微调阶段:在项目初期,通过微调让模型适配企业的业务逻辑和数据特性。

RAG阶段:在运营过程中,通过动态更新知识库,适应业务变化和外部环境变化。

案例:一家电商平台使用微调让模型理解其产品目录的描述逻辑,通过RAG实时检索库存和促销信息,提供精准的购物建议。

五、可视化理解:微调 vs RAG

| 对比维度 | 微调 | RAG |

|---|---|---|

| 能否动态更新知识? | ❌ 不能 | ✅ 能 |

| 是否能彻底解决幻觉? | ❌ 不能 | ✅ 有效缓解 |

| 适合用途 | 风格、语义理解 | 知识注入、专业问答 |

| 是否推荐搭配使用? | ✅ 是 | ✅ 是 |

六、微调的当前落地实践

在实际应用中,微调主要集中在以下场景:

1. 模型自我认知调整

企业通过微调让模型体现品牌特色或特定功能。例如,某教育机构的AI助教被微调为“学习伙伴小智”,能够在回答中突出其教育理念。

2. 对话风格优化

微调可以让模型适配目标用户群体的语言习惯。例如,面向年轻用户的AI客服可能被微调为更活泼、亲切的语气,而面向企业用户的AI则更注重专业性。

3. 提升问题理解能力

在专业领域中,微调帮助模型更准确地理解复杂问题。例如,在技术支持场景中,微调模型能够更精准地识别用户描述的技术问题,并提供针对性的解决方案。

落地案例:

医疗行业:某医院通过微调让模型理解复杂的病历描述,并结合RAG检索最新的医学文献,提供辅助诊断建议。

法律行业:某律所通过微调优化模型对法律条款的理解能力,通过RAG检索最新判例,确保回答符合当前法规。

六、未来展望:微调与RAG的融合趋势

随着大模型技术的不断发展,微调与RAG的结合将成为主流趋势:

-

智能化知识库管理:未来的RAG系统可能通过自动化工具动态优化知识库,提高检索效率。

-

高效微调技术:如LoRA(Low-Rank Adaptation)等参数高效微调技术的普及,将降低微调成本,使其更广泛应用于中小企业。

-

混合架构:结合微调的定制化能力和RAG的动态性,构建更灵活、精准的AI系统。

七、总结

微调和RAG是大模型应用落地的两大核心技术。微调通过优化模型的内在能力,适配特定场景和风格;RAG通过动态检索外部知识,解决幻觉问题并提升回答的准确性。在专业问答系统中,RAG是核心驱动力,而微调则起到辅助优化的作用。两者结合,能够实现更高效、可靠的AI应用落地。

建议:

对于需要高精度、动态更新的场景(如专业问答系统),优先选择RAG,并辅以微调优化用户体验。

对于需要强品牌化或特定风格的场景,微调是不可或缺的工具。

通过合理搭配微调与RAG,企业可以充分发挥大模型的潜力,构建符合业务需求的智能解决方案。

微调和 RAG 并不是对立关系,而是 互补的两种技术路径。正确理解它们的优势和局限,才能在 AI 项目落地中选出最优解,打造可控、智能、可信赖的企业级 AI 应用。