数据治理:DQC(Data Quality Center,数据质量中心)概述

DQC(Data Quality Center,数据质量中心)概述

关键词:DQC、数据质量、数据治理、数据监控、数据可靠性

一、引言:为什么我们需要 DQC?

在数据驱动决策的时代,数据质量已成为企业竞争力的核心要素之一。我们常说“垃圾进,垃圾出”(Garbage In, Garbage Out),如果数据本身存在缺失、重复、错误或延迟,那么基于这些数据做出的分析、报表、推荐系统甚至自动化决策都将失去可信度。

然而,在复杂的数据链路中(从源系统 → 数仓分层 → BI/报表/算法模型),数据在流转过程中极易“污染”。如何在数据流入下游前进行拦截与预警?这就引出了我们今天的主角——DQC(Data Quality Center,数据质量中心)。

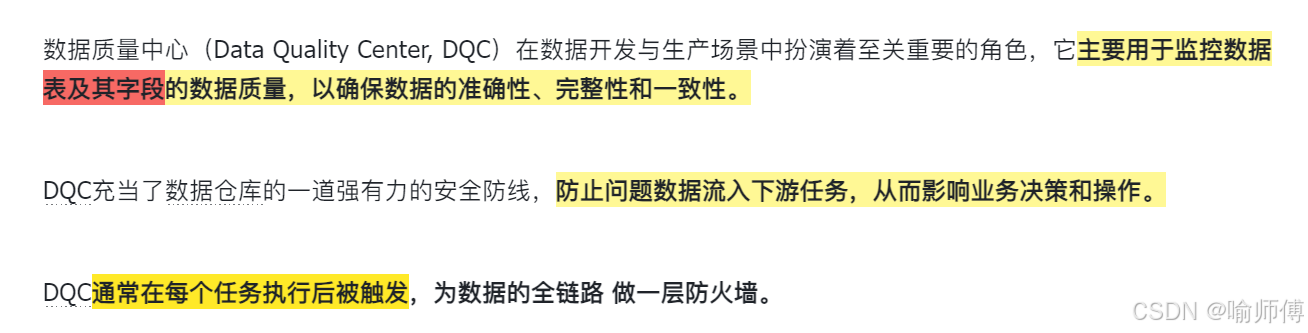

二、什么是 DQC?

DQC(Data Quality Center) 是一套用于监控、评估和管理数据质量的系统或平台,通常集成在数据开发平台中,具备以下能力:

- ✅ 自动化规则配置

- ✅ 实时/准实时质量检测

- ✅ 多维度指标监控

- ✅ 告警通知与阻断机制

- ✅ 质量报告与溯源分析

核心目标:在数据产出后、流入下游前,及时发现异常,防止“脏数据”扩散,保障数据可信。

好的数据质量,不是靠“人肉巡检”维持的,而是靠体系化、自动化、可度量的 DQC 机制保障的。

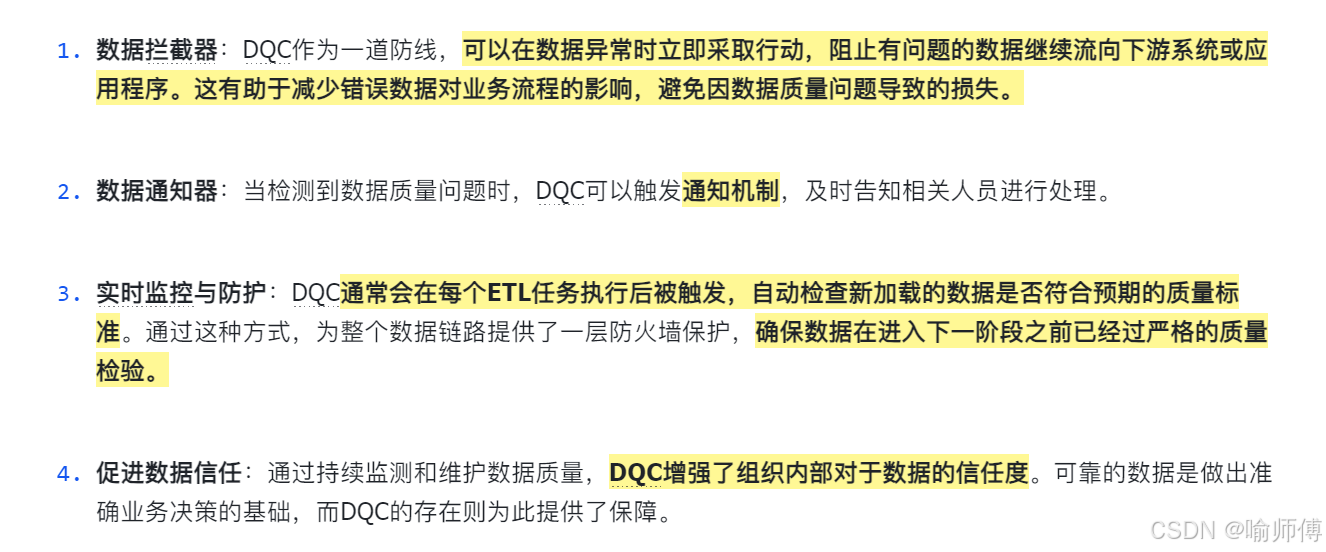

DQC的定位:

DQC常用的几类监控指标:

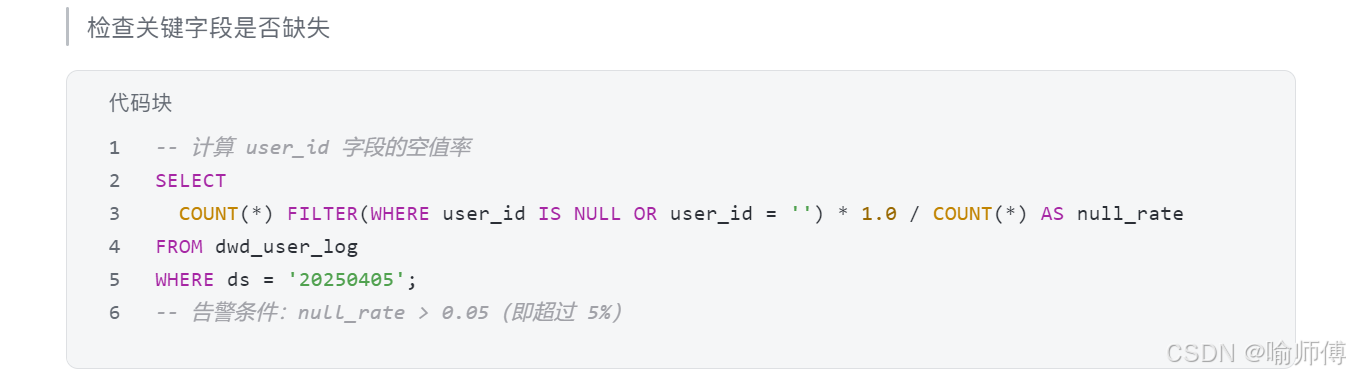

(1)核心字段完整性

- 确保所有必要的数据都存在,并且没有缺失值。 例如:检查字段是否为空或null的比例。

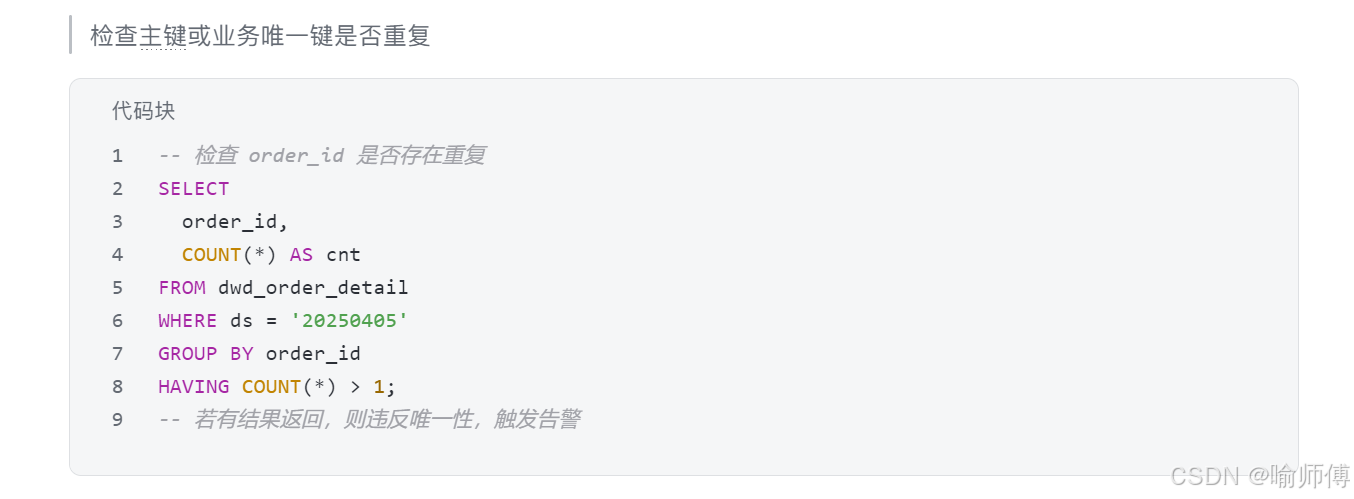

(2)唯一性

- 检查是否存在重复记录或唯一键冲突的问题。确保主键字段的唯一性,防止数据重复录入。

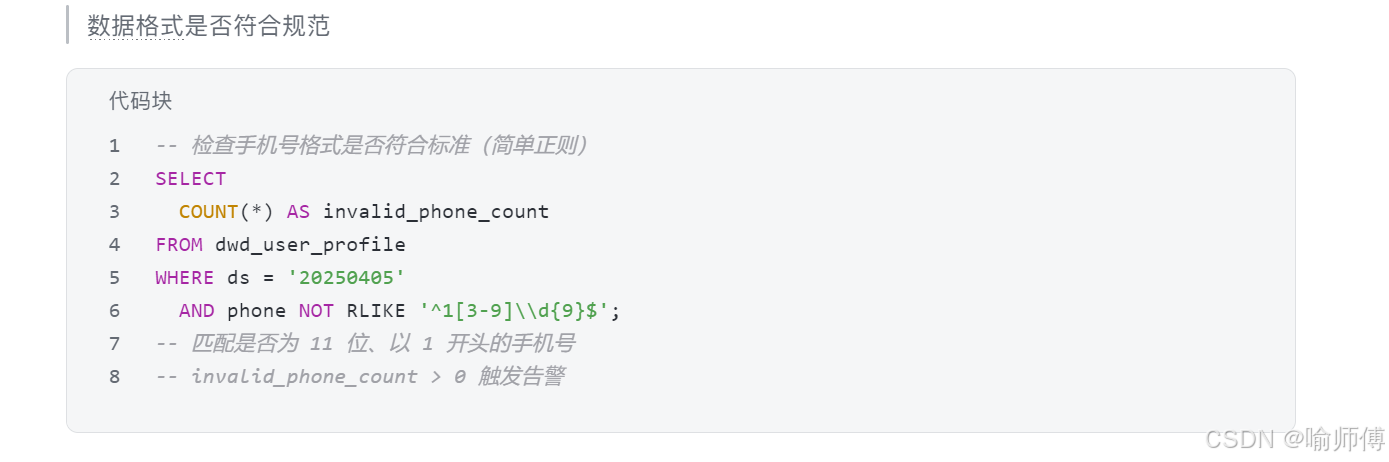

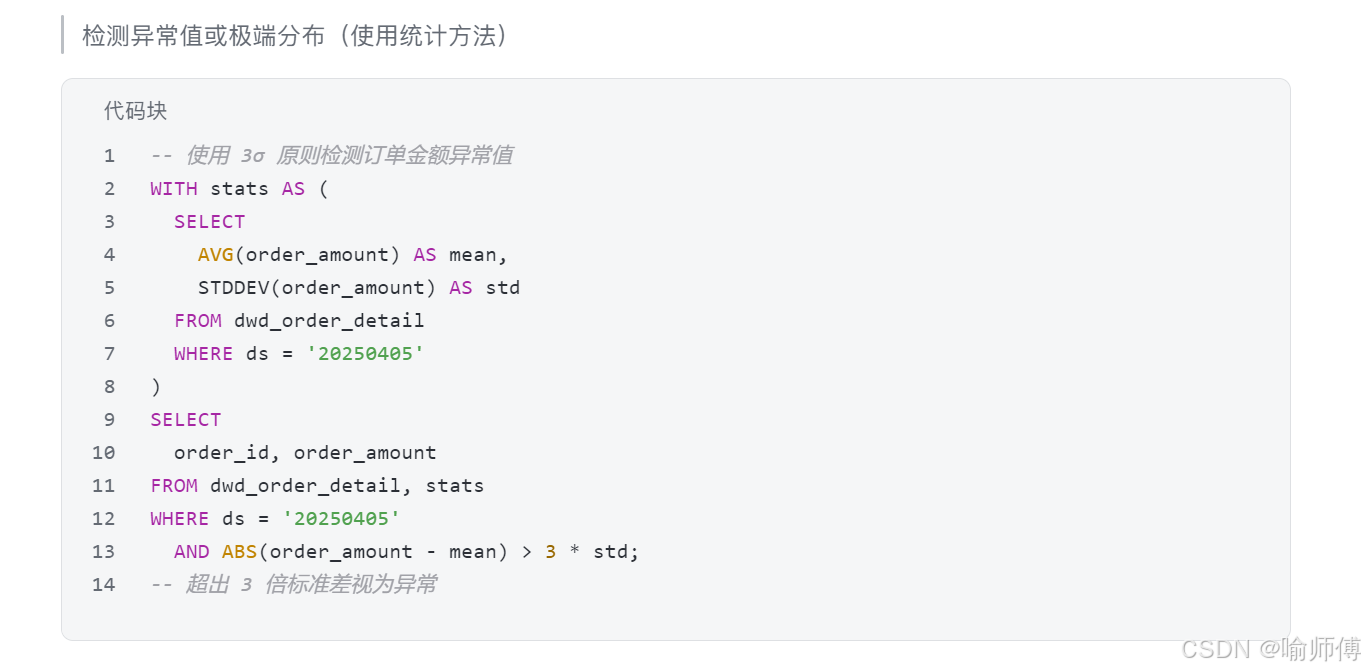

(3)有效性、分布合理性

- 数据格式和类型是否符合预定义的标准。例如:日期格式是否正确,数值范围是否合理等。

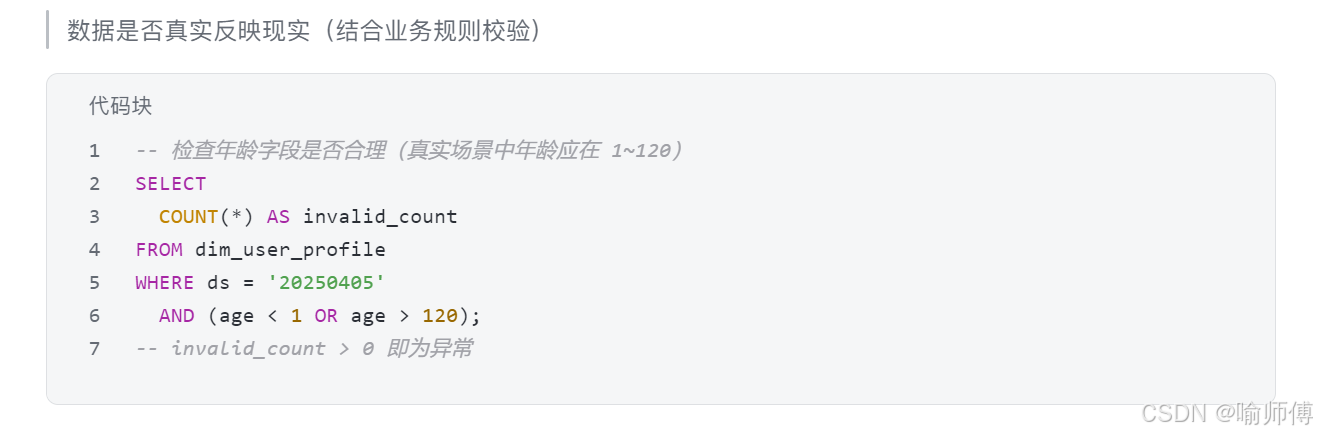

(4)准确性

验证数据是否真实反映现实情况。可以与PM沟通,应用业务规则来检查数据的有效性。

(5)合规性

根据特定行业法规或内部政策要求,确保数据处理过程遵循相关规定。实际中应使用加密、脱敏、权限控制等手段保障合规。

(6)参考完整性

确保外键关系的有效性,即子表中的外键必须能在父表中找到对应的记录。

(7)表数据行增量/减量波动合理性

- 数据行增量波动 > 10%:指的是与前一周期(如前一天、前一周等)相比,当前周期内新增的数据行数增加超过了10%。如果超过这个阈值(这里阈值10%只是举个例子哈,阈值需要根据企业的业务情况去适时调整),可能意味着数据源有异常增长或者数据处理逻辑发生了变化。

三、DQC 最佳实践原则

1. 分层分级监控:按数据重要性设定策略

不是所有表都需要高强度监控。建议根据数据的业务价值和使用范围进行分级:

| 层级 | 说明 | 监控强度 |

|---|---|---|

| S级(核心) | 如订单、用户、交易、收入等 | 强规则 + 实时告警 + 可阻断任务 |

| A级(重要) | 维表、日志汇总表 | 中等规则 + 告警 |

| B级(一般) | 临时表、中间表 | 基础规则 + 日报提醒 |

💡 建议:建立“数据资产目录”,为每张表打标签(S/A/B),DQC 规则自动继承。

2. 多维度质量规则设计

单一指标无法全面反映数据健康度。建议从各个维度去设计:

| 维度 | 指标示例 | 说明 |

|---|---|---|

| 完整性 | 空值率 > 5%、主键非空率 < 100% | 检查关键字段是否缺失 |

| 唯一性 | 主键重复率 > 0% | 防止数据重复写入 |

| 一致性 | 外键匹配率 < 95% | 检查事实表与维表关联是否正常 |

| 波动性 | 行数日环比波动 > ±20% | 检测异常增长或突降 |

| 时效性 | 数据延迟 > 1 小时 | 监控任务产出时间 |

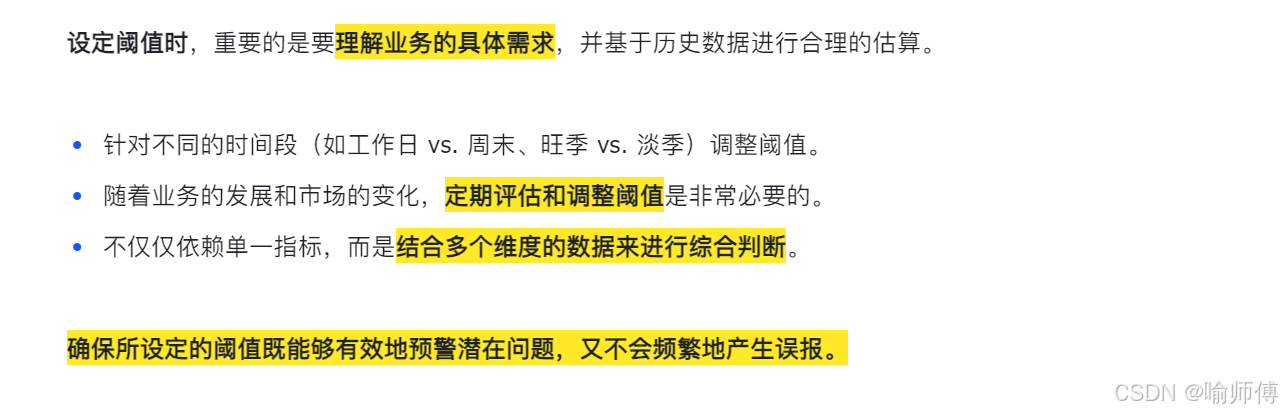

3. 动态阈值 + 业务周期适配

固定阈值(如“行数波动 > 10%”)在实际中容易误报。建议:

- 区分业务周期:大促日(如双11)允许波动更大,日常则收紧阈值。

- 动态基线:使用移动平均、滑动窗口等方式计算“正常区间”。

- 白名单机制:对已知变更(如数据迁移)临时关闭规则。

💡 Demo:

- 日常:订单表行数波动 > ±15% → 告警

- 大促日:波动 > ±50% → 告警

4. 告警分级与闭环处理

告警不是终点,处理才是。建议建立告警分级响应机制:

| 级别 | 触发条件 | 响应方式 |

|---|---|---|

| P0(紧急) | 核心表数据丢失、阻塞性错误 | 立即电话/钉钉通知负责人,可阻断下游 |

| P1(高) | 数据波动大、空值率超标 | 钉钉/企业微信通知,2小时内响应 |

| P2(中) | 维表轻微不一致 | 邮件通知,次日处理 |

| P3(低) | 临时表异常 | 日报汇总,无需即时处理 |

闭环要求:每次告警必须记录原因、处理人、修复方案,形成“问题 → 修复 → 验证”闭环。

5. 质量结果可视化与数据血缘联动

- 质量看板:展示各表/各任务的质量评分、告警趋势、TOP 问题表。

- 血缘联动:当某张表出现质量问题时,自动标记其所有下游依赖任务,防止“污染扩散”。

- 质量评分卡:为每个数据资产生成质量得分(如 95/100),纳入数据治理考核。

Demo:

- 表名、负责人、更新频率

- 最近一次检查结果、历史波动图

- 关联下游任务数、影响范围

DQC 规则配置demo——核心表:dwd_fact_order,:

| 规则类型 | 规则描述 | 阈值 | 告警级别 |

|---|---|---|---|

| 行数波动 | 日订单量环比变化 | > ±20% | P1 |

| 空值率 | order_id 为空的比例 | > 0% | P0 |

| 唯一性 | order_id 重复率 | > 0% | P0 |

| 外键一致性 | user_id 在 dim_user 中匹配率 | < 98% | P1 |

| 字段范围 | order_amount < 0 | 存在负数 | P0 |

| 时效性 | 任务延迟超过 30 分钟 | 是 | P1 |

四、DQC简易流程图

+-------------------+

| 数据任务执行完成 |

| (ETL/ELT Job) |

+--------+----------+|v

+-------------------+

| 触发 DQC 质量检查任务 |

+--------+----------+|v

+-----------------------------+

| 1. 加载目标表 & 元数据信息 |

| (Table, Columns, Rules) |

+-----------------------------+|v

+--------------------------------------------------+

| 2. 执行预定义的质量规则(并行或串行) |

| 例如: |

| - 行数波动检查 (±10%) |

| - 空值率检查 (name IS NULL > 5%) |

| - 唯一性检查 (order_id 重复率 = 0) |

| - 核心字段非空 (user_id NOT NULL) |

| - 数值范围校验 (age BETWEEN 1 AND 120) |

| - 维表一致性 (外键匹配 dim_user) |

+--------------------------------------------------+|v

+-----------------------------+

| 3. 判断规则是否全部通过? |

| ┌────────────┐ |

| ↓ 是 ↓ 否 |

| +----------------+ +------------------+

| | 标记为“质量通过” | | 进入异常处理流程 |

| | 记录日志 | | |

| +----------------+ +--------+---------+

| |

| v

| +------------------------+

| | 4. 异常处理与通知 |

| | - 生成质量报告 |

| | - 标记问题数据行 |

| | - 发送告警(邮件/钉钉/企业微信)|

| | - 可选:阻断下游任务 |

| +--------+-----------------+

| |

| v

| +------------------+

| | 5. 人工介入 or 自动修复 |

| | - 数据回刷 |

| | - 规则调整 |

| | - 重新校验 |

| +------------------+

+--------------------------------------------------+|v

+-----------------------------+

| 6. 更新质量结果到元数据中心 |

| (供溯源、报表、审计使用) |

+-----------------------------+|v

+-----------------------------+

| 下游任务继续执行 or 暂停 |

+-----------------------------+

tips:

在数据仓库体系中,DQC 是数据产出后的第一道防火墙。

每当一个 ETL 任务完成,就会自动触发 DQC 质量检查。

基于预设的规则(比如行数波动超过 ±10%、核心字段空值率超标等)对数据进行扫描。

如果全部通过,数据正常放行;一旦发现问题,系统会立即生成告警并通知负责人,严重时会阻断下游任务,防止脏数据扩散。

所有检查结果都会记录到元数据中心,便于后续溯源和分析。