【机器学习深度学习】量化与选择小模型的区别:如何理解两者的优势与局限?

目录

前言

一、什么是小模型?

1.1 小模型的特点

1.2 小模型的局限

二、什么是量化?

2.1 量化的特点

2.2 量化的局限

三、量化与小模型的区别

3.1 目标不同

3.2 影响的方面不同

3.3 应用场景

3.4 性能差异

3.5 灵活性

3.6 小结:量化与小模型的对比

四、量化和小模型的优劣势

4.1 直观对比

4.2 量化的优势

4.3 量化的劣势

4.4 小模型的优势

4.5 小模型的劣势

五、量化与小模型选择的权衡

5.1 量化适用场景:

5.2 小模型适用场景:

5.3 结合使用

六、量化和小模型的结合

七、技术原理深度解析

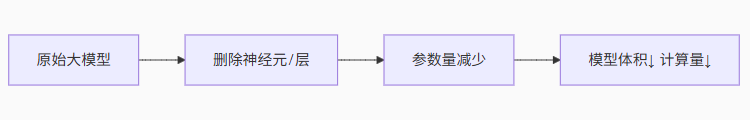

7.1 小模型:减法策略

7.2 量化:压缩策略

八、关键决策因素:如何选择?

九、 颠覆性认知:大模型时代的规则改写

十、终极解决方案:混合策略

十一、总结

前言

随着深度学习模型的快速发展,尤其是在自然语言处理、计算机视觉等领域,我们常常需要在模型的性能和计算资源之间做权衡。为了提高模型的性能和效率,量化和选择小模型是两种常见的优化手段。尽管它们的目标都在于提升效率,但在原理和应用上有着本质的区别。

在本文中,我们将深入探讨量化和选择小模型之间的区别,分析它们各自的优缺点,帮助读者在实际应用中做出更合适的选择。

一、什么是小模型?

小模型指的是参数量相对较少的深度学习模型。通常,这些模型的参数量处于几亿到几十亿之间(例如 0.5B,表示 5 亿个参数)。它们的主要特点是参数数量少,因此模型体积小,计算效率较高。

1.1 小模型的特点

-

参数量少:例如,0.5B 模型的参数量仅为 5 亿个参数。与数十亿甚至上百亿参数的大模型相比,小模型在存储和计算上占用的资源较少。

-

训练和推理速度快:由于参数少,训练和推理过程所需的计算资源和时间相对较少。

-

适用于资源有限的环境:在一些硬件资源有限的场景中(例如边缘计算设备或移动设备),小模型能够以更少的计算资源提供足够的性能。

1.2 小模型的局限

-

性能受限:由于参数量少,小模型的表达能力和性能通常低于大模型,尤其是在复杂任务上。比如,对于复杂的语言生成任务,0.5B 的模型通常无法达到 32B(32亿参数)的模型效果。

-

缺乏灵活性:小模型可能无法很好地适应多样化的任务,尤其是在面对大规模数据时,可能无法学习到足够的特征。

二、什么是量化?

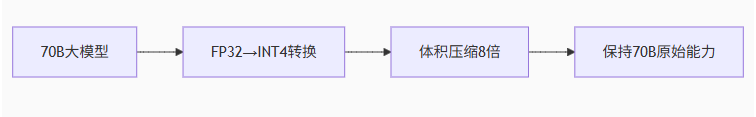

量化是一种优化技术,它通过减少模型中每个参数的精度(例如从 32 位浮点数降为 8 位整数),来压缩模型的体积和加速计算。量化并不改变模型的参数数量,而是减少每个参数所占的存储空间。量化通常应用于大模型和需要高效推理的场景中。

2.1 量化的特点

-

不改变模型结构:量化并不减少模型的参数量,只是减少了每个参数的存储精度。

-

减少存储需求:通过将浮动精度(例如 32 位浮点数)转换为整数精度(例如 8 位整数),量化可以显著减小模型的存储需求。

-

加速计算过程:低精度计算通常比高精度计算速度更快,因此量化后的模型推理速度更快。

-

节省内存带宽:量化减少了参数所需的内存带宽,使得推理过程在硬件上能更高效地进行。

2.2 量化的局限

-

精度损失:由于量化会减少参数精度,可能会导致一定的性能损失,尤其是当量化过度时,模型的表现可能会显著下降。

-

量化带来的挑战:不同任务和不同模型对量化的容忍度不同,量化效果往往需要通过实验调优。

三、量化与小模型的区别

尽管量化和选择小模型都旨在提高效率,但它们的原理和应用场景有着显著的区别。

3.1 目标不同

-

小模型:通过减少模型的参数量来降低计算复杂度,进而减少计算资源消耗。

-

量化:通过降低每个参数的存储精度来减少模型存储需求,并加速推理过程。

3.2 影响的方面不同

-

小模型:减少模型的规模,意味着其表达能力会受到限制,适用于资源有限但对性能要求不高的场景。

-

量化:虽然量化减少了存储空间和计算量,但不会显著影响模型的结构和参数量,因此它保留了原模型的大部分能力。

3.3 应用场景

-

小模型:适用于计算资源非常有限、对模型精度要求不高的场景。例如,边缘设备或低功耗设备上运行的模型。

-

量化:适用于需要保持大模型精度的同时,进行部署优化的场景。通过量化,大模型可以在硬件资源受限的环境下运行,同时尽量保持性能。

3.4 性能差异

-

小模型:由于参数少,小模型通常计算速度快,但性能有限。对于复杂任务,小模型的能力远不如大模型。

-

量化:量化后的大模型依然能发挥较强的性能,但推理速度通常比原始的高精度大模型要快,且占用的内存更少。

3.5 灵活性

-

小模型:适用于特定场景,但面对多样化任务时可能不如大模型灵活。

-

量化:量化不仅可以应用于小模型,也能应用于大模型,具有更高的灵活性。通过量化,大模型能够在资源有限的场景中运行,同时保留大部分性能。

3.6 小结:量化与小模型的对比

以下表格总结了量化与小模型的主要区别:

| 特性 | 量化 | 小模型 |

|---|---|---|

| 参数量 | 不变(例如32B) | 减少(例如0.5B) |

| 存储精度 | 降低(例如从32bit到8bit) | 通常保持高精度(32bit) |

| 存储需求 | 显著减少(与精度成比例) | 较少(与参数量成比例) |

| 性能 | 接近原始模型,略有精度损失 | 受参数量限制,通常低于大模型 |

| 计算复杂度 | 显著降低(低精度计算更快) | 较低(参数量少) |

| 适用场景 | 资源受限设备上的高性能模型 | 低性能需求的轻量级应用 |

四、量化和小模型的优劣势

4.1 直观对比

| 特点 | 量化 | 小模型 |

|---|---|---|

| 优势 | ||

| 保留模型性能 | 保留大模型的高性能,适合需要高精度的场景 | 参数少,资源需求低,适用于资源有限的场景 |

| 高效部署 | 降低存储和计算需求,能在边缘设备或低成本硬件上运行 | 天生轻量,存储和计算需求低,适合嵌入式或移动设备 |

| 灵活性 | 可应用于各种规模的模型,无论是 7B 还是 32B,都能通过调整精度实现优化 | 无需复杂优化流程,直接设计并使用,开发简便 |

| 劣势 | ||

| 精度损失 | 尽管现代技术如QAT能减少精度损失,但复杂任务仍可能受到影响 | 小模型参数量少,性能受到限制,复杂任务中表现差 |

| 硬件依赖 | 低精度计算要求硬件支持 INT8 或 4bit,部分旧设备可能无法充分利用 | 无法通过优化提升性能,模型扩展性差,难以达到大模型的表现 |

总结:

量化 更适合需要高精度、但又希望在资源受限的环境下运行的大模型。它通过调整模型参数精度,降低了计算和存储需求,但可能会牺牲部分精度。

小模型 更适合在硬件资源极其有限的环境中使用,直接设计和部署,通常无需复杂的优化过程,但其性能和扩展性受限。

4.2 量化的优势

-

保留模型性能:量化后的模型通常保留了原始大模型的强大性能,适合需要高精度的场景。

-

高效部署:通过降低存储和计算需求,量化使大模型能够在边缘设备或低成本硬件上运行。

-

灵活性:量化可以应用于各种规模的模型,无论是7B还是32B,都能通过调整精度实现优化。

4.3 量化的劣势

-

精度损失:尽管现代量化技术(如QAT)能尽量减少精度损失,但复杂任务仍可能受到影响。

-

硬件依赖:低精度计算需要支持INT8或4bit的硬件,某些旧设备可能无法充分利用。

4.4 小模型的优势

-

天生轻量:小模型的参数量少,存储和计算需求低,适合资源极为有限的场景。

-

开发简单:小模型通常无需复杂的优化流程,直接设计即可使用。

4.5 小模型的劣势

-

性能受限:参数量少导致模型在复杂任务上的表现不如大模型。

-

扩展性差:小模型的性能上限受架构限制,难以通过简单优化提升到大模型的水平。

五、量化与小模型选择的权衡

5.1 量化适用场景:

-

对于大模型,尤其是在大规模服务器或高效硬件平台上,量化能够显著提高推理效率,而不需要完全放弃大模型的精度。

-

在边缘设备或云端部署中,量化后的大模型能够在相同硬件上进行快速推理,适合需要保持高精度但又要求高效推理的场景。

选择量化:

当你需要部署一个高性能的大模型(如32B)到资源受限的设备上时,量化是首选。例如,智能音箱上运行的语言模型可以通过量化在保持高精度的同时适配有限的硬件。

当硬件支持低精度计算(如GPU或TPU)时,量化的效率优势尤为明显。

适合需要平衡性能和资源占用的场景,如实时翻译或图像处理。

5.2 小模型适用场景:

-

在硬件资源极其有限的情况下,选择小模型更为合适。

-

对于实时推理、低功耗设备、移动设备等场景,选择小模型可以显著减少延迟和能耗。

选择小模型:

当任务对性能要求不高,或者硬件资源极度有限(如低功耗传感器)时,小模型是更好的选择。

适合简单任务,如基本的分类或轻量级嵌入式应用。

当开发周期短或无需复杂优化时,小模型更易于实现。

5.3 结合使用

对于需要兼顾性能和效率的场景,可以选择适中规模的模型并进行量化。例如,7B模型量化后可在智能手机上高效运行复杂的对话系统。

六、量化和小模型的结合

在实际应用中,量化和小模型并非完全对立的策略,有时可以结合使用。例如,可以先设计一个参数量适中的模型(如7B),再通过量化将其压缩到INT8或4bit格式,从而兼顾性能和效率。这种方法在边缘计算中尤为常见,例如在智能家居设备上运行语音识别模型。

以下表格展示了结合量化和小模型的效果(以7B模型为例):

| 配置 | 参数量 | 存储精度 | 存储需求 | 相对推理速度 |

|---|---|---|---|---|

| 7B (FP32) | 7亿 | 32bit | ~28GB | 1x |

| 7B (INT8) | 7亿 | 8bit | ~7GB | ~2.5x |

| 0.5B (FP32) | 0.5亿 | 32bit | ~2GB | ~1.2x |

从表格可见,量化的7B模型在存储需求和推理速度上优于未量化的7B模型,而0.5B模型存储需求最低,但推理速度提升有限。

七、技术原理深度解析

7.1 小模型:减法策略

-

典型场景:MobileNet(参数量仅420万),TinyBERT(参数量1400万)

-

优势:

-

天生轻量,适合超低资源设备(如MCU微控制器)

-

推理延迟极低(无需复杂计算优化)

-

-

代价:

-

能力天花板显著降低:7B参数模型难以达到70B模型的复杂推理能力

-

需重新设计架构(非通用方案)

-

7.2 量化:压缩策略

-

优势:

-

保留大模型能力:70B量化模型性能仍远优于7B全精度模型

-

无需重新训练(PTQ方案)

-

-

代价:

-

可能损失推理精度(需量化校准)

-

依赖运行时支持(如GGUF推理引擎)

-

八、关键决策因素:如何选择?

根据目标场景做技术选型:

| 考量维度 | 优先选小模型 | 优先选量化 |

|---|---|---|

| 硬件资源 | 内存<1GB,无GPU(IoT设备) | 内存>4GB,有CPU/GPU(手机/PC) |

| 任务复杂度 | 简单分类/检测(如物体识别) | 复杂生成/推理(如文案创作) |

| 精度要求 | 允许5%+精度损失 | 需接近原始大模型精度 |

| 开发成本 | 可接受模型重构 | 需快速部署现有模型 |

💡 典型案例:

智能手表语音助手 → 选小模型(0.5B)

手机端Llama 3聊天机器人 → 70B模型+4-bit量化

九、 颠覆性认知:大模型时代的规则改写

传统观念认为“精度决定一切”,但大模型揭示了新规律:

参数量 >> 参数精度

即:70B-INT4模型 > 7B-FP32模型

实验数据佐证(LLM能力对比):

| 模型 | MMLU(知识测试) | GSM8K(数学) | 存储需求 |

|---|---|---|---|

| 7B-FP32 | 45.2% | 12.1% | 14GB |

| 70B-INT4 | 68.7%↑ | 56.3%↑ | 35GB↓ |

| 70B-FP32(原始) | 72.1% | 58.9% | 280GB |

*数据说明:量化后70B模型性能仍碾压小模型,体积仅增2.5倍但能力提升50%+*

十、终极解决方案:混合策略

前沿实践已将两条路径融合:

小架构设计 + 极致量化 = 超高效模型

(例如:1B参数模型 + 2-bit量化 → 仅需250MB内存)

技术演进趋势:

-

训练时量化感知:让模型从出生就适应低精度

-

混合精度量化:关键层保留FP16,次要层压缩至INT4

-

稀疏化+量化:先剪枝去除冗余参数,再量化压缩

十一、总结

| 方法 | 参数量 | 计算复杂度 | 存储需求 | 精度 | 适用场景 |

|---|---|---|---|---|---|

| 小模型 | 少(如 0.5B) | 较低 | 较低 | 可能较低 | 低资源环境,实时推理 |

| 量化 | 不变(大模型) | 较高(如 32B) | 较低 | 保持较高精度 | 大模型部署,硬件优化 |

在大多数实际应用中,量化 和 小模型 并不是对立的选择。根据需求和资源的不同,可以结合两者的优点,选择合适的优化方案。例如,某些场景下可以选择量化后的大模型,确保高效推理,同时保留较高的精度;而在一些计算资源极其有限的情况下,选择小模型则更加直接有效。

选择合适的模型优化方式,需要综合考虑任务复杂性、硬件资源和实时性要求等因素。

【没有最好,只有最合适】

量化是让巨人穿上跑鞋,小模型是培养灵活的短跑选手。当你的应用需要:

保留复杂能力 → 量化大模型

极端资源限制 → 设计小模型

鱼与熊掌兼得 → 小模型+量化

理解这一本质区别,就能在算力与智能的平衡木上走出最优路径。未来的赢家,属于那些能精准匹配模型能力与硬件边界的AI工程师。