线程控制块 (TCB) 与线程内核栈的内存布局关系

在操作系统中,每个线程通常都有两部分关键的内核态存储:线程控制块(Thread Control Block, TCB)和内核栈(Kernel Stack)。TCB包含线程的状态、寄存器信息、调度参数等元数据,而内核栈是线程在内核态执行时使用的栈空间。下面我们通过一系列问题详细解释TCB与内核栈在内存布局中的关系。

TCB所在的内存空间

TCB是否位于内核空间? 是的,在主流操作系统中,线程控制块作为操作系统管理线程的关键数据结构,通常保存在内核空间中。用户程序无法直接访问内核空间的数据结构,因此将TCB置于内核空间可以保证线程状态等敏感信息的安全。例如,在Windows系统中,每个线程由内核对象ETHREAD(执行线程块)和嵌入其中的KTHREAD(内核线程块)表示,这些结构完全存在于内核空间中,用户态不可直接访问[1]。同样地,Linux将线程描述符(task_struct等)保存在内核地址空间中,由内核进行维护[2]。这意味着无论Linux还是Windows,其TCB都由内核分配和管理,位于内核内存区域。

值得注意的是,有些高级语言或用户级线程库会在用户空间维护线程的部分信息(例如Windows的TEB,线程环境块,在用户空间保存线程的线程局部存储等),但那些不属于操作系统内核调度的TCB范畴[1]。操作系统底层调度使用的TCB仍然是在内核中的数据结构。

TCB与内核栈的连续性

TCB和内核栈在内存中是否物理连续? 这取决于操作系统的实现,不同系统甚至同一系统的不同版本有所差异。在一些操作系统设计中,选择将每个线程的TCB结构放置在该线程内核栈的固定位置,这使得它们在内存中相邻连续;而在其他实现中,TCB和内核栈是独立分配的,通过指针关联而非物理毗邻。

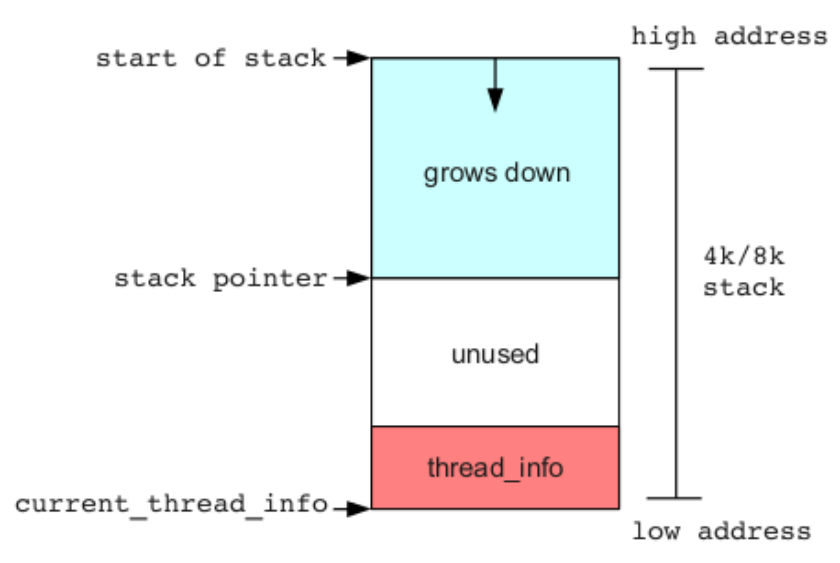

以Linux为例,早期内核版本(例如2.4及以前)曾经直接将进程/线程描述符放在内核栈的末端,实现TCB与内核栈的物理连续[2]。在Linux 2.6引入SLAB分配器之后,task_struct(线程的主要描述符)不再紧贴栈分配,而是改为动态分配。因此Linux引入了一个较小的体系结构相关结构thread_info,将其放在每个线程内核栈的底部[3][4]。也就是说,在Linux 2.6和后续的3.x版本中,每个线程的内核栈空间的低地址处存放thread_info结构,其余大部分高地址区域作为实际的栈空间使用[5][6]。由于栈在大多数架构上向下生长,thread_info位于栈最低地址处,和栈内存连续共享同一内存块,如下图所示:

图:Linux内核中每个线程的内核栈与TCB (thread_info) 在内存中的布局示意图。其中红色部分为线程控制信息thread_info,上方白色和蓝色部分为内核栈(栈从高地址向低地址增长)[4][7]

在上述布局下,TCB(thread_info)和栈实际共享了一段物理内存(通常是若干页,例如x86上典型的是两个连续的物理页组成一个8KB的栈区域,其中底部若干字节用于thread_info)[6][8]。通过这种方式,内核可以通过当前栈指针快速计算出TCB的位置,例如在x86架构上,将栈指针按栈大小对齐屏蔽低位即可定位当前线程的thread_info结构,从而获得指向完整线程描述符(task_struct)的指针[9][10]。这种计算利用了TCB与栈的固定相对地址关系,无需在寄存器中专门保存当前线程指针[9]。

然而,并非所有系统都采取TCB与栈连续的布局。Windows操作系统自始至终采用分离分配的策略:每创建一个线程,会分别为其分配内核栈和线程对象(ETHREAD/KTHREAD),二者在内存中并不相邻[11]。Windows内核通过在KTHREAD结构中维护指向该线程内核栈的指针和边界信息(如InitialStack、StackLimit等)来关联它们[11]。也就是说,Windows的TCB(可以理解为ETHREAD/KTHREAD)和内核栈没有固定位移关系,而是通过指针字段互相关联。这种方式下,它们通常不会共享同一页框,也不要求物理连续。

每线程的TCB和内核栈:独立分配与关联

操作系统是否为每个线程分配独立的TCB和内核栈,它们之间如何关联? 是的,主流操作系统为每个线程都会单独分配自己的TCB和内核栈。这样在线程切换时,内核能够切换到目标线程各自的内核栈,并恢复/保存对应的寄存器上下文。关键在于如何将这两者关联以便相互找到对方:

- 独立的TCB和栈:无论TCB与栈是否紧邻,每个线程都有自己专属的TCB结构和内核栈空间,彼此独立,不会与其他线程混用。这是线程并发运行和隔离的基础。例如,Linux中的task_struct加上(旧版中的)thread_info组成了线程的控制块信息,而每个线程还拥有自己的一段内核栈内存;Windows中的ETHREAD/KTHREAD表示线程,并有自己的一块内核栈区域。

- 关联方式:如果TCB(或其子结构)与栈放在一起(如Linux旧机制),关联非常直接——在栈内存的固定偏移处就是TCB。在这种情况下,内核通常通过数学计算或宏(如Linux中的current_thread_info())由栈地址得到TCB地址[10]。反之,如果TCB和栈分离分配,则需要通过指针建立关联。例如,在Windows的KTHREAD结构中有字段保存该线程内核栈的起始地址和当前栈指针,线程调度切换时会更新CPU的栈指针到该地址[12][13]。同样,KTHREAD也保存了栈的边界(栈底)用于检测溢出等[11]。在Linux中,引入THREAD_INFO_IN_TASK配置后,线程的thread_info被嵌入到task_struct中,不再位于内核栈内存里[14][15]。此时,每个task_struct中会有指针指向该线程独立分配的内核栈起始地址,并通过该指针在需要时访问栈(例如设置TSS的esp0用于中断时切换栈)[16]。

总的来说,每个线程都有各自的TCB和内核栈,两者要么共享一段内存、通过固定偏移定位,要么完全独立、通过指针互相引用。这样的设计保证线程在内核态运行时有独立的栈,不会彼此干扰,同时内核可以根据当前线程快速找到其控制块信息。

不同系统中的组织方式:Linux vs. Windows

不同操作系统对于TCB和内核栈的内存布局实现有所不同。下面分别介绍Linux内核(以2.6、3.x直到近年的5.x为例)和Windows NT系列(包括现代的Windows 10/11)中TCB与内核栈的组织方式。

Linux内核中的TCB与内核栈布局

Linux 2.6/3.x时代:TCB(thread_info)在栈中 – 在Linux 2.6到3.x内核中,每个线程的内核栈大小通常是固定的(比如x86架构上THREAD_SIZE为8192字节,即两个物理页)[17][6]。内核通过定义一个联合体 union thread_union 将 struct thread_info 和一个大小为THREAD_SIZE的栈数组组合在一起,这实际上保证了thread_info结构占据栈内存的底部,而上方剩余空间用于内核栈[6]。换言之,thread_info与内核栈共享同一段连续内存,只是各占其中一部分[6][8]。thread_info包含一个指向真正线程描述符(task_struct)的指针以及少量标志和CPU编号等字段[18][19]。由于thread_info位置固定不变(栈底部),Linux可以通过当前栈地址很快地推算出当前线程的thread_info地址(例如屏蔽栈指针低13位对齐到8KB边界)[10][20],再通过thread_info里的task指针找到完整的task_struct[21][22]。

这种设计在Linux中有两个历史原因:其一,早期Linux(2.4及以前)曾将task_struct直接存在栈末端以便快速通过栈指针拿到进程描述符,但task_struct体积较大(>1KB)会占据过多栈空间[3][5]。2.6后改为将精简的thread_info置于栈底,既实现快速定位,又将完整task_struct改为通过slab单独分配[3][5]。其二,thread_info结构体与栈共址还带来微小的性能优势:在x86这样的寄存器紧缺架构上,无需耗费额外寄存器保存当前线程指针,只靠栈地址计算即可[9][23]。

然而,这种将TCB置于栈内的方式有安全隐患:如果内核栈发生溢出,位于栈底的thread_info可能被覆盖,从而破坏线程的关键信息[24][15]。实际中就曾发生过利用内核栈溢出篡改thread_info进而提权的攻击思路[25][26]。为增强健壮性,Linux从Linux 4.x/5.x开始逐步改进了这种布局:

Linux 5.x新时代:TCB与栈分离 – 近年的Linux内核已经支持将thread_info移出栈内存的方法。通过启用配置选项CONFIG_THREAD_INFO_IN_TASK,thread_info结构被嵌入为task_struct的第一个成员,从而彻底脱离栈的内存[14][27]。在这种组织下,每个线程的task_struct仍由slab分配,而内核栈则独立通过vmalloc或内存池分配(常与防溢出的卫戍页结合)[28][29]。由于不再依赖thread_info在栈中的位置,Linux改用其它途径获取当前线程指针,例如对x86架构,引入了gs寄存器指向CPU的per-CPU区域保存当前任务指针,或者使用每CPU变量来存储current任务[14][15]。总之,Linux新版本中TCB和内核栈不再共用同一段内存,二者通过指针关联:在task_struct中有指向该线程内核栈的起始地址(例如task_struct->stack),内核态切换时使用该地址作为新线程的栈基址[30][31]。此外,新版Linux对每个内核栈采用虚拟映射并在末尾留出一页空洞作为保护,当栈溢出越界时会立即触发页故障停止线程,从而避免损坏相邻内存[28][32]。这种改进提升了系统可靠性和安全性。

小结: Linux内核的TCB与内核栈布局经历了从“同一内存、紧邻分配”到“分离分配、指针关联”的转变:2.6/3.x将精简TCB(thread_info)置于栈底(与栈连续),而5.x开始逐步将其移出栈(与栈独立)[14][15]。无论哪种方式,每个线程都有自己独立的TCB和内核栈,旧机制下通过固定偏移关联,新机制下通过指针字段关联。

Windows系统中的TCB与内核栈布局

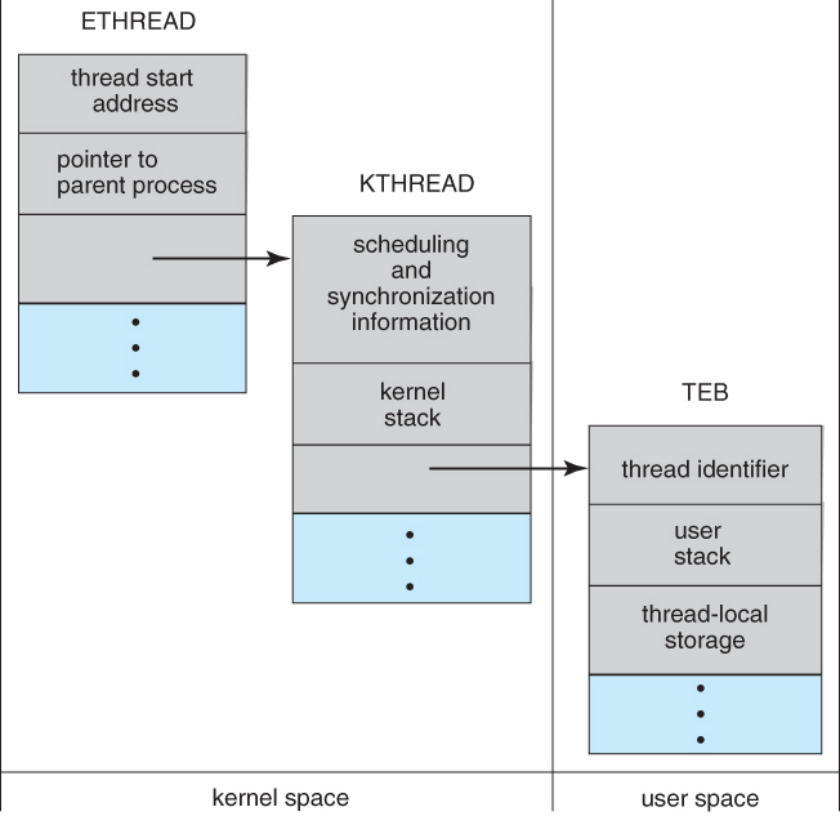

Windows的线程管理也体现为线程对象与内核栈两部分,但组织方式自Windows NT以来一直是分离的。每个Windows线程在内核中对应一个ETHREAD(执行体线程)结构,其中包含了一个KTHREAD内核线程块作为TCB。KTHREAD负责调度运行时的信息,包括线程的调度状态、优先级、等待队列等,同样也保存了该线程内核栈的管理信息[11]。当线程被创建时,Windows内核会为其分配内核栈空间(默认大小取决于架构和版本,例如在x86下通常为12KB栈加4KB保护页,在x64下常为24KB栈等)以及分配ETHREAD/KTHREAD结构。不同于旧版Linux的紧邻设计,Windows不会将KTHREAD放在栈内存里;相反,KTHREAD通过成员变量记录着栈的起始地址和边界地址。例如,KTHREAD结构包含InitialStack(初始栈顶)和StackLimit(栈底)字段,指明该线程内核栈的内存范围[11]。还有一个KernelStack指针用于存储线程当前的栈指针位置,当线程被切换出去时,CPU的栈指针值会保存到KernelStack,以便下次恢复[12][13]。在线程切换时,调度代码会将即将运行的新线程的KernelStack值加载到CPU的栈指针寄存器,从而切换到新线程的内核栈上继续执行[12][16]。

图:Windows内核中线程的数据结构示意(ETHREAD包含KTHREAD,在内核空间),以及每线程对应的内核栈和用户栈的位置关系。绿色/灰色部分表示ETHREAD/KTHREAD的信息,如线程起始地址、调度同步信息等;蓝色部分表示各自的栈。可以看到,KTHREAD通过指针引用内核栈,而用户栈存在于用户空间的地址范围内。

如上图所示,Windows线程的TCB (ETHREAD/KTHREAD) 位于内核空间,内核栈也是在内核空间分配的一块独立内存。此外还有每线程的用户栈位于用户空间(TEB线程环境块则位于用户空间并包含指向用户栈、线程局部存储等的信息)[1][33]。需要强调的是,Windows内核栈和TCB不共享内存页框:ETHREAD对象通常由内核非分页池分配,而内核栈则是在内核地址空间中划出一段连续虚拟页并预留一页保护。ETHREAD包含指向其KTHREAD的指针或直接嵌入KTHREAD结构[34][35],而KTHREAD通过上述字段指向栈地址。因此TCB和栈通过指针双向关联:内核可以从KTHREAD找到栈地址范围,同样在需要从栈找到所属线程时,可以通过每帧栈保存的线程信息或通过PCR(Processor Control Region,处理器控制区)中的当前线程指针找到KTHREAD来定位ETHREAD[16][36]。

Windows的这种设计在各版本(从NT系到Win10/11)基本一致,没有像Linux那样经历TCB嵌入栈的阶段。因为内核栈典型比用户栈小且空间宝贵,Windows非常注重防止栈溢出导致的不良后果。使用独立页来隔离栈并设置保护页框,当出现栈 overflow 时会触发蓝屏错误(如典型的0x7F错误码表示双重fault,常由栈耗尽引起)[37][38]。这种“一旦栈溢出即隔离故障”的策略有效保护了相邻的内核对象(包括TCB)不被覆写。因此,在Windows中每个线程的TCB和内核栈始终保持分离的内存布局,由TCB中的指针保持两者关联和切换。

总结

综上,线程控制块(TCB) 通常位于内核空间,由操作系统内核维护[1]。TCB和内核栈是否物理连续取决于实现策略:Linux早期版本选择将TCB(或其精简结构)置于内核栈内存的一端,使它们共享连续内存[4][6];现代Linux和Windows则将两者分开独立分配,通过指针互相引用[14][11]。无论哪种方式,每个线程都会有自己独立的TCB和内核栈。在Linux系统中,历史上TCB与内核栈曾紧密相邻(如将thread_info置于栈底),但新版本内核已将TCB从栈中分离出来嵌入任务结构[14][15]。在Windows系统中,自始至终TCB和内核栈都是独立内存区域,TCB通过保存栈指针和边界来管理线程的内核栈[11]。两种架构虽实现不同,但目标一致:既要让每个线程拥有隔离的内核栈空间用于内核态执行,又能让内核方便地根据当前执行线程找到其控制块,以进行调度和资源管理。

参考资料: 操作系统内核源码及文档对于TCB与内核栈布局有详细描述,可参阅Linux内核关于线程描述符和栈的注释[2][18]以及Windows内部原理关于ETHREAD/KTHREAD的结构说明[1][11]等以获取更深入的信息。

[1] [33] Operating Systems: Threads

https://www.cs.uic.edu/~jbell/CourseNotes/OperatingSystems/4_Threads.html

[2] [4] [7] [10] [18] [19] [20] [21] [22] Process Descriptor and the Task Structure

https://litux.nl/mirror/kerneldevelopment/0672327201/ch03lev1sec1.html

[3] [5] [9] [23] multithreading - Linux Kernel: Threading vs Process - task_struct vs thread_info - Stack Overflow

https://stackoverflow.com/questions/21360524/linux-kernel-threading-vs-process-task-struct-vs-thread-info

[6] [8] [17] repository.root-me.org

https://repository.root-me.org/Exploitation%20-%20Syst%C3%A8me/Unix/EN%20-%20Exploiting%20Stack%20Buffer%20Overflows%20in%20the%20Linux%20x86%20Kernel.pdf

[11] [37] [38] The NT Insider:Don't Blow Your Stack -- Clever Ways to Save Stack Space

https://www.osronline.com/article.cfm%5Earticle=347.htm

[12] [13] [16] [36] Reverse Engineering 0x4 Fun: Windows Internals - A look into SwapContext routine

http://rce4fun.blogspot.com/2014/09/windows-internals-look-into-swapcontext.html

[14] [15] [24] [27] [30] [31] Mitigating Stack Overflows - Analysis on Kernel Self-Protection: Understanding Security and Performance Implication

https://samsung.github.io/kspp-study/

[25] [26] Exploiting Stack Overflows in the Linux Kernel | Jon Oberheide

https://jon.oberheide.org/blog/2010/11/29/exploiting-stack-overflows-in-the-linux-kernel/

[28] [29] [32] virtually mapped stacks and thread_info cleanup [LWN.net]

https://lwn.net/Articles/694348/

[34] [35] CodeMachine - Article - Catalog of key Windows kernel data structures

https://codemachine.com/articles/kernel_structures.html