当AI学会“说人话“:Azure语音合成技术的魔法世界

你有没有想过,有一天你的电脑能用周杰伦的声音给你念新闻?或者让你家的智能音箱用你妈妈的声音叫你起床?别笑,这些早就不是科幻了。今天咱们就来聊聊微软Azure的语音合成技术——一个能让机器"开口说话"的神奇工具箱。

一、开场白:机器为什么要学说话?

记得小时候看《变形金刚》,擎天柱那浑厚的声音让人印象深刻。但你知道吗?给一个没有"嘴巴"的机器赋予声音,比让它学会识别图片要难得多。

现在,语音合成(Text-to-Speech,简称TTS)技术已经无处不在:

-

你在导航时听到的"请在500米后右转"

-

盲人朋友使用的屏幕阅读器

-

有声书平台那些"永不疲惫"的播音员

-

智能客服那温柔(有时也很机械)的问候

但传统的TTS有个致命问题——听起来就像"机器人"。单调、僵硬、毫无感情,听久了让人抓狂。这就是为什么Azure Speech Service的出现堪称行业地震:它用神经网络让机器说出了"人话"。

二、技术架构:这套系统到底有多厉害?

2.1 核心能力全景图

Azure Cognitive Speech TTS就像一个超级工具箱,提供了从基础到高级的完整解决方案:

┌─────────────────────────────────────────────────────────┐

│ Azure Speech Service TTS │

├─────────────────────────────────────────────────────────┤

│ 基础层:预置神经语音(400+种声音,支持140+语言) │

├─────────────────────────────────────────────────────────┤

│ 高级层:Custom Neural Voice(定制专属品牌音色) │

├─────────────────────────────────────────────────────────┤

│ 应用层: │

│ • 长音频合成 API │

│ • 发音评估引擎 │

│ • TTS Avatar(会说话的虚拟形象) │

│ • 实时对话合成 │

└─────────────────────────────────────────────────────────┘

2.2 神经网络语音合成:技术突破点在哪?

传统TTS采用的是"拼接合成"或"参数合成",简单说就是把录好的音节像拼乐高一样组装起来。效果嘛,就像用碎纸片拼出的作文——能看懂,但别扭。

Azure的Neural TTS(神经语音)则完全不同,它基于深度学习模型:

1. FastSpeech 2架构 这是微软在2020年提出的突破性模型。传统模型生成语音时是"自回归"的(得一个音一个音往后推),FastSpeech 2采用了"并行生成"策略,速度快了几十倍,还能精确控制语速、音调、停顿。

2. HiFiNet2声码器 2022年,Azure将所有神经语音升级到48kHz采样率,使用HiFiNet2声码器。这玩意儿能把模型生成的"声学特征"转换成高保真音频,细节丰富到能听出换气声。

3. DelightfulTTS 2021年推出的这个模型更厉害,能让AI理解"语境"。比如同样是说"好的",在不同场景下语气完全不同:

-

收到礼物时:"好的!"(兴奋上扬)

-

被批评时:"好的..."(低沉委屈)

-

接受任务时:"好的。"(平稳职业)

4. NaturalSpeech 2 2023年的这个模型实现了"人类级别"的语音质量,在盲测中已经分不出是真人还是AI。它使用了扩散模型(Diffusion Model),和生成图片的Stable Diffusion是类似的原理。

2.3 核心技术组件解析

(1)SSML:给机器写"剧本"

SSML(Speech Synthesis Markup Language)就像是TTS的导演脚本。你不仅能告诉它说什么,还能指导它怎么说:

<speak version="1.0" xmlns="http://www.w3.org/2001/10/synthesis" xml:lang="zh-CN"><voice name="zh-CN-XiaoxiaoNeural">我现在<prosody rate="150%" pitch="+10%">超级兴奋!</prosody><break time="500ms"/>因为终于搞懂了这个技术。<emphasis level="strong">真的太酷了!</emphasis></voice>

</speak>

这段代码会让"晓晓"用加快50%的语速和提高音调说"超级兴奋",然后停顿半秒,最后重读"真的太酷了"。这种控制力是传统TTS做梦都想不到的。

(2)Custom Lexicon:教AI读特殊词汇

你公司的产品叫"XYZ-9000",AI可能会读成"埃克斯歪贼九千"。通过自定义词典,你能告诉它正确读音:

<lexicon version="1.0" xmlns="http://www.w3.org/2005/01/pronunciation-lexicon" alphabet="ipa" xml:lang="zh-CN"><lexeme><grapheme>XYZ-9000</grapheme><phoneme>sɛn waɪ zi naɪn θaʊzənd</phoneme></lexeme>

</lexicon>

(3)风格控制:让声音有情绪

Azure支持20+种说话风格(Styles):

-

cheerful:开心雀跃 -

sad:悲伤低落 -

angry:愤怒激动 -

customerservice:客服专业范儿 -

newscast:新闻播报腔 -

chat:随意聊天感

在新闻平台,同一条新闻可以用不同风格合成:

-

体育新闻用

excited(激动) -

讣告用

sad(悲伤) -

财经新闻用

newscast-formal(正式播报)

三、实战应用:看看大厂们怎么玩

3.1 案例1:文档秒变播客(Doc to Podcast)

项目中有个特别有意思的应用——把PDF学术论文转成播客节目。整个流程自动化到令人发指:

工作流程:

# 1. 提取PDF文本

def pdf2text(pdf_file):pdf_reader = PyPDF2.PdfReader(pdf_file)text = ''for page in pdf_reader.pages:text += page.extract_text()return text# 2. 用GPT-4生成播客对话脚本

def CreatePodcastSsml(text):prompt = """创建一个名为'AI unboxed'的播客对话脚本,两位主持人讨论这篇论文。用轻松幽默的语气,加入'哈哈'、'哇'这种口语化表达。输出为SSML格式,使用Andrew和Emma两个语音。"""# 调用GPT-4生成SSML脚本ssml = call_gpt4(text, prompt)return ssml# 3. Azure TTS合成音频

def GenerateAudio(ssml, outaudio):speech_config = speechsdk.SpeechConfig(subscription=speech_key, region=service_region)audio_output = speechsdk.audio.AudioOutputConfig(filename=outaudio)speech_synthesizer = speechsdk.SpeechSynthesizer(speech_config, audio_output)result = speech_synthesizer.speak_ssml_async(ssml).get()

惊艳之处:

-

GPT-4能理解论文核心观点,生成自然对话

-

两个AI主持人一唱一和,还会互相插话

-

使用HD语音(DragonHDLatestNeural),音质接近专业播客

-

最后还会自动生成配图视频

这意味着什么?一个技术博客可以在5分钟内变成一期有声节目,学术论文能在通勤路上"听完"。知识传播的门槛被彻底打破了。

3.2 案例2:定制专属品牌声音(Custom Neural Voice)

记得小鹏汽车的"小P"吗?它的声音就是用Azure定制的。整个流程是这样的:

训练流程:

1. 数据准备(300-2000句录音)├─ 录音要求:安静环境、专业设备├─ 文本覆盖:常用词汇、多样化句式└─ 声明授权:voice talent的书面同意2. 数据上传与标注├─ 使用CustomVoice-API上传音频├─ 系统自动进行音频分析└─ 检查发音准确度(DSAT检测)3. 模型训练(24-48小时)├─ 神经网络学习音色特征├─ 学习韵律和情感表达└─ 生成可控的声音模型4. 测试与部署├─ 在Speech Studio中试听测试├─ 创建专属终端节点(Endpoint)└─ 通过API调用专属声音

关键代码示例:

# 提交训练任务

def submitTraining():data = {'name': 'MyBrandVoice','description': '我们的品牌专属音色','locale': 'zh-CN','models': json.dumps(['voice-model-id']),'properties': json.dumps({'ConcatenateResult': 'true'})}with open('training_script.txt', 'rb') as script_file:files = {'script': script_file}response = requests.post(f"{baseAddress}voicesynthesis",data=data,headers={"Ocp-Apim-Subscription-Key": subscription_key},files=files)if response.status_code == 202:synthesis_id = response.headers['Location'].split("/")[-1]print(f"训练任务已提交,ID: {synthesis_id}")return synthesis_id

真实效果:

-

王源为小米小爱同学定制的声音,粉丝辨识度100%

-

Duolingo用偶像声音教你学外语(想象钢铁侠教你英语的画面)

-

BBC用定制声音打造了自己的AI播音员

3.3 案例3:发音评估引擎(Pronunciation Assessment)

这是个被低估的神器。它不仅能合成语音,还能当你的"口语老师"。

评估维度:

-

准确度(Accuracy):每个音素读得对不对

-

流利度(Fluency):有没有卡顿、重复

-

完整度(Completeness):是否漏读或错读单词

-

韵律(Prosody):语调、节奏、重音是否自然

代码实现:

# 构建评估参数

reference_text = "Good morning."

pron_assessment_params_json = {"GradingSystem": "HundredMark","Dimension": "Comprehensive","ReferenceText": reference_text,"EnableProsodyAssessment": "true","PhonemeAlphabet": "IPA","EnableMiscue": "true"

}# 发送音频进行评估

response = requests.post(url=api_url,data=get_audio_chunks(audio_file),headers={"Ocp-Apim-Subscription-Key": subscription_key,"Pronunciation-Assessment": base64.b64encode(json.dumps(pron_assessment_params_json).encode())}

)# 结果示例

{"NBest": [{"PronunciationAssessment": {"AccuracyScore": 85.7,"FluencyScore": 92.3,"CompletenessScore": 100,"PronScore": 89.5},"Words": [{"Word": "good","PronunciationAssessment": {"AccuracyScore": 95},"Phonemes": [{"Phoneme": "ɡ", "AccuracyScore": 100},{"Phoneme": "ʊ", "AccuracyScore": 90}]}]}]

}

应用场景:

-

在线教育平台(Duolingo、VIPKID)用它自动批改口语作业

-

雅思托福口语练习APP给出实时反馈

-

企业用它培训客服的标准话术

3.4 案例4:TTS Avatar(会说话的数字人)

2024年正式GA的这个功能简直是元宇宙的基础设施。你提供文本,它不仅生成语音,还生成同步的虚拟形象视频。

特色:

-

15+预置数字人形象(商务、休闲、正式等风格)

-

支持透明背景,可叠加到任何场景

-

唇形完美同步,支持多语言

-

手势和表情自动匹配语义

技术原理:

-

TTS引擎生成音频和音素时间戳

-

音素序列驱动口型变化模型

-

情感识别模型调整面部表情

-

姿态生成器添加自然手势

-

渲染引擎输出高清视频

适用场景:

-

新闻播报(BBC已在用)

-

企业培训视频批量生成

-

电商主播(24小时不下播)

-

无障碍信息传播

四、技术细节:那些让人拍案叫绝的设计

4.1 长音频合成的黑科技

合成一本10万字的小说,普通API会超时或爆内存。Azure的Batch Synthesis API专门解决这个问题:

设计巧思:

-

分段异步处理:自动将长文本切分成段落,分布式合成

-

智能缓存:相同文本不重复合成,直接返回缓存

-

断点续合:任务失败可从中断处继续,不用重来

-

自动拼接:合成完成后可选择输出单个文件或分段文件

# 提交长音频任务

def submitLongAudioSynthesis():data = {'name': 'Audiobook_Chapter1','description': '有声书第一章','models': json.dumps(['voice-id']),'locale': 'zh-CN','outputformat': 'audio-24khz-48kbitrate-mono-mp3','properties': json.dumps({'ConcatenateResult': 'true'})}with open('chapter1.txt', 'rb') as script:files = {'script': script}response = requests.post(synthesis_url, data=data, files=files)# 轮询任务状态while True:status = check_synthesis_status(synthesis_id)if status == "Succeeded":download_audio(result_url)breaktime.sleep(10)

4.2 实时对话优化:Spoken Chat模式

当你在做语音助手时,最怕的是延迟。用户说完话等半天才听到回复,体验极差。Azure的解决方案很聪明:

流式合成策略:

# GPT流式输出 + TTS增量合成

for chunk in gpt_stream_completion:chunk_text = chunk['choices'][0]['delta']['content']collected_messages.append(chunk_text)# 遇到句子结束符就立即合成if chunk_text in [".", "!", "?", "。", "!", "?"]:sentence = ''.join(collected_messages).strip()if sentence:# 立即播放,不等整段生成完speech_synthesizer.speak_text_async(sentence).get()collected_messages.clear()

效果对比:

-

传统方式:等GPT全部输出完(5-10秒)→ TTS合成(2-3秒)= 8-13秒延迟

-

流式方式:GPT输出一句 → 立即合成播放 = 首句1-2秒就能听到

这就是为什么ChatGPT语音模式能实现接近真人的对话节奏。

4.3 TTS Player:网页接入零成本方案

想给你的博客加个"朗读"按钮?不用写后端,纯前端就搞定:

// 引入TTS Player库

<script src="tts-player/tts-player.js"></script>// 一行代码启用朗读

ttsPlayer.init({region: 'eastus',voice: 'zh-CN-XiaoxiaoNeural',targetElement: 'article', // 要朗读的区域enableCache: true // 自动缓存,节约成本

});

智能特性:

-

自动提取页面文本,过滤掉代码、链接等

-

首次合成后缓存到浏览器,再次访问秒开

-

可调节语速、音量、选择不同声音

-

无障碍友好,支持键盘操作

WordPress还有现成的插件,安装后所有文章自动带朗读功能。

五、性能与成本:真金白银的考量

5.1 延迟表现

| 场景 | 首字节延迟(P50) | 完整音频延迟 |

|---|---|---|

| 短句合成(<20字) | 80-150ms | 200-300ms |

| 段落合成(100字) | 150-250ms | 1-2秒 |

| 长音频批量合成 | - | 异步处理,分钟级 |

| 实时流式合成 | 100-200ms | 边合成边播放 |

优化建议:

-

使用流式合成减少感知延迟

-

预热常用文本(如欢迎语)

-

选择地理位置最近的区域(Region)

5.2 成本分析

Azure TTS按字符数计费(不是按时长,这点很良心):

| 类型 | 价格(美元/百万字符) | 说明 |

|---|---|---|

| 标准神经语音 | $15 | 400+种声音可选 |

| HD语音 | $100 | 更高保真度 |

| Custom Neural Voice | $40 | 定制音色,训练费另计 |

| Real-time API | $15 | 实时合成 |

| Batch Synthesis | $10 | 批量处理更便宜 |

省钱小技巧:

-

能用批量合成就别用实时API(便宜33%)

-

启用缓存,相同文本不重复计费

-

SSML标签不计费(

<break/>、<emphasis>这些随便用) -

标点符号和空格也算字符,精简文本能省钱

实际案例: 一个日更新10篇文章(每篇3000字)的新闻网站:

-

月合成字符:10 × 3000 × 30 = 90万字符

-

使用标准神经语音:90万 ÷ 100万 ×

13.5/月

-

启用缓存后(假设30%重复):约$9.5/月

比雇一个播音员便宜太多了。

六、深度对比:Azure vs 竞品

6.1 核心指标对比

| 维度 | Azure Speech | AWS Polly | Google Cloud TTS |

|---|---|---|---|

| 神经语音数量 | 400+ | 60+ | 220+ |

| 语言支持 | 140+ | 30+ | 40+ |

| 音质(MOS分数) | 4.5-4.7 | 4.2-4.4 | 4.3-4.6 |

| 定制语音训练 | 支持(300句起) | 支持(需数千句) | 支持(需上万句) |

| SSML丰富度 | ⭐⭐⭐⭐⭐ | ⭐⭐⭐⭐ | ⭐⭐⭐⭐ |

| 实时合成延迟 | 80-150ms | 100-200ms | 120-180ms |

| 价格竞争力 | 中等 | 较低 | 较高 |

6.2 Azure的核心优势

1. 技术领先性

-

首个推出48kHz HD语音的云服务

-

NaturalSpeech 2在盲测中击败Google和AWS

-

发音评估精度业界第一(基于数百万学习者数据训练)

2. 生态完整性

-

与Azure OpenAI无缝集成(GPT+TTS一条龙)

-

丰富的SDK支持(C#、Python、Java、JavaScript、Go)

-

企业级特性(私有端点、VNet支持、合规认证)

3. 中文优化

-

中文神经语音数量最多(40+种方言和风格)

-

中文韵律处理最自然(针对声调和多音字优化)

-

本土化案例最多(小鹏、理想、长城汽车都在用)

4. 创新速度

-

月均发布新特性(查看文章开头的更新日志)

-

研究成果快速产品化(论文发表后半年内上线)

-

活跃的开发者社区和Discord频道

6.3 何时选其他方案?

选AWS Polly:

-

你的整个基础设施在AWS上

-

对成本极度敏感(Polly最便宜)

-

只需要基础功能,不追求音质极致

选Google Cloud TTS:

-

需要WaveNet音质(Google的独家技术)

-

大量使用Google的AI服务(AutoML、Vertex AI)

-

对小语种有特殊需求(如非洲语言)

选本地开源方案(如Coqui TTS):

-

数据隐私要求极高,不能上云

-

有强大的ML团队,能自己维护模型

-

预算充足,能投入GPU资源

七、实战建议:避坑指南与最佳实践

7.1 常见坑点

坑1:音频卡顿和爆音 ❌ 错误做法:把整篇文章一次性扔给API ✅ 正确做法:按句子或段落切分,每段不超过500字

坑2:语音听起来"怪怪的" ❌ 错误做法:直接把Markdown或HTML扔进去 ✅ 正确做法:清理标签、代码块、链接,只保留纯文本

# 文本预处理示例

import re

from bs4 import BeautifulSoupdef clean_text_for_tts(html_content):# 移除HTML标签soup = BeautifulSoup(html_content, 'html.parser')# 移除代码块for code in soup.find_all(['code', 'pre']):code.decompose()# 提取纯文本text = soup.get_text()# 移除多余空白text = re.sub(r'\s+', ' ', text).strip()# 处理特殊字符text = text.replace('&', '和')text = text.replace('$', '美元')return text

坑3:账单突然暴涨 ❌ 错误做法:每次用户刷新页面就重新合成 ✅ 正确做法:实现三级缓存

# 三级缓存策略

def get_audio(text, voice):# 1级:内存缓存(Redis)cache_key = f"tts:{hash(text)}:{voice}"audio = redis.get(cache_key)if audio:return audio# 2级:CDN缓存cdn_url = f"https://cdn.example.com/tts/{cache_key}.mp3"if cdn_exists(cdn_url):return cdn_url# 3级:真正合成audio = azure_tts_synthesize(text, voice)# 回填缓存redis.set(cache_key, audio, ex=86400) # 24小时过期upload_to_cdn(audio, cdn_url)return audio

7.2 进阶优化技巧

技巧1:用SSML提升自然度

<!-- 基础版(机械感强) -->

<speak version="1.0" xml:lang="zh-CN"><voice name="zh-CN-XiaoxiaoNeural">今天天气很好,我们去公园吧。</voice>

</speak><!-- 优化版(更自然) -->

<speak version="1.0" xml:lang="zh-CN"><voice name="zh-CN-XiaoxiaoNeural"><mstts:express-as style="cheerful">今天天气<prosody pitch="+5%">很好</prosody>哎,<break time="300ms"/>我们去公园吧!</mstts:express-as></voice>

</speak>

技巧2:多语音混合使用

<!-- 对话场景:男女两个角色 -->

<speak version="1.0" xml:lang="zh-CN"><voice name="zh-CN-YunxiNeural">你好,我是客服小李,有什么可以帮你?</voice><break time="500ms"/><voice name="zh-CN-XiaoxiaoNeural">我想咨询一下产品的使用方法。</voice>

</speak>

技巧3:自动调整语速

# 根据文本长度智能调整语速

def calculate_optimal_rate(text_length):if text_length < 50:return "100%" # 短句正常速度elif text_length < 200:return "105%" # 中等稍快else:return "110%" # 长文更快,避免听疲劳def generate_ssml_with_dynamic_rate(text, voice):rate = calculate_optimal_rate(len(text))ssml = f"""<speak version="1.0" xml:lang="zh-CN"><voice name="{voice}"><prosody rate="{rate}">{text}</prosody></voice></speak>"""return ssml

7.3 安全与合规

责任AI使用准则:

-

获得授权:定制语音必须获得声音所有者的书面同意

-

透明披露:在使用合成语音的地方明确标注"AI生成"

-

防止滥用:不得用于深度伪造、诈骗、误导性政治宣传

-

版权意识:合成名人声音需获得肖像权授权

代码中嵌入水印: Azure提供了语音水印技术(2022年推出),可在合成音频中嵌入不可听见的数字指纹,用于溯源和防伪。

八、未来趋势:下一个十年的语音技术

8.1 技术演进方向

1. Zero-Shot TTS(零样本语音克隆) 2024年推出的Personal Voice功能,只需要1分钟录音样本,就能克隆你的声音。这背后是VALLE模型的威力——它把语音当成"语言"来理解,实现了真正的"少样本学习"。

未来3-5年,可能只需要3秒钟的音频,甚至一张照片,AI就能推测出你的声音特征。

2. 情感智能(Emotion AI) 现在的TTS能表达预设的几种情绪(开心、悲伤等),但未来会更智能:

-

自动检测文本情感倾向

-

根据上下文动态调整语气

-

甚至能模拟"犹豫"、"思考"这种细微状态

3. 跨语言声音迁移 想象一下:你用中文录音,AI能用你的声音说流利的英语、日语、法语,而且保留你的音色和说话习惯。微软已经发布了相关研究论文《Speak Foreign Languages with Your Own Voice》,产品化可能就在未来2年内。

4. 神经语音编辑 就像Photoshop编辑图片一样,未来能可视化编辑语音:

-

拖动曲线调整语调

-

选中某个词改变重音

-

在波形图上直接插入停顿

8.2 应用场景展望

教育领域:

-

个性化有声教材(根据学生水平调整语速和用词)

-

AI口语陪练(实时纠正发音,比真人老师更有耐心)

-

历史人物"复活"(用林肯的声音讲解葛底斯堡演说)

医疗领域:

-

失语症患者的声音重建

-

手术导航的实时语音提示

-

心理治疗的AI对话伙伴

娱乐产业:

-

游戏NPC的动态对话生成(告别固定台词)

-

电影配音自动化(演员只需录一种语言)

-

虚拟偶像的个性化互动

企业服务:

-

客服机器人完全拟人化(听不出是AI)

-

会议纪要自动转语音摘要

-

品牌声音IP化(可口可乐的"专属声音")

8.3 伦理挑战

技术进步的同时,我们必须面对的问题:

1. 深度伪造危机 2024年已经出现用AI语音诈骗的案例(克隆老板声音骗会计转账)。解决方案包括:

-

强制水印标记

-

生物特征二次验证

-

区块链溯源

2. 声音版权归属 你的声音被克隆了,版权归谁?现行法律还没跟上。可能需要建立"声音银行"制度,类似照片的Getty Images。

3. 就业冲突 播音员、配音演员、客服人员...很多岗位会被AI替代吗?历史告诉我们:技术会消灭旧岗位,但也会创造新岗位(比如"AI语音导演"、"情感标注师")。

九、动手实践:30分钟搭建你的语音应用

9.1 快速开始:第一个TTS程序

环境准备:

# 安装Azure Speech SDK

pip install azure-cognitiveservices-speech# 设置API密钥(去Azure Portal创建Speech资源)

export SPEECH_KEY="your_subscription_key"

export SPEECH_REGION="eastus"

5行代码实现语音合成:

import azure.cognitiveservices.speech as speechsdk# 配置

speech_config = speechsdk.SpeechConfig(subscription=os.environ.get('SPEECH_KEY'),region=os.environ.get('SPEECH_REGION')

)

speech_config.speech_synthesis_voice_name = "zh-CN-XiaoxiaoNeural"# 合成

synthesizer = speechsdk.SpeechSynthesizer(speech_config=speech_config)

result = synthesizer.speak_text_async("你好,世界!").get()if result.reason == speechsdk.ResultReason.SynthesizingAudioCompleted:print("成功!")

9.2 进阶项目:个人博客朗读器

需求:给你的WordPress/Hexo博客加上"听文章"功能

实现方案(前后端分离):

后端(Flask):

from flask import Flask, request, send_file

import azure.cognitiveservices.speech as speechsdk

import hashlib

import osapp = Flask(__name__)@app.route('/tts', methods=['POST'])

def text_to_speech():text = request.json['text']voice = request.json.get('voice', 'zh-CN-XiaoxiaoNeural')# 使用文本哈希作为缓存键cache_key = hashlib.md5(f"{text}{voice}".encode()).hexdigest()cache_file = f"cache/{cache_key}.mp3"# 检查缓存if os.path.exists(cache_file):return send_file(cache_file, mimetype='audio/mpeg')# 合成音频speech_config = speechsdk.SpeechConfig(subscription=os.environ['SPEECH_KEY'],region=os.environ['SPEECH_REGION'])speech_config.set_speech_synthesis_output_format(speechsdk.SpeechSynthesisOutputFormat.Audio24Khz48KBitRateMonoMp3)audio_config = speechsdk.audio.AudioOutputConfig(filename=cache_file)synthesizer = speechsdk.SpeechSynthesizer(speech_config=speech_config,audio_config=audio_config)# 使用SSML优化ssml = f"""<speak version="1.0" xmlns="http://www.w3.org/2001/10/synthesis" xml:lang="zh-CN"><voice name="{voice}"><prosody rate="105%">{text}</prosody></voice></speak>"""result = synthesizer.speak_ssml_async(ssml).get()if result.reason == speechsdk.ResultReason.SynthesizingAudioCompleted:return send_file(cache_file, mimetype='audio/mpeg')else:return {"error": "合成失败"}, 500if __name__ == '__main__':os.makedirs('cache', exist_ok=True)app.run(debug=True)

前端(JavaScript):

<!DOCTYPE html>

<html>

<head><title>文章朗读器</title>

</head>

<body><article id="article"><h1>我的博客文章</h1><p>这是文章内容...</p></article><button id="playBtn">🔊 听这篇文章</button><audio id="audioPlayer" controls style="display:none;"></audio><script>document.getElementById('playBtn').addEventListener('click', async () => {const articleText = document.getElementById('article').innerText;const btn = document.getElementById('playBtn');btn.disabled = true;btn.innerText = '⏳ 生成中...';try {const response = await fetch('http://localhost:5000/tts', {method: 'POST',headers: {'Content-Type': 'application/json'},body: JSON.stringify({text: articleText,voice: 'zh-CN-XiaoxiaoNeural'})});const audioBlob = await response.blob();const audioUrl = URL.createObjectURL(audioBlob);const player = document.getElementById('audioPlayer');player.src = audioUrl;player.style.display = 'block';player.play();btn.innerText = '🔊 重新播放';btn.disabled = false;} catch (error) {console.error('错误:', error);btn.innerText = '❌ 生成失败';btn.disabled = false;}});</script>

</body>

</html>

优化建议:

-

把缓存文件上传到CDN(Azure Blob Storage)

-

使用WebSocket实现流式播放(边合成边播)

-

添加进度条和播放速度调节

-

支持多语言自动检测

9.3 终极项目:自己的播客生成器

基于项目中的doctopodcast.py,你可以:

-

上传一篇技术文章

-

GPT-4自动改写成对话脚本

-

两个AI主持人对话合成

-

生成配套的视频封面

-

一键发布到播客平台

商业化思路:

-

学术论文解读播客(Arxiv Podcast)

-

技术博客音频化服务(按篇收费)

-

企业内部培训材料语音化(SaaS订阅)

十、写在最后:语音技术的诗与远方

记得小时候看《星际迷航》,舰长对着电脑说话,电脑就能回应。当时觉得那是遥不可及的未来。

现在,这个未来已经到来。Azure Speech Service这样的技术,让"人机对话"从科幻变成了日常。

但技术本身是中性的。它可以用来帮助视障人士"看见"世界,也可能被用来制造骗局。它能让知识传播更高效,也可能让人们过度依赖AI而失去表达能力。

作为开发者,我们的责任不只是学会调用API,更要思考:

-

我们创造的语音体验是否足够透明?

-

我们是否在技术与伦理之间找到平衡?

-

我们能否让技术真正服务于人,而不是操控人?

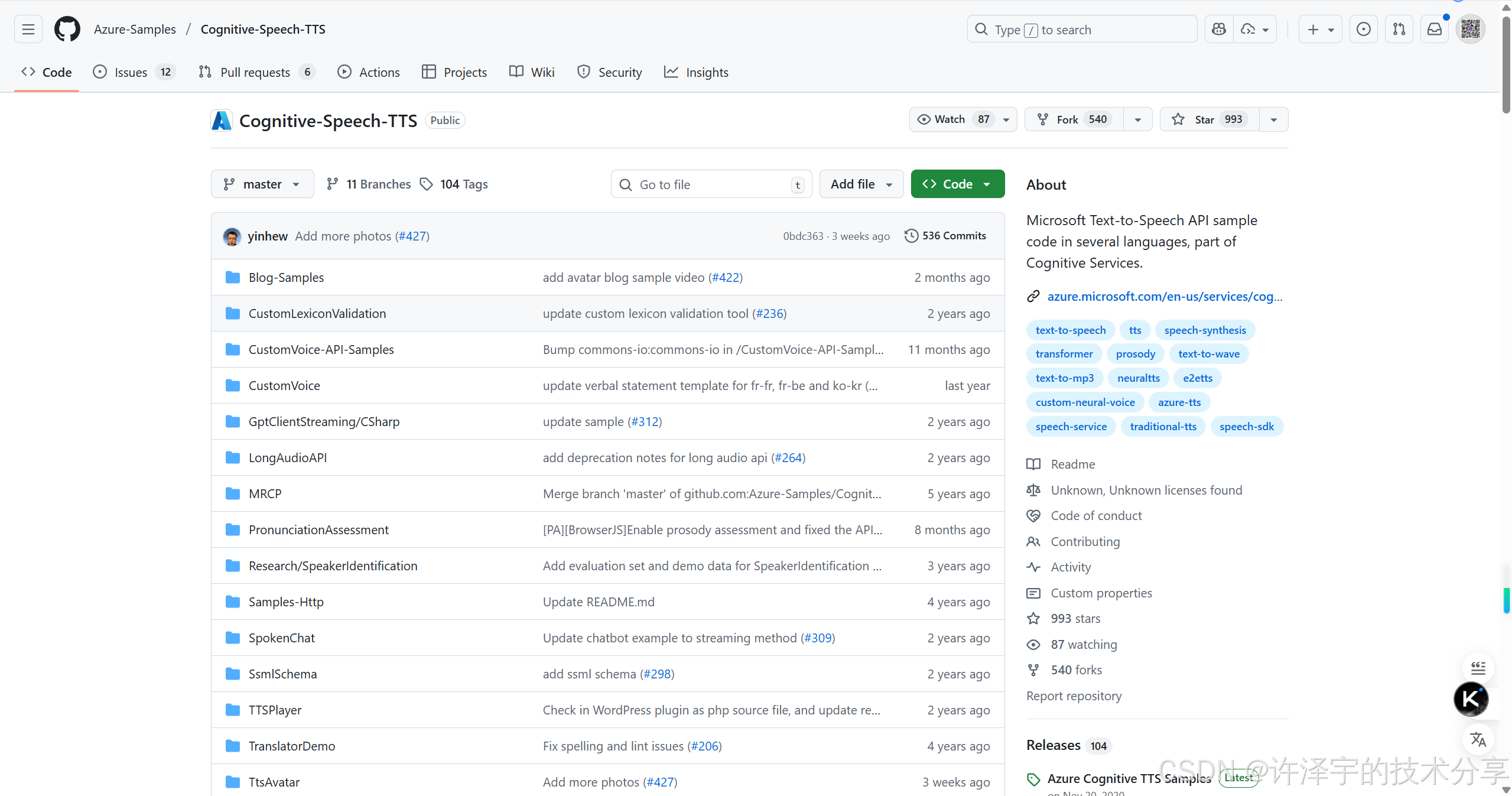

这个项目(Cognitive-Speech-TTS)开源了大量的代码示例,不仅是在教你怎么用技术,更是在邀请你参与到"负责任的AI"建设中来。

最后的彩蛋: 微软在2023年推出了"Project Gutenberg Open Audiobook",用Azure TTS将5000多本公版书免费转成有声书。这些书包括《傲慢与偏见》《双城记》等经典名著,任何人都能免费下载。

这件事被《时代》周刊评为"2023年最佳发明之一"。不是因为技术有多酷炫,而是因为它让知识触手可及。

这,才是技术最美的模样。

参考资源

官方文档:

-

Azure Speech Service 文档

-

SSML参考手册

-

Speech SDK GitHub

项目地址:

-

Cognitive-Speech-TTS Sample

相关论文:

-

NaturalSpeech 2: Latent Diffusion Models are Natural and Zero-Shot Speech and Singing Synthesizers

-

FastSpeech 2: Fast and High-Quality End-to-End Text to Speech

-

VALLE: Neural Codec Language Models are Zero-Shot Text to Speech Synthesizers

社区:

-

Azure TTS Discord 频道

-

Stack Overflow 标签: microsoft-cognitive

更多AIGC文章

RAG技术全解:从原理到实战的简明指南

更多VibeCoding文章

更多Agent文章