H-RDT:基于人类操作增强的双臂机器人操作研究

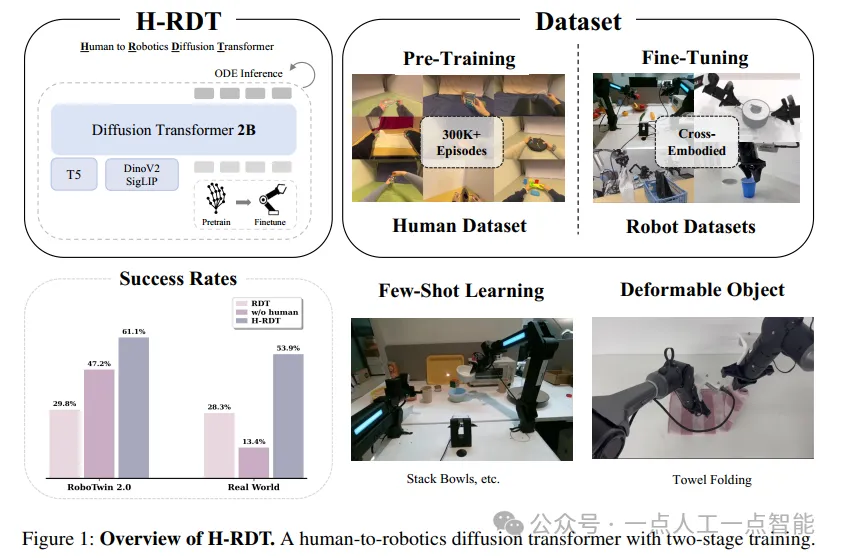

导读:H-RDT(Human to Robotics Diffusion Transformer)是一项旨在利用大规模人类操作数据提升机器人操作能力的研究工作。该研究由清华大学与地平线机器人合作完成,主要针对机器人模仿学习中高质量演示数据稀缺的问题,提出了一种基于人类第一视角视频与3D手部姿态数据的预训练与跨具身微调方法。论文地址:https://arxiv.org/pdf/2507.23523项目地址:https://embodiedfoundation.github.io/hrdt摘要部分首先指出了当前机器人模仿学习面临的核心问题:大规模、高质量的机器人演示数据稀缺。尽管现有的机器人基础模型尝试通过跨具身数据预训练来扩大数据规模,但由于不同机器人形态与动作空间的差异,统一训练仍具有挑战性。H-RDT 提出了一种新的解决方案,即利用带有3D手部姿态标注的大规模人类第一视角操作视频,从中提取丰富的操作先验知识,并将其迁移至机器人策略学习中。该方法采用两阶段训练范式:首先在大规模人类数据上进行预训练,然后通过模块化的动作编码器与解码器进行跨具身微调。模型基于具有20亿参数的扩散Transformer架构,使用流匹配(flow matching)技术建模复杂的动作分布。实验部分涵盖了仿真与真实环境、单任务与多任务、少样本学习与鲁棒性评估等多个维度。结果表明,H-RDT 在仿真和真实环境中分别比从头训练的方法提升了13.9%和40.5%的成功率,显著优于现有最优方法如π₀和RDT。引言引言部分进一步阐述了机器人学习领域的近期进展,包括专门的动作策略模型(如ACT、Diffusion Policy、3D Diffusion Policy)和视觉-语言-动作(VLA)模型(如RT-2、OpenVLA、RDT、π₀、π₀.5等)。这些方法虽然表现出色,但仍受限于数据收集的高成本和不一致性。当前主流的跨具身预训练方法(如Open X-Embodiment)面临数据规模有限和异构质量问题。与之相比,人类操作行为提供了大量易于获取的演示数据。近年来出现的以EgoDex为代表的大规模第一视角视频数据集,提供了829小时带有手部姿态标注的操作视频,为学习丰富的操作先验提供了可能。人类演示天然地捕捉了物体的可操作性、操作策略和任务分解模式,这些可作为机器人学习的有力归纳偏置。已有研究如EgoMimic和HAT尝试将人类数据用于机器人策略学习,但规模有限且局限于特定机器人形态。H-RDT 在此基础上提出系统性地利用人类操作数据,重点解决数据稀缺、跨具身迁移和训练效率三大问题。

其核心贡献包括:提出一个基于人类数据的预训练框架、设计支持跨具身迁移的模块化Transformer架构、并通过大量实验验证其在多种场景下的有效性。相关工作2.1 基于学习的机器人操作近年来,模仿学习在机器人操作中取得了显著进展。ACT、Diffusion Policy 和 3D Diffusion Policy 等方法通过序列建模和生成式方法学习视觉-动作映射,在灵巧操作任务中表现出色。另一方面,VLA模型如RT-2、OpenVLA、RDT、π₀、π0.5等将视觉理解、语言理解和动作生成统一在一个架构中,实现了指令跟随和跨具身泛化能力。这些模型通常在大规模跨具身数据集上进行预训练,但数据规模和质量的限制仍是一个瓶颈。H-RDT 在RDT架构基础上引入了流匹配训练机制和人类到机器人的知识迁移模块,显著提升了训练稳定性和跨具身适应能力。2.2 基于第一视角人类操作的学习大规模第一视角数据集(如Ego4D、EPIC-Kitchens)虽包含大量人-物交互视频,但缺乏精确的3D手部姿态标注。EgoDex填补了这一空白,提供了829小时的高质量标注数据。EgoMimic和HAT尝试利用人类视频进行策略学习,但数据规模较小(2k和27k条轨迹),且局限于类人形态机器人。H-RDT 则通过解耦预训练与微调过程,并引入模块化动作适配器,实现了向任意机器人形态的泛化。方法3.1 问题形式化机器人操作被形式化为一个条件序列生成问题。策略πθ需基于多模态观测(包括视觉观测、本体状态和语言指令)生成未来动作序列。由于特定机器人的演示数据稀缺,现有方法多采用跨具身数据联合训练,但数据总量仍受限。H-RDT 提出利用人类操作数据作为统一形态的先验来源,从而降低数据收集成本并提升泛化能力。然而,人类与机器人在形态和运动学上的差异、现有方法的规模限制以及跨机器人适配能力不足,仍是亟待解决的问题。

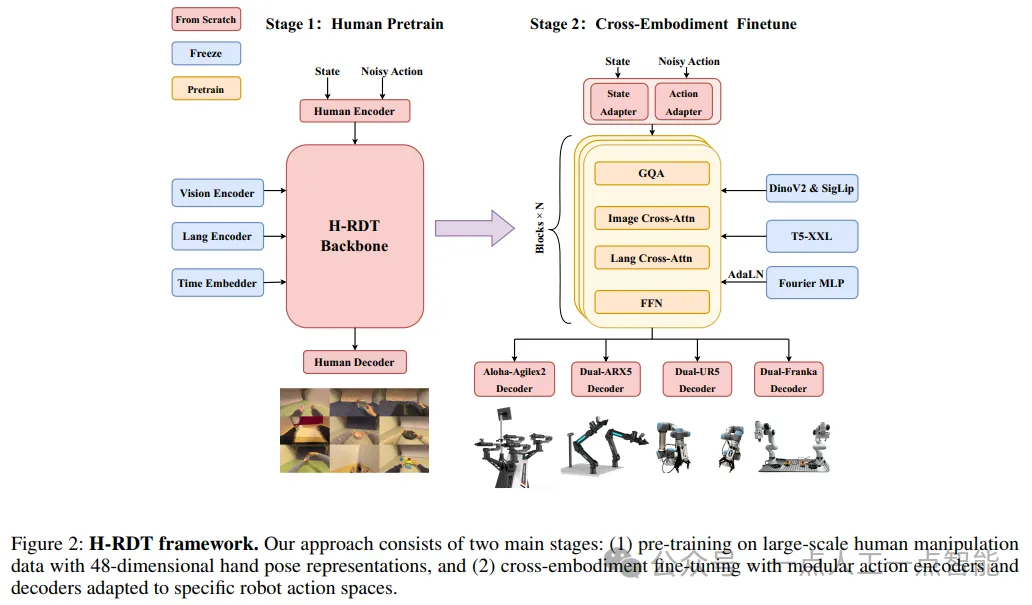

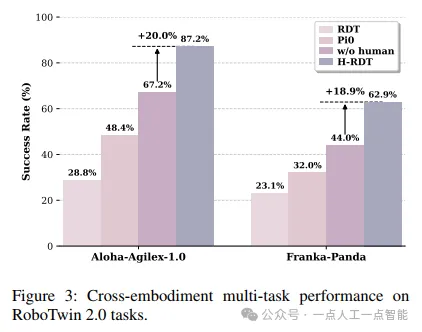

3.2 整体框架H-RDT 是一个基于Transformer的架构,采用两阶段训练范式。首先在人类数据上进行预训练,学习通用的操作表示;然后通过模块化设计适配具体机器人的动作空间。该框架使用流匹配进行动作生成,提升了训练稳定性和推理效率。3.3 人类动作表示设计为弥合人类与机器人的形态差异,现有方法或使用光流作为中间表示(缺乏显式动作参数),或需复杂重定向(限制泛化能力)。H-RDT 采用48维向量表示双手操作信息,包括双侧手腕位姿(位置+朝向,共18维)和指尖位置(30维)。该表示覆盖了大多数机器人末端执行器的动作空间,从而支持跨形态的知识迁移。3.4 两阶段训练范式第一阶段使用EgoDex数据集进行预训练,共338k条轨迹,覆盖194种操作任务。动作表示为48维手部姿态。第二阶段进行跨具身微调:视觉编码器、语言编码器和Transformer主干权重保持不变,而状态适配器、动作适配器和动作解码器则重新初始化,以适应目标机器人的动作空间(如14维的双7自由度机械臂)。这种选择性迁移策略在保持语义知识的同时,实现了对不同机器人形态的高效适配。H-RDT 架构4.1 流匹配动作生成H-RDT 采用流匹配替代传统扩散模型,其目标是学习一个向量场,将高斯噪声分布转换为目标动作分布。给定目标动作序列,构建直线流路径:其中z为高斯噪声,τ∈[0,1]为流时间。神经网络vθ学习预测该向量场,损失函数为:其中c为条件信息(观测、状态、指令)。推理时通过ODE求解器积分学习到的向量场,以确定性方式生成动作。4.2 网络架构H-RDT 包含五个模块化组件:· 视觉与语言编码器:使用预训练的DinoV2和SigLIP提取图像特征,T5-XXL处理文本指令,并通过MLP适配器投影至统一嵌入空间。· 模块化动作编码器:通过MLP分别编码本体状态和带噪声的动作序列。· Transformer主干:采用LLaMA-3风格的架构,使用RMSNorm和SwiGLU激活函数。图像和语言特征通过交叉注意力注入,避免模态不平衡。· 模块化动作解码器:将隐藏状态解码为目标机器人的动作空间输出。实验5.1 实验设置实验在仿真与真实环境中进行,评估维度包括单任务与多任务性能、跨具身泛化、环境鲁棒性和少样本学习能力。仿真使用RoboTwin 2.0平台,提供简单和困难两种模式(后者包含域随机化)。真实实验覆盖多种机器人平台,包括Aloha-Agilex、Franka-Panda、ARX5和UR5+UMI。5.2 基线方法比较方法包括RDT、π₀以及无人类预训练的H-RDT变体(w/o human)。5.3 真实世界验证在Aloha-Agilex-2.0平台上,H-RDT在毛巾折叠和杯子放置任务中分别达到52%和64%的成功率,显著优于基线。在ARX5平台上的少样本实验中,H-RDT在113项任务上平均成功率达41.6%,优于RDT(16.0%)和π₀(31.2%)。在UR5+UMI系统中,H-RDT在双手取放任务中各子任务均表现最佳,平均成功率达58.0%。5.3 仿真结果在RoboTwin 2.0的单任务评估中,H-RDT在简单和困难模式下分别达到68.7%和25.6%的平均成功率。多任务实验中,H-RDT在45项任务上达到87.2%的成功率,显著优于其他方法。跨具身实验表明,H-RDT在Aloha-Agilex-1.0和Franka-Panda上均保持优异性能,验证了其泛化能力。

5.4 分析与讨论人类预训练带来的提升在所有实验设置中一致显著,尤其在少样本场景下效果最为突出。H-RDT在域随机化环境下仍保持稳健,展示了良好的环境适应性。其模块化架构支持跨平台部署,在多种机器人形态上均表现一致。结论H-RDT 通过利用大规模人类操作数据,显著提升了机器人操作策略的泛化能力和样本效率。其核心创新包括模块化Transformer架构、流匹配训练机制和两阶段训练范式。大量实验验证了该方法在仿真和真实环境中的有效性,证明了人类行为先验在机器人学习中的重要作用。