基于yolov8的土豆马铃薯叶子病害检测系统python源码+pytorch模型+评估指标曲线+精美GUI界面

【算法介绍】

基于YOLOv8的土豆马铃薯叶子病害检测系统是一种创新的农业智能解决方案,旨在通过深度学习技术实现对马铃薯叶片病害的精准识别与早期预警。该系统利用YOLOv8(You Only Look Once,版本8)模型,这是一种广泛应用于物体检测中的卷积神经网络模型,以其实时性和高效性著称,非常适合于农作物病害检测任务。

该系统能够识别的病害主要包括早疫病(Early Blight)、健康叶片(Healthy)以及晚疫病(Late Blight)。这些病害对马铃薯的产量和质量有着直接影响,因此早期准确识别对于病害防控至关重要。

为了实现这一目标,系统首先收集并处理了大量马铃薯叶片病害的数据集,这些数据集经过精心标注,以确保模型训练的准确性和有效性。随后,基于这些数据集,使用YOLOv8模型进行病害识别模型的训练。训练完成后,系统通过用户友好的界面,允许农民或农业工作者上传叶片图像,并快速获得病害识别结果。

此外,该系统还具备高度的可扩展性和灵活性,可以根据实际需求进一步优化和扩展病害识别种类。同时,其用户界面设计简洁直观,使得非专业人士也能轻松上手使用。

综上所述,基于YOLOv8的土豆马铃薯叶子病害检测系统为农业生产提供了一种高效、准确的病害检测手段,有助于农民及时采取措施防控病害,保障马铃薯的健康生长和高产高质。这一系统的应用将极大地推动农业智能化进程,提升农业生产效率和管理水平。

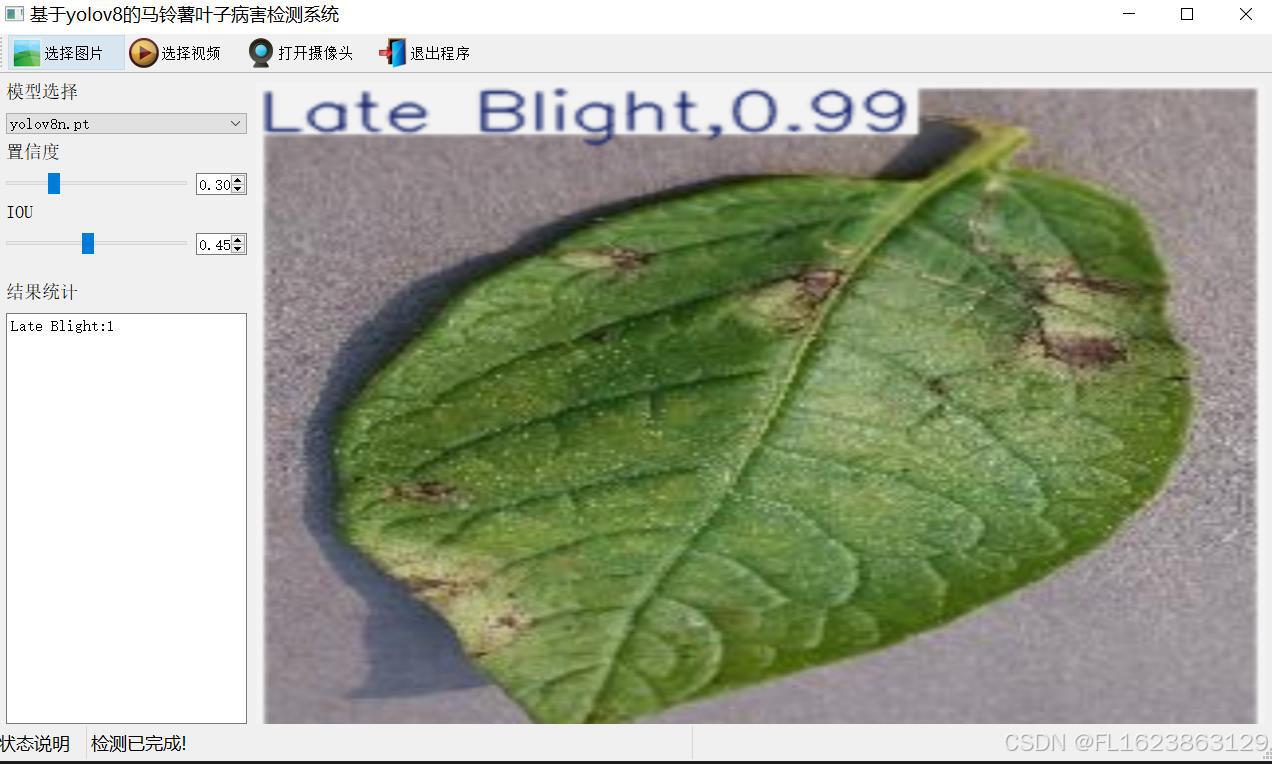

【效果展示】

【测试环境】

windows10

anaconda3+python3.8

torch==2.3.0

ultralytics==8.3.81

【训练数据集信息】

注意本次训练数据集都是使用单叶片进行训练,数据集图片预览如下:

【模型可以检测出3类别】

早疫病(Early Blight)、健康叶片(Healthy)以及晚疫病(Late Blight)

【训练信息】

| 参数 | 值 |

| 训练集图片数 | 1273 |

| 验证集图片数 | 363 |

| 训练map | 97.1% |

| 训练精度(Precision) | 100% |

| 训练召回率(Recall) | 99.5% |

验证集测试精度信息

| Class | Images | Instances | P | R | mAP50 | mAP50-95 |

| all | 363 | 363 | 0.998 | 1 | 0.995 | 0.971 |

| Early Blight | 160 | 160 | 0.997 | 1 | 0.995 | 0.988 |

| Healthy | 101 | 101 | 1 | 0.999 | 0.995 | 0.952 |

| Late Blight | 102 | 102 | 0.997 | 1 | 0.995 | 0.972 |

【部分实现源码】

class Ui_MainWindow(QtWidgets.QMainWindow):

signal = QtCore.pyqtSignal(str, str)

def setupUi(self):

self.setObjectName("MainWindow")

self.resize(1280, 728)

self.centralwidget = QtWidgets.QWidget(self)

self.centralwidget.setObjectName("centralwidget")

self.weights_dir = './weights'

self.picture = QtWidgets.QLabel(self.centralwidget)

self.picture.setGeometry(QtCore.QRect(260, 10, 1010, 630))

self.picture.setStyleSheet("background:black")

self.picture.setObjectName("picture")

self.picture.setScaledContents(True)

self.label_2 = QtWidgets.QLabel(self.centralwidget)

self.label_2.setGeometry(QtCore.QRect(10, 10, 81, 21))

self.label_2.setObjectName("label_2")

self.cb_weights = QtWidgets.QComboBox(self.centralwidget)

self.cb_weights.setGeometry(QtCore.QRect(10, 40, 241, 21))

self.cb_weights.setObjectName("cb_weights")

self.cb_weights.currentIndexChanged.connect(self.cb_weights_changed)

self.label_3 = QtWidgets.QLabel(self.centralwidget)

self.label_3.setGeometry(QtCore.QRect(10, 70, 72, 21))

self.label_3.setObjectName("label_3")

self.hs_conf = QtWidgets.QSlider(self.centralwidget)

self.hs_conf.setGeometry(QtCore.QRect(10, 100, 181, 22))

self.hs_conf.setProperty("value", 25)

self.hs_conf.setOrientation(QtCore.Qt.Horizontal)

self.hs_conf.setObjectName("hs_conf")

self.hs_conf.valueChanged.connect(self.conf_change)

self.dsb_conf = QtWidgets.QDoubleSpinBox(self.centralwidget)

self.dsb_conf.setGeometry(QtCore.QRect(200, 100, 51, 22))

self.dsb_conf.setMaximum(1.0)

self.dsb_conf.setSingleStep(0.01)

self.dsb_conf.setProperty("value", 0.25)

self.dsb_conf.setObjectName("dsb_conf")

self.dsb_conf.valueChanged.connect(self.dsb_conf_change)

self.dsb_iou = QtWidgets.QDoubleSpinBox(self.centralwidget)

self.dsb_iou.setGeometry(QtCore.QRect(200, 160, 51, 22))

self.dsb_iou.setMaximum(1.0)

self.dsb_iou.setSingleStep(0.01)

self.dsb_iou.setProperty("value", 0.45)

self.dsb_iou.setObjectName("dsb_iou")

self.dsb_iou.valueChanged.connect(self.dsb_iou_change)

self.hs_iou = QtWidgets.QSlider(self.centralwidget)

self.hs_iou.setGeometry(QtCore.QRect(10, 160, 181, 22))

self.hs_iou.setProperty("value", 45)

self.hs_iou.setOrientation(QtCore.Qt.Horizontal)

self.hs_iou.setObjectName("hs_iou")

self.hs_iou.valueChanged.connect(self.iou_change)

self.label_4 = QtWidgets.QLabel(self.centralwidget)

self.label_4.setGeometry(QtCore.QRect(10, 130, 72, 21))

self.label_4.setObjectName("label_4")

self.label_5 = QtWidgets.QLabel(self.centralwidget)

self.label_5.setGeometry(QtCore.QRect(10, 210, 72, 21))

self.label_5.setObjectName("label_5")

self.le_res = QtWidgets.QTextEdit(self.centralwidget)

self.le_res.setGeometry(QtCore.QRect(10, 240, 241, 400))

self.le_res.setObjectName("le_res")

self.setCentralWidget(self.centralwidget)

self.menubar = QtWidgets.QMenuBar(self)

self.menubar.setGeometry(QtCore.QRect(0, 0, 1110, 30))

self.menubar.setObjectName("menubar")

self.setMenuBar(self.menubar)

self.statusbar = QtWidgets.QStatusBar(self)

self.statusbar.setObjectName("statusbar")

self.setStatusBar(self.statusbar)

self.toolBar = QtWidgets.QToolBar(self)

self.toolBar.setToolButtonStyle(QtCore.Qt.ToolButtonTextBesideIcon)

self.toolBar.setObjectName("toolBar")

self.addToolBar(QtCore.Qt.TopToolBarArea, self.toolBar)

self.actionopenpic = QtWidgets.QAction(self)

icon = QtGui.QIcon()

icon.addPixmap(QtGui.QPixmap(":/images/1.png"), QtGui.QIcon.Normal, QtGui.QIcon.Off)

self.actionopenpic.setIcon(icon)

self.actionopenpic.setObjectName("actionopenpic")

self.actionopenpic.triggered.connect(self.open_image)

self.action = QtWidgets.QAction(self)

icon1 = QtGui.QIcon()

icon1.addPixmap(QtGui.QPixmap(":/images/2.png"), QtGui.QIcon.Normal, QtGui.QIcon.Off)

self.action.setIcon(icon1)

self.action.setObjectName("action")

self.action.triggered.connect(self.open_video)

self.action_2 = QtWidgets.QAction(self)

icon2 = QtGui.QIcon()

icon2.addPixmap(QtGui.QPixmap(":/images/3.png"), QtGui.QIcon.Normal, QtGui.QIcon.Off)

self.action_2.setIcon(icon2)

self.action_2.setObjectName("action_2")

self.action_2.triggered.connect(self.open_camera)

self.actionexit = QtWidgets.QAction(self)

icon3 = QtGui.QIcon()

icon3.addPixmap(QtGui.QPixmap(":/images/4.png"), QtGui.QIcon.Normal, QtGui.QIcon.Off)

self.actionexit.setIcon(icon3)

self.actionexit.setObjectName("actionexit")

self.actionexit.triggered.connect(self.exit)

self.toolBar.addAction(self.actionopenpic)

self.toolBar.addAction(self.action)

self.toolBar.addAction(self.action_2)

self.toolBar.addAction(self.actionexit)

self.retranslateUi()

QtCore.QMetaObject.connectSlotsByName(self)

self.init_all()【使用步骤】

使用步骤:

(1)首先根据官方框架安装好yolov8环境,并安装好pyqt5

(2)切换到自己安装的yolov8环境后,并切换到源码目录,执行python main.py即可运行启动界面,进行相应的操作即可

【提供文件】

python源码

yolov8n.pt模型

训练的map,P,R曲线图(在weights\results.png)

测试图片(在test_img文件夹下面)

注意不提供数据集

【常用评估参数介绍】

在目标检测任务中,评估模型的性能是至关重要的。你提到的几个术语是评估模型性能的常用指标。下面是对这些术语的详细解释:

- Class:

- 这通常指的是模型被设计用来检测的目标类别。例如,一个模型可能被训练来检测车辆、行人或动物等不同类别的对象。

- Images:

- 表示验证集中的图片数量。验证集是用来评估模型性能的数据集,与训练集分开,以确保评估结果的公正性。

- Instances:

- 在所有图片中目标对象的总数。这包括了所有类别对象的总和,例如,如果验证集包含100张图片,每张图片平均有5个目标对象,则Instances为500。

- P(精确度Precision):

- 精确度是模型预测为正样本的实例中,真正为正样本的比例。计算公式为:Precision = TP / (TP + FP),其中TP表示真正例(True Positives),FP表示假正例(False Positives)。

- R(召回率Recall):

- 召回率是所有真正的正样本中被模型正确预测为正样本的比例。计算公式为:Recall = TP / (TP + FN),其中FN表示假负例(False Negatives)。

- mAP50:

- 表示在IoU(交并比)阈值为0.5时的平均精度(mean Average Precision)。IoU是衡量预测框和真实框重叠程度的指标。mAP是一个综合指标,考虑了精确度和召回率,用于评估模型在不同召回率水平上的性能。在IoU=0.5时,如果预测框与真实框的重叠程度达到或超过50%,则认为该预测是正确的。

- mAP50-95:

- 表示在IoU从0.5到0.95(间隔0.05)的范围内,模型的平均精度。这是一个更严格的评估标准,要求预测框与真实框的重叠程度更高。在目标检测任务中,更高的IoU阈值意味着模型需要更准确地定位目标对象。mAP50-95的计算考虑了从宽松到严格的多个IoU阈值,因此能够更全面地评估模型的性能。

这些指标共同构成了评估目标检测模型性能的重要框架。通过比较不同模型在这些指标上的表现,可以判断哪个模型在实际应用中可能更有效。

【常见问题】

目标检测训练中,Mean Average Precision(MAP)偏低可能有以下原因:

原因一:欠拟合:如果训练数据量过小,模型可能无法学习到足够的特征,从而影响预测效果,导致欠拟合,进而使MAP偏低。因此可以加大数据集数量

原因二:小目标:如果数据集包含大部分小目标则一般会有可能产生map偏低情况,因为小目标特征不明显,模型很难学到特征。

原因三:模型调参不对:比如学习率调整过大可能会导致学习能力过快,模型参数调节出现紊乱

原因四:过拟合(现在模型基本不存在这种情况):如果模型在训练数据上表现非常好,但在验证或测试数据上表现较差,可能是出现了过拟合。这通常是因为模型参数过多,而训练数据量相对较小,导致模型学习到了训练数据中的噪声或特定模式,而无法泛化到新的数据。如今现在目标检测模型都对这个情况做的很好,很少有这种情况发生。

原因五:场景不一样:验证集验证精度高,测试集不行,则有可能是与训练模型场景图片不一致导致测试map过低

针对以上原因,可以采取以下措施来提高MAP:

(1)优化模型结构:根据任务和数据集的特点选择合适的模型,并尝试使用不同的网络架构和构件来改进模型性能。

(2)增强数据预处理:对数据进行适当的预处理和增强,如数据归一化、缺失值填充、数据扩增等,以提高模型的泛化能力。

(3)调整损失函数:尝试使用不同的损失函数或组合多种损失函数来优化模型性能。

(4)优化训练策略:调整学习率、批次大小、训练轮数等超参数,以及使用学习率衰减、动量等优化算法来改善模型训练效果。

(5)使用预训练模型:利用在大规模数据集上预训练的模型进行迁移学习,可以加速模型收敛并提高性能。

(6)增加数据集数量,尽可能提供多场景图片,提高模型泛化能力,增强模型特征学习能力。

综上所述,提高目标检测训练的MAP需要从多个方面入手,包括优化模型结构、增强数据预处理、调整损失函数、优化训练策略以及使用预训练模型等。