VGG论文精细解读

VGG论文精细解读(《VERY DEEP CONVOLUTIONAL NETWORKS FOR LARGE-SCALE IMAGE RECOGNITION》)

这篇论文是2015年ICLR的会议论文,由牛津大学VGG团队发表,核心贡献是证明了卷积神经网络的深度是提升大尺度图像识别精度的关键,并提出了以“小卷积核+深网络”为核心的VGG架构,至今仍是计算机视觉领域的经典基准模型。以下从论文核心逻辑、细节设计、实验验证到贡献影响,进行逐部分精细拆解。

一、论文核心定位与研究背景

1. 核心问题

当时的CNN(如AlexNet、ZFNet)已在图像识别中取得突破,但学界尚未明确“网络深度”对性能的具体影响。论文的核心目标是:在固定架构设计原则下,通过持续增加卷积层深度,验证深度对大尺度图像识别精度的提升作用。

2. 研究背景

- 数据基础:ImageNet数据集(1000类、130万训练图)提供了大尺度训练数据支撑。

- 硬件基础:GPU和分布式计算让深层网络训练成为可能。

- 行业现状:此前的改进集中在“卷积核大小(如AlexNet的11×11、ZFNet的7×7)”“步长”“密集评估”等,而“深度”这一维度未被系统探索。

二、VGG架构设计细节(核心创新点)

论文的架构设计遵循“统一原则+深度递增”,所有配置共享相同的基础结构,仅通过增减卷积层改变深度。

2.1 通用架构框架

| 模块 | 设计细节与核心逻辑 |

|---|---|

| 输入预处理 | 输入为224×224 RGB图像,仅做“减训练集RGB均值”预处理(无复杂归一化,简化流程)。 |

| 卷积层设计 | - 卷积核尺寸:统一用3×3(最小能捕捉“左/右、上/下、中心”空间关系的核)。 - 步长(stride):固定为1,确保特征图不被过度压缩。 - 填充(padding):3×3卷积对应padding=1,保证卷积后特征图空间分辨率不变(公式:H_out=(H_in - 3 + 2×1)/1 +1 = H_in)。 - 非线性激活:所有隐藏层后接ReLU(无LRN,实验证明LRN不提升精度,还增加计算量和内存)。 |

| 池化层设计 | - 类型:max-pooling(最大池化)。 - 窗口:2×2,步长=2。 - 数量:共5个,仅在部分卷积层后插入(非每个卷积层都接池化),用于下采样并保留关键特征。 |

| 全连接层设计 | 所有配置共享3层全连接(FC): - FC1:4096维 - FC2:4096维 - FC3:1000维(对应ImageNet 1000类) - 输出层:softmax(多分类概率归一化)。 - 正则化:前两层FC后接dropout(比例0.5),防止过拟合。 |

2.2 5种具体配置(A-E)

核心差异是“深度”(权重层数量:11→19层)和“卷积核类型”,通道数遵循“每经过1个池化层翻倍”的规则(64→128→256→512→512):

| 配置 | 权重层总数 | 卷积层细节(括号内为“卷积核类型-通道数”) | 关键特点 |

|---|---|---|---|

| A | 11层(8 conv+3 FC) | conv3-64 → 池化 → conv3-128 → 池化 → conv3-256×2 → 池化 → conv3-512×2 → 池化 → conv3-512×2 → 池化 | 最浅,无1×1卷积 |

| A-LRN | 11层(同A) | 在conv3-64后加LRN层 | 验证LRN作用(实验证明无效) |

| B | 13层(10 conv+3 FC) | 比A多2个conv3-64(第一层后新增)、多2个conv3-128(第二层后新增) | 深度增加,无1×1卷积 |

| C | 16层(13 conv+3 FC) | 比B多3个conv1-256/512(分别在256、512、512通道组中插入) | 引入1×1卷积,增加非线性 |

| D | 16层(13 conv+3 FC) | 把C中的3个conv1-256/512替换为conv3-256/512 | 纯3×3卷积,捕捉空间上下文更强 |

| E | 19层(16 conv+3 FC) | 比D多3个conv3-256/512(256通道组加1个,两个512通道组各加1个) | 最深,纯3×3卷积 |

2.3 关键设计的底层逻辑

(1)为什么用3×3卷积替代大卷积?

论文的核心创新之一,用“堆叠小卷积”替代“单个大卷积”,优势有二:

- 感受野等价:3个3×3卷积堆叠的感受野 = 1个7×7卷积(逐步叠加感受野)。

- 非线性更强:3个3×3卷积对应3个ReLU激活,而1个7×7卷积仅1个ReLU,让决策函数更具判别力。

- 参数效率更高:假设输入输出通道数均为C,3个3×3卷积的参数数=3×(3×3×C×C)=27C²;1个7×7卷积的参数数=7×7×C×C=49C²,参数减少44%,相当于隐式正则化,降低过拟合风险。

(2)1×1卷积的作用

配置C中引入1×1卷积,核心目的是“增加非线性,不改变感受野”:

- 1×1卷积本质是通道维度的线性投影(输入输出通道数相同),但后接ReLU可注入额外非线性。

- 不改变特征图的空间尺寸和感受野,仅增强通道间的交互。

(3)为什么去掉LRN?

AlexNet中LRN(局部响应归一化)被用于提升泛化性,但VGG实验证明:

- LRN在ImageNet数据集上对精度无提升(A-LRN与A的top-5误差分别为10.5%和10.4%)。

- 增加内存消耗和计算时间,因此在深层配置(B-E)中直接移除。

三、训练与测试框架(工程细节,决定性能上限)

VGG的成功不仅靠架构,更依赖严谨的训练流程和测试策略,论文给出了可复现的详细参数:

3.1 训练细节

| 训练环节 | 具体参数与逻辑 |

|---|---|

| 优化器 | SGD + 动量(momentum=0.9):经典组合,保证训练稳定性。 |

| 批大小(batch size) | 256:平衡显存占用与训练效率(论文用4块NVIDIA Titan Black GPU并行训练)。 |

| 正则化策略 | - 权重衰减(L2 penalty):系数5e-4,抑制全连接层过拟合。 - Dropout:仅前两层FC用,比例0.5。 |

| 学习率调度 | 初始学习率1e-2,当验证集精度停止提升时,学习率降为原来的1/10,共降3次,总训练迭代37万次(74个epoch)。 |

| 权重初始化 | - 初期:先训练浅模型A(随机初始化),再用A的前4个卷积层和后3个FC层初始化深模型(中间层随机初始化)。 - 后续发现:用Glorot & Bengio(2010)的随机初始化可直接训练深层模型,无需预训练。 |

| 数据增强 | - 尺度抖动:训练图最小边S随机采样自[256,512](多尺度训练,适配不同尺寸物体)。 - 随机裁剪:从S×S图中随机裁剪224×224。 - 水平翻转+RGB颜色偏移:增加数据多样性。 |

3.2 测试细节(提升精度的关键技巧)

(1)全卷积网络(FC→Conv)改造

将3层全连接层转为卷积层,实现“密集评估”:

- FC1(4096维)→ 7×7卷积(输入为最后一个池化层的7×7特征图,输出4096通道)。

- FC2(4096维)→ 1×1卷积(输出4096通道)。

- FC3(1000维)→ 1×1卷积(输出1000通道)。

- 优势:可处理任意尺寸输入,输出“类分数图”,避免传统裁剪测试的重复计算,且能捕捉图像全局上下文。

(2)多尺度测试+水平翻转

- 测试尺度Q:对多尺度训练的模型,Q取[256, 384, 512](覆盖训练尺度范围)。

- 结果融合:对每个测试图,计算原图和水平翻转图的分数,再对多尺度结果平均,提升鲁棒性。

(3)多裁剪评估(可选)

- 对每个测试尺度,裁剪5×5网格+水平翻转,共50个裁剪图,多尺度累计150个裁剪图。

- 与密集评估互补(边界条件不同:裁剪图用零填充,密集评估用图像邻域填充),结合后可进一步提升精度。

四、实验结果与关键结论(基于ImageNet数据集)

论文通过大量对比实验验证架构设计,核心结果集中在“深度影响”“训练/测试策略影响”“SOTA对比”三方面:

4.1 深度对性能的影响(核心结论)

| 配置 | 单尺度测试(S=256, Q=256)top-5误差 | 多尺度测试(Q=[256,384,512])top-5误差 | 关键结论 |

|---|---|---|---|

| A(11层) | 10.4% | - | 深度最浅,误差最高 |

| B(13层) | 9.9% | 9.6% | 深度增加,误差下降 |

| C(16层,含1×1) | 9.4% | 8.2% | 1×1卷积提升非线性,但不如纯3×3 |

| D(16层,纯3×3) | 8.8% | 7.5% | 纯3×3捕捉空间上下文,性能优于C |

| E(19层,纯3×3) | 9.0% | 7.5% | 深度饱和,误差与D接近(19层未比16层显著提升,说明当时数据集下16层已达最优深度) |

核心结论1:网络深度是提升精度的关键,从11层到16层,top-5误差从10.4%降至8.8%;但深度超过19层后,精度趋于饱和(无显著提升)。

4.2 训练/测试策略的影响

- 多尺度训练>固定尺度训练:配置D用多尺度训练(S∈[256,512]),单尺度测试误差8.1%,比固定S=256的8.8%低0.7%。

- 多尺度测试>单尺度测试:配置D多尺度测试误差7.5%,比单尺度测试低0.6%。

- 多裁剪+密集评估>单一评估:配置E结合后top-5误差7.1%,比单独密集评估低0.4%。

4.3 与SOTA模型的对比(ILSVRC 2014)

| 模型 | top-5测试误差 | 关键优势 |

|---|---|---|

| AlexNet(2012) | 16.4% | - |

| ZFNet(2013) | 14.8% | - |

| GoogLeNet(2014冠军) | 6.7%(7模型融合) | 架构复杂(Inception模块) |

| VGG-D(单模型) | 7.0% | 架构简单,单模型性能超GoogLeNet(7.9%) |

| VGG-D+E(2模型融合) | 6.8% | 融合后接近冠军,模型数量远少于GoogLeNet |

核心结论2:VGG用“简单架构+深度”击败了复杂架构的GoogLeNet,证明传统CNN的深度潜力;且模型融合效率更高(2个模型vs7个模型)。

4.4 定位任务结果(附录A)

VGG团队在ILSVRC 2014定位任务中夺冠(top-5误差25.3%),关键设计:

- 用配置D作为基础架构,最后一层FC改为“边界框回归头”(PCR:per-class regression,类特异性回归,优于SCR单类回归)。

- 微调所有层(而非仅微调FC层),利用深层特征的定位能力。

五、泛化性验证(附录B,证明模型价值)

论文通过在多个小数据集上测试,验证VGG特征的泛化能力(无需微调,仅用预训练特征+线性SVM分类):

| 数据集 | 任务类型 | VGG-D/E的性能 | 当时SOTA性能 |

|---|---|---|---|

| VOC 2007 | 图像分类(mAP) | 89.3%(单模型)/89.7%(融合) | Chatfield et al.(2014)82.4% |

| VOC 2012 | 图像分类(mAP) | 89.0%(单模型)/89.3%(融合) | Wei et al.(2014)81.7% |

| Caltech-256 | 图像分类(召回率) | 85.1%(E模型) | Chatfield et al.(2014)77.6% |

| VOC 2012 | 动作分类(mAP) | 84.0%(融合+边界框特征) | Hoai(2014)76.3% |

核心结论3:VGG的深层卷积特征具有极强的泛化性,在小数据集、不同任务(分类、动作识别)上均超越当时的SOTA,成为后续迁移学习的重要预训练模型。

六、论文贡献与深远影响

1. 学术贡献

- 首次系统证明“深度”是CNN性能提升的核心因素,确立“深网络”的研究方向。

- 提出“3×3小卷积核堆叠”范式,成为CNN架构设计的标准组件(后续ResNet、MobileNet等均沿用小卷积核思路)。

- 验证了“全卷积网络+密集评估”的测试方法,大幅提升测试效率和精度。

2. 工程影响

- 提供了可复现的训练/测试流程(数据增强、学习率调度、初始化方法),成为后续CNN训练的“基准模板”。

- VGG-16/VGG-19模型开源后,成为迁移学习的首选预训练模型(在目标检测、语义分割、图像生成等任务中广泛应用)。

- 影响后续架构设计:ResNet通过残差连接解决深层网络梯度消失问题,本质是“在VGG的深度思路上进一步突破”。

3. 局限性

- 参数量大:VGG-16约138M参数,主要集中在全连接层,训练和推理耗时耗显存(后续MobileNet、EfficientNet通过通道剪枝、深度可分离卷积优化)。

- 深度饱和:19层后精度无显著提升,说明单纯增加深度并非无限有效,需结合残差、注意力等机制。

七、论文与代码的差异说明

import torch

from torch import nn

from d2l import torch as d2l

import matplotlib.pyplot as plt# 固定随机种子(确保结果可重复)

torch.manual_seed(42)

torch.cuda.manual_seed(42)

torch.cuda.manual_seed_all(42)def vgg_block(num_convs, in_channels, out_channels):layers = []for _ in range(num_convs):layers.append(nn.Conv2d(in_channels, out_channels,kernel_size=3, padding=1))layers.append(nn.ReLU())in_channels = out_channelslayers.append(nn.MaxPool2d(kernel_size=2, stride=2))return nn.Sequential(*layers)conv_arch = ((1, 64), (1, 128), (2, 256), (2, 512), (2, 512))def vgg(conv_arch):conv_blks = []in_channels = 1# 卷积层部分for (num_convs, out_channels) in conv_arch:conv_blks.append(vgg_block(num_convs, in_channels, out_channels))in_channels = out_channels# 动态计算Flatten后的维度(增强鲁棒性)test_X = torch.randn(1, 1, 224, 224)for blk in conv_blks:test_X = blk(test_X)flatten_dim = test_X.numel()# 全连接层部分return nn.Sequential(*conv_blks, nn.Flatten(),nn.Linear(flatten_dim, 4096), nn.ReLU(), nn.Dropout(0.5),nn.Linear(4096, 4096), nn.ReLU(), nn.Dropout(0.5),nn.Linear(4096, 10))# 构建精简版VGG

ratio = 4

small_conv_arch = [(pair[0], pair[1] // ratio) for pair in conv_arch]

net = vgg(small_conv_arch)# 测试网络前向传播(验证维度正确性)

X = torch.randn(size=(1, 1, 224, 224))

for blk in net:X = blk(X)print(blk.__class__.__name__, 'output shape:\t', X.shape)# 超参数(调整为更稳定的值)

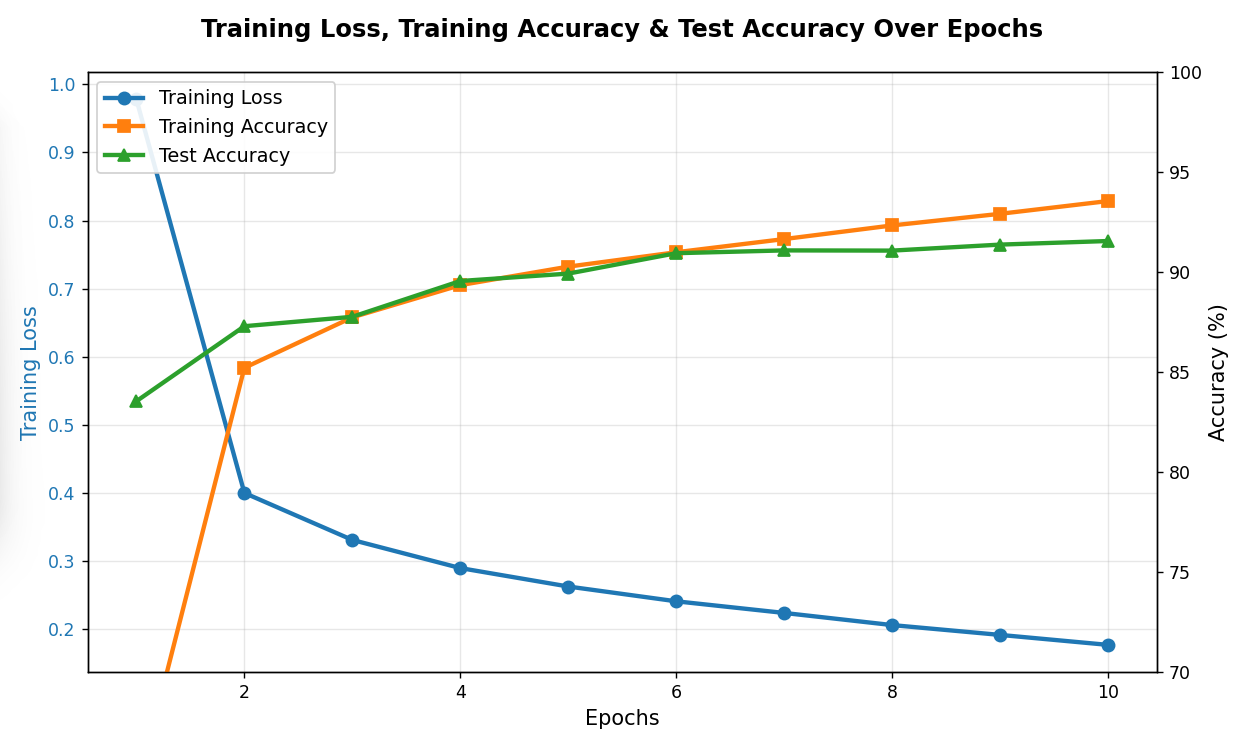

lr, num_epochs, batch_size = 0.01, 10, 64 # lr从0.05→0.01,batch_size从128→64

train_iter, test_iter = d2l.load_data_fashion_mnist(batch_size, resize=224)def train_ch6(net, train_iter, test_iter, num_epochs, lr, device):"""用GPU训练模型(在第六章定义),新增指标记录以支持后续绘图"""def init_weights(m):if type(m) == nn.Linear or type(m) == nn.Conv2d:nn.init.xavier_uniform_(m.weight)net.apply(init_weights)print('training on', device)net.to(device)# 优化器:添加momentum加速收敛optimizer = torch.optim.SGD(net.parameters(), lr=lr, momentum=0.9)# 学习率调度器:每3轮降低学习率(可选,增强稳定性)scheduler = torch.optim.lr_scheduler.StepLR(optimizer, step_size=3, gamma=0.9)loss = nn.CrossEntropyLoss()animator = d2l.Animator(xlabel='epoch', xlim=[1, num_epochs],legend=['train loss', 'train acc', 'test acc'])timer, num_batches = d2l.Timer(), len(train_iter)# 初始化指标列表train_losses = []train_accs = []test_accs = []for epoch in range(num_epochs):metric = d2l.Accumulator(3) # 总损失、总正确数、总样本数net.train()for i, (X, y) in enumerate(train_iter):timer.start()optimizer.zero_grad()X, y = X.to(device), y.to(device)y_hat = net(X)l = loss(y_hat, y)l.backward()optimizer.step()with torch.no_grad():metric.add(l * X.shape[0], d2l.accuracy(y_hat, y), X.shape[0])timer.stop()# 计算当前平均损失和精度train_l = metric[0] / metric[2]train_acc = metric[1] / metric[2]# 绘制中间进度if (i + 1) % (num_batches // 5) == 0 or i == num_batches - 1:animator.add(epoch + (i + 1) / num_batches,(train_l, train_acc, None))# 评估测试集精度test_acc = d2l.evaluate_accuracy_gpu(net, test_iter)animator.add(epoch + 1, (None, None, test_acc))# 学习率调度scheduler.step()# 记录当前轮指标avg_train_loss = metric[0] / metric[2]avg_train_acc = metric[1] / metric[2]train_losses.append(avg_train_loss)train_accs.append(avg_train_acc)test_accs.append(test_acc)# 打印最终结果print(f'Final: loss {train_l:.3f}, train acc {train_acc:.3f}, 'f'test acc {test_acc:.3f}')print(f'{metric[2] * num_epochs / timer.sum():.1f} examples/sec 'f'on {str(device)}')return train_losses, train_accs, test_accs# 训练模型(解包返回值,而非赋值给单个变量a)

train_losses, train_accs, test_accs = train_ch6(net, train_iter, test_iter, num_epochs, lr, d2l.try_gpu()

)# 绘制训练曲线(修正后使用解包后的变量)

epochs = range(1, num_epochs + 1)

fig, ax1 = plt.subplots(figsize=(10, 6))# 左侧Y轴:训练损失

color1 = '#1f77b4'

ax1.set_xlabel('Epochs', fontsize=12)

ax1.set_ylabel('Training Loss', color=color1, fontsize=12)

line1 = ax1.plot(epochs, train_losses, 'o-', color=color1, linewidth=2.5,markersize=7, label='Training Loss')

ax1.tick_params(axis='y', labelcolor=color1)

ax1.grid(True, alpha=0.3)# 右侧Y轴:精度(训练+测试)

ax2 = ax1.twinx()

color2 = '#ff7f0e'

color3 = '#2ca02c'

ax2.set_ylabel('Accuracy (%)', fontsize=12)

line2 = ax2.plot(epochs, [acc*100 for acc in train_accs], 's-', color=color2,linewidth=2.5, markersize=7, label='Training Accuracy')

line3 = ax2.plot(epochs, [acc*100 for acc in test_accs], '^-', color=color3,linewidth=2.5, markersize=7, label='Test Accuracy')

ax2.set_ylim(70, 100) # 固定精度范围,更直观# 合并图例

lines = line1 + line2 + line3

labels = [l.get_label() for l in lines]

ax1.legend(lines, labels, loc='upper left', fontsize=11, framealpha=0.9)# 图表美化

plt.title('Training Loss, Training Accuracy & Test Accuracy Over Epochs',fontsize=14, fontweight='bold', pad=20)

fig.tight_layout()

plt.show()

代码是VGG的“简化实现”,与论文原版的核心差异的:

| 差异点 | 论文原版 | 你的代码 |

|---|---|---|

| 通道数 | 64→128→256→512→512(完整尺寸) | 通道数÷4(small_conv_arch),轻量化 |

| 批大小 | 256(4GPU并行) | 64(适配单GPU) |

| 学习率 | 初始1e-2,分3次衰减 | 初始0.01,无衰减(简化) |

| 数据增强 | 多尺度训练、RGB偏移 | 仅resize=224,简化增强 |

| 测试策略 | 全卷积+多尺度+翻转 | 仅单尺度训练后绘图,无复杂测试 |

简化版更适合快速验证架构,而论文的完整配置和训练/测试策略是其达到SOTA的关键。