AI研究-123 FSD V14 深度解析:纯视觉 SDF 与端到端 相比 V12 具体升级

TL;DR

- 场景:面向想系统理解 FSD 从 V12→V14 的技术读者与评测者。

- 结论:V14=更大模型 + 更细粒度纯视觉重建 + 更拟人的端到端决策;提升明显,但可解释性与硬件门槛更高。

- 产出:对比要点、常见误读/问题。

神经网络架构与感知系统

特斯拉FSD(Full Self-Driving)V14采用纯视觉感知方案,通过多摄像头输入和大规模神经网络实现对环境的建模和决策。V12版本实现了关键的范式转变:将原有30万行C++驾驶逻辑代码几乎完全替换为端到端深度神经网络,用“AI模型”取代了大量的手工规则。在V12中,8个摄像头采集的原始图像经由48个神经网络组成的管线处理,转化为对车辆周围三维空间的理解,例如通过鸟瞰图投影(Bird’s Eye View)和占用网络构建环境模型。

这一代架构可直接从摄像头像素输出转向、加减速指令,实现感知-规划-控制的端到端学习。特斯拉工程师将其形容为“汽车的ChatGPT”,通过学习数百万小时人类驾驶数据来替代硬编码规则。例如,马斯克曾解释:“V11代码里没有一句明确告诉车辆如何过环岛……V11版本有30多万行C++代码,而V12基本没有这些了”。这标志着特斯拉从传统模块化(感知、预测、规划分离)架构向统一神经网络架构的革命性跃迁。

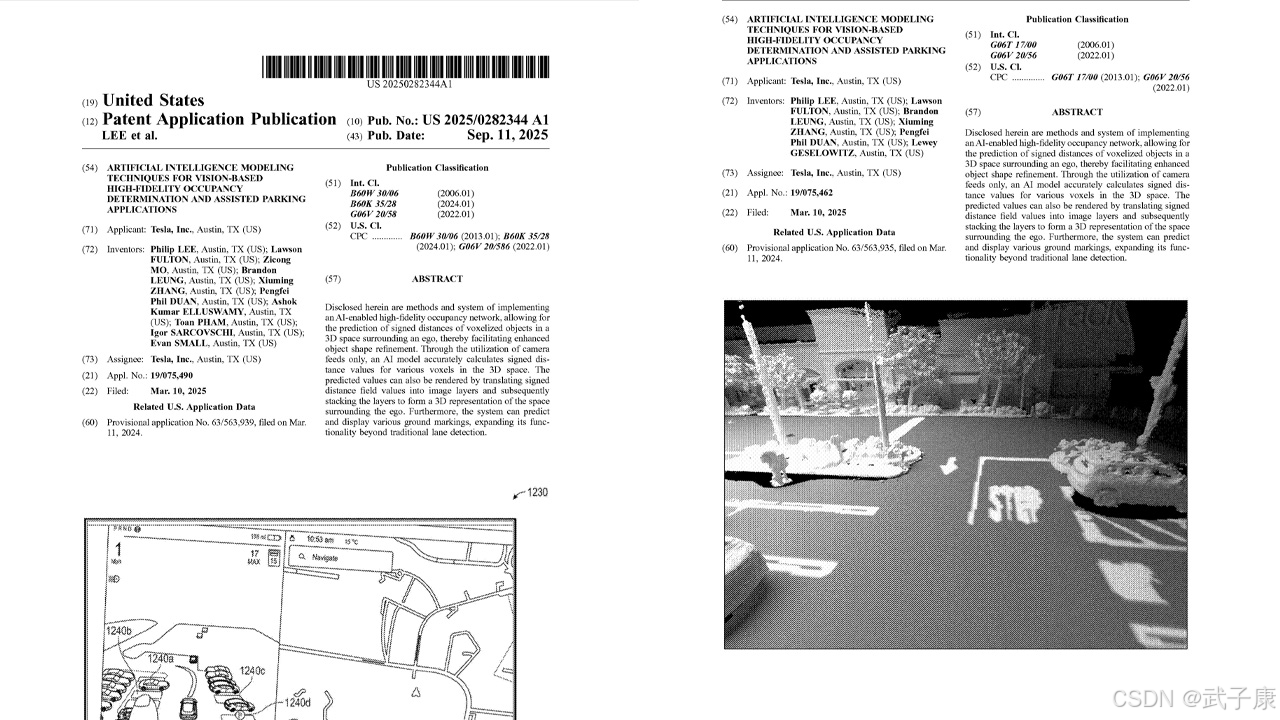

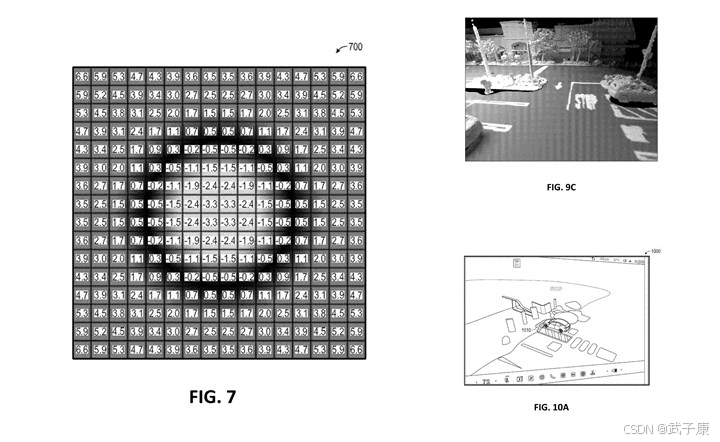

在感知方面,FSD V14继续坚持纯视觉路线,完全依赖摄像头而弃用雷达和激光雷达,通过AI来“看”世界。特斯拉近期公开的专利显示,其感知网络引入有向距离场(Signed Distance Fields, SDF)技术,将多摄像头影像转化为连续的三维占用网格。具体而言,一个Transformer结构的神经网络融合8路摄像头视频,输出场景的高精度SDF体素表示,每个体素记录距离最近物体表面的距离,从而以10厘米精度重建车辆周围的3D空间。相较之前约33厘米分辨率的占用网格,精度提升了约3倍至10厘米级别。这使得FSD能够捕捉更细腻的环境细节,例如路边缘石、停车位标线等,以往版本仅能以较粗糙的方块表现物体轮廓。

下图对比了传统FSD视觉化(左)和新SDF高精度重建(右):左图中道路元素以简化的线框和矩形表示,每格约0.3米;右图展示了接近实景的3D环境重建,包括更平滑的路缘、地面标记和车辆外形。

不仅如此,FSD V14的感知网络还能识别以往难以捕捉的地面特殊标记和细节。如专利所述,无障碍停车位标志、消防通道标线等地面涂装都能被AI识别到体素级别。多帧时空融合技术也被应用于感知:通过整合连续帧信息,网络可以跟踪行人、车辆等动态物体的位置,实现更稳定精准的检测。

例如,车辆能预测行人穿行轨迹或识别慢速移动的施工车辆,从而更平稳地应对动态环境。值得一提的是,特斯拉利用全球超400万辆车队收集了海量视频数据,通过“影子模式”在后台比较AI决策与人类行为,在驾驶员介入时回传片段用于训练。据报道,每个完整训练周期需要处理1.5PB驾驶数据、耗费7万GPU小时,由此可见其神经网络的训练规模之大。

决策与控制策略

自V12以来,特斯拉FSD的决策控制逐步由神经网络接管,大幅减少了手工编码规则。早期的Autopilot系统采用Mobileye方案,只能依赖固定算法检测车道线、执行简单巡航控制,局限性明显。2016年与Mobileye分手后,特斯拉转向内部开发分阶段引入神经网络:先在2016-2019年用HydraNet多任务网络处理感知(目标检测、轨迹预测等),但规划控制仍由C++规则实现;2020年后逐步用NN替换各子模块,例如用学习策略代替硬编码的停车让行规则、交通灯逻辑等。

到2023年底发布的FSD V12,这一路线达到顶峰——原先约300,000行手写控制代码被压缩到仅几千行,用于管理神经网络的启停,其余决策均交由网络学习产生。正如Autopilot团队成员Dhaval Shroff所述:“我们不再用规则计算汽车的行驶路径,而是用神经网络从数百万例人类驾驶中学会如何走正确的路”。

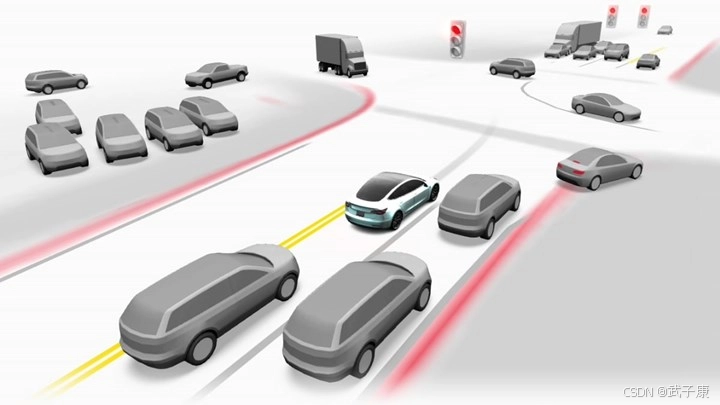

因此,在V14中,FSD的决策流程基本成为 “黑箱”神经网络 :摄像头像素 -> 神经网络 -> 控制指令,整个链路没有明确的if-then规则介入。这种端到端策略使FSD能够学会许多 “涌现”行为 :比如自动识别社交驾驶礼让行为,在有人行横道前减速避让行人,跟随前车通过复杂施工区,遇到路边有自行车或行人时稍向另一侧避让等等。

这些举动并非由工程师逐一编写,而是网络从人类示范中总结出的模式,往往较传统代码实现更自然顺畅。马斯克表示,FSD V14让车辆驾驶“感觉像是有生命”,更加贴近人类风格。例如,当前FSD已经会在接近斑马线时轻微减速,或在超越路边自行车时压线避让,V14进一步强化了这种类人的动态反应。可以说,特斯拉试图让FSD具备一种“类直觉”的决策能力,而非严格按预编程指令运行。

当然,完全依赖学习的决策也带来挑战。由于缺少明确的规则约束,神经网络决策过程难以解释,这被视为“黑箱AI”,验证其安全性更具难度。传统自动驾驶(如Waymo、Cruise)的模块化方案可以跟踪每步决策依据,例如遇到行人时按照规则计算刹车,这种可解释性便于调试和监管审查。而特斯拉的网络输出一个转向角或车速,并不能轻易解释为何如此操作,这对证明系统可靠性提出了更高要求。

特斯拉通过大量真实世界测试和迭代来提升决策的鲁棒性,并引入了多重冗余安全层:比如对极端不合理的指令设置限制,或保留少量底层规则(如防撞紧急制动)兜底,以防网络失误。但总体上,V14代表着特斯拉几乎完全拥抱AI学习决策的策略,其核心理念是“大数据+大网络”能够涌现出有效驾驶策略,替代人工难以覆盖的海量规则。

端到端模型设计与性能改进

FSD V14在模型设计上相对V12做了显著增强。首先是规模和容量的大幅提升:马斯克透露V14采用的神经网络参数量是V13的10倍(相比之下,V12与V13在参数上差距不大)。网络容量的暴增使得旧款硬件HW3已无法胜任V14——这也正是特斯拉将V14仅限于HW4平台推送的原因。HW4计算机拥有约2倍于HW3的算力和内存,才能加载规模庞大的新模型。

尽管许多HW3车辆目前仍停留在V12.x或“V13精简版”软件上,特斯拉表示将于2026年推出“V14 Lite”供HW3使用,尽量后向移植部分V14功能。但由于HW3硬件受限,“Lite”版本难以包含10倍参数和无压缩视频等特性,只能实现V14部分改进(如施工区和紧急车辆的增强处理、自动泊车选项、新的驾驶模式UI等)。真正完整的V14体验需要HW4甚至未来的HW5(Tesla计划HW5算力和内存再提高数量级)。

除了更大的模型,V14还改进了输入数据的处理。此前FSD为减小带宽,对摄像头视频进行了较强压缩,而V14通过优化视频帧压缩算法,减少了图像细节损失。这使神经网络能够获取更多微妙信息,例如远处行人的细微动作、路面更淡的标线等,从而提高感知和决策精度。特斯拉声称,参数规模的10倍增长结合视频质量提升,将让网络洞察更细节、响应更拟人。

一些核心场景得益于此发生质变:例如在无保护左转(对向有来车情况下左转)情形下,V14能更准确地判断对向车速度和距离,从而更大胆或更谨慎地完成左转,而V12有时会犹豫不决或过于保守。又如并线变道,V14据报道比V12更流畅自如,减少了反复犹豫的现象。一位长期测试者反馈:“V14.1.2 已经解决了95%的犹豫变道和刹车问题,过去两天我完全没碰方向盘”。这表明端到端模型增强带来了明显的性能提升,接近可以在多数场景下不需人工干预。

技术上,特斯拉也在优化模型的计算效率。据外媒报道,特斯拉在第二项专利中提出了一种“三线性插值”方法,只需对8个点采样计算即可推算出连续空间的深度值,从而以很小的代价获得接近无限分辨率的环境表示。这一创新据称可在保持厘米甚至毫米级精度的同时 减少高达90% 的计算量。

换言之,传统提高占用网格精度会导致计算量呈指数增长,而特斯拉的算法通过数学插值极大降低了运算复杂度,让实时高精度感知成为可能。这一技术不仅适用于车辆,同样适用于特斯拉的人形机器人Optimus:专利显示其AI架构可自动适配不同摄像头配置,使机器人在狭窄空间(如走廊)中安全移动,车辆在停车场中精确操作。汽车与机器人的感知决策经验也可相互借鉴,实现跨领域的“共同智能”。

由此可见,V14背后的关键技术创新不仅在于规模升级,还有算法层面的突破,使纯视觉方案具备媲美激光雷达的感知精度和更广泛的应用潜力。

V12与V14核心技术差异

架构统一与端到端AI:FSD V12的最大成就是完成了街道和高速“双栈”合一,首次将端到端神经网络引入高速场景。此前版本中,高速公路Autopilot沿用较传统的模块化算法,而V12用AI接管高速驾驶决策,使城市街道和高速公路共享同一套网络模型。V12还启用了驾驶员监控摄像头,以视觉方式检测驾驶员注意力,替代过去靠方向盘扭矩提示的“nag”机制。这减少了不必要的报警,在驾驶员专注且安全驾驶一段时间后,会自动解除先前因不当操作累计的警告等级。另外,V12引入了新的驾驶风格配置(如Chill、Average模式)并优化了变道逻辑,使车辆行为更平顺自然。

相比之下,V14在V12基础上主要提升了感知精度和智能化程度。

首先,模型容量骤增10倍并结合高清摄像头输入,使V14能捕获环境更加细腻的要素,从而在决策上更接近人类直觉。

其次,V14增加了许多长尾场景和特殊工况的处理能力,包括:对紧急车辆(警车、消防车、救护车)的让行避让更加及时明确;遇到道路封闭或施工,FSD可通过视觉识别路障并自动重新规划绕行路线;对静态障碍物和杂物(如坠落的轮胎、树枝、箱子)有了更强的检测和绕避能力;在复杂的无保护转弯、加塞/被加塞场景中,决策更从容稳健。

此外,V14扩展和细化了速度策略和驾驶风格参数。除了原有的“放心(Chill)”“普通(Average)”“积极(Assertive)”等模式,新增了比Chill更慢更保守的“树懒(Sloth)”模式和比Assertive更激进的“疯狂麦克斯(Mad Max)”模式。Mad Max模式允许更高车速和更频繁的变道,专为拥堵交通下高效通勤设计,开启后系统在车流中表现得更积极但仍保持安全边际。反之,Sloth模式则极为谨慎,用较低速度和大跟车距离行驶,以满足一些用户在复杂城区路况下求稳的需求。

最后,V14针对用户体验也做了升级,包括引入“起步即自主驾驶”功能(车辆从P挡出发或途中可一键进入FSD模式)和新的中控UI,允许驾驶者在行驶中随时调整速度配置和到达方式。驾驶员监控的敏感度也有所降低,V14在系统足够自信时减少对驾驶员目视前方的频繁提醒,避免用户为了操作中控屏或调节音乐就被警告甚至介入。当然,特斯拉强调这并不意味着可以完全不管不顾,驾驶员在复杂路口、异常路况或恶劣天气下仍需随时接管。

总体而言,相对V12,FSD V14更像是在 “智能”和“细节” 两个层面全面进化:智能上更加拟人、减少介入需求;细节上更加精致、处理场景更全。这使其朝着最终的“无人监督驾驶”又迈进了一步。

其他系列

🚀 AI篇持续更新中(长期更新)

AI炼丹日志-29 - 字节跳动 DeerFlow 深度研究框斜体样式架 私有部署 测试上手 架构研究,持续打造实用AI工具指南!

AI-调查研究-108-具身智能 机器人模型训练全流程详解:从预训练到强化学习与人类反馈

🔗 AI模块直达链接

💻 Java篇持续更新中(长期更新)

Java-154 深入浅出 MongoDB 用Java访问 MongoDB 数据库 从环境搭建到CRUD完整示例

MyBatis 已完结,Spring 已完结,Nginx已完结,Tomcat已完结,分布式服务正在更新!深入浅出助你打牢基础!

🔗 Java模块直达链接

📊 大数据板块已完成多项干货更新(300篇):

包括 Hadoop、Hive、Kafka、Flink、ClickHouse、Elasticsearch 等二十余项核心组件,覆盖离线+实时数仓全栈!

大数据-278 Spark MLib - 基础介绍 机器学习算法 梯度提升树 GBDT案例 详解

🔗 大数据模块直达链接