Advancing Real-World Image Dehazing: Perspective, Modules, and Training

标题:推进真实场景图像去雾:视角、模块与训练

原文连接:https://ieeexplore.ieee.org/stamp/stamp.jsp?tp=&arnumber=10564179

发表:TPAMI-2024

摘要

从退化的雾天观测图像中恢复高质量图像是计算机视觉领域一项基础且重要的任务。尽管深度模型在合成数据上取得了显著成功,但其在真实场景中的有效性仍有待验证。为提高在真实环境中的适应性,本文从成像视角、结构模块和训练策略三个关键方面入手,构建了一个全新的计算框架。为模拟真实雾天图像中常被忽略的多重退化属性,本文提出了一种新的雾天成像模型,该模型包含多种退化因素,有助于缩小合成图像空间与真实图像空间之间的领域差距。与现有主要针对逆成像过程的方法不同,本文设计了一种遵循“定位-去除”流程的新型去雾网络。退化定位模块旨在帮助网络捕捉具有判别性的雾相关特征信息,退化去除模块通过学习训练样本的权重矩阵来消除特征间的依赖关系,从而避免现有深度方法中提取特征的虚假相关性。本文还定义了一种新的高斯感知对比损失,以进一步约束网络向自然去雾的方向更新。在具有挑战性的RTTS、URHI和Fattal真实雾天数据集上,通过多项全参考/无参考图像质量指标和主观视觉效果评估,所提方法表现出优异性能,优于当前最先进的方法。

关键词-真实图像去雾;成像视角;结构模块;训练策略

1 引言

雾霾、烟尘污染等恶劣天气现象普遍存在能见度降低的问题,严重干扰视觉系统的成像质量。对于自动驾驶辅助、近岸海域监测、无人机航拍等依赖图像信息的视觉任务,雾、霾污染导致的图像质量退化可能带来严重的安全风险[1], [2]。为消除雾天干扰,众多学者对退化图像的视觉恢复方法展开了富有洞察力的研究。尽管已提出多种具有代表性的去雾方法[3], [4], [5],但真实场景下的去雾仍面临较大挑战。

早期的经典优化方法[6], [7], [8]以大气光散射模型(ASM)[9]推导的物理原理为基础,结合统计先验构建模型,是图像去雾的核心方法。然而,这些方法通常需要理想的数据假设。由于真实雾分布的不均匀性,当实际获取的先验信息与理想数据假设存在偏差时,去雾效果会变差。得益于大规模数据的可获得性,数据驱动的学习方法在各个领域占据主导地位,单图像去雾任务也不例外。一系列数据驱动的深度网络[10], [11], [12], [13], [14]通过精心设计的网络架构和训练策略解决单图像去雾问题。

在这些深度网络中,一类方法[15], [16], [17]利用神经网络估计ASM的物理参数,间接学习无雾图像;另一类方法[11], [18], [19]通过在大规模合成雾天数据上训练,直接学习雾天图像与无雾图像之间的映射关系。尽管这些方法大多在特定场景下取得了理想的视觉质量,但它们难以充分泛化到真实雾天场景,应用于真实雾天数据时,往往会产生场景昏暗或去雾无效的结果。主要原因如下:(1)真实世界图像去雾是一个高度不适定问题,会受到多种退化因素(如弱光、噪声等)的干扰。然而,现有用于训练的合成数据仅考虑单一的图像退化因素,导致这些合成数据与真实雾天数据集之间存在较大的分布差异。(2)这些深度去雾网络过于依赖ASM本身或理想的合成雾天数据进行训练,产生有偏预测,导致网络泛化能力不足。

针对上述问题,一种方案是基于大气光散射模型、雾机或扩散模型生成更逼真的配对雾天数据,以缩小与真实数据的分布差异。然而,由于ASM本身的局限性以及其他雾天数据生成方法缺乏足够的理论保障,这些合成训练数据并非始终有效。另一种方案是设计良好的训练策略。许多研究从领域偏移[20]或先验引导[21], [22], [23]的角度,通过领域自适应来解决这些问题。诚然,这些方法通过采用领域对抗或解耦重构,确实可以缩小合成数据与真实数据之间的分布差异。但在复杂的真实雾天场景中,这些方法的去雾性能不稳定,去雾结果容易出现颜色混淆[5], [20]、亮度衰减[24]和过饱和[23], [25]等问题。

近年来,利用领域泛化的思想解决数据分布偏移问题取得了进一步的研究进展。领域泛化研究表明,特征间细微的统计相关性是网络模型泛化能力不足的主要原因[26], [27], [28]。在复杂的真实雾天环境中,深度网络提取的特征可能包含不利的混淆特征(如弱光、噪声等),这些混淆特征会与本质特征产生细微的统计相关性,干扰深度网络的分析能力,导致意外的预测结果。因此,要使去雾网络获得稳定的泛化性能,尽可能消除神经网络从数据中学习到的本质特征与混淆特征之间的依赖关系,是一种重要的解决方案。

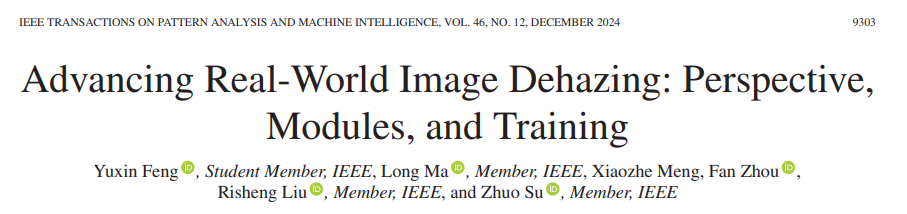

基于上述分析,为提高在真实雾天场景中的适应性,本文从成像视角、结构模块和训练策略三个关键方面构建了一个全新的计算框架。首先,考虑弱光、噪声等多种因素,构建一种新的雾天多重退化模型(MD),以减少与真实雾天图像的分布差异。其次,设计遵循“定位-去除”流程的新型去雾网络。退化定位模块作为提取器,帮助网络捕捉具有判别性的雾相关特征信息;退化去除模块通过学习一个对数据进行全局解相关和标准化的权重矩阵,消除无雾背景特征与雾之间的依赖关系。最后,为使恢复的图像具有更逼真的外观,本文借鉴对比学习的思想,设计了高斯感知对比损失(GPC)。该损失能够充分利用清晰样本和雾天样本的有效信息,引导网络向自然去雾的方向更新。图1展示了所提方法的有效性评估。本文的主要贡献可总结如下:

- 提出一种新颖的雾天成像模型,用于模拟真实雾天图像中常被忽略的多重退化属性,该模型包含多种退化因素,有助于减少合成图像空间与真实图像空间之间的分布差异。

- 构建遵循“定位-去除”流程的新型图像去雾网络。退化定位模块旨在帮助网络捕捉具有判别性的雾相关特征信息,退化去除模块利用随机傅里叶特征和样本加权的特性,消除无雾背景特征与雾之间的依赖关系。

- 定义一种精细的高斯感知对比(GPC)损失,进一步约束网络向自然去雾的方向更新。此外,本文还验证了GPC可作为一种“即插即用”的损失,用于提升其他去雾模型的性能。

- 在具有挑战性的数据集上,通过九项权威的全参考/无参考图像质量指标和主观视觉效果评估,所提方法表现出优异性能,优于当前最先进的方法。

2 相关工作

与其他经典图像处理任务[29], [30], [31], [32], [33], [34]类似,单图像去雾技术也从基于模型的传统方法发展到了数据驱动的深度网络。下文将全面介绍两类相关工作。

2.1 基于传统模型的方法

大气光散射模型[9]通过引入物理成像的基本原理,为图像去雾奠定了基础。该模型描述了理想条件下的雾天成像过程,指出雾天图像可分解为大气光、场景透射图和反射图像三个部分。基于这一原理,基于模型的传统方法[6], [8], [35]以大气光散射模型启发的保真原则为指导,致力于开发高效的统计物理先验。

为实现图像去雾任务,研究人员通常会观察和统计图像中雾区的物理规律,然后利用启发式设计的先验知识(或手工设计特征)估计透射图和大气光,最终根据大气光散射模型得到去雾结果。更具代表性的方法包括:Wang等人[4]提出了灰度雾线先验(GHP),并证明雾主要集中在RGB颜色空间的雾线上,且可准确投影到YUV颜色空间Y通道的灰度分量上;Ju等人[5]基于增强的大气光散射模型,提出了灰度世界假设先验IDE,该方法可同时实现图像去雾和曝光校正。

此外,部分学者基于观测到的统计先验和图像特征,提出了用于去雾的浅层学习方法,包括马尔可夫模型、线性回归模型等。其中较具代表性的工作有:Zhu等人[36]提出了颜色衰减先验,并在该先验约束下构建线性模型来对场景深度进行建模;Nishino等人[37]提出了经典的贝叶斯去雾方法。同时,也有学者提出了基于模型先验的图像特征融合去雾方法,例如:Hu等人[38]提出了自适应图像去雾的联合局部-全局光照调整算法;Guo等人[39]结合高斯暗通道得到的大气光值和基于大气光散射模型得到的透射图,使图像获得精细的纹理结构和均衡的颜色。尽管基于模型先验的方法在特定场景下能取得较好的去雾效果,但在复杂雾天场景中,当先验信息不满足时,这些方法的鲁棒性较差。此外,利用先验信息准确估计透射矩阵通常较为繁琐,需要大量优化时间。

2.2 数据驱动的深度网络

近年来,随着深度学习技术的发展,单图像去雾任务不再单纯依赖设计启发式先验进行任务建模,而是更多地从海量合成数据中学习深度模型[40], [41], [42]。目前,数据驱动的深度方法[43], [44], [45], [46]已成为图像去雾技术发展的主流方向。

设计网络架构[47], [48], [49]是数据驱动深度网络的关键要素。众多学者在构建更具泛化性的网络结构方面开展了深入研究。早期受模型启发的学习方法[15], [16], [17]已被证明在图像去雾任务中有效:Cai等人[15]首次提出包含双侧校正线性单元的新激活函数来估计大气光,随后利用网络从雾天图像中学习透射图;Ren等人[50]通过引入语义信息来估计透射图;Zhang等人[51]设计了同时学习大气光和场景透射图的网络;Li等人[52]以分类方式估计大气光,并通过渐进式网络获得透射图。通过在大规模合成数据集上训练,这些方法能够提取有效特征以直接估计透射图。然而,这些方法严格依赖传统的大气光散射模型,且主要利用低层图像特征,因此无法在复杂的真实雾天场景中有效学习深层雾相关特征,导致图像去雾失败。

与上述受模型启发的学习方法不同,得益于残差连接、跳跃连接和密集连接技术的发展,许多启发式设计的深度去雾网络[11], [18], [19]通过设计复杂的网络结构,直接学习雾天图像到无雾图像的映射关系。例如:Dong等人[53]设计了具有密集特征融合的多尺度增强去雾网络;Lin等人[41]提出了多尺度注意力特征融合去雾网络;Liang等人[54]设计了特征密集关联模块和浅层特征映射模块,构建了全局去雾网络。此外,先验启发与深度网络的结合也得到了广泛研究[21], [55], [56],以生成更具泛化性的网络。

除上述学习范式外,一系列技术还致力于启发式设计网络架构[10], [11], [57], [58], [59], [60]。其中,[58]和[10]中的方法侧重于构建有效的注意力机制以提取雾相关特征信息,而[59]中的工作则强调建立双向归一化流模型;Li等人[61]提出了多尺度条件归一化流去雾网络,该工作利用对数似然计算来学习从雾天图像到无雾图像的条件分布;此外,Zheng等人[3]提出了一种新的课程对比正则化方法,Song等人[12]提出了基于注意力的多流反馈网络。毫无疑问,数据驱动的深度网络通过利用海量数据进行训练,极大地推动了图像去雾领域的发展。然而,当这些方法应用于训练分布之外的复杂雾天场景时,其去雾性能仍有较大提升空间。

与上述侧重于架构设计的方法不同,近年来,众多学者开始研究用于实现稳定泛化性能的学习策略[25], [62], [63], [64]。例如:Zheng等人[3]提出了新的课程对比正则化方法;Liu等人[65]设计了元学习去雾网络;Liang等人[25]提出了自监督自适应学习方法;Wu等人[66]提出了对比损失来监督去雾网络的训练;Yu等人[62]设计了无源无监督领域自适应去雾方法。这些方法都显著推动了单图像去雾领域的发展。

3 生成真实数据

真实雾天数据对难以获取,而基于学习的去雾方法通常需要大量配对数据用于训练和评估。因此,构建大规模合成数据[67], [68]是训练深度网络的基础要素,受到了广泛关注。

3.1 大气散射模型(ASM)的局限性

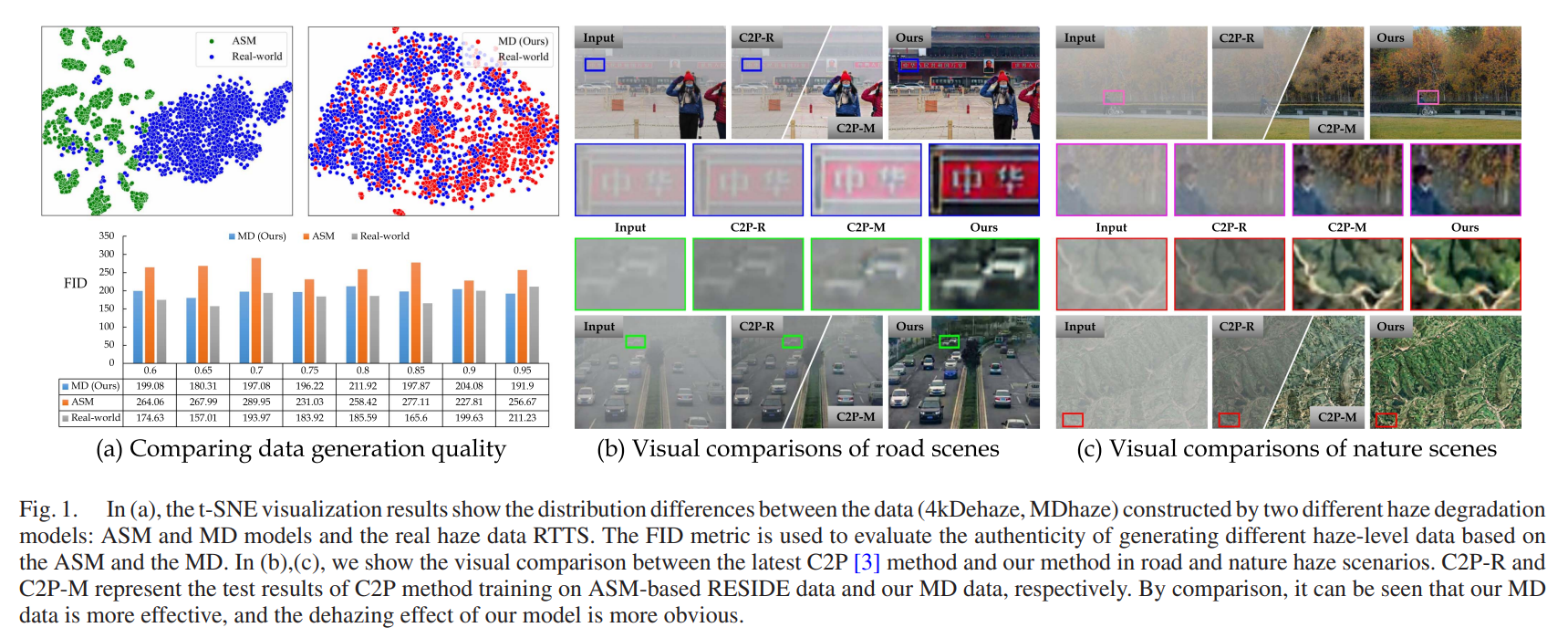

当前主流方法是通过大气光散射模型(ASM)合成配对雾天数据集。然而,经典ASM未考虑与场景深度和纹理密度相关的光捕获现象,导致去雾后图像出现昏暗效果。同时,基于ASM合成的雾天数据仅考虑影响图像退化的单一雾天因素,而真实雾天图像会受到多种退化因素的干扰,如噪声、模糊等。为说明ASM的缺陷,本文从真实世界中收集了四类不同的雾天图像,并采用两种在基于ASM合成的雾天数据RESIED-Out上训练的深度方法SGID [46]、DeHamer [47]进行去雾处理。这些雾天图像和去雾结果如图2所示。通过对比图2的第二行和第三行可以发现,在受多种混淆因素干扰的真实雾天场景中,这两种代表性方法的去雾结果偏暗,甚至包含噪声和模糊。

图2. 在存在不同混淆因素的真实雾天场景中,两种代表性方法的可视化结果对比。可见在基于ASM合成数据上训练的DeHamer [47]和SGID [46]方法无法有效去除雾及其他不利干扰,且去雾结果偏暗。放大区域用于突出显示差异。

3.2 含多重退化因素的雾天成像

基于上述发现,本文定义公式以清晰描述含多因素干扰的多重退化模型(MD):

I=∑F×(Aγ(Rtγ+1−tγ)+N),(1)I=\sum F × \left(A^{\gamma}(R t ^{\gamma}+1-t ^{\gamma})+N\right), (1)I=∑F×(Aγ(Rtγ+1−tγ)+N),(1)

其中,照明选择系数γ<1\gamma<1γ<1,Aγ<AA^{\gamma}<AAγ<A用于调整光照强度;ttt表示透射图;Rtγ+1−tγR t ^{\gamma}+1-t ^{\gamma}Rtγ+1−tγ用于调整生成雾天图像的雾浓度;N=γAγ−1(1+γ(R−1)t)γ−1εN=\gamma A^{\gamma-1}(1+\gamma(R-1) t)^{\gamma-1} \varepsilonN=γAγ−1(1+γ(R−1)t)γ−1ε用于模拟生成雾天图像中是否存在噪声;FFF表示滤波核,用于模拟是否存在模糊因素。推导过程详见补充材料。

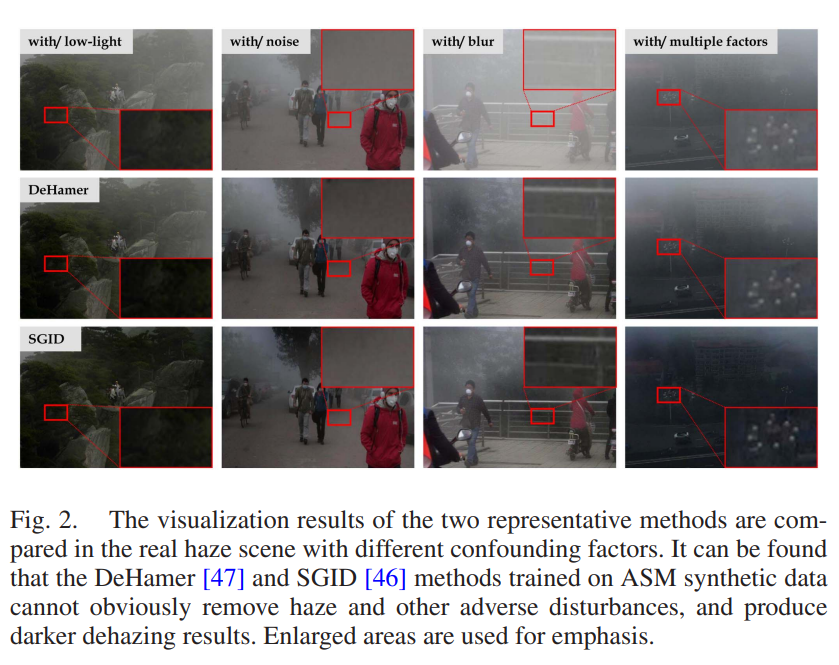

图4. 所提合成雾天图像(MDhaze)、现有合成雾天图像(4KDehaze、RESIDE-Out)与真实雾天图像(RTTS)的主观视觉结果对比。

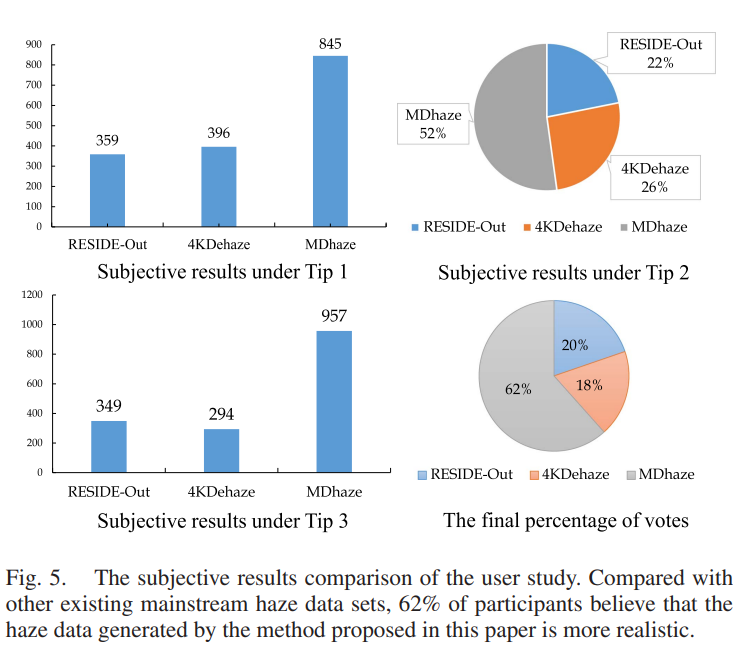

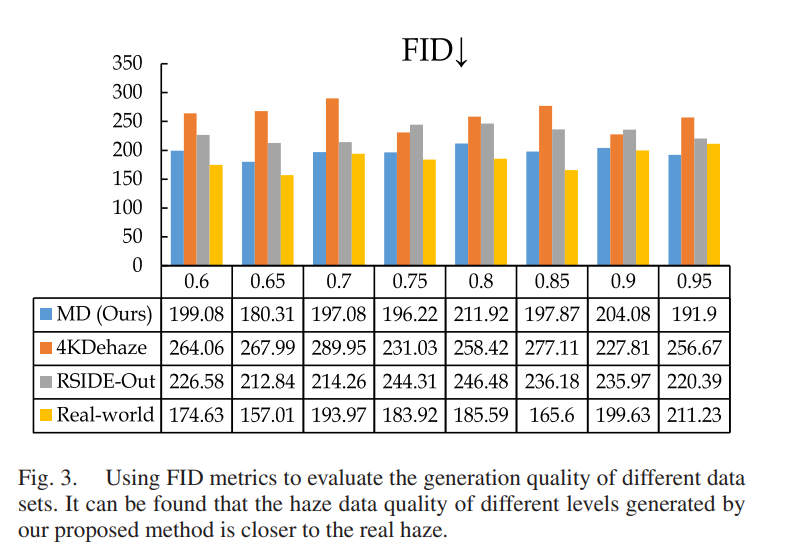

基于上述含多重退化因素的雾天成像模型(M1D),可轻松生成更逼真的配对雾天数据集(MDhaze)。为验证MD合成的雾天数据集(MDhaze)的真实性,本文首先展示了现有主流数据集(4KDehaze、RESIDE-Out)与所提MDhaze数据集之间的主观视觉对比结果和生成质量评估结果。如图4所示,在主观视觉上,本文提出的MDhaze数据更接近真实的RTTS雾天图像。此外,本文还通过用户研究对所提MDhaze与其他数据集进行主观评估:从RTTS、RESIDE-Out、4KDehaze和MDhaze数据集中随机选取40幅图像进行对比,邀请20名具有图像处理背景的专家和20名普通观察者作为志愿者。在用户研究开始前,向观察者提供三条评估提示:1)生成的雾是否浓密且与实际雾天场景相符;2)生成的雾是否符合真实雾天图像中的随机分布特征;3)能见度是否有所降低。随后,将图像分组展示给观察者,每组包含输入图像和不同方法的生成结果。本文统计了每种方法被选为最佳方法的百分比,最终得分如图5所示。此外,图3还提供了不同雾天数据集的图像生成质量(弗雷歇 inception 距离,FID)评估结果。与现有几种雾天数据集相比,本文提出的MDhaze数据集的生成质量更接近真实雾天数据。显然,上述构建的雾天退化模型(MD)可生成受多种退化因素干扰的数据,以模拟真实场景中的雾天情况。这些生成数据能有效减小与真实数据的分布差异¹,为后续在这些生成数据上训练的深度模型实现泛化能力提供了重要基础。

图5. 用户研究的主观结果对比。与现有主流雾天数据集相比,62%的参与者认为本文所提方法生成的雾天数据更真实。

图3. 采用FID指标评估不同数据集的生成质量。可见本文所提方法生成的不同浓度雾天数据质量更接近真实雾天。

¹ 实验支持请参见图1。

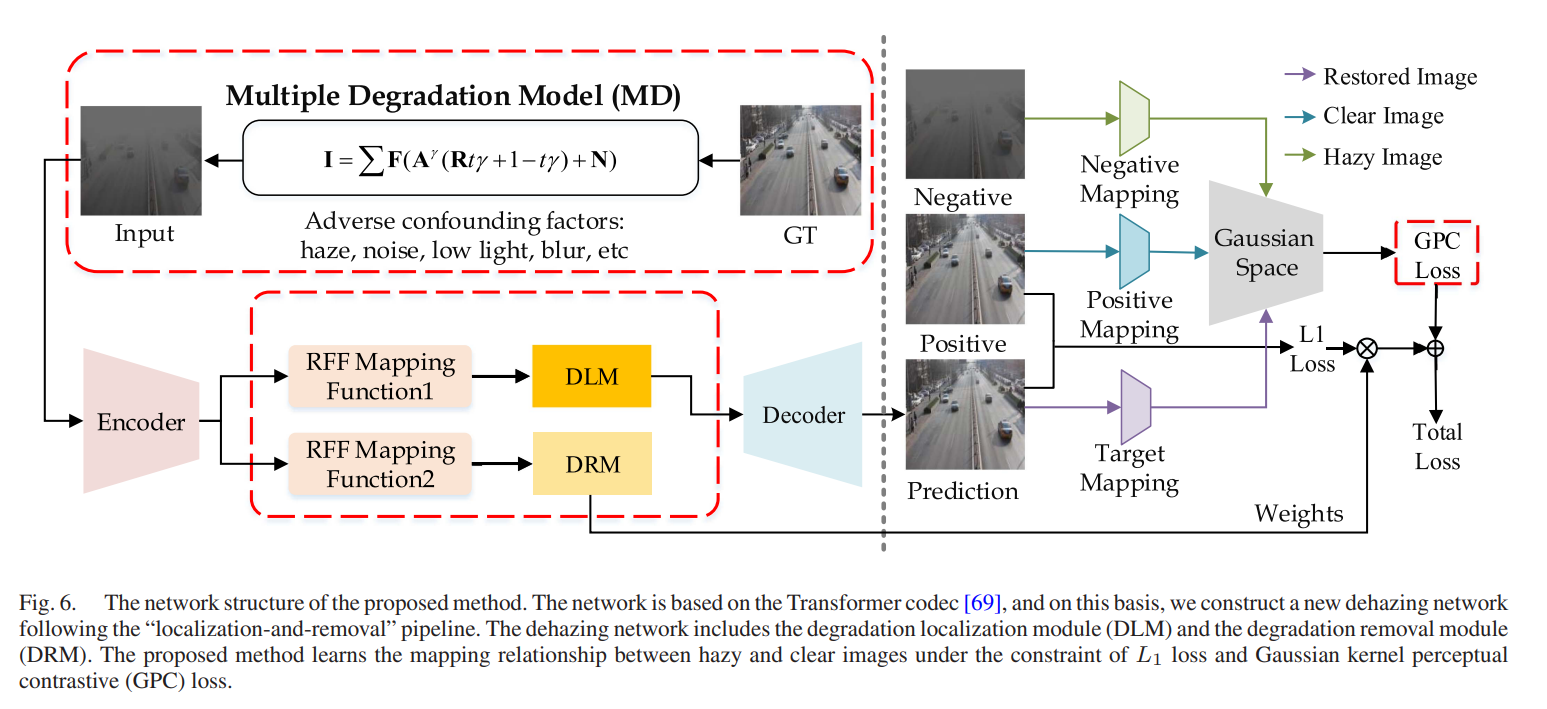

4 广义网络构建

由于多重退化因素作用的复杂性,尽管本文构建的雾天图像数据已显著缩小与真实数据的分布差距,但这些生成数据仍难以完全覆盖真实世界场景的复杂性。因此,本文设计了如下“定位-去除”流程,以进一步解决去雾问题。图6展示了所提网络模型的整体架构。下文将详细介绍所设计的网络模块和学习策略。

图6. 所提方法的网络结构。该网络基于Transformer编解码器[69],并在此基础上构建了遵循“定位-去除”流程的新型去雾网络。去雾网络包含退化定位模块(DLM)和退化去除模块(DRM)。所提方法在L1L_1L1损失和高斯核感知对比(GPC)损失的约束下,学习雾天图像与无雾图像之间的映射关系。

4.1 退化定位模块

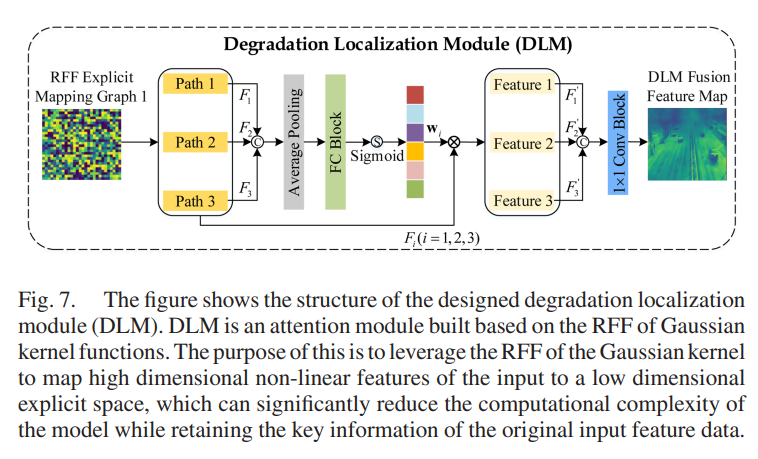

在真实雾天图像中,受风力、气压等外部环境变化的影响,不同区域可能被不同浓度的雾遮挡,导致网络难以捕捉具有判别性的雾相关特征和深度信息。因此,本文设计的去雾方法以嵌入高斯核随机傅里叶特征为基础,退化定位模块(DLM)的设计目的是作为提取器,帮助网络捕捉区域可识别的雾相关特征信息——这是有效去除真实雾并保留图像细微纹理信息的关键。近期研究表明,利用再生核希尔伯特空间的几何结构设计非线性嵌入[26], [70],有助于获得更丰富的模型。这启发本文采用再生核希尔伯特空间理论设计非线性嵌入。据本文所知,基于高斯核函数的随机傅里叶特征(RFF)设计非线性嵌入的方法尚未在现有去雾任务中出现。因此,本文提出退化定位模块(DLM),它是一种针对雾天图像设计的并行多尺度注意力结构。

图7. 所设计的退化定位模块(DLM)结构示意图。DLM是基于高斯核函数随机傅里叶特征(RFF)构建的注意力模块,其目的是利用高斯核的随机傅里叶特征将输入的高维非线性特征映射到低维显式空间,在保留原始输入特征数据关键信息的同时,显著降低模型的计算复杂度。

如图7所示,DLM首先利用随机傅里叶特征对输入特征图中的高阶非线性信息进行低维显式表示,然后将随机傅里叶特征输入三个设计的并行路径分支,以生成注意力图。具体而言,在DLM中,将从编码模块得到的输入特征y∈Rh×w×cy \in \mathbb{R}^{h ×w ×c}y∈Rh×w×c用于估计每个通道上的给定高斯核GyG_{y}Gy,满足:

Gy=exp(−(yi−yj)T(yi−yj)2σ2)≈z(yi)Tz(yj),(2)G_{y}=exp \left(-\frac{\left(y_{i}-y_{j}\right)^{T}\left(y_{i}-y_{j}\right)}{2 \sigma^{2}}\right) \approx z\left(y_{i}\right)^{T} z\left(y_{j}\right), (2)Gy=exp(−2σ2(yi−yj)T(yi−yj))≈z(yi)Tz(yj),(2)

其中z(y)z(y)z(y)是低维显式映射函数,也可表示为以下形式:

z(y)=λ(cos(sdTy+bd))D,z(y)=\lambda\left(cos \left(s_{d}^{T} y+b_{d}\right)\right)^{D},z(y)=λ(cos(sdTy+bd))D,

式中λ=2D\lambda=\sqrt{\frac{2}{D}}λ=D2,偏置参数bdb_dbd服从均匀分布U[0,2π]U[0, 2\pi]U[0,2π];权重(即sds_{d}sd,i=1,...,Di=1, ..., Di=1,...,D)从高斯核的缩放傅里叶变换中采样得到[71],即从以下分布中采样:

p(sd)=(2π)−D/2exp(−∥s∥22).p\left(s_{d}\right)=(2 \pi)^{-D / 2} exp \left(-\frac{\| s\| ^{2}}{2}\right) .p(sd)=(2π)−D/2exp(−2∥s∥2).

上述过程可概括为随机傅里叶特征(RFF)映射函数。基于估计得到的z(y)z(y)z(y),本文设计了以下具有判别性的雾相关特征提取结构。

注1:此处简要分析RFF映射函数如何为输入特征y∈Rh×w×cy \in \mathbb{R}^{h ×w ×c}y∈Rh×w×c赋予高斯核的判别能力。对于任意两个随机特征向量y‾i\overline{y}_{i}yi、y‾j\overline{y}_{j}yj,根据博赫纳定理(Bochner’s theorem)[71],可通过以下公式计算两者的相似度匹配度:

E[y‾iTy‾j]=E[z(yi)Tz(yj)]=∑dλcos(sdTyi+bd)⋅λcos(sdTyj+bd),=E[exp(isT(yi−yj))]=E[cos(sT(yi−yj))],=∫Rdp(s)exp(isT(yi−yj))ds=Gy.\begin{aligned} \mathbb{E}\left[\overline{y}_{i}^{T} \overline{y}_{j}\right] & =\mathbb{E}\left[z\left(y_{i}\right)^{T} z\left(y_{j}\right)\right] \\ & =\sum_{d} \lambda cos \left(s_{d}^{T} y_{i}+b_{d}\right) \cdot \lambda cos \left(s_{d}^{T} y_{j}+b_{d}\right), \\ & =\mathbb{E}\left[exp \left(i s^{T}\left(y_{i}-y_{j}\right)\right)\right]=\mathbb{E}\left[cos \left(s^{T}\left(y_{i}-y_{j}\right)\right)\right], \\ & =\int_{\mathbb{R}^{d}} p(s) exp \left(i s^{T}\left(y_{i}-y_{j}\right)\right) d_{s}=G_{y} . \end{aligned} E[yiTyj]=E[z(yi)Tz(yj)]=d∑λcos(sdTyi+bd)⋅λcos(sdTyj+bd),=E[exp(isT(yi−yj))]=E[cos(sT(yi−yj))],=∫Rdp(s)exp(isT(yi−yj))ds=Gy.

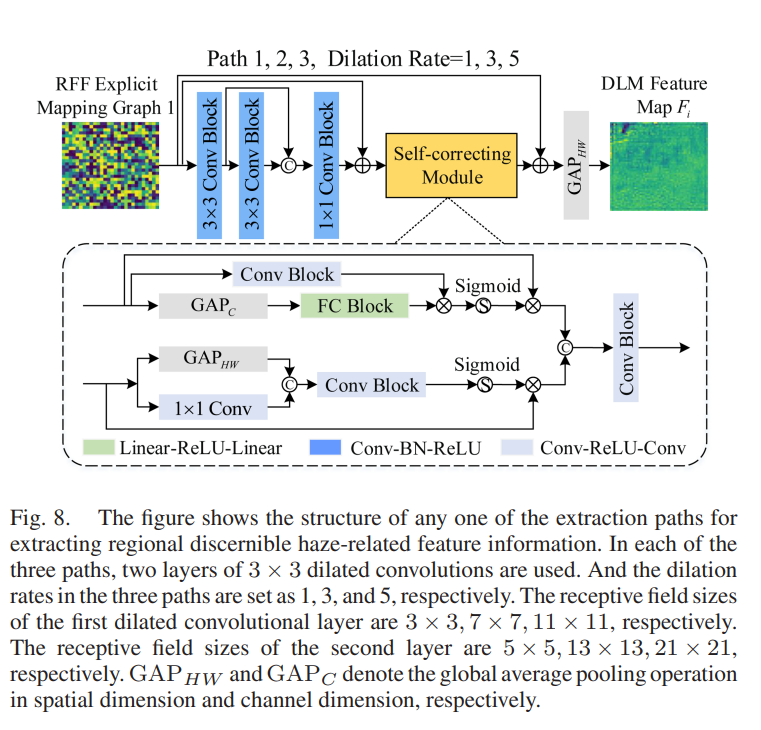

获取随机傅里叶特征z(y)z(y)z(y)后,本文构建了并行多尺度注意力结构。该结构包含三条并行路径,分别用于捕捉图像不同区域中不同雾浓度和深度对应的判别性雾相关特征信息。这三条路径基于空洞卷积构建,能够在保持图像分辨率、减少参数数量的同时,从不同尺寸的感受野中提取特征。如图8所示,通过这三条特征提取路径,可在六种不同尺寸的感受野下充分提取多尺度特征,以捕捉不同浓度和深度的雾相关特征信息。然而,考虑到通过上述操作得到的雾相关特征信息仍来自局部区域,因此在每条提取路径中,本文还引入了自校正模块,分别在输入特征的通道方向和空间方向上建模全局与局部特征之间的相互依赖关系。

图8. 用于提取区域可识别雾相关特征信息的任意一条提取路径结构示意图。在三条路径中,每条路径均采用两层3×3空洞卷积,且三条路径的空洞率分别设置为1、3、5。第一层空洞卷积的感受野尺寸分别为3×3、7×7、11×11,第二层的感受野尺寸分别为5×5、13×13、21×21。GAPHWGAP_{HW}GAPHW和GAPCGAP_CGAPC分别表示在空间维度和通道维度上的全局平均池化操作。

在从三条特征提取路径获取多尺度特征的基础上,本文采用加权求和的方式对这些特征进行融合,以进一步得到区域可识别的雾相关特征信息。与许多去雾方法直接对特征进行简单拼接操作不同,本文方法具有以下优势:1)学习权重可帮助DLM自适应调整从三条并行路径提取的特征信息的重要性,有利于增强网络对不同浓度和深度雾的判别学习能力;2)直接拼接操作会使特征通道数呈指数级增长,而加权求和操作可保持原始通道数不变,且不增加计算量。融合过程可通过以下公式(6)和(7)描述:

{Fi=1c∑k=1cF‾ik,i=1,2,3,F‾a=1hw∑u=1h∑v=1wConcat[F1,F2,F3](u,v).(6)\left\{ \begin{array}{l} F_{i}=\frac{1}{c} \sum_{k=1}^{c} \overline{F}_{i}^{k}, i=1,2,3, \\ \overline{F}_{a}=\frac{1}{h w} \sum_{u=1}^{h} \sum_{v=1}^{w} Concat\left[F_{1}, F_{2}, F_{3}\right](u, v) . \end{array} \right. (6) {Fi=c1∑k=1cFik,i=1,2,3,Fa=hw1∑u=1h∑v=1wConcat[F1,F2,F3](u,v).(6)

通过在通道方向上对三条路径得到的特征进行全局平均池化拼接后,可通过以下公式得到融合特征:

{w=Sigmoid(FC(F‾a)),y‾DLM=gc(∑i=13(F‾ik⊗wik)),i=1,2,3,(7)\left\{ \begin{array}{l} w=Sigmoid\left(FC\left(\overline{F}_{a}\right)\right), \\ \overline{y}_{DLM}=g_{c}\left(\sum_{i=1}^{3}\left(\overline{F}_{i}^{k} \otimes w_{i}^{k}\right)\right), i=1,2,3, \end{array} \right. (7) {w=Sigmoid(FC(Fa)),yDLM=gc(∑i=13(Fik⊗wik)),i=1,2,3,(7)

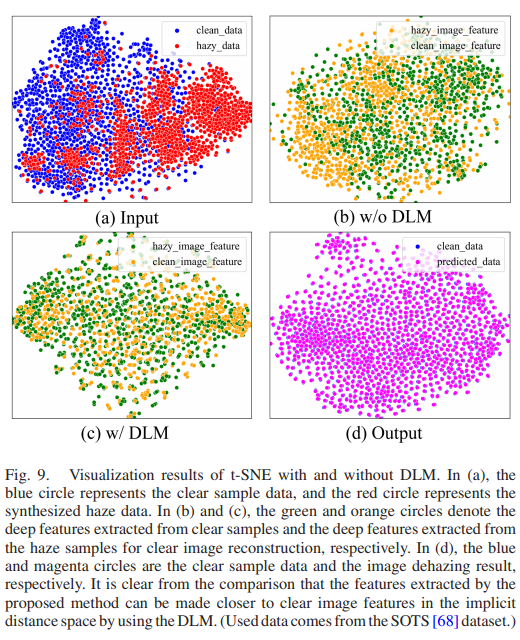

其中gcg_{c}gc表示1×1卷积层;wki∈Rh×w×cw_{k}^{i} \in \mathbb{R}^{h ×w ×c}wki∈Rh×w×c是由权重www的第iii个通道的值wiw^{i}wi扩展形成的矩阵;y‾DLM\overline{y}_{DLM}yDLM表示DLM最终提取的特征。DLM的有效性如图9所示,通过对比可见,利用DLM可使所提方法提取的特征在隐距离空间中更接近无雾图像特征(所用数据来自SOTS[68]数据集)。

图9. 含DLM与不含DLM的t-SNE可视化结果。(a)中蓝色圆圈表示清晰样本数据,红色圆圈表示合成雾天数据;(b)和(c)中绿色圆圈和橙色圆圈分别表示从清晰样本提取的深层特征和从用于重建清晰图像的雾天样本提取的深层特征;(d)中蓝色圆圈和品红色圆圈分别表示清晰样本数据和图像去雾结果。

4.2 退化去除模块

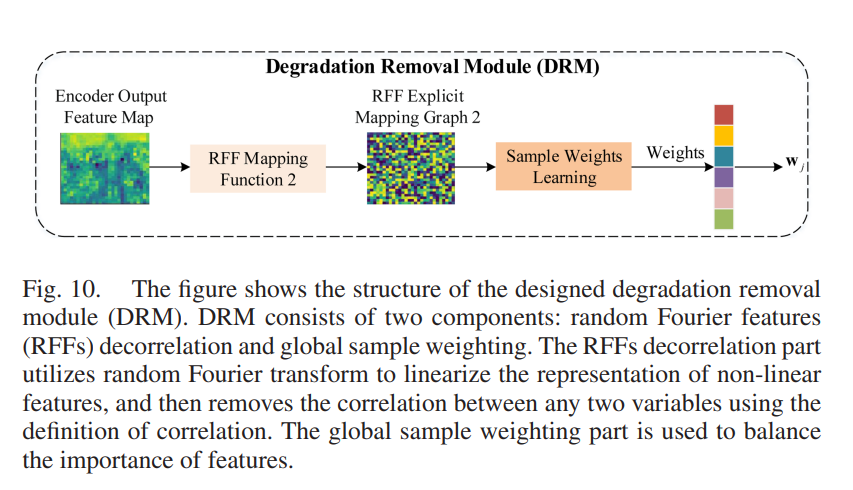

相关研究[26], [28]表明,特征间的细微相关性是模型泛化性能下降的主要原因。在复杂的真实雾天环境中,深度网络提取的特征可能包含不利的混淆特征(如弱光、噪声等),这些混淆特征会与本质特征产生细微的统计相关性,干扰深度网络的分析能力,导致意外的预测结果。因此,要使去雾网络获得稳定的泛化性能,尽可能消除神经网络从数据中学习到的本质特征与混淆特征之间的依赖关系,是一种重要的解决方案。本文从特征相关性的定义出发,利用统计相关性定义构建解相关双层优化目标。如图10所示,本文构建了退化去除模块(DRM),该模块由两部分组成:随机傅里叶特征(RFF)解相关和全局样本加权。其中,随机傅里叶特征解相关部分利用随机傅里叶变换对非线性特征的表示进行线性化,然后通过相关性定义去除任意两个变量之间的相关性;全局样本加权部分用于平衡特征的重要性,它将表示空间中每个学习到的特征视为一个处理变量,通过样本的训练权重平衡源数据在每个学习到的特征表示中的分布,从而学习一个新的数据领域——在该领域中,仅有与图像去雾任务相关的本质特征是有效的。

图10. 所设计的退化去除模块(DRM)结构示意图。DRM由两部分组成:随机傅里叶特征(RFF)解相关和全局样本加权。随机傅里叶特征解相关部分利用随机傅里叶变换对非线性特征的表示进行线性化,然后通过相关性定义去除任意两个变量之间的相关性;全局样本加权部分用于平衡特征的重要性。

给定自然雾天图像xxx,设网络中最后一个编码模块得到的训练样本特征集为YYY。若使特征集YYY中任意一对特征y:,iy_{:,i}y:,i、y:,jy_{:,j}y:,j互不相关,根据希尔伯特-施密特独立性准则(HSIC)[72],则y:,iy_{:,i}y:,i与y:,jy_{:,j}y:,j之间的互协方差需满足Cov(y:,i,y:,j)=0Cov(y_{:,i}, y_{:,j})=0Cov(y:,i,y:,j)=0。然而,考虑到在整个训练数据集上进行HSIC操作的计算开销巨大,本文将欧氏空间的希尔伯特-施密特范数转换为弗罗贝尼乌斯范数(Frobenius norm)来求解。y:,iy_{:,i}y:,i与y:,jy_{:,j}y:,j之间的互协方差可重写为:

Cov=η∑u=1n[(h((y:,i)u)−1n∑v=1nh((y:,j)v))T⋅(f((y:,i)u)−1n∑v=1nf((y:,j)v))],(8)\begin{aligned} Cov&=\eta \sum_{u=1}^{n}\left[ \left(h\left(\left(y_{:, i}\right)_{u}\right)-\frac{1}{n} \sum_{v=1}^{n} h\left(\left(y_{:, j}\right)_{v}\right)\right)^{T} \cdot \right. \\ &\quad\quad\left. \left(f\left(\left(y_{:, i}\right)_{u}\right)-\frac{1}{n} \sum_{v=1}^{n} f\left(\left(y_{:, j}\right)_{v}\right)\right)\right], \quad(8) \end{aligned} Cov=ηu=1∑n(h((y:,i)u)−n1v=1∑nh((y:,j)v))T⋅(f((y:,i)u)−n1v=1∑nf((y:,j)v))],(8)

其中η=1n−1\eta=\frac{1}{n-1}η=n−11,h(y:,i)=(h1(y:,i),h2(y:,i),...,hn(y:,i))h(y_{:,i})=(h_{1}(y_{:,i}), h_{2}(y_{:,i}), ..., h_{n}(y_{:,i}))h(y:,i)=(h1(y:,i),h2(y:,i),...,hn(y:,i)),f(y:,j)=(f1(y:,j),f2(y:,j),...,fn(y:,j))f(y_{:,j})=(f_{1}(y_{:,j}), f_{2}(y_{:,j}), ..., f_{n}(y_{:,j}))f(y:,j)=(f1(y:,j),f2(y:,j),...,fn(y:,j));对于任意nnn,hn(⋅)h_{n}(\cdot)hn(⋅)和fn(⋅)f_{n}(\cdot)fn(⋅)分别从随机傅里叶特征函数空间中采样得到。根据HSIC准则,当成对特征y:,iy_{:,i}y:,i、y:,jy_{:,j}y:,j的互协方差矩阵CovCovCov减小至0时,y:,iy_{:,i}y:,i与y:,jy_{:,j}y:,j相互独立。

相关研究表明[26],在表示空间中,利用训练样本的学习权重平衡用于表示源数据分布的特征,可去除特征间的虚假相关性,得到有用特征与真实特征之间的本质关系。受此启发,本文通过学习训练样本的权重,去除特征空间中无雾背景特征与雾特征之间的依赖关系,并通过最小化成对特征的互协方差使它们相互独立。用w^\widehat{w}w表示样本权重,且满足∑1nw^i=n\sum_{1}^{n} \widehat{w}_{i}=n∑1nwi=n。对于任意成对特征y:,iy_{:,i}y:,i、y:,jy_{:,j}y:,j,加权互协方差矩阵CwC_{w}Cw可通过以下公式计算:

Cw=η∑u=1n[(hu−1n∑v=1nhv)T⋅(fu−1n∑v=1nfv)],(9)C_{w}=\eta \sum_{u=1}^{n}\left[\left(h_{u}-\frac{1}{n} \sum_{v=1}^{n} h_{v}\right)^{T} \cdot\left(f_{u}-\frac{1}{n} \sum_{v=1}^{n} f_{v}\right)\right], (9) Cw=ηu=1∑n(hu−n1v=1∑nhv)T⋅(fu−n1v=1∑nfv),(9)

其中huh_{u}hu、hvh_{v}hv分别表示为hu=w^ih((y:,i)u)h_{u}=\widehat{w}_{i} h((y_{:,i})_{u})hu=wih((y:,i)u)、hv=w^jh((y:,j)v)h_{v}=\widehat{w}_{j} h((y_{:,j})_{v})hv=wjh((y:,j)v);fuf_{u}fu、fvf_{v}fv分别表示为fu=w^if((y:,i)u)f_{u}=\widehat{w}_{i} f((y_{:,i})_{u})fu=wif((y:,i)u)、fv=w^jf((y:,j)v)f_{v}=\widehat{w}_{j} f((y_{:,j})_{v})fv=wjf((y:,j)v)。此外,通过以下公式优化w^\widehat{w}w:

w^∗=argminw^∑1≤i<j≤c∥Cw∥F2,\hat{w}^{*}=\underset{\hat{w}}{arg min } \sum_{1 \leq i<j \leq c}\left\| C_{w}\right\| _{F}^{2}, w^∗=w^argmin1≤i<j≤c∑∥Cw∥F2,

其中w^≥0\widehat{w}\geq0w≥0且∑i=1nw^i=n\sum_{i=1}^{n}\widehat{w}_{i}=n∑i=1nwi=n。最后,利用优化后的权重w^\widehat{w}w对训练样本进行加权,并通过以下自适应损失引导网络训练:

Lossa=min1n∑i=1nw^i(t)∥φ(xi)−Ji∥,(11)\mathcal{L}_{oss_{a}}=min \frac{1}{n} \sum_{i=1}^{n} \hat{w}_{i}^{(t)}\left\| \varphi\left(x_{i}\right)-J_{i}\right\| , \quad(11) Lossa=minn1i=1∑nw^i(t)∥φ(xi)−Ji∥,(11)

同时满足:

w^(t+1)=argminw^∑1≤i≤j≤c∥Cov(y:,i(t+1),y:,j(t+1))∥F2.(12)\hat{w}^{(t+1)}=\underset{\hat{w}}{arg min } \sum_{1 \leq i \leq j \leq c}\left\| Cov\left(y_{:, i}^{(t+1)}, y_{:, j}^{(t+1)}\right)\right\| _{F}^{2} . (12) w^(t+1)=w^argmin1≤i≤j≤c∑Cov(y:,i(t+1),y:,j(t+1))F2.(12)

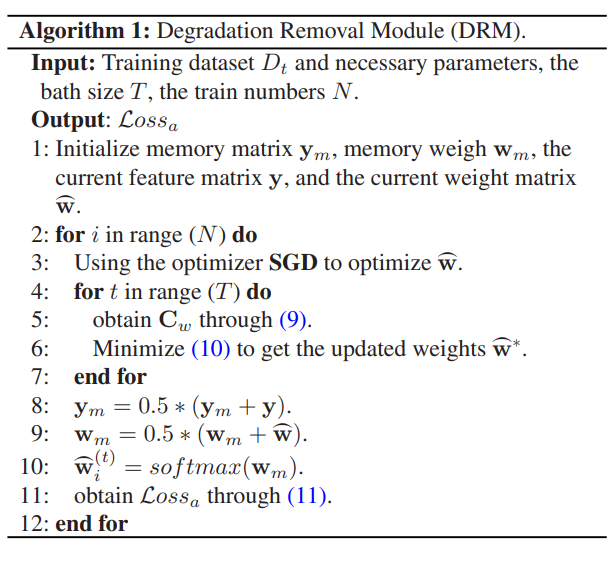

其中ttt表示每个批次的时间戳,φ(⋅)\varphi(\cdot)φ(⋅)表示所提模型(模型骨干基于Transweather[69]),JiJ_iJi表示对应的无雾标签值;初始权重值w^(0)=1\widehat{w}^{(0)}=1w(0)=1,且在公式(12)中,样本权重参数w^\widehat{w}w通过迭代优化更新。退化去除模块的训练过程如算法1所示。

算法1:退化去除模块(DRM)

输入:训练数据集DtD_tDt及必要参数、当前特征矩阵yyy、当前权重矩阵w^\widehat{w}w

输出:自适应损失Lossa\mathcal{L}_{oss_{a}}Lossa

- 初始化记忆矩阵ymy_mym、记忆权重wmw_mwm、批次大小TTT、训练轮次NNN;

- 对于iii从1到NNN:

- 采用SGD优化器优化w^\widehat{w}w;

- 对于ttt从1到TTT:

通过公式(9)计算CwC_wCw;

最小化公式(10)以得到更新后的权重w^∗\widehat{w}^*w∗; - 结束内层循环;

- ym=0.5×(ym+y)y_m = 0.5 \times (y_m + y)ym=0.5×(ym+y);

- wm=0.5×(wm+w^)w_m = 0.5 \times (w_m + \widehat{w})wm=0.5×(wm+w);

- w^i(t)=softmax(wm)\widehat{w}^{(t)}_i = softmax(w_m)wi(t)=softmax(wm);

- 通过公式(11)计算Lossa\mathcal{L}_{oss_{a}}Lossa;

- 结束外层循环;

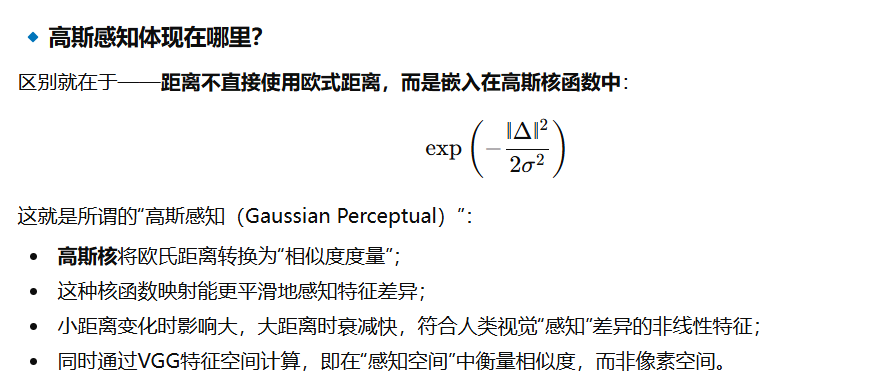

4.3 高斯感知对比损失

受对比学习思想[66], [73], [74]的启发,对比学习旨在学习一种表示形式,使得在特定度量准则下,正样本对的距离更近,负样本对的距离更远。为获得更自然的去雾效果,本文提出高斯感知对比损失函数(GPC),以约束网络恢复的无雾图像更接近清晰图像、远离雾天图像。

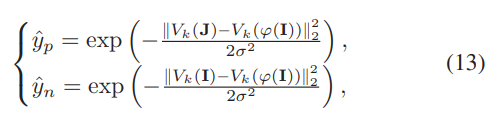

为简化表述,将所提方法恢复的图像定义为J^\hat{J}J^,则对应的正样本对由恢复图像J^\hat{J}J^与清晰图像JJJ组成,负样本对由J^\hat{J}J^与雾天图像III组成。由此,目标函数可描述为:

其中VkV_{k}Vk表示从预训练的VGG-19模型[75]中提取的第kkk层隐藏层特征,σ\sigmaσ表示控制参数,φ(⋅)\varphi(\cdot)φ(⋅)表示所提模型。进一步,GPC损失可定义为:

Lg=α∑k=1Kθk⋅y^py^n,k=1,2,...,K,\mathcal{L}_{g}=\alpha \sum_{k=1}^{K} \theta_{k} \cdot \frac{\hat{y}_{p}}{\hat{y}_{n}}, \quad k=1,2, ..., K, Lg=αk=1∑Kθk⋅y^ny^p,k=1,2,...,K,

式中α\alphaα为惩罚参数,y^p\hat{y}_{p}y^p和y^n\hat{y}_{n}y^n分别表示度量空间中正样本对和负样本对的距离,θk\theta_{k}θk表示权重系数。

基于上述分析,所采用的总损失可总结为:

Ltotal=Loss+Lg,(15)\mathcal{L}_{total }=\mathcal{L}_{oss }+\mathcal{L}_{g}, \quad(15) Ltotal=Loss+Lg,(15)

其中Loss\mathcal{L}_{oss}Loss(此处指基础损失,如L1L_1L1损失)与Lg\mathcal{L}_{g}Lg共同约束网络向去雾彻底性和视觉友好性的方向更新。

4.4 讨论

在退化定位模块(DLM)中,本文采用随机傅里叶特征(RFF)对原始输入的高阶非线性特征信息进行显式映射,以生成注意力图。采用RFF的核心启发在于,这些特征可借助高维特征空间的高分辨率能力,帮助定位模块聚焦于更具判别性的雾区。

退化去除模块(DRM)的核心思想实际上是引入全局特征解相关策略以辅助网络训练,而非用于测试阶段。高斯感知对比损失(GPC)则在高斯加权欧氏距离空间中缩小预测样本与目标样本之间的距离。事实上,本文设计的与任务相关的DLM、DRM及GPC损失可迁移至其他有监督去雾模型中,以提升其去雾性能。

5 实验

本节将介绍实验的实现细节,包括所用的训练与测试数据集、训练设置、评估指标及对比方法;随后通过大量实验分析验证所提方法的有效性。

5.1 基准数据集说明

5.1.1 合成数据集

Li等人[68]提出了一个图像去雾参考数据集,包含室内外合成场景与自然场景的雾天-清晰图像对。本文使用该数据集室内训练集中的13,990幅雾天图像进行训练,并使用合成对比测试集(SOTS)中的500幅室内外图像进行测试。

考虑到真实场景中雾天图像的退化受多种混淆因素影响,而现有基于大气散射模型(ASM)的合成数据仅考虑雾天图像退化的单一因素,导致在这些雾天数据上训练的模型难以适应复杂的真实雾天场景。因此,本文基于上述构建的雾天退化模型(MD),生成了新的雾天数据集MDhaze。其构建过程可通过以下公式描述:

I=∑F×(Aγ(Rtγ+1−tγ)+N),(16)I=\sum F \times\left(A^{\gamma}(R t ^{\gamma}+1-t ^{\gamma})+N\right), \quad(16) I=∑F×(Aγ(Rtγ+1−tγ)+N),(16)

其中III表示待合成的雾天图像;γ\gammaγ为用于调整生成雾天图像亮度的照明选择系数,在区间[0.2,0.8][0.2,0.8][0.2,0.8]内均匀采样;大气光值AAA在区间[0.75,0.9][0.75,0.9][0.75,0.9]内均匀选取;ttt表示场景透射图,RRR表示反射图像;N=γAγ−1(1+γ(R−1)t(x))γ−1εN=\gamma A^{\gamma-1}(1+\gamma(R-1) t(x))^{\gamma-1} \varepsilonN=γAγ−1(1+γ(R−1)t(x))γ−1ε表示噪声项,服从均值为0、方差在[0.0001,5][0.0001,5][0.0001,5]区间内的正态分布;F(⋅)F(\cdot)F(⋅)表示模糊核。由该公式可见,其合成的数据可模拟真实雾天图像退化模型中的多种混淆因素,如雾、弱光、噪声、模糊等。

5.1.2 真实数据集

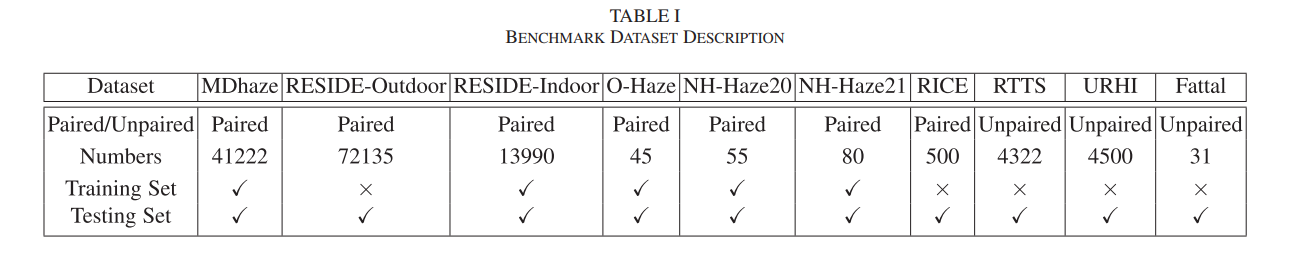

为充分验证所提方法的有效性与鲁棒性,本文还在真实雾天数据集URHI和RTTS[68]上分别选取了4,500幅和4,322幅雾天图像;同时,从Fattal[76]数据集和RICE²遥感数据集中分别选取了31幅自然雾天图像和500幅遥感雾天图像用于评估。此外,本文还在O-Haze[77]、NH-Haze20[78]和NH-Haze21[77]数据集上分别进行了训练与测试。为保证公平性,上述三个数据集的训练与测试均遵循NTIRE去雾挑战赛规则。本文所用的训练与测试数据集详情如表1所示。

表1 基准数据集说明

5.2 训练设置

本文在RGB通道上训练所提网络,并通过90°、180°、270°随机旋转和水平翻转对训练数据集进行增强。实验中,所有图像的尺寸固定为256×256。整个网络在RESIDE数据集、MDhaze数据集、O-Haze、NH-Haze20和NH-Haze21数据集上进行训练(其中在RESIDE和MDhaze数据集上训练200轮,在其他数据集上训练3000轮)。此外,优化过程采用Adam优化器,其中β1\beta_1β1和β2\beta_2β2使用默认值0.9和0.999;初始学习率设置为1×10−41×10^{-4}1×10−4,并采用余弦退火策略,使学习率根据余弦函数从初始值降至0。

本文在预训练VGG-19模型的第13层、第9层、第5层、第3层和第1层的隐特征后设置公式(15)中的GPC损失,其对应的权重系数θk\theta_kθk(k=5,4,...,1k=5,4,...,1k=5,4,...,1)分别设为1、14\frac{1}{4}41、18\frac{1}{8}81、116\frac{1}{16}161、132\frac{1}{32}321。模型训练基于Windows系统,使用PyTorch 1.7.0框架和NVIDIA GeForce GTX 3090 GPU。

为验证所提方法的有效性,本文采用多种权威评估指标:在合成数据集评估中,使用峰值信噪比(PSNR)、结构相似性指数(SSIM)和感知图像块相似度(LPIPS);在真实数据集评估中,还使用多种无参考/全参考数值指标,如BIQME[84](增强图像盲评价方法)、FADE[85](雾浓度评估指标)、PIQE³(基于感知的图像质量评估指标)、Brisque[86](基于自然图像统计特征的质量评估指标)、模糊感知度⁴(无参考感知模糊指标)、熵⁵(图像熵评估指标)。

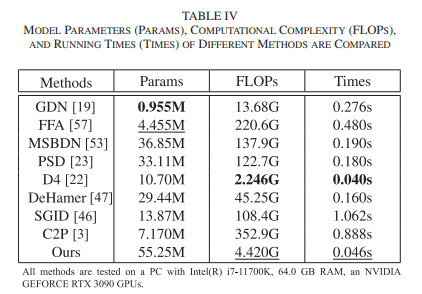

为充分评估所提方法的泛化能力,本文将其与现有最先进的去雾方法进行定性与定量对比。所选方法包括:基于先验的方法(IDE[5]、IDRLP[7])、有监督浅层去雾网络(GCA[79]、GDN[19]、FFA[57])、有监督深度去雾方法(MSBDN[53]、DFlow[61]、DeHamer[47]、SGID[46]、C2P[3]、RIDCP[21])以及半监督/无监督方法(DAD[20]、D4[22]、PSD[23])。此外,还将所提方法与最先进的多天气退化恢复方法进行定性与定量对比,所选方法包括:AirNet[80]、Transweather[69]、TOENet[81]、MIR[82]、ROP+[83]、WeatherDiff[1]。

² RICE遥感数据来源:https://arxiv.org/abs/1901.00600

³ PIQE指标详见:https://ieeexplore.ieee.org/document/7084843/

⁴ 模糊感知度指标详见:https://spie.org/Publications/Proceedings/Paper/

⁵ 熵指标详见:http://www.joca.cn/EN/10.11772/

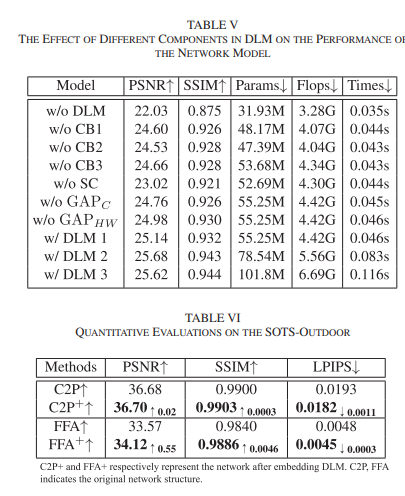

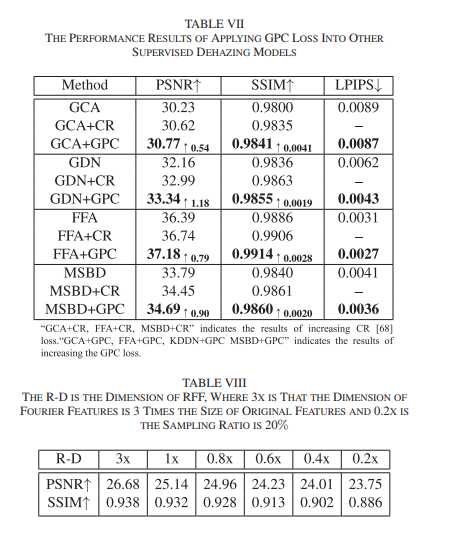

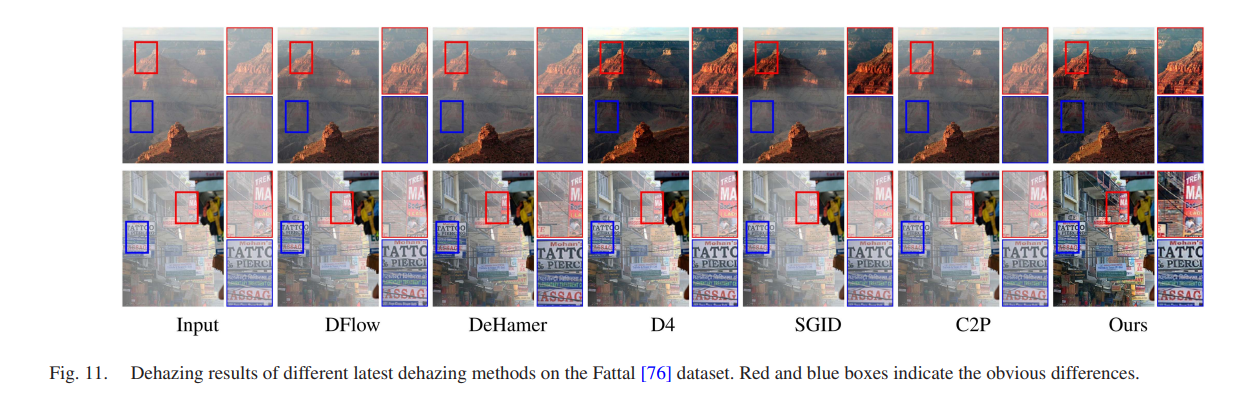

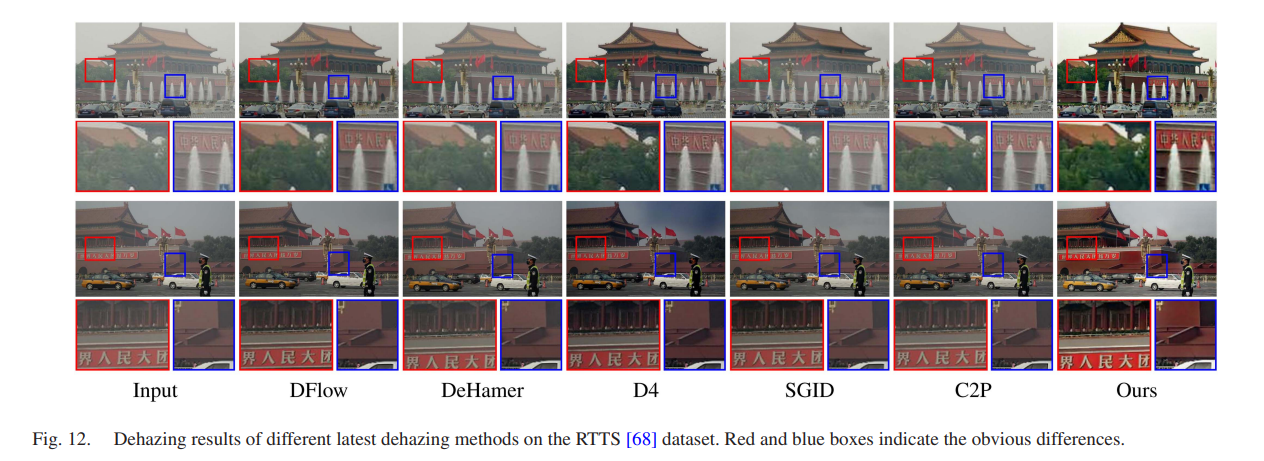

5.3 标准基准数据集评估

首先,在Fattal[76]数据集和RTTS[68]数据集上对所提方法进行评估。图11和图12展示了多种最先进去雾方法在真实雾天图像上的去雾效果:可以发现,DFlow、DeHamer、C2P等深度去雾方法无法显著去除图像中的雾;D4和SGID这两种真实图像去雾方法虽能去除图像局部区域的雾,但整体去雾效果欠佳。与这些最先进的去雾方法相比,所提方法在去雾程度、图像清晰度及纹理细节保留方面表现更优。

图11. 不同最新去雾方法在Fattal[76]数据集上的去雾结果。红色和蓝色方框标记出明显差异。

图12. 不同最新去雾方法在RTTS[68]数据集上的去雾结果。红色和蓝色方框标记出明显差异。

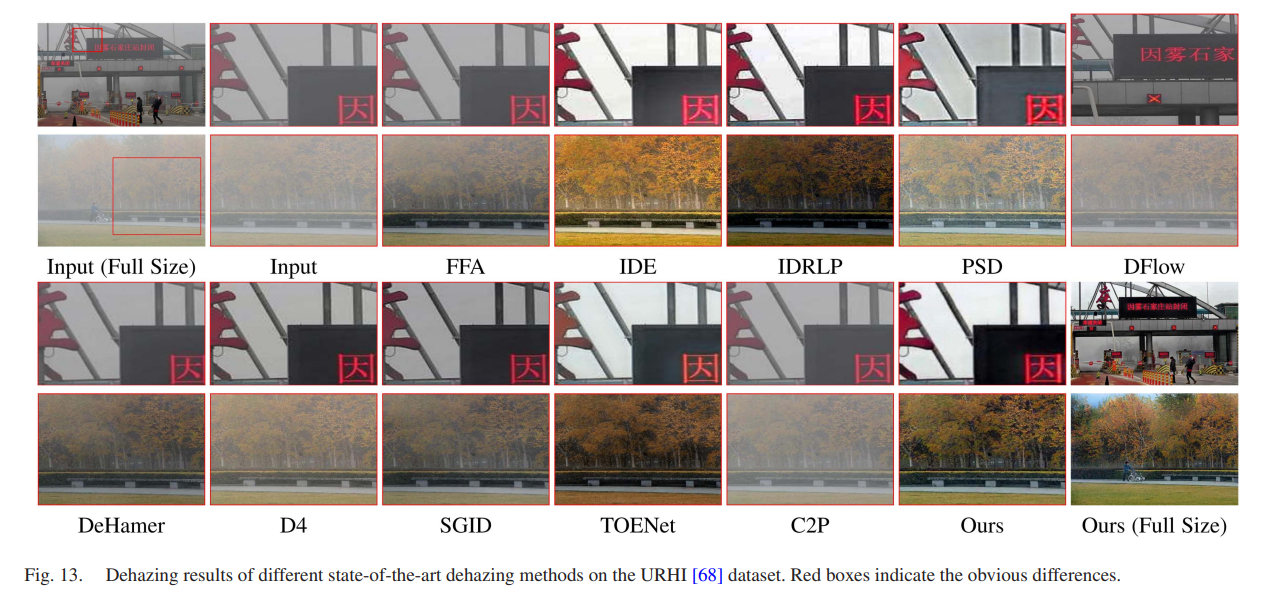

其次,为充分验证所提方法在不同雾天场景中的适应性,本文还在URHI[68]数据集上开展测试。URHI是一个包含多种复杂雾天场景的大型数据集,常被用于评估各类去雾方法的适用性。图13展示了11种最先进去雾方法在真实自然雾天图像上的去雾效果:基于先验信息的IDE和IDRLP方法虽能提升图像整体亮度,但去雾程度有限,且去雾后图像存在颜色偏移;受物理先验引导的深度真实去雾网络PSD和D4仍无法有效去除浓雾;TOENet、DFlow、DeHamer、SGID、C2P等在合成数据集上表现良好的深度学习方法,其去雾结果仍残留较多雾。与之相比,所提方法实现了显著的去雾效果,去雾后的图像不仅保留了更多细节信息,视觉效果也更自然。

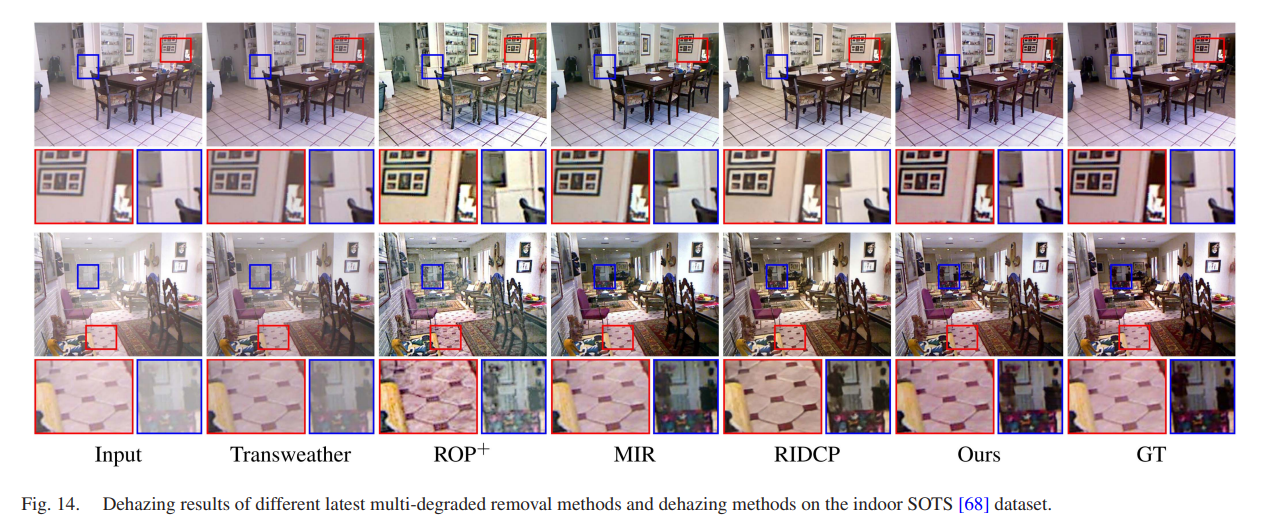

此外,本文还在SOTS-Indoor[68]雾天数据集上进行了测试评估,参与评估的方法包括最先进的多天气退化恢复方法(如Transweather、MIR)以及去雾方法(如ROP+、RIDCP)。需特别说明的是,这些方法均未在与测试数据相似的训练集上进行训练。如图14所示,所提方法的视觉性能优于其他技术,尤其在颜色控制和细节表征方面优势明显。相关结果还显示,与其他方法相比,所提方法在PSNR和SSIM这两项指标上均位列前两名。

图13. 不同最先进去雾方法在URHI[68]数据集上的去雾结果。红色方框标记出明显差异。

图14. 不同最新多退化去除方法和去雾方法在室内SOTS[68]数据集上的去雾结果。

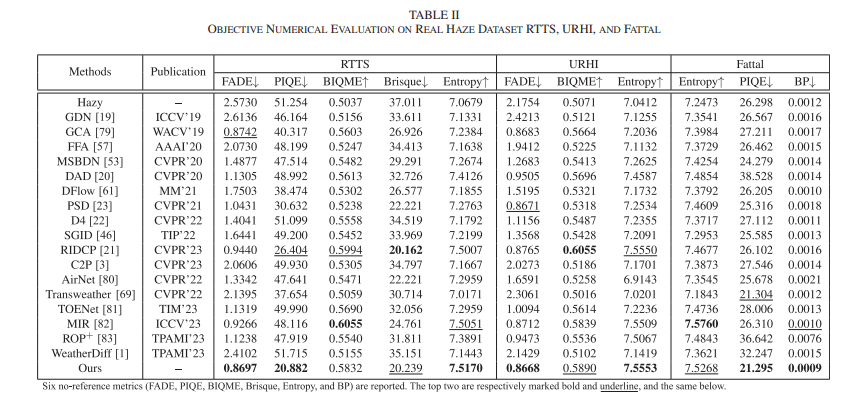

第三,本文在RTTS、URHI、Fattal等包含多种雾天场景的真实数据集上进行了定量评估(这三个数据集参与评估的雾天图像分别为4322幅、150幅和31幅)。通过对比不同最先进去雾方法、多天气退化恢复方法与所提方法在六项评估指标上的客观数值可知,所提方法在六项权威客观指标中均位列前三名。这一结果充分表明,所提方法在去雾彻底性、对比度、颜色保真度、自然感知效果及图像信息量方面均具备优异性能。

此外,分析发现:SGID、DFlow等在合成数据集上表现优异的深度网络,在雾分布不均匀的真实图像上表现较差。这可能是因为这类网络结构较深,对训练雾天图像数据的拟合程度较高;一旦雾浓度和分布与数据集中的人工雾存在显著差异,其适应性下降幅度会大于GCA等浅层网络。尽管所选的六种多天气退化恢复方法在其他低层图像恢复或增强任务中表现良好,但在图像去雾任务的客观评估指标上并未展现出理想性能。另外,PSD和RIDCP方法通过巧妙结合物理先验与深度网络,在多项客观指标上也取得了优异结果,但与它们相比,所提方法在多个数据集的定量和定性评估中仍具有明显优势。

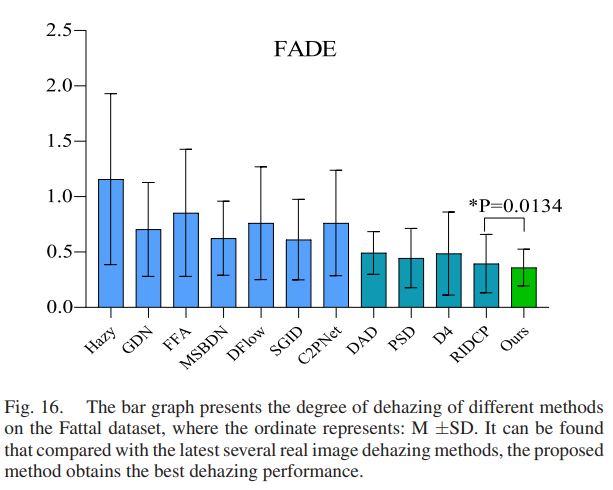

进一步地,如图16所示,显著性测试图呈现了不同方法在Fattal数据集上的去雾程度。在反映去雾彻底性的FADE指标上,本文对所提方法与先进去雾方法进行了显著性差异分析。结果显示,与先进去雾方法相比(尤其是当前性能最佳的真实图像去雾方法RIDCP),所提方法在自然雾天图像上的去雾性能更优。

图16. 柱状图呈现了不同方法在Fattal数据集上的去雾程度,纵轴表示均值±标准差(M±SD)。可见与最新的几种真实图像去雾方法相比,所提方法取得了最佳的去雾性能。

7 结论

本文提出了一种新颖、稳健的真实场景去雾方法,该方法在去雾彻底性和泛化能力方面表现优异。通过在多种不同类型的真实雾天数据上开展大量评估,验证了所提方法在图像去雾任务中的优越性能。

所提方法从构建含多因素干扰的雾天退化模型、网络结构设计与学习策略三个视角解决真实图像去雾问题:首先,基于所提雾天退化模型合成的 MDhaze 数据集,能更逼真地模拟真实场景中的雾天情况,缩小与真实数据的差异;其次,在网络结构中引入退化定位模块和退化去除策略,进一步解决数据分布偏移问题,使模型获得稳定的泛化性能;最后,设计了灵活的高斯感知对比损失(GPC),进一步约束网络向自然去雾方向更新。

与当前主流去雾方法及多天气退化恢复方法相比,所提方法在客观评估指标、图像恢复质量与图像处理效率方面均取得了优异性能。