一次实时采集任务延迟问题的完整复盘(Flink CDC)

本文记录一次 Flink CDC 实时采集任务的延迟异常、内存报错以及延迟恢复缓慢的完整排查过程,并结合 MySQL 复制协议从根因角度解释问题来源,供后续参考。

一、问题现象

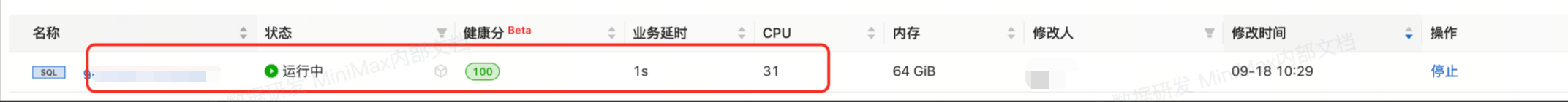

在一次 MySQL → Flink CDC → 下游的实时采集链路中,出现以下情况:

- Flink 延迟突然升至 12 小时以上 任务随后出现内存不足报错(OOM)

- 将 TaskManager 内存从 16GB 提升至64GB

- 延迟开始下降,但恢复速度极慢

- 监控显示资源空闲:CPU 无压力,背压为 0

- 延迟下降速度明显与资源状况不匹配。

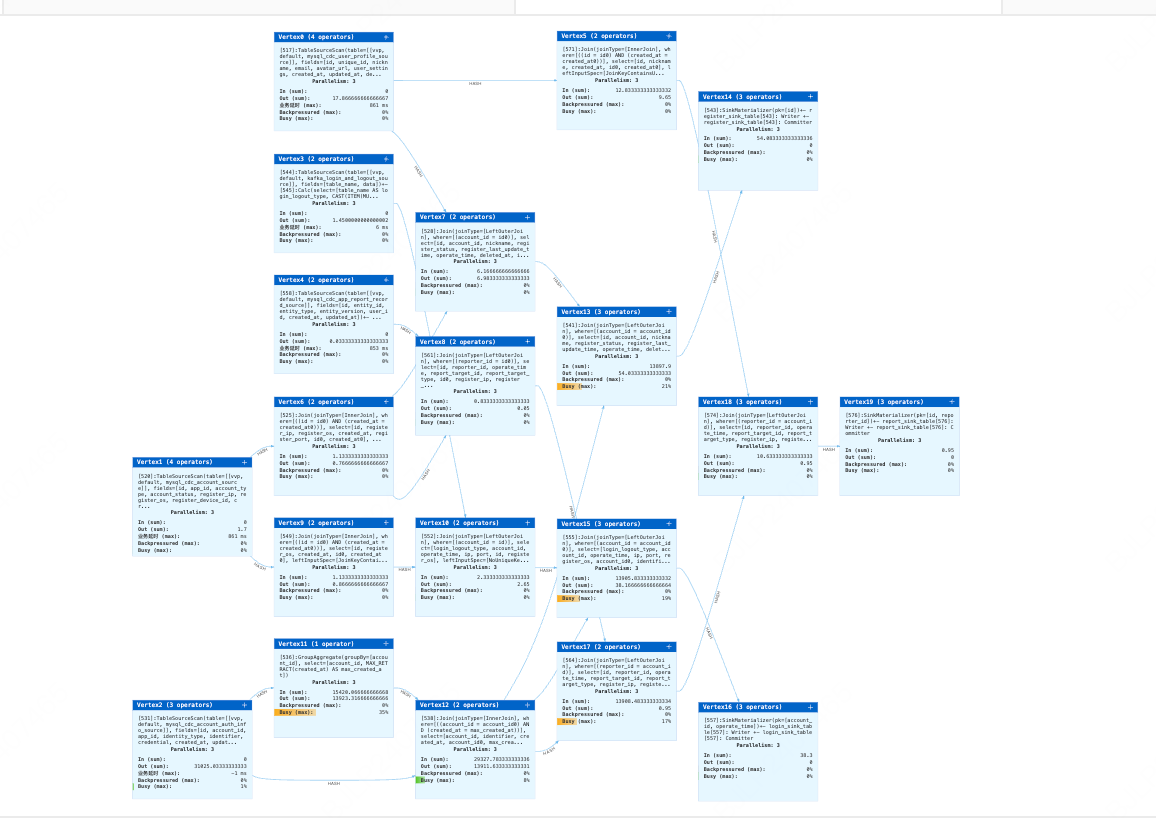

拓扑图显示 TaskManager 基本处于空闲状态,但延迟并未快速回落。

二、初步排查方向

根据 Flink 后台无压力的表现,可以排除任务本身的计算瓶颈,于是从以下方向进行分析:

- 上游 MySQL 可能存在 IO 或响应瓶颈

- Flink CDC 可能受到协议层限制

- 上游长时间无增量数据导致追赶历史 Binlog 速度较慢

经过观察和日志分析,最终将可疑点集中在 Flink CDC 的数据输入速度上。

三、关键机制分析:Flink CDC 的角色是“从库”,不是“文件读取器”

Flink CDC 并不会直接从服务器磁盘读取 binlog 文件,它必须模拟 MySQL 的从库,通过复制协议与主库通信。

这一点非常重要,也是延迟恢复慢的根本原因之一。

其机制如下:

- CDC 会向 MySQL 主库发送一个 Dump 请求

- 主库按照 MySQL 复制协议,主动把 Binlog 数据推送给 CDC

- CDC 只能等待主库按照自己的节奏发送数据

不能像本地程序一样直接随机读取 binlog 文件。这意味着 CDC 无法加速,也无法跳过 MySQL 的推送速率。

四、主库处理 Binlog 的内部耗时

MySQL 在响应一个复制客户端(Flink CDC)读取历史 Binlog 时,需要完成多项工作,而这些工作都有速度上限。

- 磁盘 IO

主库需要定位具体的 binlog 文件和 offset,然后从磁盘依次读取数据块。

这一步受到磁盘 IOPS 和吞吐能力限制。 - 协议封装

读取到的数据需要封装成特定的协议包(例如每个 packet 最大 16MB)。

这是 CPU 开销,也是 MySQL 主线程的工作。 - 网络发送

封装后的 Binlog 包最终通过网络传给 Flink TaskManager。

受限于带宽、主库连接线程、复制协议本身的效率。

这三步都无法跳过或并行,也是 MySQL 复制协议天然的瓶颈。

五、结合机制后的结论:延迟恢复慢是正常现象

回到实际现象:

- Flink 资源空闲

- 无背压

- 延迟下降速度和资源表现完全不一致

- 最终在一定时间后突然恢复正常

综合分析后可以得出结论:

延迟恢复慢并不是 Flink 处理速度问题,而是 MySQL 在推送历史 Binlog 时存在无法绕过的物理和协议瓶颈。在上游长时间无增量或 Binlog 堆积较多时,追赶速度受限于主库的读取和推送能力,导致 Flink 端无法立即消化延迟。

换言之:

瓶颈在 MySQL,不在 Flink。

六、最终结论

本次延迟问题的根因如下:

- 上游 MySQL 长时间处于低负载或无增量状态,导致 Flink CDC 需要读取较多历史 binlog。

- MySQL 在读取历史 binlog 时受到磁盘 IO、协议封装、网络传输等限制。

- Flink CDC 被动等待主库推送,处理速度完全受限于主库复制线程。

- 因此,即使 TaskManager 资源非常空闲,延迟仍然无法快速下降。

- 经过一段时间后,主库推送完成历史数据,任务自动恢复。

这是 MySQL 主从复制协议层面的限制,并非 Flink 的问题。

七、经验与建议

- 延迟飙升不一定是 Flink 的算力瓶颈,可以优先从上游状态判断。

- 监控 MySQL 的 binlog 文件大小和推送速率非常关键。

- 如需加快恢复速度,可以考虑:

- 提升 MySQL 的磁盘性能(SSD、IO 优化)

- 监控并减少 binlog 堆积

- 优化 MySQL 复制线程配置

- 使用并行 CDC(Flink CDC 2.x 支持部分表的并行读取)

这些优化比单纯增加 Flink 内存更有效。

最终问题解决