【AI基础篇】长短时记忆神经网络LSTM的解析与应用

引言

长短时记忆神经网络(Long Short-Term Memory, LSTM)作为循环神经网络(RNN)的一种先进变体,自诞生以来便在处理序列数据方面展现出卓越的能力,尤其擅长捕捉数据中的长期依赖关系。本文旨在系统性地梳理与解析LSTM的核心知识体系。我们将从其基本工作原理与数学构造出发,深入探讨其多样化的架构变体,并结合自然语言处理、时间序列预测等领域的具体案例,展示其广泛的应用价值。

1. LSTM 核心原理与结构

为了深刻理解LSTM,我们首先需要回归其设计的初衷——解决传统循环神经网络(RNN)的局限性。

1.1. 背景:为何需要LSTM?

传统的RNN在理论上可以处理任意长度的序列数据,但在实践中,当序列过长时,会遭遇严重的“梯度消失”或“梯度爆炸”问题。梯度消失导致网络难以学习到距离当前时间步较远的信息,即无法建立“长期依赖”;而梯度爆炸则会使训练过程极其不稳定。为了克服这一核心难题,LSTM被设计出来,其关键在于引入了精巧的“门控机制”。

1.2. LSTM单元的核心结构

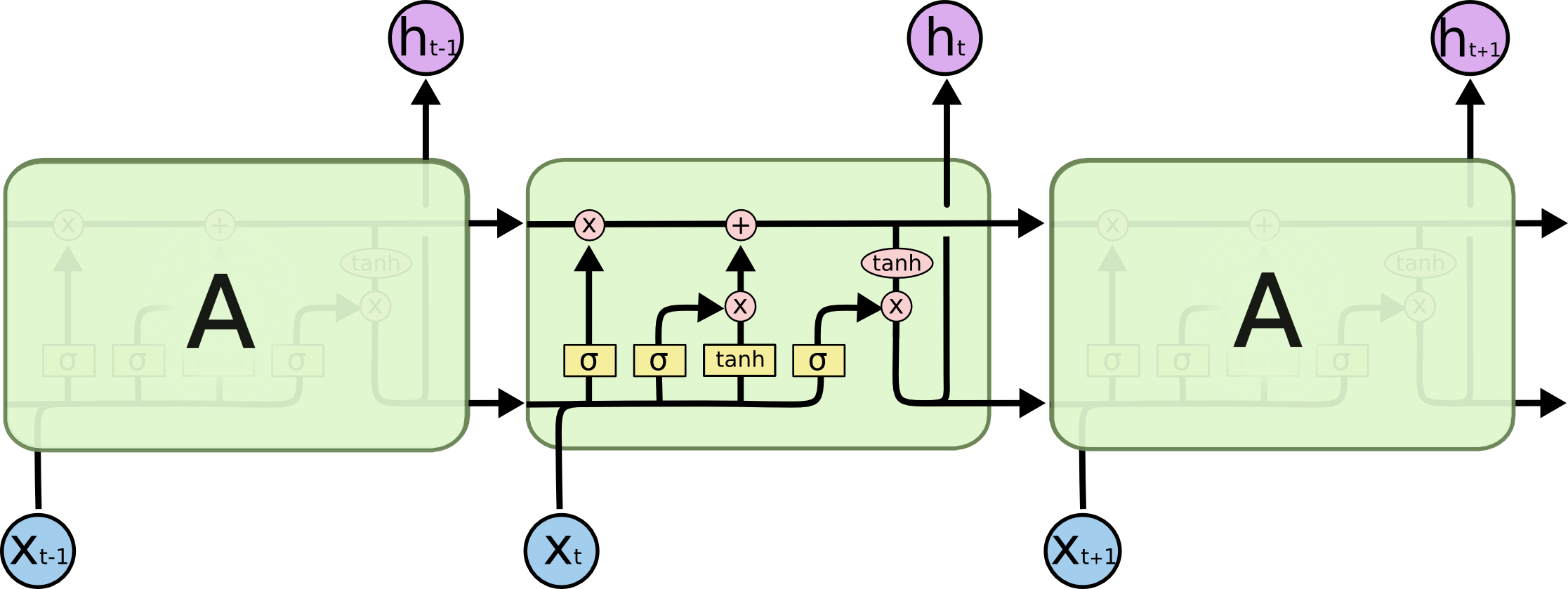

LSTM的核心创新在于其独特的单元(Cell)结构。相较于RNN单元的简单构造,一个LSTM单元内部包含三个关键组件,即“门(Gate)”,以及一个贯穿始终的“细胞状态(Cell State)”。

- 细胞状态(Cell State, C_t):这是LSTM的记忆核心,可以被看作一条信息传送带。它贯穿整个网络链条,信息可以在上面流动而只进行少量的线性变换,从而使得久远的信息能够被有效保存下来。

- 门控机制(Gating Mechanism):LSTM通过三个“门”结构来精细地控制细胞状态中信息的增加与移除。这些门本质上是带有Sigmoid激活函数的全连接层,其输出值在0到1之间,0代表“完全关闭”,1代表“完全打开”,从而实现对信息流动的“开关”控制。这三个门分别是:遗忘门(Forget Gate)、输入门(Input Gate)、输出门(Output Gate)。

(图片来源:Christopher Olah的博客)

1.3. 门控机制与工作流程

在每个时间步,LSTM单元会接收当前时刻的输入

、上一时刻的隐藏状态

和上一时刻的细胞状态

,并计算出当前时刻的输出

和新的细胞状态

。整个过程可以分为四个步骤:

决定遗忘信息(遗忘门) :遗忘门读取

和

,然后输出一个0到1之间的数值,该数值与上一时刻的细胞状态

按元素相乘,决定从旧记忆中遗忘哪些部分。值为0表示完全忘记,值为1表示完全保留。

决定存入新信息(输入门) :输入门同样基于

和

,决定哪些新信息是重要的。与此同时,一个tanh层会创建一个新的候选值向量

,准备添加到细胞状态中。输入门的输出将与这个候选值向量相乘,以控制新信息的流入量。

更新细胞状态:将旧的细胞状态

乘以遗忘门的输出(选择性遗忘),然后加上输入门筛选过的新信息(选择性记忆),从而得到当前时刻的细胞状态

。这个“遗忘”加“记忆”的过程,是LSTM能够维持长期记忆的关键。

决定输出信息(输出门) :最后,输出门基于

和

,决定细胞状态中的哪些信息将被作为当前时间步的输出。细胞状态

会先经过一个tanh函数进行处理(将其值缩放到-1到1之间),然后与输出门的输出相乘,最终得到隐藏状态

,这个

既是当前时刻的输出,也会作为下一时刻的输入之一。

1.4. 数学公式详解

下面是LSTM单元内部计算的数学表达,这些公式构成了LSTM运作的基石 :

遗忘门 (Forget Gate):

代表Sigmoid激活函数。

和

分别是遗忘门的权重矩阵和偏置项。

表示将上一时刻的隐藏状态和当前输入拼接成一个向量。

- 输入门 (Input Gate):

决定了哪些新信息将被更新。

是通过tanh激活函数创建的候选记忆内容。

- 细胞状态更新 (Cell State Update):

* 表示逐元素相乘。此公式完美体现了“忘记旧的,记住新的”这一过程。

- 输出门 (Output Gate):

决定了细胞状态的哪些部分可以作为输出。

是最终的隐藏状态输出。

2. LSTM 的主要变体与架构演进

基于标准LSTM(也称Vanilla LSTM),研究人员提出了一系列变体,以简化结构或增强特定性能。

带窥视孔连接的LSTM (Peephole LSTM) :这是一个重要的变体,它允许门控单元直接“窥视”细胞状态

。这意味着在计算三个门的输出时,除了

和

,还会加入

作为输入。这使得门能够根据当前的记忆内容做出更精准的决策,但同时也增加了模型的复杂度和计算量。

门控循环单元 (Gated Recurrent Unit, GRU) :GRU是LSTM最流行和最成功的变体之一。它将LSTM的遗忘门和输入门合并为一个“更新门(Update Gate)”,并将细胞状态和隐藏状态合并。这使得GRU的参数量少于标准LSTM,训练速度通常更快,而在许多任务上,其性能与LSTM不相上下 。尽管大量研究表明,许多对LSTM的微小修改并不能带来显著的性能提升 但GRU因其简洁和高效而成为一个强有力的替代方案。

堆叠LSTM (Stacked LSTM) :为了学习数据中更深层次、更抽象的特征,可以将多个LSTM层堆叠起来。第一层的输出序列

将作为第二层的输入序列

。这种深度结构增强了模型的表达能力,使其能够处理更复杂的模式,常用于复杂的序列建模任务。

双向LSTM (Bidirectional LSTM, BiLSTM) :对于很多任务,例如文本情感分析或命名实体识别,一个词的含义不仅取决于前面的词,也取决于后面的词。双向LSTM通过使用两个独立的LSTM层来解决这个问题:一个按时间正向处理序列,另一个按时间反向处理序列。在每个时间步,两个LSTM的隐藏状态被拼接起来,形成最终的输出。这使得模型能够同时利用过去和未来的上下文信息,极大地提升了在许多NLP任务上的表现。

3. LSTM 的典型应用领域与案例

凭借其强大的序列建模能力,LSTM在多个领域取得了巨大成功。

自然语言处理 (NLP) :这是LSTM应用最广泛、最成功的领域。

- 机器翻译:LSTM可以作为编码器-解码器(Encoder-Decoder)架构的核心,编码器将源语言句子压缩成一个上下文向量,解码器则基于该向量生成目标语言的句子。

- 文本生成与语言建模:通过学习大量文本,LSTM可以预测下一个最有可能出现的单词或字符,从而生成连贯的文本,如诗歌、代码或新闻文章。

- 情感分析:LSTM可以逐词阅读一条评论或推文,并利用其记忆来判断整体的情感倾向(正面、负面或中性)。

时间序列预测:LSTM非常适合处理带有时间依赖性的数据。

- 金融预测:通过分析历史股票价格、交易量等数据,LSTM可以预测未来股价的走势。

- 天气预报与流量预测:模型可以学习气象数据或交通流量数据中的周期性模式和长期趋势,以进行未来的预测。

语音识别:语音本质上是随时间变化的音频信号序列。LSTM能够有效处理这种时序信息,将音频帧序列转换为文本。例如,百度的Deep Speech系统就成功地应用了结合LSTM的网络结构进行端到端的语音识别。

其他应用:LSTM的应用边界不断扩展,还包括视频分析(理解视频中的动态内容)、图像描述生成(为图片生成文字描述)、手写识别等。

4. LSTM 模型训练与优化

要充分发挥LSTM的性能,高效的训练和精细的优化至关重要。

4.1. 超参数调优最佳实践

超参数的选择对模型性能有决定性影响,通常需要通过大量实验来确定 。以下是一些针对中等规模文本语料库的实证性建议:

- 隐藏层大小 (Hidden Size) :它决定了模型的容量。通常从128、256或512等数值开始尝试。过小的尺寸可能导致模型欠拟合,无法学习复杂模式;而过大的尺寸不仅会增加计算成本,还可能导致过拟合。增加隐藏层大小的收益会递减。

- 网络层数 (Number of Layers) :对于多数任务,2到3层的堆叠LSTM是一个很好的起点 。更深的网络能学习更抽象的特征,但也更容易过拟合,需要更多数据和更强的正则化。

- 批量大小 (Batch Size) :通常在32、64或128之间选择,具体取决于GPU内存大小。较大的批量可以使梯度下降更稳定,训练速度更快,但有时可能会陷入泛化能力较差的“尖锐最小值”区域。

- 学习率与调度 (Learning Rate & Schedules) :这是最关键的超参数之一 。建议使用自适应优化器如Adam或RMSprop,并设置一个较小的初始学习率(如1e-3或5e-4)。更重要的是,应配合使用学习率调度策略,例如“当验证集损失不再下降时降低学习率(ReduceLROnPlateau)”或“余弦退火(Cosine Annealing)”,这能帮助模型在训练后期更精细地收敛 。

4.2. 正则化与防止过拟合

- Dropout:是防止LSTM过拟合最有效的技术之一。它在训练期间随机地将一部分神经元的输出置为零。对于LSTM,一种更有效的变体是 变分Dropout(Variational Dropout) 或 循环Dropout(Recurrent Dropout) ,它对循环连接也应用相同的Dropout掩码,从而更好地正则化记忆单元。

- 早停 (Early Stopping) :在训练过程中持续监控验证集的性能(如损失或准确率)。一旦验证集性能在连续多个周期内不再提升,就提前终止训练,以防止模型在训练集上过拟合。

4.3. 梯度裁剪 (Gradient Clipping)

为了应对梯度爆炸问题,梯度裁剪是一个必不可少的技巧。它为梯度的范数(norm)设定一个上限,如果一次迭代中计算出的梯度超过了这个阈值,就将其缩放回阈值范围内,从而确保训练的稳定性。

未来展望

展望未来,纯粹的LSTM或纯粹的Transformer可能都不是序列建模的终极答案。未来的趋势很可能指向:

- 混合架构:结合RNN的线性效率、CNN的局部感知能力和Transformer的全局建模能力的混合模型将持续成为研究热点。

- 效率与性能的平衡:新一代序列模型(如Mamba、xLSTM)正在重新定义效率与性能之间的权衡,它们在保持强大性能的同时,极大地降低了计算复杂度。

- LSTM的基石地位:尽管面临新架构的挑战,LSTM作为理解和处理序列数据的基本构建块,其核心思想——门控机制和记忆单元——将继续影响未来的模型设计。在许多对计算资源敏感或数据固有强时序性的场景中,LSTM及其变体仍将是不可或代、极具价值的工具。