机器学习20:自编码器(Auto-Encoder)与扩散模型综述学习

摘要

这次系统了解了自编码器的基本原理及其作为自监督学习经典方法的代表性,详细阐述了其通过编码器-解码器结构实现数据压缩与重构的核心机制,并分析了去噪自编码器等变体的工作原理。课程进一步深入综述了扩散模型的理论基础、主流改进方向及其与VAE、GAN等生成模型的广泛联系,全面梳理了扩散模型在计算机视觉、多模态生成及科学计算等领域的革命性应用,最后剖析了其在理论理解、潜空间语义性、基本假设与计算成本等方面面临的关键挑战,为理解生成式AI的前沿发展提供了系统性的知识框架。

Abstract

This lecture systematically introduces the basic principles of the Auto-Encoder and its role as a classic method in self-supervised learning, detailing its core mechanism of data compression and reconstruction through an encoder-decoder structure, and analyzes the working principles of its variants such as the Denoising Auto-Encoder. The course further provides an in-depth review of the theoretical foundations of Diffusion Models, mainstream improvement directions, and their broad connections with other generative models like VAEs and GANs. It comprehensively outlines the revolutionary applications of diffusion models in fields such as computer vision, multimodal generation, and scientific computing. Finally, it examines the key challenges faced in terms of theoretical understanding, latent space semantics, fundamental assumptions, and computational cost, offering a systematic knowledge framework for understanding the cutting-edge developments in generative AI.

一.自编码器

1.了解自编码器

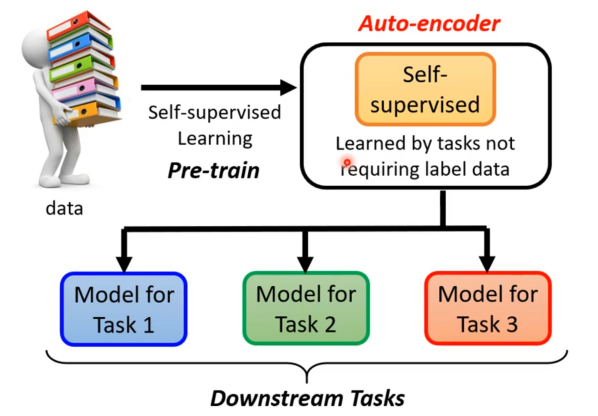

自编码器其实也可以算是自监督式学习的一环,所以再简单回顾下自监督式学习框架。自监督式学习先通过大量没有标注的资料训练一个模型,如完成“填空”或者预测下一个token的任务,训练完后就可以经过微调后将其用在其他下游任务中。

但是在自监督式学习这种不用标注资料就可以学习的任务中,在BERT以及GPT之前就已经有个更古老的不用标注资料的任务就叫做自编码器。

2.自编码器的运行

前面自监督式学习都是在用文字做例子,这里就先换成影像,假设有非常大量的图片在自编码器任务中。而自编码器中有两个网络编码器(encoder)和解码器(decoder),其中编码器是将输入的图片转成一个向量,接着这个向量作为解码器的输入,通过解码器之后便得到一个图片,而自编码器训练的任务就是使解码器输出的图片与编码器输入的图片越接近越好,这个过程也可以