[人工智能-大模型-122]:模型层 - RNN是通过神经元还是通过张量时间记录状态信息?时间状态信息是如何被更新的?

这是一个触及RNN(循环神经网络)核心机制的深刻问题。我们来用清晰、准确又通俗的方式回答:

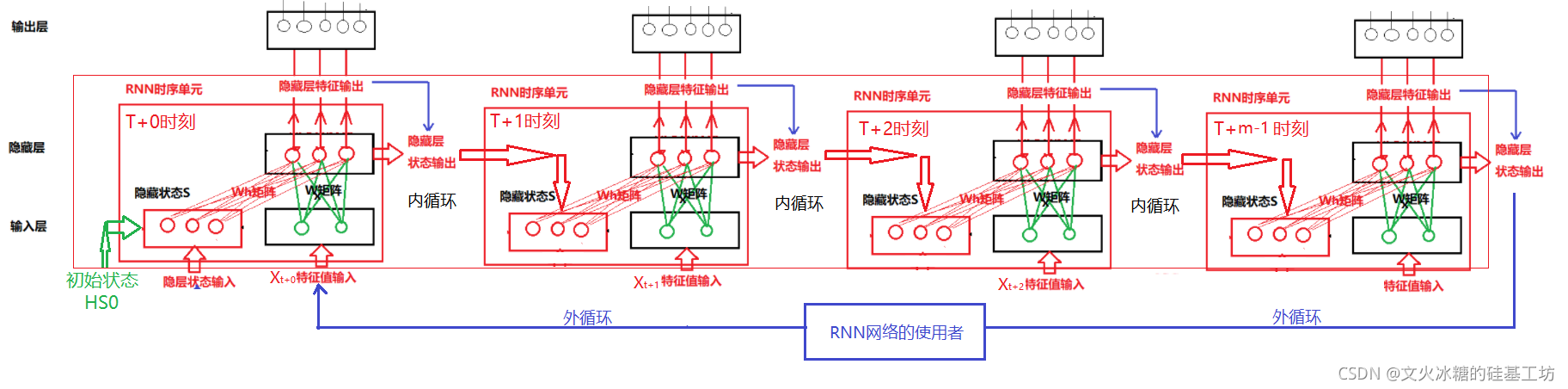

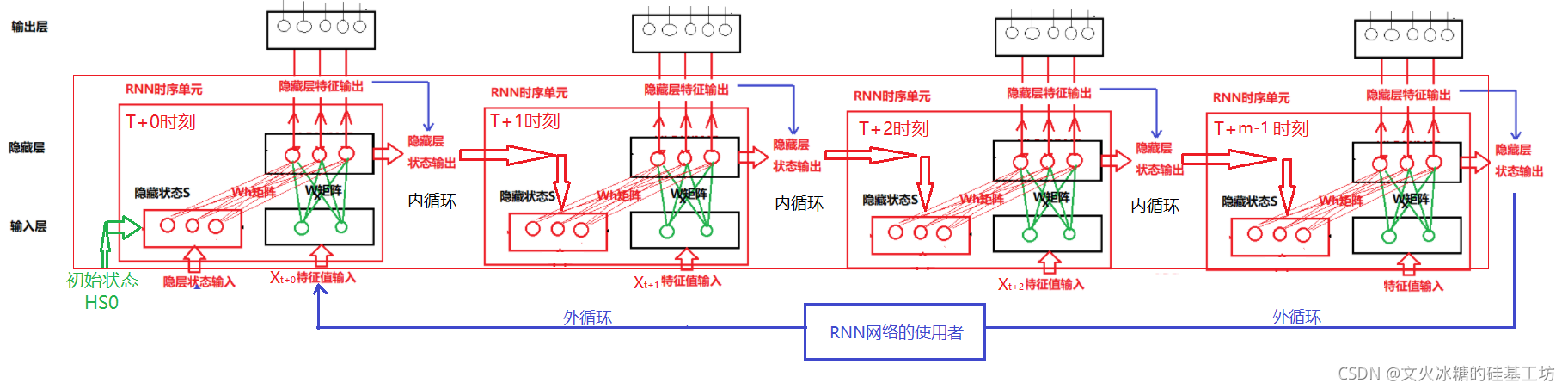

一、 RNN是通过“张量”来记录状态信息的

直接答案:

RNN通过一个“张量”(Tensor)来存储和传递状态信息。

- 这个张量叫什么?

它被称为隐藏状态(Hidden State),通常记作h_t(t表示时间步)。 - 它长什么样?

它是一个向量(一维张量),其长度等于RNN隐藏层的神经元数量。

例如,如果隐藏层有128个神经元,那么h_t就是一个包含128个浮点数的向量。 - 它存了什么?

这个向量是从序列开始到当前时刻t的所有输入信息的压缩摘要。它不是存储原始数据,而是存储网络“理解”后的抽象表示。

✅ 关键:

张量h_t就是RNN的“记忆本”,它在每个时间步被更新,用于携带历史信息。

二、 “神经元”在这里的角色是什么?

神经元不是“存储”状态的地方,而是参与计算和更新状态的“计算单元”。

- 每个神经元对应

h_t中的一个元素。

例如,h_t[0]是第1个神经元的激活值,h_t[1]是第2个神经元的激活值,以此类推。 - 神经元的工作:

在每个时间步,所有神经元一起工作,根据当前输入和上一时刻的状态,计算出一个新的状态向量h_t。

✅ 类比:

想象一个128人的合唱团(128个神经元)。

- “乐谱”是权重(固定规则)。

- “当前听到的音乐”是输入

x_t。- “他们共同唱出的新声音”就是新的状态

h_t(一个128维的向量)。

声音(状态)是由所有人(神经元)共同产生的,但声音本身是“声波”(张量),而不是人。

三、 时间状态信息是如何被更新的?—— 核心机制

状态的更新是一个由带权重的神经网络计算驱动的数学过程。

更新公式(以简单RNN为例):

h_t = tanh(W_hh @ h_{t-1} + W_xh @ x_t + b)我们来一步步拆解这个更新过程:

| 步骤 | 操作 | 涉及的组件 |

|---|---|---|

| 1. 获取旧记忆 | 读取上一时刻的隐藏状态 h_{t-1} | 张量(记忆载体) |

| 2. 获取新输入 | 读取当前时刻的输入 x_t | 张量(新信息) |

| 3. 加权计算 | - 用权重矩阵 W_hh 对 h_{t-1} 进行加权(记忆的重要性)- 用权重矩阵 W_xh 对 x_t 进行加权(新输入的重要性) | 带权重的神经元(计算机制) |

| 4. 合并与激活 | 将加权后的结果相加,加上偏置 b,再通过 tanh 函数压缩到 [-1, 1] | 神经元的激活函数 |

| 5. 生成新状态 | 输出新的隐藏状态 h_t | 新的张量(更新后的记忆) |

✅ 关键点:

- 输入:旧记忆

h_{t-1}(张量) + 新输入x_t(张量)- 计算:由

W_hh和W_xh(权重,由神经元构成)驱动的线性变换。- 输出:新记忆

h_t(张量)- 一次更新的长度:每次重新计算所有的状态。

四、 形象比喻:智能日记本

想象你有一个智能日记本(代表RNN):

- 日记本的每一页:就是一个张量

h_t,记录了当天的“总结”。 - 写日记的人:就是神经元组成的计算模块,它有固定的“写作规则”(权重)。

- 每天的更新过程:

- 翻开昨天的总结(

h_{t-1})。 - 回顾今天发生的事(

x_t)。 - 根据“写作规则”(权重),判断哪些旧信息重要,哪些新事件关键。

- 写下今天的全新总结(

h_t),并覆盖掉昨天的页面。

- 翻开昨天的总结(

在这个比喻中:

- “日记内容”是张量(状态)。

- “写作规则和人”是带权重的神经元(更新机制)。

五、 总结

| 问题 | 答案 |

|---|---|

| 状态信息存储在哪里? | 存储在一个**张量(隐藏状态 h_t)**中。它是记忆的“载体”。 |

| 神经元的作用是什么? | 神经元是计算单元,它们通过带权重的连接,执行状态更新的计算。 |

| 状态如何更新? | 通过一个神经网络计算: |

新状态 = f(旧状态, 当前输入), | |

其中 f 是由权重 W_hh 和 W_xh 定义的函数。 |

最终结论:

张量是“记忆的容器”,神经元(及其权重)是“更新记忆的引擎”。

两者协同工作,使RNN能够像人一样,基于过去的经验(h_{t-1})和当前的见闻(x_t),形成新的认知(h_t),实现对时间序列的建模。