裸金属 vs. 虚拟化 GPU 服务器:AI 训练与推理应该怎么选

根据研究机构预测,全球人工智能市场规模在 2024 年的价值为 234.6 亿美元。预计该市场将从 2025 年的 2,941.6 亿美元增长到 2032 年的 1,7716.62 亿美元,在预测期间的复合年增长率为 29.2%。到 2030 年全球 AI 推理市场规模将达到 2549.8 亿美元,而推理任务将占据 数据中心整体计算需求的 70% 以上。

AI 模型的复杂度正以指数级增长,从数亿参数的语言模型到上千亿参数的多模态系统。支撑这些模型的,不只是算法,还有底层的算力架构。无论是训练、微调还是推理部署,GPU 服务器的选择都会直接影响性能、延迟与成本。

目前市场上按照 GPU 服务器的类型来划分包括裸金属 GPU 服务器与虚拟化的 GPU 服务器。

在这样的背景下,如何在性能、弹性和成本之间取得平衡,如何在两种 GPU 服务器中进行选择,成为 AI 团队无法回避的核心决策。

两种 GPU 服务器架构的根本区别

当前主流的 GPU 服务器可分为两类:裸金属(Bare Metal) 和 **虚拟化(Virtualized)**。它们的区别不仅在资源分配方式,更体现在性能可预测性、带宽利用率和成本模式上。

| 对比维度 | 裸金属 GPU 服务器 | 虚拟化 GPU 服务器 |

|---|---|---|

| 架构形态 | 独享整台物理服务器,直接访问 GPU 资源 | 通过 Hypervisor 层共享 GPU 资源 |

| 性能开销 | 几乎为零,无虚拟化层损耗 | 存在 4%–25% 的“虚拟化损耗” |

| 隔离性 | 资源完全独立,避免干扰 | 多租户共享,可能存在带宽争用 |

| 带宽访问 | 独享 GPU 显存与通信带宽 | 共享通道 |

| 启动与伸缩 | 启动时间较长(分钟级),不支持弹性扩展 | 快速启动(秒级),弹性伸缩灵活 |

| 计费方式 | 多为包月或长期租用 | 按小时/秒计费,灵活付费 |

可以简单地理解为:

- 裸金属服务器 = 独享整台硬件,追求极致性能;

- 虚拟化服务器 = 在共享硬件上分配算力,强调灵活与弹性。

前者是“性能主义”,后者是“资源优化派”。

虚拟化 GPU 服务器:灵活的弹性与高性价比

虚拟化 GPU 服务器的最大优势在于灵活性。

通过 Hypervisor 层,云服务商能把一台物理 GPU 拆分成多个虚拟 GPU(vGPU),供不同实例使用。这样,开发者无需关心底层硬件,即可在几秒内启动或释放资源。

优点:

- 快速弹性:可在秒级创建或销毁实例,应对突发计算需求;

- 成本友好:按小时或秒计费,适合预算有限的团队;

- 研发效率高:非常适合 PoC 测试、模型调参、小规模训练等任务;

- 可选 GPU 型号多:大多数云平台很少提供裸金属服务器,DigitalOcean 是个例外,但该平台上的虚拟化 GPU 服务器的型号比裸金属 GPU 服务器的型号更多,用户可选的灵活度更大。

缺点:

- 性能损耗明显:由于虚拟化层的 CPU/I/O 开销及带宽争用,实际性能可能下降 **15%~25%**;

- 带宽不稳定:当多租户同时高负载时,内存带宽和 I/O 通道可能成为瓶颈;

- 延迟波动:对实时推理类任务(如金融风控、自动驾驶)不够友好。

因此,虚拟化 GPU 服务器非常适合研发阶段、短期任务或预算受限的团队。例如初创公司、科研机构或教育场景,都可以通过这种架构快速验证模型想法,而无需长期绑定硬件资源。

裸金属 GPU 服务器:为性能和确定性而生

裸金属 GPU 服务器则完全绕过了虚拟化层,让用户直接控制底层硬件。这种架构几乎没有性能开销,是高性能 AI 训练与推理的首选。

优势:

- 无虚拟化损耗:CPU、内存、I/O 通道都直接连接 GPU,可用率接近 100%;

- 带宽独享:AI 模型训练尤其依赖显存带宽。裸金属环境下,GPU 能获得完整、独占的带宽资源;

- 性能可预测:没有“吵闹邻居”问题(Noisy Neighbor),吞吐与延迟稳定;

- 数据安全性更高:裸金属 GPU 服务器的数据属于单一客户管理,所以数据安全性更高。

行业测试表明,在训练大型模型时,裸金属 GPU 服务器相比虚拟化架构,**性能可提升 25%~30%**,训练时间显著缩短。

不足:

- 启动与部署周期较长:相对于虚拟化服务器来讲,裸金属服务器需要完整配置与环境加载;

- 成本更高:多为长期租用或包月计费;

- 灵活性不足:裸金属服务器是不支持灵活扩展的,所以配置方案需提前规划。

这类架构最适合对性能极度敏感的应用场景:如大语言模型训练、高频推理服务、实时风控、自动驾驶、或需要高带宽吞吐的 AI 推理平台。

不同类型业务该怎么选?

没有一种架构能“通吃”所有任务。最优解往往取决于你的业务阶段与算力需求。

| 业务类型 | 核心诉求 | 推荐架构 | 理由 |

|---|---|---|---|

| 大模型训练(长期高负载) | 性能、稳定性 | 裸金属服务器 | 长周期训练对资源可预测性要求高,性能损耗会被放大。 |

| 模型微调、小样本学习 | 弹性与灵活性 | 虚拟化服务器 | 快速启动、短期计费,适合多实验切换。 |

| 实时推理(自动驾驶、金融交易) | 亚毫秒响应 | 裸金属服务器 | 去除虚拟化层,降低延迟波动。 |

| 研发与测试 | 成本控制 | 虚拟化服务器 | 成本低、启动快,满足灵活实验需求。 |

一个常见的做法是:

在早期实验和开发阶段使用虚拟化的 GPU 服务器,可以节省成本;当模型进入稳定生产后迁移到裸金属环境,获得确定的高性能与更低延迟。

兼得之道:云平台的双架构支持

如今,主流云平台开始同时提供这两种类型的 GPU 基础设施。例如 DigitalOcean 就在其 GPU Droplet 产品中同时支持:

- 虚拟化 GPU 按需实例:方便快速迭代与按需部署;

- 裸金属 GPU 服务器:为生产级 AI 训练与推理提供独享算力。

这种“双架构”支持,让团队可以在同一平台上完成从模型原型到生产部署的全流程,既能保持灵活性,又能在关键时刻释放全部性能潜力。

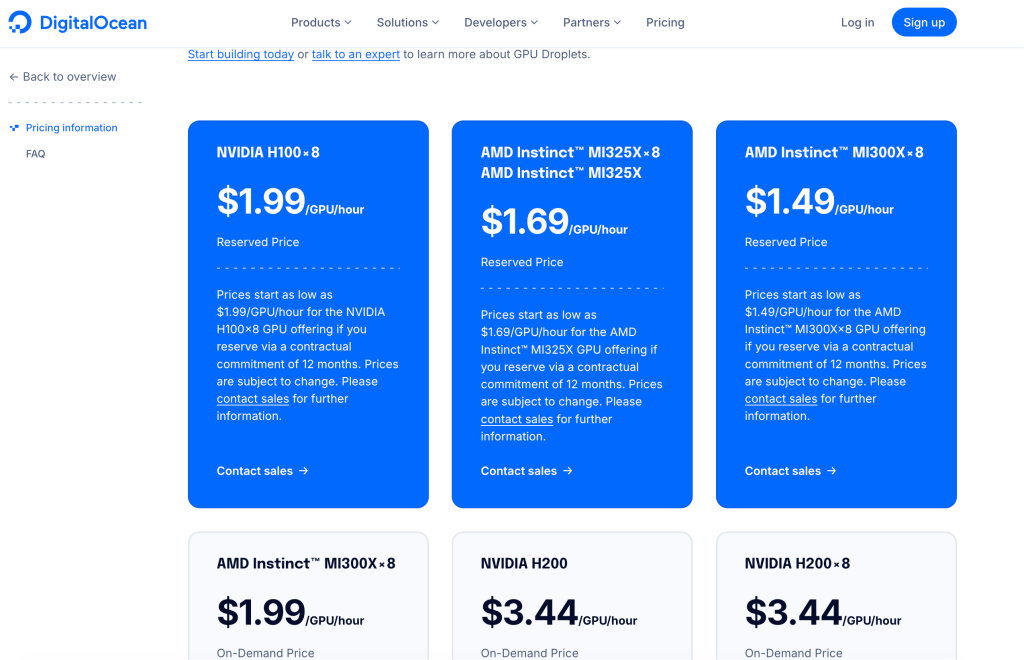

目前,DigitalOcean 可提供的裸金属 GPU 服务器型号包括:NVIDIA HGX H100、NVIDIA HGX H200、AMD MI300X。DigitalOcean 裸金属 GPU 服务器是按照合约价格来计算的,详情可与 DigitalOcean 中国区独家战略合作伙伴卓普云 aidroplet.com 直接咨询。

DigitalOcean Gradient AI 平台可提供的 GPU Droplet 按需实例则支持更多 GPU 型号,包括:AMD Instinct™ MI325X、AMD Instinct™ MI300X,以及 NVIDIA 旗下的 H200、H100、RTX 6000 Ada、 RTX 4000 Ada、A100、L40S 等。

同时,DigitalOcean 还通过中国区独家战略合作伙伴卓普云 aidroplet.com 提供技术支持服务,如果你需要了解这些虚拟化的 GPU 服务器的详细配置,以及裸金属 GPU 服务器的价格,可与卓普云直接咨询。

结语

AI 基础设施的选择,本质上是“性能”与“弹性”的权衡。裸金属服务器代表确定性与极致算力,虚拟化服务器代表敏捷与成本效率。成熟的团队会根据任务阶段动态切换两种架构——在开发阶段快步试错,在生产阶段稳定提速。当 AI 成为业务的核心生产力,算力架构的每一个选择,都将成为你竞争力的放大器。