SSA-Transformer-LSTM麻雀搜索算法优化组合模型分类预测结合SHAP分析!优化深度组合模型可解释分析,Matlab代码

基于SSA(麻雀搜索算法)优化Transformer-LSTM组合模型的结合SHAP可解释分析分类预测模型的MATLAB实现。以下是详细分析:

1. 主要功能

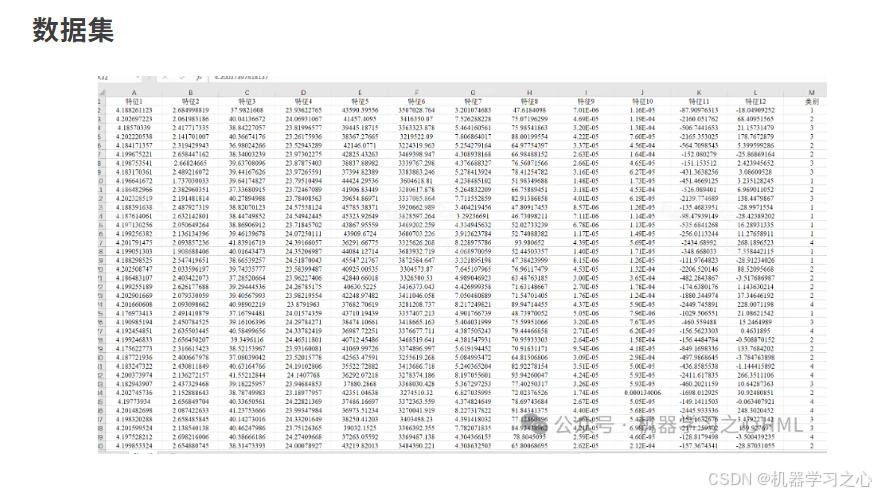

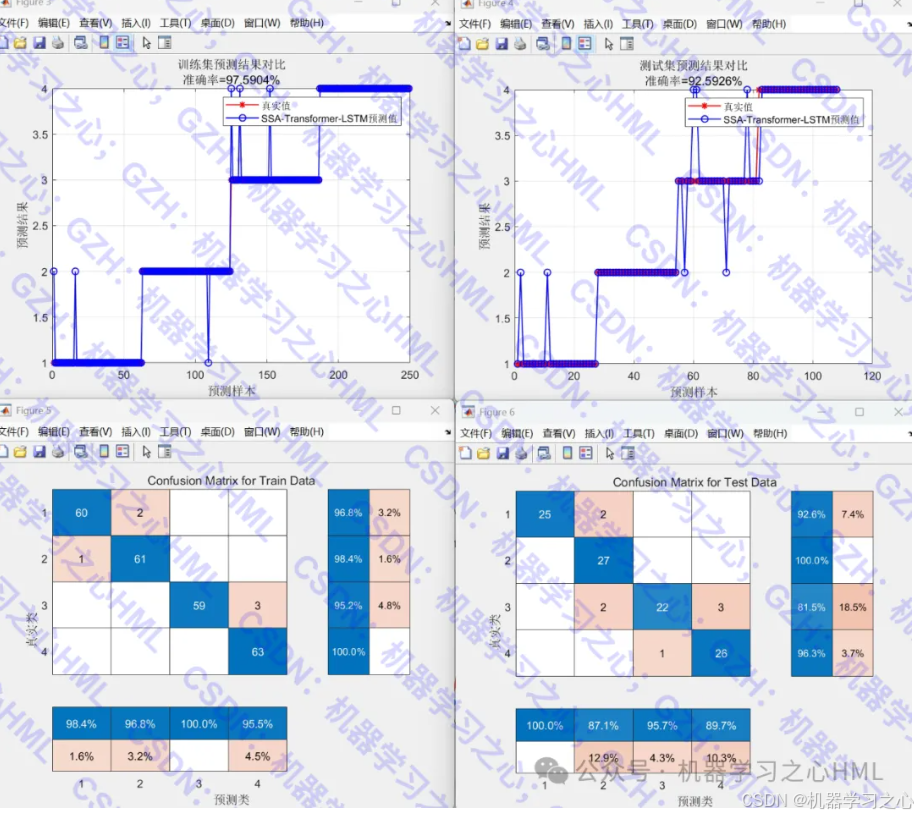

- 多分类任务:对数据集进行分类预测

- 智能优化:使用SSA算法自动寻找最优网络超参数

- 混合神经网络:结合Transformer的自注意力机制和LSTM的时序建模能力

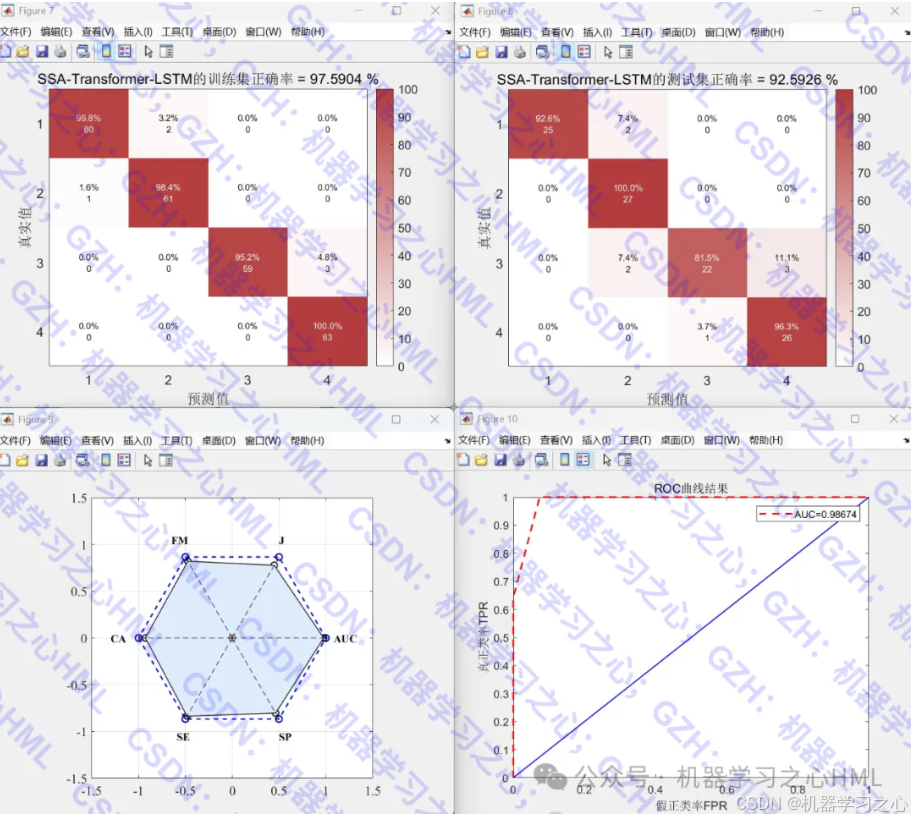

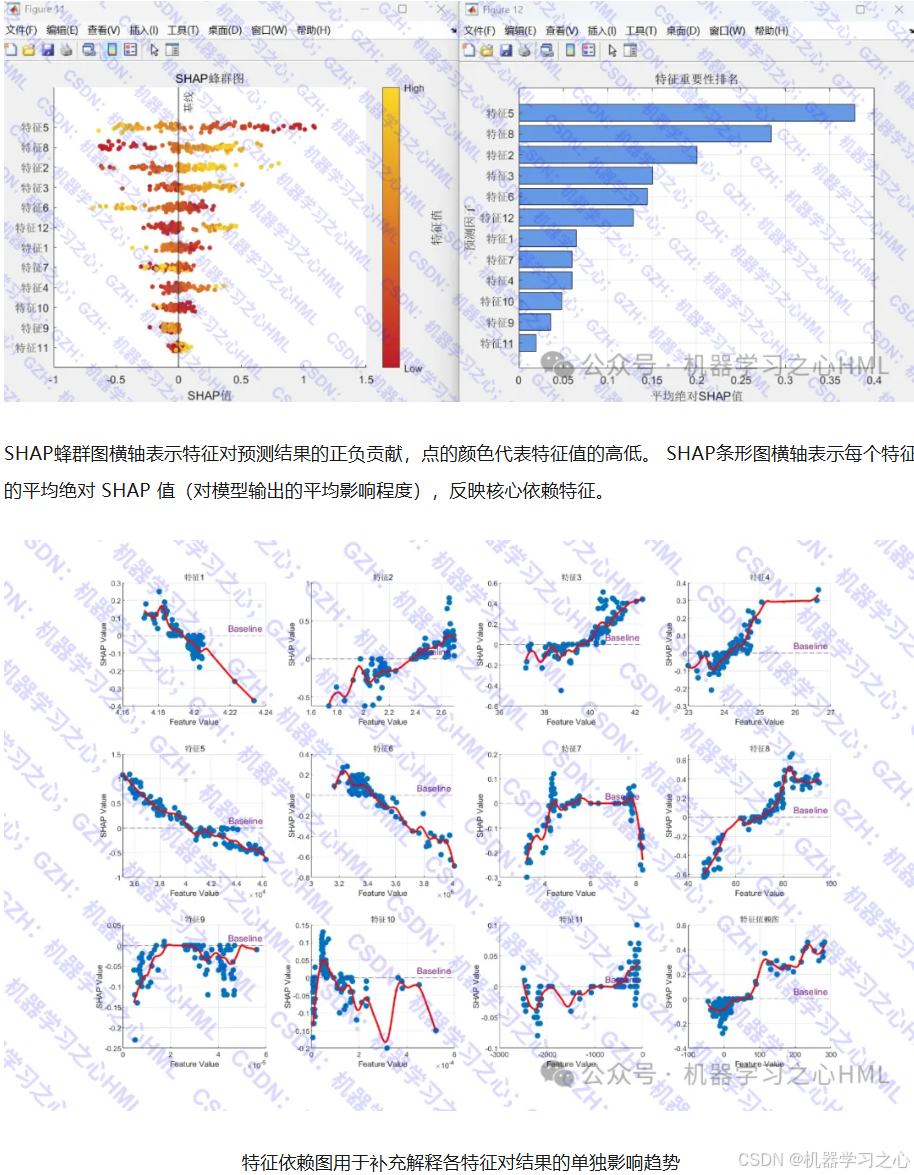

- 全面评估:提供准确率、混淆矩阵、ROC曲线、SHAP分析等

2. 逻辑关联流程

数据准备 → 数据预处理 → SSA优化 → 网络构建 → 模型训练 → 预测评估 → 可解释性分析

3. 算法步骤详解

3.1 数据预处理阶段

- 数据读取与随机打乱

- 训练集/测试集划分(70%/30%)

- 数据归一化(mapminmax)

- 数据格式转换(适应网络输入)

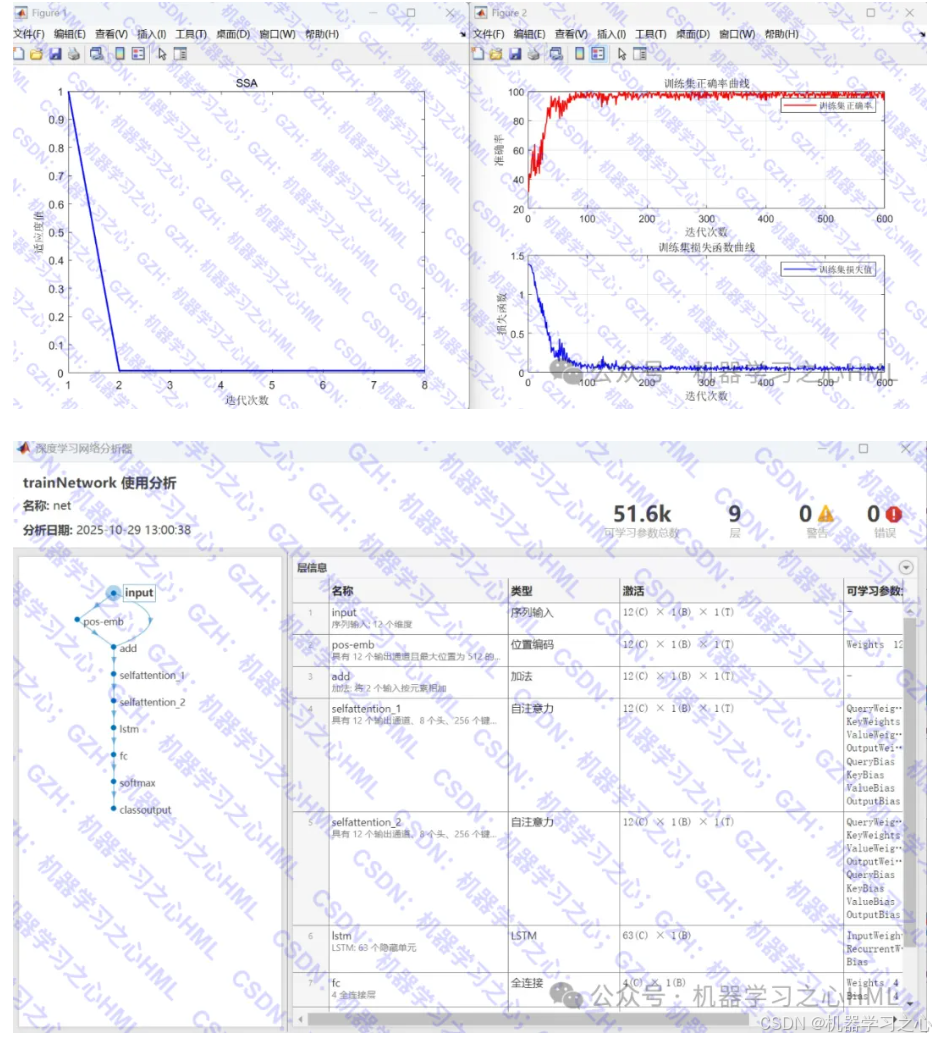

3.2 SSA优化阶段

优化目标:min f(x) = 1 - 分类准确率

优化变量:x = [学习率, 注意力头数, 隐藏层节点, L2正则化系数]

3.3 网络架构

输入层 → 位置编码 → 自注意力层 ×2 → LSTM层 → 全连接层 → 分类输出

4. 技术路线

4.1 Transformer原理

- 自注意力机制:Attention(Q,K,V)=softmax(QKTdk)VAttention(Q,K,V) = softmax(\frac{QK^T}{\sqrt{d_k}})VAttention(Q,K,V)=softmax(dkQKT)V

- 位置编码:PE(pos,2i)=sin(pos/100002i/dmodel)PE(pos,2i) = sin(pos/10000^{2i/d_{model}})PE(pos,2i)=sin(pos/100002i/dmodel)

- 多头注意力:并行多个注意力头增强特征提取

4.2 LSTM原理

- 遗忘门:ft=σ(Wf⋅[ht−1,xt]+bf)f_t = \sigma(W_f · [h_{t-1}, x_t] + b_f)ft=σ(Wf⋅[ht−1,xt]+bf)

- 输入门:it=σ(Wi⋅[ht−1,xt]+bi)i_t = \sigma(W_i · [h_{t-1}, x_t] + b_i)it=σ(Wi⋅[ht−1,xt]+bi)

- 输出门:ot=σ(Wo⋅[ht−1,xt]+bo)o_t = \sigma(W_o · [h_{t-1}, x_t] + b_o)ot=σ(Wo⋅[ht−1,xt]+bo)

4.3 SSA算法

基于麻雀觅食行为的群体优化算法,包含发现者、追随者和预警者角色。

5. 关键参数设定

5.1 SSA参数

SearchAgents_no = 5; % 种群数量

Max_iteration = 8; % 最大迭代次数

dim = 4; % 优化变量维度

5.2 训练参数

MiniBatchSize = 64; % 批大小

MaxEpochs = 200; % 最大训练轮数

InitialLearnRate = 优化值; % 初始学习率

L2Regularization = 优化值; % L2正则化

5.3 网络参数

numHeads = 优化值; % 注意力头数 (4-8)

numUnits = 优化值; % LSTM隐藏节点 (32-64)

6. 运行环境要求

- 软件:MATLAB 2024b及以上版本

7. 创新特点

- 智能超参数优化:SSA自动寻找最优网络配置

- 混合架构:Transformer + LSTM优势互补

- 全面可解释性:SHAP分析特征重要性

- 多维度评估:从准确率到特征依赖的完整评估体系