上海AI Lab开源模型P1-235B-A22B在国际物理竞赛夺金?

目录

前言

一、一场颠覆性的胜利:开源AI如何“称霸”物理考场

二、揭秘背后:一个强大的模型,加上一个“永不疲倦”的解题团队

三、不止于物理:这场胜利的深远意义

结语

🎬 攻城狮7号:个人主页

🔥 个人专栏:《AI前沿技术要闻》

⛺️ 君子慎独!

🌈 大家好,欢迎来访我的博客!

⛳️ 此篇文章主要介绍 上海AI Lab开源模型P1-235B-A22B

📚 本期文章收录在《AI前沿技术要闻》,大家有兴趣可以自行查看!

⛺️ 欢迎各位 ✔️ 点赞 👍 收藏 ⭐留言 📝!

前言

物理学,可以说是人类理解宇宙的基石。从苹果落地到星系运转,它用严谨的逻辑和精确的数学来描述我们周围的一切。正因如此,物理学也被视为检验智能体推理能力的终极试金石之一。国际物理奥林匹克竞赛(IPhO),就是全世界最顶尖的年轻人类头脑在这个领域进行较量的巅峰舞台。这里的题目,需要的不仅仅是知识的记忆,更是深刻的洞察力、复杂的推理链条和创造性地应用定律的能力。

多年来,我们已经习惯了AI在语言、图像等领域展现出的惊人能力。但要让AI去解决一道IPhO级别的物理题,一直被认为是遥不可及的。然而,在2025年,一件足以载入AI发展史册的事件发生了:一个人工智能,不仅参加了IPhO,还成功摘得金牌。

更令人惊讶的是,取得这一历史性突破的,并非来自某个闭源的、神秘的科技巨头,而是一个完全开源的模型——来自上海AI Lab的P1-235B-A22B。

一、一场颠覆性的胜利:开源AI如何“称霸”物理考场

这次胜利的含金量极高,因为它并非一次偶然。

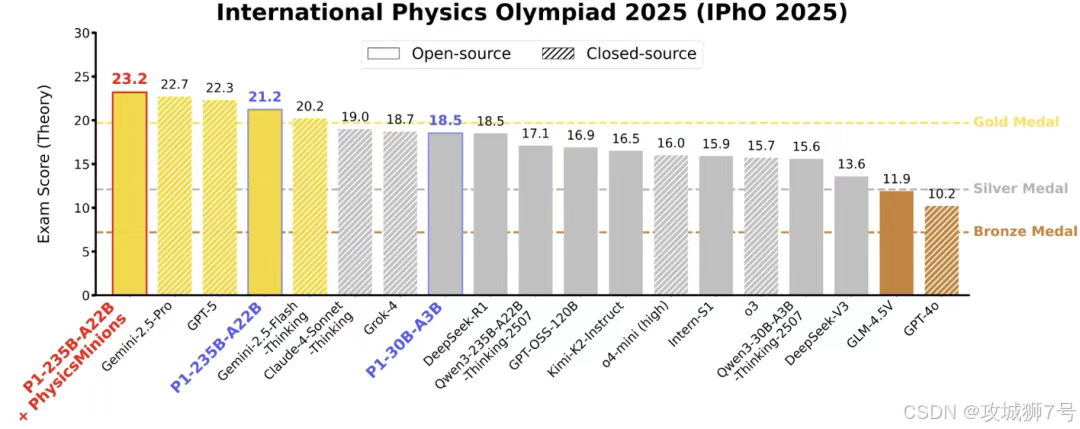

首先,是在最受瞩目的国际物理奥林匹克竞赛(IPhO 2025)上,P1-235B-A22B模型以21.2分(总分30分)的成绩,稳稳地跨过了金牌分数线。这是历史上首次有开源模型获此殊荣。

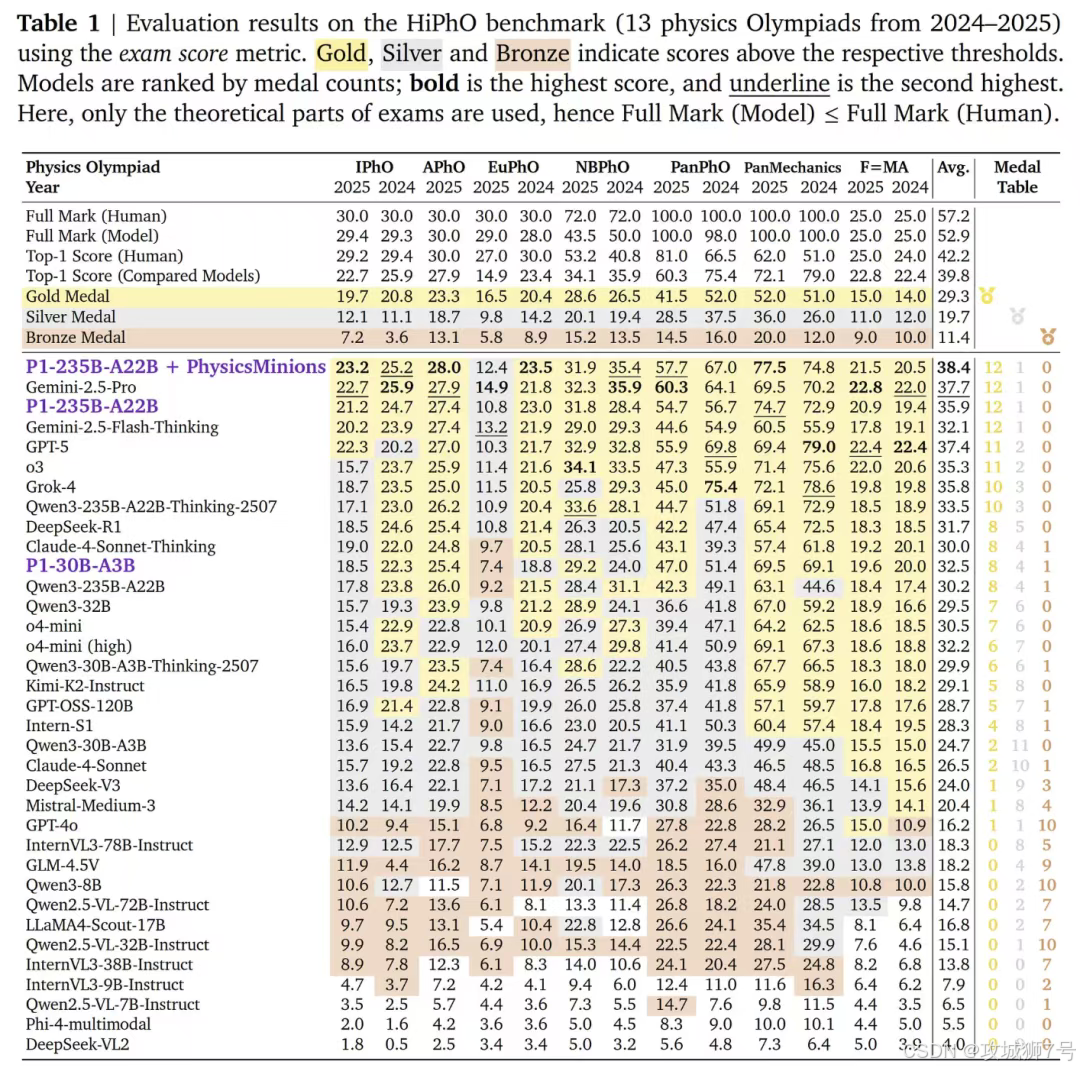

为了更全面地检验AI的物理能力,避免“单场定胜负”的偶然性,上海AI Lab的研究团队还构建了一个全新的、堪称“地狱难度”的物理AI评测基准——HiPhO。这个基准测试,打包了2024至2025年度全球13场最顶级的物理竞赛,包括IPhO、亚洲物理奥林匹克(APhO)等,并严格采用官方的评分标准,确保AI的得分能与人类选手直接、公平地比较。

在这个堪称物理奥赛“世界杯”的综合基准上,P1-235B-A22B的表现更是惊人:它总计获得了12枚金牌和1枚银牌。这个成绩,与谷歌强大的Gemini-2.5-Pro并列奖牌榜第一,同时明确地超越了OpenAI的GPT-5(11金)和xAI的Grok-4(10金)。

这一系列数据清晰地传递出一个信息:在物理推理这个硬核科学领域,开源模型的力量,已经第一次追上甚至反超了最顶尖的闭源模型。这在过去是难以想象的。那么,上海AI Lab究竟做对了什么?

二、揭秘背后:一个强大的模型,加上一个“永不疲倦”的解题团队

P1模型的成功,并非仅仅是“大力出奇迹”地堆砌参数,而是一套深思熟虑的系统性工程的胜利。这套工程可以拆解为两个核心部分:一个经过特殊“淬炼”的强大模型,和一个由AI组成的“解题复盘小组”。

首先,是如何“淬炼”出一个物理学霸模型。

研究团队意识到,要让AI学会解物理题,首先得有高质量的“教科书”和“模拟考卷”。为此,他们精心构建了一个包含数千道奥赛级别题目的训练数据集,每道题都有完整的解题过程和标准答案。

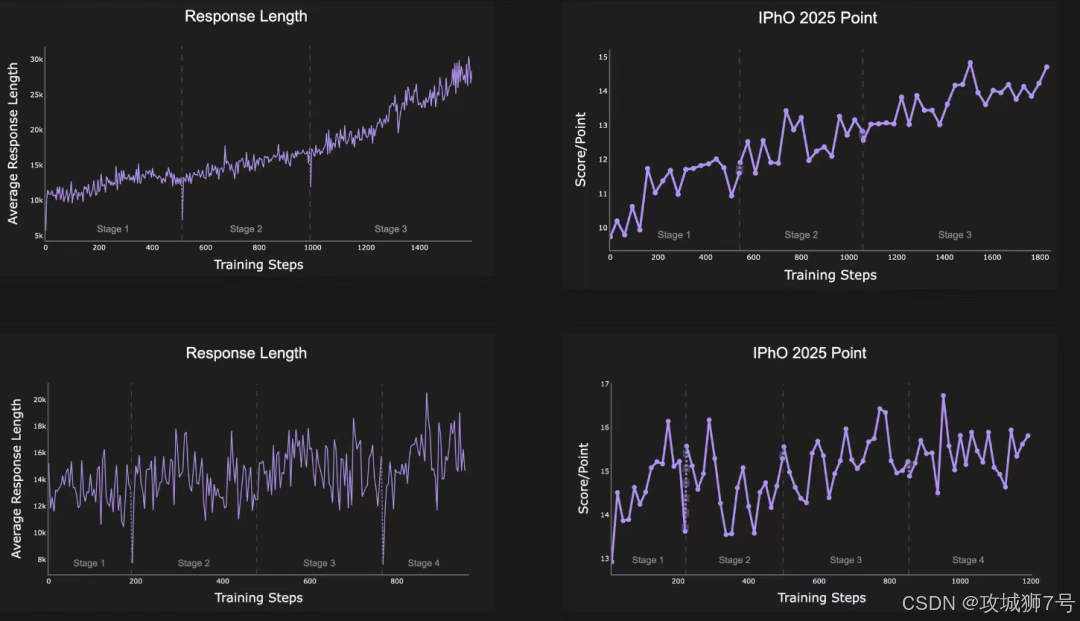

有了教材,还需要科学的训练方法。他们采用了一种名为“多阶段强化学习”的策略。我们可以将其通俗地理解为一种“阶梯式”的学习方法:

(1)让AI的“草稿纸”越来越大:在训练初期,AI可能只能写出简短的解题步骤。随着训练的深入,团队逐步放宽了模型生成答案的长度限制(即扩展上下文窗口)。这鼓励模型去探索更长、更复杂的推理链条,而不是因为“写不下”而半途而废。

(2)只做“跳一跳才能够得着”的题:在给模型喂数据前,他们会先进行筛选,把那些太简单(AI一眼就能看穿)或者太难(远超当前能力)的题目过滤掉。这确保了模型在每个阶段学习的都是最有效率、最能促进其成长的“好题”。

通过这种持续、稳定、循序渐进的强化训练,P1模型打下了坚实的物理推理基础。

但一个“学霸”单打独斗还不够,还需要一个“复盘小组”。

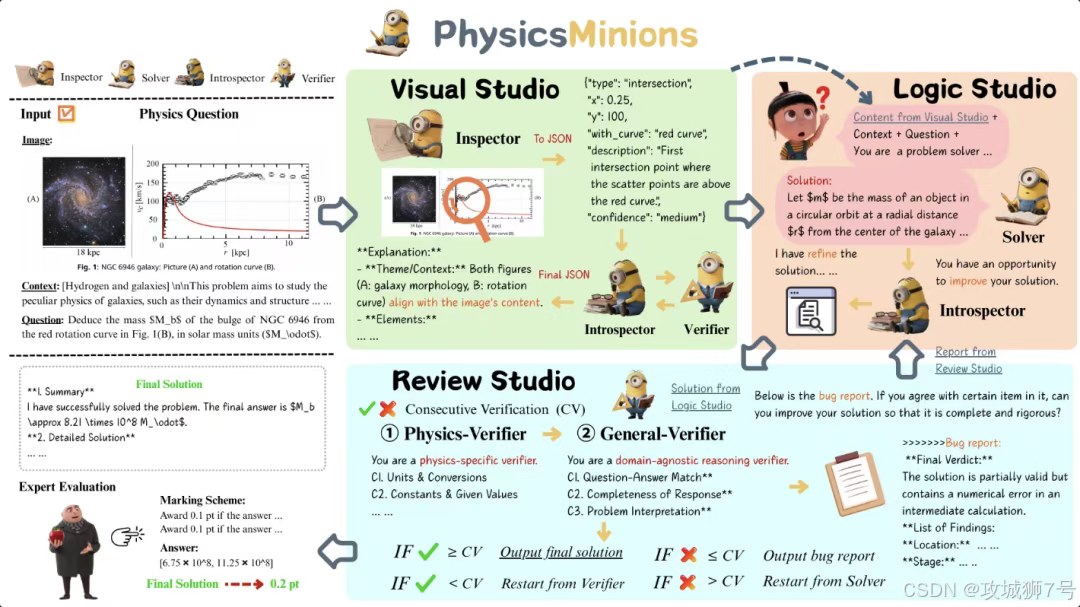

这正是整个项目中第二项,也是更具创新性的部分——一个名为`PhysicsMinions`的协同进化多智能体系统。

研究团队发现,即便是最强的AI模型,在面对极其复杂的物理问题时,也可能会犯错,或者陷入思维定式。人类解题时,常常会反复检查、验算、从不同角度审视自己的答案。于是,他们为P1模型也设计了这样一个“自我反思”的机制。

`PhysicsMinions`系统由几个各司其职的AI智能体组成:

逻辑模块 (Logic Studio):这是主要的“解题者”。它负责阅读题目,并生成初步的解题方案。

审核模块 (Review Studio):这是至关重要的“检查员”和“批判者”。它会对“解题者”给出的答案进行两个层面的双重验证:

(1)物理一致性验证:检查解题过程中使用的物理常数是否正确?单位换算有没有出错?最终答案的单位是否合理?

(2)通用逻辑验证:检查推理过程是否存在逻辑漏洞?计算过程是否准确无误?

这个系统最精妙的地方在于其“协同进化”的循环机制。当“审核模块”发现任何错误时,它不会简单地给出一个“错误”的结论,而是会生成一份详细的“错误报告”,清晰地指出问题所在,然后反馈给“逻辑模块”。“逻辑模块”在收到这份报告后,会进行“反思”,并根据反馈修正自己的解题思路,生成一个新版本的答案。

这个“解答→审核→反馈→修正”的循环会不断迭代,直到“审核模块”对答案完全满意为止。

这个`PhysicsMinions`系统带来的效果是惊人的。在HiPhO基准测试中,P1-235B-A22B模型本身已经能取得35.9分的平均分,但在配备了这个“复盘小组”后,其平均分飙升至38.4分,一举超越了所有其他模型,成为综合排名第一。

这充分证明了,“模型+系统”的组合拳,远比单纯一个强大的模型要有效得多。

三、不止于物理:这场胜利的深远意义

P1模型在物理奥赛上的突破,其意义远不止于为AI的成绩单上增添一枚金牌。

首先,它证明了“通专融合”的可能性。

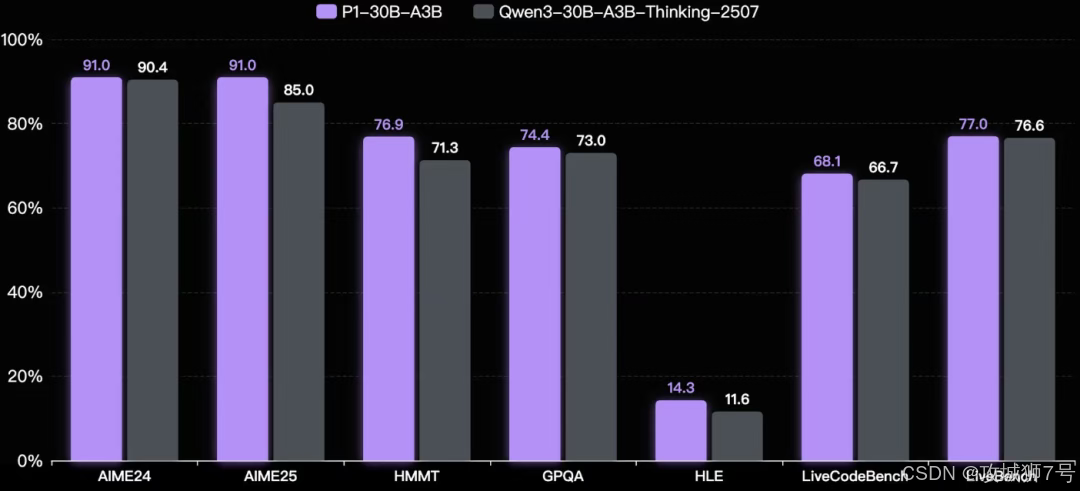

一个有趣的发现在于,当P1模型在物理推理上变得越来越强时,它在数学、代码、甚至其他STEM(科学、技术、工程和数学)领域的通用能力也得到了显著提升。这说明,在物理学这种硬核科学领域进行的深度推理训练,能够让AI学到一种更底层的、可泛化的逻辑与解决问题的能力。学会解物理题的AI,也更会解数学题和写代码了。

其次,它为“开源”正名,将加速科学创新的步伐。

这次胜利,是对开源精神的一次巨大肯定。上海AI Lab没有将模型和技术藏于高阁,而是选择将整个体系——包括P1系列模型、HiPhO评测基准、训练算法,乃至`PhysicsMinions`智能体框架——全部开源。

这意味着,全世界任何一个研究者、学生或开发者,都可以免费获取这些顶尖的工具,站在巨人的肩膀上进行自己的研究。这无疑会极大地降低AI在科学领域探索的门槛,吸引更多智慧的涌入,从而加速整个领域的技术创新。

最后,它预示了AI在真实世界中的广阔前景。

能够解决奥赛级别的物理题,意味着AI已经初步具备了应对现实世界中复杂物理问题的潜力。这种能力,未来可以直接迁移到更广阔的工业和科研场景中,例如:

(1)工程仿真:在设计飞机、汽车时,进行更精确的流体力学和结构力学仿真。

(2)材料研发:通过模拟分子间的相互作用,加速新材料的发现。

(3)生物医药:分析蛋白质折叠等复杂的生物物理过程,助力新药研发。

结语

P1模型的夺金,是一个强有力的信号:AI的能力正在从感知和生成,向着更深层次的、人类引以为傲的科学推理能力迈进。而开源,则确保了这项强大的技术能够成为全人类共同的财富,而非少数公司的专利。

这或许只是一个开始。我们有理由相信,在不远的未来,AI将不再仅仅是竞赛的参与者,而会成为科学家们身边最得力的助手,与我们一同探索和解开宇宙更深层次的奥秘。

Project Page: https://prime-rl.github.io/P1

Github: https://github.com/PRIME-RL/P1

HiPhO:

论文:https://arxiv.org/abs/2509.07894

数据集:https://huggingface.co/datasets/SciYu/HiPhO

排行榜:https://phyarena.github.io/

PhysicsMinions

https://arxiv.org/abs/2509.24855

看到这里了还不给博主点一个:

⛳️ 点赞☀️收藏 ⭐️ 关注!

💛 💙 💜 ❤️ 💚💓 💗 💕 💞 💘 💖

再次感谢大家的支持!

你们的点赞就是博主更新最大的动力!