大模型学习2

使用LMDeploy

官网链接:安装 — lmdeploy

注意前置条件是安装了conda等环境

安装完LMDeploy的conda环境以后

快速开始 — lmdeploy

使用:以下命令部署本地模型

lmdeploy serve api_server 本地模型地址

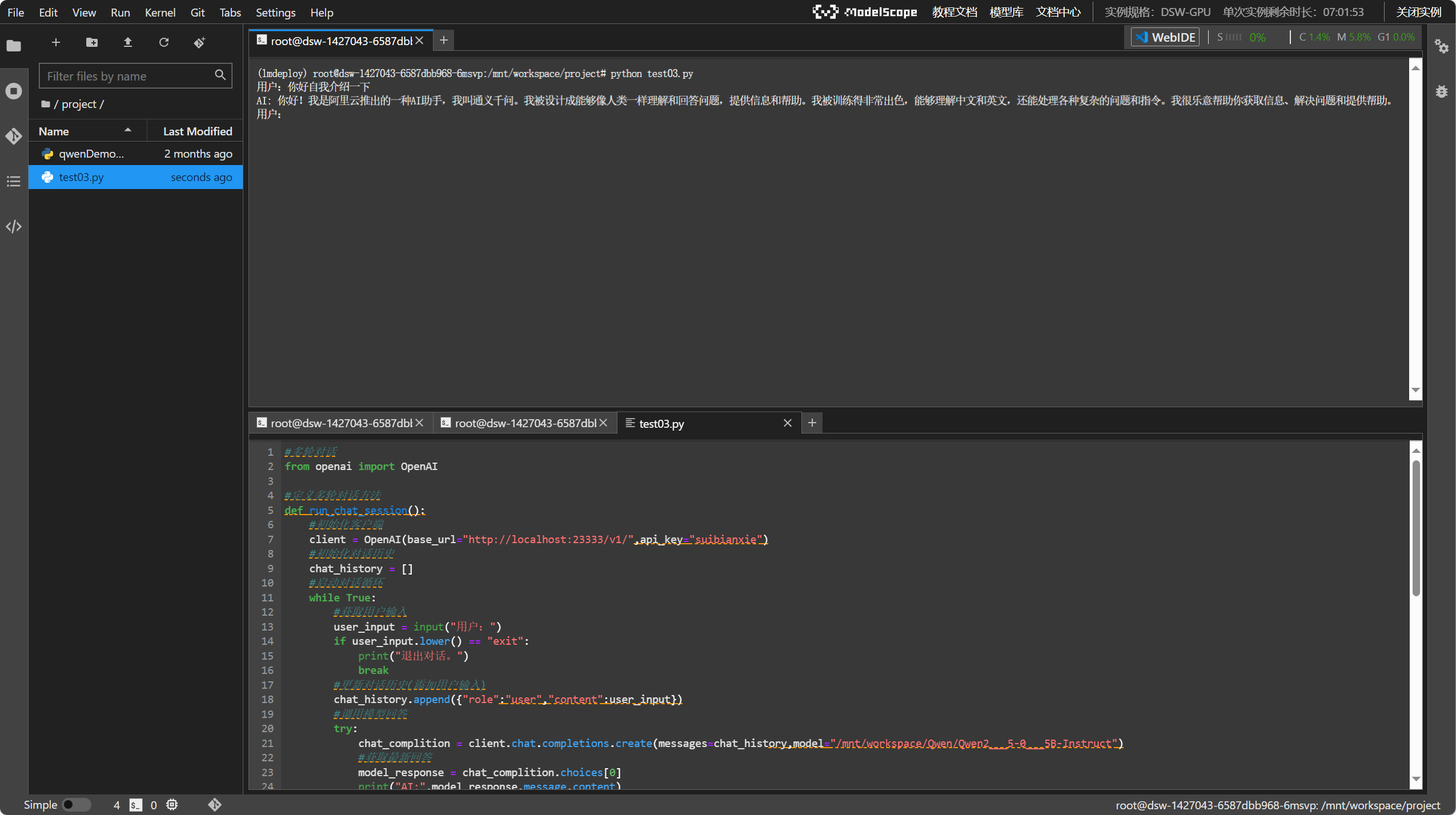

python调用本地部署的接口,端口地址23333

#多轮对话

from openai import OpenAI#定义多轮对话方法

def run_chat_session():#初始化客户端client = OpenAI(base_url="http://localhost:23333/v1/",api_key="suibianxie")#初始化对话历史chat_history = []#启动对话循环while True:#获取用户输入user_input = input("用户:")if user_input.lower() == "exit":print("退出对话。")break#更新对话历史(添加用户输入)chat_history.append({"role":"user","content":user_input})#调用模型回答try:chat_complition = client.chat.completions.create(messages=chat_history,model="/mnt/workspace/Qwen/Qwen2___5-0___5B-Instruct")#获取最新回答model_response = chat_complition.choices[0]print("AI:",model_response.message.content)#更新对话历史(添加AI模型的回复)chat_history.append({"role":"assistant","content":model_response.message.content})except Exception as e:print("发生错误:",e)break

if __name__ == '__main__':run_chat_session()

运行python脚本调用接口。