One-Shot Federated Learning with Classifier-FreeDiffusion Models

摘要

背景问题:

联邦学习(Federated Learning, FL)让多个客户端协同训练模型,而不需要集中数据。

但传统FL需要多轮通信(客户端与服务器频繁交互),通信成本很高。

现有解决方案与问题:

一次性联邦学习(One-Shot Federated Learning, OSFL)只需一轮通信,大幅减少通信量。

目前常见做法是服务器通过**扩散模型(Diffusion Models, DMs)**生成辅助数据或进行模型蒸馏。

但多数方法使用分类器引导的扩散模型(classifier-guided DMs),这要求每个客户端额外训练分类器模型,增加计算负担。

本文提出的创新:

提出 OSCAR,一种无需分类器的扩散模型辅助OSFL方法。

OSCAR 利用**大模型(foundation models)**在每个客户端生成类别特定的数据表示。

这些表示与**无分类器扩散模型(classifier-free diffusion model)**结合,用于服务器端生成辅助数据。

成果与优势:

OSCAR 简单、成本低。

在四个基准数据集上超越当前最优方法。

同时将通信负载减少了至少 99%。

简而言之,这段话讲的是:OSCAR是一种新的“一次通信”联邦学习方法,通过结合大模型和无分类器扩散模型,避免了额外的客户端分类器训练,显著降低通信和计算成本,同时性能优于现有方法。

引言

🧩 一、研究背景:什么是联邦学习(FL)

联邦学习(Federated Learning, FL) 是一种分布式机器学习方法:

多个客户端(如手机、医院、IoT设备)在不共享原始数据的前提下,协同训练一个全局模型。它的优势是:保护数据隐私、避免数据集中带来的安全与合规问题。

因此,FL 被广泛应用于:

自动驾驶(autonomous vehicles)

物联网(IoT)

医疗健康(healthcare)

⚙️ 二、传统联邦学习的主要问题

不同客户端的数据通常是 非独立同分布(non-IID),即每个客户端的数据分布不一样。

这导致全局模型需要经过**多轮通信(多次客户端–服务器参数交换)**才能收敛。

多轮通信带来高通信开销。

虽然已有一些方法(如客户端选择、梯度压缩、梯度丢弃)可以减少每轮通信负载,但仍需多轮同步,且在非IID情况下效果受限(模型容易“漂移”)。

🚀 三、一次性联邦学习(OSFL)的优势与挑战

一次性联邦学习(One-Shot Federated Learning, OSFL) 只需 一轮通信。

优点:

大幅减少通信开销。

对非IID数据更鲁棒(全局模型不是直接由客户端模型合并得出)。

能应对客户端掉线或延迟问题(client dropout, stragglers)。

现有OSFL主要有两类方法:

知识蒸馏(Knowledge Distillation):需要一个公共数据集作为知识中介;

数据生成(Dataset Generation):利用**生成模型(如扩散模型,DM)**来合成数据。

💡 四、现有DM辅助OSFL方法的问题

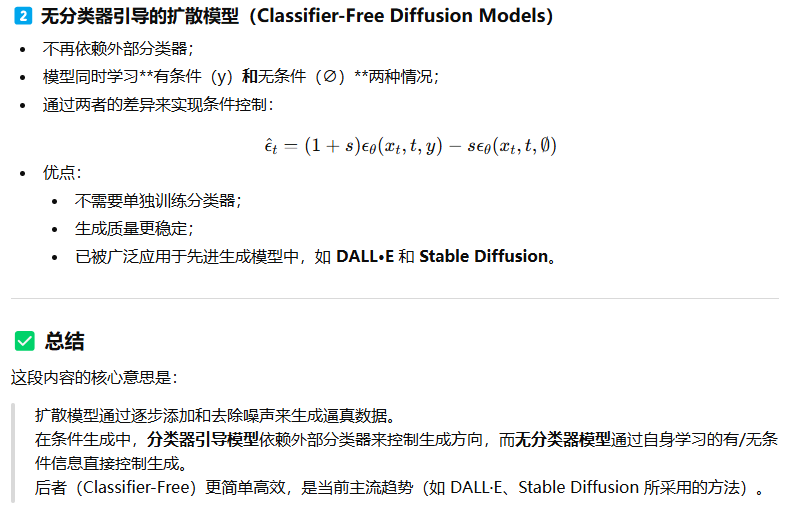

现有方法大多使用 分类器引导的扩散模型(classifier-guided DMs)。

存在两大问题:需要每个客户端额外训练分类器模型,增加计算和通信负担;

有时还需要把扩散模型下载到客户端,进一步增加成本。

🧠 五、本文的创新:OSCAR 方法

提出 OSCAR(One-Shot Federated Learning with Classifier-Free Diffusion Models)。

主要创新点:

用分类器自由的扩散模型(classifier-free DMs) 替代需要分类器的DM;

利用基础模型(Foundation Models, FMs) 直接生成类别特征编码(category-specific encodings),无需训练或微调;

服务器端生成数据,再用生成的数据训练全局模型;

通信负载减少99%,因为客户端上传的只是轻量级特征编码;

在四个基准数据集上性能优于当前最优方法(SOTA)。

相关工作

🧩 A. One-Shot Federated Learning(一次性联邦学习)

这一部分回顾了已有的 OSFL 方法,并将它们分为两大类:

1️⃣ 基于知识蒸馏的方法(Knowledge Distillation-based OSFL)

这些方法通过数据蒸馏或模型蒸馏来训练全局模型:

DOSFL [15]:

客户端生成并上传“蒸馏后的合成数据(distilled synthetic data)”,

服务器用这些数据来训练全局模型。FedKT [24]:

每个客户端使用公共辅助数据集(public auxiliary dataset)

和“师生模型(student-teacher models)”结构来训练,

最终服务器聚合出一个全局学生模型(global student model)。

👉 总体思路:客户端提供知识(通过数据或模型蒸馏),服务器利用这些知识训练全局模型。

2️⃣ 基于辅助数据生成的方法(Data Generation-based OSFL)

这些方法依靠服务器端的数据生成来形成全局模型,

客户端只需上传中间信息(如模型参数、特征或分类器):

DENSE [14]:

客户端训练生成器(generator)与本地分类器配合,

服务器利用这些生成器生成辅助数据训练全局模型。FedCVAE [25]:

每个客户端训练条件变分自编码器(CVAE),

服务器聚合各客户端的解码器部分,用来生成新数据。FedDiff [17]:

客户端训练扩散模型(Diffusion Models, DMs),

服务器聚合这些DM形成全局生成模型用于数据生成。FedCADO [13]:

客户端训练分类器,服务器使用**分类器引导的扩散模型(classifier-guided DMs)**生成数据。FedDISC [26]:

使用客户端上传的数据特征(data features),结合预训练的DMs生成新数据。

👉 总体思路:服务器利用客户端上传的模型或特征,通过生成模型(如扩散模型)合成辅助数据,用于全局训练。

🧠 B. Federated Learning with Foundation Models(基础模型在联邦学习中的应用)

这一部分讨论了 基础模型(Foundation Models, FMs)

(包括大语言模型 LLMs 和视觉语言模型 VLMs)在联邦学习中的应用探索。

主要研究方向与示例

Yu et al. [27]、Charles et al. [28]:探索在联邦学习环境中训练FMs。

PromptFL [29]:研究在数据稀缺的FL环境下的提示学习(prompt learning)。

FedDAT [30]:提出了一种多模态FMs的联邦微调方法(federated fine-tuning)。

FedPCL [31]:将FMs融入传统FL流程,作为**类原型提取器(class-wise prototype extractors)**使用。

总结

虽然FMs在减少数据异质性、降低通信开销方面具有巨大潜力,

但目前它们在联邦学习中的应用仍然研究不足,未被充分利用。

✅ 总体总结

这一节主要讲:

(上半部分) 回顾了现有的OSFL方法,分为:

基于知识蒸馏的;

基于服务器端数据生成的(通常使用扩散模型等生成器)。

(下半部分) 讨论了基础模型(如LLMs、VLMs)在联邦学习中的早期探索,

并指出它们虽然有潜力减少通信和异质性问题,但目前仍未充分开发利用。

前提知识

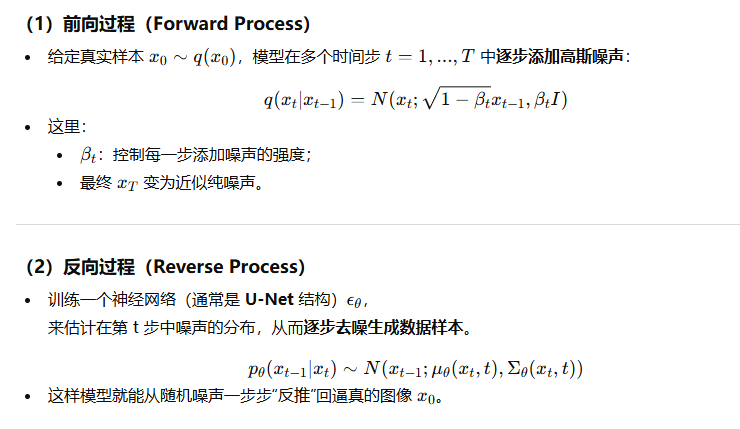

🧩 一、扩散模型的基本思想

扩散模型(Diffusion Models, DMs),尤其是 去噪扩散概率模型(DDPM, Denoising Diffusion Probabilistic Models),是一类生成模型。

它通过逐步加入噪声再逐步去噪来学习数据分布。

模型的目标是从随机噪声中重建出逼真的数据样本(如图像)。

OSCAR 方法的设计与流程说明

🧩 一、研究目标与总体思路

传统联邦学习(FL)需要多轮通信来聚合各客户端的模型,通信开销大。

OSCAR 旨在解决这个问题:

利用基础模型(Foundation Models)和无分类器扩散模型(Classifier-Free Diffusion Models),

让服务器仅通过一次通信,就能生成反映各客户端数据分布的合成数据集,

再用这些数据训练出全局模型。

因此,OSCAR 是一种高效、低通信成本的 One-Shot 联邦学习方法。

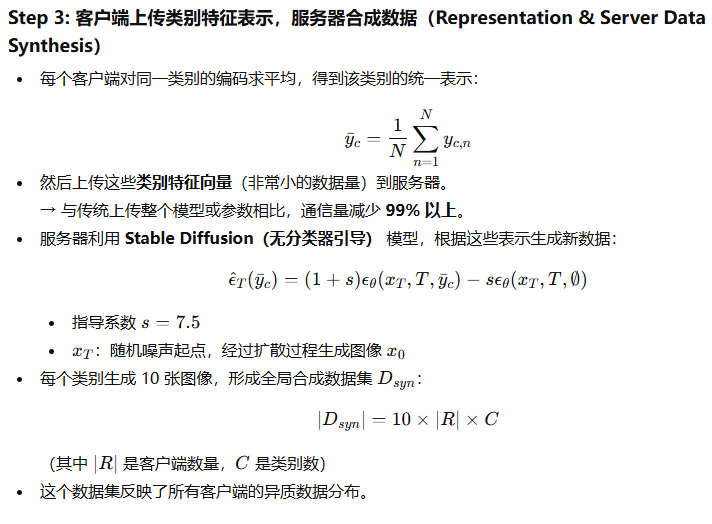

⚙️ 二、OSCAR 总体流程(四个步骤)

论文中提到 OSCAR 流程可分为四步(如 Fig. 2 所示):

Step 1: 客户端生成数据描述(Description Generation)

每个客户端不再训练分类器(区别于传统的 classifier-guided 方法)。

而是用视觉语言模型(VLM)BLIP 为本地图片生成文字描述。

例如,一张猫的图片可能生成描述 “a small orange cat sitting on a couch”。

| 对比维度 | 传统FL / OSFL | OSCAR创新 |

|---|---|---|

| 客户端任务 | 模型训练 + 分类器训练 | 仅生成描述和编码,无需训练 |

| 通信负载 | 高(上传模型参数) | 极低(上传特征向量) |

| 生成模型类型 | 分类器引导DM | 无分类器扩散模型 |

| 服务器端任务 | 模型聚合或蒸馏 | 通过Stable Diffusion生成全局数据 |

| 数据异质性适应 | 弱 | 强(特征条件生成) |

| 效果 | 需多轮通信 | 一轮即可达到SOTA性能 |

实验准备

🧩 一、Datasets(数据集)

作者使用了三个具有代表性的数据集来评估 OSCAR 的性能:

1️⃣ NICO++ [37]

图像大小:224×224,包含 60 个类别。

每个类别都有来自不同域(domain)的图像,用于模拟数据异质性。

有两种设置:

Common NICO++:所有类别共享相同的 6 个域

→[autumn, dim, grass, outdoor, rock, water]Unique NICO++:每个类别拥有自己独特的域集合

→ 更强的非IID特性(客户端间数据差异更大)。

🔍 用途:测试模型在异构环境下(数据分布不同)学习的能力。

2️⃣ DomainNet [38]

包含 345 个类别,跨越 6 个域(如 clipart、real、sketch、painting 等)。

作者选用了其中 90 个类别的子集。

🔍 用途:用于多领域的跨域泛化实验。

3️⃣ OpenImage [39]

一个多任务数据集,包含 600 个类别,共 170 万张图像。

本实验选用了 120 个类别的子集(参照 [13] 的预处理方式)。

🔍 用途:评估 OSCAR 在大规模、多类别场景下的表现。

⚙️ 二、Data Division(数据划分方式)

作者采用 非独立同分布(non-IID) 的划分策略,以更贴近真实的联邦学习场景。

总体原则:每个客户端的数据来自不同域或类别分布。

具体划分:

NICO++ 和 DomainNet:

每个客户端仅拥有每个类别的一个特定域的数据(例如客户端A有“dog-autumn”,客户端B有“dog-water”)。

→ 造成 特征分布偏移(feature distribution skew)。OpenImage:

将 120 个类别划分为 6 个子组,每个客户端从每个子组中选 1 个类别。

→ 保证每个客户端都有不同类别的数据。

客户端数量固定为 6,与上述数据集的域数一致。

🔍 目的:在数据强异质(non-IID)环境下验证 OSCAR 的稳健性。

⚖️ 三、Baselines(对比方法)

为了验证 OSCAR 的有效性,作者选择了三类基线方法:

1️⃣ Local Learning(本地学习)

每个客户端独立训练模型,不进行任何通信或协作。

代表“无联邦学习”的下界。

2️⃣ Traditional Federated Learning(传统联邦学习)

使用多轮通信的经典算法:

FedAvg [1]:标准联邦平均算法;

FedProx [40]:在本地目标函数中加入近端项以稳定训练;

FedDyn [41]:通过动态正则化缓解客户端漂移问题。

3️⃣ DM-assisted OSFL(基于扩散模型的一次性联邦学习)

FedDISC [26] 与 FedCADO [13]:

使用扩散模型生成辅助数据;

需要在客户端训练分类器或生成器(带来额外计算负担)。

🔍 对比目的:展示 OSCAR 在无需分类器、通信量更低的情况下能否达到或超越这些最先进方法。

✅ 总结

这段主要讲:

作者在三个具有代表性的数据集(NICO++、DomainNet、OpenImage)上进行实验,采用非IID数据划分(每个客户端数据分布不同),并将 OSCAR 与多种基线方法进行对比,包括本地训练、传统联邦学习方法(FedAvg/FedProx/FedDyn)以及基于扩散模型的最新一次性联邦学习方法(FedDISC、FedCADO)。

实验结果

🧩 a) Main Results(主要结果)

这一部分介绍了 OSCAR 与各基线方法的整体性能对比。

实验设置与对比方法

所有方法都在四个基准数据集上进行比较。

本地学习(Local) 和 传统FL方法(FedAvg、FedProx、FedDyn):

→ 使用原始真实图像训练。DM辅助方法(FedCADO、FedDISC) 以及 OSCAR:

→ 使用扩散模型合成数据训练全局模型。所有测试均在真实测试集上进行评估。

性能指标为 Top-1 Accuracy(准确率)。

主要发现

OSCAR 在所有数据集上都优于基线方法(见 Table I)。

不仅平均准确率更高,在不同域(domain)或客户端的测试集上也表现更优。

在 NICO++ 与 OpenImage 等真实图像数据集上提升更明显。

在 DomainNet 的素描(sketch)和卡通(clipart)域上略低,但传统FL方法在这些域上也表现不佳。

实验细节

所有实验的分类器均为 ResNet-18。

每个客户端每类图片数量固定为 30。

✅ 总结:

OSCAR 在四个基准数据集上均优于传统FL和其他DM辅助OSFL方法,在非IID场景下展现出稳定的全局性能。

🧠 b) Classifier Networks(不同分类器结构的影响)

这一部分分析不同模型架构对合成数据性能的影响。

主要内容

主实验使用 ResNet-18,便于与现有方法比较。

为验证生成数据的潜力,作者在 NICO++ Unique/Common 数据集上尝试不同模型:

ResNet 系列(如 ResNet-50, ResNet-101)

Vision Transformer (ViT B-16)

结果(见 Table II)显示:

更强的网络(如 ResNet-101、ViT-B16)能更好利用合成数据;

随着每类样本数增加,性能进一步提升。

✅ 结论:

OSCAR 生成的数据质量较高,可被更复杂模型更好地利用,从而提升全局模型性能。

📊 c) Number of Generated Images(生成样本数量的影响)

这一部分分析生成数据数量对模型性能的影响。

主要发现

随着生成样本数量增加,模型准确率最初上升;

当样本数超过一定阈值后,性能趋于稳定甚至略有下降。

说明生成数据的作用主要是辅助增强(auxiliary),而非完全替代真实数据。

✅ 结论:

生成数据在合理规模下有助于性能提升,但过多样本不会带来持续收益,可能引入噪声或冗余信息。

📡 d) Communication Analysis(通信开销分析)

这一部分展示了 OSCAR 的通信效率优势。

核心结果

OSCAR上传的参数量最少,因为:

客户端只需上传类别特征编码(512维);

不需要上传分类器或模型权重。

对比:

FedCADO:每个客户端上传约 1169万参数(11.69M);

FedDISC:比 FedCADO 减少 60% 以上,但仍比 OSCAR 大约 100 倍;

OSCAR:每类只需上传 512个参数,上传量不足1%。

随着客户端数量增加,OSCAR 的优势更加显著。

✅ 结论:

OSCAR 在保持高性能的同时,大幅降低通信负担(>99% 减少),适合大规模、低带宽的联邦环境。

🏁 总体总结

这部分主要展示了 OSCAR 在性能、可扩展性和通信效率上的全面优势:

维度 | 结果总结 |

|---|---|

模型准确率 | 所有数据集均优于基线方法 |

模型结构适应性 | 生成数据能被更强网络充分利用(ResNet-101、ViT表现最好) |

生成数据量影响 | 性能先升后稳,生成数据最适合作为辅助训练数据 |

通信成本 | 上传参数量减少 ≥99%,远低于现有方法(FedCADO/FedDISC) |