人工智能风险与伦理(3)

三、AI 依赖

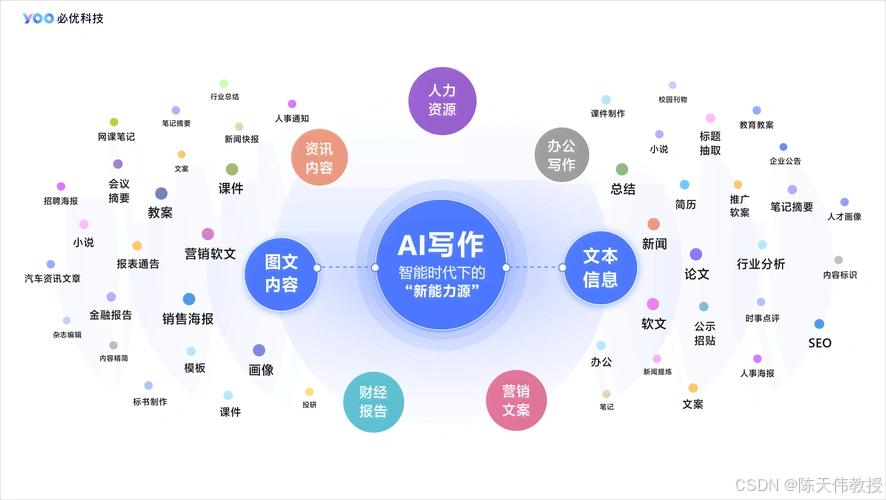

随着人工智能的功能日益强大,人们对其依赖度也不断攀升:文秘人员用 AI 撰写文稿,教育工作者用 AI设计课程,科研人员用 AI 润色论文,学生用 AI 解答作业⋯⋯然而,过度依赖 AI 可能带来严重问题。

在教育领域,人工智能能给学生解题提供实时帮助,就像随时陪伴在身边的老师。然而,如果学生把所有作业都交给AI 来完成,就会失去自我提升的机会。老师可以让AI 辅助设计课程,但若完全依赖AI,难以培养自身的创造性和教学能力。

在科研领域,科研人员可以用人工智能协助思考解决方案或润色论文,但让AI 承担过多角色会影响自身的创新能力养成,也引发学术公平性的担忧(如部分人甚至用 AI 审稿)

更令人忧虑的是,当前的人工智能并不完美,特别在回答一些事实性问题时常常出错。若毫无保留地相信其生成结果,势必带来严重后果。例如,部分学校让AI 替代教师答疑,但一旦答案出错,就会误导学生;还有研究者利用AI 大段生成论文或图书内容,却不做仔细核查地快速发表,可能污染人类的知识源头,形成恶性循环。

为应对这种风险,《自然·机器智能》杂志在 2024 年 11 月的一篇文章中提出“AI 生成内容的署名原则”,包括:(1)人类作者须对 AI 生成内容负责;(2)人类作者需有足够贡献;(3)人类作者应声明 AI 在科研各环节中的贡献。虽然这些原则是有价值的,但很难保证所有作者自觉遵守;一些投机者可能会利用AI 低成本生产海量垃圾内容,不仅破坏学术公平,还动摇科学界历经多年建立的信任体系。类似风险在新闻报道、技术论坛、百科资源等领域同样存在。倘若将来大多数内容都由 AI 生成且真假难辨,后果不堪设想。

目前,研究团队也在研发能够检测 AI 生成内容的工具,如 TraceGPT、WinstonAI、Hive、GPTZero。但 2023年 12 月发表于《国际教育诚信期刊》的研究表明,这些工具对学术论文的检测既不精确也不可靠,漏判率极高。