YOLO26:面向实时目标检测的关键架构改进与性能基准测试

原文链接戳这里!!!

YOLO26:面向实时目标检测的关键架构改进与性能基准测试

兰詹·萨普科塔¹、拉胡尔·哈沙·切帕利²、阿贾伊·沙尔达²、马诺吉·卡尔基¹

¹美国纽约州伊萨卡市康奈尔大学生物与环境工程系,邮编14850

电子邮箱:rs2672@cornell.edu,mk2684@cornell.edu

²美国堪萨斯州曼哈顿市堪萨斯州立大学生物与农业工程系,邮编66502

2025年10月1日

摘要

本研究对Ultralytics YOLO26进行了全面分析,重点阐述其关键架构改进及在实时边缘目标检测场景下的性能基准测试。YOLO26于2025年9月发布,是YOLO系列最新、最先进的模型,专为在边缘设备和低功耗设备上实现高效性、准确性与部署就绪性而设计。本文依次详细介绍了YOLO26的架构创新,包括移除分布焦点损失(DFL)、采用端到端无非极大值抑制(NMS)推理、集成渐进式损失(ProgLoss)与小目标感知标签分配(STAL),以及引入MuSGD优化器以实现稳定收敛。除架构外,本研究还将YOLO26定位为多任务框架,支持目标检测、实例分割、姿态/关键点估计、定向检测与分类任务。文中呈现了YOLO26在NVIDIA Jetson Nano、Orin等边缘设备上的性能基准测试结果,并与YOLOv8、YOLOv11、YOLOv12、YOLOv13及基于Transformer的检测器进行对比。此外,本文还探讨了YOLO26的实时部署路径、灵活的导出选项(ONNX、TensorRT、CoreML、TFLite)以及INT8/FP16量化方案,重点展示了其在机器人、制造业和物联网(IoT)领域的实际应用案例,以体现跨行业适应性。最后,本文讨论了YOLO26的部署效率及更广泛的应用意义,并概述了YOLO26及整个YOLO系列的未来发展方向。

关键词:YOLO26;边缘人工智能(Edge AI);多任务目标检测;无NMS推理;小目标识别;你只看一次(You Only Look Once);目标检测;MuSGD优化器

1 引言

目标检测已成为计算机视觉领域最关键的任务之一,能够让机器在图像或视频流中定位并分类多个目标[1,2]。从自动驾驶、机器人技术到监控、医学影像、农业和智能制造业,实时目标检测算法都是人工智能(AI)应用的核心支撑[3,4]。在这些算法中,“你只看一次”(YOLO)系列已成为实时目标检测领域最具影响力的模型系列,兼具准确性与极高的推理速度[5,6,7,7]。自2016年推出以来,YOLO经历了多次架构迭代,每一代都在解决前代局限性的同时,融合了神经网络设计、损失函数和部署效率领域的前沿技术[5]。2025年9月发布的YOLO26是该进化历程中的最新里程碑,其引入了架构简化方案、新型优化器和增强的边缘部署能力,专为低功耗设备设计。

表1详细对比了从YOLOv1到YOLOv13及YOLO26的各版本模型,重点展示了它们的发布年份、关键架构创新、性能改进及开发框架。

(注:原文中此处标注了arXiv论文编号:arXiv:2509.25164v2 [cs.CV] 30 Sep 2025,及YOLO26官方源码链接:YOLO26: (Ultralytics YOLO26 Official Source Link),作者标注:SAPKOTA ET AL. 2025)

表1:YOLOv1至YOLOv13及YOLO26模型汇总:发布年份、架构、创新点与框架

| 模型(年份) | 关键架构创新与贡献 | 任务 | 框架 |

|---|---|---|---|

| YOLOv1(2015)[8] | 首个统一的单阶段目标检测器(单个网络同时处理边界框和类别概率) | 目标检测、分类 | Darknet |

| YOLOv2(2016)[9] | 引入多尺度训练;通过锚框维度聚类优化先验框(YOLO9000实现检测与分类联合任务) | 目标检测、分类 | Darknet |

| YOLOv3(2018)[10] | 采用带残差连接的更深层Darknet-53骨干网络;新增空间金字塔池化(SPP)模块与多尺度特征融合,提升小目标检测性能 | 目标检测、多尺度检测 | Darknet |

| YOLOv4(2020)[11] | 采用Mish激活函数;使用跨阶段部分网络(CSPDarknet-53)作为骨干网络,增强特征复用能力 | 目标检测、目标跟踪 | Darknet |

| YOLOv5(2020)(源码链接) | 由Ultralytics基于PyTorch实现;提供无锚框检测头选项;采用SiLU(Swish)激活函数和PANet颈部进行特征聚合 | 目标检测、实例分割(有限支持) | PyTorch(Ultralytics) |

| YOLOv6(2022)[12] | 采用嵌入自注意力机制的EfficientRep骨干网络;引入无锚框目标检测模式以提升效率 | 目标检测、实例分割 | PyTorch |

| YOLOv7(2022)[13] | 采用扩展型高效层聚合网络(E-ELAN)骨干网络与模型重参数化技术;集成基于Transformer的模块以支持更广泛任务(如跟踪) | 目标检测、目标跟踪、实例分割 | PyTorch |

| YOLOv8(2023)(源码链接) | Ultralytics下一代模型;采用新型C2f骨干网络与解耦检测头;融合生成式技术(基于GAN的增强)和全无锚框设计 | 目标检测、实例分割、全景分割、关键点估计 | PyTorch(Ultralytics) |

| YOLOv9(2024)[14] | 引入可编程梯度信息(PGI)以实现选择性学习;提出增强型高效层聚合网络(G-ELAN)以改进特征提取 | 目标检测、实例分割 | PyTorch |

| YOLOv10(2024)[15] | 通过一致的双分配训练策略实现端到端无NMS检测(移除后处理步骤) | 目标检测 | PyTorch |

| YOLOv11(2024)(源码链接) | 在骨干网络/颈部全流程采用C3k2 CSP瓶颈结构(小核CSP块)以提升效率;保留SPPF模块并引入C2PSA(带空间注意力的CSP)模块,聚焦关键区域;将YOLO扩展至姿态估计与定向目标检测任务 | 目标检测、实例分割、姿态估计、定向检测 | PyTorch(Ultralytics) |

| YOLOv12(2025)[16] | 注意力中心化架构:引入高效区域注意力模块(低复杂度全局自注意力)与残差型高效层聚合网络(R-ELAN)块,提升特征聚合能力;在保持YOLO速度的同时达到Transformer级别的准确性 | 目标检测 | PyTorch |

| YOLOv13(2025)[17] | 引入基于超图的自适应关联增强(HyperACE)模块,捕捉全局高阶特征交互;采用全流程聚合-分布(FullPAD)方案,增强网络全流程特征流动;使用深度可分离卷积降低复杂度 | 目标检测 | PyTorch |

| YOLOv26(2025)(源码链接) | Ultralytics边缘优化模型:通过原生端到端预测器移除NMS;移除分布焦点损失(DFL),实现更简洁、更快的推理;引入MuSGD优化器(SGD与Muon混合优化器),实现稳定且快速的收敛;显著提升小目标检测准确性,CPU推理速度较前代提升高达43%,适用于低功耗设备部署 | 目标检测、实例分割、姿态估计、定向检测、分类 | PyTorch(Ultralytics) |

YOLO框架由约瑟夫·雷德蒙(Joseph Redmon)及其团队于2016年首次提出,为目标检测领域带来了范式变革[8]。与R-CNN[18]、Faster R-CNN[19]等传统两阶段检测器(将区域提议与分类分离处理)不同,YOLO将检测任务构建为单一回归问题[20]。通过卷积神经网络(CNN)单次前向传播直接预测边界框和类别概率,YOLO在保证竞争力准确性的同时实现了实时速度[21,20]。这种高效性使YOLOv1在机器人技术、自主导航、实时视频分析等对延迟敏感的应用中极具吸引力。后续版本YOLOv2(2017)[9]和YOLOv3(2018)[10]在保留实时性能的基础上显著提升了准确性。YOLOv2引入了批量归一化、锚框和多尺度训练,增强了对不同目标尺寸的鲁棒性;YOLOv3采用基于Darknet-53的更深层架构,并结合多尺度特征图以改进小目标检测。这些改进使YOLOv3在数年内成为学术和工业应用的默认标准[22,5,23]。

随着对准确性需求的不断提升(尤其是在航空影像、农业、医学分析等复杂领域),YOLO模型向更先进的架构方向发展。YOLOv4(2020)[11]引入了跨阶段部分网络(CSPNet)、Mish等改进型激活函数,以及马赛克数据增强、CIoU损失等先进训练策略。YOLOv5(由Ultralytics于2020年推出,非官方版本)凭借其PyTorch实现、广泛的社区支持以及在不同平台上的简化部署特性,获得了极高的关注度。YOLOv5还具备模块化特性,便于适配分割、分类和边缘应用场景。后续发展包括YOLOv6[12]和YOLOv7[13](2022年),它们集成了先进优化技术、参数高效模块和受Transformer启发的块结构。这些迭代使YOLO在逼近当前最优(SoTA)准确性基准的同时,始终聚焦实时推理。至此,YOLO生态系统已牢固确立其在目标检测研究与部署领域的领先地位。

作为现代YOLO版本的主要维护者,Ultralytics通过YOLOv8(2023)[24]重新定义了该框架。YOLOv8采用解耦检测头、无锚框预测和优化的训练策略,在准确性和部署灵活性上均实现了大幅提升[25]。其简洁的Python API、与TensorRT、CoreML、ONNX的兼容性,以及针对速度-准确性权衡优化的多版本(nano、small、medium、large、extra-large),使其在工业界得到广泛应用。YOLOv9[14]、YOLOv10[15]和YOLOv11随后快速迭代,每一代都突破了架构和性能的边界:YOLOv9引入通用高效层聚合网络(GELAN)和渐进式蒸馏,兼顾效率与更高的特征表达能力;YOLOv10通过混合任务对齐分配策略平衡准确性与推理延迟;YOLOv11进一步优化了Ultralytics的设计理念,在GPU上实现更高效率的同时保持了出色的小目标检测性能[5]。这些模型共同巩固了Ultralytics在生产级YOLO版本开发中的地位,使其能够适配现代部署流程。

继YOLOv11之后,YOLOv12[16]和YOLOv13[17]等衍生版本引入了注意力中心化设计和先进架构组件,力求在不同数据集上最大化准确性。这些模型探索了多头自注意力、改进的多尺度融合和更强的训练正则化策略,但仍依赖非极大值抑制(NMS)和分布焦点损失(DFL)——这两个组件会引入延迟开销和导出难题,尤其对低功耗设备不友好。基于NMS的后处理和复杂损失函数的局限性,推动了YOLO26的开发(Ultralytics YOLO26官方源码链接)。2025年9月,在伦敦举办的“YOLO Vision 2025”活动上,Ultralytics正式发布YOLO26,将其定位为面向边缘计算、机器人技术和移动AI的下一代模型。

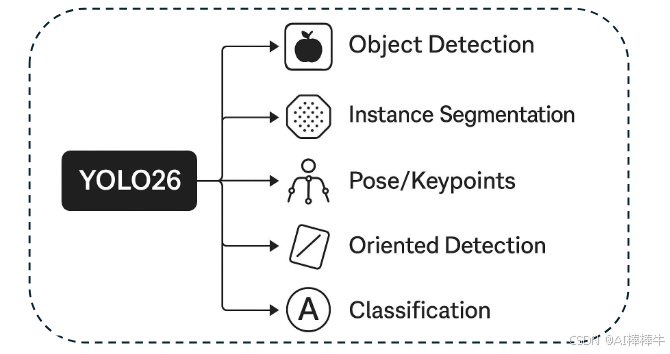

YOLO26的设计围绕三个核心原则:简洁性、高效性和创新性。图1概述了这些设计选择及其支持的五项任务:目标检测、实例分割、姿态/关键点检测、定向检测和分类。在推理路径上,YOLO26移除了NMS,通过原生端到端预测消除了主要后处理瓶颈,减少了延迟波动,并简化了跨部署场景的阈值调优。在回归方面,它移除了DFL,将分布式边界框解码转变为更轻量化、更适配硬件的形式,可顺畅导出至ONNX、TensorRT、CoreML和TFLite——这对边缘和移动部署流程而言是重要优势。这些改进共同打造了更精简的计算图、更快的冷启动速度和更少的运行时依赖,对CPU受限和嵌入式场景尤为有利。

训练稳定性和小目标检测精度通过两项技术解决:渐进式损失平衡(ProgLoss)和小目标感知标签分配(STAL)。ProgLoss通过自适应调整目标权重,避免训练后期模型过度拟合易检测样本;STAL优先为微小或遮挡目标分配标签,在航空影像、机器人视觉、智能摄像头等场景中(常见 clutter、 foliage 或运动模糊)提升召回率。优化过程由MuSGD驱动——这是一种混合优化器,融合了SGD的泛化能力与受Muon风格方法启发的动量/曲率特性,实现更快、更平稳的收敛,且在不同尺度下均能稳定达到性能平台期。

功能上(图1再次强调),YOLO26的五项能力共享统一的骨干网络/颈部结构和精简的检测头:

- 目标检测:无锚框、无NMS的边界框与得分输出

- 实例分割:轻量级掩码分支与共享特征耦合

- 姿态/关键点检测:用于人体或部件标志点的紧凑关键点检测头

- 定向检测:用于倾斜目标和细长目标的旋转边界框

- 分类:用于纯识别任务的单标签对数输出

这种整合式设计支持多任务训练或任务特定微调,无需重构架构;同时,简化的导出流程确保了跨加速器的可移植性。综上,YOLO26通过将端到端推理、无DFL回归与ProgLoss、STAL、MuSGD相结合,推动了YOLO系列的发展,最终实现了部署更快、训练更稳定、功能更广泛的模型(图1直观总结)。

图1:YOLO26统一架构支持五项关键视觉任务

(注:原文图1标题为“YOLO26 unified architecture supports five key vision tasks object detection, instance segmentation, pose/keypoints detection, oriented detection, and classification”,图中以“YOLO26”为中心,通过分支分别连接“Object Detection(目标检测)”“Instance Segmentation(实例分割)”“Pose/Keypoints(姿态/关键点检测)”“Oriented Detection(定向检测)”“Classification(分类)”五项任务,原文中标注“Classfication”为拼写误差,正确应为“Classification”)

2 YOLO26的架构改进

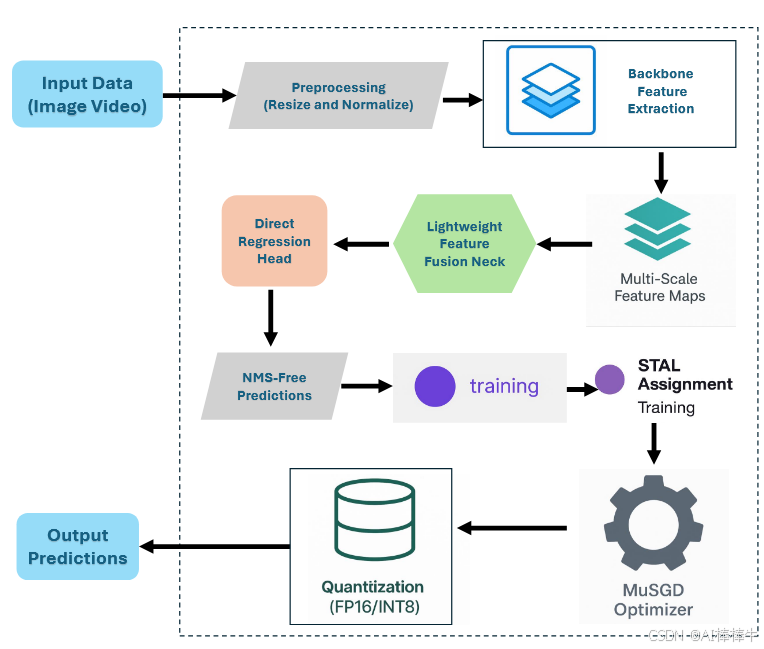

YOLO26的架构遵循精简高效的流程,专为边缘和服务器平台的实时目标检测设计。如图2所示,流程始于图像或视频流形式的输入数据,首先通过调整大小、归一化等预处理操作转换为适合模型推理的标准维度。随后,数据进入骨干网络特征提取阶段——紧凑且高性能的卷积网络在此捕捉视觉模式的层级表示。为增强跨尺度鲁棒性,该架构生成多尺度特征图(图2),保留对大、小目标均有效的语义信息。这些特征图随后传入轻量级特征融合颈部,以计算高效的方式整合信息。

检测专用处理在直接回归头中进行——与前代YOLO版本不同,该检测头无需依赖非极大值抑制(NMS),直接输出边界框和类别概率。这种端到端无NMS推理(图2)消除了后处理开销,加速了部署。训练稳定性和准确性通过ProgLoss平衡模块和STAL分配模块得到强化,前者确保损失项权重均衡,后者提升小目标检测性能。模型优化由MuSGD优化器引导,融合SGD和Muon的优势,实现更快、更可靠的收敛。

部署效率通过量化进一步提升,支持FP16(半精度)和INT8(整数精度)量化,可在CPU、NPU(神经网络处理单元)和GPU上实现加速,且准确性损失极小。最终,流程输出预测结果,包括可叠加在输入图像上可视化的边界框和类别分配。总体而言,YOLO26的架构体现了精心平衡的设计理念,在准确性、稳定性和部署简洁性上同时实现突破。

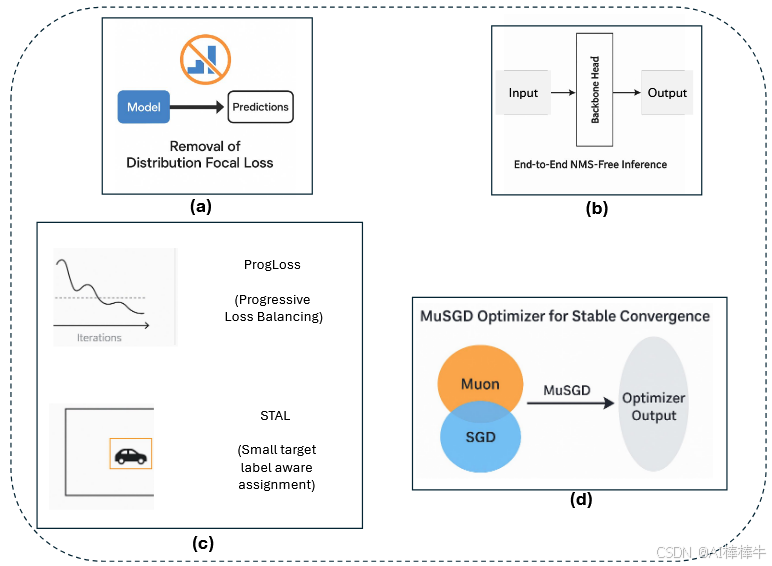

YOLO26引入了多项关键架构创新,使其区别于前代YOLO模型。这些改进不仅提升了训练稳定性和推理效率,还从根本上重塑了实时边缘设备的部署流程。本节将详细介绍YOLO26的四大核心贡献:(1)移除分布焦点损失(DFL);(2)引入端到端无NMS推理;(3)创新损失函数策略(包括渐进式损失平衡ProgLoss和小目标感知标签分配STAL);(4)开发MuSGD优化器以实现稳定高效收敛。每个改进均会详细阐述,并通过对比分析突出其相较于YOLOv8、YOLOv11、YOLOv12、YOLOv13等前代版本的优势。

(注:原文中此处标注作者信息:YOLO26: (Ultralytics YOLO26 Official Source Link),SAPKOTA ET AL. 2025)

图2:Ultralytics YOLO26简化架构图

(注:原文图2为流程图形式,各模块及连接关系如下)

输入层:Input Data (Image/Video)(输入数据:图像/视频)

预处理层:Feature Extraction (Resize and Normalize)(特征提取:调整大小与归一化)

骨干网络层:Backbone(骨干网络)→ 输出Multi-Scale Feature Maps(多尺度特征图)

颈部网络层:Lightweight Feature Fusion Neck(轻量级特征融合颈部)

检测头层:Direct Regression Head(直接回归头)

训练优化模块:NMI training(NMI训练)、STAL Assignment(STAL分配)、Optimizer MuSGD(MuSGD优化器)

量化模块:Quantization (FP16/INT8)(量化:FP16/INT8)

输出层:NMS-Free Predictions(无NMS预测)→ Output Predictions(输出预测结果)

2.1 移除分布焦点损失(DFL)

YOLO26最显著的架构简化之一是移除了分布焦点损失(DFL)模块(图3a)——该模块在YOLOv8、YOLOv11等前代YOLO版本中均有保留。DFL最初设计用于通过预测边界框坐标的概率分布来改进边界框回归,从而实现更精确的目标定位。尽管该策略在早期模型中提升了准确性,但也引入了显著的计算开销和导出难题:在推理和模型导出过程中,DFL需要特殊处理,这使得面向ONNX、CoreML、TensorRT、TFLite等硬件加速器的部署流程变得复杂。

通过移除DFL,YOLO26简化了模型架构,使边界框预测成为更直接的回归任务,且未牺牲性能。对比分析表明,YOLO26(尤其结合ProgLoss、STAL等其他创新)的准确性与基于DFL的YOLO模型相当,甚至更优。此外,移除DFL大幅降低了推理延迟,提升了跨平台兼容性——这对边缘AI场景至关重要,因为此类场景对轻量化、硬件友好型模型的需求极高。

相比之下,YOLOv12、YOLOv13等模型仍在架构中保留DFL,尽管它们在GPU资源丰富的环境中表现出出色的准确性基准,但在受限设备上的适用性受到限制。因此,YOLO26的这一改进标志着目标检测领域的关键一步:将当前最优性能与移动、嵌入式、工业应用的实际需求对齐。

2.2 端到端无NMS推理

YOLO26的另一项突破性特征是原生支持端到端推理,无需非极大值抑制(NMS)(参考图3b)。包括YOLOv8至YOLOv13在内的传统YOLO模型,在很大程度上依赖NMS作为后处理步骤——通过保留置信度最高的边界框,过滤掉重复预测。尽管NMS有效,但它为流程增加了额外延迟,且需要手动调整交并比(IoU)阈值等超参数。这种对人工设计后处理步骤的依赖,导致部署流程存在不稳定性,尤其对边缘设备和延迟敏感型应用不利。

YOLO26通过重新设计预测头,直接输出无冗余的边界框预测,彻底摆脱了对NMS的依赖。这种端到端设计不仅降低了推理复杂度,还消除了对人工调优阈值的依赖,简化了向生产系统的集成。对比基准测试表明,YOLO26的推理速度优于YOLOv11和YOLOv12,其中nano版本的CPU推理时间减少了高达43%。这一优势使YOLO26特别适用于移动设备、无人机(UAV)和嵌入式机器人平台——在这些场景中,毫秒级的延迟差异可能对操作产生重大影响。

除速度外,无NMS方案还提升了可复现性和部署可移植性,因为模型不再需要复杂的后处理代码。尽管RT-DETR、Sparse R-CNN等其他先进检测器也尝试过无NMS推理,但YOLO26是首个采用该范式且仍保持YOLO标志性“速度-准确性平衡”的YOLO版本。与仍依赖NMS的YOLOv13相比,YOLO26的端到端流程是面向实时检测的前瞻性架构。

2.3 ProgLoss与STAL:提升训练稳定性与小目标检测性能

训练稳定性和小目标识别仍是目标检测领域的核心挑战。YOLO26通过集成两项创新策略解决这些问题:渐进式损失平衡(ProgLoss)和小目标感知标签分配(STAL)(如图3c所示)。

ProgLoss在训练过程中动态调整不同损失组件的权重,确保模型不会过度拟合占比高的目标类别,同时避免对稀有或小目标类别预测性能不足。这种渐进式权重调整提升了模型的泛化能力,并防止训练后期出现不稳定性。STAL则专门优先为小目标分配标签——小目标由于像素占比低、易受遮挡,一直是检测难点。ProgLoss与STAL协同作用,使YOLO26在COCO、无人机影像等含小目标或遮挡目标的数据集上,准确性得到显著提升。

相比之下,YOLOv8、YOLOv11等早期模型未集成此类针对性机制,往往需要依赖数据集特定增强或外部训练技巧才能实现可接受的小目标检测性能。YOLOv12、YOLOv13尝试通过注意力模块和增强型多尺度特征融合解决这一问题,但这些方案增加了架构复杂度和推理成本。YOLO26则以更轻量化的方式实现了相当甚至更优的改进,进一步强化了其对边缘AI应用的适用性。通过集成ProgLoss和STAL,YOLO26在保持YOLO系列效率与可移植性的同时,成为一款鲁棒的小目标检测器。

2.4 用于稳定收敛的MuSGD优化器

YOLO26的最后一项创新是引入MuSGD优化器(图3d)——该优化器融合了随机梯度下降(SGD)的优势与最新提出的Muon优化器(受大型语言模型(LLM)训练优化策略启发)的特性。MuSGD既保留了SGD的鲁棒性和泛化能力,又融入了Muon的自适应特性,实现了更快的收敛速度和更稳定的优化过程,且在不同数据集上均能保持一致性能。

这种混合优化器体现了现代深度学习的重要趋势:自然语言处理(NLP)与计算机视觉领域的技术交叉融合。通过借鉴LLM训练实践(如Moonshot AI的Kimi K2),YOLO26获得了YOLO系列此前未探索过的稳定性增强。实验结果表明,MuSGD使YOLO26能以更少的训练轮次达到具备竞争力的准确性,同时减少训练时间和计算成本。

YOLOv8至YOLOv13等前代YOLO版本依赖标准SGD或AdamW变体优化器。这些优化器虽有效,但需要大量超参数调优,且在高变异性数据集上有时会出现收敛不稳定的问题。相比之下,MuSGD在保持YOLO轻量化训练理念的同时提升了可靠性。对开发者而言,这意味着更短的开发周期、更少的训练重启次数,以及在不同部署场景下更可预测的性能。通过集成MuSGD,YOLO26不仅成为推理优化型模型,还成为研究人员和工业界开发者友好的训练型架构。

图3:YOLO26的关键架构改进

(注:原文图3包含4个子图,分别对应4项核心改进,各子图说明如下)

- 图3a(Removal of Distribution Focal Loss):移除分布焦点损失(DFL),简化边界框回归流程,提升效率与导出兼容性

- 图3b(End-to-End NMS-Free Inference):端到端无NMS推理,消除后处理瓶颈,实现更快、更简洁的部署

- 图3c(ProgLoss and STAL):ProgLoss(渐进式损失平衡)与STAL(小目标感知标签分配),提升训练稳定性,显著改进小目标检测准确性

- 图3d(MuSGD Optimizer):MuSGD优化器融合SGD与Muon的优势,实现更快、更稳定的训练收敛(图中通过迭代次数(Iterations)与输出(Output)的关系曲线,对比了Muon、MuSGD、SGD三种优化器的收敛效果)

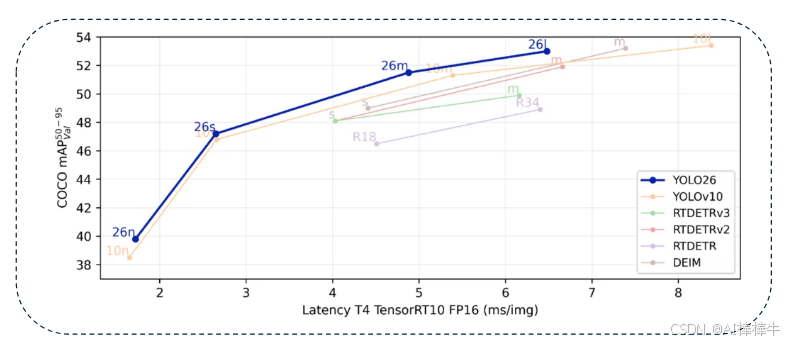

3 基准测试与对比分析

针对YOLO26,本研究开展了一系列严格的基准测试,以评估其相较于YOLO前代版本及其他当前最优架构的性能。图4综合展示了该评估结果,在搭载TensorRT FP16优化的NVIDIA T4 GPU上,绘制了COCO数据集平均精度均值(mAP,IoU阈值50–95)与延迟(每幅图像毫秒数)的关系。测试中纳入了YOLOv10、RT-DETR、RT-DETRv2、RT-DETRv3、DEIM等竞争架构,全面呈现了实时检测领域的最新进展。

从图中可见,YOLO26展现出独特的性能定位:其准确性可与RT-DETRv3等基于Transformer的模型媲美,同时在推理速度上显著超越这些模型。例如,YOLO26-m(中等规模版本)和YOLO26-l(大规模版本)的mAP分别超过51%和53%,且延迟大幅降低——这充分体现了其无NMS架构和轻量化回归头的优势。

这种“准确性-速度平衡”对边缘部署尤为重要,因为此类场景中,保持实时吞吐量与确保可靠检测质量同等关键。与YOLOv10相比,YOLO26在各模型规模下均实现了更低延迟,CPU受限推理场景下速度提升高达43%,同时通过ProgLoss和STAL机制保持甚至提升了准确性。与DEIM、RT-DETR系列(严重依赖Transformer编码器和解码器)相比,YOLO26简化的骨干网络和MuSGD驱动的训练流程,在实现更快收敛和更精简推理的同时,未牺牲小目标识别性能。

图4清晰展示了这些差异:尽管RT-DETRv3在大规模准确性基准测试中表现出色,但其延迟特性远不及YOLO26——这进一步印证了YOLO26“边缘中心化”的设计理念。此外,基准测试分析凸显了YOLO26在“准确性-延迟曲线”上的鲁棒性,使其成为同时适用于高吞吐量服务器应用和资源受限设备的通用检测器。这些对比证据证实,YOLO26并非简单的增量更新,而是YOLO系列的范式变革,成功弥合了早期YOLO模型“效率优先”理念与基于Transformer检测器“准确性优先”定位之间的差距。最终,基准测试结果表明,YOLO26在部署上具备显著优势,尤其适用于对延迟有严格限制且需可靠性能的实际场景。

(注:原文中此处标注作者信息:YOLO26: (Ultralytics YOLO26 Official Source Link),SAPKOTA ET AL. 2025)

图4:YOLO26与YOLOv10、RT-DETR、RT-DETRv2、RT-DETRv3、DEIM在COCO数据集上的性能基准测试

(注:原文图4为散点图,坐标轴及数据点说明如下)

- 纵轴(Y轴):COCO mAP(50–95)(COCO数据集平均精度均值,IoU阈值50至95),数值范围38–54

- 横轴(X轴):Latency T4 TensorRT10 FP16 (ms/img)(搭载TensorRT 10 FP16优化的NVIDIA T4 GPU上的延迟,单位:毫秒/图像),数值范围2–8

- 数据点:

- YOLO26系列:包含“26n”(nano版本)、“26s”(small版本)、“26m”(medium版本)、“26l”(large版本),mAP分别约40%、44%、51%、53%,延迟分别约2ms、3ms、4ms、6ms

- 其他模型:YOLOv10(含“10n”版本,mAP约40%,延迟约3ms)、RT-DETRv3(mAP约52%,延迟约7ms)、RT-DETRv2(mAP约50%,延迟约6ms)、RT-DETR(mAP约48%,延迟约8ms)、DEIM(mAP约38%,延迟约2ms)、R18(未明确模型全称,mAP约46%,延迟约3ms)

- 结论:YOLO26在准确性与效率间实现了更优平衡,在保持竞争力检测性能的同时显著降低延迟,凸显其对实时边缘及资源受限部署场景的适用性

4 Ultralytics YOLO26的实时部署

过去十年,目标检测模型的发展不仅体现在准确性提升上,还伴随着部署复杂度的增加[26,27,28]。R-CNN及其快速变体(Fast R-CNN、Faster R-CNN)等早期检测器虽实现了出色的检测质量,但计算成本高昂,需通过多阶段处理完成区域提议与分类[29,30,31]——这限制了它们在实时和嵌入式应用中的使用。YOLO系列的出现改变了这一局面:通过将检测任务重构为单一回归问题,YOLO在商用GPU上实现了实时性能[32]。然而,随着YOLO从v1迭代至v13,准确性提升往往伴随着架构复杂度的增加(如引入分布焦点损失DFL、非极大值抑制NMS等复杂后处理步骤、更厚重的骨干网络),为部署带来阻碍。YOLO26通过同时简化架构和导出路径,直接解决了这一长期挑战,降低了跨硬件和软件生态系统的部署门槛。

(注:原文中此处标注作者信息:YOLO26: (Ultralytics YOLO26 Official Source Link),SAPKOTA ET AL. 2025)

4.1 灵活的导出与集成路径

YOLO26的核心优势之一是能无缝集成到现有生产流程中。Ultralytics维护着一个活跃开发的Python包,提供训练、验证、导出的统一支持,降低了开发者采用YOLO26的技术门槛。与早期YOLO模型(需通过大量自定义转换脚本实现硬件加速[33,34,35])不同,YOLO26原生支持多种导出格式,包括:

- TensorRT:用于GPU最大加速

- ONNX:用于广泛的跨平台兼容性

- CoreML:用于iOS原生集成

- TFLite:用于Android和边缘设备

- OpenVINO:用于Intel硬件优化性能

这些丰富的导出选项使研究人员、工程师和开发者能够轻松实现从原型设计到生产部署的过渡,无需面对前代模型常见的兼容性瓶颈。

历史上,YOLOv3至YOLOv7在导出过程中(尤其面向NVIDIA TensorRT、Apple CoreML等专用推理引擎时)常需人工干预[36,37];类似地,DETR及其衍生的基于Transformer的检测器,由于依赖动态注意力机制,在PyTorch环境外转换时也面临挑战。相比之下,YOLO26通过移除DFL和采用无NMS预测头简化了架构,确保跨平台兼容性的同时未牺牲准确性。这使YOLO26成为迄今为止部署友好性最高的检测器之一,进一步巩固了其“边缘优先”的模型定位。

4.2 量化与资源受限设备

除导出灵活性外,实际部署的核心挑战在于确保在计算资源有限的设备上的效率[27,38]。智能手机、无人机、嵌入式视觉系统等边缘设备通常缺乏独立GPU,必须在内存、功耗和延迟约束间寻求平衡[39,40]。量化是降低模型大小和计算负载的广泛采用策略,但许多复杂检测器在激进量化下会出现显著的准确性损失——YOLO26的设计已考虑到这一限制。

得益于精简的架构和简化的边界框回归流程,YOLO26在半精度(FP16)和整数(INT8)量化方案下均能保持稳定的准确性:

- FP16量化:利用GPU对混合精度算术的原生支持,在降低内存占用的同时实现更快推理

- INT8量化:将模型权重压缩为8位整数,大幅降低模型大小和能耗,且仍保持竞争力准确性

基准实验证实,YOLO26在这些量化级别下性能稳定,在相同条件下优于YOLOv11和YOLOv12。这一特性使YOLO26特别适合部署在紧凑硬件上,如NVIDIA Jetson Orin、高通骁龙AI加速器,甚至驱动智能摄像头的基于ARM的CPU。

相比之下,RT-DETRv3等基于Transformer的检测器在INT8量化下性能大幅下降[41],主要原因是注意力机制对精度降低极为敏感;YOLOv12、YOLOv13虽在GPU服务器上表现出出色准确性,但在低功耗设备上量化后难以保持竞争力性能。因此,YOLO26为目标检测领域的“量化感知设计”树立了新基准,证明架构简洁性可直接转化为部署鲁棒性。

4.3 跨行业应用:从机器人技术到制造业

这些部署改进的实际价值,可通过跨行业应用得到最佳体现。在机器人技术领域,实时感知对导航、操作和人机安全协作至关重要[42,43]。YOLO26的无NMS预测和稳定低延迟推理,使机器人系统能更快、更可靠地理解环境:例如,搭载YOLO26的机械臂可在动态条件下更高精度地识别和抓取目标;移动机器人在杂乱空间中对障碍物的识别能力也得到提升。与YOLOv8或YOLOv11相比,YOLO26的推理延迟更低——在高速场景中,这一差异可能决定操作的安全性(如避免碰撞)。

在制造业领域,YOLO26对自动化缺陷检测和质量保证具有重要意义。传统人工检测不仅人力成本高,还易受人为误差影响。YOLOv8等前代YOLO版本虽已在智能工厂部署,但导出复杂度和NMS延迟开销有时限制了大规模推广。YOLO26通过OpenVINO或TensorRT提供轻量化部署选项,使制造商能将实时缺陷检测系统直接集成到生产线中。早期基准测试表明,基于YOLO26的缺陷检测流程,在吞吐量上高于YOLOv12和DETR等基于Transformer的替代方案,且运营成本更低。

4.4 YOLO26部署的广泛启示

综上,YOLO26的部署特性凸显了目标检测领域的核心主题:架构效率与准确性同等重要。过去五年,从基于卷积的YOLO变体到DETR、RT-DETR等基于Transformer的检测器,模型复杂度不断提升,但实验室性能与生产就绪性之间的差距往往限制了它们的实际影响。YOLO26通过简化架构、扩展导出兼容性、确保量化鲁棒性,弥合了这一差距,使前沿准确性与实际部署需求对齐。

对移动应用开发者而言,YOLO26通过CoreML和TFLite支持无缝集成,确保模型在iOS和Android平台上原生运行;对在云端或本地服务器部署视觉AI的企业,TensorRT和ONNX导出提供了可扩展的加速选项;对工业和边缘用户,OpenVINO和INT8量化确保即使在资源严格受限的条件下,性能仍保持稳定。从这个角度看,YOLO26不仅是目标检测研究的进步,更是推动部署民主化的重要里程碑。

5 结论与未来方向

综上,YOLO26是YOLO目标检测系列的重大飞跃,融合了架构创新与务实的部署导向设计。该模型通过两项关键简化提升效率:一是移除分布焦点损失(DFL)模块,简化边界框回归流程,避免导出复杂问题,从而扩大硬件兼容性;二是实现端到端无NMS推理,使网络无需后处理步骤即可直接输出最终检测结果,既降低延迟,又简化部署流程——这是对早期YOLO理念的自然演进。

在训练方面,YOLO26引入渐进式损失平衡(ProgLoss)和小目标感知标签分配(STAL),前者稳定学习过程,后者提升对复杂场景中小目标的检测准确性;此外,融合SGD与Muon特性的新型MuSGD优化器,加速了收敛速度并提升了训练稳定性。这些改进协同作用,打造出一款准确性更高、鲁棒性更强、同时速度更快、轻量化程度更高的检测器。

基准测试对比表明,YOLO26相较于YOLO前代版本和同期模型均表现出色:YOLOv11在效率上超越更早版本,YOLOv12通过集成注意力机制进一步提升准确性,YOLOv13则借助超图优化实现额外改进;面对基于Transformer的竞争对手,YOLO26大幅缩小了性能差距——其原生无NMS设计借鉴了Transformer启发型检测器的端到端思路,同时保留了YOLO标志性的效率优势。YOLO26在保证竞争力准确性的同时,显著提升了主流硬件上的吞吐量,并降低了复杂度。事实上,YOLO26在CPU上的推理速度较前代YOLO版本提升高达43%,使其成为资源受限环境中最实用的实时检测器之一。这种“性能-效率”的和谐平衡,使YOLO26不仅在基准测试排行榜上表现优异,更能在速度、内存、能耗均受限的实际部署场景中脱颖而出。

YOLO26的核心贡献在于其对部署优势的重视。该模型的架构专为实际应用优化:通过省略DFL和NMS,规避了在专用硬件加速器上难以实现的操作,从而提升跨设备兼容性;支持ONNX、TensorRT、CoreML、TFLite、OpenVINO等多种导出格式,确保开发者能轻松将其集成到移动应用、嵌入式系统或云服务中。关键的是,YOLO26还支持稳健的量化方案——得益于简化的架构(可耐受低比特推理),其在INT8量化或FP16半精度部署下,准确性损失极小。这意味着模型可通过压缩实现加速,同时仍保持可靠的检测性能。这些特性转化为实际边缘性能的提升:从无人机到智能摄像头,YOLO26能在CPU和小型设备上实现实时运行,而前代YOLO模型在这些场景中往往表现不佳。所有这些改进体现了一个核心主题:YOLO26弥合了前沿研究理念与可部署AI解决方案之间的差距,彰显了其作为“学术创新与工业应用桥梁”的角色,将最新视觉技术直接交付到实践者手中。

(注:原文中此处标注作者信息:YOLO26: (Ultralytics YOLO26 Official Source Link),SAPKOTA ET AL. 2025)

5.1 未来方向

展望未来,YOLO及目标检测研究的发展轨迹呈现出多个有前景的方向:

(1)多视觉任务的进一步整合

YOLO26已支持目标检测、实例分割、姿态估计、定向边界框、分类五项任务,体现了“多任务通用性”的发展趋势。未来YOLO迭代可能进一步推动这一方向,将开放词汇(open-vocabulary)和基础模型(foundation-model)能力融入其中。这意味着可借助强大的视觉-语言模型,使检测器能以零样本(zero-shot)方式识别任意目标类别,摆脱固定标签集的限制。通过基于基础模型和大规模预训练,下一代YOLO有望成为通用视觉AI,无缝处理检测、分割甚至新目标的上下文描述任务。

(2)半监督与自监督学习的深度融合

当前最优检测器仍高度依赖大型标注数据集,但针对无标注或部分标注数据的训练方法研究正快速推进[44,45,46,47]。未来YOLO训练流程可能集成教师-学生训练[48,49,50]、伪标签[51,52]、自监督特征学习[53]等技术,减少对大规模人工标注的依赖。下一代YOLO或许能自动利用海量无标注图像或视频提升识别鲁棒性,在不按比例增加标注数据的情况下持续改进检测能力,从而更好地适配新领域或稀有目标类别。

(3)Transformer与CNN设计理念的融合

目标检测器领域可能继续融合Transformer与CNN的设计原则。近期YOLO模型的成功表明,向类YOLO架构中注入注意力机制和全局推理能力,可提升准确性[54,55]。未来YOLO架构可能采用混合设计:以卷积骨干网络实现高效局部特征提取,结合基于Transformer的模块或解码器捕捉长距离依赖和上下文信息。这种混合方案能通过建模纯CNN或简单自注意力难以捕捉的关系,提升模型对复杂场景(如拥挤环境或高上下文关联场景)的理解能力。预计下一代检测器将智能融合这些技术,在丰富特征表示与低延迟间取得平衡——“基于CNN”与“基于Transformer”检测器的界限将进一步模糊,取两者之长以应对多样化检测挑战。

(4)边缘感知训练与优化的强化

由于部署仍是核心关注点,未来研究可能重点关注“边缘感知训练与优化”。这意味着模型开发将从训练阶段就考虑硬件约束,而非仅在后期处理。例如,“量化感知训练”(在训练中模拟低精度算术)可确保模型量化至INT8后仍保持准确性;神经架构搜索和自动化模型压缩可能成为YOLO模型设计的标准流程,使每个新版本都能与特定目标平台协同设计。此外,将部署反馈(如设备延迟测量、能耗数据)纳入训练循环也是新兴方向:一款边缘优化的YOLO可能学会根据运行时约束动态调整深度或分辨率,或通过模型蒸馏从大型模型精简为小型模型(且性能损失极小)。通过在训练中融入这些考量,最终的检测器将在实际场景中实现更优的“准确性-效率”权衡。这种对“高效AI”的关注至关重要,因为目标检测器正越来越多地应用于物联网(IoT)、增强现实/虚拟现实(AR/VR)、自主系统等领域——这些场景对有限硬件上的实时性能有硬性要求。

注:本研究将在近期通过基准测试进一步评估YOLO26性能,对比对象包括YOLOv13、YOLOv12和YOLOv11。研究团队将使用机器视觉相机在农业环境中采集自定义数据集,包含10,000个以上人工标注的目标对象;在相同条件下训练各模型,并从精度(precision)、召回率(recall)、准确性(accuracy)、F1分数、平均精度均值(mAP)、推理速度、前后处理时间等维度报告结果。此外,将在NVIDIA Jetson设备上开展边缘计算实验,评估实时检测能力,为YOLO26在资源受限农业应用中的实际部署提供参考。