Prompt Engineering 关键技能:精准掌控 LLM 输出的格式、内容与风格

在大模型应用中,"得到答案" 只是基础,"得到符合预期格式、内容和风格的答案" 才是效率的关键。想象一下:让 LLM 生成的 JSON 直接被代码解析,让报告自动符合公司模板,让客服回复精准匹配品牌调性 —— 这些都需要通过 Prompt Engineering 实现对输出的精确控制。本文将系统拆解控制 LLM 输出的核心技能,从格式约束到内容雕琢,再到风格塑造,帮你从 "能用" 升级到 "善用" 大模型。

一、为什么要控制 LLM 的输出?

未经控制的 LLM 输出常常存在 "不确定性":格式混乱导致无法直接使用(如 JSON 缺括号)、内容冗余或遗漏关键信息、风格与场景不符(如用学术腔回复客户咨询)。这些问题会大幅增加后续处理成本 —— 据统计,开发者平均要花 30% 的时间清洗 LLM 输出,而精准控制能将这一比例降低至 5% 以下。

控制输出的本质是通过结构化提示缩小模型的 "决策空间":明确告诉模型 "必须输出什么格式"、"必须包含哪些内容"、"必须用什么风格表达",让模型的生成过程从 "自由创作" 转为 "按要求执行"。

二、精确控制输出格式:让机器读懂你的输出

格式控制是 Prompt Engineering 中最基础也最常用的技能,尤其在需要机器自动处理 LLM 输出的场景(如 API 集成、数据入库)中必不可少。核心目标是让输出结构化、无歧义、可直接解析。

1. 结构化格式:JSON、表格与自定义模板

(1)JSON 格式控制

JSON 是最常用的结构化格式,需明确指定字段、类型和约束条件。关键技巧:

- 用

{}标记 JSON 起始,避免多余文本- 列出必填字段及说明(如

"name": "用户姓名,字符串类型")- 提供示例(尤其字段复杂时)

- 强调 "不添加任何解释文本"

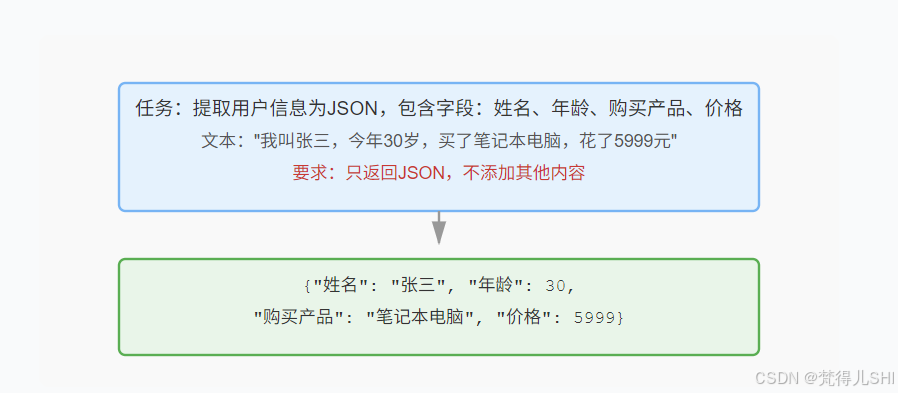

实战示例:

任务:从以下文本中提取用户信息,以JSON格式返回,包含字段:姓名、年龄、购买产品、价格(数字类型)。

文本:"我叫张三,今年30岁,昨天买了一台笔记本电脑,花了5999元。"

要求:只返回JSON,不添加其他内容。

模型响应:

{"姓名": "张三", "年龄": 30, "购买产品": "笔记本电脑", "价格": 5999}

(2)表格格式控制

适合展示结构化数据对比,需指定表头和行列规则。关键技巧:

- 用

|分隔单元格,---标记表头分隔线- 明确列数和每列含义

- 要求 "表格无多余边框,行列对齐"

示例:

将以下3种水果的信息整理成Markdown表格,包含列:名称、单价(元)、成熟季节。

信息:苹果单价8元,秋季成熟;香蕉单价5元,夏季成熟;橙子单价6元,冬季成熟。

模型响应:

| 名称 | 单价(元) | 成熟季节 |

|---|---|---|

| 苹果 | 8 | 秋季 |

| 香蕉 | 5 | 夏季 |

| 橙子 | 6 | 冬季 |

(3)自定义模板控制

针对特定业务场景(如报告、邮件),可预设模板让模型填充内容。关键技巧:

- 用

{{占位符}}标记需要填充的部分- 说明占位符的取值范围

- 强调 "严格按照模板结构,不增删段落"

示例:

按以下模板生成产品故障报告:

故障报告 产品名称:{{产品名}}

故障现象:{{具体描述}}

可能原因:1. {{原因1}} 2. {{原因2}}

解决方案:{{步骤}}

信息:用户反馈"新买的扫地机器人无法开机,充电时指示灯不亮"。

模型响应:

故障报告

产品名称:扫地机器人

故障现象:无法开机,充电时指示灯不亮

可能原因:1. 充电器接触不良 2. 电池故障

解决方案:1. 检查充电器插头是否插紧;2. 更换充电器尝试充电;3. 若仍无效,联系售后检测电池

2. 格式约束的核心技巧

| 技巧 | 作用 | 示例 |

|---|---|---|

| 明确分隔符 | 避免输出混杂其他内容 | " 用json和包裹 JSON 内容 " |

| 字段类型标注 | 确保数据类型正确(如数字、布尔值) | "价格": "数字类型,不带单位" |

| 错误兜底 | 处理信息不全的情况 | "若年龄未提及,用 null 表示" |

| 示例引导 | 复杂格式必用,降低模型理解成本 | 先给一个正确示例,再让模型模仿 |

三、精准控制输出内容:让信息不多不少,恰到好处

内容控制的目标是让 LLM 输出覆盖核心需求、排除无关信息、保证准确性。很多时候,模型输出质量差不是因为能力不足,而是因为你没说清楚 "要什么" 和 "不要什么"。

1. 控制内容范围:明确 "包含什么" 和 "排除什么"

(1)正向约束:指定必须包含的信息

通过 "必须包含 XX 点" 强制模型覆盖核心内容,尤其适合需要完整性的场景(如需求文档、检查清单)。

示例:

总结以下产品说明,必须包含:1. 核心功能;2. 适用人群;3. 注意事项。不超过200字。

产品说明:"智能手环B3支持心率监测、睡眠分析、运动计步,续航7天。适合上班族和运动爱好者使用。使用时需远离强磁场,充电时请使用原装充电器。"

模型响应:智能手环 B3 的核心功能包括心率监测、睡眠分析和运动计步,续航达 7 天。适用人群为上班族和运动爱好者。注意事项:使用时需远离强磁场,充电必须使用原装充电器。

(2)反向约束:指定必须排除的信息

通过 "不包含 XX" 过滤冗余内容,适合需要简洁性的场景(如摘要、快速回复)。

示例:

解释什么是"机器学习",要求:1. 不使用数学公式;2. 不提及具体算法名称;3. 用日常生活举例。

模型响应:机器学习是让计算机像人一样 "从经验中学习" 的技术。比如,手机相册能自动识别人脸,它通过分析大量标注好的照片,逐渐学会区分不同人的面部特征,下次看到新照片时就能准确识别,这个过程就像人通过多次见面记住朋友的样子。

2. 控制内容深度:从 "概要" 到 "细节" 的精准调节

通过关键词控制信息颗粒度,满足不同场景需求:

- 概要级:用 "简要说明"、"一句话总结"

- 中等深度:用 "分点说明(3-5 点)"、"核心步骤"

- 深度细节:用 "详细描述"、"每个步骤包含 XX 信息"

示例对比:

# 概要级

简要说明"如何煮米饭",不超过30字。

# 中等深度

分3步说明"如何煮米饭",每步不超过50字。

# 深度细节

详细说明"如何煮米饭",包含:米和水的比例、浸泡时间、火候控制、判断熟度的方法。

3. 控制内容准确性:减少幻觉与错误

LLM 有时会生成 "看似合理但错误" 的内容(即 "幻觉"),通过以下技巧降低风险:

- 限定信息来源:"仅基于以下文本回答,不添加外部信息"

- 标注不确定性:"若信息不明确,用 ' 可能 ' 标注并说明原因"

- 要求验证依据:"每个结论需引用文本中的具体句子"

示例:

基于以下文本回答:"人工智能首次击败人类围棋冠军是哪一年?

" 文本:"2016年3月,谷歌DeepMind开发的AlphaGo与围棋世界冠军李世石进行比赛并获胜,这是人工智能首次在围棋领域击败人类顶尖选手。"

要求:仅用文本中的信息回答,若文本未提及,回复"未提及"。

四、精细控制输出风格:让表达适配场景与对象

风格控制能让 LLM 的输出贴合场景氛围、匹配受众特征,在营销文案、客服沟通、内容创作等场景中至关重要。风格的核心要素包括:语气(正式 / 随意)、措辞(专业 / 通俗)、情感(积极 / 中性)、角色(专家 / 朋友)。

1. 语气与措辞控制

通过明确形容词指定语气,配合示例强化效果:

- 正式语气:"使用书面语,避免口语化表达,结构严谨"

- 随意语气:"像朋友聊天一样,用口语化表达,可加语气词"

- 专业措辞:"使用 XX 领域术语(如计算机领域的 ' 迭代 '、' 封装 ')"

- 通俗措辞:"用小学生能听懂的话解释,多举生活例子"

示例对比:

# 正式专业版

解释"区块链",使用金融领域术语,结构严谨,适合向投资人说明。

# 随意通俗版

解释"区块链",像和朋友聊天一样,用口语化表达,适合向长辈说明。

模型响应(正式专业版):区块链是一种去中心化的分布式账本技术,通过密码学算法实现交易记录的不可篡改与可追溯。其核心特性包括分布式存储、共识机制与智能合约,在金融领域可应用于跨境支付、供应链金融等场景,能降低信任成本与交易摩擦。

模型响应(随意通俗版):区块链就像一个大家共用的记事本,你记一笔,我记一笔,所有人都能看到,但谁也改不了之前的记录。比如你给朋友转钱,这笔账会被所有人记下来,想赖账都不行,这就是为啥大家说它靠谱。

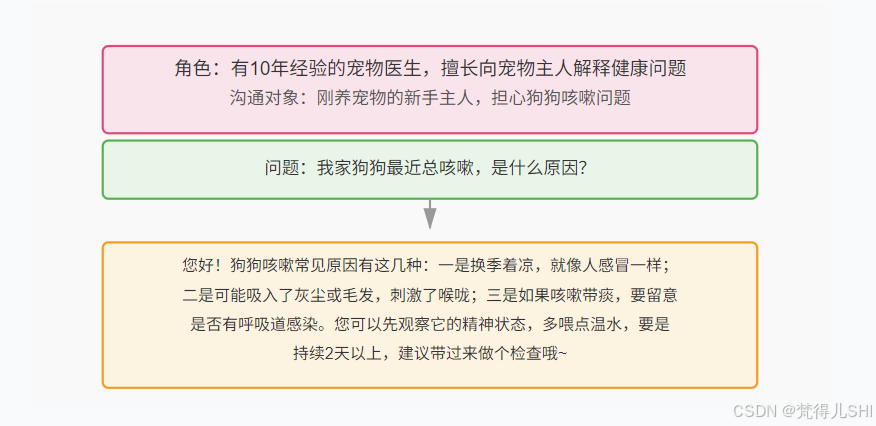

2. 角色绑定与风格迁移

给模型赋予具体角色,让其从角色视角输出内容,本质是激活模型对该角色的 "语言习惯记忆"。关键技巧:

- 角色细节越具体越好(如 "有 10 年经验的小学科学老师,擅长用实验举例")

- 明确角色的沟通对象(如 "向 6 岁儿童解释")

- 可附加角色的典型表达方式(如 "常用 ' 你看呀 '、' 咱们试试 ' 等句式")

五、实战技巧:当模型 "不听话" 时该怎么办?

即使掌握了上述方法,模型偶尔仍会 "跑偏"(如 JSON 格式错误、遗漏内容)。这时可采用以下进阶技巧:

-

逐步引导法:复杂任务拆分成多步提示,先让模型确认理解格式要求,再输出内容。

第一步:请重复我需要的JSON格式(包含字段:姓名、年龄)。

第二步:根据文本"小李今年25岁",按上述格式输出。

错误修正法:直接指出模型的错误并要求重写。

你输出的JSON缺少"年龄"字段,且"价格"应为数字类型(当前带了单位),请修正后重新输出。

-

冗余约束法:用多重约束强化格式要求(尤其对较笨的模型)。

必须输出JSON,用```包裹,字段不能缺失,值为数字的字段不能加引号,不允许任何解释文字,否则输出无效。

六、总结:控制输出的底层逻辑

控制 LLM 输出的核心不是 "命令",而是 "清晰的预期传递"。无论是格式、内容还是风格,本质都是通过以下方式缩小模型的生成空间:

- 明确边界:告诉模型 "能做什么" 和 "不能做什么"

- 提供示例:用具体案例展示 "正确的样子"

- 匹配场景:让模型理解 "输出将被如何使用"

练习建议:从日常任务开始(如让模型生成带格式的待办清单),逐步增加复杂度(如生成可直接入库的 JSON 数据),并记录模型 "不听话" 的场景 —— 这些场景正是你提升 Prompt 技能的关键突破口。

互动话题:你在控制 LLM 输出时遇到过哪些棘手问题?是如何解决的?欢迎在评论区分享你的经验!