深度解析英伟达DGX与HGX服务器——从架构差异到场景选择

一、DGX与HGX的深度区别解析

1 核心定位的本质差异

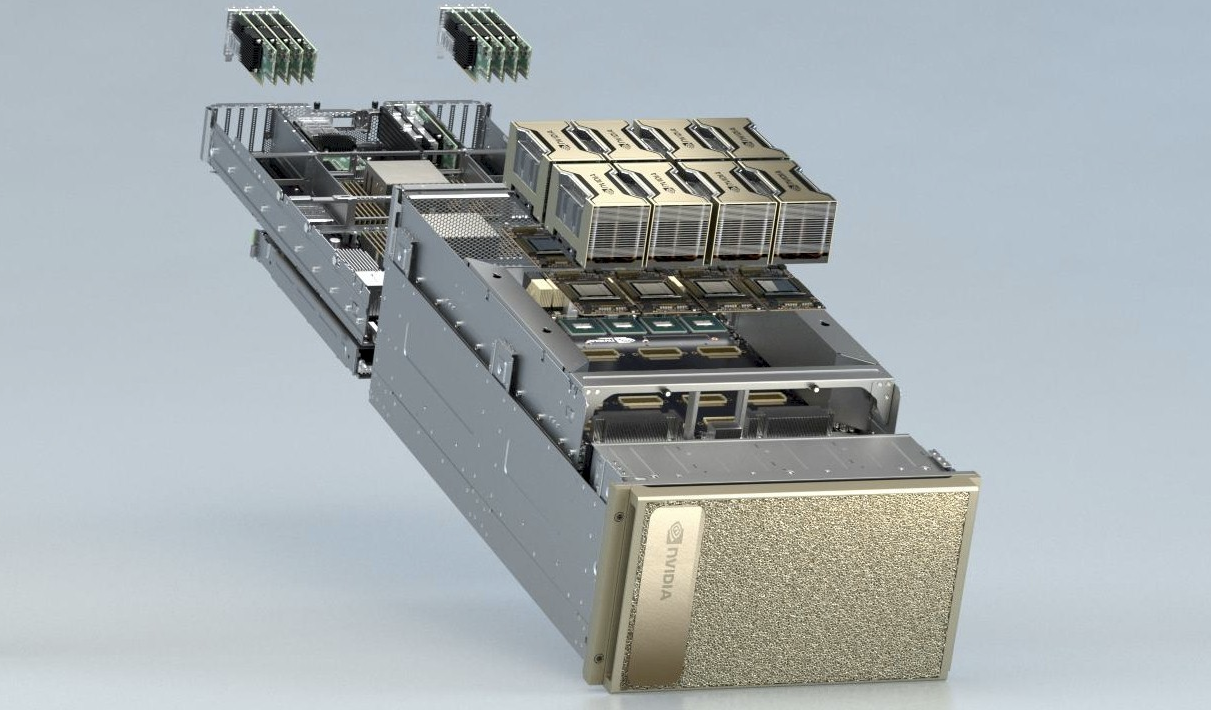

NVIDIA DGX:全栈式AI解决方案的集大成者

DGX代表了NVIDIA在AI计算领域的终极产品形态。它不仅仅是一台服务器,更是一个完整的AI工作流解决方案。从硬件到软件,从部署到运维,DGX提供了端到端的服务体验。这种"交钥匙工程"的理念,让用户能够专注于AI模型开发和业务应用,而无需担心底层基础设施的复杂性和兼容性问题。

NVIDIA HGX:模块化设计的基石平台

HGX的定位更加底层和灵活,它是NVIDIA为服务器制造商提供的"乐高积木"式参考设计。通过标准化GPU互联架构和基础板卡设计,HGX让合作伙伴能够在保持核心计算性能的同时,根据不同的应用场景和客户需求进行定制化开发。这种模式既保证了技术先进性,又兼顾了市场灵活性。

2 技术架构的详细对比

2.1. DGX系统架构特点:

硬件层面:

- 集成8颗最新一代的NVIDIA GPU(如H100、A100等)

- 采用NVIDIA NVLink高速互联技术,提供极高的GPU间通信带宽

- 配备专用的NVSwitch芯片,实现全互联拓扑结构

- 集成高性能网络接口(通常包括InfiniBand和以太网)

- 预装企业级存储解决方案(NVMe SSD等)

软件层面:

- 预装NVIDIA AI Enterprise软件套件

- 包含优化的深度学习框架(TensorFlow、PyTorch等)

- 集成NVIDIA Base Command平台,提供集群管理功能

- 包含预训练的AI模型和应用框架

- 提供完整的驱动和固件更新服务

2.2. HGX架构特点:

核心模块设计:

- 标准化的GPU板卡设计,支持4-8颗GPU

- 灵活的NVLink配置,支持不同规模的互联拓扑

- 模块化的基础板设计,便于集成到不同服务器机箱

- 标准化的接口定义,支持不同厂商的CPU和内存配置

定制化空间:

- 合作伙伴可自由选择CPU平台(Intel Xeon、AMD EPYC等)

- 灵活的内存配置和扩展能力

- 可定制的存储解决方案(SAS、SATA、NVMe等)

- 网络接口的灵活配置(不同速率的以太网、InfiniBand等)

3 产品形态的演进历程

NVIDIA DGX 与 HGX 产品演进对比

| 产品线 | 产品名称 | 发布年份 | 基于架构 | 核心特性与意义 |

|---|---|---|---|---|

| DGX 产品线 | DGX-1 | 2016 | Pascal | 首款专为深度学习设计的AI超级计算机,奠定了企业级AI解决方案的形态。 |

| DGX-2 | 2018 | Volta | 首次引入NVSwitch,实现所有16颗GPU全互联,大幅提升大规模模型训练效率。 | |

| DGX A100 | 2020 | Ampere | 支持多实例GPU(MIG),可将单颗GPU分割为多个独立实例,提升资源利用率。 | |

| DGX H100 | 2022 | Hopper | 集成Transformer引擎,专为当今最主流的大语言模型和生成式AI优化。 | |

| HGX 平台 | HGX-1 | 2017 | Volta | 支持8颗V100 GPU的参考设计,为服务器厂商提供高性能GPU集成蓝图。 |

| HGX-2 | 2018 | Volta | 支持16颗V100 GPU的大规模设计,将DGX-2的先进互联技术平台化。 | |

| HGX A100 | 2020 | Ampere | 支持Ampere架构的更新设计,为云服务商和OEM厂商提供A100 GPU的灵活集成方案。 | |

| HGX H100 | 2022 | Hopper | 支持Hopper架构的最新设计,是构建AI工厂和大规模AI集群的底层硬件基石。 |

4 服务支持体系的差异

DGX服务体系:

- 直接由NVIDIA提供技术支持

- 包含硬件保修和软件支持的全包服务

- 专门的客户成功团队提供技术指导

- 定期的软件更新和性能优化

- 培训和技术认证服务

HGX支持模式:

- 由服务器制造商提供一线支持

- NVIDIA提供二线技术支持和设计指导

- 合作伙伴负责本地化服务实施

- 定制化的服务等级协议(SLA)

二、DGX与HGX的技术联系深度剖析

1 共同的技术基因

统一的GPU架构:

无论是DGX还是基于HGX的服务器,都采用相同架构的NVIDIA GPU。这意味着在计算核心层面,两者具有相同的指令集、计算能力和特性支持。这种统一性保证了应用代码的兼容性和性能的一致性。

一致的互联技术:

NVLink和NVSwitch技术是DGX和HGX共同的"神经系统"。这种高速互联技术让多个GPU能够以远超传统PCIe总线的速度进行数据交换,为大规模模型训练提供了必要的通信带宽。

共享的软件生态:

CUDA平台、深度学习框架、容器化部署方案等软件栈在DGX和HGX平台上保持高度一致。这种软件生态的统一性,使得开发者能够在不同平台间无缝迁移应用。

2 技术演进的双向影响

从HGX到DGX的技术传递:

HGX作为参考设计平台,往往是新技术验证的首选。新的GPU互联方案、散热设计、电源架构等首先在HGX平台上进行验证,成熟后再集成到DGX系统中。

从DGX到HGX的经验反馈:

DGX作为直接面向最终用户的产品,能够收集到真实的用户需求和问题反馈。这些经验反过来指导HGX平台的改进和优化,形成良性的技术迭代循环。

3 生态系统协同效应

开发者生态:

DGX为开发者提供了稳定可靠的开发环境,而基于HGX的服务器则为大规模部署提供了经济高效的方案。两者共同构成了完整的AI计算基础设施生态。

合作伙伴生态:

HGX平台吸引了大量的服务器制造商参与,形成了丰富的产品组合。DGX则树立了产品标准和性能标杆,为整个生态提供了发展方向。

三、DGX与HGX使用场景深度分析

1 DGX适用场景详解

1.1. 企业AI研发平台

典型用户:

- 大型金融机构的风险模型训练

- 制造业的智能质检系统开发

- 医疗机构的医学影像分析平台

- 零售企业的推荐算法研发

价值主张:

- 快速部署:从开箱到开始训练通常在1-2天内完成

- 简化运维:统一的软件栈和自动化的系统管理

- 性能保证:经过NVIDIA官方验证的性能基准

- 技术支持:直接获得NVIDIA工程师的技术支持

1.2. 科研机构与高校

应用场景:

- 大规模科学计算(气候模拟、天体物理等)

- 前沿AI算法研究(大语言模型、生成式AI等)

- 多学科交叉研究平台

- 研究生和科研人员的训练平台

特殊优势:

- 预装的科研软件栈

- 针对学术研究的优惠授权

- 与学术生态的深度集成

- 长期的技术演进支持

1.3. 快速原型验证

适用情况:

- 创业公司的产品原型开发

- 传统企业的AI转型试点

- 新业务模式的技术验证

- 算法模型的初步训练和调优

2 HGX适用场景深度解析

2.1. 超大规模云服务商

部署模式:

- 大规模集群部署(通常数百至数千节点)

- 多租户的GPU资源池化

- 自动化的资源调度和管理

- 定制化的运维监控体系

技术优势:

- 深度定制:根据工作负载特性优化硬件配置

- 成本优化:通过规模化采购和定制化设计降低TCO

- 灵活扩展:模块化设计便于按需扩展

- 异构计算:支持不同配置的混合部署

2.2. 行业解决方案提供商

典型应用:

- 智慧城市的大脑计算平台

- 工业互联网的AI推理集群

- 自动驾驶的仿真训练平台

- 金融风控的实时计算系统

定制化需求:

- 特殊的机柜部署要求

- 定制化的网络拓扑

- 行业特定的认证需求

- 特殊的环境适应性要求

2.3. 混合云部署场景

架构特点:

- 私有云与公有云的统一架构

- 工作负载的灵活迁移

- 数据本地化与计算弹性结合

- 分级存储与计算资源配置

四、未来发展趋势

1 技术演进方向

| 发展趋势维度 | 具体演进方向 | 说明与典型特征 |

|---|---|---|

| 计算架构创新 | • 新一代GPU架构演进 • 异构计算能力增强 • 内存层次优化 • 能效比持续提升 | - 专为AI计算(如Transformer)设计的新型核心。 - CPU、GPU、DPU协同计算,各司其职。 - HBM高频宽内存与新型存储技术结合。 - 关注每瓦特性能,降低运营成本。 |

| 互联技术发展 | • 更高带宽NVLink • 更灵活拓扑结构 • 光电混合互联 • 跨节点统一内存架构 | - 持续提升GPU间互联速度,减少通信瓶颈。 - 支持更动态、更高效的GPU集群连接方式。 - 远距离、高带宽、低延迟的集群互联方案。 - 实现超大规模集群的共享内存空间。 |

| 新兴工作负载 | • 生成式AI规模化部署 • 数字孪生实时计算 • 边缘与云协同计算 • 量子-经典混合计算 | - 支持万亿参数大模型的持续训练与推理。 - 对物理世界进行高保真、实时仿真与预测。 - AI能力从云端下沉到边缘和终端。 - GPU作为量子计算模拟器与协处理器。 |

| 行业深度渗透 | • 传统行业智能化转型 • 科学发现的加速器 • 创意产业的工具革命 • 教育普惠的技术支撑 | - 赋能金融、制造、医疗等领域的AI应用。 - 加速生命科学、气候预测、新材料等领域研究。 - 成为影视、设计、音乐创作的核心生产工具。 - 通过云端资源让高校和学生更易获得算力。 |

2 应用场景扩展

| 发展趋势维度 | 具体演进方向 | 说明与典型特征 |

|---|---|---|

| 软件定义硬件 | • 更灵活的资源配置 • 动态的硬件重构 • 智能的资源调度 • 自适应的性能优化 | - 通过软件(如MIG)将单台服务器虚拟化为多个实例。 - 根据负载需求,动态调整计算、网络和存储资源。 - AI驱动的调度器,自动将任务分配到最优节点。 - 系统能自动识别应用类型并启用最佳配置。 |

| 可持续发展 | • 绿色计算技术集成 • 能耗的智能管理 • 硬件生命周期延长 • 循环经济实践 | - 采用液冷等高效散热技术,降低PUE。 - 实时监控并优化能耗,实现“按需用电”。 - 通过架构化设计,便于维修、升级和部件复用。 - 注重材料的可回收性,减少电子垃圾。 |

| 商业模式与服务 | • AI即服务(AIaaS)深化 • 解决方案垂直化 • 生态合作紧密化 | - 基于HGX的云服务和使用DGX的私有化部署方案并存。 - 针对医疗、金融等特定行业提供软硬件一体的交钥匙方案。 - NVIDIA与合作伙伴共同构建从芯片到应用的全栈生态。 |

通过以上深度分析,我们可以看到DGX和HGX虽然定位不同,但共同构成了NVIDIA在AI计算领域的完整布局。理解它们的区别、联系和适用场景,对于构建高效、经济的AI计算基础设施至关重要。随着AI技术的不断发展,这两条产品线都将继续演进,为各行各业的智能化转型提供强大的计算支撑。