【终极面试集锦】如何设计微服务熔断体系?

如何设计微服务熔断体系

--楼兰

面试官:”你简历上写着精通微服务,那这次我们来聊聊微服务的熔断问题把。“

“服务熔断是干什么的?解决什么问题?”

“你用过哪些熔断框架?他们是如何处理服务熔断的?”

“你们项目中是如何确定服务是否需要熔断的?”

“服务熔断后要怎么恢复服务?”

“每次服务熔断都会丢失客户请求,有没有更好的处理方法?”

怎么样?能接得住吗?面试官这一套问题下来,环环相扣,层层加码。如果没有一点实战经验,光靠背面试题,还真不太好接招。这已经不是在问一个孤立的技术点了,他是在通过“熔断”这一个切口,来剖析你的整个微服务知识体系的深度和广度。

必须强调,熔断技术,在微服务体系中,是‘生命线’;在技术面试中,是‘黄金分割线’。它不仅是保障线上系统稳定运行的核心机制,更是区分‘面试理论派’和‘技术实战派’的关键技术。而且真正从项目中积累下来的实战经验,可是目前AI也无法替代的实战精华。

今天,我们就完全顺着面试官的思路,一层一层地剥开这个问题,看看简历上精通微服务的含金量有多少。

一、熔断的本质:防止服务雪崩

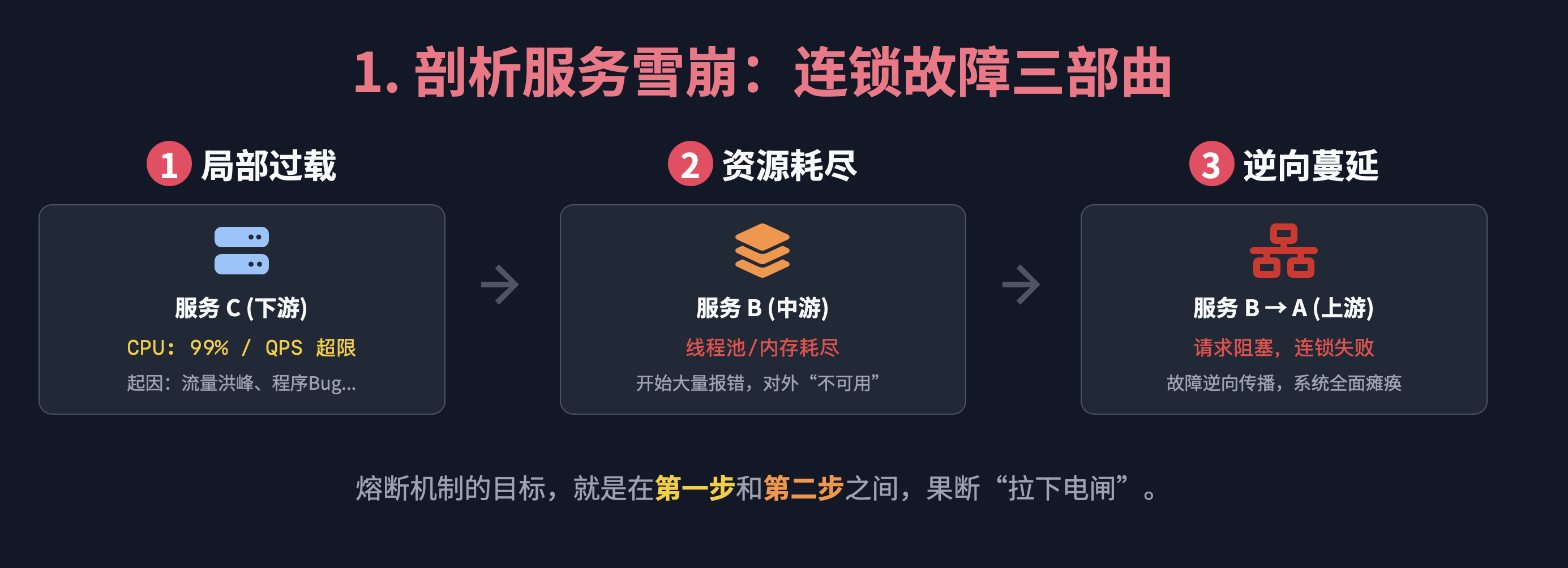

首先服务熔断方案针对的是微服务架构中最可怕的噩梦-服务雪崩。

想象一个场景:最上游的服务A调用服务B,服务B再调用下游的服务C。现在,服务C因为高负载或者Bug,响应变得极慢甚至直接宕机。服务B的线程在调用C时,就会被卡住、等待超时。当大量请求涌入时,服务B的线程池很快就会被这些等待的线程耗尽。此时,服务B对于服务A来说,也变得无法响应。这个过程会像多米诺骨牌一样,沿着调用链反向传播,最终导致整个系统全线崩溃。

而熔断,就是斩断服务雪崩的利剑!我们会在服务B调用服务C的地方,装上一个熔断器。当熔断器检测到服务C出问题后,会立刻“跳闸”。之后,服务B再来调用服务C的请求,根本就不会发出去了,而是被熔断器直接拦截、快速失败。这样,服务B的线程就不会被耗尽,服务B得以幸存,雪崩就被阻止了。

所以,熔断的本质就是牺牲局部,保全整体的“故障隔离”思想。

二、熔断的实现:从拦截到降级

我们常用的熔断框架有Hystrix、Resilience4j、Sentinel等,它们的核心都是用一个“熔断器对象”,像AOP切面一样,包裹住我们的远程调用。

这个对象内部,通过“滑动窗口”(比如统计最近10秒或最近100次请求)来实时计算两个核心指标:错误率和慢调用比例。一旦指标超过我们设定的阈值,熔断器就“跳闸”了。

关键来了,“跳闸”后到底发生了什么?它并不是简单地抛个异常就完事了。一个设计良好的熔断器,会立刻执行一个降级逻辑(Fallback)。也就是说,原本要走网络去调用远端服务的代码路径,被切换到了另一条执行本地代码的路径上。

举个具体的例子:在一个电商APP里,商品详情页需要调用“推荐服务”来展示个性化推荐。但如果”推荐服务”出现了问题,就会导致整个详情页崩溃。这时就需要对“推荐服务”进行熔断处理。熔断之后,商品详情页可以切断对“推荐服务”的调用请求,改为调用本地的降级服务。返回一些或许不太正确,但至少能够正常展示的数据。比如返回空列表、或者提前准备好的本地热销榜单等。

通过降级,我们虽然损失了个性化推荐,但至少整个商品详情页的核心功能依然可用,并且响应飞快。这就是从“被动报错”到“主动降级”的巨大进步。

三、优雅的恢复:“半开”状态的试探

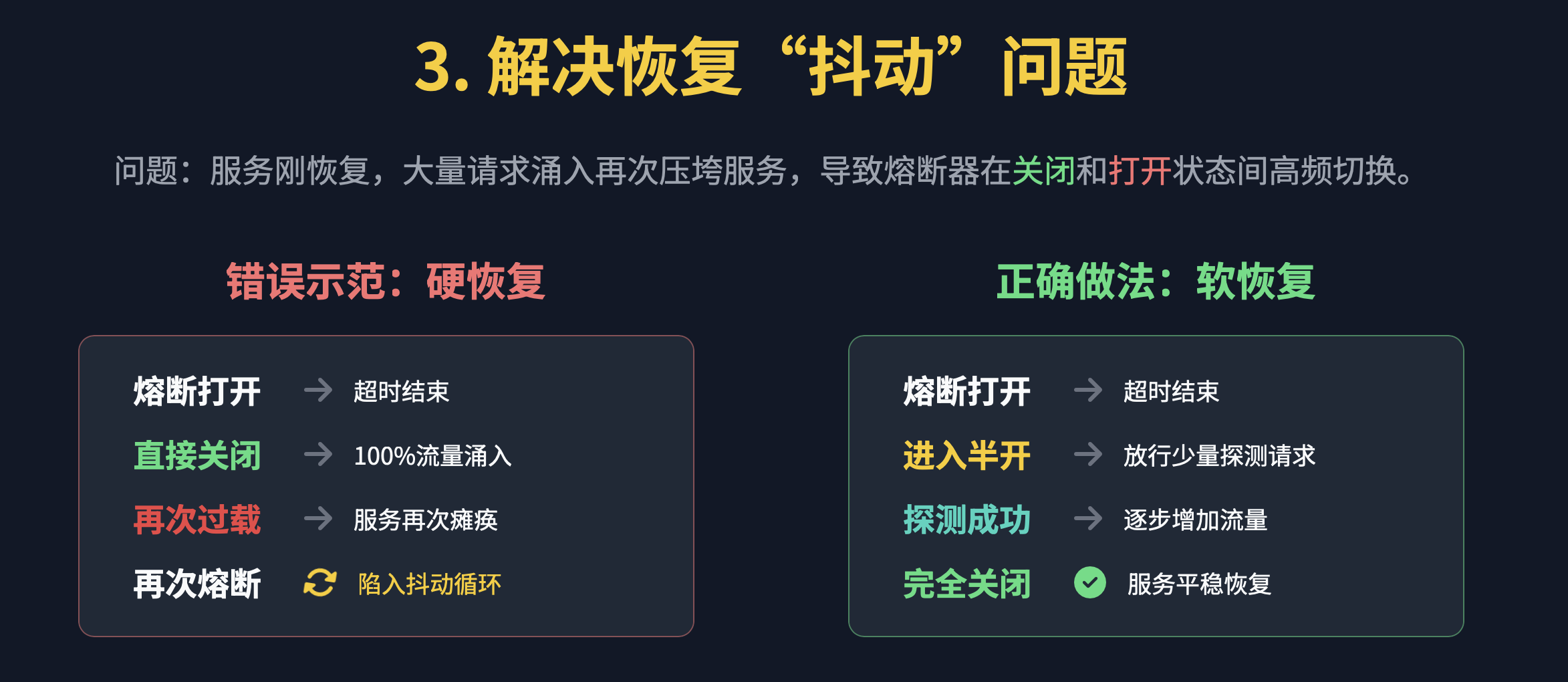

面试的深水区问题:如何恢复服务?很多人的简单想法就是,等后端服务恢复后就简单的恢复远程服务调用就可以了呗。

但这里有一个致命的陷阱就是“恢复抖动”。如果熔断恢复后,100%的流量瞬间打过去,一个刚刚“复活”的脆弱服务很可能被再次打垮,导致系统在“熔断”和“恢复”之间反复抽搐。

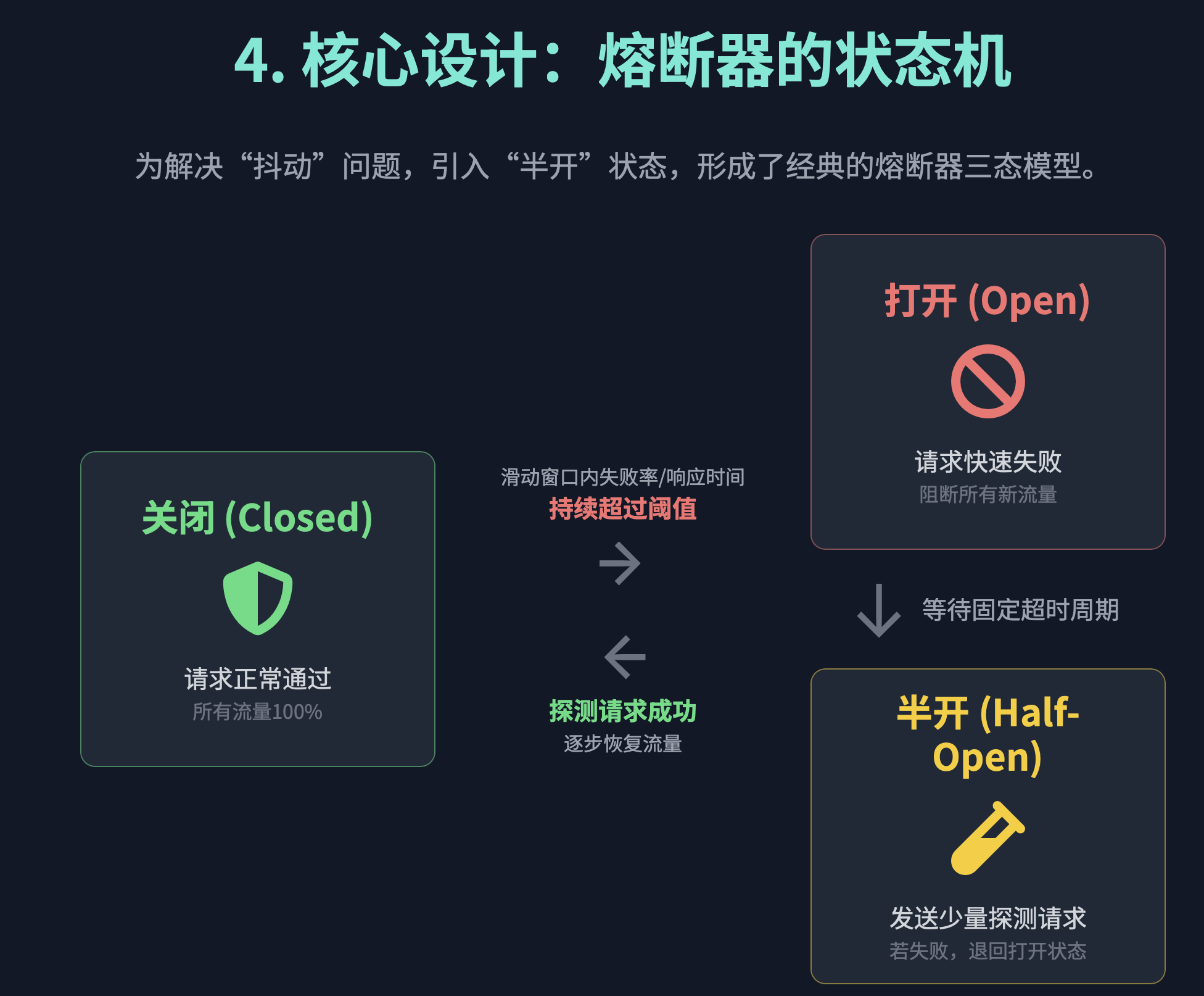

为了解决这个问题,我们必须引入 ‘半开(Half-Open)’状态 ,构成一个完整的三态状态机。

- 关闭 (Closed):绿灯。正常状态,请求通行。

- 打开 (Open):红灯。熔断状态,请求被拦截,执行降级。当计时器(比如1分钟)到期后,自动转入“半开”。

- 半开 (Half-Open):这才是精髓! 在这个状态下,熔断器会像一个侦察兵,小心翼翼地放行一个(或极少数几个)“探测”请求去访问下游服务。

- 如果探测成功:太好了!证明下游服务真的缓过来了。熔断器立刻关闭,恢复正常。

- 如果探测失败:说明下游还没好。熔断器立刻退回“打开”状态,并重置计时器,等待下一轮的探测。

通过这种“试探性”的恢复,我们实现了对下游服务的“软着陆”,避免了流量洪峰的二次冲击。

四、王者方案:从被动防御到主动治理

终极问题:熔断会丢请求,有没有更好的方法?这要求我们把视野从单个组件,拉高到整个架构。

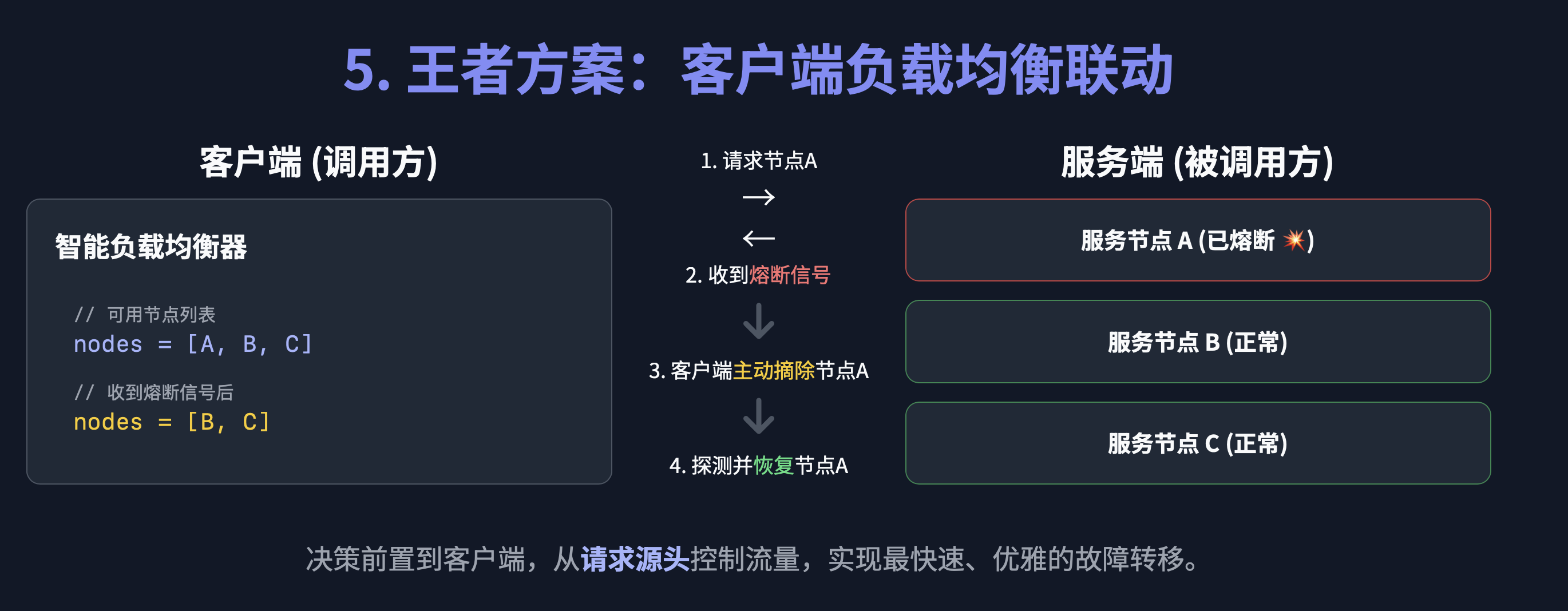

前面讲的,都还停留在“服务端”的被动防御。而最顶级的方案,是客户端与服务端的联动治理!

在一个典型的微服务架构中,一个服务,比如订单服务,会通过客户端负载均衡器去调用服务集群,比如多个库存服务实例。这个过程依赖于服务注册中心,如Nacos来获取健康的实例列表。

- 上报状态:当库存服务A的熔断器进入“打开”状态时,它不仅仅是自己内部拦截请求,它还会通过心跳机制,主动告诉注册中心:“我病了,我现在是‘OUT_OF_SERVICE’状态!”

- 更新列表:注册中心收到这个信号后,会立刻将库存服务A从提供给外部的健康实例列表中移除。

- 主动绕行:当订单服务的客户端负载均衡器再来拉取实例列表时,它拿到的就只剩下健康的库存服务B和C了。

这样一来,订单服务发出的请求,从源头上就根本不会被路由到已经出故障的服务A上!故障被完美地隔离在了客户端之外。这才是真正的“主动治理”,它把故障扼杀在了发生之前,从根本上避免了请求的浪费和丢失,实现了最高效的故障转移。

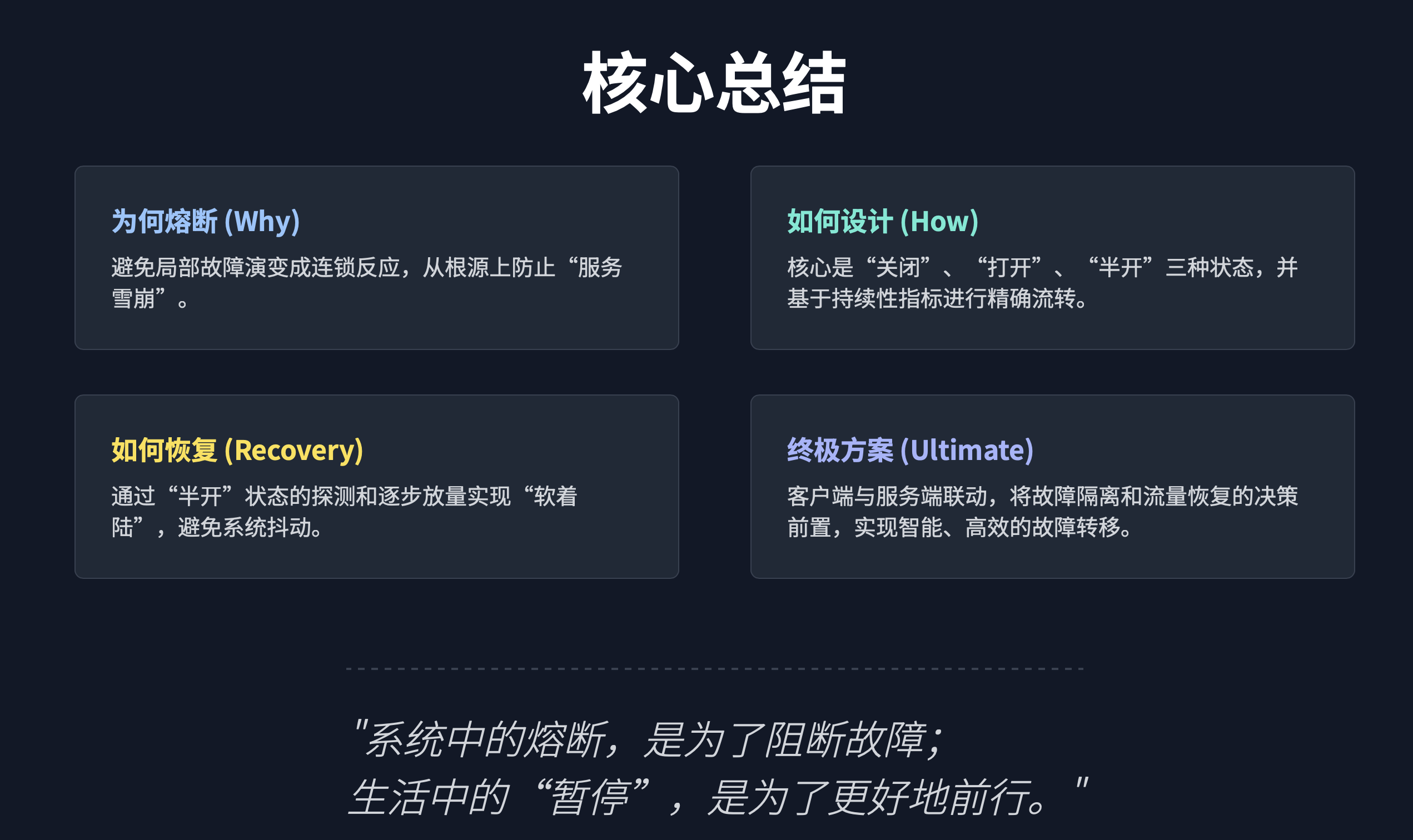

总结与升华

一套顶级的熔断体系,它是一个立体的防御工程:

- 在点上:它有熔断器和降级逻辑作为基本单元,保证单个调用点的韧性。

- 在线上:它有三态状态机来保证从故障中有序、优雅地“软着陆”恢复。

- 在面上:它通过客户端负载均衡与服务注册的联动,构建了全系统的、主动的、具备预见性的故障治理能力。

当你能把这三个层次都清晰地讲出来,面试官就会明白,你思考的,绝不只是如何“修复”一个故障,而是如何构建一个靠谱的弹性系统。而这种思维,正是我一直强调的高级工程师的核心价值所在。最后,系统中的熔断,是为了阻断故障,生活中的暂停,是为了更好的前行。与大家共勉。