iOS 智能应用开发实践:从模型集成到场景化交互

随着人工智能(AI)技术的飞速发展,越来越多的产品希望将 AI 能力集成到iOS 应用中。无论是智能语音助手、图像识别、自然语言处理,还是实时视频分析,AI 都能为移动应用带来前所未有的智能体验。本文将围绕 iOS 平台上实践 AI 的主题,结合实际项目经验,分享从模型集成到智能交互的整体流程。

一、iOS 上集成 AI 的主流方式

在 iOS 上集成 AI,主要有以下几种方式:

- 调用云端 AI 服务:如百度、阿里、腾讯等云端 API,适合对算力要求高、模型体积大的场景。

- 本地模型:利用 Core ML、TensorFlow Lite、PyTorch Mobile 等框架,将模型直接集成到 App 内,适合对隐私、实时性要求高的场景。

- 混合方案:本地模型与云端服务结合,既保证实时性,又能利用云端强大的算力。

下面我们以本地模型为例,介绍如何在 iOS 项目中集成 AI 能力。

二、Core ML介绍

Core ML 是苹果官方推出的机器学习框架,支持多种模型格式(如 Keras、Caffe、ONNX、TensorFlow),并且与 Vision、Natural Language 等框架深度集成。开发者可以通过 Xcode 导入 .mlmodel 文件,并在 Swift 或 Objective-C 项目中调用。

利用 Core ML 在 App 中整合机器学习模型。Core ML 为所有模型提供了一种统一的呈现方式。App 可以使用 Core ML API 和用户数据进行预测,以及训练或精调模型,一切都在用户设备上完成。

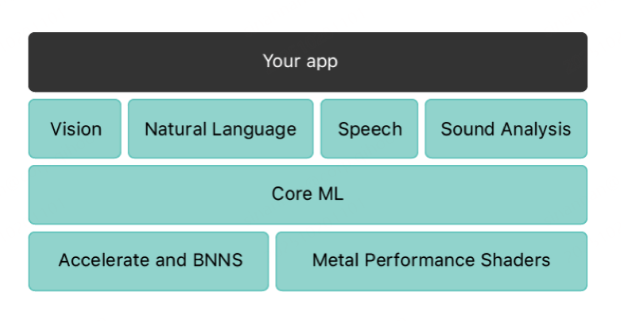

Core ML框架结构如下图示,最底层是性能框架层,它由Acccelerate和Metal Performance Shaders两个框架构成。Acccelerate专注于图形学和数学领域的大规模计算,而Metal Performance Shaders则致力于优化和加速GPU及图形渲染。

Core ML是该框架的核心组件之一,它支持导入机器学习模型,并能生成对应的高级代码,如Swift和Objective-C。此外,针对特定场景,如iOS 11中新增的Vision和NLP框架,进行了封装和优化。Vision框架主要用于图片分析,如人脸识别,NLP框架则擅长自然语义分析,如上下文理解。

1. Core ML 使用流程

主要三个步骤:

1.1、获取Core ML的训练模型:

从苹果官网获取模型:

https://developer.apple.com/cn/machine-learning/models/

自己训练生成模型,Xcode集成了Create ML工具,Open Develop Tool->Create ML。

将第三方模型通过 coremltools 转换为 Core ML 格式。

1.2、将这些模型导入到开发项目中。Xcode 中,将.mlmodel 拖入项目,自动生成对应的 Swift/ObjC 类。

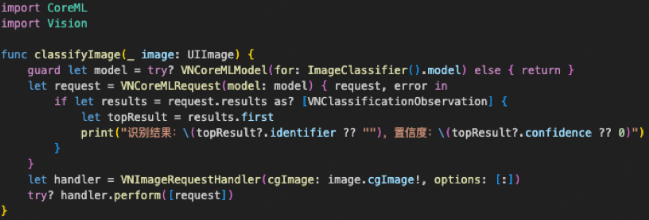

1.3、利用生成的Swift/ObjC接口实现业务逻辑。以 Swift 为例,假设我们要对用户拍摄的照片进行分类:

三、AI 在音视频会议中的实践

在实际项目中,AI 能力应用场景广泛,比如为音视频会议场景带来智能化体验。例如:

- 智能语音识别:实时转写会议内容,生成会议纪要。

- 活跃发言人检测:自动识别当前发言人,突出显示。

- 人脸识别与表情分析:提升互动体验,自动打标签或生成统计。

以活跃发言人检测为例,假设我们有一个远端流管理类 QHVCConferenceVC,可以通过集成语音活动检测模型,自动识别当前发言人并在 UI 上高亮显示。

1. 集成语音活动检测模型

假设我们有一个 Core ML 语音活动检测模型 VoiceActivity.mlmodel,可以在音频流回调中实时推理:

#import<CoreML/CoreML.h>

#import"VoiceActivity.h"

// 在音频数据回调中调用模型

- (void)processAudioBuffer:(AVAudioPCMBuffer

)buffer userId:(NSString

)userId {VoiceActivity *model = [[VoiceActivity alloc] init];NSError *error = nil;MLMultiArray *inputArray = [self convertBufferToMLMultiArray:buffer];VoiceActivityOutput *output = [model predictionFromInput:inputArray error:&error];if (output.isSpeaking.boolValue) {// 标记该用户为活跃发言人[self highlightActiveSpeaker:userId];}

}2. UI 智能高亮

结合 KVO 和 UI 动画,可以在检测到发言人变化时自动高亮:

- (void)highlightActiveSpeaker:(NSString *)userId {dispatch_async(dispatch_get_main_queue(), ^{// 找到对应的流视图QHVCUserStreamModel *stream = [self getRemoteStreamOfUserId:userId];stream.preview.layer.borderColor = [UIColor redColor].CGColor;stream.preview.layer.borderWidth = 2.0;// 其他流复位for (QHVCUserStreamModel *other in self.remoteStreamArray) {if (![other.userId isEqualToString:userId]) {other.preview.layer.borderWidth = 0;}}});

}四、AI 与自然语言处理(NLP)在 iOS 的结合

除了视觉和语音,NLP 也是 AI 在 iOS 上的重要应用场景。例如:

- 智能聊天机器人:集成 GPT、BERT 等模型,实现智能问答。

- 文本自动摘要:会议纪要自动生成。

- 情感分析:分析用户评论或聊天内容。

以智能聊天机器人为例,可以通过调用云端 GPT API 或集成本地 NLP 模型,实现智能对话:

func sendMessageToAI(_ message: String, completion: @escaping (String) -> Void) {let url = URL(string: "

https://api.openai.com/v1/chat/completions

")!var request = URLRequest(url: url)request.httpMethod = "POST"request.addValue("Bearer YOUR_API_KEY", forHTTPHeaderField: "Authorization")let body = ["model": "gpt-3.5-turbo","messages": [["role": "user", "content": message]]]request.httpBody = try?

JSONSerialization.data

(withJSONObject: body)URLSession.shared.dataTask(with: request) { data,

, inif let data = data,let json = try? JSONSerialization.jsonObject(with: data) as? [String: Any],let choices = json["choices"] as? [[String: Any]],let reply = choices.first?["message"] as? [String: Any],let content = reply["content"] as? String {completion(content)}}.resume()

}这样,用户即可在 App 内与 AI 机器人进行智能对话。

五、AI 实践中的性能与隐私优化

在 iOS 上集成 AI 时,开发者还需关注性能和隐私:

- 模型体积与推理速度:Core ML 支持模型量化和加速,TensorFlow Lite 支持 GPU/Metal 加速。

- 隐私保护:本地推理避免数据上传,敏感信息加密存储。

- 多线程与异步处理:推理过程建议放在后台线程,避免阻塞 UI。

例如,使用 Core ML 的异步推理:

let request = VNCoreMLRequest(model: model) { request, error in// 处理结果

}

request.imageCropAndScaleOption = .centerCrop

DispatchQueue.global

(qos: .userInitiated).async {let handler = VNImageRequestHandler(cgImage: image.cgImage!, options: [:])try? handler.perform([request])

}六、总结

AI 已成为 iOS 应用创新的核心驱动力。无论是智能识别、语音交互,还是自动化分析,AI 都能为移动应用赋能。本文结合实际项目,介绍了 iOS 上集成 AI 的主流方式、具体代码实现、性能优化等关键环节。随着 Apple Vision Pro、ARKit、SiriKit 等技术的不断发展,AI 与 iOS 的结合将更加紧密,智能应用场景将更加丰富。