【大数据技术实战】Kafka 认证机制全解析

前言

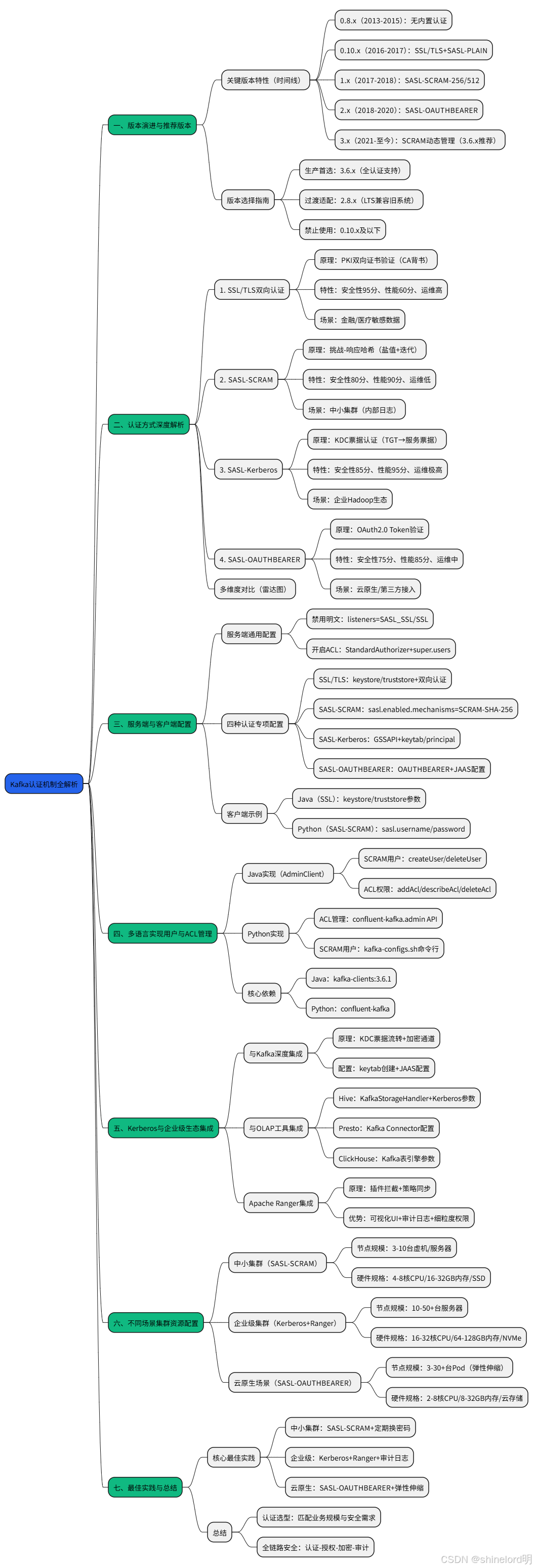

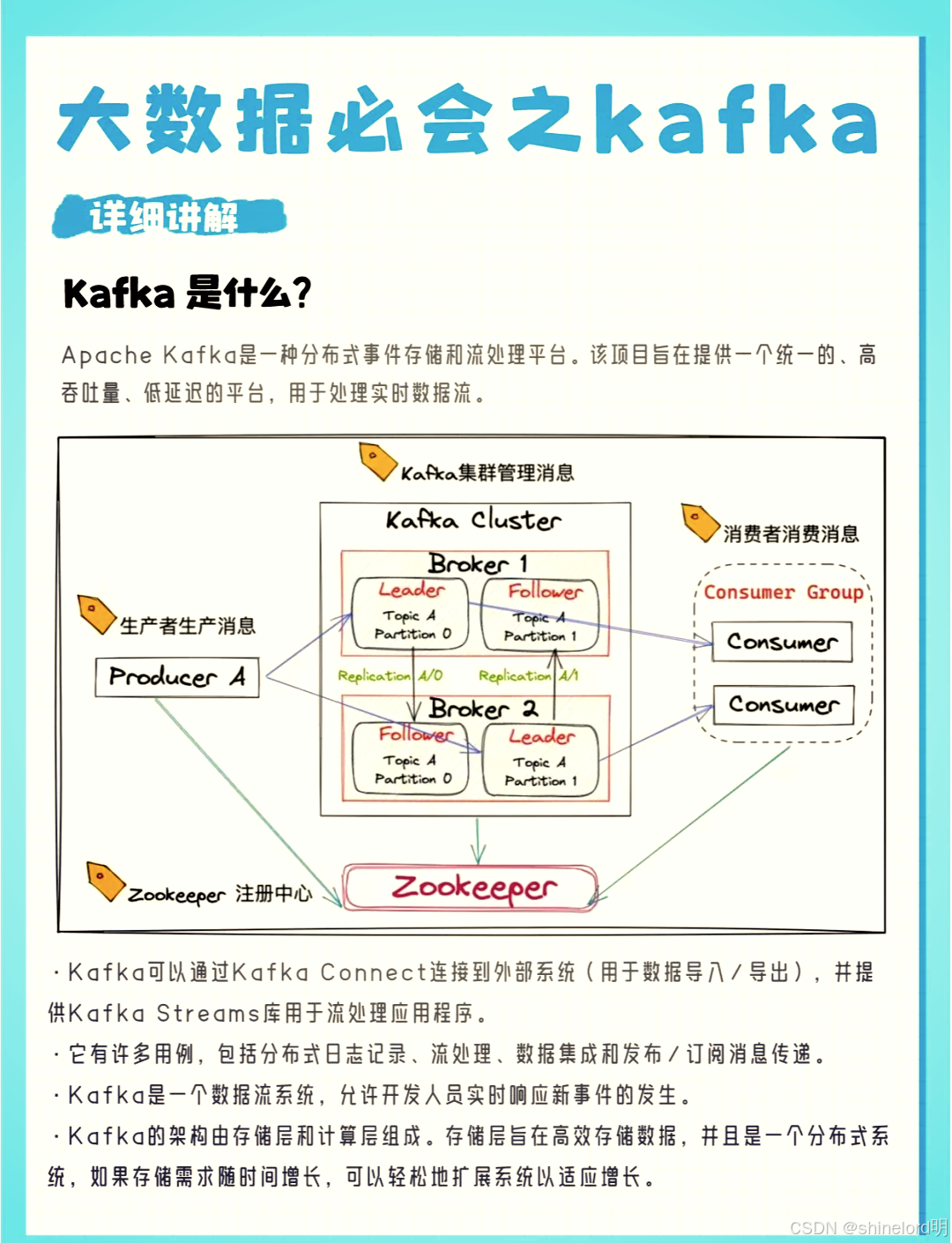

Kafka 作为分布式流处理平台的核心,其数据传输安全性直接决定业务可靠性。随着版本迭代,Kafka 认证机制从 “无安全防护” 演进为支持SSL/TLS、SASL-SCRAM、Kerberos、OAuth2.0的完整体系,且在企业级场景中需与 OLAP 工具(Hive/Presto)、权限系统(Ranger)联动。本文通过可视化图表 + 可落地代码 + 表格对比,系统梳理认证原理、配置实践与生态集成,帮助构建 “认证 - 授权 - 审计” 全链路安全 Kafka 集群。

目录

前言

目录

一、Kafka 版本演进与推荐版本

1.1 关键版本认证特性(可视化时间线)

1.2 版本特性对比表

1.3 推荐版本选择指南

二、Kafka 认证方式深度解析(原理 + 场景 + 性能)

核心维度定义(统一评价标准)

2.1 四种认证方式多维度对比(可视化雷达图)

2.2 1. SSL/TLS 双向认证(金融级安全)

原理(可视化流程)

核心特性与场景

2.3 2. SASL-SCRAM(中小集群首选)

原理(可视化流程)

核心特性与场景

2.4 3. SASL-Kerberos(企业统一身份)

原理(可视化流程)

核心特性与场景

2.5 4. SASL-OAUTHBEARER(云原生动态接入)

原理(可视化流程)

核心特性与场景

三、服务端与客户端配置实践(3.6.x 版本)

3.1 服务端通用配置(server.properties)

3.2 四种认证方式服务端专项配置表

3.3 客户端配置示例

1. Java 客户端(SSL 双向认证)

2. Python 客户端(SASL-SCRAM)

四、Java 实现用户与 ACL 管理

4.1 依赖引入(Maven)

4.2 SCRAM 用户管理(创建 / 删除)

4.3 ACL 权限管理(增删查)

五、Python 实现用户与 ACL 管理

5.1 依赖安装

5.2 ACL 管理示例(增删查)

5.3 SCRAM 用户创建(命令行辅助)

六、Kerberos 与企业级生态集成

6.1 Kerberos 与 Kafka 集成原理(可视化架构)

6.2 Kerberos 与 OLAP 工具集成配置

1. Hive 集成 Kafka(Kerberos 认证)

2. Presto 集成 Kafka(Kerberos 认证)

6.3 Apache Ranger 集成 Kafka(集中权限管控)

集成原理(可视化流程)

Ranger 与 Kafka 原生 ACL 对比表

七、最佳实践与总结

7.1 核心最佳实践(按场景分类)

1. 中小集群(10 节点以内)

2. 大型企业集群(50 节点以上)

3. 云原生场景(K8s 部署)

7.2 总结

一、Kafka 版本演进与推荐版本

Kafka 认证特性随版本迭代逐步完善,选择适配版本是安全落地的基础。

1.1 关键版本认证特性(可视化时间线)

1.2 版本特性对比表

| 版本系列 | 时间范围 | 核心认证特性 | 安全性 | 适用场景 |

| 0.8.x | 2013-2015 | 无内置认证,依赖第三方代理(如 VPN) | 极差 | 已淘汰,禁止生产使用 |

| 0.10.x | 2016-2017 | 支持 SSL/TLS 加密认证、SASL-PLAIN(明文密码) | 较低 | 测试环境,不建议生产 |

| 1.x | 2017-2018 | 新增 SASL-SCRAM-256/512(哈希认证,防明文) | 中高 | 早期生产环境过渡 |

| 2.x | 2018-2020 | 支持 SASL-OAUTHBEARER(OAuth2.0),优化 SSL 性能 | 高 | 云原生场景初期适配 |

| 3.x | 2021 - 至今 | SCRAM 动态用户管理、OAuth Token 刷新、安全漏洞修复 | 极高 | 推荐生产环境(最新 3.6.x) |

1.3 推荐版本选择指南

🔵 生产环境首选:3.6.x(最新稳定版)

支持所有主流认证方式,性能与安全性平衡

社区维护活跃,修复近 2 年关键安全漏洞(如权限绕过)

🟢 过渡环境适配:2.8.x(LTS 长期支持版)

兼容旧系统依赖(如低版本 Java),无需大规模重构

支持核心认证场景(SSL/SCRAM/Kerberos)

🟡 禁止使用版本:0.10.x及以下

缺乏基本安全防护,存在明文传输、身份伪造风险

无社区维护,漏洞无法修复

二、Kafka 认证方式深度解析(原理 + 场景 + 性能)

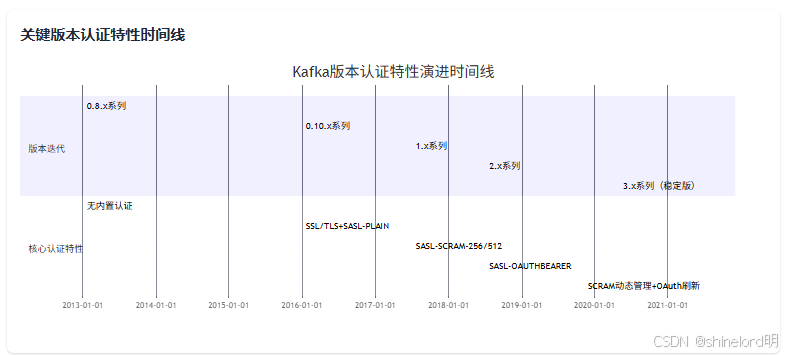

Kafka 认证基于SASL(简单认证与安全层) 和SSL/TLS(传输层加密) ,四种方式需从 “安全性 - 性能 - 运维成本” 三维度权衡。

核心维度定义(统一评价标准)

🔵 安全性:防身份伪造、数据窃听能力(数值越高越安全,满分 100)

🟢 性能:认证效率 + 数据传输开销(数值越高性能越好,满分 100)

🟡 运维复杂度:反向维度(数值越高 = 运维成本越高,满分 100)

🟣 生态兼容性:与外部系统(Hadoop/K8s / 身份服务)集成便捷性(满分 100)

🔴 动态扩展性:用户 / 权限实时管理能力(满分 100)

2.1 四种认证方式多维度对比

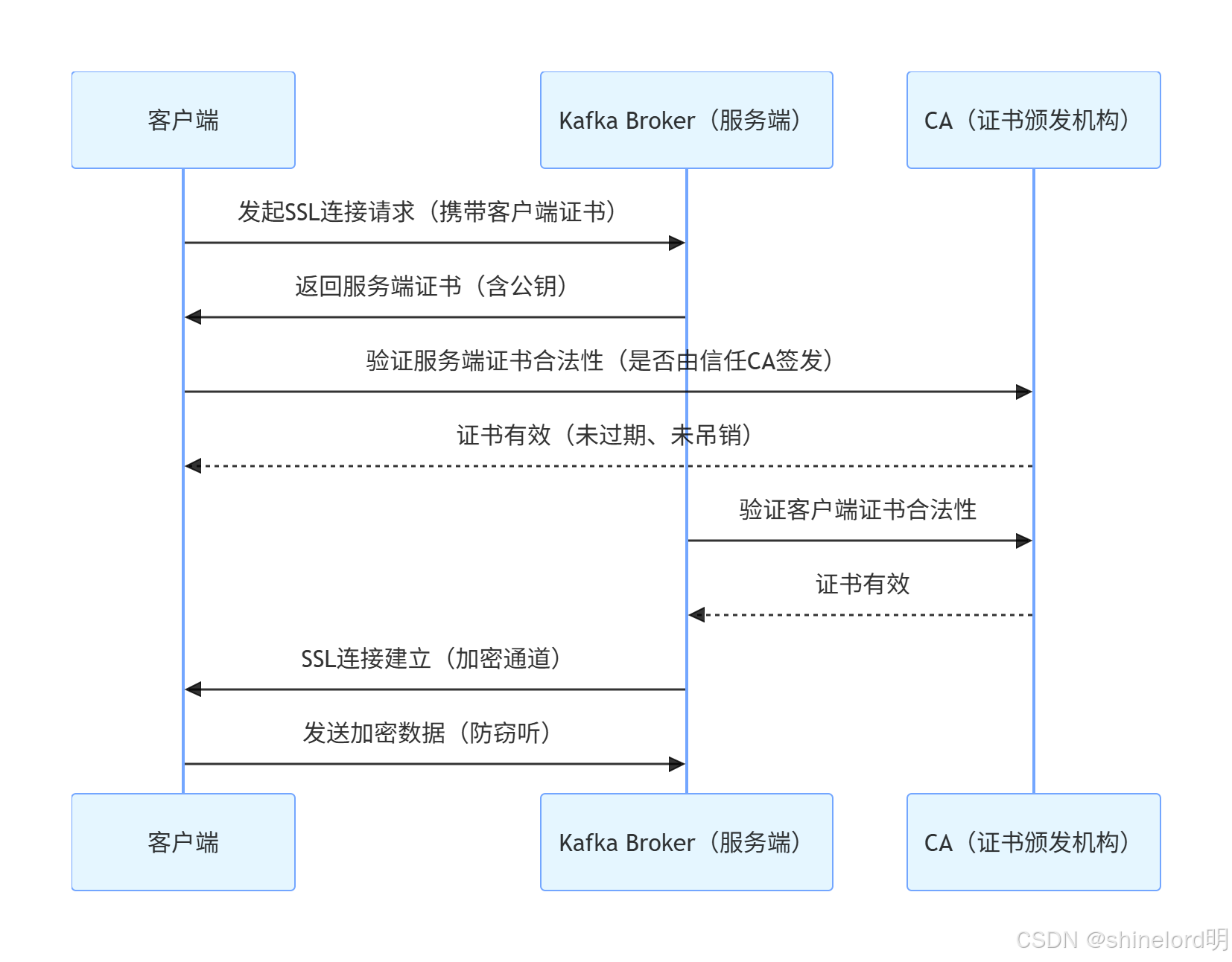

2.2 1. SSL/TLS 双向认证(金融级安全)

原理(可视化流程)

基于PKI(公钥基础设施) 实现双向身份验证,服务端与客户端互相验证证书合法性:

核心特性与场景

| 维度 | 详情(含数值) |

| 🔵 安全性 | 95 分(最高):加密传输防窃听,证书链验证防身份伪造,支持证书吊销 |

| 🟢 性能 | 60 分(中等):握手耗时 10-50ms / 连接,数据加密损耗 5%-10%,需开启连接复用 |

| 🟡 运维复杂度 | 85 分(高):需维护 CA 根证书、客户端证书(90 天轮换),吊销需更新信任库 |

| 🟣 生态兼容性 | 70 分(中等):支持主流客户端,但需单独配置证书,无内置适配 Kerberos/OAuth |

| 🔴 动态扩展性 | 65 分(中等):新增客户端需签发证书,无法实时生效(需更新信任库) |

- 适用场景:金融、医疗等敏感数据传输(如用户交易数据),需严格限制客户端身份(仅允许特定机构接入)

2.3 2. SASL-SCRAM(中小集群首选)

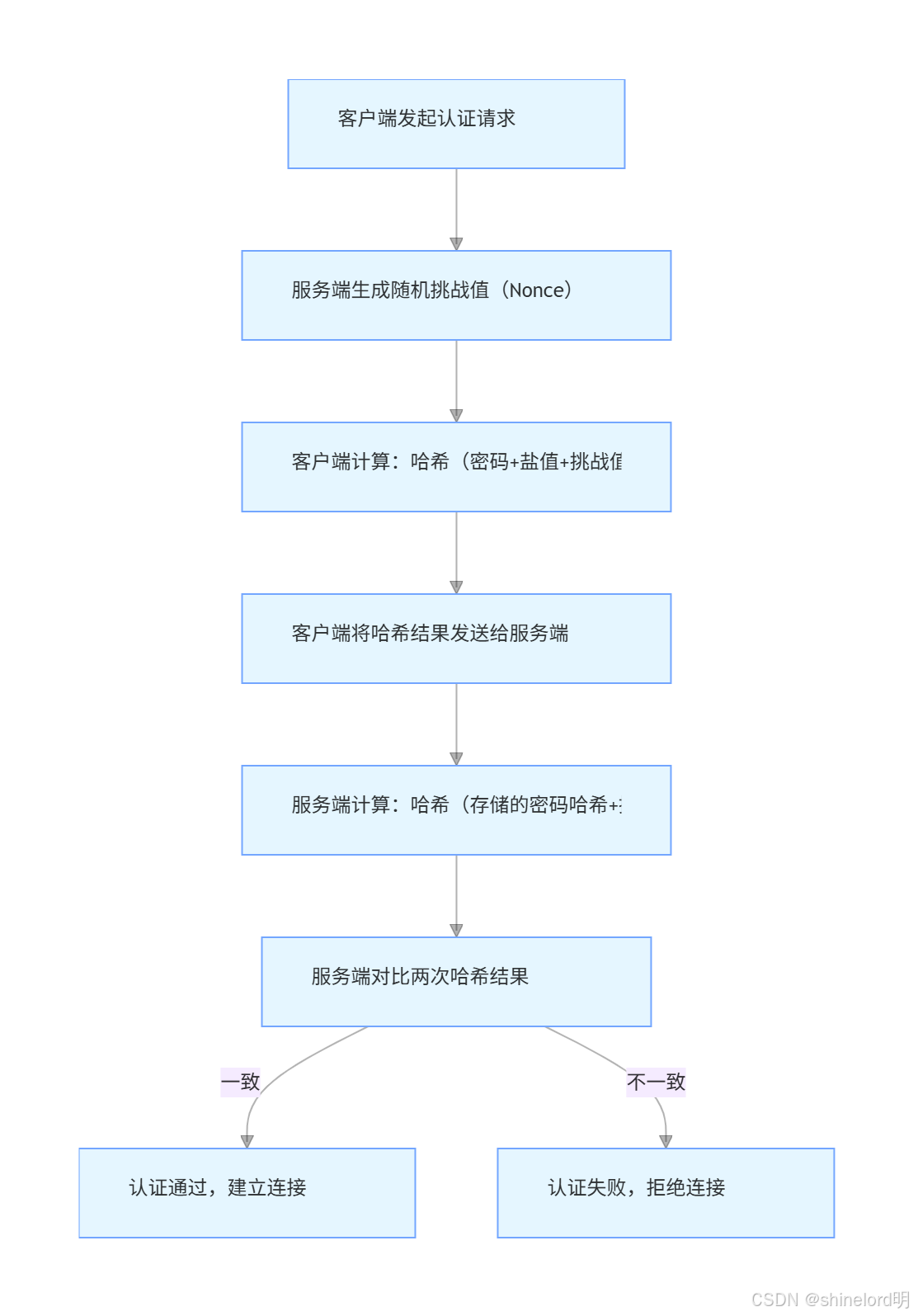

原理

基于挑战 - 响应机制的哈希认证,服务端存储密码哈希(带盐值 + 迭代次数),避免明文传输:

核心特性与场景

| 维度 | 详情(含数值) |

| 🔵 安全性 | 80 分(高):密码哈希存储(盐值 + 迭代),挑战值防重放攻击,需额外开启 SSL 加密数据 |

| 🟢 性能 | 90 分(极高):握手耗时 1-5ms / 连接,无证书解析开销,哈希计算轻量 |

| 🟡 运维复杂度 | 30 分(低):无需维护证书,支持动态增删用户(Kafka 3.x 无需重启集群) |

| 🟣 生态兼容性 | 80 分(高):适配所有 Kafka 客户端,无外部服务依赖(如 KDC/OAuth 服务器) |

| 🔴 动态扩展性 | 95 分(最高):用户 / 密码实时更新,ACL 权限即时生效 |

- 适用场景:中小规模内部集群(如业务系统日志传输),需简单用户名 / 密码管理,且运维资源有限

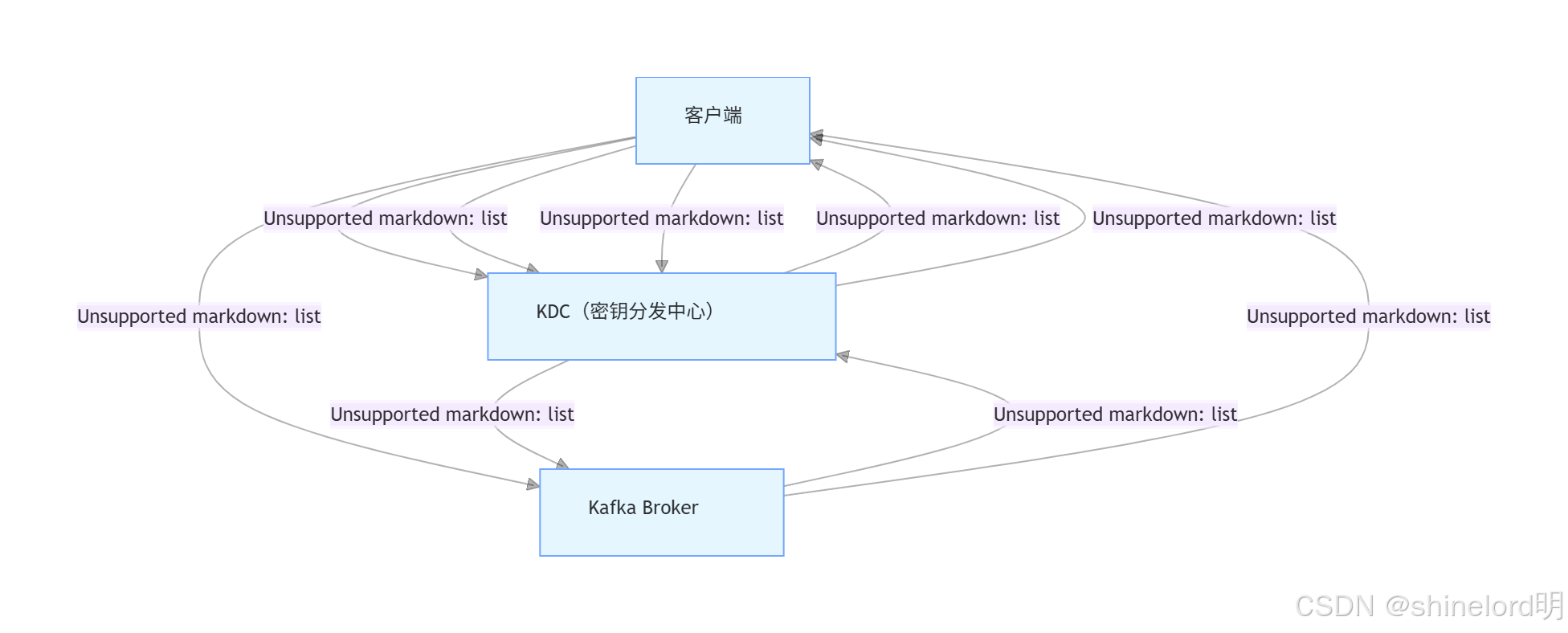

2.4 3. SASL-Kerberos(企业统一身份)

原理

基于票据(Ticket) 的集中式认证,依赖 Kerberos KDC(密钥分发中心),无需服务端存储密码:

核心特性与场景

| 维度 | 详情(含数值) |

| 🔵 安全性 | 85 分(极高):票据无密码传输,有效期可控,支持单点登录(SSO) |

| 🟢 性能 | 95 分(最高):票据可复用,长连接无重复认证,适合高并发流处理(Flink/Spark) |

| 🟡 运维复杂度 | 90 分(极高):需部署 KDC、维护 keytab 文件、同步 Kerberos Realm 配置 |

| 🟣 生态兼容性 | 95 分(最高):无缝适配 Hadoop 生态(HDFS/Hive/YARN),统一身份管理 |

| 🔴 动态扩展性 | 70 分(中等):新增用户需在 KDC 注册主体,无法通过 Kafka API 直接管理 |

- 适用场景:大型企业集群(多团队共享 Kafka),已有 Kerberos 生态,需与 Hadoop 组件统一身份

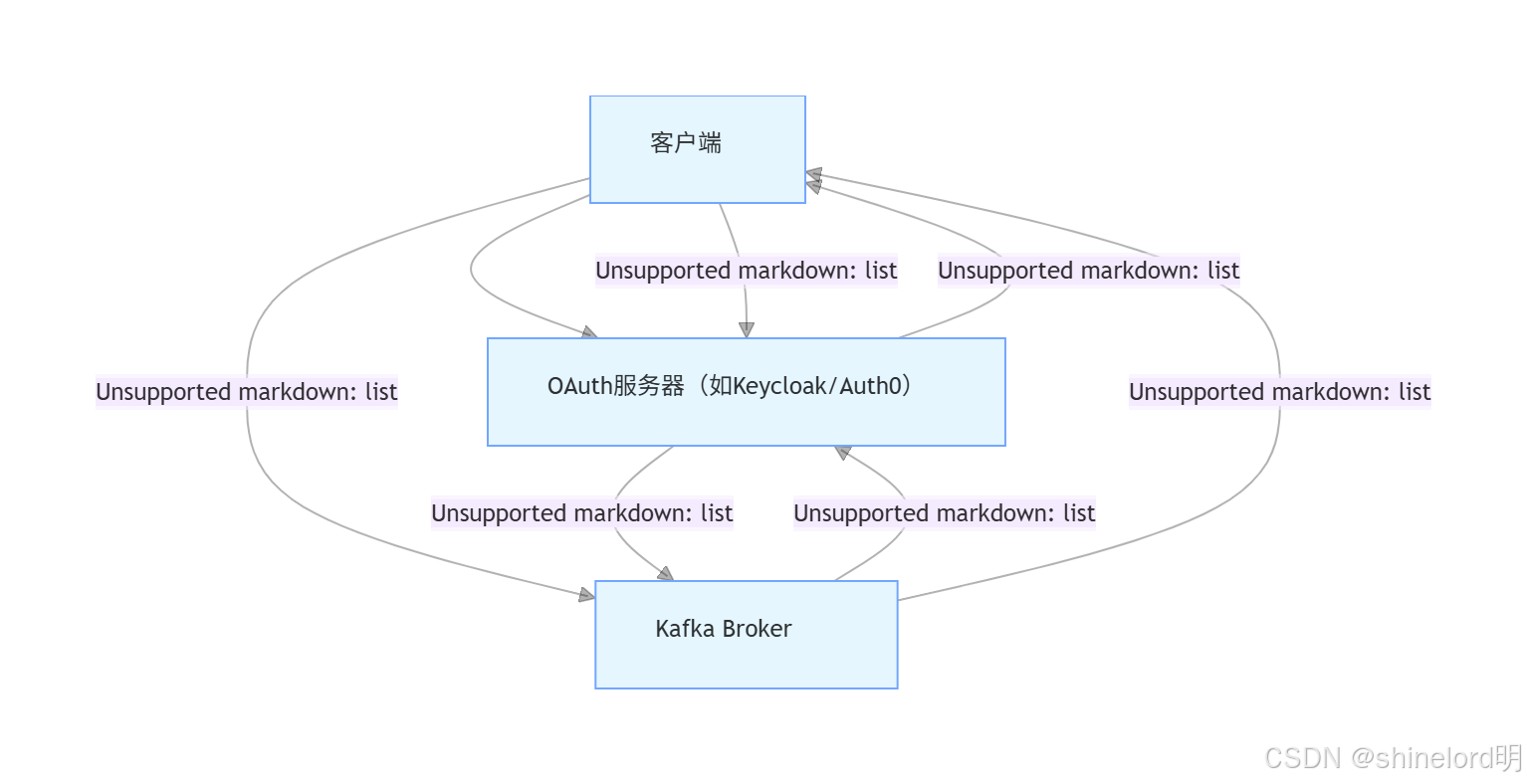

2.5 4. SASL-OAUTHBEARER(云原生动态接入)

原理

基于OAuth2.0 协议的 Token 认证,客户端从第三方 OAuth 服务器获取 JWT Token,服务端仅验证 Token 有效性:

核心特性与场景

| 维度 | 详情(含数值) |

| 🔵 安全性 | 75 分(中高):Token 短期有效,支持刷新机制,泄露风险低 |

| 🟢 性能 | 85 分(高):Token 验证仅验签名(轻量计算),无证书 / 票据解析开销 |

| 🟡 运维复杂度 | 60 分(中等):需部署 OAuth 服务器,维护 Token 签名密钥,无需管理证书 |

| 🟣 生态兼容性 | 90 分(高):适配云原生(K8s)/ 第三方服务,支持外部身份系统集成 |

| 🔴 动态扩展性 | 95 分(最高):Token 自动刷新,权限通过 OAuth 服务器实时调整 |

- 适用场景:云原生环境(K8s 集群)、第三方服务临时接入(如合作伙伴数据同步)

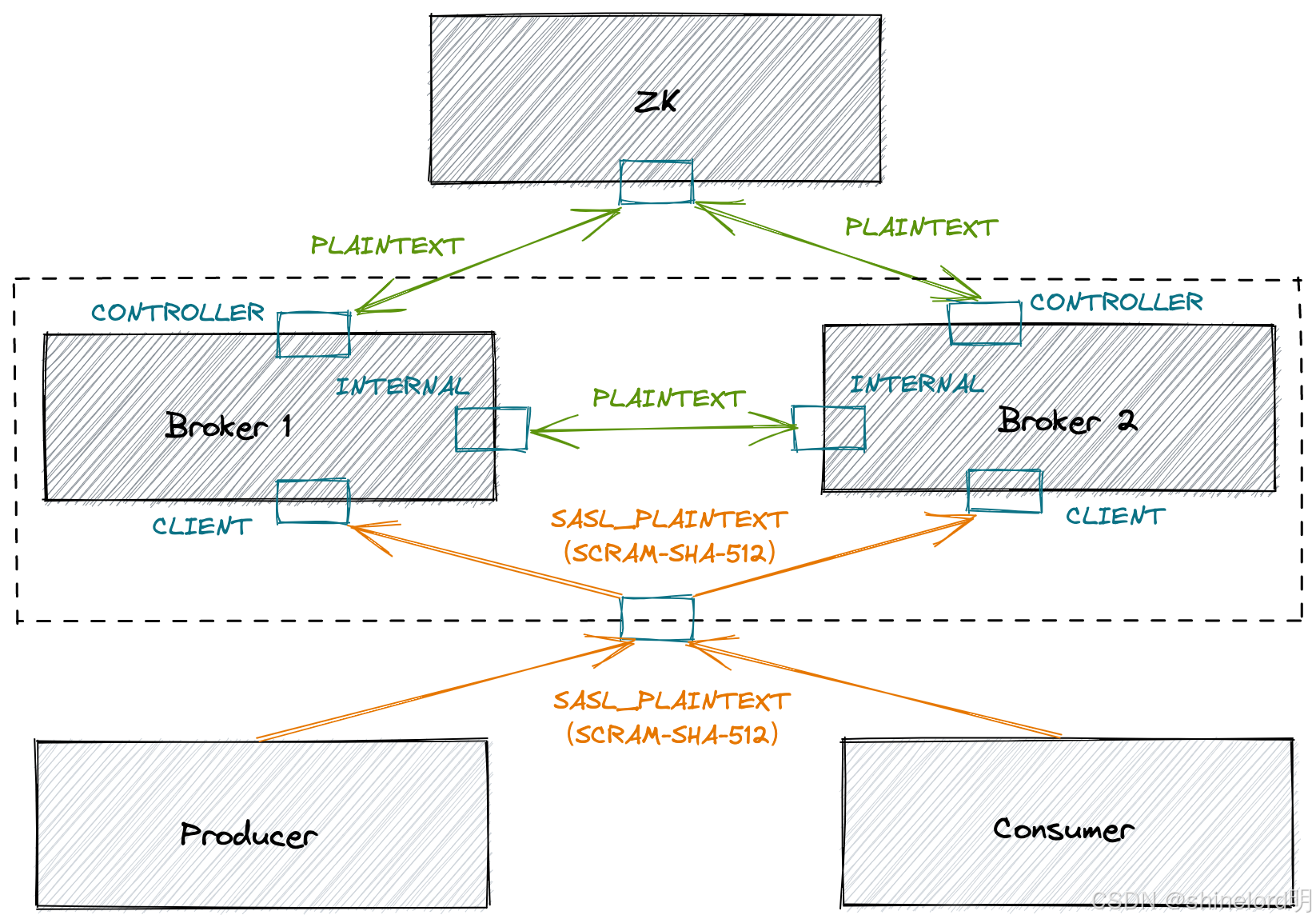

三、服务端与客户端配置实践(3.6.x 版本)

以3.6.x为基础,提供四种认证方式的核心配置与客户端示例,确保可直接落地。

3.1 服务端通用配置(server.properties)

所有认证方式需先禁用明文协议,开启基础安全配置:

# 禁用明文协议(生产环境必配)listeners=SASL_SSL://kafka-host:9093,SSL://kafka-host:9094 # 仅保留安全协议advertised.listeners=SASL_SSL://kafka-host:9093,SSL://kafka-host:9094 # 客户端实际连接地址# 开启ACL权限控制(配合认证使用)authorizer.class.name=org.apache.kafka.metadata.authorizer.StandardAuthorizersuper.users=User:admin # 管理员账号(不受ACL限制)

3.2 四种认证方式服务端专项配置表

| 认证方式 | 核心配置(server.properties) |

| SSL/TLS 双向认证 | ssl.keystore.location=/path/server.keystore.jksssl.keystore.password=123456ssl.truststore.location=/path/server.truststore.jksssl.truststore.password=123456ssl.client.auth=required |

| SASL-SCRAM | sasl.enabled.mechanisms=SCRAM-SHA-256sasl.mechanism.inter.broker.protocol=SCRAM-SHA-256listener.name.sasl_ssl.scram-sha-256.sasl.jaas.config=org.apache.kafka.common.security.scram.ScramLoginModule required; |

| SASL-Kerberos | sasl.enabled.mechanisms=GSSAPIsasl.mechanism.inter.broker.protocol=GSSAPIlistener.name.sasl_ssl.gssapi.sasl.jaas.config=com.sun.security.auth.module.Krb5LoginModule required useKeyTab=true keyTab="/path/kafka.keytab" principal="kafka/kafka-host@EXAMPLE.COM"; |

| SASL-OAUTHBEARER | sasl.enabled.mechanisms=OAUTHBEARERsasl.mechanism.inter.broker.protocol=OAUTHBEARERlistener.name.sasl_ssl.oauthbearer.sasl.jaas.config=org.apache.kafka.common.security.oauthbearer.OAuthBearerLoginModule required; |

3.3 客户端配置示例

1. Java 客户端(SSL 双向认证)

# 客户端配置文件(client-ssl.properties)bootstrap.servers=kafka-host:9094security.protocol=SSL# 客户端证书与私钥ssl.keystore.location=/path/client.keystore.jksssl.keystore.password=client123ssl.key.password=client123# 信任服务端证书ssl.truststore.location=/path/client.truststore.jksssl.truststore.password=client123

2. Python 客户端(SASL-SCRAM)

from confluent_kafka import Producer, Consumer# 配置字典conf = {'bootstrap.servers': 'kafka-host:9093','security.protocol': 'SASL_SSL', # 认证+加密'sasl.mechanism': 'SCRAM-SHA-256','sasl.username': 'alice', # 动态创建的SCRAM用户'sasl.password': 'alice123','ssl.ca.location': '/path/ca.crt' # 自签证书需指定CA}# 生产者示例(发送消息)producer = Producer(conf)producer.produce('test-topic', key='1', value='sasl-scram-test')producer.flush()# 消费者示例(接收消息)consumer = Consumer(conf)consumer.subscribe(['test-topic'])while True:msg = consumer.poll(1.0)if msg and not msg.error():print(f"消费消息:{msg.value().decode()}")四、Java 实现用户与 ACL 管理

Kafka 的SCRAM 用户管理和ACL 权限控制通过AdminClient API 实现,需管理员权限操作,依赖kafka-clients库。

4.1 依赖引入(Maven)

<dependency><groupId>org.apache.kafka</groupId><artifactId>kafka-clients</artifactId><version>3.6.1</version> <!-- 与Kafka集群版本一致 --></dependency>4.2 SCRAM 用户管理(创建 / 删除)

import org.apache.kafka.clients.admin.AdminClient;import org.apache.kafka.clients.admin.AdminClientConfig;import org.apache.kafka.common.security.scram.internals.ScramMechanism;import java.util.Properties;import java.util.concurrent.ExecutionException;public class ScramUserManager {private final AdminClient adminClient;// 初始化管理员客户端(需SASL-SCRAM认证)public ScramUserManager(String bootstrapServers) {Properties props = new Properties();props.put(AdminClientConfig.BOOTSTRAP_SERVERS_CONFIG, bootstrapServers);props.put(AdminClientConfig.SECURITY_PROTOCOL_CONFIG, "SASL_SSL");props.put("sasl.mechanism", "SCRAM-SHA-256");// 管理员账号配置(需提前创建)props.put("sasl.jaas.config","org.apache.kafka.common.security.scram.ScramLoginModule required " +"username=\"admin\" password=\"admin123\";");this.adminClient = AdminClient.create(props);}// 🔴 动态创建SCRAM用户(Kafka自动生成盐值与迭代次数)public void createUser(String username, String password) throws ExecutionException, InterruptedException {adminClient.alterUserScramCredentials(ScramMechanism.SCRAM_SHA_256, // 哈希算法username,password.toCharArray()).all().get();System.out.println("用户 " + username + " 创建成功");}// 🔴 动态删除SCRAM用户public void deleteUser(String username) throws ExecutionException, InterruptedException {adminClient.deleteUserScramCredentials(ScramMechanism.SCRAM_SHA_256,username).all().get();System.out.println("用户 " + username + " 删除成功");}// 测试示例public static void main(String[] args) throws Exception {ScramUserManager manager = new ScramUserManager("kafka-host:9093");manager.createUser("alice", "alice123"); // 创建用户alicemanager.deleteUser("alice"); // (可选)删除用户alicemanager.adminClient.close(); // 关闭客户端,释放资源}}4.3 ACL 权限管理(增删查)

import org.apache.kafka.clients.admin.AdminClient;import org.apache.kafka.clients.admin.AdminClientConfig;import org.apache.kafka.common.acl.AclBinding;import org.apache.kafka.common.acl.AclOperation;import org.apache.kafka.common.acl.AclPermissionType;import org.apache.kafka.common.resource.PatternType;import org.apache.kafka.common.resource.ResourcePattern;import org.apache.kafka.common.resource.ResourceType;import java.util.Collections;import java.util.Properties;import java.util.concurrent.ExecutionException;public class AclManager {private final AdminClient adminClient;// 初始化管理员客户端(同用户管理)public AclManager(String bootstrapServers) {Properties props = new Properties();props.put(AdminClientConfig.BOOTSTRAP_SERVERS_CONFIG, bootstrapServers);props.put(AdminClientConfig.SECURITY_PROTOCOL_CONFIG, "SASL_SSL");props.put("sasl.mechanism", "SCRAM-SHA-256");props.put("sasl.jaas.config","org.apache.kafka.common.security.scram.ScramLoginModule required " +"username=\"admin\" password=\"admin123\";");this.adminClient = AdminClient.create(props);}// 🔴 添加ACL:允许用户alice读取test-topicpublic void addAcl() throws ExecutionException, InterruptedException {// 1. 定义资源:主题test-topic(精确匹配)ResourcePattern topicResource = new ResourcePattern(ResourceType.TOPIC,"test-topic",PatternType.LITERAL);// 2. 定义权限:允许alice读取,所有主机可访问AclBinding acl = new AclBinding(topicResource,new org.apache.kafka.common.acl.AccessControlEntry("User:alice", // SCRAM用户前缀为"User:""*", // 允许所有主机AclOperation.READ, // 权限类型:读取AclPermissionType.ALLOW // 允许访问));// 3. 执行创建adminClient.createAcls(Collections.singleton(acl)).all().get();System.out.println("ACL添加成功(alice可读取test-topic)");}// 测试示例public static void main(String[] args) throws Exception {AclManager manager = new AclManager("kafka-host:9093");manager.addAcl(); // 给alice添加读权限manager.adminClient.close();}}五、Python 实现用户与 ACL 管理

Python 通过confluent-kafka库实现 ACL 管理,SCRAM 用户创建需补充 Kafka 命令行(暂不支持 API 直接创建)。

5.1 依赖安装

pip install confluent-kafka # 版本需≥2.0.0(支持AdminClient)5.2 ACL 管理示例(增删查)

from confluent_kafka.admin import (AdminClient, AclBinding, ResourcePattern, ResourceType,AccessControlEntry, AclOperation, AclPermissionType, PatternType)def init_admin_client() -> AdminClient:"""🔴 初始化管理员客户端(需SASL-SCRAM认证)"""return AdminClient({'bootstrap.servers': 'kafka-host:9093','security.protocol': 'SASL_SSL','sasl.mechanism': 'SCRAM-SHA-256','sasl.username': 'admin','sasl.password': 'admin123','ssl.ca.location': '/path/ca.crt' # 自签证书需指定CA根证书})def add_acl(admin_client: AdminClient) -> None:"""🔴 添加ACL:允许用户bob写入test-topic"""# 1. 定义资源:主题test-topicresource = ResourcePattern(ResourceType.TOPIC,'test-topic',PatternType.LITERAL # 精确匹配主题名)# 2. 定义权限:允许bob写入entry = AccessControlEntry(principal='User:bob', # SCRAM用户前缀host='*',operation=AclOperation.WRITE,permission_type=AclPermissionType.ALLOW)# 3. 创建ACL绑定acl_binding = AclBinding(resource, entry)# 4. 执行创建fs = admin_client.create_acls([acl_binding])for future in fs.values():future.result() # 等待执行完成print("ACL添加成功(bob可写入test-topic)")def describe_acls(admin_client: AdminClient) -> None:"""🔴 查询test-topic的所有ACL规则"""# 定义筛选条件:主题test-topic的所有ACLfilter_binding = AclBinding(ResourcePattern(ResourceType.TOPIC, 'test-topic', PatternType.LITERAL),AccessControlEntry('*', '*', AclOperation.ANY, AclPermissionType.ANY))# 执行查询acls = admin_client.describe_acls(filter_binding)print("test-topic的ACL规则:")for acl in acls:print(f" - {acl}")# 测试示例if __name__ == "__main__":admin = init_admin_client()add_acl(admin)describe_acls(admin)admin.close() # 关闭客户端5.3 SCRAM 用户创建(命令行辅助)

Python 暂不支持通过 API 创建 SCRAM 用户,需用 Kafka 自带kafka-configs.sh命令行:

# 🔴 创建SCRAM用户bob(SCRAM-SHA-256算法)

# 🔴 创建SCRAM用户bob(SCRAM-SHA-256算法)kafka-configs.sh --bootstrap-server kafka-host:9093 \--entity-type users --entity-name bob \--alter --add-config 'SCRAM-SHA-256=[password=bob123]' \--command-config /path/admin.config # 管理员配置文件(含admin账号密码)# 🔴 验证用户是否创建成功kafka-configs.sh --bootstrap-server kafka-host:9093 \--entity-type users --entity-name bob \--describe --command-config /path/admin.configkafka-configs.sh --bootstrap-server kafka-host:9093 \

--entity-type users --entity-name bob \

--alter --add-config 'SCRAM-SHA-256=[password=bob123]' \

--command-config /path/admin.config # 管理员配置文件(含admin账号密码)

# 🔴 验证用户是否创建成功

kafka-configs.sh --bootstrap-server kafka-host:9093 \

--entity-type users --entity-name bob \

--describe --command-config /path/admin.config

六、Kerberos 与企业级生态集成

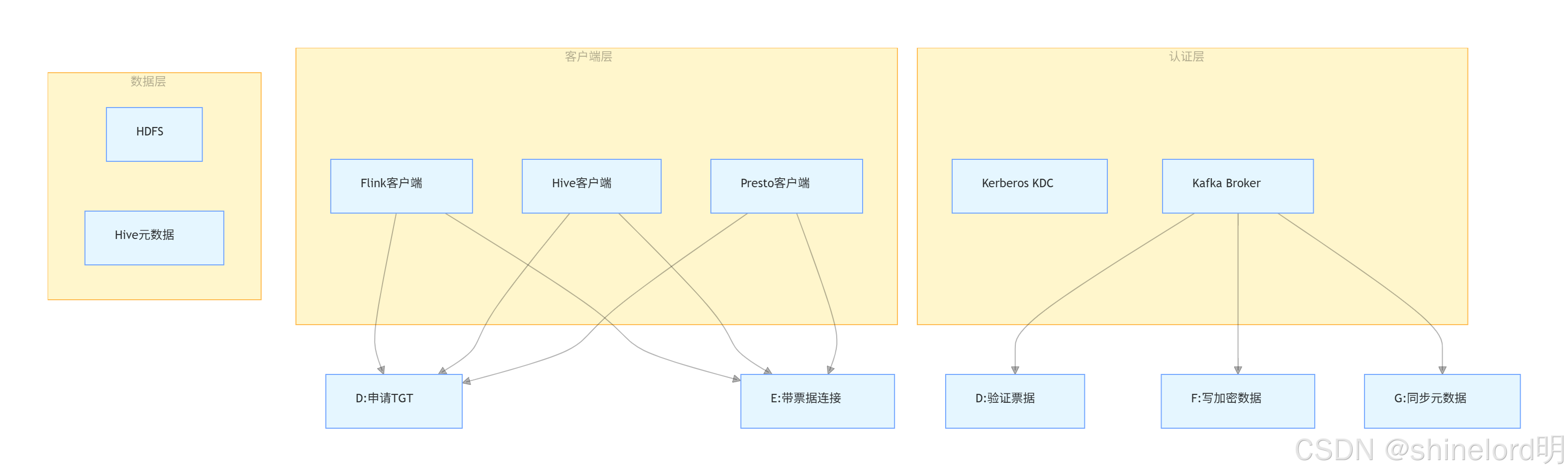

在企业级数据平台中,Kafka 需与OLAP 工具(Hive/Presto/ClickHouse) 、权限系统(Apache Ranger) 联动,Kerberos 作为统一身份认证标准,是集成的核心纽带。

6.1 Kerberos 与 Kafka 集成原理

6.2 Kerberos 与 OLAP 工具集成配置

1. Hive 集成 Kafka(Kerberos 认证)

Hive 通过KafkaStorageHandler读取 Kafka 数据,需在 Hive 配置中注入 Kerberos 信息:

<!-- hive-site.xml 配置 -->

<property>

<name>hive.execution.engine</name>

<value>tez</value> <!-- 或Spark,需确保引擎也启用Kerberos -->

</property>

<property>

<name>hive.metastore.sasl.enabled</name>

<value>true</value> <!-- 若Metastore启用Kerberos -->

</property>

<!-- 创建Kafka外部表 -->

CREATE EXTERNAL TABLE kafka_user_events (

id INT,

username STRING,

event_time TIMESTAMP

)

STORED BY 'org.apache.hadoop.hive.kafka.KafkaStorageHandler'

TBLPROPERTIES (

"kafka.bootstrap.servers" = "kafka-host:9095", # Kerberos监听端口

"kafka.topic" = "user-events",

"kafka.sasl.kerberos.service.name" = "kafka", # Kerberos服务名

"kafka.security.protocol" = "SASL_SSL",

"kafka.sasl.mechanism" = "GSSAPI"

);

<!-- 访问表前获取Kerberos票据 -->

kinit -kt /path/hive-user.keytab hive-user@EXAMPLE.COM

hive -e "SELECT * FROM kafka_user_events LIMIT 10;"

2. Presto 集成 Kafka(Kerberos 认证)

Presto 通过 Kafka Connector 访问数据,需在 Connector 配置中添加 Kerberos 参数:

# presto/etc/catalog/kafka.properties

connector.name=kafka

kafka.bootstrap.servers=kafka-host:9095

# Kerberos认证配置

kafka.security.protocol=SASL_SSL

kafka.sasl.kerberos.service.name=kafka

kafka.sasl.mechanism=GSSAPI

# Presto服务的Kerberos主体(需在KDC注册)

kafka.kerberos.principal=presto/kafka-host@EXAMPLE.COM

kafka.kerberos.keytab=/path/presto.keytab

# 查询Kafka数据(无需手动kinit,Presto自动用keytab获取票据)

SELECT * FROM kafka.default.user_events LIMIT 10;

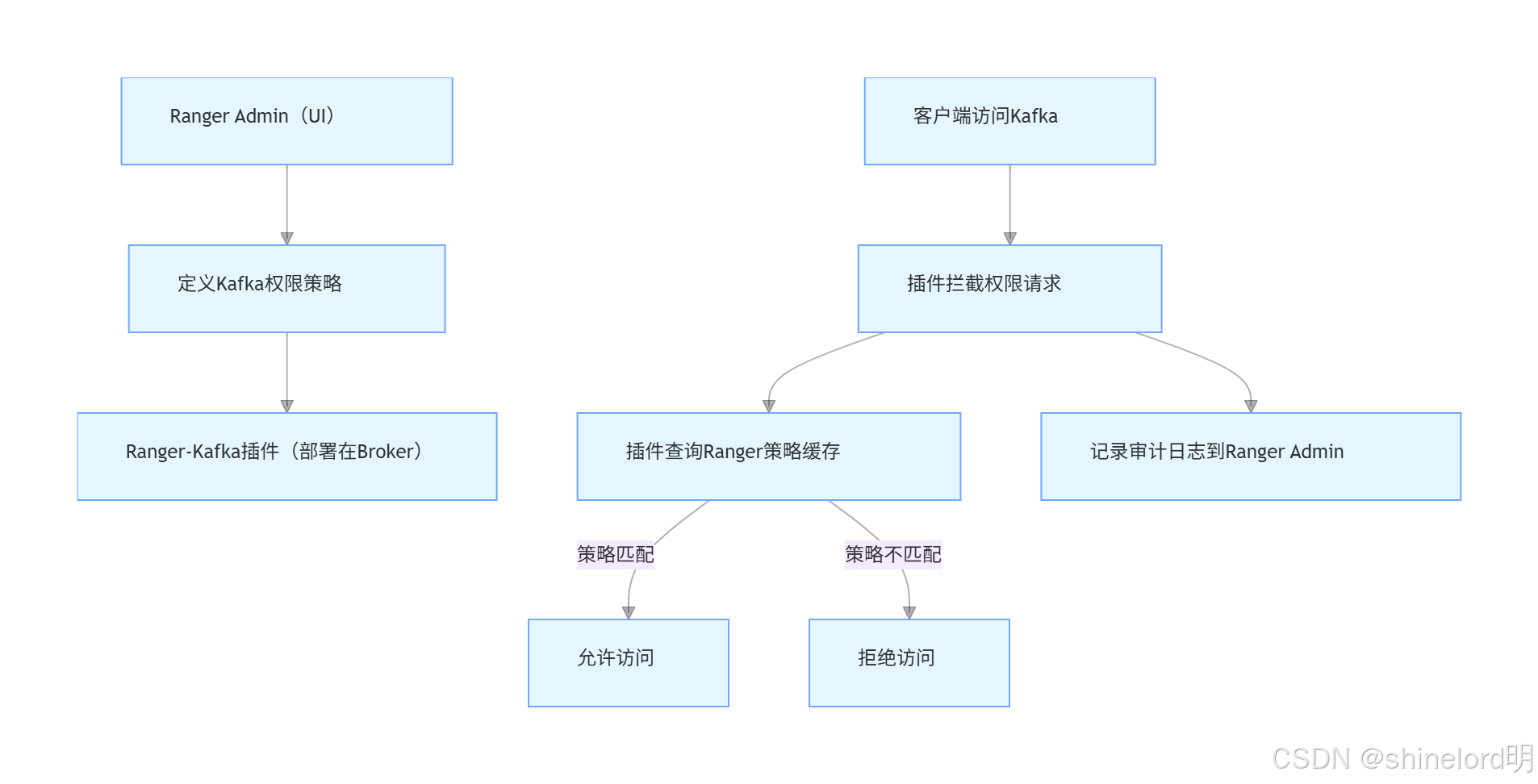

6.3 Apache Ranger 集成 Kafka(集中权限管控)

Apache Ranger 是 Hadoop 生态的集中式权限工具,可替代 Kafka 原生 ACL,提供 UI 操作、审计日志等企业级特性。

集成原理

Ranger 与 Kafka 原生 ACL 对比表

| 特性 | Kafka 原生 ACL | Apache Ranger |

| 🔵 管理方式 | 命令行 / API(无 UI) | 可视化 UI(支持角色管理) |

| 🟢 权限粒度 | 主题 / 组 / 集群级 | 主题 / 分区 / 字段级(支持数据掩码) |

| 🟡 审计日志 | 无(需手动埋点) | 详细记录访问 / 授权事件(时间 / IP / 用户) |

| 🟣 动态更新 | 需显式执行命令 | 实时同步策略(无需重启 Broker) |

| 🔴 多租户支持 | 弱(依赖主体命名规范) | 强(支持部门 / 角色分组) |

七、最佳实践与总结

7.1 核心最佳实践(按场景分类)

1. 中小集群(10 节点以内)

- 🔵 认证选型:SASL-SCRAM(低运维 + 高扩展性)

- 🟢 性能优化:开启连接复用,减少 SCRAM 握手开销

- 🟡 安全加固:定期轮换用户密码(90 天),禁用明文协议

- 🔴 权限管理:用 Java/Python API 动态管理 ACL,遵循最小权限原则

2. 大型企业集群(50 节点以上)

- 🔵 认证选型:Kerberos+Ranger(统一身份 + 集中权限)

- 🟢 性能优化:延长 Kerberos 票据有效期(10 小时),Ranger 策略缓存设为 5 秒

- 🟡 运维简化:用配置中心(Apollo/Nacos)管理 keytab / 证书路径

- 🔴 审计合规:开启 Ranger 审计日志,满足 SOX/PCI 合规要求

3. 云原生场景(K8s 部署)

- 🔵 认证选型:SASL-OAUTHBEARER(动态 Token + 云服务集成)

- 🟢 性能优化:Token 有效期设为 15-30 分钟,开启自动刷新

- 🟡 安全加固:用 K8s Secret 存储 OAuth 客户端密钥,避免硬编码

- 🔴 扩展性:对接云厂商身份服务(AWS Cognito / 阿里云 RAM)

7.2 总结

Kafka 认证机制的选择需匹配业务规模与安全需求:

- 中小集群优先SASL-SCRAM,平衡成本与安全性;

- 企业级集群首选Kerberos+Ranger,实现统一身份与集中管控;

- 云原生场景推荐SASL-OAUTHBEARER,适配动态接入与第三方服务。

通过 “认证(SSL/Kerberos)- 授权(ACL/Ranger)- 加密(SSL)- 审计(Ranger)” 全链路设计,可构建生产级安全 Kafka 集群,保障数据从传输到存储的完整性与保密性。