零基础学AI大模型之RAG系统链路解析与Document Loaders多案例实战

| 大家好,我是工藤学编程 🦉 | 一个正在努力学习的小博主,期待你的关注 |

|---|---|

| 实战代码系列最新文章😉 | C++实现图书管理系统(Qt C++ GUI界面版) |

| SpringBoot实战系列🐷 | 【SpringBoot实战系列】SpringBoot3.X 整合 MinIO 存储原生方案 |

| 分库分表 | 分库分表之实战-sharding-JDBC分库分表执行流程原理剖析 |

| 消息队列 | 深入浅出 RabbitMQ-RabbitMQ消息确认机制(ACK) |

| AI大模型 | 零基础学AI大模型之大模型的“幻觉” |

前情摘要:

1、零基础学AI大模型之读懂AI大模型

2、零基础学AI大模型之从0到1调用大模型API

3、零基础学AI大模型之SpringAI

4、零基础学AI大模型之AI大模型常见概念

5、零基础学AI大模型之大模型私有化部署全指南

6、零基础学AI大模型之AI大模型可视化界面

7、零基础学AI大模型之LangChain

8、零基础学AI大模型之LangChain六大核心模块与大模型IO交互链路

9、零基础学AI大模型之Prompt提示词工程

10、零基础学AI大模型之LangChain-PromptTemplate

11、零基础学AI大模型之ChatModel聊天模型与ChatPromptTemplate实战

12、零基础学AI大模型之LangChain链

13、零基础学AI大模型之Stream流式输出实战

14、零基础学AI大模型之LangChain Output Parser

15、零基础学AI大模型之解析器PydanticOutputParser

16、零基础学AI大模型之大模型的“幻觉”

17、零基础学AI大模型之RAG技术

本文章目录

- 零基础学AI大模型之RAG系统链路解析与Document Loaders多案例实战

- 一、RAG系统核心链路:从数据到生成的完整流程

- 1.1 RAG数据流流水线示意图

- 1.2 RAG关键技术环节解析

- 二、RAG与LLM交互架构:为什么RAG能解决“幻觉”?

- 2.1 RAG与LLM交互架构图

- 2.2 架构核心优势

- 三、Document Loaders核心概念:LangChain如何统一数据入口?

- 3.1 LangChain Loaders的核心设计:BaseLoader接口

- 3.2 Document对象:数据的“统一载体”

- 3.3 Loaders分类:覆盖所有常见数据源

- 四、Document Loaders多案例实战:从理论到代码

- 前置准备:安装依赖

- 案例1:TextLoader——加载纯文本文件

- 实战代码

- 关键说明

- 案例2:CSVLoader——加载Excel表格数据

- 实战场景

- 实战代码

- 关键说明

- 案例3:JSONLoader——加载JSON文件(复杂结构解析)

- 实战场景

- 实战代码

- 关键:jq_schema语法常用模式

- 五、Loaders实战常见问题与解决方案

- 六、总结

零基础学AI大模型之RAG系统链路解析与Document Loaders多案例实战

在之前的AI大模型系列中,我们从基础概念(如大模型“幻觉”、LangChain核心模块)逐步深入到实战(如Stream流式输出、PydanticOutputParser解析),并在第17篇初步提及RAG技术的重要性。

RAG(Retrieval-Augmented Generation,检索增强生成)是解决大模型“幻觉”的核心方案——通过“检索外部知识”为LLM提供精准上下文,让生成结果更可靠。但RAG系统并非单一技术,而是一条完整的“数据处理→存储→检索→生成”链路,其中数据加载(Document Loaders)是整个链路的“入口” ——没有高质量的原始数据加载,后续的向量化、检索都无从谈起。

本文将聚焦RAG系统的完整链路解析,并通过多案例实战,带你掌握LangChain中Document Loaders的核心用法,为后续RAG项目打下坚实基础。

一、RAG系统核心链路:从数据到生成的完整流程

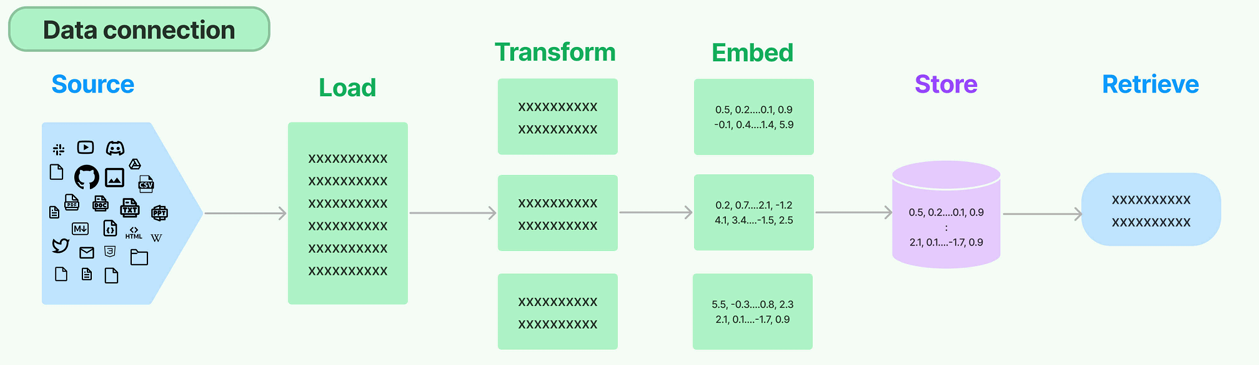

RAG的本质是“让LLM带着外部知识回答问题”,其核心链路可拆解为数据准备”和“检索生成”两大阶段,每个阶段包含多个关键技术环节。理解这条链路,是后续实战的前提。

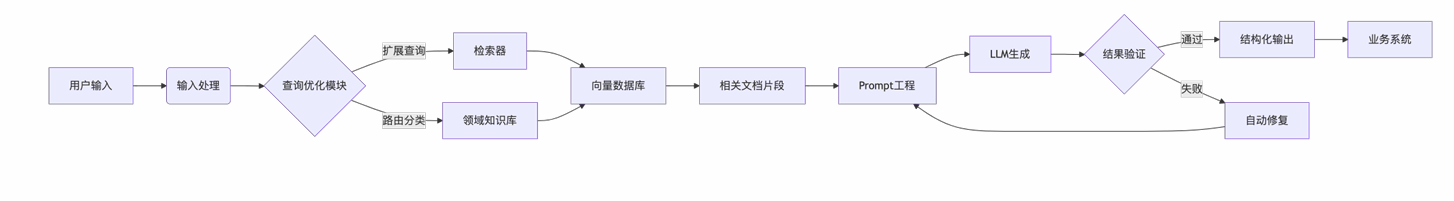

1.1 RAG数据流流水线示意图

原始数据需要经过一系列处理,才能最终为LLM提供有效支撑,完整流程如下:

1.2 RAG关键技术环节解析

链路中每个环节都有明确的职责,缺一不可:

- 文档加载器(Document Loaders):本文核心,负责将不同来源、不同格式的原始数据(如本地PDF、在线网页、MySQL数据库)转为LangChain统一的

Document对象,解决“数据入口不统一”问题。 - 文档转换器(Document Transformers):对

Document进行清洗(去除乱码、空白行)和分块(如按500字符/块分割),避免长文本向量化时的语义失真。 - 文本嵌入模型(Embedding Models):如OpenAI的

text-embedding-3-small、开源的BERT,负责将文本转为高维向量(如1536维),让计算机能通过“向量距离”判断文本相似度。 - 向量存储(Vector Stores):如Pinecone、Chroma、Milvus,专门存储文本向量,支持快速相似性检索(毫秒级找到与查询最像的文本)。

- 检索器(Retrievers):定义检索逻辑(如“相似性检索Top 3”“关键词过滤+相似性检索”),从向量库中抓取与用户查询匹配的上下文。

二、RAG与LLM交互架构:为什么RAG能解决“幻觉”?

传统LLM直接生成回答时,依赖的是训练时的“记忆”,但存在“知识过时”“虚构信息”问题;而RAG通过“检索+生成”的交互模式,让LLM“带着参考资料答题”,从根本上减少幻觉。

2.1 RAG与LLM交互架构图

2.2 架构核心优势

- 知识实时更新:无需重新训练LLM,只需更新向量库中的数据(如新增2024年LangChain新特性),即可让LLM获取最新知识。

- 结果可追溯:生成的回答可对应到具体的原始数据(如“该结论来自XX PDF第5页”),便于验证准确性。

- 降低训练成本:无需训练千亿参数的大模型,用中小模型(如7B的Llama3)+ RAG,即可实现高精度回答。

三、Document Loaders核心概念:LangChain如何统一数据入口?

LangChain为了解决“不同数据源适配”问题,设计了统一的加载器接口,无论原始数据格式如何,最终都能转为Document对象。

3.1 LangChain Loaders的核心设计:BaseLoader接口

LangChain所有加载器都继承自抽象类BaseLoader,确保统一的调用方式。核心接口定义如下(简化版):

from abc import ABC, abstractmethod

from langchain_core.documents import Documentclass BaseLoader(ABC):# 懒加载(生成器模式,避免大文件加载时内存溢出)@abstractmethoddef lazy_load(self) -> Iterable[Document]:pass# 直接加载(返回Document列表,内部调用lazy_load)def load(self) -> list[Document]:return list(self.lazy_load())

load()方法:最常用,直接返回所有Document组成的列表,适合小文件。lazy_load()方法:生成器模式,逐个返回Document,适合大文件(如1000页的PDF),避免一次性加载到内存导致OOM。

3.2 Document对象:数据的“统一载体”

所有Loader最终输出的都是Document对象,其结构非常简单,包含两个核心字段:

class Document(BaseMedia):page_content: str # 文本内容(如PDF某一页的文字、CSV某一行的数据)metadata: dict # 元数据(如来源路径、页码、行号,便于后续追溯)type: Literal["Document"] = "Document"

示例Document对象:

Document(page_content="LangChain Loaders支持PDF、CSV、网页等多种数据源",metadata={"source": "data/rag_intro.pdf", "page": 3} # 来源PDF第3页

)

3.3 Loaders分类:覆盖所有常见数据源

LangChain的langchain_community.document_loaders模块提供了上百种Loader,按数据源类型可分为三大类:

| 分类 | Loader类型 | 功能描述 | 适用场景 |

|---|---|---|---|

| 文件加载器 | TextLoader | 加载纯文本文件(.txt) | 本地日志文件、纯文本笔记 |

| PyPDFLoader | 加载PDF文件,支持提取页码元数据 | 技术文档、论文 | |

| Docx2txtLoader | 加载Word文档(.docx) | 工作报告、需求文档 | |

| CSVLoader | 加载CSV文件,按行生成Document | 数据报表、用户列表 | |

| 网页加载器 | WebBaseLoader | 抓取静态网页文本(无需JS渲染) | 博客文章、百科页面 |

| SeleniumURLLoader | 加载动态网页(需JS渲染,如Vue/React页面) | 电商商品页、登录后页面 | |

| 数据库加载器 | SQLDatabaseLoader | 执行SQL查询,加载结果为Document | MySQL、PostgreSQL等关系库 |

| MongoDBLoader | 从MongoDB集合中加载文档 | NoSQL数据库数据 |

四、Document Loaders多案例实战:从理论到代码

光说不练假把式,下面通过3个最常用的Loader案例(TextLoader、CSVLoader、JSONLoader),带你掌握实战技巧,所有代码可直接复制运行。

前置准备:安装依赖

首先安装LangChain及Loader所需的额外依赖:

# 核心依赖:LangChain

pip install langchain langchain-community

# JSONLoader需要jq(处理JSON解析)

pip install jq

案例1:TextLoader——加载纯文本文件

纯文本文件(.txt)是最基础的数据源,TextLoader支持自定义编码,解决中文乱码问题。

实战代码

from langchain_community.document_loaders import TextLoader# 1. 初始化Loader(处理中文文件时,建议开启autodetect_encoding)

loader = TextLoader(file_path="data/test.txt", # 本地文本文件路径encoding="utf-8", # 编码格式(默认utf-8)autodetect_encoding=True # 自动检测编码(解决中文乱码)

)# 2. 加载数据(返回Document列表)

documents = loader.load()# 3. 查看结果

print(f"加载的Document数量:{len(documents)}") # 输出:1(纯文本文件默认1个Document)

print(f"\n前100个字符内容:{documents[0].page_content[:100]}")

print(f"\n元数据:{documents[0].metadata}") # 输出:{'source': 'data/test.txt'}

关键说明

- 中文乱码解决:如果

test.txt是GBK编码,直接用encoding="utf-8"会乱码,开启autodetect_encoding=True后,Loader会自动识别编码。 - 大文本处理:如果

test.txt有10万行,用lazy_load()逐个获取Document:for doc in loader.lazy_load():print(doc.page_content[:50]) # 逐个打印每行前50字符

案例2:CSVLoader——加载Excel表格数据

CSV文件(.csv)常用于存储结构化数据(如销售报表),CSVLoader支持按行生成Document,且可指定字段名。

实战场景

假设data/sales.csv文件内容如下(销售数据):

产品名称,销售数量,客户名称

手机,100,张三

电脑,50,李四

平板,30,王五

实战代码

from langchain_community.document_loaders import CSVLoader# 1. 初始化Loader(指定CSV分隔符和字段名)

loader = CSVLoader(file_path="data/sales.csv",csv_args={"delimiter": ",", # CSV分隔符(默认逗号,Excel导出的CSV常用)"fieldnames": ["产品名称", "销售数量", "客户名称"] # 字段名(可选,默认用首行)},source_column="产品名称" # 将“产品名称”作为metadata的source字段(便于追溯)

)# 2. 加载数据

documents = loader.load()# 3. 查看结果

print(f"加载的Document数量:{len(documents)}") # 输出:3(3行数据,不含表头)

print(f"\n第1条数据内容:{documents[0].page_content}")

# 输出:产品名称: 手机, 销售数量: 100, 客户名称: 张三

print(f"\n第1条数据元数据:{documents[0].metadata}")

# 输出:{'source': '手机', 'row': 0}(row为行号,从0开始)

关键说明

- 自定义分隔符:如果CSV是用制表符(\t)分隔,需将

delimiter设为"\t"。 - 字段筛选:如果只需加载“产品名称”和“销售数量”,可在

csv_args中添加"usecols": ["产品名称", "销售数量"]。

案例3:JSONLoader——加载JSON文件(复杂结构解析)

JSON文件常用于存储半结构化数据(如接口返回、日志),JSONLoader的核心是通过jq_schema指定数据提取规则,支持复杂结构解析。

实战场景

假设data/articles.json文件内容如下(文章列表):

{"status": "success","data": {"articles": [{"id": 1,"title": "RAG系统链路解析","content": "RAG包含加载、预处理、向量化、存储、检索五大环节","author": "工藤学编程","date": "2024-05-20"},{"id": 2,"title": "Document Loaders实战","content": "TextLoader适合纯文本,CSVLoader适合表格数据","author": "工藤学编程","date": "2024-05-21"}]}

}

实战代码

from langchain_community.document_loaders import JSONLoader# 1. 初始化Loader(核心:jq_schema指定提取规则)

loader = JSONLoader(file_path="data/articles.json",jq_schema=".data.articles[]", # 提取data.articles数组中的每个元素content_key="content", # 将“content”字段作为Document的page_content# 自定义元数据(将id、title、author添加到metadata)metadata_func=lambda record: {"article_id": record["id"],"title": record["title"],"author": record["author"],"date": record["date"]}

)# 2. 加载数据

documents = loader.load()# 3. 查看结果

print(f"加载的Document数量:{len(documents)}") # 输出:2(articles数组有2个元素)

print(f"\n第1篇文章内容:{documents[0].page_content}")

# 输出:RAG包含加载、预处理、向量化、存储、检索五大环节

print(f"\n第1篇文章元数据:{documents[0].metadata}")

# 输出:{'article_id': 1, 'title': 'RAG系统链路解析', 'author': '工藤学编程', 'date': '2024-05-20'}

关键:jq_schema语法常用模式

jq_schema是JSONLoader的核心,用于定义“从JSON中提取哪些数据”,常用语法如下:

| 需求场景 | jq_schema示例 | 说明 |

|---|---|---|

| 提取根级数组 | “.[]” | 适合JSON本身是数组(如[{“id”:1},{“id”:2}]) |

| 提取嵌套数组 | “.data.articles[]” | 提取深层数组元素(如本文案例) |

| 条件过滤 | ".data.articles[] | select(.id > 1)" |

| 多字段合并 | ".data.articles[] | {c: .content, t: .title}" |

五、Loaders实战常见问题与解决方案

实战中难免遇到各种问题,这里整理3个高频问题及解决方案:

| 常见问题 | 原因分析 | 解决方案 |

|---|---|---|

| 中文乱码(如“��”) | 文本编码与Loader指定的encoding不匹配 | 1. 开启autodetect_encoding=True;2. 手动指定编码(如encoding="gbk") |

| JSONLoader报错“jq: error” | jq_schema语法错误,或JSON结构与预期不符 | 1. 用jq在线验证工具测试语法;2. 打印原始JSON确认结构 |

六、总结

本文我们掌握了RAG系统的核心链路,以及作为“数据入口”的Document Loaders实战技巧。

如果觉得本文有帮助,欢迎点赞+关注,你的支持是我持续更新的动力!有任何问题,也可以在评论区留言交流~