云原生时代的数据库字段加密:在微服务与 Kubernetes 中实现合规与敏捷的统一

引言:当“上云”遇上“加密”,矛盾如何化解?

某金融科技公司完成微服务改造后,将 200+ 服务部署在 Kubernetes 集群中,数据库迁至云厂商 RDS。然而在密评整改中却遭遇难题:

- 每个服务都可能访问用户身份证号、手机号;

- 若在每个 Pod 中嵌入加密逻辑,代码改造量巨大;

- 云 RDS 的 TDE 仅加密磁盘,不满足“字段级加密”要求;

- 运维团队无法统一管理密钥与策略。

这并非个例。随着企业全面拥抱云原生,数据库加密面临三大新挑战:

- 架构碎片化:微服务导致数据访问入口分散;

- 部署动态化:Pod 生命周期短暂,传统代理难以适配;

- 合规刚性化:密评明确要求“重要数据字段级加密 + 国密算法”。

如何在不牺牲云原生敏捷性的前提下,实现统一、合规、低侵入的字段加密?本文将深入探讨云原生环境下数据库加密的架构演进、技术选型与落地路径。

第一章:云原生对数据库加密的新要求

1.1 微服务架构下的加密困境

在单体架构中,加密逻辑可集中于 DAO 层;但在微服务架构中:

- 每个服务独立访问数据库;

- 技术栈异构(Java、Go、Python);

- 服务数量动辄上百,策略难以统一。

若采用应用层加密:

- 需为每种语言开发加密 SDK;

- 密钥配置分散,易泄露;

- 查询逻辑复杂化(如无法直接 WHERE 加密字段)。

核心矛盾:DevOps 追求“去中心化”,而安全要求“集中管控”。

1.2 Kubernetes 环境的特殊性

- Pod IP 动态分配,传统基于 IP 的访问控制失效;

- 容器无持久化存储,密钥不能写入本地;

- 服务网格(如 Istio)已接管流量,加密方案需与之协同。

1.3 合规要求不因上云而降低

《商用密码管理条例》《密评规范》明确:

- 无论数据在本地还是云上,均需加密;

- 算法必须为 SM2/SM3/SM4;

- 密钥必须由合规密码模块管理。

第二章:主流方案对比:从 SDK 到服务网格

2.1 方案一:应用 SDK 加密(侵入式)

原理:每个服务引入加密 SDK,写入前加密,读取后解密。

问题:

- 改造成本高,尤其对遗留服务;

- 多语言 SDK 维护困难;

- 无法支持 SQL 原生查询(如

WHERE phone = ?需传入密文); - 密钥轮换需重启所有服务。

适用性:仅适合全新、技术栈统一的项目。

2.2 方案二:Sidecar 代理模式(半透明)

原理:为每个 Pod 注入一个加密 Sidecar 容器,拦截数据库流量。

优点:

- 对主应用无侵入;

- 可统一加密逻辑;

- 与 Kubernetes 生命周期一致。

挑战:

- 需修改 Deployment YAML,增加运维复杂度;

- Sidecar 资源开销需评估;

- 多数据库协议支持需自研。

2.3 方案三:服务网格集成(Istio + Mixer)

原理:通过 Istio Mixer 扩展,在流量路径中加入加密逻辑。

问题:

- Istio 已弃用 Mixer,新版本依赖 WASM 插件;

- 数据库协议(MySQL)非 HTTP,集成难度大;

- 性能损耗显著。

结论:目前服务网格对数据库加密支持有限。

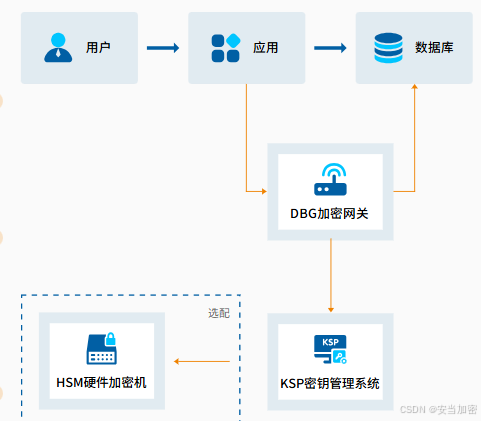

2.4 方案四:集中式数据库加密网关(透明代理)

原理:在 Kubernetes 集群外或 Ingress 层部署加密网关,所有服务连接网关而非直连数据库。

优点:

- 零代码改造:服务连接方式不变;

- 策略集中管理:统一配置哪些字段加密;

- 密钥统一托管:对接合规密码服务;

- 兼容云原生网络:支持 Service、Ingress、LoadBalancer。

挑战:

- 引入单点,需高可用设计;

- 网络路径增加一跳,延迟略升。

趋势:该方案正成为云原生环境下字段加密的主流选择。

第三章:集中式加密网关的云原生适配架构

3.1 部署模式

模式一:集群外独立部署(推荐)

- 加密网关部署在 VPC 内,独立于 K8s 集群;

- 服务通过 K8s Service 或 ExternalName 访问网关;

- 优势:升级、扩缩容不影响业务 Pod。

模式二:集群内 DaemonSet 部署

- 每个 Node 部署一个网关实例;

- 服务通过 localhost 访问;

- 优势:低延迟;劣势:资源占用高,运维复杂。

3.2 与 Kubernetes 原生集成

- ConfigMap 管理策略:将加密策略以 YAML 形式存入 ConfigMap,实现“策略即代码”;

- Secret 管理证书:网关 TLS 证书通过 Secret 注入;

- HPA 自动扩缩容:根据 QPS 自动调整网关副本数;

- Service Mesh 协同:网关出口流量可被 Istio 管控,实现端到端 mTLS。

3.3 密钥安全与合规

- 网关不存储私钥,每次加解密调用外部 KSP(密钥管理系统);

- KSP 对接国密 HSM,私钥不出设备;

- 所有操作留痕,满足密评审计要求。

第四章:典型场景落地实践

4.1 场景一:金融微服务——统一加密,分权访问

背景:

- 信贷、支付、风控等 50+ 微服务共享用户库;

- 信贷服务需完整身份证号,风控仅需脱敏后四位。

方案:

- 部署集中式加密网关;

- 配置策略:

- 所有服务写入时自动 SM4 加密身份证号;

- 读取时,根据服务账号(ServiceAccount)返回不同视图:

svc-loan→ 明文;svc-risk→1101011990******123X。

效果:

- 无需修改任何服务代码;

- 满足《金融数据安全分级指南》对“差异化访问”的要求。

4.2 场景二:政务云 SaaS 平台——多租户隔离加密

背景:

- 一套 SaaS 系统服务多个委办局;

- 各局数据物理隔离,但共享同一数据库实例。

方案:

- 网关根据 JWT Token 中的

tenant_id动态选择密钥; - 写入时自动加密,密文存入同一表;

- 读取时仅能解密本租户数据。

效果:

- 实现“逻辑隔离 + 加密隔离”双重保障;

- 通过等保三级与密评。

4.3 场景三:DevOps 测试环境——快速克隆安全数据

背景:

- 每日从生产库克隆数据到测试环境;

- 需确保测试库不含真实敏感信息。

方案:

- 生产库字段已加密;

- 克隆时直接复制密文;

- 测试环境连接同一加密网关,但配置脱敏策略。

效果:

- 克隆速度提升(无需脱敏计算);

- 测试数据始终安全。

技术实现参考:此类云原生场景要求加密网关支持 Kubernetes 原生集成、多租户密钥隔离及动态脱敏。例如,安当 DBG(Database Guard)数据库加密网关提供容器化镜像,支持 Helm Chart 部署。

第五章:合规对齐:满足密评的关键控制点

| 密评要求 | 云原生实现方式 |

|---|---|

| 重要数据加密 | 对身份证、手机号等字段使用 SM4 加密 |

| 算法合规 | 网关内置 SM4/SM3,禁用 AES/SHA1 |

| 密钥管理 | 私钥由KSP + HSM 管理,网关仅持令牌 |

| 访问控制 | 基于 K8s ServiceAccount 或 JWT 鉴权 |

| 审计日志 | 记录加解密操作,日志输出至 Loki/ES |

特别注意:若加密方案未通过商用密码产品认证,即使技术实现合规,密评仍可能不通过。企业应优先选择具备认证资质的标准化产品。

第六章:实施建议与避坑指南

6.1 分阶段推进

| 阶段 | 目标 | 关键动作 |

|---|---|---|

| 1. 评估 | 识别敏感字段与服务依赖 | 使用 eBPF 或流量镜像分析数据库访问模式 |

| 2. 试点 | 选择 2–3 个非核心服务验证 | 部署网关,配置简单加密策略 |

| 3. 推广 | 全量迁移 | 通过 ConfigMap 批量下发策略 |

| 4. 治理 | 纳入 GitOps | 策略文件纳入 Git 仓库,CI/CD 自动部署 |

6.2 性能与高可用设计

- 性能:启用连接池复用,减少 TLS 握手开销;

- 高可用:网关部署至少 2 副本,配合 Liveness/Readiness 探针;

- 灾备:密钥支持跨区域同步,网关支持故障切换。

第七章:未来展望

- eBPF 驱动的内核级加密:在内核态拦截 syscalls,实现更低开销;

- 与 OpenTelemetry 集成:自动标记加密字段的 trace 链路;

- Serverless 数据库加密:适配 AWS Aurora Serverless、阿里云 PolarDB Serverless。

结语:安全不是云原生的绊脚石,而是信任的基石

在云原生时代,安全架构必须与 DevOps 流程深度融合,而非事后补丁。通过集中式数据库加密网关,企业可以在不牺牲微服务敏捷性的前提下,实现字段级加密的统一管控、国密合规与动态脱敏。

对于正在推进云原生转型的金融、政务、医疗等行业,选择通过国家商用密码认证、支持容器化部署、具备 Kubernetes 原生集成能力的数据库安全方案,是平衡“合规”与“效率”的关键一步。