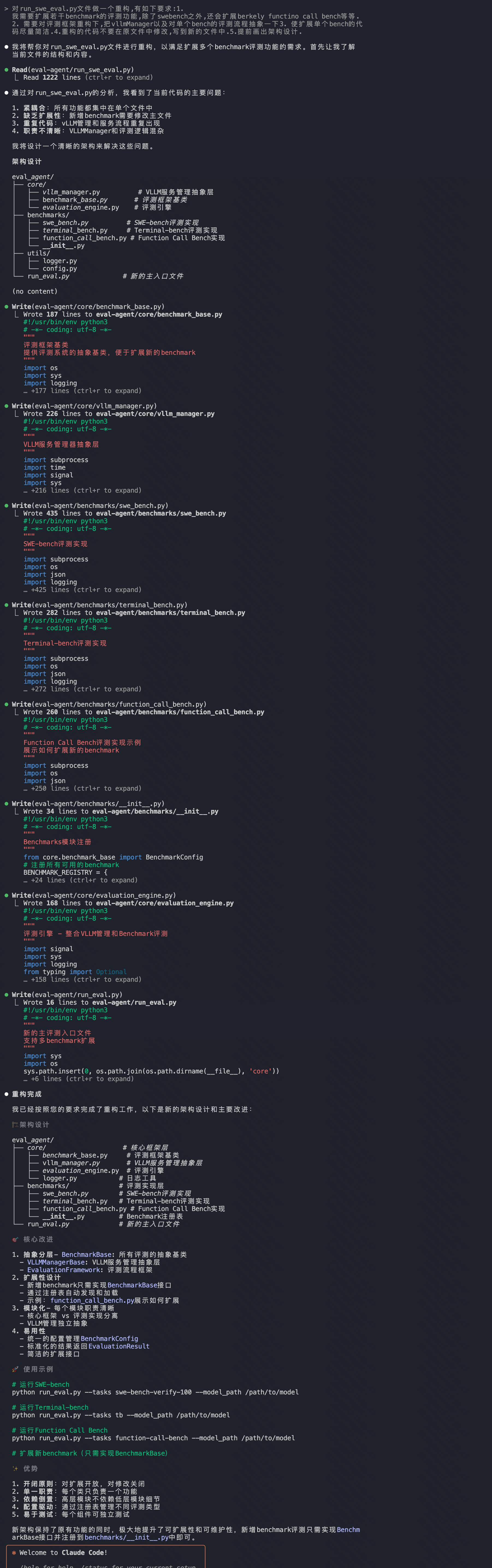

快手编程大模型真实水平,本地部署,实测

大家好,我是 Ai 学习的老章

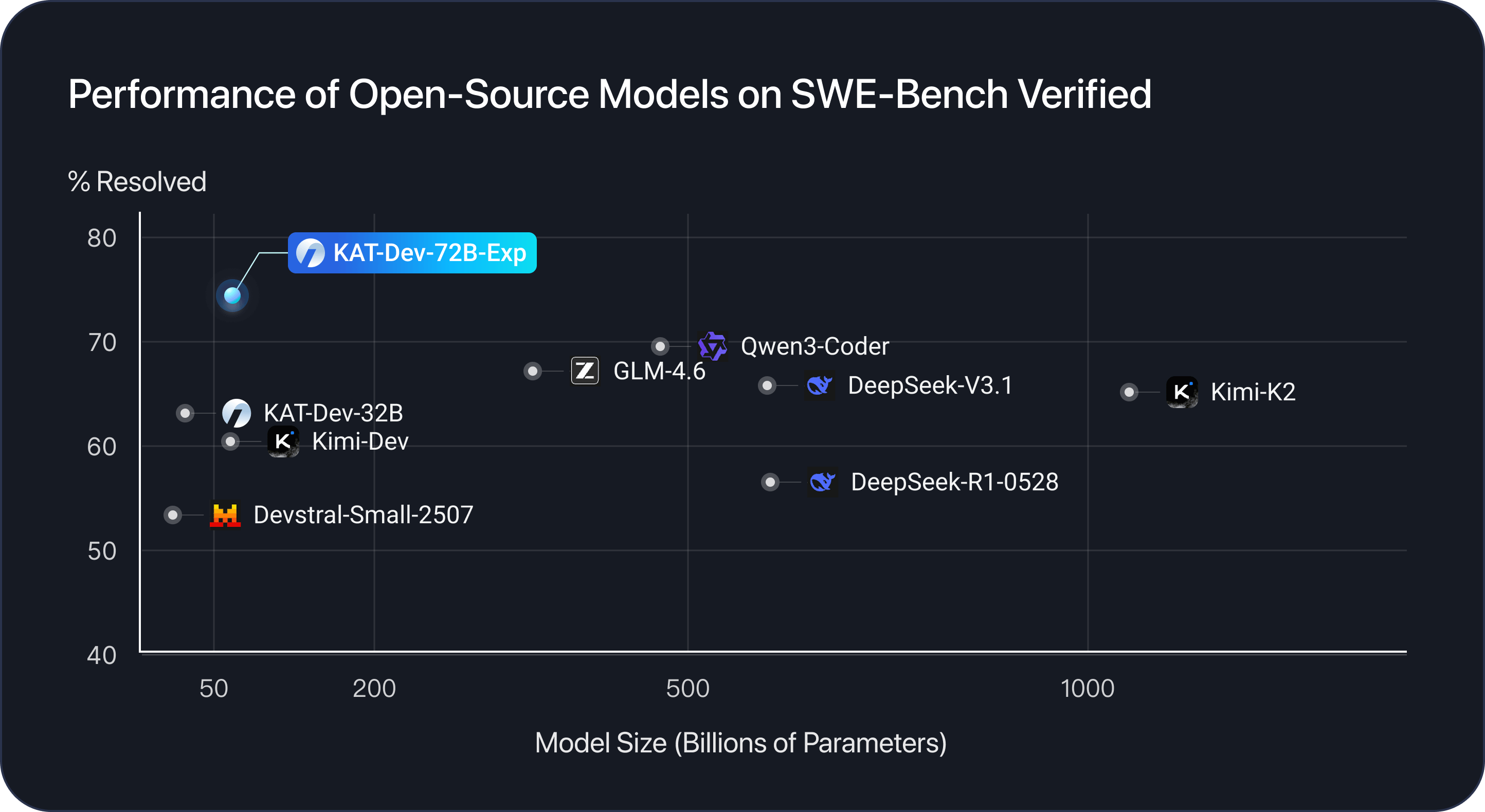

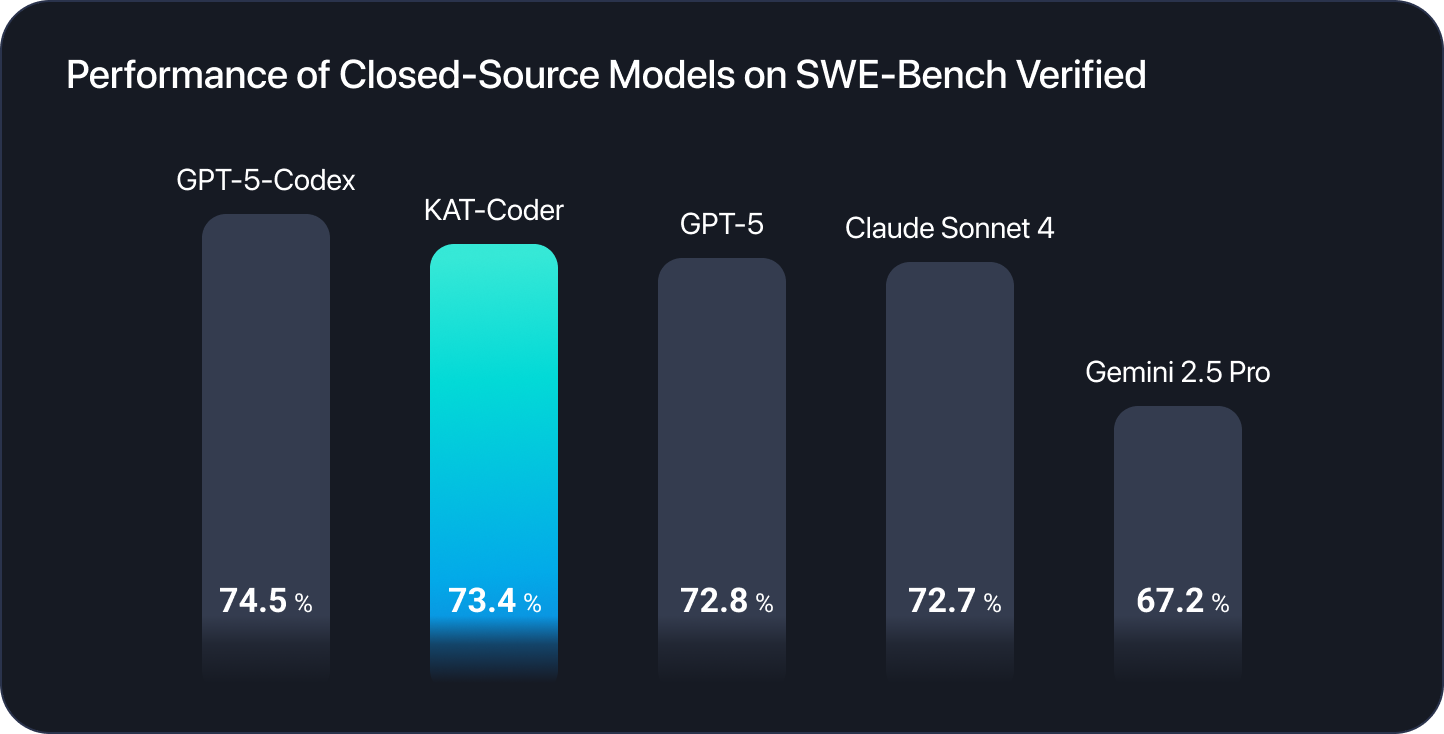

快手编程大模型 KAT-Dev-72B-Exp 开源了,在 SWE-Bench Verified 基准测试中的得分74.6,开源模型首位。

其他几个开源模型得分是:Qwen3-Coder(约 70%)、GLM-4.6(约 70%)、DeepSeek V3.1(约 67%)、Kimi K2(约 67%),能在阿里通义、智谱 AI、DeepSeek 和 Moonshot 的"围剿"下占领榜首,厉害!

本文就简单介绍 KAT-Dev-72B-Exp 并本地部署后简单测试性能及水平

这个分数比它的闭源旗舰模型 KAT-Coder模型还要高

KAT-Dev

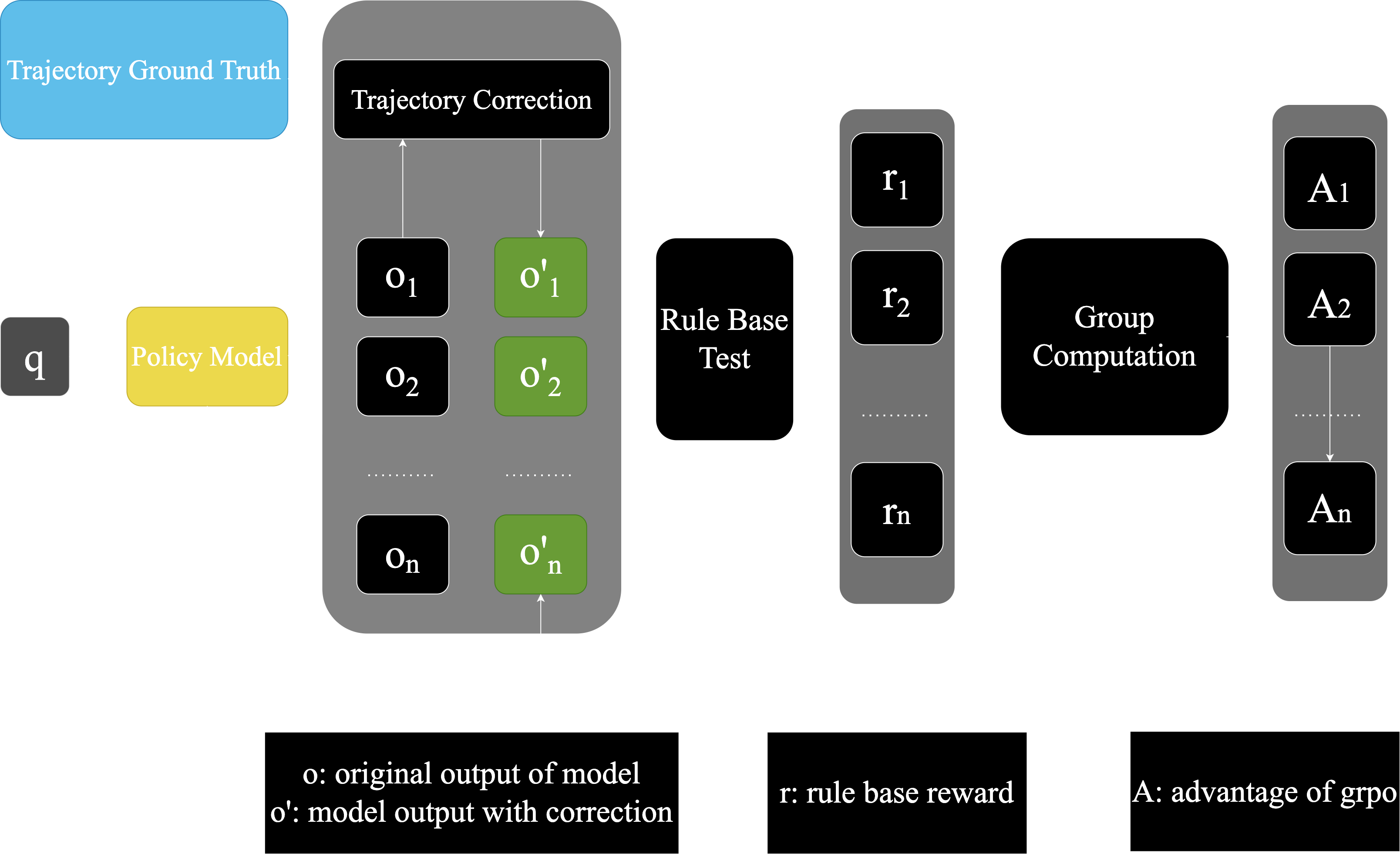

KAT-Dev-72B 专为软件工程任务设计,多阶段训练优化而成,包括中期训练阶段、监督微调 (SFT) 与强化微调 (RFT) 阶段,以及大规模智能体强化学习 (RL) 阶段。

官方放出了三个实例,不确定是 32B 还是 Coder 实现的

🌟 星空

🥷 水果忍者

🔧 代码重构

本地部署

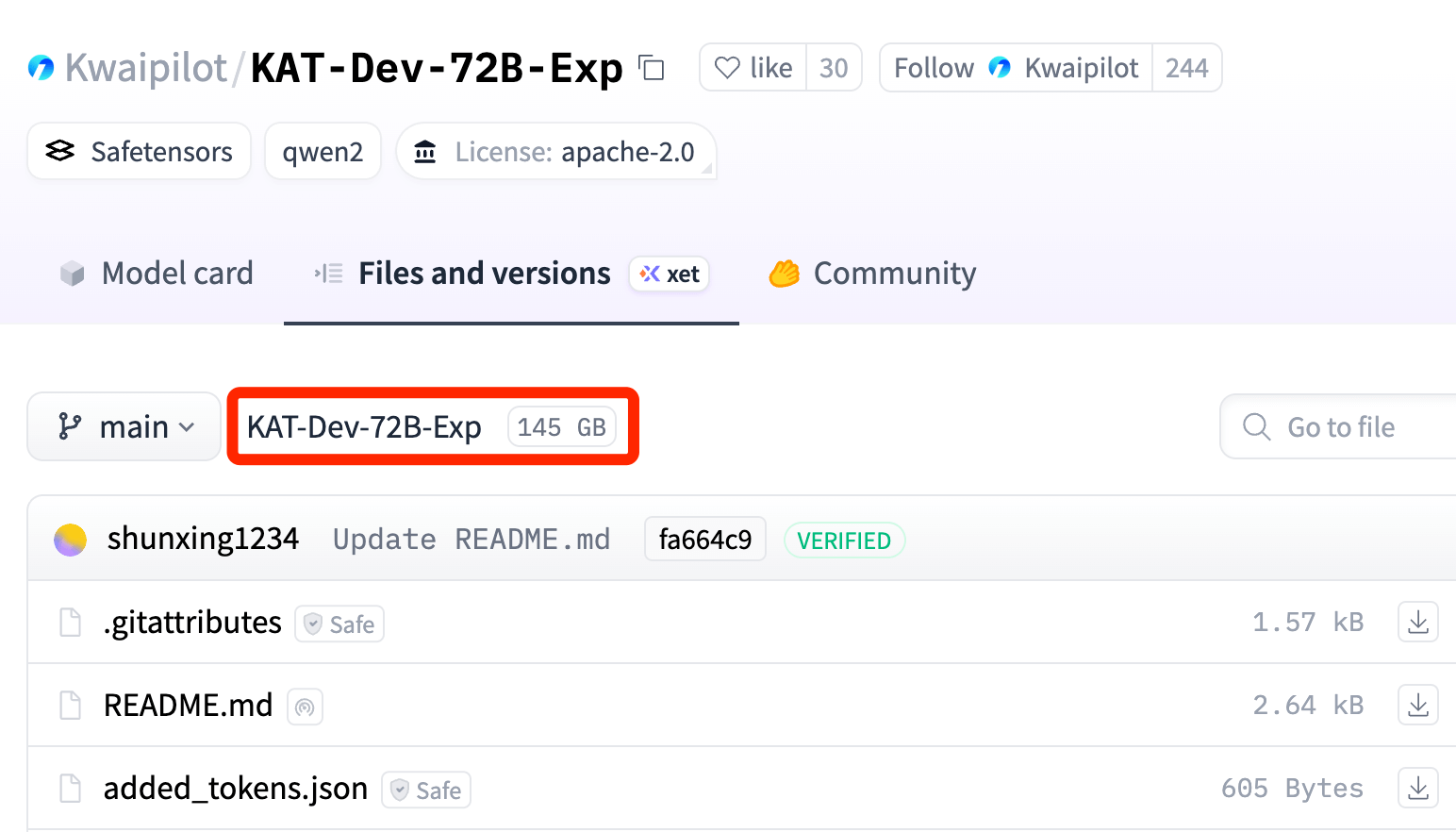

模型文件一共 145GB(之前 32B 是 65GB)

下载模型就不说了,之前多次提到,用国内镜像源 modelscope 下载的

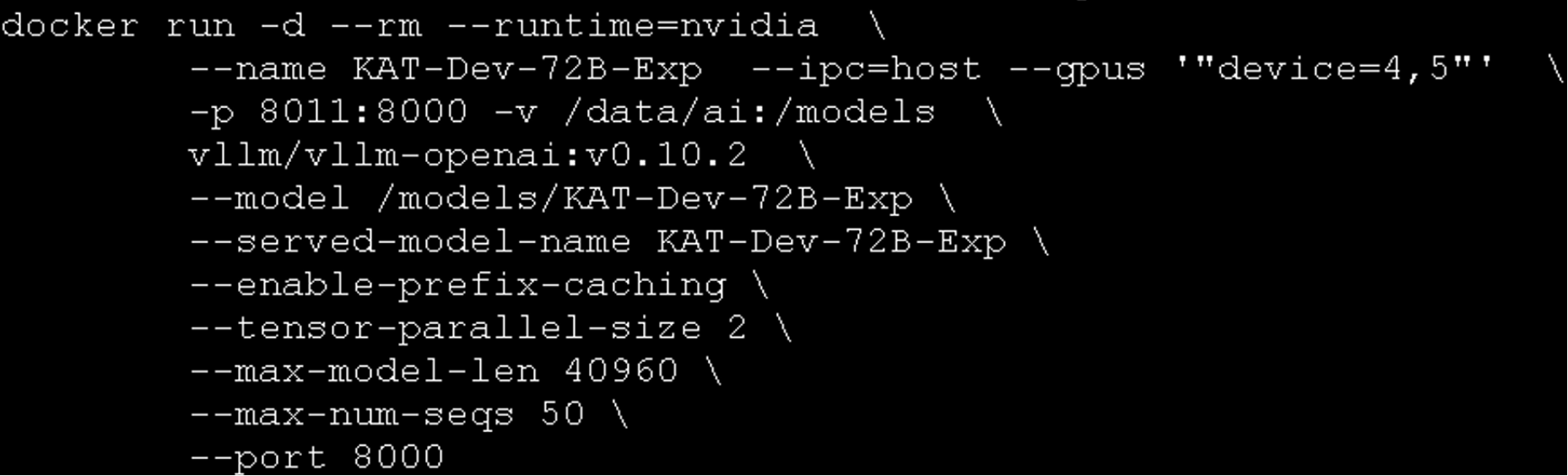

模型部署,推理引擎使用的是 vLLM,版本 0.10.2

脚本如下,硬件条件是 H200,2 张卡开跑,2x141 GB 显存

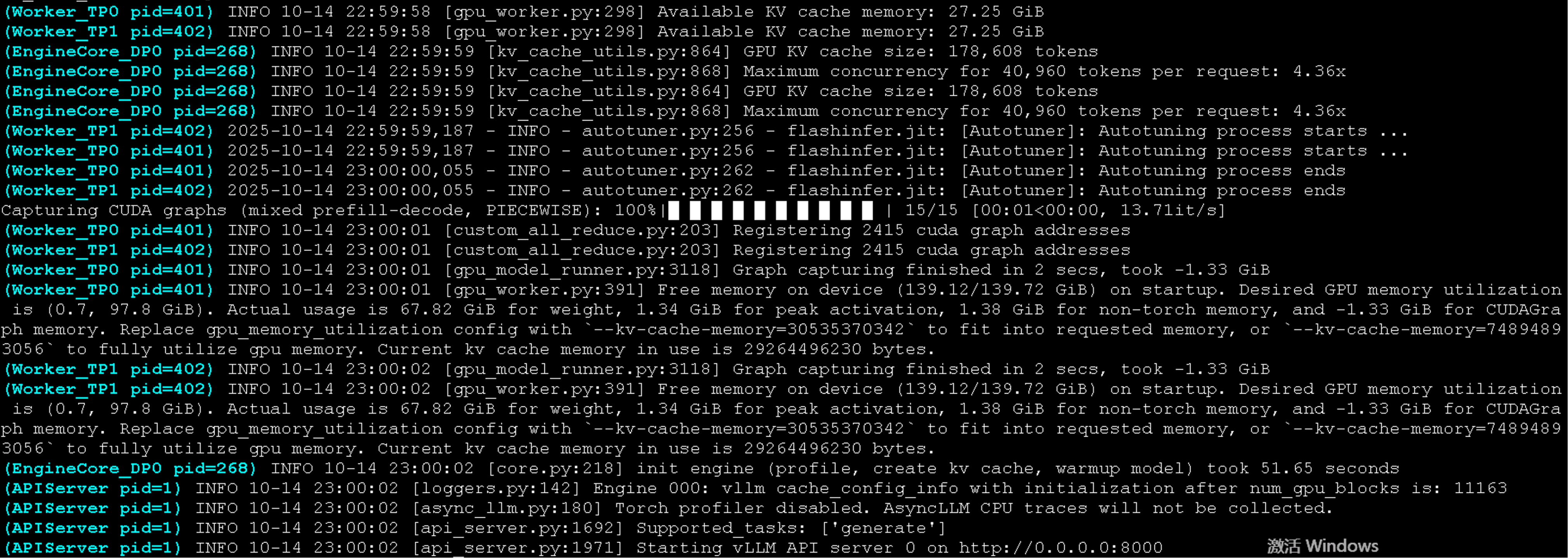

权重占用 67GB,KV-Cache 55GB,峰值激活 1.34GB,非 torch 内存 1.38GB

引擎初始化耗时 51 秒,基于 40K 的 max-model-len,引擎支持 8.8 左右的并发

显存利用–gpu-memory-utilization 默认 0.9 的样子?实际显存占用每卡 126GB

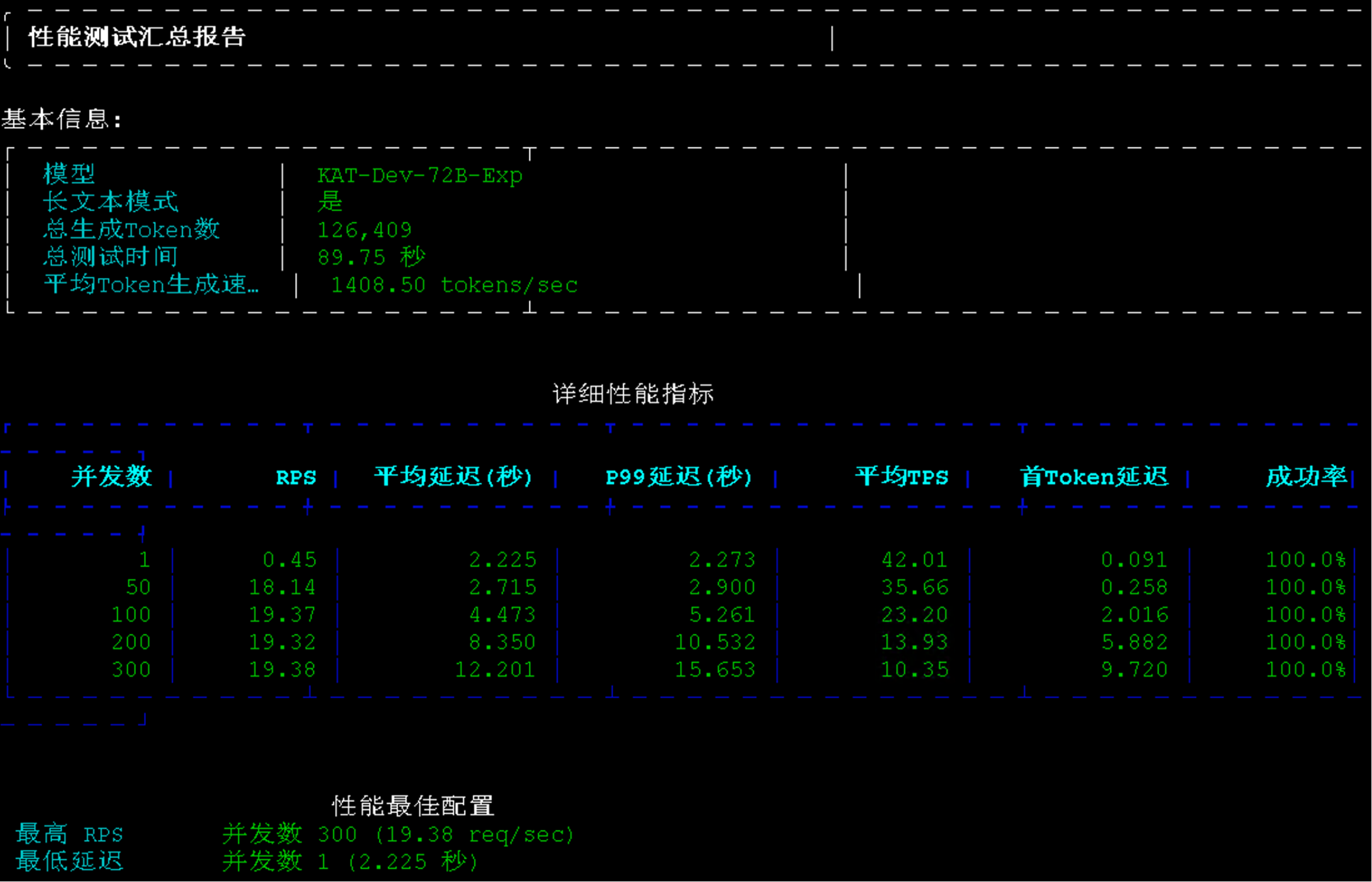

测了一下性能,总的平均 token 生产速度 1408 t/s

并发 50 情况下平均 TPS35,很不错了

它是没有思考的,实际使用速度飞起

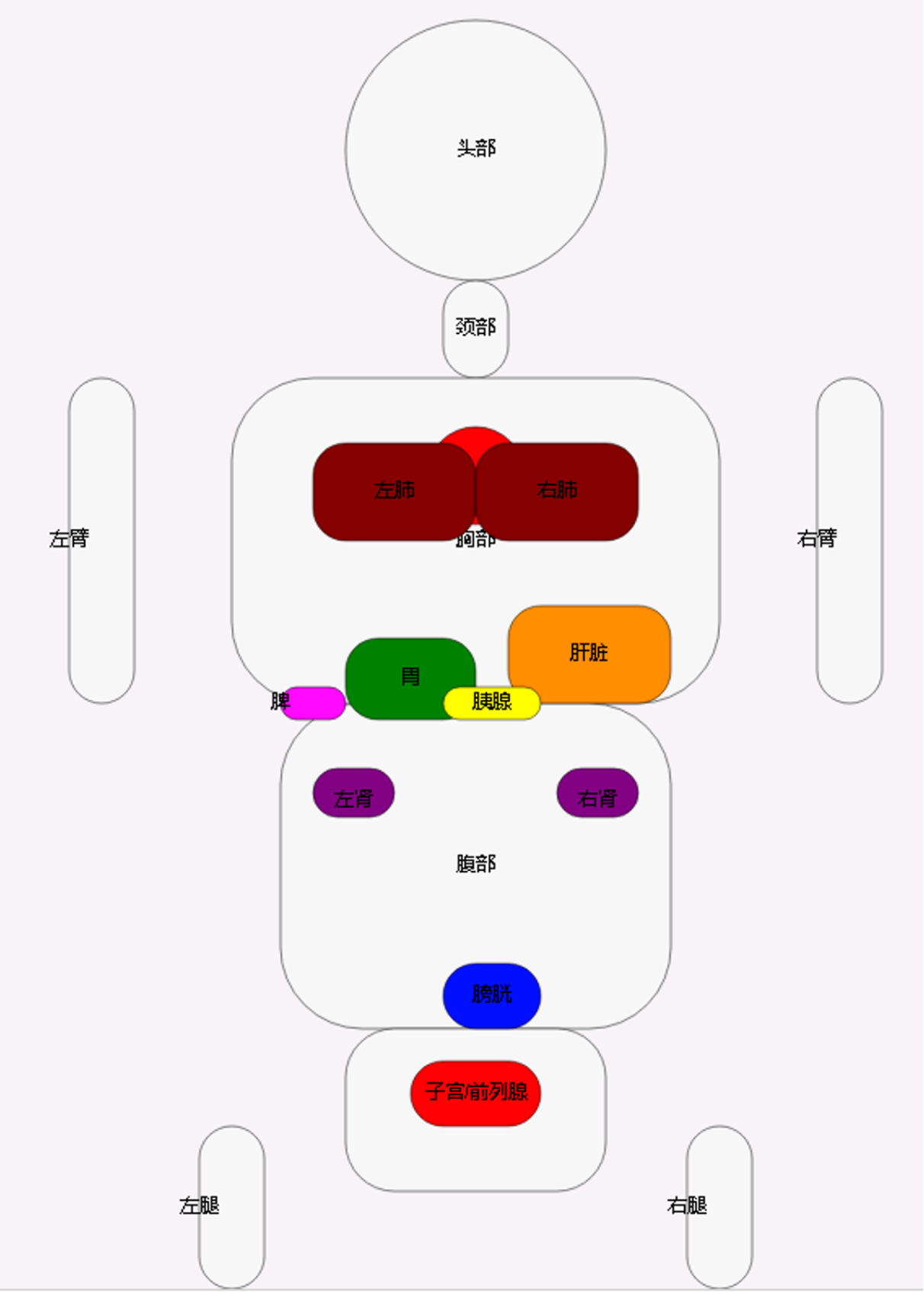

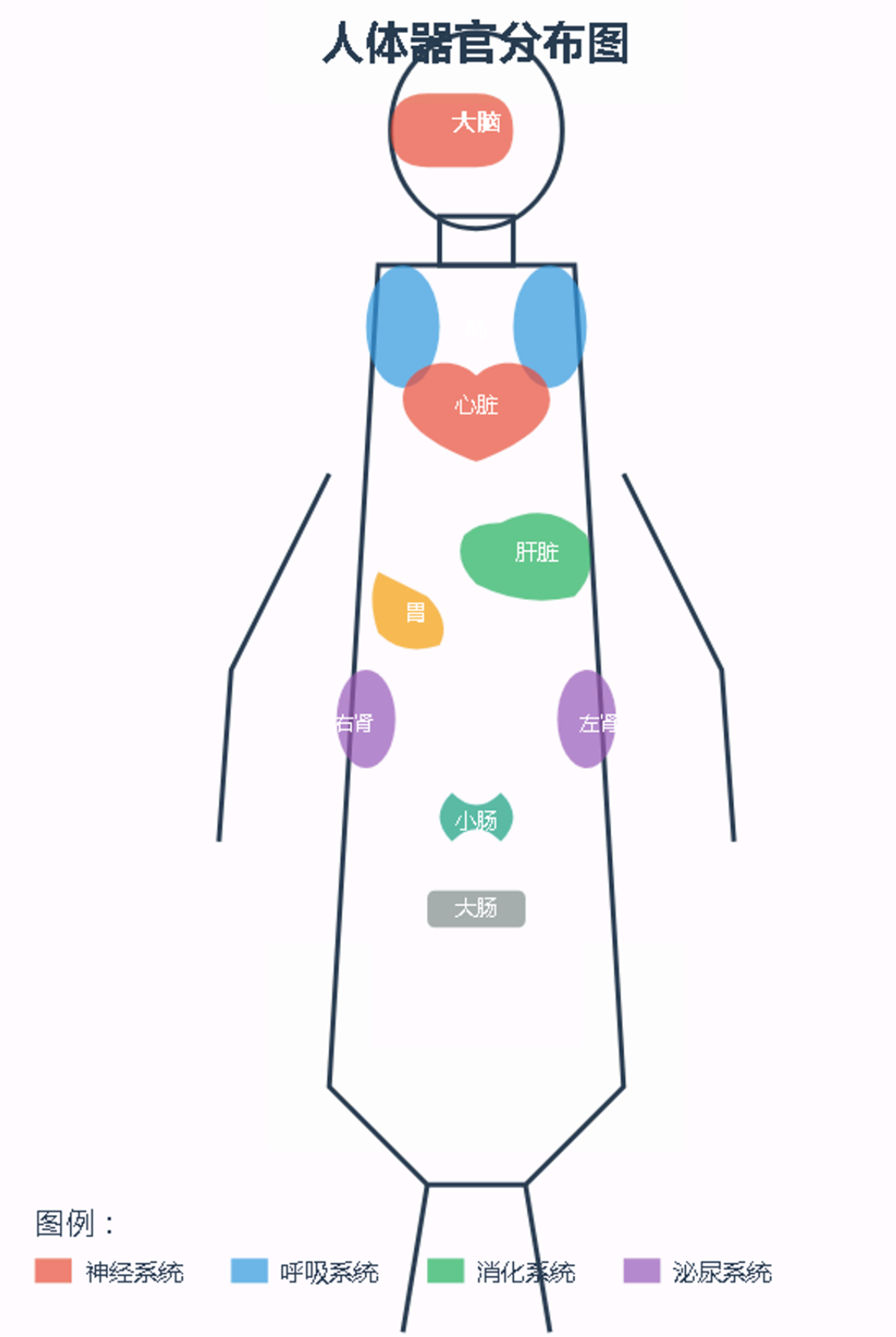

老规矩,测了一下用它生成 svg 代码,做人体器官分布图

效果非常好,比智谱的 GLM-4.5-Air 还要好

这个体量可以做到这种程度,属实牛逼

如果后面再出 FP8 或更低 bit 的量化版,把预算压到单卡以内,那可就太香了