【源码讲解+复现】YOLOv10: Real-Time End-to-End Object Detection

论文核心创新点(简明版)

-

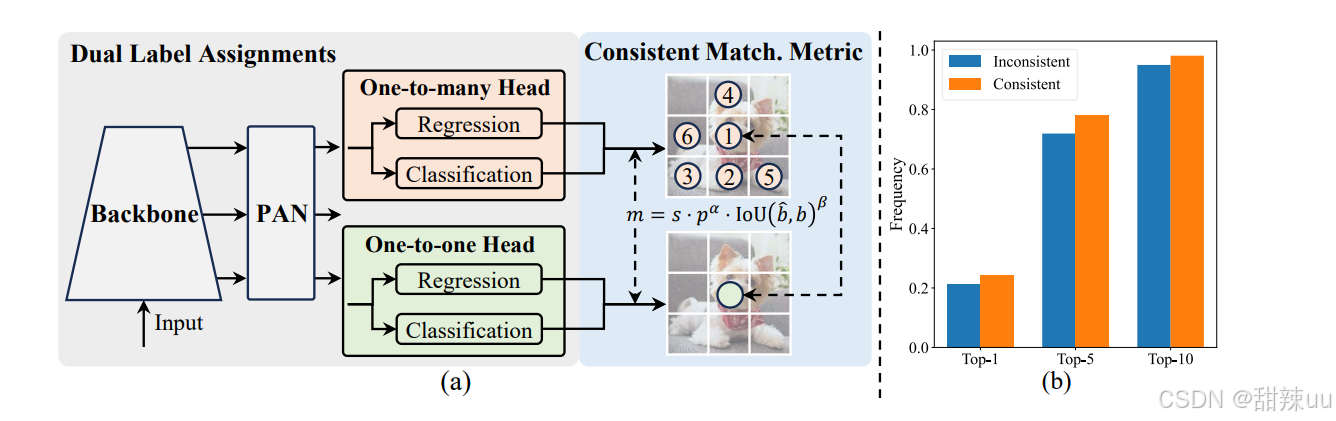

NMS-free(端到端)训练:一致的双分配(consistent dual assignments) —— 通过设计训练时的双分配策略,能在不依赖 NMS(non-maximum suppression)后处理的情况下获得稳定的检测输出,从而降低推理延迟并使模型更“端到端”。arXiv

-

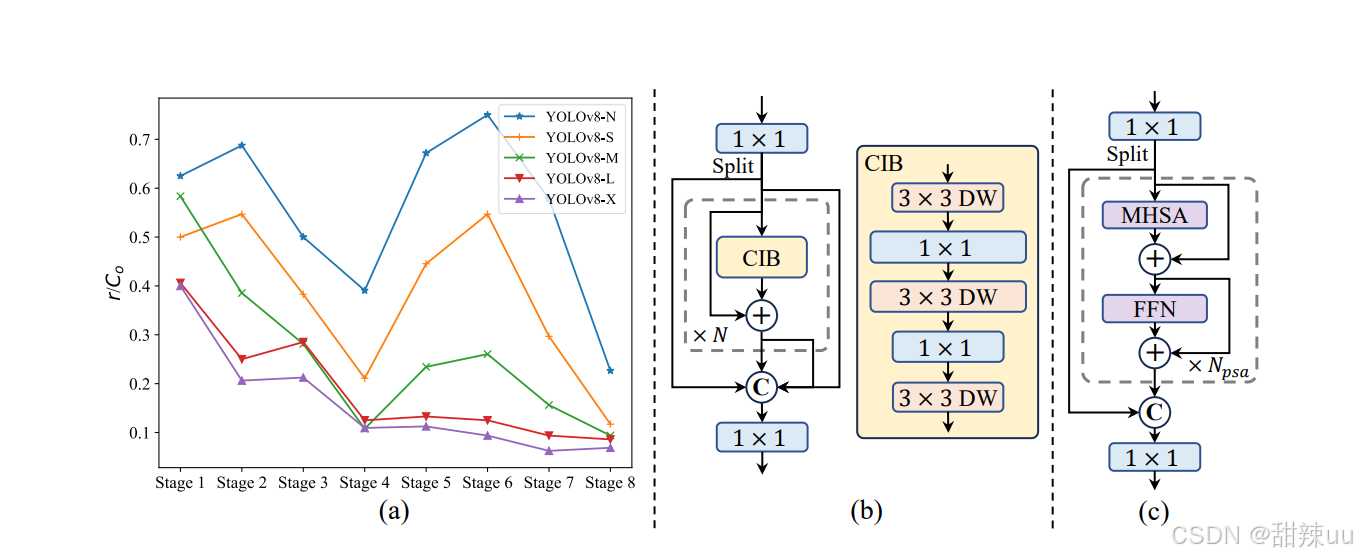

效率—精度驱动的整体设计(holistic efficiency-accuracy design) —— 对骨干、特征融合、检测头等各模块做系统性优化,减少冗余计算,跨不同规模(n/s/m/b/l/x)都达到更好 latency vs AP trade-off。arXiv

-

双头 / 结构优化(practical architecture tweaks) —— 在检测头和 assignment 策略上改进(论文与代码细节),实现更少参数 / 更低 FLOPs 下的高性能;官方对比显示在 COCO 上在多尺寸下实现领先的速度/精度平衡(论文给出定量对比)。arXiv+1

-

官方开源并提供预训练权重与多种模型尺度,便于直接微调到自定义任务

先决条件(建议)

-

GPU(至少 1× NVIDIA),Linux / Colab 推荐

-

Python 3.8–3.10,PyTorch + CUDA,pip 可用

-

注意许可:官方仓库采用 AGPL-3.0(商用/闭源注意合规)。GitHub

1) 克隆与安装(在终端)

# 克隆官方仓库

git clone https://github.com/THU-MIG/yolov10.git

cd yolov10# 推荐用 venv / conda 建立环境

python -m venv .venv && source .venv/bin/activate

pip install -U pip# 安装依赖(仓库 requirements.txt)

pip install -r requirements.txt# 或直接用 pip 安装库(很多教程用这个快捷方式)

pip install git+https://github.com/THU-MIG/yolov10.git

下载官方预训练权重(示例 nano / small)

# Releases 页面有 yolov10n.pt / yolov10s.pt / yolov10m.pt ...

# 例如下载 yolov10n.pt(v1.1 release)

wget https://github.com/THU-MIG/yolov10/releases/download/v1.1/yolov10n.pt -P weights/

3) 用官方 CLI 做一次简单推理

仓库及周边教程通常支持 yolo 风格的 CLI(与 ultralytics 类似):

# 推理一张图像(把 model 指向你下载的权重)

yolo task=detect mode=predict model=weights/yolov10n.pt source=./test_images/my.jpg conf=0.25 save=True

# infer_yolov10.py

from pathlib import Path

import subprocess# 最简单:用 CLI 调用(稳妥兼容官方仓库)

model = "weights/yolov10n.pt"

source = "test_images/my.jpg"

cmd = f"yolo task=detect mode=predict model={model} source={source} conf=0.25 save=True"

subprocess.run(cmd, shell=True, check=True)

# 使用 ultralytics / community wrapper(仅当安装了对应包)

from ultralytics import YOLOv10 # 若已提供该类

model = YOLOv10.from_pretrained('path_or_hf_repo_or_local')

model.predict(source='test_images/my.jpg', save=True)

参考(部分关键来源)

-

YOLOv10 论文(arXiv / NeurIPS 2024)。arXiv

-

官方实现仓库

THU-MIG/yolov10(代码 + releases 权重)。GitHub+1 -

Ultralytics 文档关于 YOLOv10 的概览。Ultralytics

-

Roboflow / Colab 实战教程(训练自定义数据的 step-by-step)。

Roboflow Blog