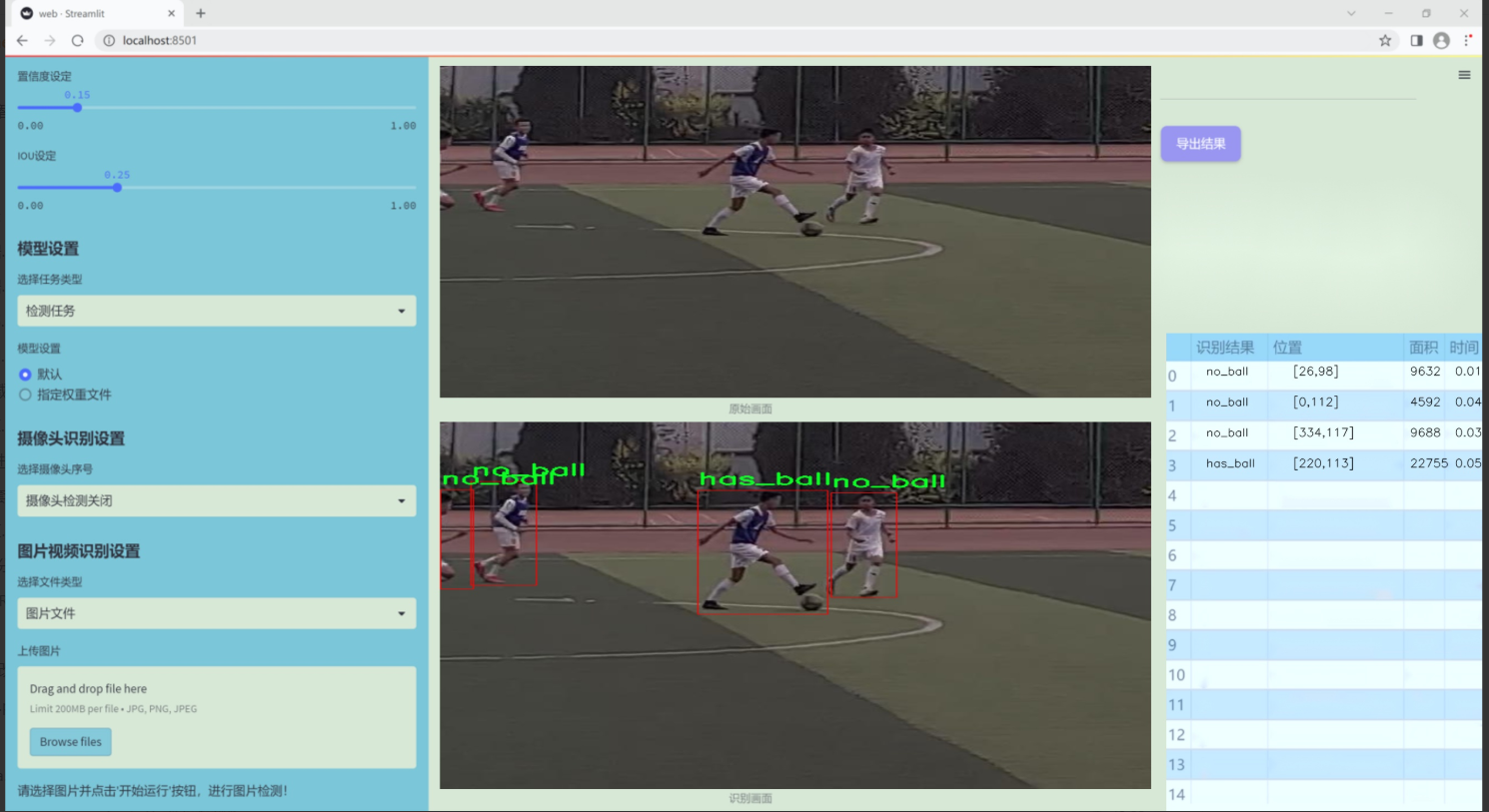

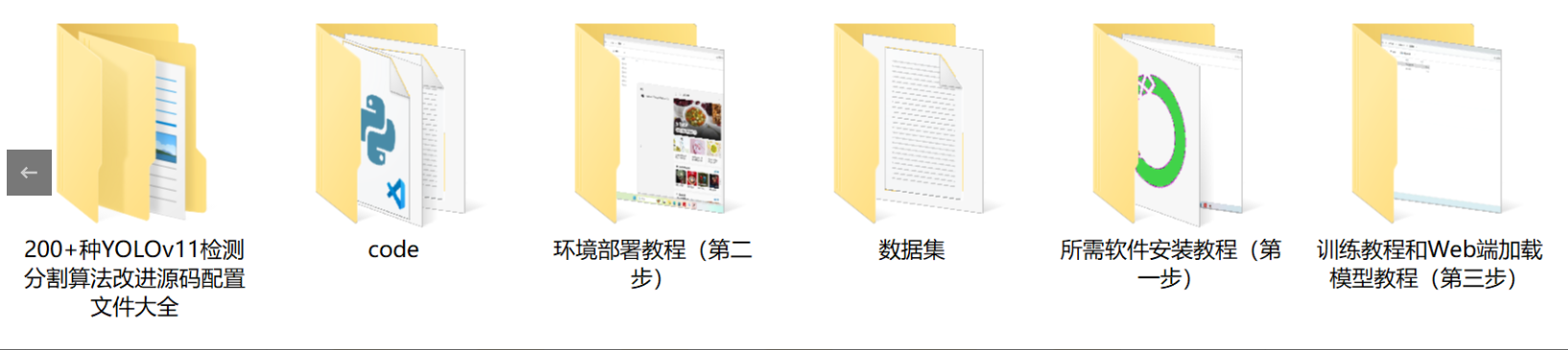

【完整源码+数据集+部署教程】 【运动的&足球】足球场上球检测系统源码&数据集全套:改进yolo11-DGCST

背景意义

随着计算机视觉技术的快速发展,物体检测在多个领域中得到了广泛应用,尤其是在体育赛事分析中。足球作为全球最受欢迎的运动之一,其比赛过程中的动态变化和复杂场景为物体检测技术提出了更高的要求。传统的图像处理方法在实时性和准确性方面往往难以满足需求,因此,基于深度学习的物体检测算法逐渐成为研究的热点。YOLO(You Only Look Once)系列模型因其高效的检测速度和良好的准确性而被广泛应用于实时物体检测任务中。

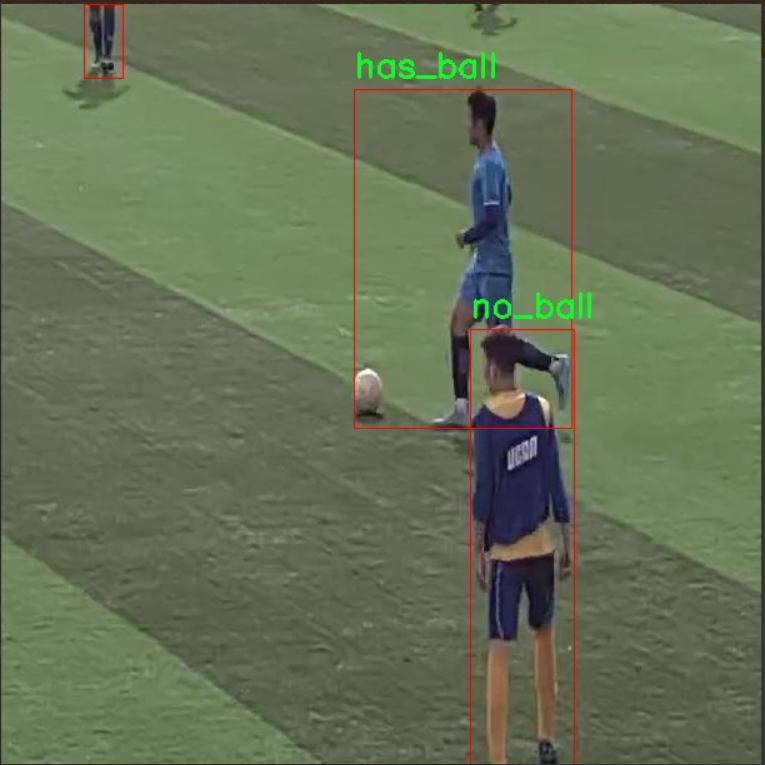

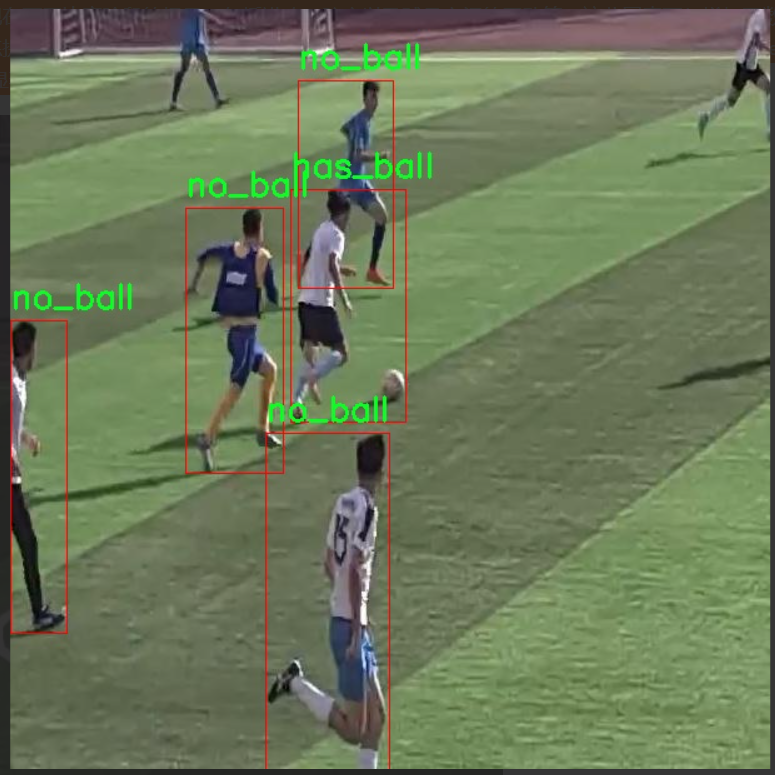

本研究旨在基于改进的YOLOv11模型,构建一个专门用于足球场上球检测的系统。该系统将利用一个包含1200张图像的数据集,其中标注了“has_ball”和“no_ball”两个类别,旨在提高对足球在比赛中出现状态的检测能力。通过对该数据集的深入分析和模型的优化,期望能够实现对足球在复杂场景下的准确识别,为教练员和分析师提供实时的数据支持,进而提升战术分析和比赛策略的制定。

此外,随着足球比赛的不断发展,如何利用先进的技术手段提升比赛的观赏性和竞技水平,已成为体育科技研究的重要方向。基于YOLOv11的足球场上球检测系统不仅可以为实时比赛分析提供技术支持,还能够为后续的智能裁判系统、运动员表现评估等应用奠定基础。因此,本研究具有重要的理论价值和实际应用意义,能够推动足球赛事分析的智能化进程,为未来的体育科技发展提供新的思路和方法。

图片效果

数据集信息

本项目所使用的数据集名为“soccer data”,旨在为改进YOLOv11的足球场上球检测系统提供高质量的训练数据。该数据集专注于足球比赛中的关键元素,特别是与球的状态相关的检测任务。数据集中包含三种类别,分别为“has_ball”(有球)、“no_ball”(无球)以及一个占位符类别“-”,用于标识未定义或不相关的图像区域。这种分类方式使得模型能够在复杂的比赛场景中有效地区分球的存在与否,从而提高检测的准确性和实时性。

“soccer data”数据集的构建过程经过精心设计,涵盖了多种比赛环境和光照条件,以确保模型在不同情况下的鲁棒性。数据集中包含大量标注清晰的图像,涵盖了各种角度和距离的拍摄,真实反映了足球场上的动态场景。通过对这些图像进行标注,数据集为模型提供了丰富的学习样本,使其能够捕捉到球在比赛中的不同状态及其与球员的相互作用。

此外,数据集的多样性还体现在不同比赛阶段的场景,包括进攻、防守以及球员之间的互动等。这些因素不仅增加了数据集的复杂性,也为模型的训练提供了更为全面的背景信息,促使其在实际应用中具备更强的适应能力。通过使用“soccer data”数据集,我们期望能够显著提升YOLOv11在足球场上球检测的性能,为后续的研究和应用奠定坚实的基础。

核心代码

以下是代码中最核心的部分,并附上详细的中文注释:

class DetectionValidator(BaseValidator):

“”"

DetectionValidator类用于基于检测模型的验证,继承自BaseValidator类。

“”"

def __init__(self, dataloader=None, save_dir=None, pbar=None, args=None, _callbacks=None):"""初始化检测模型,设置必要的变量和参数。"""super().__init__(dataloader, save_dir, pbar, args, _callbacks)self.nt_per_class = None # 每个类别的目标数量self.is_coco = False # 是否为COCO数据集self.class_map = None # 类别映射self.args.task = "detect" # 设置任务为检测self.metrics = DetMetrics(save_dir=self.save_dir, on_plot=self.on_plot) # 初始化检测指标self.iouv = torch.linspace(0.5, 0.95, 10) # mAP@0.5:0.95的IoU向量self.niou = self.iouv.numel() # IoU的数量self.lb = [] # 用于自动标注def preprocess(self, batch):"""对YOLO训练的图像批次进行预处理。"""batch["img"] = batch["img"].to(self.device, non_blocking=True) # 将图像移动到设备上batch["img"] = (batch["img"].half() if self.args.half else batch["img"].float()) / 255 # 归一化图像for k in ["batch_idx", "cls", "bboxes"]:batch[k] = batch[k].to(self.device) # 将其他数据移动到设备上# 如果需要保存混合数据if self.args.save_hybrid:height, width = batch["img"].shape[2:] # 获取图像的高度和宽度nb = len(batch["img"]) # 批次中的图像数量bboxes = batch["bboxes"] * torch.tensor((width, height, width, height), device=self.device) # 调整边界框self.lb = ([torch.cat([batch["cls"][batch["batch_idx"] == i], bboxes[batch["batch_idx"] == i]], dim=-1)for i in range(nb)]if self.args.save_hybridelse []) # 为自动标注准备数据return batch # 返回处理后的批次def postprocess(self, preds):"""对预测输出应用非极大值抑制(NMS)。"""return ops.non_max_suppression(preds,self.args.conf, # 置信度阈值self.args.iou, # IoU阈值labels=self.lb, # 标签multi_label=True, # 多标签agnostic=self.args.single_cls, # 是否单类max_det=self.args.max_det, # 最大检测数量)def update_metrics(self, preds, batch):"""更新指标统计信息。"""for si, pred in enumerate(preds): # 遍历每个预测self.seen += 1 # 记录已处理的图像数量npr = len(pred) # 当前预测的数量stat = dict(conf=torch.zeros(0, device=self.device), # 置信度pred_cls=torch.zeros(0, device=self.device), # 预测类别tp=torch.zeros(npr, self.niou, dtype=torch.bool, device=self.device), # 真阳性)pbatch = self._prepare_batch(si, batch) # 准备批次数据cls, bbox = pbatch.pop("cls"), pbatch.pop("bbox") # 获取类别和边界框nl = len(cls) # 目标数量stat["target_cls"] = cls # 记录目标类别if npr == 0: # 如果没有预测if nl: # 如果有目标for k in self.stats.keys():self.stats[k].append(stat[k]) # 更新统计信息continue # 跳过当前循环# 处理预测if self.args.single_cls:pred[:, 5] = 0 # 如果是单类,设置类别为0predn = self._prepare_pred(pred, pbatch) # 准备预测数据stat["conf"] = predn[:, 4] # 记录置信度stat["pred_cls"] = predn[:, 5] # 记录预测类别# 评估if nl: # 如果有目标stat["tp"] = self._process_batch(predn, bbox, cls) # 处理批次for k in self.stats.keys():self.stats[k].append(stat[k]) # 更新统计信息# 保存预测结果if self.args.save_json:self.pred_to_json(predn, batch["im_file"][si]) # 保存为JSON格式if self.args.save_txt:file = self.save_dir / "labels" / f'{Path(batch["im_file"][si]).stem}.txt' # 保存为TXT格式self.save_one_txt(predn, self.args.save_conf, pbatch["ori_shape"], file)def get_stats(self):"""返回指标统计信息和结果字典。"""stats = {k: torch.cat(v, 0).cpu().numpy() for k, v in self.stats.items()} # 转换为numpy格式if len(stats) and stats["tp"].any(): # 如果有真阳性self.metrics.process(**stats) # 处理指标self.nt_per_class = np.bincount(stats["target_cls"].astype(int), minlength=self.nc) # 计算每个类别的目标数量return self.metrics.results_dict # 返回结果字典

代码核心部分说明:

DetectionValidator类:这是一个用于YOLO模型验证的类,继承自BaseValidator,主要负责处理检测任务的相关逻辑。

初始化方法:在初始化时设置了许多与检测相关的参数,包括类别映射、指标初始化等。

预处理方法:对输入的图像批次进行处理,包括归一化和将数据移动到指定设备。

后处理方法:应用非极大值抑制(NMS)来过滤预测结果,保留最优的检测框。

更新指标方法:在每次验证时更新统计信息,包括真阳性、置信度等,并保存预测结果。

获取统计信息方法:计算并返回每个类别的目标数量和其他相关指标的统计信息。

这些核心部分构成了YOLO模型验证的基础,确保了模型在验证集上的性能评估。

这个程序文件 val.py 是一个用于YOLO(You Only Look Once)目标检测模型验证的类,名为 DetectionValidator,它继承自 BaseValidator 类。该类的主要功能是对目标检测模型进行验证,计算各种性能指标,并生成相应的可视化结果。

在初始化方法 init 中,类会设置一些必要的变量和参数,包括模型的任务类型、度量标准、IOU(Intersection over Union)向量等。该类还定义了用于处理数据的多个方法,包括预处理图像、初始化度量标准、更新度量统计等。

preprocess 方法用于对输入的图像批次进行预处理,包括将图像转换为适合模型输入的格式,并根据需要进行归一化处理。init_metrics 方法则负责初始化评估指标,包括确定数据集是否为COCO格式,并设置相应的类别映射。

在验证过程中,postprocess 方法应用非极大值抑制(NMS)来过滤预测结果,确保最终输出的边界框是最优的。update_metrics 方法用于更新模型的性能指标,处理每个批次的预测结果和真实标签,并将结果保存到指定的文件中。

此外,类中还包含了用于构建数据集和数据加载器的方法,例如 build_dataset 和 get_dataloader,这些方法负责从指定路径加载图像并创建数据集对象。plot_val_samples 和 plot_predictions 方法用于可视化验证样本和模型的预测结果,生成相应的图像文件。

在最终结果的处理上,finalize_metrics 方法用于设置最终的度量速度和混淆矩阵,get_stats 方法返回性能统计数据,print_results 方法则打印每个类别的验证结果,包括检测到的图像数量、实例数量以及各种评估指标。

最后,eval_json 方法用于评估YOLO输出的JSON格式结果,并返回性能统计数据,特别是计算mAP(mean Average Precision)等指标。

总体而言,这个文件提供了一个完整的框架,用于对YOLO目标检测模型进行验证和评估,涵盖了数据预处理、指标计算、结果可视化等多个方面。

10.4 block.py

以下是经过简化并添加详细中文注释的核心代码部分:

import torch

import torch.nn as nn

import torch.nn.functional as F

def autopad(k, p=None, d=1):

“”“自动填充以实现’same’形状输出”“”

if d > 1:

k = d * (k - 1) + 1 if isinstance(k, int) else [d * (x - 1) + 1 for x in k] # 实际的卷积核大小

if p is None:

p = k // 2 if isinstance(k, int) else [x // 2 for x in k] # 自动填充

return p

class Conv(nn.Module):

“”“卷积层,包含卷积和批归一化”“”

def init(self, in_channels, out_channels, kernel_size=3, stride=1, padding=None, groups=1, act=True):

super().init()

self.conv = nn.Conv2d(in_channels, out_channels, kernel_size, stride, autopad(kernel_size, padding), groups=groups, bias=False)

self.bn = nn.BatchNorm2d(out_channels)

self.act = nn.SiLU() if act else nn.Identity()

def forward(self, x):return self.act(self.bn(self.conv(x)))

class Bottleneck(nn.Module):

“”“标准瓶颈结构”“”

def init(self, c1, c2, shortcut=True, g=1, k=(3, 3), e=0.5):

super().init()

c_ = int(c2 * e) # 隐藏通道数

self.cv1 = Conv(c1, c_, k[0], 1) # 第一个卷积

self.cv2 = Conv(c_, c2, k[1], 1, g=g) # 第二个卷积

self.add = shortcut and c1 == c2 # 是否使用shortcut连接

def forward(self, x):"""前向传播"""return x + self.cv2(self.cv1(x)) if self.add else self.cv2(self.cv1(x))

class C3k(nn.Module):

“”“C3k模块,包含多个瓶颈结构”“”

def init(self, c1, c2, n=1, shortcut=False, g=1, e=0.5, k=3):

super().init()

self.m = nn.Sequential(*(Bottleneck(c1, c2, shortcut, g, k=(k, k), e=1.0) for _ in range(n)))

def forward(self, x):"""前向传播"""return self.m(x)

class DynamicConv(nn.Module):

“”“动态卷积层”“”

def init(self, c1, c2, k=1, s=1, p=None, g=1, d=1, act=True):

super().init()

self.conv = nn.Sequential(

nn.Conv2d(c1, c2, k, s, autopad(k, p, d), groups=g, bias=True),

nn.BatchNorm2d(c2),

nn.SiLU() if act else nn.Identity()

)

def forward(self, x):return self.conv(x)

class AttentionBlock(nn.Module):

“”“注意力模块”“”

def init(self, dim, num_heads=8):

super().init()

self.num_heads = num_heads

self.head_dim = dim // num_heads

self.scale = self.head_dim ** -0.5

self.qkv = nn.Conv2d(dim, dim * 3, kernel_size=1)

self.proj = nn.Conv2d(dim, dim, kernel_size=1)

def forward(self, x):B, C, H, W = x.shapeqkv = self.qkv(x).reshape(B, 3, self.num_heads, self.head_dim, H * W).permute(0, 1, 3, 4, 2)q, k, v = qkv[0], qkv[1], qkv[2]attn = (q @ k.transpose(-2, -1)) * self.scaleattn = attn.softmax(dim=-1)out = (attn @ v).reshape(B, C, H, W)return self.proj(out)

示例使用

class ExampleModel(nn.Module):

def init(self):

super().init()

self.bottleneck = Bottleneck(3, 16) # 输入通道3,输出通道16

self.attention = AttentionBlock(16) # 输入通道16

def forward(self, x):x = self.bottleneck(x)x = self.attention(x)return x

代码说明

autopad函数:用于自动计算卷积的填充,使输出的尺寸与输入相同。

Conv类:定义了一个卷积层,包含卷积、批归一化和激活函数。

Bottleneck类:实现了标准的瓶颈结构,包含两个卷积层和可选的shortcut连接。

C3k类:是一个包含多个瓶颈结构的模块。

DynamicConv类:实现了动态卷积,适用于输入特征的动态处理。

AttentionBlock类:实现了一个简单的注意力机制,使用了多头注意力。

ExampleModel类:示例模型,展示了如何使用瓶颈和注意力模块。

注意事项

该代码段是原始代码的简化版本,保留了核心结构和功能。

详细的注释帮助理解每个部分的功能和作用。

这个 block.py 文件包含了多种深度学习模型组件的实现,主要是用于构建卷积神经网络(CNN)和变换器(Transformer)模型的模块。文件中使用了 PyTorch 框架,以下是对文件中主要内容的逐步说明。

首先,文件导入了必要的库,包括 PyTorch 的核心库、神经网络模块、功能模块、一些数学工具以及自定义的卷积模块和注意力机制模块。通过这些导入,文件可以使用深度学习中常用的各种操作和结构。

接下来,文件定义了一系列的卷积和注意力模块,包括 autopad 函数用于自动计算卷积的填充大小,确保输出尺寸与输入相同。然后,定义了多种激活函数,如 swish、h_swish 和 h_sigmoid,这些函数在模型中用于增加非线性。

文件中有多个类定义,分别实现了不同的模块,例如 DyHeadBlock、Fusion、Partial_conv3 等。这些模块的设计通常是为了实现特定的功能,如注意力机制、特征融合、卷积操作等。

DyHeadBlock:实现了动态头部块,包含多种注意力机制的实现,利用特征图的不同层次进行融合。

Fusion:实现了特征融合的不同策略,包括加权、适应性、拼接等。

Partial_conv3:实现了部分卷积操作,主要用于推理阶段,保持输入的完整性。

DynamicConv、GhostConv、RepConv 等:这些是不同类型的卷积操作,具有不同的特性和应用场景。

此外,文件中还实现了一些新的模块,如 MogaBlock、SMAFormerBlock 和 CSP_PTB,这些模块结合了卷积和注意力机制,旨在提高模型的表现力和效率。

在文件的后半部分,定义了一些用于特定任务的模块,如 SDFM、GEFM 和 PSFM,这些模块用于特征融合和上下文信息的提取,适用于图像处理任务。

最后,文件还实现了一些更复杂的结构,如 C3k2 和 C3 系列模块,这些模块结合了多种卷积和注意力机制,形成了更深层次的网络结构。

总的来说,block.py 文件是一个功能丰富的模块集合,适用于构建现代深度学习模型,特别是在计算机视觉领域的应用。每个模块的设计都考虑到了性能和灵活性,使得用户可以根据具体任务需求进行组合和扩展。

源码文件

源码获取

欢迎大家点赞、收藏、关注、评论啦 、查看👇🏻获取联系方式