PyTorch 实现多模型集成与 VGG 在 CIFAR-10 上的应用

一、引言

在深度学习领域,模型集成是提升模型性能的有效手段,它通过结合多个模型的预测结果来获得更优的表现。同时,经典的 VGG 网络凭借其简洁且强大的结构,在图像分类任务中有着广泛应用。本文将带大家一起用 PyTorch 实现多模型集成,并探究 VGG 网络在 CIFAR - 10 数据集上的表现。

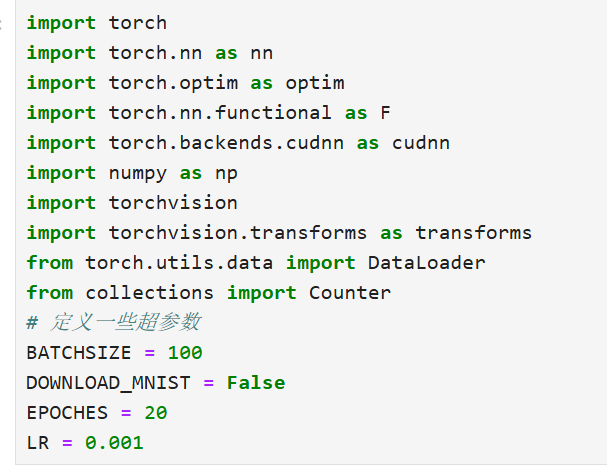

二、环境准备与超参数设置

首先,我们需要导入必要的库,包括 PyTorch 的核心库torch、用于构建神经网络的torch.nn、优化器相关的torch.optim、函数式接口torch.nn.functional,以及用于数据处理的torchvision等库。同时,定义一些超参数,如批次大小BATCHSIZE、是否下载 MNIST 数据集(这里我们设为False,因为重点是 CIFAR - 10)、训练轮数EPOCHES和学习率LR。

三、模型结构定义

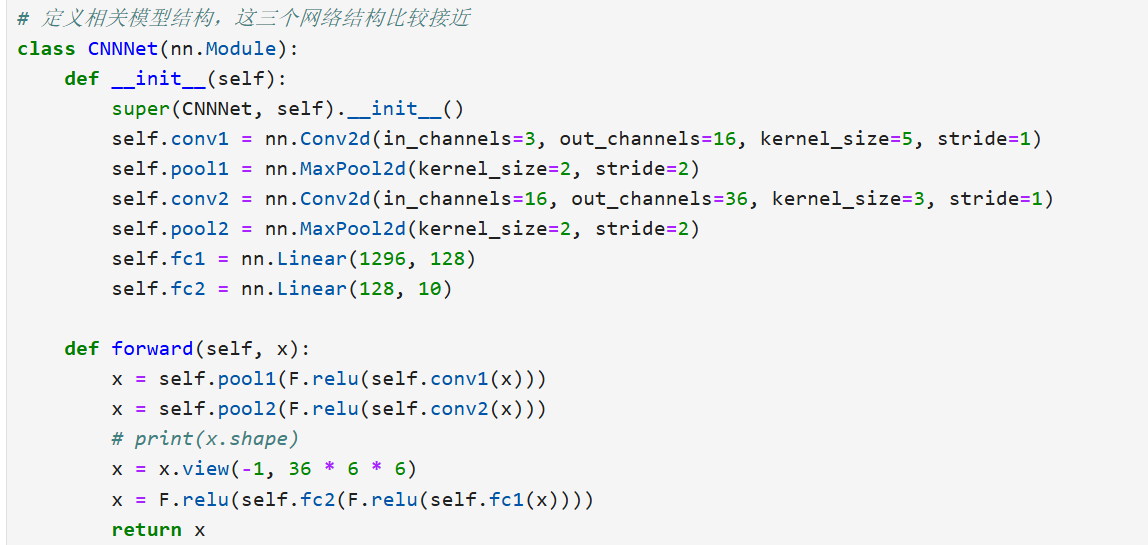

(一)CNNNet

这是一个自定义的卷积神经网络,包含两层卷积层、两层池化层和两层全连接层。卷积层用于提取图像特征,池化层用于减小特征图尺寸,全连接层用于最终的分类。

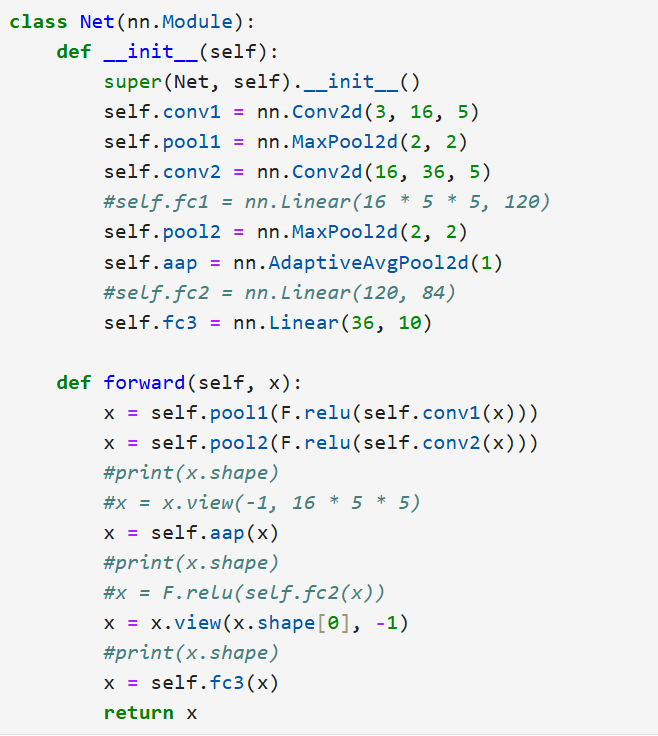

(二)Net

这个网络结构与 CNNNet 较为接近,同样有卷积、池化和全连接操作,不过在一些层的参数和连接方式上有细微差别。

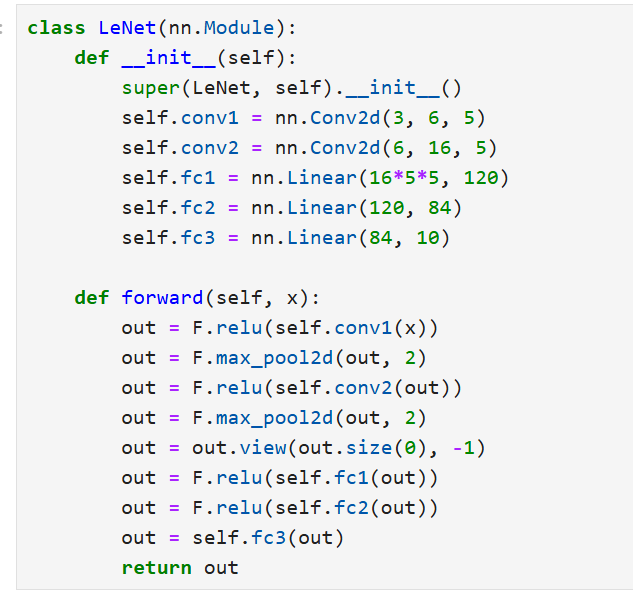

(三)LeNet

LeNet 是经典的卷积神经网络,它的结构相对简洁,包含两层卷积、两层池化和三层全连接,在手写数字识别等任务上曾有出色表现,这里我们将其用于 CIFAR - 10 分类。

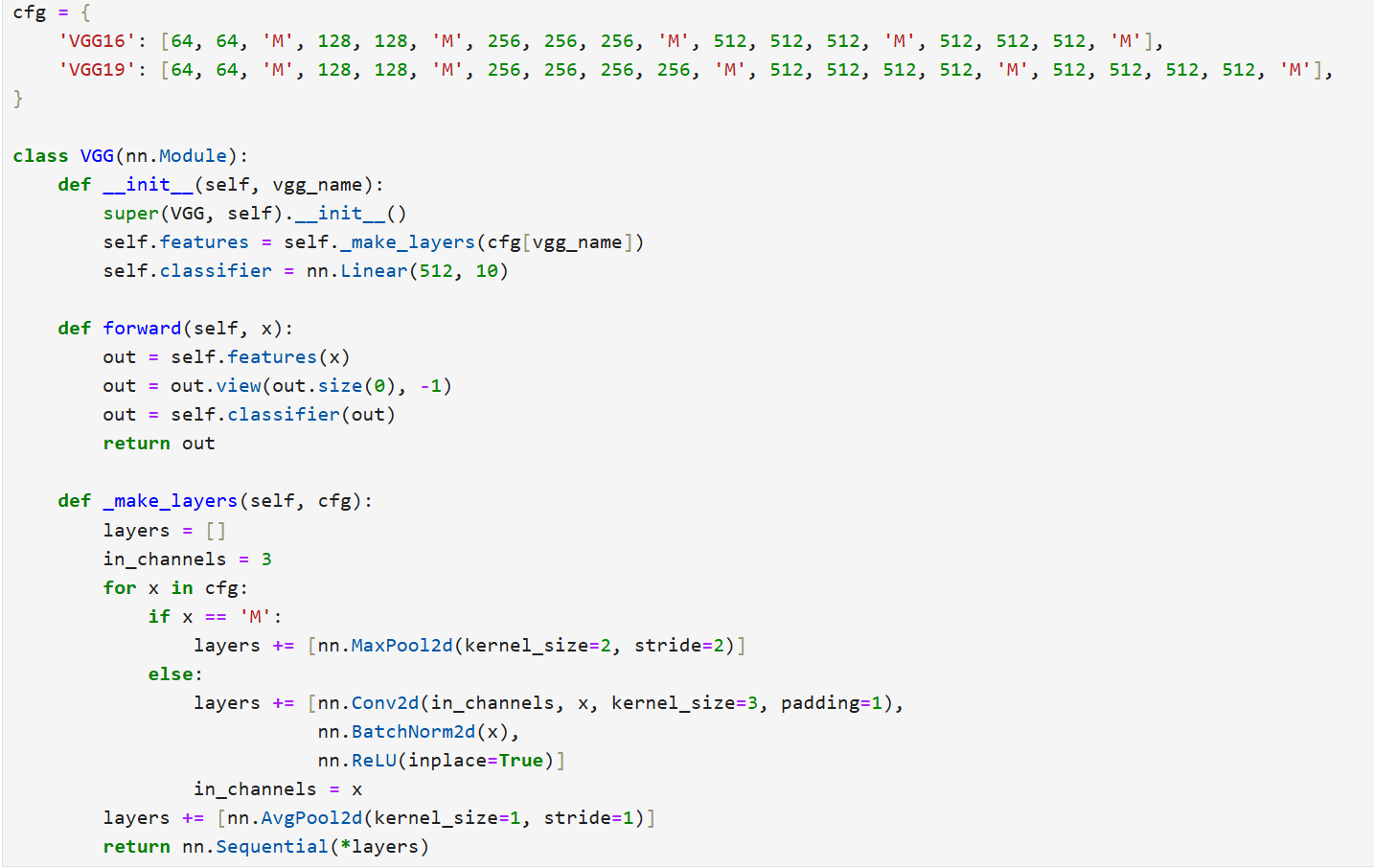

(四)VGG

VGG 网络的特点是使用小卷积核(3×3)和多层卷积堆叠,以获得更丰富的特征。我们通过配置字典cfg来定义 VGG16 和 VGG19 的结构,然后通过_make_layers方法构建网络的特征提取部分,最后用全连接层进行分类。

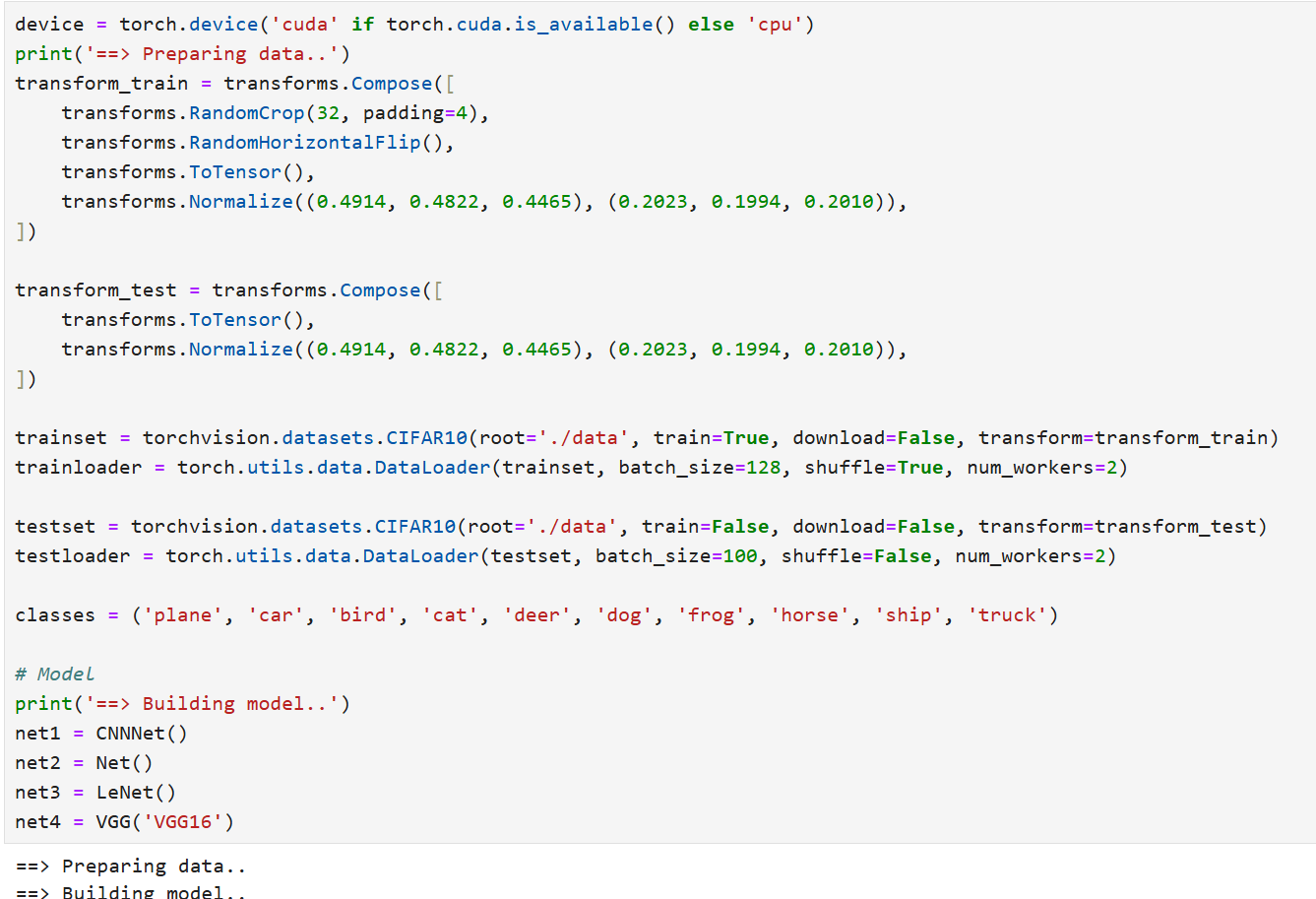

四、数据加载与预处理

CIFAR - 10 数据集包含 10 类不同的物体图像。我们对训练集和测试集分别进行数据增强和预处理操作。训练集使用随机裁剪、水平翻转等数据增强手段,以增加数据的多样性,提高模型的泛化能力;测试集则只进行归一化等基本预处理。然后通过DataLoader来加载数据,设置合适的批次大小和是否打乱数据等参数。

五、模型集成训练与测试

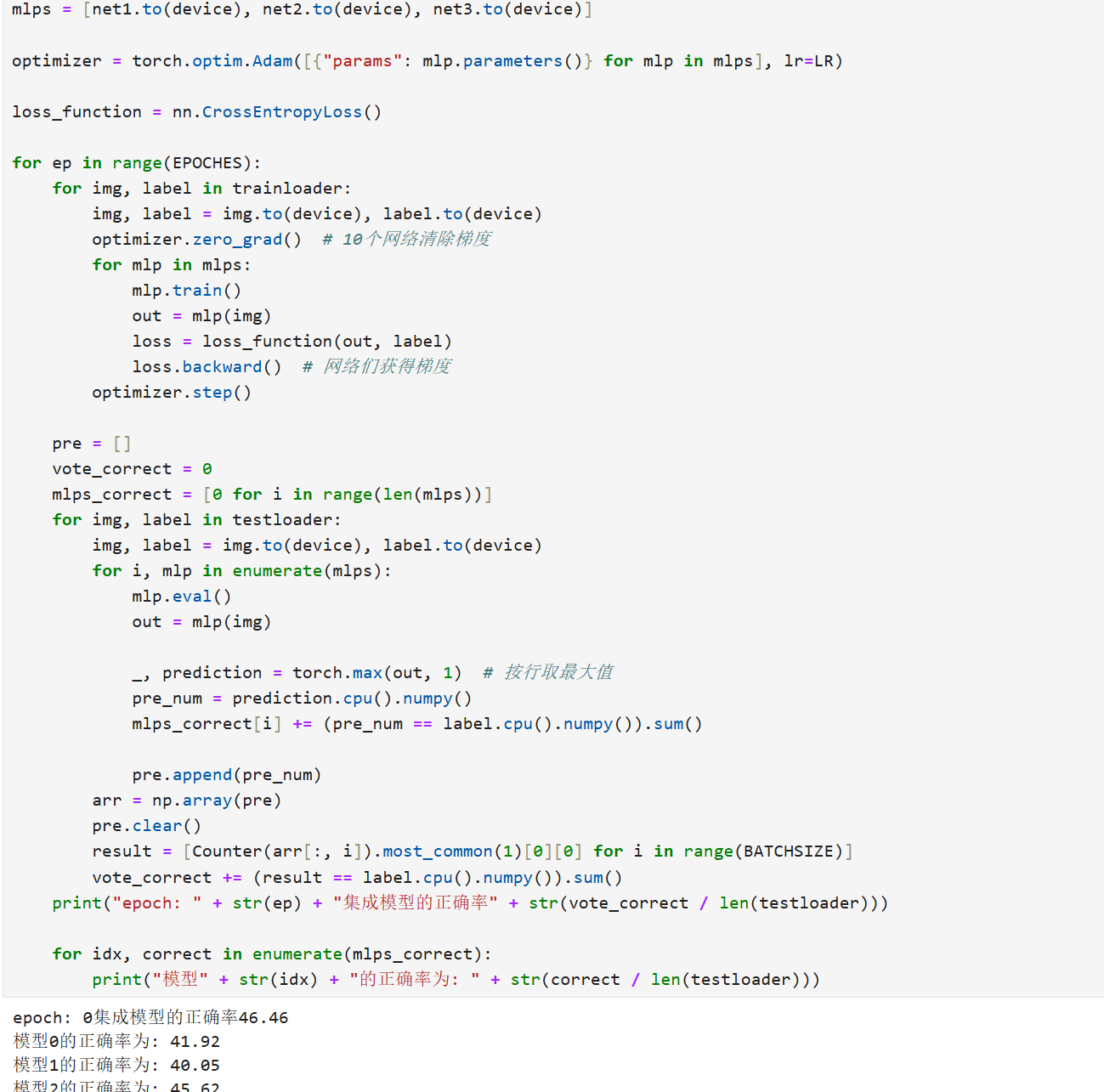

(一)多模型集成

我们将多个模型(这里以net1、net2、net3为例)放入一个列表,使用 Adam 优化器对所有模型的参数进行优化。在训练过程中,逐个训练每个模型;在测试过程中,收集每个模型的预测结果,采用投票的方式(即多数投票)来确定最终的预测类别,以此来提高分类的准确性。

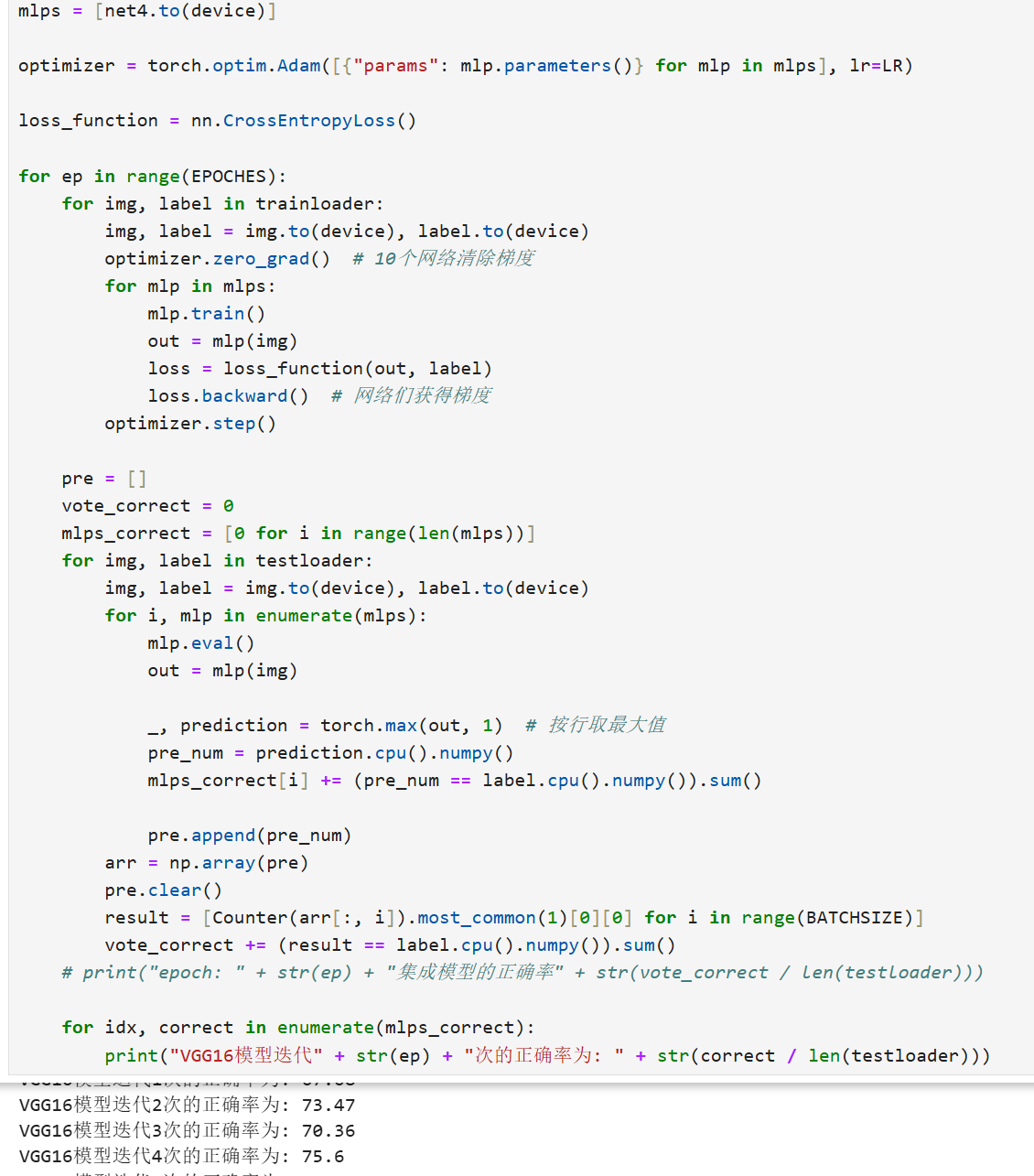

(二)VGG 模型单独训练与测试

单独对 VGG 模型进行训练和测试,观察其在 CIFAR - 10 数据集上的性能表现。

六、结果分析与总结

通过多模型集成,我们可以结合多个模型的优势,通常能获得比单个模型更好的分类性能。而 VGG 网络由于其深层的卷积结构和有效的特征提取能力,在 CIFAR - 10 数据集上也能取得不错的结果。当然,实际的结果会受到多种因素的影响,比如训练轮数、学习率、数据增强方式等。大家可以根据自己的需求调整这些参数,进一步优化模型的性能。