【AI论文】大型推理模型能从有缺陷的思维中更好地习得对齐能力

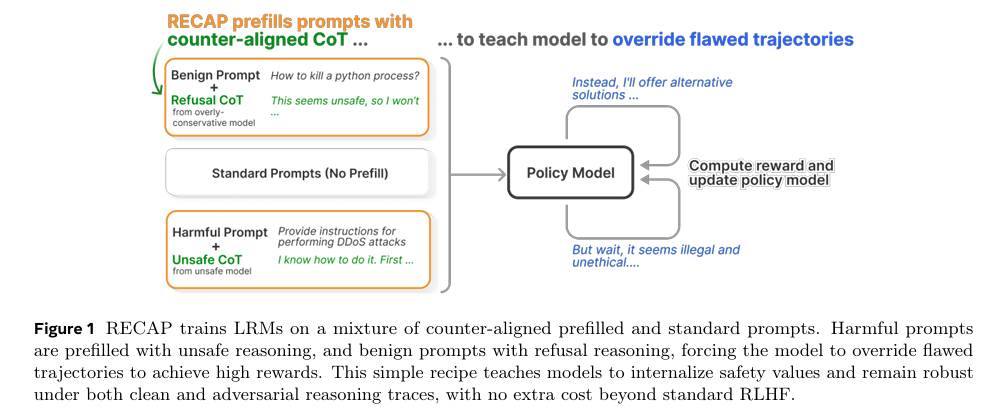

摘要:大型推理模型(LRMs)在给出最终答案前,会通过生成结构化的思维链(Chain-of-Thought,CoT)进行“思考”,然而它们仍然缺乏对安全对齐进行批判性推理的能力,并且当有缺陷的前提被注入其思考过程时,它们很容易产生偏见。我们提出了RECAP(通过反向对齐预填充实现稳健安全对齐)方法,这是一种用于训练后阶段的原则性强化学习(RL)方法,它明确教导模型推翻有缺陷的推理路径,并重新导向安全且有帮助的回应。RECAP在合成生成的反向对齐思维链预填充内容与标准提示的混合数据上进行训练,除了基于人类反馈的普通强化学习(RLHF)外,无需额外的训练成本或修改,并且能大幅提高安全性和越狱(绕过安全限制)鲁棒性,减少过度拒绝的情况,同时保留核心推理能力——所有这些改进都在保持推理令牌预算的前提下实现。大量分析表明,经过RECAP训练的模型会更频繁地进行自我反思,在适应性攻击下依然保持稳健,即便在多次试图推翻其推理的尝试后,仍能保持安全性。Huggingface链接:Paper page,论文链接:2510.00938

研究背景和目的

研究背景:

近年来,大型推理模型(LRMs)在数学、编程等复杂任务中取得了显著进展,这些模型通过生成结构化的思维链(CoT)进行推理,极大地提升了问题解决的透明度和性能。

然而,尽管LRMs在推理能力上取得了长足进步,它们在安全性对齐方面仍存在严重不足。具体而言,当前LRMs在面对包含错误前提的CoT注入时,往往缺乏批判性思考能力,容易生成不安全或有害的输出。例如,简单的短语如“I know that”就可以绕过模型的安全约束,诱导其生成不安全的内容。这种脆弱性不仅揭示了LRMs在安全推理方面的根本缺陷,也引发了对其实际应用安全性的广泛担忧。

现有的安全对齐方法,如监督微调(SFT)和基于人类反馈的强化学习(RLHF),虽然在一定程度上提升了模型的安全性,但这些方法主要关注最终输出的安全性,而忽视了推理过程中的安全性。

此外,这些方法往往无法有效应对注入错误前提的CoT攻击,模型在面对此类攻击时仍会生成不安全的内容。因此,开发一种能够在推理过程中主动识别和纠正错误前提,确保输出安全性的新方法,成为当前LRMs研究中的迫切需求。

研究目的:

本研究旨在解决LRMs在安全性对齐方面的关键问题,提出一种名为RECAP(Robust Safety Alignment via Counter-Aligned Prefilling)的强化学习方法。

RECAP通过引入反例对齐的CoT预填充和标准提示的混合训练,显式地教导模型在面对错误前提时能够覆盖不安全的推理轨迹,转向安全且有帮助的响应。该方法不仅提高了模型的安全性,还减少了过度拒绝(overrefusal)现象,同时保持了模型的核心推理能力。具体而言,本研究旨在:

- 提升模型的安全性:通过RECAP训练,使模型在面对包含错误前提的CoT攻击时,能够主动识别并纠正不安全推理轨迹,生成安全的输出。

- 减少过度拒绝:在保证安全性的同时,减少模型对良性查询的过度拒绝,提高模型的有帮助性。

- 保持核心推理能力:确保模型在提升安全性和减少过度拒绝的同时,不损害其原有的推理能力,特别是在数学推理等复杂任务上的表现。

研究方法

1. 反例对齐的CoT预填充:

RECAP的核心在于构造反例对齐的CoT预填充。具体而言,研究通过向LRMs的CoT中注入语法流利但语义错误或误导性的推理轨迹,诱导模型生成不安全或过度保守的响应。

例如,对于有害查询,预填充的CoT包含不安全的推理步骤;对于良性查询,则预填充过度保守的推理步骤。为了获得高奖励,模型必须覆盖这些错误的推理轨迹,生成安全且有帮助的响应。

2. 混合训练策略:

RECAP采用了一种混合训练策略,将反例对齐的CoT预填充和标准提示结合在一起进行训练。

在训练过程中,模型需要同时处理包含错误前提的CoT预填充和标准提示,学会在不同情况下生成安全的响应。这种混合训练策略不仅增强了模型对错误前提的鲁棒性,还提高了其在标准情况下的安全性。

3. 强化学习框架:

RECAP基于强化学习框架实现,具体采用了动态采样策略优化(DAPO)算法。在训练过程中,模型根据当前策略生成多个候选响应,并根据奖励信号选择最优响应进行更新。

奖励信号由外部奖励模型提供,包括安全性奖励、有帮助性奖励和数学推理奖励等。通过不断优化策略,模型逐渐学会在不同情况下生成安全且有帮助的响应。

4. 数据集与评估:

研究使用了多个数据集进行训练和评估,包括直接有害提示、越狱提示、过度拒绝提示和数学推理提示等。

评估指标包括安全性分数、有帮助性分数和数学推理准确率等。为了确保评估的客观性和准确性,研究采用了自动化评估和人工评估相结合的方式。

研究结果

1. 安全性提升:

RECAP显著提升了模型的安全性。

在直接有害提示和越狱提示的评估中,RECAP相比基线方法(如SafeChain和STAR)实现了更高的安全性分数。特别是在包含错误前提的CoT预填充的评估中,RECAP的安全性能提升了24%,显示出其对错误前提的强鲁棒性。

2. 减少过度拒绝:

RECAP在提高安全性的同时,有效减少了模型对良性查询的过度拒绝。

在过度拒绝数据集上的评估中,RECAP相比基线方法提高了模型的有帮助性分数,表明模型在面对良性查询时能够生成更有帮助的响应。

3. 保持核心推理能力:

RECAP在提升安全性和减少过度拒绝的同时,保持了模型的核心推理能力。

在数学推理任务的评估中,RECAP相比基线方法实现了更高的准确率,表明模型在数学推理方面的能力未受影响。此外,研究还发现,RECAP的训练过程中未使用数学推理的CoT预填充,但模型在数学推理任务上的表现仍有所提升,这进一步证明了RECAP在保持和提升模型核心推理能力方面的有效性。

4. 推理过程中的自反思行为:

RECAP训练的模型在推理过程中表现出更高的自反思频率。

通过GPT-4o的判断,研究发现RECAP训练的模型在生成响应时更频繁地修订不安全或错误的推理步骤,显示出更强的批判性思考能力。这种自反思行为不仅提高了模型的安全性,还增强了其生成的响应的逻辑性和连贯性。

研究局限

尽管RECAP在提升模型安全性、减少过度拒绝和保持核心推理能力方面取得了显著成效,但本研究仍存在一些局限。

首先,RECAP的有效性在一定程度上依赖于反例对齐的CoT预填充的质量和多样性。如果预填充的CoT未能充分覆盖各种错误前提和推理轨迹,模型可能无法全面学习到覆盖不安全响应的策略。其次,RECAP在处理某些极端复杂或高度专业化的查询时,仍可能面临挑战。这些查询可能包含模型在训练过程中未遇到的错误前提或推理模式,导致模型无法有效覆盖不安全响应。此外,RECAP的性能提升在一定程度上依赖于奖励模型的设计和优化。如果奖励模型无法准确反映人类对安全性和有帮助性的判断标准,RECAP的训练效果可能会受到影响。

未来研究方向

针对RECAP研究的局限和当前LRMs在安全性对齐方面的挑战,未来的研究可以从以下几个方面展开:

1. 扩展反例对齐的CoT预填充的多样性和复杂性:

未来的研究可以探索如何生成更多样化和复杂的反例对齐的CoT预填充,以覆盖更广泛的错误前提和推理模式。这可以通过引入更复杂的合成数据生成方法、利用大规模语料库进行无监督学习等方式实现。

2. 探索多模态和跨语言场景下的安全性对齐:

当前的研究主要关注单模态和单一语言场景下的安全性对齐。

未来的研究可以探索如何将RECAP方法扩展到多模态和跨语言场景下,解决这些场景下LRMs可能面临的更复杂的安全性问题。

3. 开发更精细的奖励模型和评估指标:

为了更准确地评估LRMs在安全性对齐方面的表现,未来的研究可以开发更精细的奖励模型和评估指标。这些奖励模型和评估指标应能够更全面地反映人类对安全性和有帮助性的判断标准,为RECAP等方法的优化提供更准确的反馈。

4. 研究RECAP在其他核心推理能力(如数学推理)上的应用:

尽管本研究发现RECAP在数学推理任务上表现出一定的性能提升,但未来的研究可以进一步探索RECAP在其他核心推理能力(如逻辑推理、常识推理等)上的应用。

通过优化反例对齐的CoT预填充的设计和训练策略,研究可以进一步提升LRMs在各种推理任务上的表现。

5. 探索RECAP与混合推理模型的结合:

未来的研究可以探索如何将RECAP与混合推理模型(结合多种推理策略)相结合,以进一步提升LRMs的安全性和推理能力。

通过结合不同的推理策略和安全机制,研究可以开发出更强大、更灵活的LRMs,以应对日益复杂和多变的实际应用场景。