图文详解Transformer模型——解码器输入(shifted input)详解

经过上几期的视频教程,我们介绍了Transformer模型的输入部分,包括positional encoding位置编码与word embedding词嵌入向量的概念,通过视频,图文与代码3个维度详细分析了位置编码与词嵌入维度的概念,但是我们发现,decoder的输入称之为output(shifted right)?

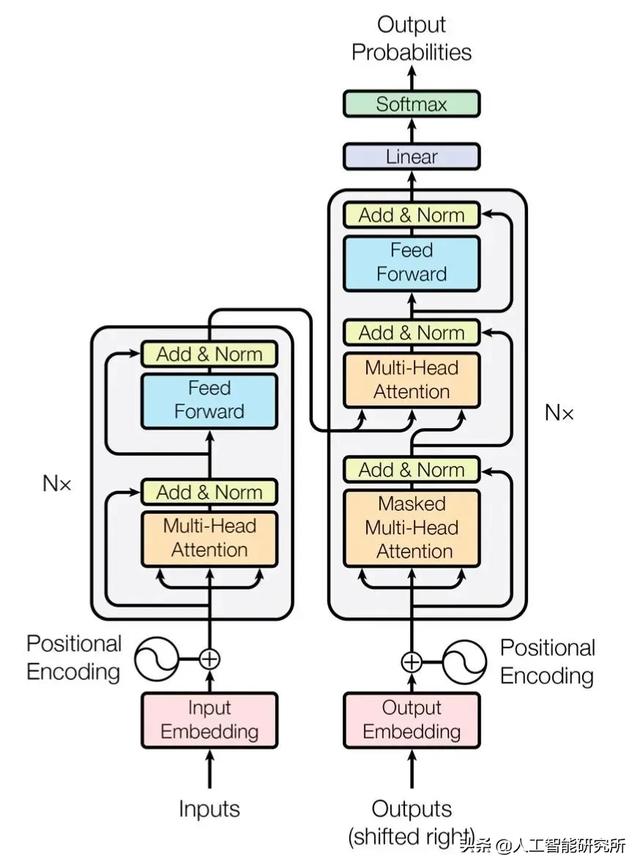

Transformer模型框架

虽然从Transformer模型框架图来看,其encoder编码器部分的输入与decoder解码器部分的输入是完全一样的,都是word embedding后加入positional encoding位置编码,但是我们发现,decoder解码器部分的输入称之为shifted right input,且经过word embedding与positional encoding位置编码后,decoder解码器的自注意力机制称之为Masked Multi-head Attention。

为何这2个地方,跟encoder编码器部分不完全一致,本期,我们就详细介绍一下decoder解码器的输入部分

——1——

decoder解码器的输入部分

根据Transformer模型的架构图,我们知道Transformer模型一共包含2个输入。

一个是encoder编码器的输入,按照