没有显卡,浏览器如何免费调用本地大模型智能体

无显卡也能跑大模型!浏览器调用本地API,实现AI自由免费。下面就一步步带你上车

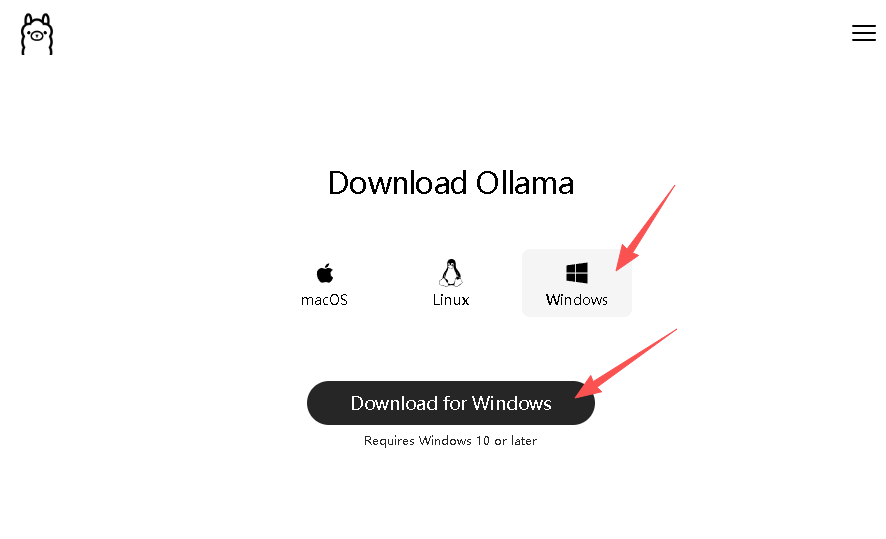

1、从官网下载安装Ollama版本0.12以上,当前最新版本0.12.3,下载地址http://ollama.com/download,大多数小白使用Windows系统,这里下载Windows版本即可。

下载后得到OllamaSetp.exe,直接运行安装就可以了,这里不再累述。

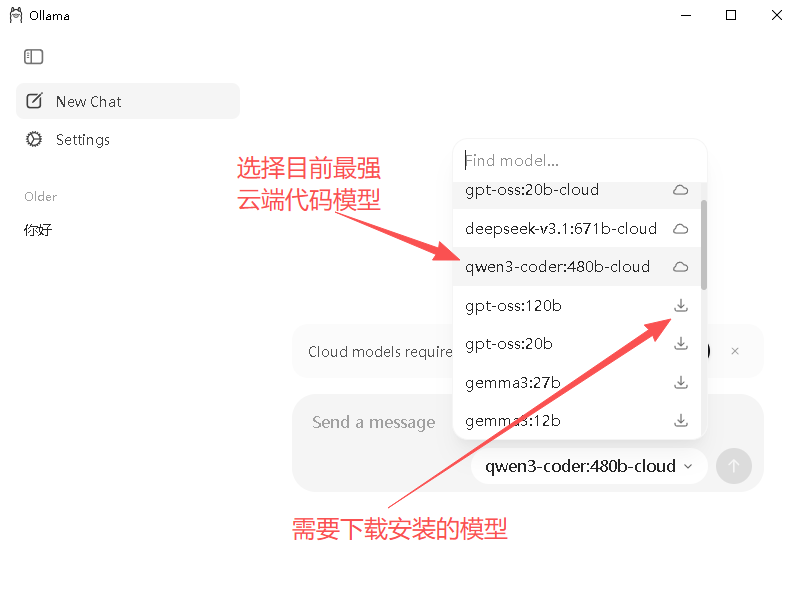

2、运行Ollama主程序,打开图形界面,有多种大模型可以选择,注意:模型列表右侧有下载图标的,是把模型下载到本地部署,根据显卡显存容量选择适当的大模型。对于没有高端显卡的友友们,直接选择云端大模型体验满血版,由于我们主要面对浏览器自动化处理,推荐选择coder版大模型效果更好。这里选择阿里的qwen3-coder:480b-cloud

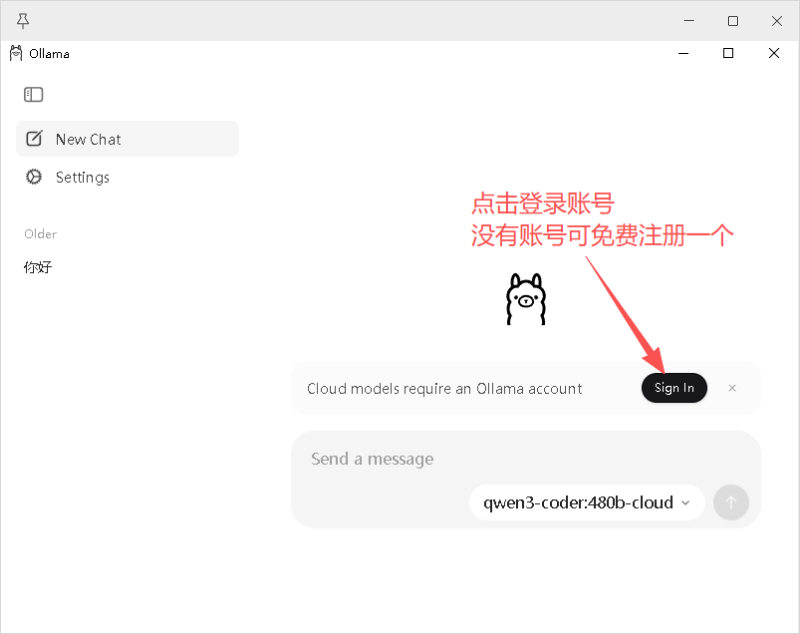

3、选择云端大模型后,Ollama要求我们登录账号,如果你还没有账号,点击注册一个新账号就可以了,这一切都是免费的哦。

4、Ollama云端大模型部署完毕,其本地API已默认开启,浏览器如何调用API呢?打开木头AI浏览器,进入系统设置。

5、在智能控制设置中,选择Ollama Api,调用本地http://localhost:11434端口,浏览器自动加载当前可用的大模型列表,同样选择云端大模型qwen3-coder:480b-cloud.

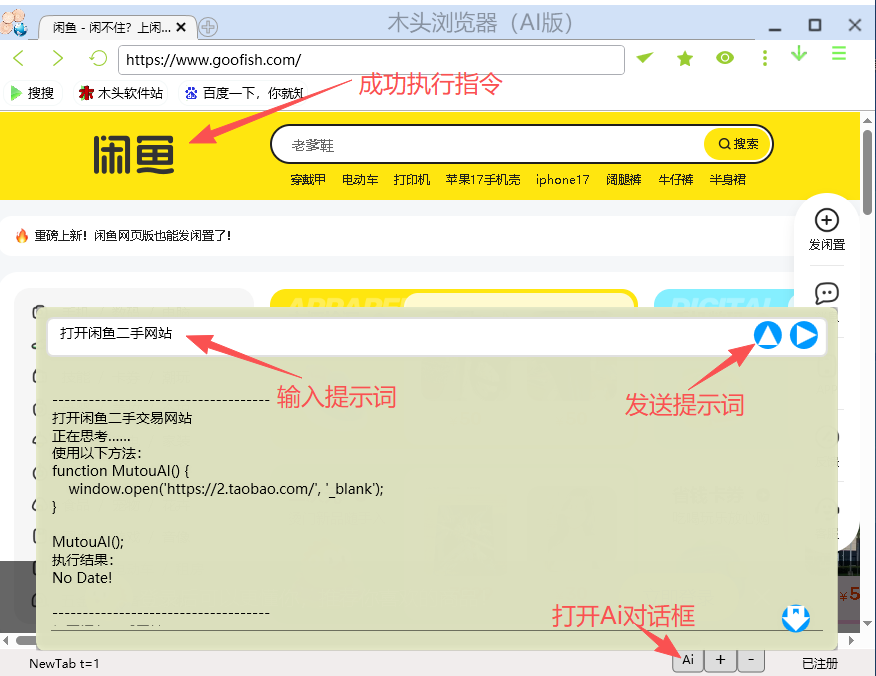

6、最后我们测试一下效果吧,打开浏览器Ai控制窗口,输入提示词“打开闲鱼二手网站”,浏览器调用本地Ai大模型接口,获取完成操作需要的代码,并执行代码完成操作。

对于需要重复执行的操作,重复调用大模型效率低时间长,我们可以保存代码为项目文件,以后就可以直接执行操作而无需调用大模型了。