【AI论文】Vision-Zero:通过策略性游戏化自对弈实现可扩展的视觉语言模型(VLM)自优化

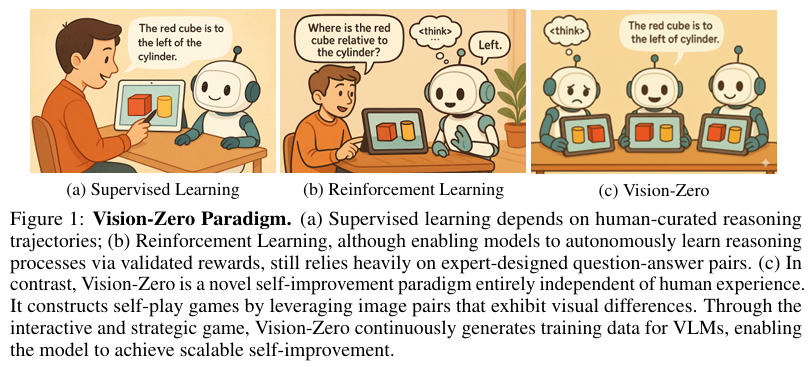

摘要:尽管强化学习(RL)能够有效提升视觉语言模型(VLMs)的推理能力,但当前方法仍严重依赖劳动密集型数据集,这些数据集需要大量人工构建和验证,导致训练成本极高,进而限制了视觉语言模型的实际应用。为应对这一挑战,我们提出了零事故愿景(Vision-Zero)框架,这是一个与领域无关的框架,能够通过从任意图像对生成的竞争性视觉游戏,实现视觉语言模型的自优化。具体而言,零事故愿景框架具备三大主要特性:(1)策略性自对弈框架:零事故愿景框架通过“谁是卧底”式游戏训练视觉语言模型,模型在多个角色中展开策略性推理和行动。通过互动游戏,模型无需人工标注即可自主生成训练数据。(2)从任意图像生成游戏玩法:与现有的游戏化框架不同,零事故愿景框架能够从任意图像生成游戏,从而增强模型在不同领域的推理能力,并展现出对不同任务的强大泛化能力。我们使用三种不同类型的图像数据集——基于CLEVR的合成场景、图表和真实世界图像——展示了这一框架的通用性。(3)可持续的性能提升:我们引入了迭代自对弈策略优化(Iterative Self-Play Policy Optimization,Iterative-SPO)这一新型训练算法,该算法在自对弈和带有可验证奖励的强化学习(Reinforcement Learning with Verifiable Rewards,RLVR)之间交替进行,缓解了仅自对弈训练中常见的性能停滞问题,实现了持续的长期性能提升。尽管使用无标签数据,零事故愿景框架在推理、图表问答和以视觉为中心的理解任务上达到了最先进的性能,超越了其他基于标注的方法。模型和代码已在Github上发布。Huggingface链接:Paper page,论文链接:2509.25541

研究背景和目的

研究背景:

近年来,强化学习(RL)在提升视觉语言模型(VLMs)的推理能力方面展现出了巨大潜力。

然而,现有的方法严重依赖于劳动密集型的数据集,这些数据集需要大量的人工构建和验证,导致训练成本极高,从而限制了VLMs在实际应用中的广泛部署。特别是在需要复杂推理和多领域泛化的任务中,传统方法面临数据稀缺和知识上限的双重挑战。具体来说,现有数据集如COCO Attributes、Ego4D和Visual Genome等,不仅标注成本高昂,而且数据多样性和规模有限,难以满足VLMs日益增长的训练需求。

此外,尽管自我对弈(Self-Play)在棋类游戏和其他领域展示了无需人工监督即可实现持续改进的强大能力,但其在VLMs训练中的应用仍然有限。现有方法通常集中在特定游戏或任务上,缺乏跨领域泛化的能力,且往往需要大量预设规则和精心设计的奖励函数。

因此,如何设计一个通用、高效的自我对弈框架,使VLMs能够在无需人工标注的情况下,通过自我对弈持续提升推理能力,成为当前研究的重要课题。

研究目的:

本研究旨在提出Vision-Zero,一个无需人工标注的、领域通用的VLMs自我改进框架。

Vision-Zero通过从任意图像对中生成竞争性视觉游戏,使VLMs能够在互动游戏中自主生成训练数据,并通过战略性推理和行动不断提升自身能力。具体目标包括:

- 降低数据依赖:通过自我对弈机制,减少对人工标注数据的依赖,降低训练成本。

- 提升推理能力:通过多样化的视觉游戏,增强VLMs在推理、空间理解和视觉理解等方面的能力。

- 跨领域泛化:设计一个领域通用的框架,使VLMs能够在不同类型和复杂度的任务中表现出色。

- 可持续性能提升:提出一种可持续的自我对弈策略优化算法,避免性能停滞,实现长期改进。

研究方法

1. 自我对弈框架设计:

Vision-Zero的核心是一个基于“谁是间谍”风格的自我对弈框架。

在这个框架中,VLMs扮演不同角色(如平民和间谍),通过观察图像并给出描述来推理其他玩家的身份。游戏分为线索阶段和决策阶段,每个阶段都有明确的奖励机制,以引导模型生成更有信息量的描述和做出更准确的判断。

2. 任意图像生成游戏:

与现有方法不同,Vision-Zero能够从任意图像对中生成游戏,从而极大地增强了模型的泛化能力。

通过自动图像编辑工具或程序化渲染,系统生成包含细微差异的图像对,作为游戏的输入。这种设计使得Vision-Zero能够处理各种类型的图像,包括合成场景、图表和真实世界图像,从而提高了模型的适应性和鲁棒性。

3. 迭代自我对弈策略优化(Iterative-SPO):

为了实现可持续的性能提升,Vision-Zero引入了Iterative-SPO算法。

该算法交替进行自我对弈和带有可验证奖励的强化学习(RLVR),以防止训练过程中的性能停滞和过早收敛。具体来说,在自我对弈阶段,模型通过互动游戏生成训练数据;在RLVR阶段,模型根据验证结果进行有监督的微调。这种交替训练机制确保了模型在保持探索性的同时,不断优化其策略。

4. 实验设置与评估:

实验使用了三种VLMs模型:Qwen2.5-VL-7B、InternVL3-8B和InternVL3-14B,并在多个推理、图表问答和视觉中心任务上进行了评估。

评估指标包括准确率、推理能力、空间理解和视觉理解等方面。同时,为了验证Vision-Zero的泛化能力,还在未见过的数据集上进行了测试。

研究结果

1. 性能提升:

实验结果表明,Vision-Zero显著提升了VLMs在多个任务上的性能。

例如,在MathVista、MathVision和ChartQA等基准测试上,Vision-Zero训练的模型准确率比基线模型提高了2%到3%。特别是在需要复杂推理和视觉理解的任务中,Vision-Zero的表现尤为突出。

2. 跨领域泛化能力:

Vision-Zero展示了强大的跨领域泛化能力。

通过在不同类型的图像数据集上进行训练,模型能够在未见过的任务和数据集上表现出色。例如,在CLEVR合成场景、图表和真实世界图像上训练的模型,在逻辑推理、图表问答和视觉中心任务上都取得了显著提升。

3. 可持续性能提升:

Iterative-SPO算法有效地避免了自我对弈训练中的性能停滞问题,实现了长期的性能提升。

通过交替进行自我对弈和RLVR训练,模型在保持探索性的同时,不断优化其策略,从而在不同训练阶段都取得了持续的性能改进。

4. 负迁移缓解:

Vision-Zero还成功缓解了跨能力负迁移问题。

传统方法中,模型在特定任务上的过度训练往往会导致其他任务上的性能下降。而Vision-Zero通过多样化的视觉游戏和战略性推理,使模型在多个能力上得到了均衡提升,有效避免了负迁移现象。

研究局限

尽管Vision-Zero在提升VLMs推理能力和跨领域泛化方面取得了显著成果,但研究仍存在一些局限性。

首先,自我对弈游戏的复杂性和多样性仍有待进一步提升,以更好地模拟现实世界中的复杂任务。其次,Iterative-SPO算法中的超参数调整和训练策略优化仍需进一步探索,以进一步提高训练效率和模型性能。此外,Vision-Zero框架在处理极端复杂或模糊的用户意图时仍面临挑战,需要更先进的自然语言处理技术和上下文理解机制来支持。

未来研究方向

针对上述研究局限,未来的研究可以从以下几个方面展开:

-

增强游戏复杂性和多样性:设计更复杂的视觉游戏,引入更多样化的图像类型和任务类型,以更好地模拟现实世界中的复杂场景和任务需求。

同时,探索自动化或半自动化的游戏生成方法,以降低游戏设计的成本和难度。 -

优化Iterative-SPO算法:进一步探索Iterative-SPO算法中的超参数调整和训练策略优化方法,以提高训练效率和模型性能。

例如,可以引入自适应学习率、动态奖励函数等机制来增强算法的鲁棒性和收敛性。 -

结合多模态信息:将文本、音频等其他模态的信息引入Vision-Zero框架中,以增强模型对复杂上下文和用户意图的理解能力。通过多模态信息的融合和交互,进一步提升模型的推理能力和泛化性能。

-

实际应用与部署研究:探索Vision-Zero在实际应用和部署中的潜力和挑战,包括模型在不同环境中的适应性、鲁棒性和安全性等问题。

通过实际案例分析和用户反馈收集,不断优化和完善Vision-Zero框架的设计和实现。 -

可解释性和透明度研究:加强对Vision-Zero框架中模型决策过程的研究和解释,提高模型的可解释性和透明度。

通过可视化技术、注意力机制分析等方法,揭示模型在视觉游戏中的推理路径和决策依据,为模型优化和应用提供有力支持。