AVM标定:解锁360°全景影像的秘密

一、AVM 标定是什么?

在如今的智能汽车领域,AVM(Around View Monitor),也就是全景影像监测系统,已经越来越普及,成为很多车型的标配或常见选装配置。它就像是给汽车装上了 “上帝视角”,通过分布在车身四周的多个摄像头,让驾驶员能在车内中控屏上看到车辆周围 360° 的全景影像,无论是狭窄道路会车、停车入库,还是低速挪车,都能大幅减少视觉盲区,提升驾驶的安全性和便捷性 。

而 AVM 标定,简单来说,就是让 AVM 系统里各个摄像头拍摄的画面能够准确无误地拼接在一起,并且与真实的车辆位置、周围环境等信息实现精准匹配的过程。想象一下,假如你用拼图游戏来类比 AVM 系统,那么 AVM 标定就是确保每一块拼图都能严丝合缝地拼接,最终呈现出完整且正确的图像。如果标定不准确,拼接后的画面可能会出现错位、变形,车辆和周围物体的位置显示也会与实际情况不符,这样一来,AVM 系统不仅无法发挥应有的辅助作用,还可能误导驾驶员,带来安全隐患。

二、AVM 标定的原理大揭秘

(一)坐标系的那些事儿

在 AVM 标定里,坐标系可是最基础却又极其关键的概念,就像是搭建高楼的基石。我们常见的有右手坐标系和左手坐标系 。简单来说,右手坐标系可以通过右手定则来判断:右手大拇指指向 Z 轴正方向,其余四指从 X 轴正方向握向 Y 轴正方向(旋转 90°),这就构成了右手坐标系;左手坐标系则是用左手,大拇指指向 Z 轴正方向,其余四指从 X 轴正方向握向 Y 轴正方向(同样旋转 90°) 。

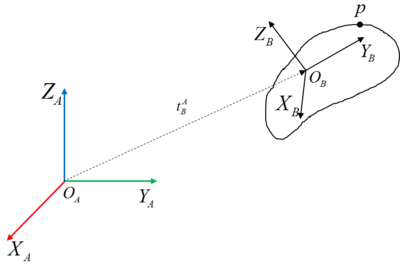

在汽车 AVM 系统中,一般会以车身的中心为原点建立一个全局坐标系,X 轴通常指向汽车的前方,Y 轴指向汽车的左侧,Z 轴垂直向上。而每个摄像头也有自己独立的局部坐标系。这就好比一个城市有一个统一的地图坐标系(全局坐标系),而每个小区又有自己的内部指引坐标系(局部坐标系)。在 AVM 标定过程中,需要把摄像头局部坐标系下采集到的图像信息,准确无误地转换到车身全局坐标系下,这样各个摄像头的图像才能在统一的参考系下进行拼接和处理。在坐标转换时,旋转角的正负判定也很重要。在右手坐标系中,从旋转轴的正方向往负方向看,逆时针旋转为正方向;左手坐标系则相反,顺时针旋转为正方向。这种坐标系的转换和旋转角的规定,是 AVM 标定中实现图像正确拼接和定位的基础,就像不同语言的人交流需要一个统一的翻译规则一样。

(二)欧拉角与旋转矩阵

欧拉角是用来描述物体在三维空间中姿态的一种方式,对于 AVM 系统中的摄像头来说,欧拉角包括俯仰角(Pitch)、航偏角(Yaw)和滚转角(Roll) 。俯仰角是摄像头绕 X 轴旋转的角度,就好像点头的动作;航偏角是绕 Y 轴旋转的角度,类似摇头;滚转角则是绕 Z 轴旋转的角度,如同汽车在行驶中车身的左右倾斜 。

这些欧拉角和旋转矩阵之间存在着紧密的联系。旋转矩阵是一个 3×3 的矩阵,通过它可以实现坐标系之间的旋转变换。以一个简单的例子来说明,如果我们有一个在初始坐标系下的点 P (x, y, z),当坐标系按照一定的欧拉角旋转后,点 P 在新坐标系下的坐标 P'(x', y', z') 就可以通过旋转矩阵 R 与原来的坐标相乘得到,即 P' = R * P 。

在 AVM 标定中,知道摄像头的欧拉角和对应的旋转矩阵,就能精确地确定摄像头的姿态。比如在计算不同摄像头图像拼接位置时,根据摄像头的欧拉角和旋转矩阵来调整图像的角度和位置,让它们能够天衣无缝地拼接在一起。而且,在进行坐标转换时,旋转矩阵也起着关键作用,它能将世界坐标系下的点准确地转换到摄像头坐标系下,为后续的图像处理和分析提供准确的数据基础。

(三)从鱼眼图像到全景视图的蜕变

AVM 系统中,为了获取车辆周围广阔的视野,通常会使用鱼眼相机。鱼眼相机的镜头就像一个特殊的 “广角大眼睛”,它的成像原理和普通相机有所不同。普通相机遵循小孔成像原理,光线通过小孔后在成像平面上形成倒立的实像;而鱼眼相机为了捕捉到超广的视角(通常能达到 180° 甚至更大),其镜头的设计使得光线在成像平面上的投影产生了畸变 。这种畸变主要表现为径向畸变和切向畸变,径向畸变会让图像从中心到边缘出现拉伸或收缩的现象,看起来就像把一个平面的图像贴在了一个球面上;切向畸变则是由于镜头制造工艺等原因,使得图像在某些方向上出现了错位 。

为了让鱼眼相机拍摄的图像能够正常使用,就需要进行去畸变处理。常见的去畸变算法是基于相机标定得到的内参(包括焦距、主点坐标等)和畸变系数来实现的。以 OpenCV 库为例,它提供了一系列函数来完成鱼眼图像的去畸变操作。通过计算,将畸变图像中的每个像素点映射到正确的位置上,从而得到相对正常的图像 。

在完成去畸变后,就进入了图像拼接和坐标标定的关键环节。首先要对各个摄像头拍摄的图像进行特征点提取与匹配,比如使用 SIFT(尺度不变特征变换)、SURF(加速稳健特征)或者 ORB(Oriented FAST and Rotated BRIEF)等特征检测算法,找到不同图像之间相同的特征点 。然后根据这些匹配的特征点,利用 RANSAC(随机抽样一致)算法等进行图像配准,确定各个图像之间的相对位置关系 。在图像融合阶段,通常会采用多频带混合(Multiband Blending)或梯度域混合(Gradient Domain Blending)等算法,让拼接后的图像在亮度、颜色等方面过渡自然,消除拼接的痕迹 。

同时,在整个过程中还需要进行坐标标定,将图像中的像素坐标与实际的世界坐标建立联系。通过在已知尺寸的标定板上进行拍摄,利用标定算法计算出相机的外参(包括相机的位置和朝向),这样就能把图像中的物体准确地定位在真实世界中。经过这些复杂而精细的步骤,最终才能将多个鱼眼相机拍摄的图像合成为一个完整、准确的全景视图,为驾驶员提供清晰、可靠的车辆周围环境信息 。

三、AVM 标定的实际操作流程

(一)标定前的精心准备

俗话说 “磨刀不误砍柴工”,在进行 AVM 标定之前,一系列细致的准备工作必不可少。首先是车辆状态的确认,要保证车辆处于空载状态,车内不能有人,因为人员的重量会改变车辆的姿态,进而影响摄像头的角度和拍摄画面 。像空气悬架等级,需设置为 Normal 模式,这样才能保证车辆的高度和姿态处于标准状态。比如一辆 SUV 车型,如果空气悬架处于较高的越野模式,车身整体抬高,那么摄像头拍摄的视野范围和角度都会发生变化,后续的标定就无法准确反映正常行驶状态下的情况 。

摄像头的检查也是关键,要确保摄像头表面无保护膜以及无附着物,像水滴、泥浆等。保护膜会影响光线的透过和折射,导致拍摄的图像出现模糊、反光等问题;而水滴、泥浆则可能直接遮挡部分视野,使得采集到的图像信息不完整 。外后视镜也要打开,并且处于正常展开状态,因为 AVM 系统中,左右后视镜下方的摄像头是获取车身侧面信息的重要来源,后视镜的折叠或异常状态会让摄像头的视角发生偏差,影响标定结果 。

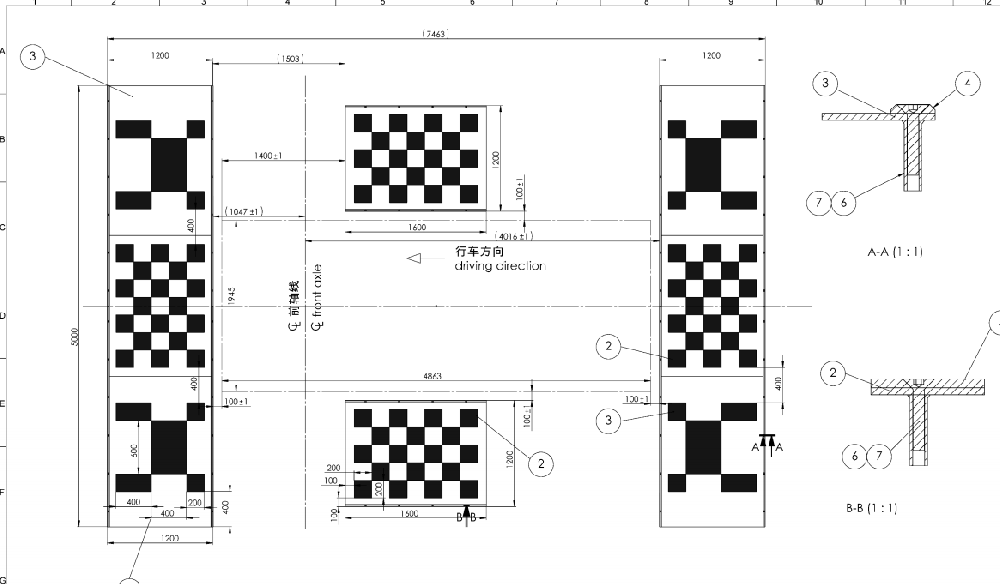

环境因素同样不容忽视,要确认周围没有强光源干扰摄像头。强光源,比如直射的太阳光、大功率的探照灯等,会使摄像头采集的图像出现过曝现象,丢失很多细节信息,让后续的特征点提取和图像处理变得困难重重 。同时,后备箱、车门也要保证没有打开,这些部件的开启会改变车辆的整体轮廓和摄像头的相对位置,干扰标定的准确性 。另外,通常会选择在专门的标定场地进行操作,比如具备稳定环境条件的标定室。标定室的光照要求漫反射光,由 LED 灯管垂直照明,这样可以避免普通荧光、日光灯管的 50HZ 频闪,环境光照亮度值一般在 300lux - 3000lux 之间,既能保证有足够的光线供摄像头采集图像,又不会过亮或过暗 。地面上还会布置黑白格 360 环视标靶,白色采用劳尔色号 RAL9016 交通白(RGB 值为 255,255,255),黑色采用劳尔色号 RAL9017 交通黑(RGB 值为 7,7,7),并且要求采用全哑光黑白油漆或铺色麻面瓷砖,避免反光,60cm×60cm 的格子与目标位置最大偏差小于 ±2mm ,这些标靶就像是给摄像头提供了精准的参考坐标,帮助后续的标定工作更加准确 。

(二)数据采集与处理

准备工作就绪后,就进入了数据采集阶段。此时,需要调整摄像头视角,让它能够覆盖整个标定点阵列。一般会通过车辆的控制系统或者专门的标定软件,对摄像头的俯仰角、航偏角和滚转角进行微调 。就像调整相机的拍摄角度一样,要让摄像头从不同的方向和角度对准标定点,这样才能采集到丰富多样的样本帧 。通常会记录多组样本帧,以确保数据的全面性和可靠性,可能会从不同的光照条件、不同的车辆位置等多个维度进行拍摄,比如在早晨、中午、傍晚等不同时段,车辆位于标定场地的不同位置,这样采集到的数据可以更好地适应各种复杂的实际场景 。

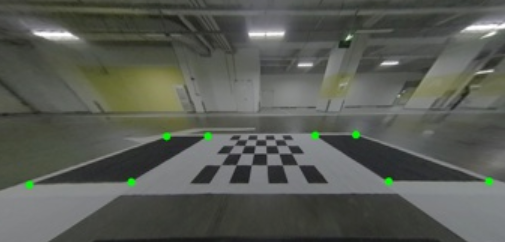

采集到样本帧后,接下来就是利用亚像素级精确定位技术提取特征点。在图像中,特征点就像是一个个关键的 “地标”,通过它们可以确定图像之间的相对位置和姿态关系 。亚像素级精确定位技术,简单来说,就是能够把特征点的位置确定到比像素级别更高的精度 。以常见的棋盘格标定板为例,传统的像素级定位只能确定棋盘格角点在某个像素位置,但亚像素级精确定位技术可以进一步确定角点在这个像素内的更精确位置,误差可以控制在亚像素级别 。这就好比在地图上,普通的定位只能确定你在某个城市,但高精度的定位可以精确到你在城市中的某条街道、某个门牌号 。通过这种技术提取出的有效特征点集合,包含了丰富的图像信息,为后续的相机矩阵推导和参数计算提供了坚实的数据基础 。在实际操作中,可能会使用 OpenCV 库中的相关函数,如cv.findChessboardCorners来寻找棋盘格角点,再通过cv.cornerSubPix进行亚像素级别的细化,以获取更准确的特征点坐标 。

(三)参数计算与优化

在有了提取的特征点和采集的数据后,就开始进行关键的参数计算。首先,要结合已知的三维几何结构信息,比如标定板上的黑白格尺寸、排列方式等,推导出对应相机矩阵表达式 。相机矩阵包含了相机的内参和外参信息,内参决定了相机的成像特性,如焦距、主点坐标等;外参则描述了相机在世界坐标系中的位置和姿态 。通过特征点在图像中的坐标以及它们在世界坐标系中的实际坐标,利用数学模型和算法,可以逐步计算出相机矩阵中的各个参数 。

同时,还需要构建从原始输入影像至最终输出视图之间的映射关系表(Map) 。这个映射关系表就像是一个 “翻译字典”,它记录了原始图像中的每个像素点在最终全景视图中的对应位置 。通过建立这种映射关系,在后续的图像处理和图像拼接过程中,就可以快速准确地将不同摄像头拍摄的图像融合在一起,加速后续渲染效率,提升用户体验质量 。比如在将鱼眼相机拍摄的畸变图像转换为正常视角的图像时,就可以根据这个映射关系表,将畸变图像中的像素点准确地映射到正确的位置上 。

为了让计算得到的参数更加准确,还会采用最小二乘法原理进行参数拟合和优化 。最小二乘法的核心思想是通过最小化误差的平方和来寻找数据的最佳函数匹配 。在 AVM 标定中,由于各种因素的影响,如测量误差、图像噪声等,直接计算得到的参数可能存在一定的偏差 。通过最小二乘法,将采集到的数据和理论模型进行对比,不断调整参数,使得模型计算结果与实际数据之间的误差平方和最小 。就像在射箭时,不断调整射箭的角度和力度,让箭尽可能地射中靶心,最小二乘法就是在不断调整参数,让计算结果尽可能地接近真实值 。经过这样的优化过程,得到的相机参数和映射关系更加准确可靠,为 AVM 系统提供高质量的全景图像奠定了基础 。

四、AVM 标定的应用场景

(一)日常泊车的得力助手

在日常驾驶中,泊车往往是让很多驾驶员头疼的难题,尤其是在车位狭窄、周围车辆较多的情况下。AVM 标定准确的全景影像系统就像是一位经验丰富的泊车导师,能为驾驶员提供全方位的视野辅助。

想象一下,当你驾驶车辆进入商场地下停车场,面对狭小的侧方位停车位,传统的后视镜和普通倒车影像很难让你准确判断车身与车位线、旁边车辆的距离 。但有了 AVM 系统,中控屏上会清晰地显示出车辆的 “上帝视角” 俯视图,车身周围 30 厘米内的障碍物分布一目了然 。系统还会贴心地提供距离预警提示,红色标尺表示危险距离,黄色代表较近距离,绿色则是安全距离 。同时,动态倒车轨迹线会随着方向盘的转动实时更新,让你清晰地看到车轮即将行驶的路径,轻松完成平行泊车、垂直泊车等操作,即使是停车技术不太熟练的新手,也能在 AVM 系统的帮助下,自信满满地将车精准停入车位,大大减少了因泊车不当导致的刮蹭事故 。

(二)复杂路况的安全保障

除了泊车场景,在通过狭窄街巷、乡村小路或施工路段等复杂路况时,AVM 标定也发挥着至关重要的作用。在狭窄街巷中,道路两侧可能存在年代久远的墙体、随意停放的车辆,路面还可能坑洼不平,驾驶难度极大 。此时,开启 AVM 系统,驾驶员能通过中控屏清晰观察车身与两侧障碍物的间距 。比如当车辆转弯时,侧视特写视角可以让驾驶员清楚看到车轮与路边的距离,避免车轮压线或刮蹭到路边的障碍物 。在乡村小路会车时,由于道路狭窄,双方车辆稍有不慎就可能发生刮擦,AVM 系统的全景画面能让驾驶员提前了解对向车辆的位置和周围环境,合理调整行驶路线,安全完成会车 。在施工路段,路面上可能有各种施工设备、警示标志,以及临时堆放的建筑材料,AVM 系统可以帮助驾驶员及时发现这些潜在的危险,绕开障碍物,确保车辆安全通过 。

(三)特殊场景的实用价值

在一些特殊场景下,AVM 标定同样能为驾驶员提供极大的便利。当车辆陷入泥泞、雪地或者需要拖车时,驾驶员需要准确了解车轮与地面的接触状态,以便调整车辆姿态 。AVM 系统的全景画面就像是一双 “透视眼”,让驾驶员坐在车内就能清楚观察到车轮的位置和周围地面的情况,避免车轮进一步陷入困境 。在日常车辆检查时,以往驾驶员需要弯腰查看底盘下方是否有异物,或者蹲下身检查轮胎是否卡入石子,既不方便又可能弄脏衣物 。有了 AVM 系统,驾驶员只需通过车内的中控屏,就能轻松查看底盘下方和轮胎的状况,大大提升了车辆维护的便捷性 。

五、AVM 标定面临的挑战与应对策略

(一)技术难点剖析

在 AVM 标定过程中,图像畸变建模是首先面临的一大技术挑战。鱼眼相机为了获取超广视角,不可避免地会产生严重的径向畸变和切向畸变 。准确地对这些畸变进行建模并非易事,因为实际的相机镜头制造工艺存在一定的误差和差异,不同批次的相机可能具有略微不同的畸变特性 。即使使用常见的畸变模型,如 Brown-Conrady 模型,也难以完全准确地描述相机的畸变情况 。一旦畸变建模不准确,后续的去畸变处理就会存在偏差,导致图像在拼接时出现错位、拉伸等问题,影响最终全景图像的质量和准确性 。

拼接精度也是 AVM 标定中的关键技术难点。在将多个摄像头的图像进行拼接时,需要精确地找到不同图像之间的对应关系 。然而,由于不同摄像头的安装位置、角度以及拍摄时的光照条件等因素的差异,图像之间的特征点可能存在较大的变化 。比如在不同光照下,同一场景中的物体颜色、亮度可能不同,这就增加了特征点匹配的难度 。如果拼接精度不够,拼接后的全景图像会出现明显的拼接缝隙,车辆周围物体的边缘也会出现不连续的情况,严重影响驾驶员对周围环境的判断 。

投影映射同样存在技术难题。要将鱼眼相机拍摄的图像准确地投影到一个统一的平面上,形成鸟瞰图,需要精确地计算投影矩阵 。这个过程涉及到相机的内参、外参以及场景中的几何信息 。在实际应用中,车辆的姿态可能会发生变化,例如在行驶过程中遇到颠簸路面,车辆会产生上下、左右的晃动,这就要求投影映射能够实时地根据车辆姿态的变化进行调整 。但由于车辆姿态的测量本身存在一定的误差,以及计算投影映射时的模型简化等原因,很难实现高精度的实时投影映射,导致全景图像中的物体位置与实际位置存在偏差 。

(二)解决方案探讨

针对上述技术难题,仿真技术成为一种有效的解决方案。通过仿真平台,可以构建虚拟的车辆模型和摄像头模型,模拟不同的场景和工况 。在仿真环境中,可以精确地控制摄像头的参数,如焦距、畸变系数等,并且能够生成带有准确标注的合成数据 。在模拟自动泊车场景时,能够批量构造各种极端和边缘泊车条件,如狭窄的车位、倾斜的地面等,同时自动提供精确的障碍物位置与车辆姿态标注 。利用这些合成数据,可以对 AVM 标定算法进行充分的训练和验证,提前发现算法中存在的问题并进行优化 。相比实车采集数据,仿真技术具有成本低、效率高、可重复性强等优势,能够大大加速 AVM 系统的开发和优化过程 。

AI 算法也为 AVM 标定带来了新的突破。例如,基于深度学习的目标检测和识别算法,可以在图像中快速、准确地识别出各种物体和特征点 。通过大量的样本训练,这些算法能够学习到不同光照条件、不同场景下物体的特征,从而提高特征点匹配的准确性和鲁棒性 。一些基于卷积神经网络(CNN)的算法可以自动提取图像中的特征,并利用这些特征进行图像拼接和投影映射 。在图像拼接中,利用 CNN 算法可以更好地处理不同图像之间的差异,找到更准确的拼接位置,减少拼接缝隙 。同时,AI 算法还可以结合车辆的传感器数据,如陀螺仪、加速度计等,实时地对车辆姿态进行估计,从而更精确地调整投影映射,提高全景图像的准确性和实时性 。

六、AVM 标定的发展趋势

(一)硬件升级

在硬件方面,AVM 标定未来将迎来显著的升级。800 万像素、超高清分辨率摄像头正逐渐成为行业新宠 。这些高像素摄像头能够捕捉到更丰富的细节信息,让 AVM 系统呈现的全景图像更加清晰锐利 。在夜间或低光照环境下,高像素摄像头凭借其出色的感光性能,依然能为驾驶员提供清晰的车辆周围影像,大大提升了驾驶安全性 。同时,AVM 系统与激光雷达、毫米波雷达的融合也将成为趋势 。激光雷达能够通过发射激光束获取高精度的三维点云数据,精确测量物体的距离、形状和尺寸,不受光线变化的影响;毫米波雷达则在恶劣天气条件下具有良好的穿透性和稳定性 。当 AVM 系统与它们融合后,就像是给汽车配备了更强大的 “感知大脑”,可以实现 “视觉 + 雷达” 的多模态融合感知 。在复杂路况下,激光雷达和毫米波雷达可以弥补摄像头在测距和恶劣天气下性能的不足,摄像头则能为雷达提供丰富的语义信息,三者相互协作,使得车辆对周围环境的感知更加全面、精准,测距精度从原来的 ±5 厘米提升至 ±2 厘米以内,进一步降低驾驶风险 。

(二)算法优化

算法优化也是 AVM 标定发展的重要方向。AI 算法、深度学习技术在 AVM 系统中的应用将愈发深入 。通过深度学习技术,AVM 系统能够自动识别行人、车辆、自行车、交通标志、车位线等目标 。系统会对大量的图像数据进行学习,不断优化识别模型,提高识别的准确率和速度 。在遇到行人突然闯入车辆行驶路径时,系统能够迅速识别并及时向驾驶员发出预警 。同时,深度学习技术还能对动态目标的运动轨迹进行预判 。通过分析目标物体在连续图像中的位置变化,结合时间因素,预测其未来的运动方向和位置,提前向驾驶员发出碰撞风险预警,让驾驶员有更充足的时间做出反应,避免事故发生 。

(三)功能拓展

从功能拓展的角度来看,AVM 系统的功能将不断丰富。以 “记忆泊车” 功能为例,它让 AVM 系统如虎添翼 。该功能的实现原理是,AVM 系统结合高精度地图和定位技术,在首次停车时,通过车辆搭载的摄像头、雷达等传感器,将停车场内的环境信息实时采集并处理,生成高精度的泊车地图,同时记录下完整的停车路径和操作步骤 。此后,当驾驶者再次需要将车辆停放在同一车位时,只需将车辆开至指定起点,并激活记忆泊车功能,车辆便会自行在停车场内寻找并泊入之前记忆的固定车位 。在这个过程中,系统会根据实时的环境感知信息,自动调整车辆的速度与方向,确保停车的精准与安全 。这种功能对于经常在固定停车场停车的用户来说,极大地提升了停车的便捷性 。

不仅如此,AVM 系统与其他智能驾驶系统协同工作的趋势也日益明显 。它可以与自动紧急制动系统(AEB)联动,当 AVM 系统检测到车辆周围有潜在的碰撞危险时,立即向 AEB 系统发送信号,触发紧急制动,避免碰撞事故的发生 。AVM 系统还能与自适应巡航控制系统(ACC)配合,在复杂的路况下,为 ACC 系统提供更全面的环境信息,帮助 ACC 系统更好地判断车辆与前车、周围障碍物的距离,实现更智能、更安全的跟车和巡航控制 。随着技术的不断发展,AVM 系统在智能驾驶领域的作用将越来越重要,为未来的自动驾驶发展奠定坚实的基础 。

七、总结与展望

AVM 标定作为智能汽车领域的关键技术,其重要性不言而喻。从技术原理来看,它涉及坐标系转换、欧拉角与旋转矩阵的运用,以及对鱼眼图像复杂的处理过程,每一个环节都紧密相扣,共同为生成精准的全景影像奠定基础 。在实际应用中,AVM 标定在泊车、复杂路况行驶以及特殊场景下,都能为驾驶员提供全方位的视野辅助,显著提升驾驶的安全性和便捷性,已然成为现代汽车不可或缺的功能 。

然而,AVM 标定技术也面临着诸多挑战,如复杂的图像畸变建模、高精度的拼接要求以及实时准确的投影映射等难题。不过,随着仿真技术和 AI 算法的不断发展,这些难题正逐步得到解决。未来,AVM 标定技术在硬件升级、算法优化和功能拓展等方面有着广阔的发展空间 。800 万像素摄像头、激光雷达与毫米波雷达的融合,将让汽车的 “眼睛” 更加敏锐;AI 算法的深度应用,将使 AVM 系统的识别和预判能力更上一层楼;“记忆泊车” 等新功能的出现,以及与其他智能驾驶系统的协同工作,将为用户带来更加智能、便捷的驾驶体验 。

可以预见,在未来的智能交通时代,AVM 标定技术将持续革新,不断完善,为自动驾驶的发展提供更强大的支持,让驾驶变得更加安全、轻松和有趣,成为推动汽车行业智能化变革的重要力量 。