图神经网络分享系列-transe(Translating Embeddings for Modeling Multi-relational Data) (二)

目录

一、实验

1.1 数据集

Wordnet

Freebase简介

FB15k数据集

FB1M数据集

1.2 实验设置

1.2.1 评估协议

1.2.2 基线方法

1.2.3 实验实现

1.3 链接预测

编辑

整体结果分析

TransE的显著优势

性能归因分析

其他方法的局限性

平移项的关键作用

详细结果分析

方法性能观测

详细结果分析

方法性能观测

解释

1.4 通过少量样本学习预测新关系

结果分析

二、结论与未来工作

图神经系列概览:图神经网络分享系列-概览-CSDN博客

承接上一篇文章,继续分享:图神经网络分享系列-transe(Translating Embeddings for Modeling Multi-relational Data) (一)

一、实验

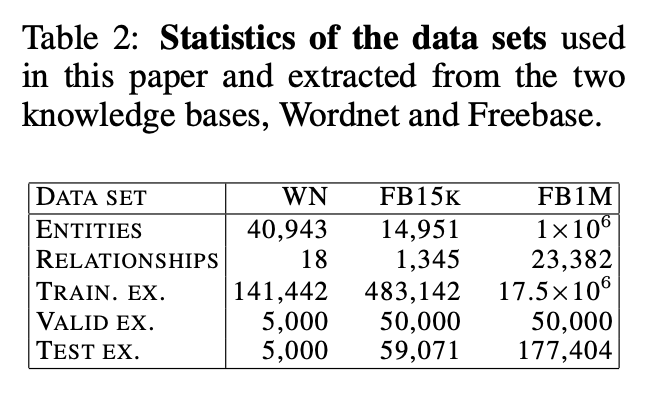

我们的TransE方法在从WordNet和Freebase提取的数据(其统计信息见表2)上进行了评估,并与文献中多种最新方法进行了对比。这些对比方法已被证明在各种基准测试中实现了当前最佳性能,且能扩展到相对大规模的数据集。

关键术语说明

- TransE:知识图谱嵌入模型,通过将实体和关系表示为低维向量空间中的平移操作来建模。

- WordNet:英语词汇数据库,提供词语间语义关系。

- Freebase:大型协作知识库,曾用于支持Google知识图谱。

1.1 数据集

Wordnet

该知识库旨在提供直观易用的词典与同义词库,并支持自动文本分析。其实体(称为同义词集,即synsets)对应单词的不同语义,关系则定义这些语义之间的词汇关联。

引用的版本标记为WN,示例三元组包括:

(score_NN_1, hypernym, evaluation_NN_1)(score_NN_2, has_part, musical_notation_NN_1)

关键术语说明

- 同义词集(Synset):表示同一语义的多个词汇集合,例如“score_NN_1”指“得分”的名词第一语义。

- 关系类型:

hypernym(上位词):表示更广义的语义(如“evaluation”是“score”的上位词)。has_part(部分关系):表示组成关联(如“musical_notation”是“score”的一部分)

Freebase简介

Freebase是一个庞大且持续增长的通用知识库,包含约12亿三元组和超过8000万个实体。基于Freebase创建了两个数据集用于实验和研究。

-

FB15k数据集

为构建小型实验数据集,筛选了同时存在于Wikilinks数据库且Freebase提及次数超过100次的实体(包括实体和关系)。移除了类似“!/people/person/nationality”的逆向关系(与“/people/person/nationality”仅头尾实体顺序相反)。最终得到592,213个三元组,包含14,951个实体和1,345种关系,按表2所示随机划分。该数据集在后文中称为FB15k。

-

FB1M数据集

为测试TransE模型的大规模性能,从Freebase中选取出现频率最高的100万个实体构建另一数据集。最终划分包含约2.5万种关系和超过1700万训练三元组,称为FB1M。

1.2 实验设置

1.2.1 评估协议

评估采用与文献[3]相同的排序流程。对于每个测试三元组,头部实体被移除并替换为字典中的每个实体,依次生成损坏的三元组。模型计算这些损坏三元组的差异值(或能量值),并按升序排序;最终记录正确实体的排名。此过程重复执行,但改为移除尾部实体而非头部实体。报告指标包括预测排名的平均值及hits@10(即正确实体排名前10的比例)。

这些指标具有参考性,但可能存在缺陷:当某些损坏的三元组本身是有效三元组(例如来自训练集)时,它们可能排名高于测试三元组,但这不应被视为错误,因为两者均为真实三元组。为避免误导性结果,提出从损坏三元组列表中移除所有出现在训练集、验证集或测试集中的三元组(目标测试三元组除外),确保所有损坏三元组均不属于数据集。

后续结果报告中,原始评估方式(可能存在缺陷)标记为raw,改进后的方式标记为filtered(或filt.)。对于FB1M数据集实验,仅提供raw结果。

1.2.2 基线方法

第一种方法是Unstructured,它是TransE的一个变体,将数据视为单关系数据,并将所有平移向量设为0(该方法已在文献[2]中作为基线使用)。另外还对比了RESCAL(一种基于集体矩阵分解的模型,见文献[11, 12])以及基于能量的模型SE(文献[3])、SME(线性/双线性,文献[2])和LFM(文献[6])。RESCAL通过交替最小二乘法训练,其他模型则与TransE类似,采用随机梯度下降法训练。

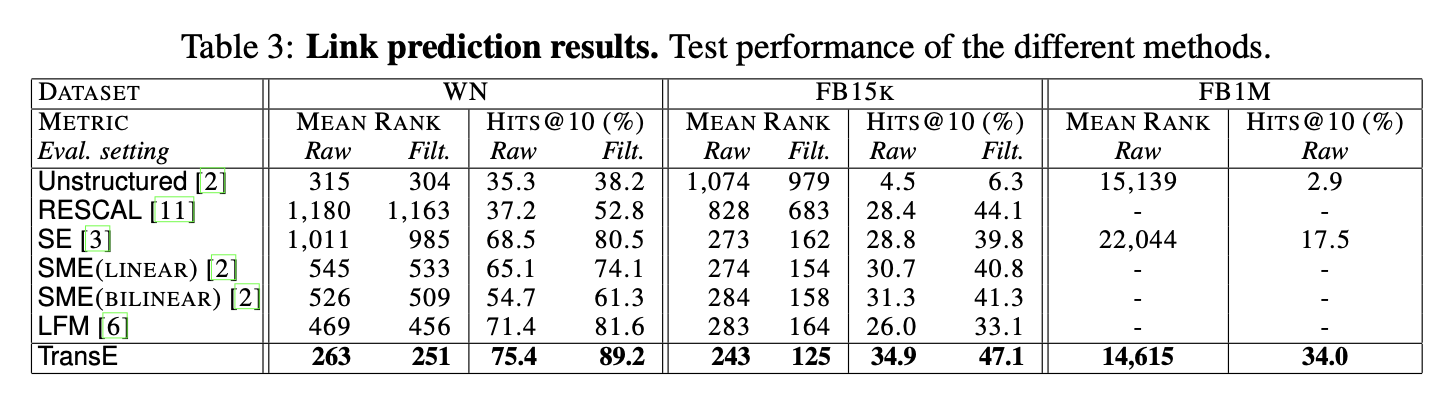

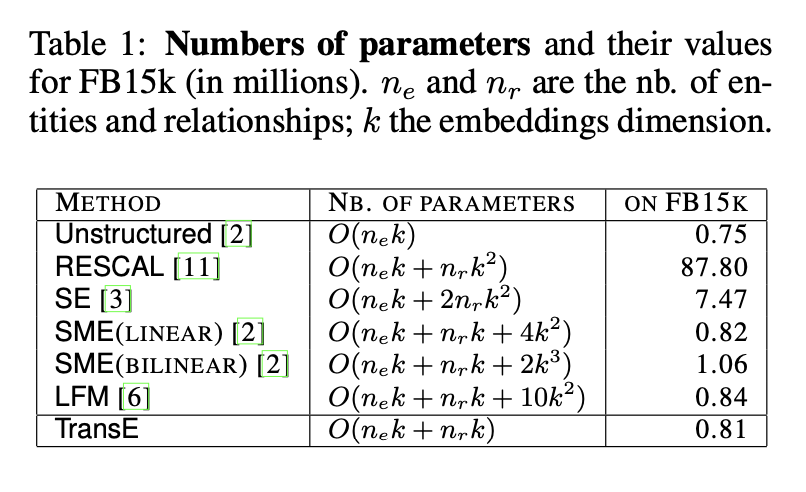

表1将基线方法的理论参数量与本文模型进行对比,并给出了FB15k数据集上的参数量级。当嵌入维度较低时,SME(线性)、SME(双线性)、LFM和TransE的参数量与Unstructured相近;而SE和RESCAL等算法需要为每个关系学习至少一个k×k矩阵,参数量迅速增加。在FB15k上,RESCAL的参数量约为其他模型的87倍,因其需要更大的嵌入空间以达到良好性能。出于参数量或训练时间的可扩展性考虑,未在FB1M数据集上对RESCAL、SME(双线性)和LFM进行实验。

所有基线方法均使用作者提供的代码进行训练。对于RESCAL模型,出于可扩展性考虑,按照文献[11]的建议将正则化参数设置为0,并在{50, 250, 500, 1000, 2000}范围内选择使验证集平均预测排名最低的潜在维度k(采用原始设置)。

对于Unstructured、SE、SME(linear)和SME(bilinear)模型,从{0.001, 0.01, 0.1}中选择学习率,从{20, 50}中选择k值,并通过验证集平均排名进行早停来选取最佳模型(训练数据总迭代次数不超过1000轮)。

针对LFM模型,同样使用验证集平均排名进行模型选择,潜在维度从{25, 50, 75}中选取,因子数量从{50, 100, 200, 500}中选择,学习率在{0.01, 0.1, 0.5}范围内确定。

1.2.3 实验实现

在TransE的实验中,通过验证集对以下参数进行调优:随机梯度下降的学习率λ从{0.001, 0.01, 0.1}中选择,边际γ从{1, 2, 10}中选择,潜在维度k从{20, 50}中选择。差异度量d根据验证集表现选择L1或L2距离。各数据集的最优配置如下:

- Wordnet:k=20,λ=0.01,γ=2,d=L1

- FB15k:k=50,λ=0.01,γ=1,d=L1

- FB1M:k=50,λ=0.01,γ=1,d=L2

所有数据集的训练时间限制为最多1,000个训练周期,早停策略基于验证集的平均预测排名(原始设定)。TransE的开源实现可通过项目网页获取。

1.3 链接预测

整体结果分析

表3展示了所有数据集上各对比方法的实验结果。与预期一致,经过筛选的设定(filtered)提供了更低的平均排名(mean rank)和更高的hits@10指标,这种设定能更清晰地评估链接预测方法的性能。尽管如此,原始设定(raw)与筛选设定的结果趋势总体一致。

-

TransE的显著优势

TransE方法在所有指标上均显著优于其他对比方法,优势幅度通常较大,并在绝对性能上达到突出水平:例如在WN数据集(包含超4万个实体)上hits@10达89%,在FB1M数据集(含100万实体)上达34%。TransE与次优方法之间的性能差异具有统计学意义。

-

性能归因分析

TransE的优异表现源于其模型设计贴合数据特性,同时得益于其简洁性——这种简洁性使其能通过随机梯度高效优化。虽然SE模型(第3节所述)在表达能力上优于TransE,但其复杂性可能导致训练困难,反而表现更差。例如在FB15k数据集上,SE在5万条训练子集上的平均排名为165、hits@10为35.5%,而TransE分别达到127和42.7%,表明TransE更不易欠拟合。

-

其他方法的局限性

SME(双线性)和LFM同样存在训练困难问题,未能充分释放模型潜力。LFM的较差结果可能与其设计初衷(预测关系而非实体排序)与评估设定不匹配有关。RESCAL在FB15k上hits@10表现尚可,但平均排名较差(尤其在WN数据集上,即便潜在维度设为2000)。

-

平移项的关键作用

TransE与无平移版本(Unstructured)的对比凸显了平移项的重要性。Unstructured虽在WN上平均排名接近最优,但hits@10极低,因其仅将共现实体聚类而忽略关系语义。例如在FB1M上,两者平均排名相近,但TransE的top10预测数量是Unstructured的10倍。

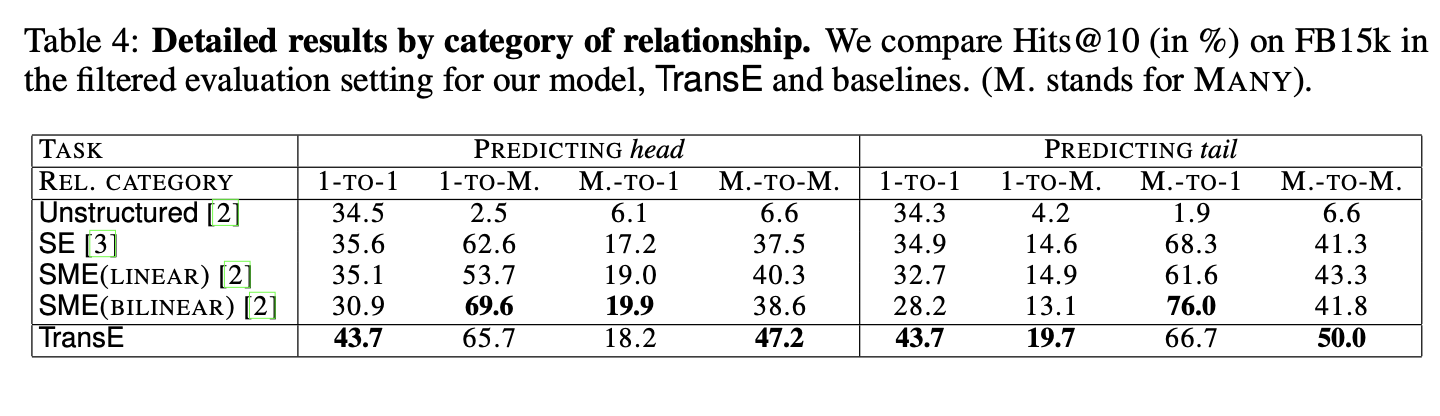

详细结果分析

表4根据关系类型及预测参数对FB15k数据集的hits@10结果进行分类。关系依据头实体和尾实体的基数特性划分为四类:1-TO-1(一对一)、1-TO-MANY(一对多)、MANY-TO-1(多对一)、MANY-TO-MANY(多对多)。

分类标准为:若某关系的头实体平均对应尾实体数≤1.5,则标记为"1",否则为"MANY"。例如,某关系平均每个尾实体对应1.2个头实体、每个头实体对应3.2个尾实体,则归类为1-TO-MANY。FB15k中四类关系占比分别为26.2%(1-TO-1)、22.7%(1-TO-MANY)、28.3%(MANY-TO-1)、22.8%(MANY-TO-MANY)。

-

方法性能观测

预测"1端"实体(即1-TO-MANY中的头实体或MANY-TO-1中的尾实体)时表现更优,这类情况存在多实体指向目标,属于定义明确的任务。SME(双线性)在此类情况下准确率极高,因其训练样本最丰富。

非结构化方法(Unstructured)在1-TO-1关系中表现良好,表明此类关系的实体可能隐含共享类型特征,该方法通过嵌入空间聚类可部分捕捉此类关联。但该策略对其他关系类型失效。

引入平移项(即TransE)后,模型能通过关系向量在嵌入空间中跨实体簇迁移,尤其在定义明确的任务中性能提升显著。

-

详细结果分析

表4根据关系类型及预测参数对FB15k数据集的hits@10结果进行分类。关系依据头实体和尾实体的基数特性划分为四类:1-TO-1(一对一)、1-TO-MANY(一对多)、MANY-TO-1(多对一)、MANY-TO-MANY(多对多)。

分类标准为:若某关系的头实体平均对应尾实体数≤1.5,则标记为"1",否则为"MANY"。例如,某关系平均每个尾实体对应1.2个头实体、每个头实体对应3.2个尾实体,则归类为1-TO-MANY。FB15k中四类关系占比分别为26.2%(1-TO-1)、22.7%(1-TO-MANY)、28.3%(MANY-TO-1)、22.8%(MANY-TO-MANY)。

-

方法性能观测

预测"1端"实体(即1-TO-MANY中的头实体或MANY-TO-1中的尾实体)时表现更优,这类情况存在多实体指向目标,属于定义明确的任务。SME(双线性)在此类情况下准确率极高,因其训练样本最丰富。

非结构化方法(Unstructured)在1-TO-1关系中表现良好,表明此类关系的实体可能隐含共享类型特征,该方法通过嵌入空间聚类可部分捕捉此类关联。但该策略对其他关系类型失效。

引入平移项(即TransE)后,模型能通过关系向量在嵌入空间中跨实体簇迁移,尤其在定义明确的任务中性能提升显著。

解释

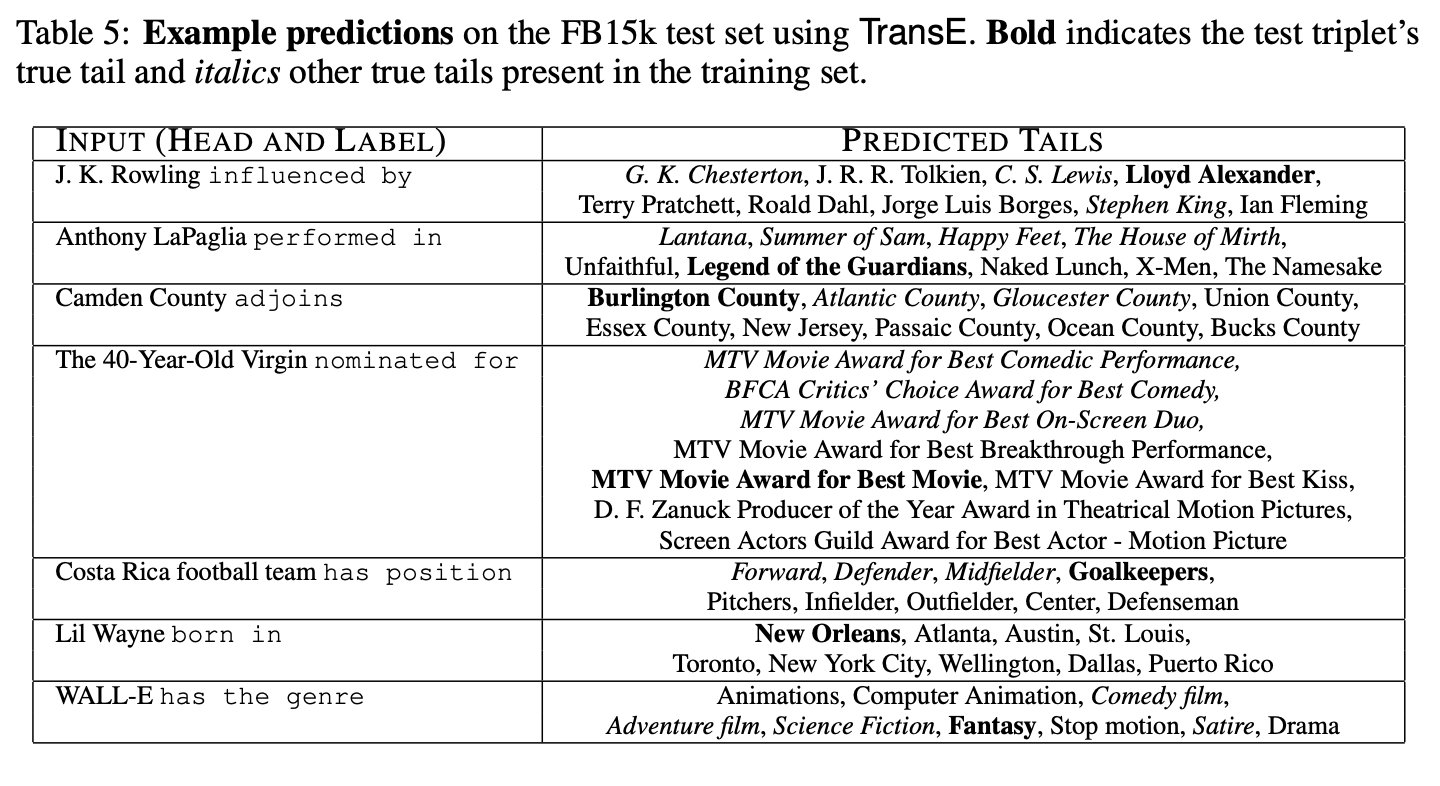

表5展示了TransE模型在FB15k测试集上(预测尾部实体)的链接预测结果示例,体现了该模型的性能。给定头部实体和关系标签后,模型预测的排名靠前的尾部实体(包含真实答案)被列出。这些示例均来自FB15k测试集。尽管正确答案并非总是位列第一,但预测结果符合常识逻辑。

1.4 通过少量样本学习预测新关系

在FB15k数据集上,通过测试模型学习新关系的速度来评估其泛化到新事实的能力。实验设计如下:随机选取40种关系,将数据分为两部分——FB15k-40rel(包含这40种关系的所有三元组)和FB15k-rest(剩余数据),确保两组数据覆盖全部实体。FB15k-rest进一步划分为353,788个训练三元组和53,266个验证三元组;FB15k-40rel划分为40,000个训练三元组(每种关系1,000个)和45,159个测试三元组。

实验分为三个阶段:

- 使用FB15k-rest的训练集和验证集训练并筛选模型;

- 仅针对新关系的相关参数,在FB15k-40rel的训练集上微调模型;

- 在FB15k-40rel的测试集(阶段1未见过的关系)上评估链接预测性能。

此过程重复进行,阶段2分别使用0、10、100和1000个样本。

结果分析

Unstructured、SE、SME(线性)、SME(双线性)和TransE的结果如图1所示。当未提供新关系样本时,Unstructured表现最佳(因其不依赖关系信息预测),但增加样本后性能无提升。TransE学习速度最快:仅需10个新关系样本,hits@10即达18%,且随样本量增加单调提升。TransE的简单性使其能高效泛化,而无需调整已训练的嵌入参数。

二、结论与未来工作

提出了一种新的知识库嵌入学习方法,重点通过模型的最小参数化来主要表征层次关系。该方法在两个不同知识库上的表现优于其他竞争方法,同时具备高度可扩展性,已成功应用于超大规模Freebase数据。尽管尚不确定该方法是否能充分建模所有关系类型,但通过将评估分解为不同类别(1对1、1对多等),其在不同场景下均表现优异。

未来工作可进一步分析该模型,并探索其在更多任务中的应用,尤其是受文献[8]启发的词表示学习等场景。结合文献[2]的思路,将知识库与文本融合是另一个重要方向,该方法可能发挥重要作用。近期已成功将TransE模型嵌入到文本关系抽取框架[16]中并取得成果。